Epic fails à gogo ! Problèmes de fiabilité, instabilités chroniques ou technologies mal maîtrisées : plongez dans notre Panthéon des pires ratés matériels de l’histoire.

N’y voyez aucun mauvais esprit, et encore moins de la moquerie : si nous explorons aujourd’hui les plus gros « fails » du hardware, c’est pour mieux s’en prémunir à l’avenir ! Et à vrai dire, il ne s’agit pas forcément de flops, ni même de produits en tout point mauvais dans l’absolu. Leur point commun ? Ils ont tous connu de gros problèmes de fiabilité, que ce soit à cause d’un bug ou de technologies mal maîtrisées. De la GeForce 8600M de chez Nvidia au bug du Pentium, en passant par plusieurs modèles de SSD, nous allons passer en revue quelques composants devenus mémorables à cause de leurs problèmes…

Évidemment, ce dossier ne prétend pas être exhaustif, si vous avez d’autres souvenirs, n’hésitez pas à en faire part dans les commentaires !

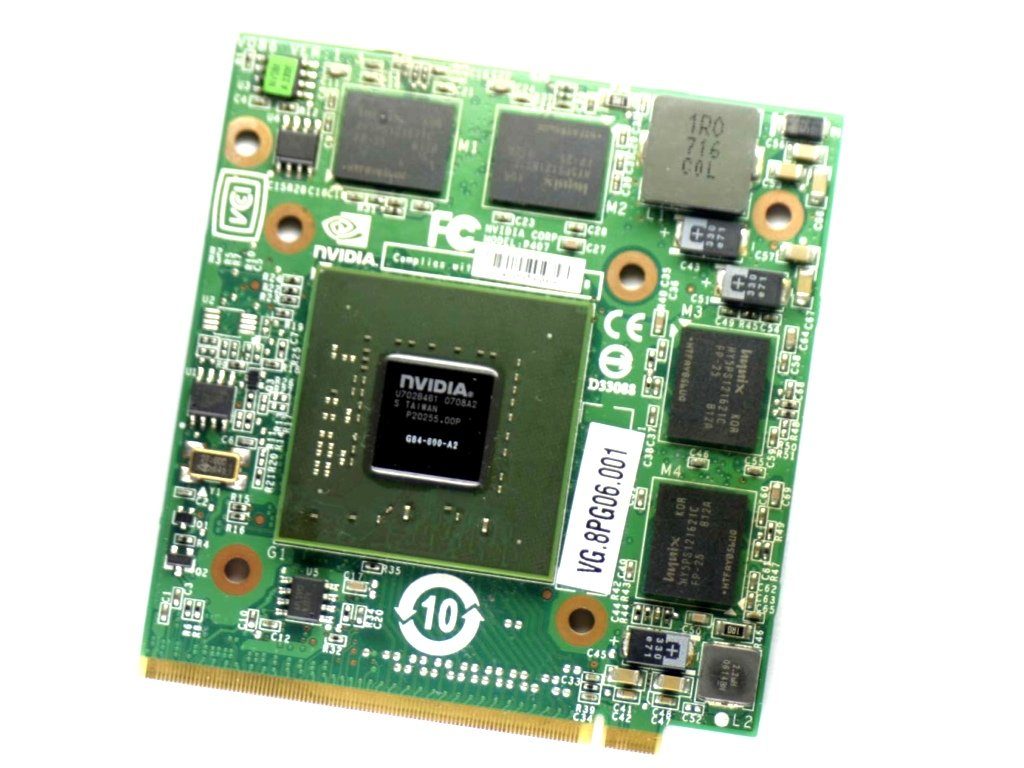

Les GeForce 8600M GT

Commençons par le problème des GeForce 8600M, qui a terni l’image de Nvidia pendant longtemps, et qui est encore dans les souvenirs de beaucoup de personnes. La GeForce 8600M est une puce milieu de gamme qui a été très utilisée en 2007 et 2008, et qui a connu un gros problème : la soudure utilisée pour connecter le GPU à la carte mère était de mauvaise qualité. C’est a priori un problème lié à la directive RoHS, qui supprimait le plomb dans la soudure. Les symptômes étaient simples : le GPU se détachait de la carte mère et l’ordinateur portable ne fonctionnait plus. Les puces mobiles ont été touchées de façon très importante parce que l’environnement confiné d’un ordinateur portable augmente la température de la puce. Nvidia a donc dû provisionner plusieurs millions de dollars pour effectuer des échanges, et des centaines de milliers d’ordinateurs portables ont été touchés par ce problème. Si d’autres GPU de la famille 8xxx ont été touchés, l’ampleur du problème n’a pas atteint le même niveau.

Le bug des 8 Mo

Un exemple récent de bug très gênant : le problème des 8 Mo chez Intel. En effet, dans certaines conditions, les SSD de la famille SSD 320 de chez Intel passaient brusquement de plusieurs centaines de Go (le SSD 320 a longtemps été le seul modèle de plus de 512 Go)… à 8 Mo, en perdant évidemment les données. Le problème a commencé à être évoqué en mai 2011 et il a fallu attendre la fin du mois d’août de la même année pour qu’Intel propose un correctif, via un nouveau firmware.

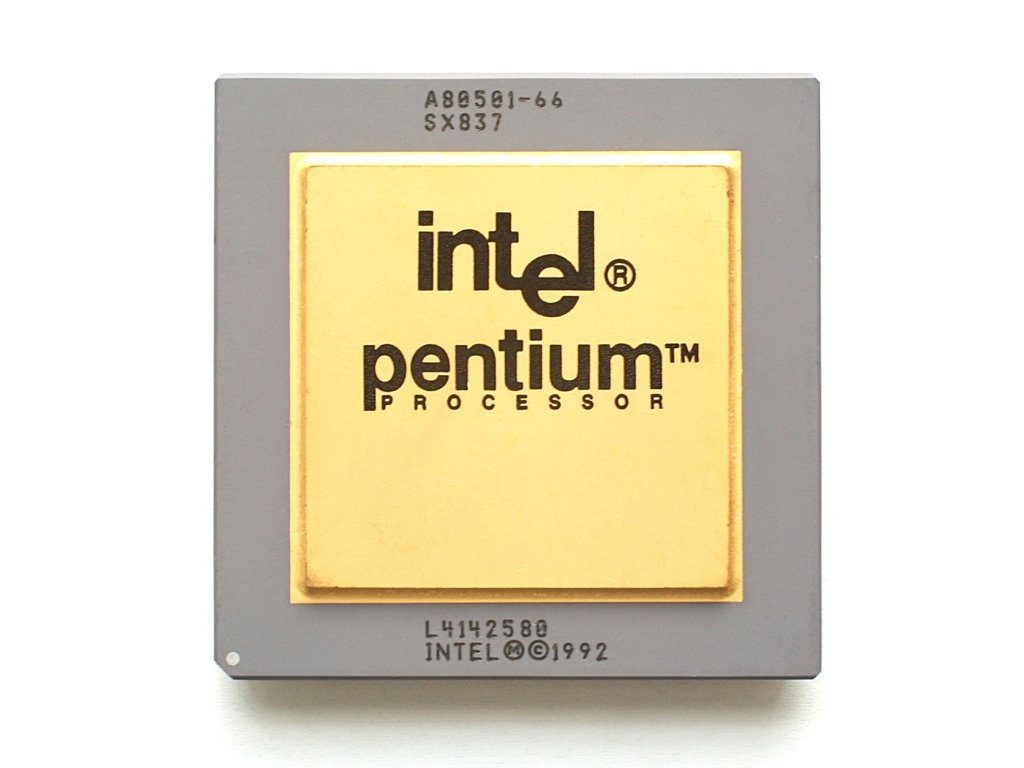

Le bug des Pentium

En 1994, peu de temps après le lancement du processeur Pentium par Intel, un bug a été découvert : dans certains cas, l’opération de division FDIV donnait un résultat incorrect. Intel a d’abord nié le bug, avant d’essayer de le minimiser, en indiquant qu’il était très rare. Finalement, devant la pression des utilisateurs et de ses concurrents (dont les clones n’avaient pas ce bug), la société a échangé les processeurs. Les Pentium 60 et 66 (P5, 800 nm) et quelques P54C (Pentium 75 à 100 MHz, gravés en 600 nm) ont été touchés par ce bug, corrigé dans les révisions suivantes de la puce.

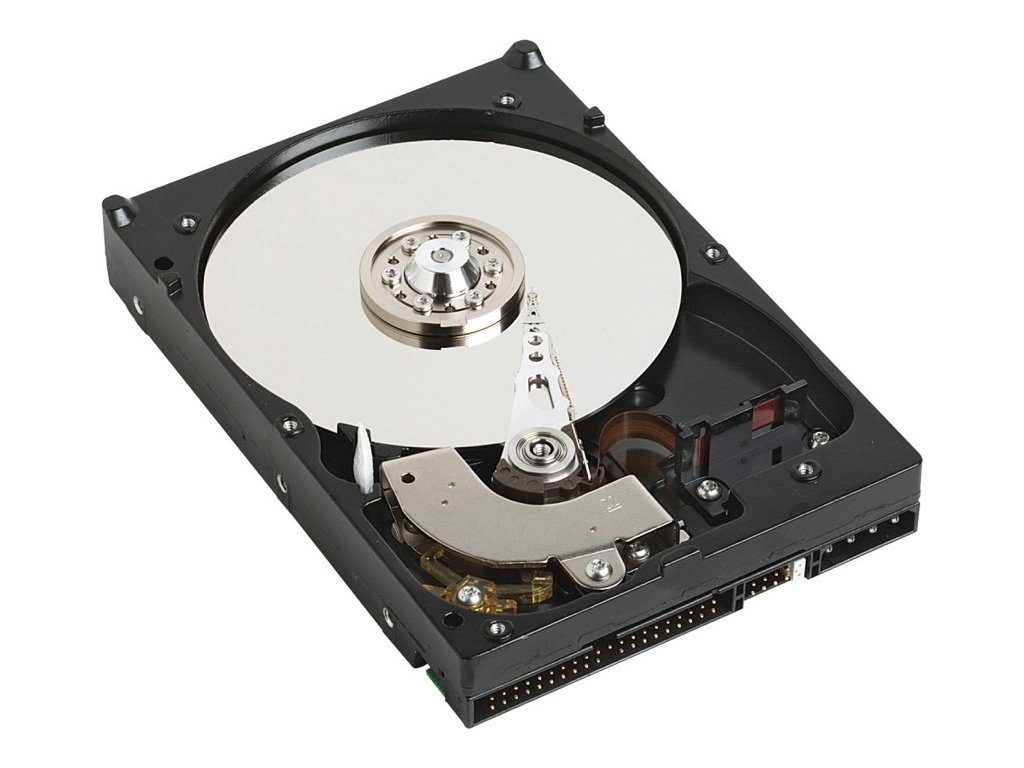

L’IBM 75GXP

En 2000, IBM a lancé le 75GXP. Ce disque dur PATA pouvait atteindre 55 Mo/s avec (au maximum) cinq plateaux de 15 Go, soit une capacité maximale de 75 Go, d’où son nom. S’il a été bien noté à sa sortie, tout le monde a vite déchanté : la fiabilité de ce modèle était désastreuse. Officieusement, le taux de retour était 10 fois plus élevé que la moyenne de ses concurrents, et IBM a essayé pendant longtemps de le cacher. Selon certaines informations, IBM a même envoyé des disques à la grande distribution alors qu’ils avaient été refusés par un grand client pour des problèmes de fiabilité. Cet épisode a écorné l’image de marque d’IBM sur ce marché, ce qui a — selon toute vraisemblance — motivé la vente à Hitachi.

Le RRoD de la Xbox

La Xbox 360 a souffert d’un terrible problème : le Red Ring of Death, alias RRoD. Très courant, il se manifestait par un cercle rouge sur la console, qui indiquait qu’elle avait un problème. La raison était simple : la technique utilisée pour souder le GPU et le CPU utilisait un nouveau type de soudure suite à la directive RoHS, et cette technique n’était pas fiable. Avec le temps, les composants se décollaient donc littéralement de la carte mère, ce qui rendait la console inopérante. L’ampleur du problème était telle que Microsoft a développé une carte mère exclusivement pour le SAV, connue sous le nom de code Opus. Elle utilisait une autre technique pour souder les composants et chauffait moins.

Les 7200.11 de Seagate

C’est en janvier 2009 que le problème a commencé à se poser : des centaines d’utilisateurs de disques durs 7200.11 de chez Seagate (et ses clones Barracuda ES.2 et DiamondMax 22) étaient subitement inutilisables. Les disques durs passaient en effet en « protection », ce qui empêchait l’accès aux données. Si certains récupéraient les données en se connectant via un bus série au disque dur, Seagate a corrigé le problème… en détruisant d’autres disques. En effet, la première correction posait des soucis avec d’autres modèles. Finalement, Seagate a corrigé le tir en proposant au final un firmware réglant le souci, après quelques milliers de téraoctets de données perdues…

Le bug des chipsets Intel

Intel, avec ses chipsets de la Serie 6 (Cougar Point pour les processeurs Sandy Bridge, P67, H67, Q67, HM67, HM65, QM67, QS67, H61 et B65) a eu un souci gênant, qui a imposé le retour de millions de cartes mères : le contrôleur SATA 3 gigabits/s de la carte mère pouvait tomber en panne. Étant donné que les chipsets ne géraient — dans le meilleur des cas — que deux connecteurs SATA 6 gigabits/s, c’était évidemment un problème. Intel a pris plusieurs mois avant d’effectuer les retours, et les constructeurs ont souvent dû se résoudre à installer des contrôleurs-tiers sur les cartes mères, le temps que la société livre une nouvelle révision du chipset.

Le KT133A de Via

Le chipset Via KT133A a été une énorme source de bugs pour les utilisateurs. Ce chipset Via a été utilisé pendant un temps avec les Athlon d’AMD, en remplacement des AMD 76x qui n’avaient été lancés par AMD que pour avoir un chipset au lancement. En vrac, les Via KT133(A) empêchaient le reset dans certains cas, posaient des soucis de corruption lors de transferts entre disques durs IDE, montraient des signes d’incompatibilité avec les lecteurs ZIP et refusaient même de fonctionner avec les premiers modems ADSL, notamment la raie manta d’Orange : les cartes mères ne délivraient pas assez d’énergie aux ports USB et le modem demandait le maximum de la norme.

Les bornes AirPort défectueuses

En 2006, un peu plus d’un an et demi après le début de la commercialisation des premières bornes AirPort Express (un routeur Wi-Fi compact signé Apple), les rapports affluent : les bornes s’arrêtent de fonctionner après 18 mois environ. Pendant de longues années, MacBidouille va recenser les bornes qui s’arrêtent de fonctionner et proposer des solutions pour les bricoleurs. Apple n’a jamais vraiment reconnu le problème, qui viendrait d’un condensateur mal dimensionné : la borne étant compacte, la température interne est élevée, ce qui diminue énormément la durée de vie des condensateurs. Le problème a été corrigé sur les bornes 802.11n, de seconde génération, quelques années plus tard.

À noter que les Time Capsule (des routeurs Wi-Fi contenant un disque dur) ont été touchés par un problème similaire en 2009, mais dans une moindre mesure.

Les SSD Everest

En 2011, OCZ lançait les SSD de la gamme Octane et Petrole. Dans les deux cas, OCZ utilisait un contrôleur maison, l’Everest, basé sur les travaux d’Indilinx. Si les performances sont correctes, c’est la fiabilité qui est problématique : nos confrères, qui ont accès aux statistiques SAV d’un commerçant français, indiquaient par exemple un taux de retour de 50 % sur certains modèles en mai 2013. Plus gênant pour OCZ, alors que le Vector (basé sur le Barefoot 3 maison) était censé être plus fiable, nos confrères indiquent un taux de retour de 10 % environ, ce qui reste élevé. OCZ ne s’est d’ailleurs pas remis de ce souci de fiabilité, déplorable pour l’image : la société a été rachetée par la suite par Toshiba.

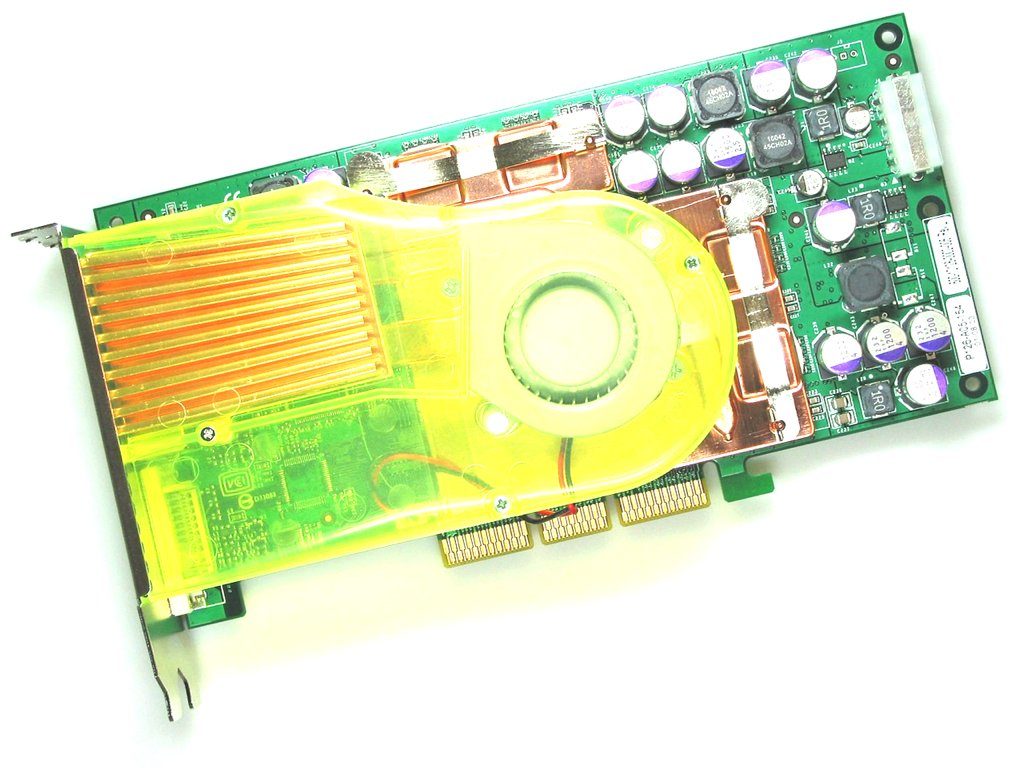

La GeForce FX 5800

Si les lancements ratés sont rares dans le monde des GPU, celui des GeForce FX 5800 est emblématique. Cette carte haut de gamme lancée en 2003 souffrait en effet de deux problèmes importants : elle n’était pas plus rapide que sa concurrente directe, l’excellente Radeon 9700 Pro d’ATi, et elle était extrêmement bruyante. La carte, pour l’époque, consommait aussi énormément et Nvidia a eu beaucoup de mal à proposer des variantes viables pour les cartes de la famille NV3x. À noter que les GeForce FX ont été les premières cartes PCI-Express chez Nvidia, avec les variantes GeForce PCX qui intégraient un bridge AGP (interface d’origine de la puce) vers PCI-Express.

Crucial et les 5 200 heures

Crucial, avec les M4, a eu aussi un petit bug généralisé potentiellement gênant : sur cette gamme de SSD, la machine devenait instable si le compteur SMART dépassait 5 200 heures d’utilisation (plus exactement après 5 184 heures). Le bug a été remonté dès qu’il est apparu — soit environ 7 mois après la sortie des SSD, en janvier 2012 — et la société a corrigé assez rapidement le problème, dès la fin du même mois. Heureusement pour les utilisateurs, il n’a touché que peu de personnes : dans la grande majorité des cas, le SSD n’était pas resté allumé depuis son achat et donc le compteur était souvent assez loin de sa limite…

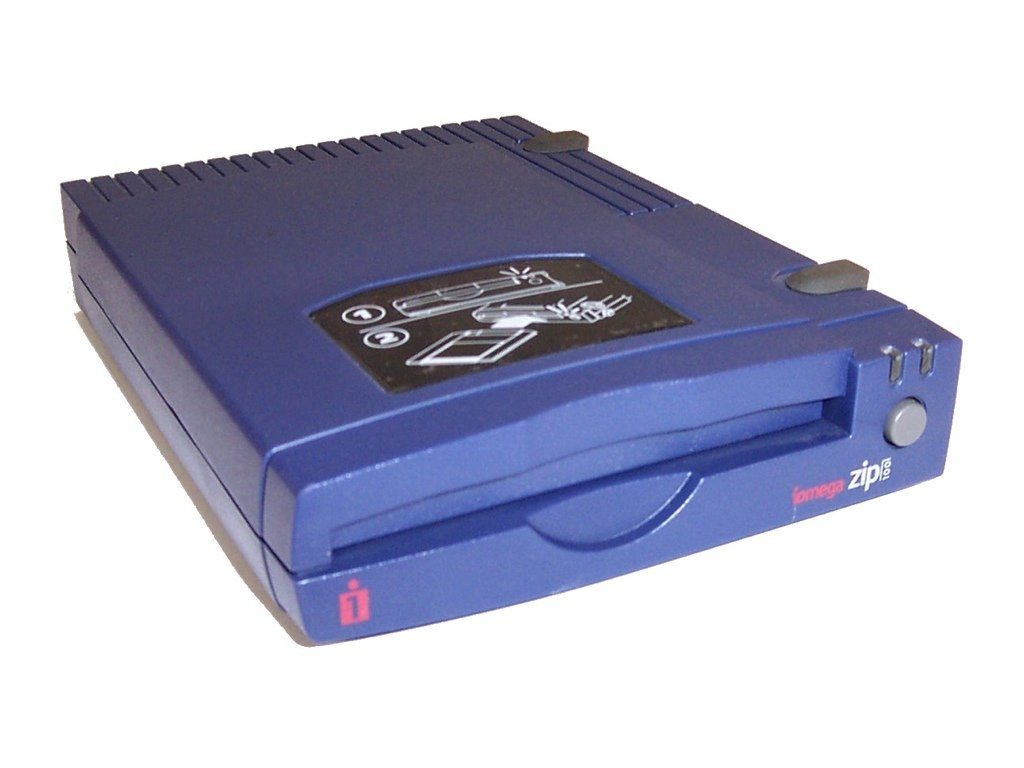

Le « clic de la mort »

Dans les années 90, on n’avait pas encore de clés USB de plusieurs giga-octets, et les CD-R restaient onéreux. Quand on voulait transférer des fichiers volumineux, on utilisait donc souvent des disques ZIP : avec 100 Mo de capacité et des débits proches de 1 Mo/s, ces cartouches ont rencontré un grand succès. Et le « clic de la mort » était un problème très courant : les têtes de la cartouche n’arrivaient plus à se synchroniser correctement sur les pistes, ce qui provoquait un déplacement du moteur et produisait un clic très audible.

L’Antennagate

Tout le monde peut faire des erreurs, même Steve Jobs. Quelques jours après le lancement de l’iPhone 4, les utilisateurs se sont en effet rendu compte que le smartphone captait très mal le réseau. La raison ? La structure de l’antenne externe. Le simple fait de tenir le téléphone dans la main diminuait en effet drastiquement la qualité de la réception, ce qui coupait les appels en cas de mauvaise réception. Après une conférence de presse organisée pour s’excuser, la société a envoyé des protections — les bumpers — aux acheteurs de l’appareil. Elle empêchait l’utilisateur de toucher l’antenne externe, ce qui réduisait le problème. Steve Jobs aurait répondu à un acheteur de tenir son téléphone autrement, et Apple a aussi modifié la gestion des barres affichant la qualité du signal… Si l’affaire a fait grand bruit, elle n’a pas empêché l’iPhone 4 de se vendre énormément, et Apple a continué de proposer ce modèle pendant plusieurs années, avec son problème…

Les batteries Sony

En 2006, Sony — qui fournissait énormément de constructeurs — a dû rappeler plusieurs millions de batteries dans le monde. En effet, dans de rares cas, les batteries pouvaient brûler ou exploser. Pendant quelques temps, les ordinateurs portables ont même été interdits dans les avions à cause de ce défaut. Tous les constructeurs ont été touchés, de Sony (évidemment) à Dell en passant par Apple.

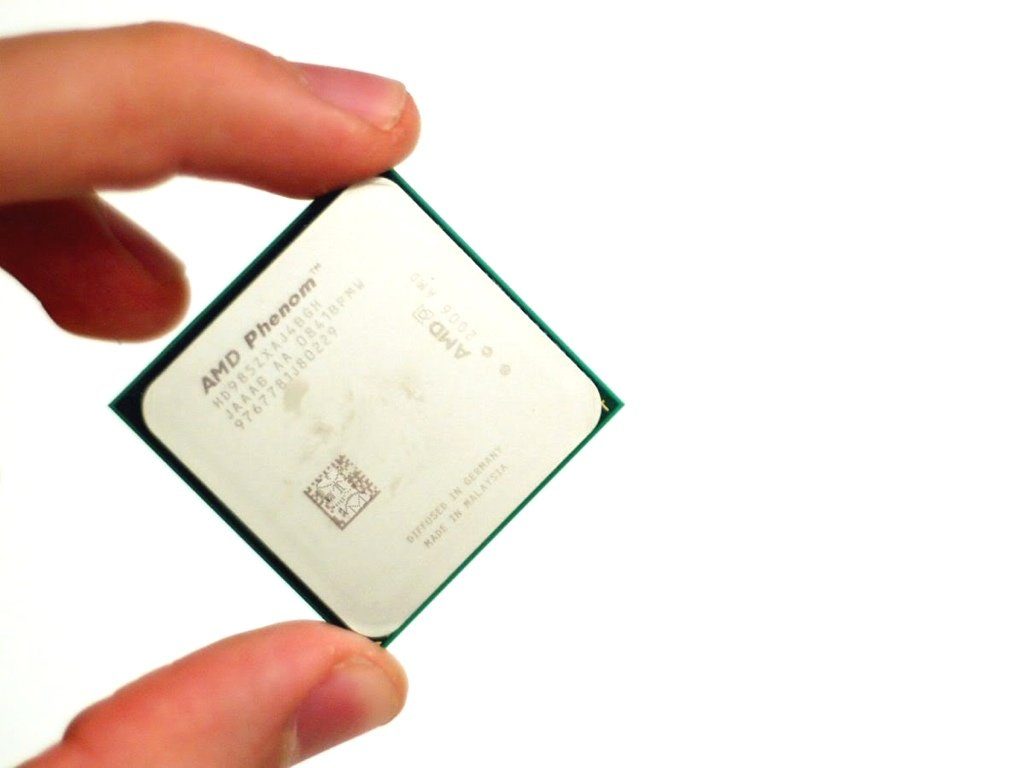

Le bug des Phenom

Le K10, alias Phenom, a été lancé dans la douleur. En effet, le processeur d’AMD a été touché par un bug à son lancement : un problème dans la gestion de la mémoire au niveau du cache de niveau 3 pouvait poser des problèmes, notamment lorsque des logiciels de virtualisation étaient utilisés. Étant donné que les Opteron basés sur le même core étaient très utilisés dans l’industrie, AMD a dû corriger le bug. La correction a été faite dans la révision B3 du processeur, alors que les premiers modèles n’ont pas été échangés : AMD a corrigé le bug via le microcode, l’équivalent du firmware du processeur. Malheureusement, cette solution a eu un impact sur les performances, avec des pertes pouvant atteindre 10 % dans certains cas, ce qui a sévèrement écorné l’image de marque d’AMD à l’époque.

Les Samsung Galaxy Note 7

En 2016, Samsung sortait le Galaxy Note 7, un appareil à mi-chemin entre la tablette et le smartphone grâce à son écran de 5,7 pouces. Poussé par la marque comme son terminal phare, le Galaxy Note 7 a débuté sa carrière sur les chapeaux de roues, devenant même l’un des meilleurs téléphones de l’année 2016. Un titre qu’il ne gardera pas très longtemps à cause d’un « petit » souci lié à sa batterie, qui poussera de nombreux téléphones à prendre feu.

En octobre 2016, Samsung stoppera la production du Galaxy Note 7, entraînant une chute de son action, avant de lancer, le mois suivant, une vaste campagne de rappel. Après plusieurs enquêtes diligentées par Samsung, il apparaît que les batteries lithium-ion utilisées pour construire ces appareils n’étaient pas adaptées. Trop grosses, elles souffraient rapidement d’un problème de surchauffe en raison d’un manque d’aération, pouvant même occasionner un début d’incendie. En 2017, le Galaxy Note 7 est réapparu sous le nom de Galaxy Note FE, avec des batteries adaptées à son format.

Les Hoverboards

En 1989, Robert Zemeckis nous présentait un 2015 empli de voitures volantes, de cinémas holographiques et autres Nike se laçant toutes seules. Il introduisait aussi le mode de transport le plus cool de l’histoire avec l’Hoverboard, ce skate du futur flottant au-dessus du sol grâce à une forme de lévitation magnétique (qui a parlé de lévitation quantique ?). Notre 2015 pour sa part, est beaucoup plus décevant puisque nos Hoverboards ne sont rien de plus que des planches gyroscopiques bien ancrées au sol par leurs deux roues.

Outre leur principe décevant, ces Hoverboard ont aussi souffert d’une très mauvaise image lors de leur arrivée sur le marché. Entre 2014 et 2015, de nombreux appareils ont ainsi pris feu, détruisant des pièces, voire des maisons entières au passage. Comme il est possible de s’en douter, ces feux sont dus à des problèmes de batteries entrant en surchauffe et ce, que ce soit en cours d’utilisation, ou lorsque l’appareil était à l’arrêt. Un problème qui avait tout de même occasionné, en 2016, pas loin de deux millions de dollars de dommages immobiliers.

Les Beats Pill XL Speakers

En 2014, Apple rachetait la marque Beats Electronics, célèbre non seulement pour ses écouteurs et autres casques audio, mais aussi pour appartenir à Dr. Dre. Une transaction qui a rapporté près de 3 milliards de dollars au rappeur, et qui a permis à Apple d’ajouter les produits de la marque à son catalogue, renforçant sa position sur le marché audio. Un an plus tard, à l’occasion de la mise en circulation des Beats Pill XL Apple a connu un léger revers.

Après une bonne année de commercialisation, la firme a en effet dû rappeler pas loin de 223 000 appareils à cause d’un problème de batterie susceptible de surchauffer, et dans le pire des cas, de prendre feu. Huit cas avérés, ayant occasionnés des dégâts corporels (doigts brûlés) ou matériels ont poussé Apple à effectuer un rappel de produits, un geste assez rare dans l’histoire de la marque auquel il n’avait pas recouru depuis les soucis de batterie de l’iPhone 5s.

La crise des iPhone 6

Suite à la sortie des derniers modèles d’iPhone, et les récentes mises à jour d’iOS, de nombreux utilisateurs d’iPhone, particulièrement sur les anciens modèles de la marque (5 et 6 principalement), ont commencé à remarquer que leurs appareils connaissaient de sévères ralentissements. Si de nombreux utilisateurs des téléphones d’Apple croient dur comme fer à la rumeur voulant que la marque impacte négativement ses appareils les plus vieux (obsolescence programmée, tu nous tiens), la vérité est toute autre.

Dans un message daté du 28 décembre 2017, Apple a décidé de répondre à la grogne de ses utilisateurs, en reconnaissant avoir agi sur les performances des anciens modèles d’iPhone. La raison ? Prévenir et empêcher les soucis liés au vieillissement des batteries lithium-ion. Ces dernières, en sus de pouvoir s’enflammer, supportent moins bien les pics d’activité, et peuvent entraîner des arrêts intempestifs des téléphones. En guise de solution, Apple avait donc mis en place des dispositifs contrôlant les performances des vieux modèles d’iPhone, occasionnant effectivement des ralentissements. Après son mea culpa, la firme a décidé d’abaisser le prix du remplacement de la batterie sur certains modèles d’iPhone, et d’offrir des outils de gestion de l’état de la batterie.

Google Home Mini

2017 est sans aucun doute l’année qui a vu débuter l’essor des assistants domestiques. Google Home, Amazon Echo et autres appareils du même acabit ont ainsi commencé à coloniser les maisons du monde entier. Si beaucoup de personnes voient en ces assistants une aide précieuse, d’autres y voient un danger pour la vie privée (voir pour l’avenir du monde, n’est-ce pas Skynet ?). Des craintes tout à fait légitimes, comme ont pu le découvrir certains possesseurs du Google Home Mini.

C’est le journaliste et fondateur d’Android Police Artem Russakovski qui le premier a soulevé le problème de la version mini du Google Home. Après avoir vérifié son service Google Activity, il a en effet remarqué que son appareil avait enregistré et envoyé, à son insu, des dizaines de clips audio de conversations et autres bruits de sa maison, faisant fi de la traditionnelle commande vocale l’activant. Un problème relevé en amont de la commercialisation (ce Google Home Mini ayant été envoyé aux journalistes pour raison de test), et qui était semble-t-il dû à un souci lié au touchpad. Un problème réglé par une mise à jour du firmware désactivant ce dernier.

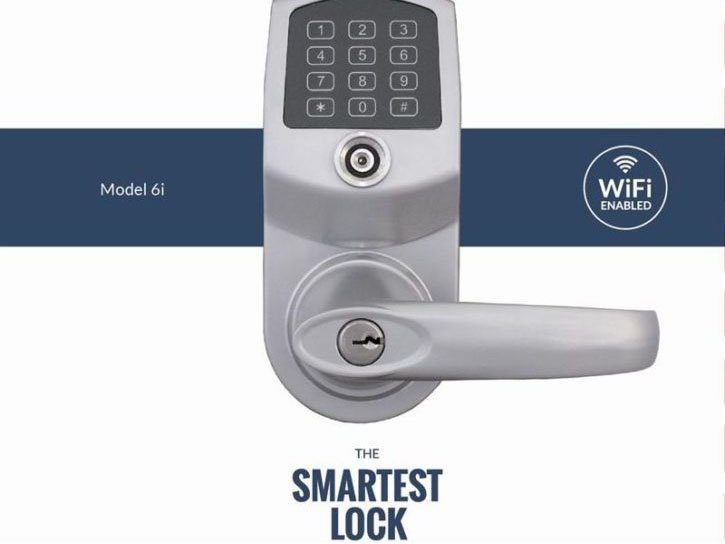

LockState 6i

Pour de nombreuses compagnies, l’avenir se trouve dans les objets connectés. L’Internet of Things, pour reprendre le terme consacré outre-Atlantique, envahit peu à peu la vie de tous les jours à grands coups d’assistants, ampoules, thermostats et autres réfrigérateurs connectés. Des objets censés nous faciliter la vie, et qui objectivement y parviennent souvent, mais qui souffrent tout de même parfois de sérieux problèmes. Outre les inquiétudes légitimes quant à la sécurité de ces objets, la plupart étant vulnérables au hacking, leur fonctionnement même peut s’avérer problématique.

Et ce ne sont pas les 500 utilisateurs de la serrure connectée LockState 6i qui viendront dire le contraire. Dans le courant du mois d’août 2017, la firme a en effet envoyé à environ 500 de ses serrures une mauvaise mise à jour du firmware, mettant ses appareils hors service, et laissant leurs clients dans l’incapacité d’ouvrir ou de fermer leur porte. Un problème d’autant plus ennuyeux que ce modèle précis de serrure était utilisé pour un partenariat avec Airbnb nommé Host Assist. À noter que la LockState a très vite proposé aux clients touchés par le problème de remplacer leur serrure, payant pour le renvoi et offrant un an de souscription gratuite.

Meltdown et Spectre

2018 a démarré sur les chapeaux de roues dans le petit milieu du hardware avec la révélation au grand jour de deux failles, Meltdown et Spectre, touchant une grande partie des processeurs, que ce soit pour les PC ou les téléphones/tablettes, présents sur le marché. Si dans un premier temps la faille semblait uniquement toucher les processeurs Intel, y compris des modèles datant d’une dizaine d’années, il est très vite apparu que la plupart des autres marques étaient elles aussi vulnérables.

Dans les faits, Meltdown et Spectre sont capables de briser la barrière entre les applications et le système, pouvant ainsi accéder à la mémoire de n’importe quel appareil afin d’en lire les données. S’il est impossible pour l’heure de modifier les données, il est toutefois possible de les récupérer. Mots de passe, photos et autres données personnelles peuvent donc être récupérées par des personnes malintentionnées. De nombreux correctifs et autres mises à jour sont d’ores et déjà sortis, Intel conseille vivement de ne pas installer leur dernière version, celle-ci provoquant des comportements imprévisibles sur certains appareils. Afin de mieux comprendre les enjeux de cette faille de sécurité, nous vous invitons à lire les articles que nous avons publiés à son sujet.

Tay, l’IA de Microsoft

En mars 2016, Microsoft a eu la bonne idée de lancer Tay, un chatbot censé tailler une bavette avec les adolescents américains sur Twitter. Un projet créé à la base pour démontrer les capacités d’apprentissage d’une IA via l’apprentissage automatique. Comprenez par-là que la petite Tay devait utiliser l’ensemble des données présentes pour répondre de la manière la plus juste aux tweets qui lui étaient adressés, et ainsi provoquer l’illusion d’une intelligence. Une démarche intéressante, qui a très bien fonctionné durant les premières heures de sa vie, période durant laquelle elle offrait des réponses candides à base d’émojis et autres réflexions bienveillantes.

Quelques heures plus tard, la petite Tay avait bien changé. Une armada d’internautes peu scrupuleux, et avides de tester les limites de l’apprentissage de l’IA, a en effet poussé le programme dans ses derniers retranchements, retournant son “esprit” vers le négationnisme, racisme, anti-féminisme, anti-immigration, avec un vocabulaire particulièrement vulgaire. Au bout de huit heures, et devant le tombereau d’immondices déversées par l’IA, Microsoft a préféré la désactiver afin de limiter la casse.

La gravure en 10 nm chez Intel

La gravure en 10 nm est certainement la plus importante difficulté à laquelle Intel fut confronté, et l’une des raisons qui ont rendu possible le comeback d’AMD dans la course aux processeurs. Accusant plusieurs années de retard sur la production massive, ce procédé de gravure n’a finalement vraiment éclos aux yeux du grand public qu’avec la sortie des récents Alder Lake. Il existait pourtant déjà chez Intel depuis 2018, avec la microarchitecture Cannon Lake. Mais elle ne se décline qu’en une unique référence, le Core i3-8121U (2 cœurs, 4 threads, de 2,2 à 3,2 GHz), trop limitée pour parler d’une vraie ligne de produits. Ice Lake, qui en prend la relève une année plus tard, vise en particulier les CPU mobiles et les Xeon des serveurs. Puis Tiger Lake, en septembre 2020, vient les optimiser et convoite les mêmes types de marché, avec des processeurs H35 conçus pour “le jeu sur ultraportables”, avec des TDP inférieurs à 35 W. Pas de quoi se mettre grand-chose sous la dent, du côté des configurations de bureau.

Contraint de satisfaire la demande avec son processus de gravure en 14 nm (++++) optimisé jusqu’à la lie, Intel, qui comptait sur le renfort des lignes en 10 nm, n’a pas pu satisfaire tous ses clients, provoquant une forte pénurie de CPU. Une solution fut de lancer des processeurs en 14 nm dénués de circuit graphique intégré. Aujourd’hui, Intel a officiellement renommé ses nœuds de gravure pour effacer ce gros couac et on parle de “Intel 7” pour désigner la gravure Enhanced SuperFin 10 nm des processeurs Alder Lake.

Le successeur direct de l’Intel 7, qui sera techniquement le premier nœud de gravure en 7 nm EUV, s’appellera Intel 4. Il promet une hausse de 20 % du rapport performances / watts par rapport à l’Intel 7. Il concernera les processeurs Meteor Lake, qui resteront, de fait, les premières puces grand public de la société gravées en 7 nm. Du côté des processeurs pour serveurs, l’Intel 4 sera utilisé pour les Granite Rapids. Production prévue en 2022.

La Ouya

Souvenez-vous de cette console présentée en 2012. Elle fit immédiatement le buzz grâce à son concept de micro-console sous forme de petit cube qui tient dans la main, tournant sous un CPU ARM et un système d’exploitation Linux, intégrant uniquement des jeux open source et surtout son prix rikiki de 99 dollars. Financée sur Kickstarter, la console profita rapidement d’une communauté très enthousiaste, surtout après avoir compris que des responsables d’IGN, Amazon, Xbox ont travaillé sur le projet et que ses droits étaient détenus par Razer. Avec de tels grands noms impliqués, la console était forcément prometteuse. Mais ce fut une réelle douche froide à l’arrivée, quand les premiers exemplaires sont sortis. La communauté a assez mal reçu le catalogue faiblard de la machine, et dès les premières prises en main les problèmes de conception et les défauts de fabrication ont sauté aux yeux – l’assemblage était désastreux, jusqu’aux coques de manettes qui se cassaient et se désolidarisaient, aussitôt en main. Au final, la Ouya a connu un vrai bide et est restée dans les mémoires comme un exemple de fausses bonnes idées.

La Nvidia Shield Portable

Quand on évoque aujourd’hui le Nvidia Shield, on pense au Shield TV, ce boitier multimédia de salon, mais on oublie parfois que tout a commencé avec la Shield Portable, la console portable de Nvidia. La marque au caméléon avait parié sur un concept assez particulier d’une console pliable tournant sous Android et prenant la forme d’une manette de jeux sur laquelle repose un écran 720p une fois dépliée. À une période où la console portable n’était plus vraiment à la mode, ou en tout cas qu’une solution intermédiaire comme la Nintendo Switch n’avait pas encore dévoilé l’ombre de ses transistors, Nvidia semblait trop en retard ou trop en avance sur son temps.

La console n’a reçu que des félicitations pour son aspect technique, avec de très belles performances grâce à sa puce Tegra (tiens, tiens, la Switch est encore là !) doublée d’une excellente autonomie. Et elle était même capable d’afficher un flux 1080p voire 4K sur un écran externe (en 2013 !). À son habitude, Nvidia avait optimisé la partie logicielle aux petits oignons, même si Android et les jeux disponibles dessus à l’époque devaient limiter quelque peu la bête. De plus, son prix de lancement de 299 dollars était très raisonnable. Mais alors que les yeux étaient rivés sur les plus prestigieuses consoles de salon, à l’époque, son format atypique a eu raison de la Shield Portable, la machine ne s’étant vendue qu’auprès de quelques geeks. Dans le même panier, on peut également mettre la Shield Tablet, la tentative de Nvidia d’intégrer le marché des tablettes Android, et plus particulièrement celui des tablettes gaming. Toujours grâce à sa puce Tegra, on retrouve tous les points positifs de la Shield, et même si elle s’est davantage écoulée que cette dernière et s’est même déclinée en plusieurs versions, le marché ultra-concurrentiel (dans lequel Android n’était pas à son avantage) l’a également enterrée.

On ne peut toutefois pas réellement parler d’échec, mais plutôt de semi-échec. Car déjà sur le plan technique, ces deux machines étaient sans reproche et ne sont au final que des échecs commerciaux et non techniques. Mais surtout, on peut se douter que Nvidia avait prévu le coup et n’avait pas réellement l’ambition de s’imposer sur le marché, mais plutôt d’utiliser ces deux produits comme laboratoire et vitrine technologique. Et quand on voit aujourd’hui le succès de la Shield TV et surtout de la Nintendo Switch (Tegra, 720p en mobile, 1080p en docké, le tout sous Android) reposant sur une puce Tegra, et plus largement le succès et les performances de ce SoC ARM, on se dit que finalement, ils étaient juste trop en avance sur leur temps. Il reste donc à savoir si le récent Steam Deck connaîtra une meilleure fortune et rencontrera durablement son public, alors que cette “console” a elle aussi pâti de retards de fabrication qui se soldent par des modèles relativement limités sur le plan technologique.

Les lancements hardware de fin 2020

Évidemment, il n’est pas question d’échec technique mais véritablement d’échec commercial. Et à un haut niveau de fail, historique quant à lui. Pourtant, tout avait bien commencé en septembre 2020 quand Nvidia a ouvert le bal avec sa gamme RTX 3000. Cartes incroyablement puissantes, prix largement revus à la baisse : il n’en fallait pas plus pour susciter l’envie immédiate d’une grande frange de joueurs, appâtés à l’idée d’embarquer dans leur PC une carte deux fois plus puissante et quasiment deux fois moins chère que la génération précédente. AMD s’est engouffré dans la brèche et a présenté à son tour ses Radeon Big Navi attendues depuis longtemps. Pour la première fois depuis près de quinze ans, l’écurie rouge se hissait au niveau du caméléon vert, au point de le mettre sous pression, avec des GPU compatibles raytracing. En parallèle, les Xbox Series X/S et PlayStation 5 ont dévoilé leur silhouette, en faisant là aussi la part belle au raytracing tout en embarquant des SSD survitaminés ainsi qu’un SoC AMD de dernière génération.

En clair, sur le papier, toutes les planètes étaient alignées. Produits plus puissants et moins chers, concurrence resserrée comme jamais : une situation idéale pour les consommateurs. Tout du moins, jusqu’au lancement des produits. Dès le premier jour de commercialisation, les ruptures de stock sont apparues en quelques fractions de seconde. Aucun produit n’a pu y échapper, et à aucun niveau de prix, jusqu’aux récentes GeForce 3070 Ti, 3080 Ti ou même 3060. Les raisons invoquées ? La pandémie liée au Covid-19, qui a fortement limité la capacité de production des usines de semiconducteurs, mais également l’appétit féroce pour les cryptomonnaies, caracolant à des valeurs encore jamais atteintes. En conséquence, les prix se sont rapidement envolés à des sommets stratosphériques eux aussi, avec des cartes aujourd’hui encore proposées largement au-dessus de leur tarif officiel. La situation est toutefois heureusement en train de se rééquilibrer, après deux ans de tempête, avec Nvidia qui communique autour de la disponibilité de modèles à des prix “raisonnables” et des prix qui reviennent globalement à la baisse. Reste à voir l’impact de la sortie des GPU Intel Arc Alchemist, d’ici quelques mois, qui pourraient bien ouvrir la situation du côté des cartes d’entrée et de milieu de gamme.

Windows 11 et ses exigences matérielles

Révélé en grande surprise au cours de l’été 2021, pour une sortie définitive dès le 5 octobre de la même année, Windows 11 a surpris tout le monde. D’abord parce qu’il vient rompre la promesse de Microsoft de faire de Windows 10 le socle définitif de son système d’exploitation. Apparu le 29 juillet 2015, il devait en effet s’imposer comme la seule version “durable” de Windows, avec des mises à jour semi-annuelles venant étoffer ses fonctionnalités ou corriger ses bugs. Il n’en sera rien, Windows 11 en prend finalement la relève, et vient épurer son interface tout en introduisant de nouvelles fonctionnalités orientées cloud. Alors que l’écosystème fête ses 35 ans, Windows 10 pourra tout de même se prévaloir de l’une des plus longues durées de vie, chez Microsoft.

Ensuite, parce qu’il impose de sérieuses exigences matérielles. Pour migrer vers Windows 11, votre PC doit en effet être équipé d’un processeur Intel ou AMD compatible – une liste assez restrictive, qui commence aux Core de 8ème génération par exemple. Mais aussi d’une carte mère avec un module de sécurité TPM 2.0. Selon Microsoft, l’utilisation de cette puce “réduirait de près de 60% les attaques des malwares”. Un vrai argument … mais qui laisse aussi sur le carreau bon nombre de configurations pas forcément obsolètes.

Le résultat ? Un rythme de migration plutôt lent : selon les stats d’avril 2022 de Steam, 18,94% des utilisateurs seraient passés à Windows 11, contre 73,55% sous Windows 10. Mais c’est surtout du côté des entreprises que la migration peine encore à séduire ; avec de telles exigences matérielles, sans réelle nouveauté fonctionnelle, pas sûr que les parcs informatiques se renouvellent à grande vitesse. Autre couac matériel, qui a largement entaché la sortie de Windows 11 : ses performances en demi-teinte sur des configurations à base de CPU AMD. Aujourd’hui résolu, le souci a tout de même écorné l’image de marque et la réputation du système. Il reste donc à déterminer comment Microsoft va progressivement corriger le tir en réinjectant des fonctionnalités vraiment originales et ambitieuses, pour mieux nous inciter à sauter le pas.

le bug du fdiv touchait aussi les pentium pro 60

Il n’y a jamais eu de “Pentium Pro 60”, uniquement en 150 MHz, 166 MHz, 180 MHz et 200 MHz (je ne compte pas les protos à 133 MHz).

Ahhh cette fichue Geforce 5800… La première fois ou j’avais investi dans un gpu haut de gamme via la marque Leadtek (la A300 de mémoire) avec son design de refroidissement tout fermé à deux ventilos ultra bruyants.

Quelle déception à l’époque, même si niveau design, c’était révolutionnairement moche 😀

Et la Hp touchpad de 2011 ???

A un moment donné, on est obligé de faire un choix 🙂

“Ensuite, parce qu’il impose de sérieuses exigences matérielles. Pour migrer vers Windows 11, votre PC doit en effet être équipé d’un processeur Intel ou AMD compatible – une liste assez restrictive, qui commence aux Core de 8ème génération par exemple. Mais aussi d’une carte mère avec un module de sécurité TPM 2.0. Selon Microsoft, l’utilisation de cette puce “réduirait de près de 60% les attaques des malwares”. Un vrai argument … mais qui laisse aussi sur le carreau bon nombre de configurations pas forcément obsolètes.”

Concernant Intel, certains processeurs de 7éme génération sons compatibles avec Windows 11, j’ai une config qui doit avoir ~5ans avec I9 7920X et j’ai Windows 11.

“En clair, sur le papier, toutes les planètes étaient alignées. Produits plus puissants et moins chers, concurrence resserrée comme jamais : une situation idéale pour les consommateurs. Tout du moins, jusqu’au lancement des produits. Dès le premier jour de commercialisation, les ruptures de stock sont apparues en quelques fractions de seconde. Aucun produit n’a pu y échapper, et à aucun niveau de prix, jusqu’aux récentes GeForce 3070 Ti, 3080 Ti ou même 3060. Les raisons invoquées ? La pandémie liée au Covid-19, qui a fortement limité la capacité de production des usines de semiconducteurs, mais également l’appétit féroce pour les cryptomonnaies, caracolant à des valeurs encore jamais atteintes. En conséquence, les prix se sont rapidement envolés à des sommets stratosphériques eux aussi, avec des cartes aujourd’hui encore proposées largement au-dessus de leur tarif officiel. La situation est toutefois heureusement en train de se rééquilibrer, après deux ans de tempête, avec Nvidia qui communique autour de la disponibilité de modèles à des prix « raisonnables » et des prix qui reviennent globalement à la baisse. Reste à voir l’impact de la sortie des GPU Intel Arc Alchemist, d’ici quelques mois, qui pourraient bien ouvrir la situation du côté des cartes d’entrée et de milieu de gamme.”

Les scalpeurs sont aussi en cause.

La PS3 a souffert du même problème que la XBOX 360.

Oui, la PS3 a souffert du problème de la 360 mais en échelle bien plus petite. Faut se rappeller que 60% des 360 produites était défaillantes d’usine. Chez la PS3, le bouton Power Orange reste assez rare et touche les modèles CECHA/B/C qui n’ont pas été tant produits que ça par rapport aux autres modèles.

La GeForce GTX 590 et les 400 series aussi sont pas mal niveau échec

I feel that is one of the most important information for me. And i’m glad studying your article. However wanna remark on some normal things, The web site taste is wonderful, the articles is really excellent : D. Excellent activity, cheers