Retour en images sur 15 ans de cartes graphiques NVIDIA et des jeux de l’époque, du NV1 cadencé à 75 MHz et ses 4 Mo de RAM EDO aux 3,2 milliards de transistors de la GeForce GTX 480.

- NV1 : la première puce NVIDIA

- NV3 : Riva 128 et Direct3D

- NV4 : TwinTexels pour la TNT

- NV5 : La première Ultra

- NV10 : GeForce, le premier GPU

- NV15 : NVIDIA améliore la GeForce 256

- NV11 : la première déclinaison bas de gamme

- NV20 : La GeForce 3 débarque

- NV17 : La GeForce 4 qui est une GeForce 2

- NV2A : Une GeForce dans une console

- NV25 : GeForce 3 en mieux, la GeForce 4 Ti

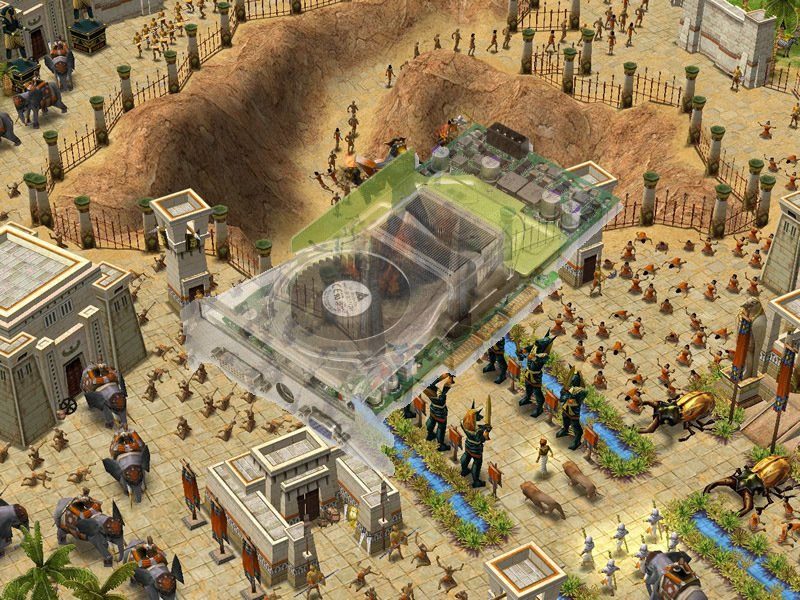

- NV30 : NVIDIA rate une carte, la FX5800

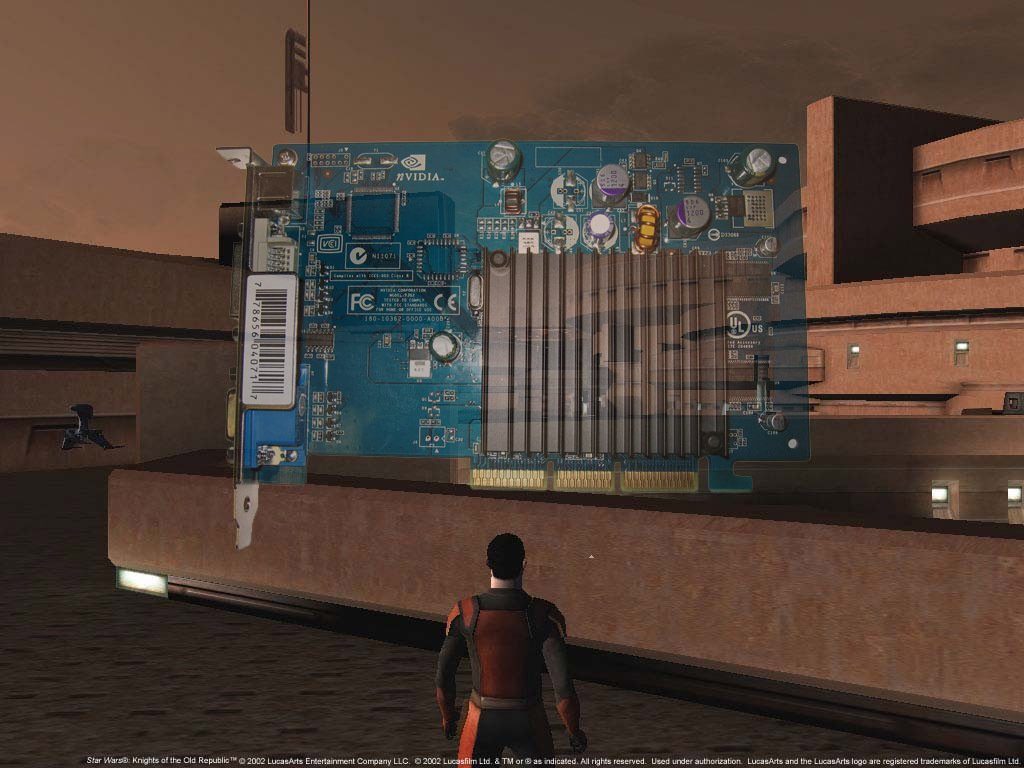

- NV3x : NVIDIA décline les GeForce FX (et PCX)

- NV40/NV45 : NVIDIA revient dans la course avec la GeForce 6800 et le SLI

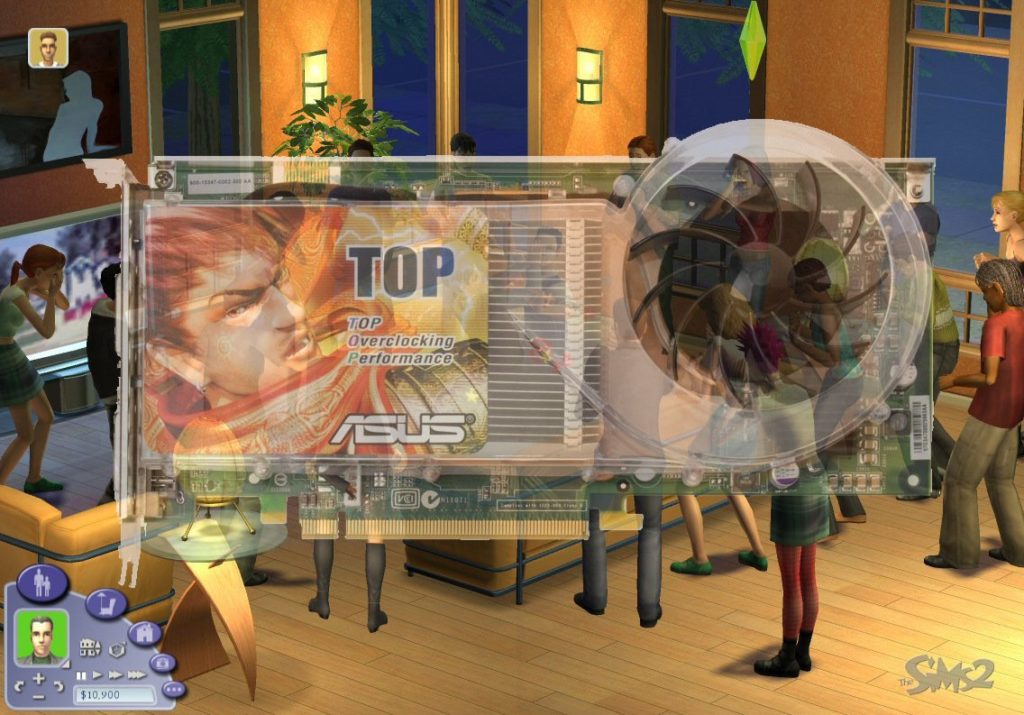

- NV4x : Les GeForce 6 envahissent le monde

- G70 et G71 : NVIDIA change de nomenclature

- G72 et G73 : L’entrée de gamme en GeForce 7

- G80 et G92 : NVIDIA et la 8800, GeForce 8 ou GeForce 9 ?

- G8x et G94 : GeForce 8 en entrée de gamme

- Les GTX 2xx, une franche réussite en haut de gamme

- GeForce 100, 200 et 300 : descente aux enfers

- ION, la renaissance ?

- La GeForce GTX 480, une déception

- Le futur

NV1 : la première puce NVIDIA

L’histoire de NVIDIA commence avec la puce NV1. Elle a été vendue par SGS-THOMSON Microelectronics sous le nom STG-2000 et proposait une carte 2D, un accélérateur 3D, une carte son et un emplacement pour des manettes Saturn dans la même carte PCI. Sortie en 1995, la carte la plus connue est la célèbre Diamond Edge 3D. Le principal problème du NV1 vient de sa gestion de la 3D : elle utilisait le quadratic texture mapping au lieu de la technique actuelle, à base de polygones. Comme DirectX, sorti peu après la carte, a utilisé les polygones, le NV1 a été un échec sur le long terme. Notons dans les points intéressants que la mémoire de la carte graphique pouvait être augmentée sur certains modèles (de 2 à 4 Mo) et qu’une bonne partie des jeux optimisés étaient des portages Saturn, la carte utilisant une architecture proche.

| Date de sortie | Septembre 1995 |

| Interface des cartes | PCI |

| Fillrate | 12 Mtexels/s |

| Version DirectX | – |

| Type de mémoire | EDO/VRAM |

| Mémoire maximale | 4 Mo |

| Fréquence mémoire | 75 MHz |

| Bus mémoire | 64 bits |

| Bande passante maximale | 0,6 Go/s |

| Résolution maximale | 1 600 x 1 200 / 15 bits |

| Sortie vidéo | 1 x VGA |

| RAMDAC | 170 MHz |

Le NV2 utilisait la même méthode de rendu et n’a jamais été terminé : il devait être utilisé à la base dans la console Dreamcast (qui a succédé à la Saturn) mais Sega a finalement choisi une technologie à base de polygones (PowerVR) et nVidia a abandonné le QTM pour un rendu à base de polygones avec le NV3.

NV3 : Riva 128 et Direct3D

En 1997, NVIDIA passe à la 3D à base de polygones avec le NV3, plus connu sous le nom de Riva 128. Riva signifie Real-time Interactive Video and Animation accelerator (accélérateur d’animation et de vidéo en temps réel). Deux versions de la puce existent : Riva 128 et Riva 128ZX. La différence est faible : un RAMDAC plus rapide sur la ZX, 8 Mo au lieu de 4 Mo de mémoire et le support de l’AGP 2x. La Riva 128 a eu un certain succès malgré une qualité parfois en retrait face aux 3Dfx de l’époque : le prix était intéressant. La carte de NVIDIA proposait la 2D et la 3D dans la même carte ainsi que le support de Direct3D. Notons que les pilotes OpenGL ne sont apparus qu’avec la Riva 128ZX, même si des versions spécifiques à Quake existaient (mais ce n’était pas un ICD complet).

| Date de sortie | Avril 1997 | Mars 1998 |

| Interface des cartes | PCI/AGP 1x | PCI/AGP 2x |

| Fillrate | 100 Mtexels/s | 100 Mtexels/s |

| Fillrate | 100 Mpixels/s | 100 Mpixels/s |

| Pipeline de rendu | 1 | 1 |

| Unité de texturing | 1 | 1 |

| Fréquence puce | 100 MHz | 100 MHz |

| Finesse de gravure | 0,35 µ | 0,35 µ |

| Nombre de transistors | 3,5 millions | 3,5 millions |

| Version DirectX | 5 | 5 |

| Type de mémoire | SDRAM | SDRAM |

| Mémoire maximale | 4 Mo | 8 Mo |

| Fréquence mémoire | 100 MHz | 100 MHz |

| Bus mémoire | 128 bits | 128 bits |

| Bande passante maximale | 1,6 Go/s | 1,6 Go/s |

| Sortie vidéo | 1x VGA | 1x VGA |

| RAMDAC | 206 MHz | 250 MHz |

La Riva 128 a été populaire auprès des OEM pour son prix : inférieur à celui d’une Voodoo Graphics pour des performances proches en Direct3D. Il s’agit d’une des premières cartes AGP, même si la Riva 128 l’utilisait essentiellement comme un PCI plus rapide. Enfin, et c’est assez amusant, un constructeur très connu concurrençait NVIDIA au niveau des performances avec une de ses cartes graphiques : Intel et son i740. Les temps ont bien changé.

NV4 : TwinTexels pour la TNT

1998. 3Dfx dispose d’une carte 3D très performante, la Voodoo2, mais avec des limitations importantes : gestion de la mémoire archaïque (textures séparées), limitation au 16 bits, obligation d’utiliser une carte graphique 2D et limitation dans la pratique au PCI (même si des modèles AGP existent). Arrive alors la Riva TNT : une carte rapide en 3D, équipée de beaucoup de mémoire (pour l’époque) et qui offrait une partie 2D efficace. En dehors de la partie vidéo (pas d’accélération du MPEG2, contrairement à ATI), la TNT est un succès. C’est la première carte NVIDIA capable d’appliquer deux textures en une seule passe, d’où le nom de la carte (TwiN Textel).

| Date de sortie | 1998 |

| Interface des cartes | PCI/AGP 2x |

| Fillrate | 180 Mtexels/s |

| Fillrate | 180 Mpixels/s |

| Pipelines de rendu | 2 |

| Unité de texturing | 2 |

| Fréquence puce | 90 MHz |

| Finesse de gravure | 0,35 µ |

| Nombre de transistors | 7 millions |

| Version DirectX | 6 |

| Type de mémoire | SDRAM |

| Mémoire | 16 Mo |

| Fréquence mémoire | 110 MHz |

| Bus mémoire | 128 bits |

| Bande passante maximale | 1,75 Go/s |

| Sortie vidéo | 1x VGA |

| RAMDAC | 250 MHz |

La TNT est une carte moins puissante qu’originellement prévu : NVIDIA comptait au départ sortir une carte plus rapide que la Voodoo 2, gravée en 250 nm avec une fréquence de 110 MHz (et 200 MHz pour la mémoire), la TNT sera finalement gravée en 350 nm et cadencée à 90 MHz, comme la carte de 3Dfx, avec de la mémoire à 110 MHz.

NV5 : La première Ultra

En 1999, la TNT2 débarque. Proche de ce que devait être la TNT à la base, on peut la considérer comme un die shrink de la TNT, du 350 au 250 nm. C’est aussi la première fois que NVIDIA utilise le nom Ultra pour une de ses cartes : la société segmente les cartes TNT2 en fonction de la fréquence. À l’époque, NVIDIA n’a utilisé que deux versions (loin des délires actuels) : TNT2 et TNT2 Ultra. La TNT2 est une carte puissante pour l’époque, largement capable d’égaler les Voodoo 3 tout en offrant plus de fonctions, même si le décodage du MPEG2 reste absent. C’est aussi la première carte AGP 4x de NVIDIA, même si cette norme n’a pas réellement été utilisée avec la TNT2.

| Date de sortie | Mars 1999 | Mars 1999 |

| Interface des cartes | PCI/AGP 4x | PCI/AGP 4x |

| Fillrate | 250 Mtexels/s | 300 Mtexels/s |

| Fillrate | 250 Mpixels/s | 300 Mpixels/s |

| Pipelines de rendu | 2 | 2 |

| Unité de texturing | 2 | 2 |

| Fréquence puce | 125 MHz | 150 MHz |

| Finesse de gravure | 0,25 µ | 0,25 µ |

| Nombre de transistors | 15 millions | 15 millions |

| Version DirectX | 6 | 6 |

| Type de mémoire | SDRAM | SDRAM |

| Mémoire | 32 Mo | 32 Mo |

| Fréquence mémoire | 150 MHz | 183 MHz |

| Bus mémoire | 128 bits | 128 bits |

| Bande passante maximale | 2,4 Go/s | 2,9 Go/s |

| Sortie vidéo | 1x VGA | 1x VGA |

| RAMDAC | 300 MHz | 300 MHz |

Notons que le NV6, sorti aussi en 1999, est une version castrée du TNT2. Il a été vendu sous le nom Vanta, Vanta LT et TNT2 M64. Ces cartes sont nettement moins rapides que les TNT2 (et TNT classiques) essentiellement à cause d’une fréquence de fonctionnement plus faible et d’un bus mémoire en 64 bits. Elles ont eu beaucoup de succès chez les OEM, qui mettaient en avant le nom TNT2.

NV10 : GeForce, le premier GPU

Fin 1999, NVIDIA annonce la GeForce 256. Première carte à utiliser ce que NVIDIA appelle un GPU, elle apporte surtout la gestion du T&L (Transform et Lightnings) aux cartes graphiques grand public. Cette technologie, déjà utilisée en Open GL et dans la 3D professionnelle, permet d’effectuer les calculs sur les triangles sur la carte graphique et non sur le CPU. Gain effectif ? Important dans certains cas, la carte graphique ayant environ 4 fois la puissance d’un CPU haut de gamme de l’époque (15 millions de triangles sur GeForce, 4 millions sur un Pentium III 550 MHz). La carte utilise une architecture différente de celle de la TNT2 : au lieu de 2 pipelines de rendu équipé chacun d’une unité de texturing, on a 4 pipelines de rendu avec une unité de texturing, ce qui permet à la GeForce d’offrir plus de puissance de rendu avec une fréquence plus faible. Enfin, la GeForce 256 est aussi la première carte à utiliser de la DDR-SDRAM, pour augmenter la bande passante de la mémoire.

| Date de sortie | Octobre 1999 | Février 2000 |

| Interface des cartes | PCI/AGP 4x | PCI/AGP 4x |

| Fillrate | 480 Mtexels/s | 480 Mtexels/s |

| Fillrate | 480 Mpixels/s | 480 Mpixels/s |

| Pipelines de rendu | 4 | 4 |

| Unité de texturing | 4 | 4 |

| Fréquence puce | 120 MHz | 120 MHz |

| Finesse de gravure | 0,22 µ | 0,22 µ |

| Nombre de transistors | 23 millions | 23 millions |

| Version DirectX | 7 | 7 |

| Type de mémoire | SDRAM | DDR |

| Mémoire maximale | 32 Mo | 32 Mo |

| Fréquence mémoire | 166 MHz | 150 MHz (x2) |

| Bus mémoire | 128 bits | 128 bits |

| Bande passante maximale | 2,6 Go/s | 4,8 Go/s |

| Sortie vidéo | 1x VGA | 1x VGA |

| RAMDAC | 350 MHz | 350 MHz |

| Gestion vidéo | MPEG2 semi-hardware | MPEG2 semi-hardware |

Notons que NVIDIA est passé directement de NV6 à NV10 pour la GeForce 256 et que les modèles suivants avanceront de 5 en 5, avec des variantes pour les modèles d’entrée/haut de gamme. De plus, la GeForce 256 est la première carte NVIDIA à prendre en compte l’accélération du format MPEG2, mais de façon partielle (Motion Compensation). Enfin, c’est aussi la première carte grand public qui a été équipée d’une prise DVI (via une puce externe).

NV15 : NVIDIA améliore la GeForce 256

Nous sommes en 2000, NVIDIA dispose d’une carte rapide (la GeForce 256 DDR) mais ATI commence à essayer de concurrencer réellement la firme du caméléon avec la Radeon, plus efficace et plus rapide. NVIDIA sort alors une nouvelle carte, la GeForce 2 GTS. Gravée en 180 nm, la carte est nettement plus rapide que la GeForce 256. De plus, elle double le nombre d’unités de texturing : on passe de 1 à 2 par pipeline de rendu, ce qui permet d’appliquer 8 textures en une passe. NVIDIA a sorti plusieurs versions de la carte : GTS (GigaTexel Shader, 200/166), Pro (200/200) et Ti (250/200).

| Date de sortie | Avril 2000 |

| Interface des cartes | PCI/AGP 4x |

| Fillrate | 1 600 Mtexels/s |

| Fillrate | 800 Mpixels/s |

| Pipelines de rendu | 4 |

| Unité de texturing | 8 |

| Fréquence puce | 200 MHz |

| Finesse de gravure | 0,18 µ |

| Nombre de transistors | 25 millions |

| Version DirectX | 7 |

| Type de mémoire | DDR |

| Mémoire maximale | 64 Mo |

| Fréquence mémoire | 166 MHz (x2) |

| Bus mémoire | 128 bits |

| Bande passante maximale | 5,3 Go/s |

| Sortie vidéo | 1x VGA |

| RAMDAC | 350 MHz |

| Gestion vidéo | MPEG2 semi-hardware |

Notons qu’en août 2000, en attendant la GeForce 3, NVIDIA a sorti le NV16 (GeForce 2 Ultra). Ce n’était pas une nouvelle carte mais un NV15 cadencé plus rapidement, 250 MHz pour le GPU et 230 MHz pour la mémoire contre 200 et 166 MHz sur la carte originale. C’est aussi une des cartes les plus onéreuses produites par la firme.

NV11 : la première déclinaison bas de gamme

Restons en 2000. La GeForce 2 GTS est performante, mais onéreuse et NVIDIA se doit de proposer une carte pour les amateurs de jeux qui ne sont pas capables de placer le SMIC dans une machine. La société développe donc le NV11, la GeForce 2 MX. Contrairement au TNT2 M64 et Vanta, qui n’était dans la pratique des des NV5 avec un bus mémoire 64 bits, les NV11 sont dotés d’une nouvelle architecture, dérivée de celle des GeForce 2 GTS. NVIDIA a supprimé une partie des pipelines de rendu, mais en multitexturing une GeForce 2 MX offre plus de puissance qu’une GeForce 256. C’est la première carte NVIDIA qui va permettre de gérer plusieurs écrans et cette fonction restera cantonnée au milieu de gamme encore quelques années. Rappelons enfin que la GeForce 2 MX dispose seulement de mémoire SDR et qu’elle a aussi été la première GeForce déclinée en version mobile (GeForce 2 Go).

| Date de sortie | Juin 2000 |

| Interface des cartes | PCI/AGP 4x |

| Fillrate | 700 Mtexels/s |

| Fillrate | 350 Mpixels/s |

| Pipelines de rendu | 2 |

| Unité de texturing | 4 |

| Fréquence puce | 175 MHz |

| Finesse de gravure | 0,18 µ |

| Nombre de transistors | 19 millions |

| Version DirectX | 7 |

| Type de mémoire | SDRAM |

| Mémoire maximale | 64 Mo |

| Fréquence mémoire | 166 MHz |

| Bus mémoire | 128 bits |

| Bande passante maximale | 2,6 Go/s |

| Sortie vidéo | 2x VGA/DVI |

| RAMDAC | 350 MHz |

| Gestion vidéo | MPEG2 semi-hardware |

NVIDIA a décliné la GeForce 2 MX en plusieurs versions, en plus du modèle classique et de la version Go. On retrouve la MX400 (équipée d’un GPU à 200 MHz), la MX200 (équipée d’un GPU à 175 MHz et de mémoire 64 bits à 166 MHz) et la très mauvaise MX100 qui proposait un GPU à 143 MHz seulement couplé à de la mémoire en 32 bits (0,6 Go/s de bande passante). Notons enfin les rares cartes équipées de DDR en 64 bits, globalement équivalentes aux versions SDR 128 bits.

NV20 : La GeForce 3 débarque

En 2001, la GeForce 3 débarque. Cette carte, la première compatible DirectX 8, supporte les pixels shaders programmables. Composée de 57 millions de transistors, la carte était assez conservatrice sur les fréquences et une GeForce 2 Ultra arrivait à la battre dans beaucoup de cas (à sa sortie). La carte dispose de quelques améliorations au niveau de la gestion de la mémoire, mais elle a le gros défaut d’utiliser une architecture complexe, qui a empêché NVIDIA de développer une version d’entrée de gamme.

| Date de sortie | Mars 2001 |

| Interface des cartes | PCI/AGP 4x |

| Fillrate | 2 000 Mtexels/s |

| Fillrate | 1 000 Mpixels/s |

| Pipelines de rendu | 4 |

| Unité de texturing | 8 |

| Unité de Vertex Shader | 1 |

| Version Pixel Shader | 1.1 |

| Fréquence puce | 250 MHz |

| Finesse de gravure | 0,15 µ |

| Nombre de transistors | 57 millions |

| Version DirectX | 8 |

| Type de mémoire | DDR |

| Mémoire maximale | 64 Mo |

| Fréquence mémoire | 230 MHz (x2) |

| Bus mémoire | 128 bits |

| Bande passante maximale | 7,4 Go/s |

| Sortie vidéo | 1x VGA |

| RAMDAC | 350 MHz |

| Gestion vidéo | MPEG2 semi-hardware |

NVIDIA a tout de même proposé deux versions différentes de la GeForce 3 : la Ti 200, un peu moins onéreuse que l’originale, et la Ti 500, plus chère. La première est cadencée à 175/200 (GPU/mémoire), la seconde à 240/250 MHz.

NV17 : La GeForce 4 qui est une GeForce 2

Passons en 2002 : NVIDIA dispose d’une carte performante, la GeForce 3, mais complexe. Créer une carte dérivée de son architecture (comme le NV11 en son temps) semble difficile et NVIDIA utilise donc l’architecture des GeForce 2 pour créer le NV17, appelé GeForce 4 MX. Les cartes utilisent la même architecture que les GeForce 2 MX (deux pipelines capables de rendre deux textures) mais avec des fréquences plus élevées. De plus, les cartes sont équipées de la gestion de la mémoire apparue avec les GeForce 3, décodent le MPEG2 de façon matérielle et supportent plusieurs écrans. Malgré tout, elles restent des cartes DirectX 7, dépassées au lancement même si les performances suivent dans certains cas. La gamme était composée de trois cartes : MX420, MX440 et MX460. La première cadencée à 250 MHz pour le GPU et 166 MHz (SDR) pour la mémoire, la seconde à 275/200 (DDR) et la dernière à 300/275 (DDR).

| Date de sortie | Février 2002 |

| Interface des cartes | PCI/AGP 4x |

| Fillrate | 1 100 Mtexels/s |

| Fillrate | 550 Mpixels/s |

| Pipelines de rendu | 2 |

| Unité de texturing | 4 |

| Fréquence puce | 275 MHz |

| Finesse de gravure | 0,15 µ |

| Nombre de transistors | 27 millions |

| Version DirectX | 7 |

| Type de mémoire | DDR |

| Mémoire maximale | 128 Mo |

| Fréquence mémoire | 200 MHz (x2) |

| Bus mémoire | 128 bits |

| Bande passante maximale | 6,4 Go/s |

| Sortie vidéo | 2x VGA/DVI |

| RAMDAC | 350 MHz |

| Gestion vidéo | MPEG2 hardware |

NVIDIA proposera, en plus des 3 versions 420, 440 et 460, des versions mobiles (GeForce 4 Go), des versions AGP 8x, avec la puce NV18 (qui n’apporte que le support de cette norme) et même une version PCI-Express en 2003, la PCX4300, équipée d’un bridge AGP 8x vers PCI-Express 16x.

NV2A : Une GeForce dans une console

En 2001, Microsoft sort sa première console de jeu, la Xbox. Elle est très proche d’un PC dans son architecture (elle utilise un processeur x86 et fonctionne sous Windows) et la carte graphique est d’origine NVIDIA. Le NV2A (c’est son nom) est une puce intermédiaire entre la GeForce 3 et la GeForce 4. Bien optimisée dans la Xbox, elle supporte DirectX 8.1 (à travers le noyau NT5 de la console) et a permis à la Xbox d’offrir des jeux impressionnants graphiquement pour l’époque.

| Date de sortie | Novembre 2001 |

| Interface des cartes | ? |

| Fillrate | 1 864 Mtexels/s |

| Fillrate | 932 Mpixels/s |

| Pipelines de rendu | 4 |

| Unité de texturing | 8 |

| Unité de Vertex Shader | 2 |

| Fréquence puce | 233 MHz |

| Finesse de gravure | 0,15 µ |

| Nombre de transistors | 63 millions |

| Version DirectX | 8.1 |

| Type de mémoire | DDR |

| Mémoire maximale | 64 Mo |

| Fréquence mémoire | 200 MHz (x2) |

| Bus mémoire | 128 bits |

| Bande passante maximale | 6,4 Go/s |

Pour la Xbox 360, c’est ATI qui va fournir la puce et NVIDIA va passer à l’ennemi avec la puce RSX de la PlayStation 3.

NV25 : GeForce 3 en mieux, la GeForce 4 Ti

La relève de la GeForce 3, sortie en février 2002, s’appelle GeForce 4 Ti. Assez proche dans son architecture du NV20 (GeForce 3), le NV25 est nettement plus rapide car il est gravé en 150 nm. NVIDIA a permis à la GeForce 4 Ti d’offrir trois fois (environ) la puissance en Vertex Shader des GeForce 3 en augmentant la fréquence et en doublant les unités de calcul. De plus, NVIDIA a amélioré le LMA, la technologie qui permet de limiter la bande passante mémoire utilisée en ne calculant pas les données qui ne sont pas affichées. NVIDIA a vendu trois versions de la carte : la Ti 4200, la Ti 4400 et la Ti 4600. La différence entre les cartes vient des fréquences : 250 MHz pour le GPU et 250 MHz pour la mémoire (Ti 4200), 275/275 sur la Ti 4400 et 300/325 sur la Ti 4600, dans le haut de gamme.

| Date de sortie | Février 2002 |

| Interface des cartes | PCI/AGP 4x |

| Fillrate | 2 400 Mtexels/s |

| Fillrate | 1 200 Mpixels/s |

| Pipelines de rendu | 4 |

| Unité de texturing | 8 |

| Unité de Vertex Shader | 2 |

| Version Pixel Shader | 1.3 |

| Fréquence puce | 300 MHz |

| Finesse de gravure | 0,15 µ |

| Nombre de transistors | 63 millions |

| Version DirectX | 8 |

| Type de mémoire | DDR |

| Mémoire maximale | 128 Mo |

| Fréquence mémoire | 325 MHz (x2) |

| Bus mémoire | 128 bits |

| Bande passante maximale | 10,4 Go/s |

| Sortie vidéo | 2x VGA |

| RAMDAC | 350 MHz |

| Gestion vidéo | MPEG2 semi-hardware |

Fin 2002, le NV28 est arrivé. Cette puce, proche du NV25, apporte simplement le support de l’AGP 8x aux cartes GeForce 4 Ti. La GeForce Ti 4800 (300/325) était d’ailleurs identique à la GeForce 4 Ti 4600 en dehors de cette compatibilité. Notons enfin que la GeForce Ti 4200 128 Mo disposait d’une bande passante inférieure à la version 64 Mo : la mémoire ne fonctionnait qu’à 222 MHz contre 250 MHz en version 64 Mo.

NV30 : NVIDIA rate une carte, la FX5800

En janvier 2003, NVIDIA sort la GeForce FX 5800 (NV30). Cette carte a été critiquée, tant pour ses performances (indignes d’une carte haut de gamme) que pour le bruit de sèche-cheveux de la carte. ATI et sa Radeon 9700 Pro disposait à l’époque d’une carte bien plus efficace et plus rapide. Le NV30 a été un échec commercial, même si NVIDIA se plaît parfois à affirmer que c’est une des meilleures choses qui soit arrivée à la société (dans le sens où elle a permis à la société de comprendre que rien n’est acquis).

| Date de sortie | Janvier 2003 |

| Interface des cartes | PCI/AGP 8x |

| Fillrate (Mtexels) | 3 200 Mtexels/s |

| Fillrate (Mpixels) | 1 600 Mpixels/s |

| Pipelines de rendu | 4 |

| Unités de texturing | 8 |

| Unité de Vertex Shader | 2 |

| Version Pixel Shader | 2.0a |

| Fréquence puce | 400 MHz |

| Finesse de gravure | 0,13 µ |

| Nombre de transistors | 125 millions |

| Version DirectX | 9 |

| Type de mémoire | DDR2 |

| Mémoire (en général) | 128 Mo |

| Fréquence mémoire | 400 MHz (x2) |

| Bus mémoire | 128 bits |

| Bande passante maximale | 12,8 Go/s |

| Sortie vidéo | 2x VGA |

| RAMDAC | 400 MHz |

| Gestion vidéo | MPEG2 hardware |

La version Ultra de la carte était encore plus rapide (ou plutôt moins lente) avec une fréquence de 500 MHz pour le GPU et la mémoire (en DDR2).

NV3x : NVIDIA décline les GeForce FX (et PCX)

Même après l’échec du NV30, NVIDIA va garder son architecture. La GeForce FX 5900 va succéder à la GeForce FX 5800 : bus mémoire sur 256 bits et amélioration de la puissance de calcul en Vertex Shader, la FX 5900 est une carte qui est arrivée à concurrencer les cartes concurrentes (Radeon 9800 Pro). NVIDIA a aussi décliné sa gamme GeForce FX en entrée et en milieu de gamme : FX5600 (NV31) et FX5700 (NV36) en milieu de gamme et FX5200 (NV34) en entrée de gamme. Notons que ces cartes ont une particularité : elles se faisaient battre par l’ancien milieu de gamme (GeForce 4 Ti 4200).

| Nom de la carte | NV35 (FX 5900) | NV31 (FX 5600) | NV36 (FX 5700) | NV34 (FX 5200) |

| Date de sortie | Mai 2003 | Mars 2003 | Octobre 2003 | Mars 2003 |

| Interface des cartes | PCI/AGP 8x | PCI/AGP 8x | PCI/AGP 8x | PCI/AGP 8x |

| Fillrate (Mtexels) | 3 200 Mtexels/s | 1 300 Mtextels/s | 1 700 Mtexels/s | 1 000 Mtexels/s |

| Fillrate (Mpixels) | 1 600 Mpixels/s | 1 300 Mpixels/s | 1 700 Mpixels/s | 1 000 Mpixels/s |

| Pipelines de rendu | 4 | 4 | 4 | 4 |

| Unités de texturing | 8 | 4 | 4 | 4 |

| Unité de Vertex Shader | 3 | 1 | 3 | 1 |

| Fréquence puce | 400 MHz | 325 MHz | 425 MHz | 250 MHz |

| Finesse de gravure | 0,13 µ | 0,13 µ | 0,13 µ | 0,13 µ |

| Nombre de transistors | 130 millions | 80 millions | 82 millions | 47 millions |

| Version DirectX | 9 | 9 | 9 | 9 |

| Version Pixel Shader | 2.0a | 2.0a | 2.0a | 2.0a |

| Type de mémoire | DDR | DDR | DDR | DDR |

| Mémoire (en général) | 256 Mo | 128 Mo | 256 Mo | 128 Mo |

| Fréquence mémoire | 425 MHz (x2) | 275 MHz (x2) | 250 MHz (x2) | 200 MHz (x2) |

| Bus mémoire | 256 bits | 128 bits | 128 bits | 128 bits |

| Bande passante maximale | 27,2 Go/s | 8,8 Go/s | 8 Go/s | 6,4 Go/s |

| Sortie vidéo | 2x VGA | 2x VGA | 2x VGA | 2x VGA |

| RAMDAC | 400 MHz | 350 MHz | 350 MHz | 350 MHz |

| Gestion vidéo | MPEG2 hardware | MPEG2 Hardware | MPEG2 Hardware | MPEG2 Hardware |

NVIDIA a aussi sorti des cartes PCI-Express, les GeForce PCX, mais il s’agissait essentiellement de cartes AGP équipées d’un bridge AGP vers PCI-Express. Enfin, certaines FX 5200 étaient équipées d’un bus 64 bits (au lieu de 128 bits) et d’une fréquence plus faible (166 contre 200 MHz) pour la mémoire.

NV40/NV45 : NVIDIA revient dans la course avec la GeForce 6800 et le SLI

Après l’échec du NV30, NVIDIA se devait de réagir. Chose que la société a parfaitement réussie avec le NV40, la GeForce 6800. Cette carte, extrêmement efficace, offre une puissance bien plus élevée que la FX 5900 au prix d’un nombre de transistors important (222 millions). Le NV45, aussi appelé GeForce 6800, n’est rien d’autre qu’un NV40 intégrant un bridge AGP vers PCI-Express, permettant à la carte de supporter cette nouvelle norme et surtout le SLI. Cette technologie permet de coupler deux cartes GeForce 6 en PCI-Express pour augmenter les performances.

| Date de sortie | Avril 2004 | Mars 2005 |

| Interface des cartes | AGP 8x | PCI-Express 16x |

| Fillrate (Mtexels) | 6 400 Mtexels/s | 6 400 Mtexels/s |

| Fillrate (Mpixels) | 6 400 Mpixels/s | 6 400 Mpixels/s |

| Pipelines de rendu | 16 | 16 |

| Unités de texturing | 16 | 16 |

| Unité de Vertex Shader | 6 | 6 |

| Fréquence puce | 400 MHz | 400 MHz |

| Finesse de gravure | 0,13 µ | 0,13 µ |

| Nombre de transistors | 222 millions | 222 millions |

| Version DirectX | 9c | 9c |

| Version Pixel Shader | 3.0 | 3.0 |

| Type de mémoire | GDDR3 | GDDR3 |

| Mémoire (en général) | 256 Mo | 256 Mo |

| Fréquence mémoire | 550 MHz (x2) | 550 MHz (x2) |

| Bus mémoire | 256 bits | 256 bits |

| Bande passante maximale | 35,2 Go/s | 35,2 Go/s |

| Sortie vidéo | 2x VGA | 2x VGA |

| RAMDAC | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware | MPEG2 hardware |

| Support multi-GPU | – | 2 |

Des cartes basées sur le NV41 et le NV42 ont aussi été produites. Le NV41 est un NV40 avec quelques unités en moins (12 pipelines et 5 unités de Vertex), utilisé dans certaines GeForce 6800 alors que le NV42 est un NV41 gravé en 110 nm (donc moins onéreux à produire).

NV4x : Les GeForce 6 envahissent le monde

Après les GeForce 6800, NVIDIA a dû sortir des cartes moins rapides mais aussi moins onéreuses. Le NV40 est puissant, mais les 222 millions de transistors limitent le rendement et augmentent le prix. Les deux cartes, les GeForce 6600 et 6200, auront un certain succès. Les GeForce 6600, gravées en 110 nm, étaient basées sur le NV43 et offraient des performances intéressantes pour un prix correct. Ces cartes, en version PCI-Express, pouvaient même fonctionner en SLI. Les GeForce 6600 sont les premières cartes NVIDIA nativement PCI-Express, les versions AGP utilisent un bridge PCI-Express vers AGP. Les GeForce 6200 sont des cartes d’entrée de gamme, peu puissante mais peu onéreuse : des versions PCI-Express, AGP, PCI et des versions intégrées dans les PC portables ont été produites.

| Date de sortie | Août 2004 | Août 2004 |

| Interface des cartes | PCI-Express 16x | PCI-Express 16x |

| Fillrate (Mtexels) | 4 000 Mtexels/s | 1 400 Mtexels/s |

| Fillrate (Mpixels) | 2 000 Mpixels/s | 700 Mpixels/s |

| Pipelines de rendu | 4 | 2 |

| Unités de texturing | 8 | 4 |

| Unité de Vertex Shader | 3 | 3 |

| Fréquence puce | 500 MHz | 350 MHz |

| Finesse de gravure | 0,11 µ | 0,11 µ |

| Nombre de transistors | 143 millions | 77 millions |

| Version DirectX | 9c | 9c |

| Version Pixel Shader | 3.0 | 3.0 |

| Type de mémoire | GDDR3 | GDDR3 |

| Mémoire (en général) | 128 Mo | 64 Mo |

| Fréquence mémoire | 450 MHz (x2) | 350 MHz (x2) |

| Bus mémoire | 128 bits | 64 bits |

| Bande passante maximale | 14,2 Go/s | 5,6 Go/s |

| Sortie vidéo | 2x VGA | 2x VGA |

| RAMDAC | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware | MPEG2 hardware |

| Support multi-GPU | 2 | – |

Les GeForce 6200 sont les premières cartes TurboCache du fabricant : en plus de la mémoire dédiée (de 16 à 512 Mo), la carte peut utiliser de la mémoire vive comme mémoire vidéo. Certains constructeurs en ont profité pour vendre des GeForce 6200 « 256 Mo » alors qu’elles étaient en fait équipées de seulement 64 Mo de mémoire dédiée. Notons aussi qu’une version intégrée du NV44, le GeForce 6100, a été intégrée dans certains chipsets NVIDIA. Gravée en 90 nm, cette puce n’offrait qu’un seul pipeline de rendu et ne proposait pas de mémoire dédiée.

G70 et G71 : NVIDIA change de nomenclature

En 2005, NVIDIA annonce les GeForce 7. Le nom de code des puces, qui était traditionnellement NVxx, passe à Gxx. La première carte est le G70 (GeForce 7800), suivie assez rapidement par le G71 (GeForce 7900). Plus puissante que les 6800, les GeForce 7800 sont une réussite pour NVIDIA. Notons que les cartes ont été déclinées dans énormément de versions : GTX, GS, etc. Des versions AGP, avec le bridge PCI-Express vers AGP, ont aussi été vendues.

| Date de sortie | Juin 2005 | Mars 2006 |

| Interface des cartes | PCI-Express 16x | PCI-Express 16x |

| Fillrate (Mtexels) | 13 200 Mtexels/s | 15 600 Mtexels/s |

| Fillrate (Mpixels) | 8 800 Mpixels/s | 10 400 Mpixels/s |

| Pipelines de rendu | 16 | 16 |

| Unités de texturing | 24 | 24 |

| Unité de Vertex Shader | 8 | 8 |

| Fréquence puce | 550 MHz | 650 MHz |

| Finesse de gravure | 0,11 µ | 0,09 µ |

| Nombre de transistors | 302 millions | 278 millions |

| Version DirectX | 9c | 9c |

| Version Pixel Shader | 3.0 | 3.0 |

| Type de mémoire | GDDR3 | GDDR3 |

| Mémoire (en général) | 512 Mo | 512 Mo |

| Fréquence mémoire | 850 MHz (x2) | 800 MHz (x2) |

| Bus mémoire | 256 bits | 256 bits |

| Bande passante maximale | 54,4 Go/s | 51,2 Go/s |

| Sortie vidéo | 2x VGA | 2x VGA |

| RAMDAC | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware, WMV9 semi-hardware | MPEG2 hardware, WMV9 semi-hardware |

| Support multi-GPU | 2 | 4 (2×2) |

Avec les GeForce 7900, NVIDIA utilise aussi pour la première fois une technique déjà proposée par ses concurrents : les cartes bi-GPU. Les 7900GX2 et 7950GX2 seront deux cartes équipées de deux G71 en parallèle. La société réutilisera cette technique en 2008, avec les GeForce 9800GX2.

G72 et G73 : L’entrée de gamme en GeForce 7

Comme d’habitude, NVIDIA a décliné son architecture haut de gamme en deux versions, une entrée de gamme (G72, GeForce 7300) et une milieu de gamme (G73, GeForce 7600). Les deux puces sont gravées en 90 nm et offrent des performances correctes, sans plus. Comme souvent, les versions mobiles utilisent les puces milieu de gamme et les GeForce 7300 Go ont été très populaires.

| Date de sortie | Janvier 2006 | Mars 2006 |

| Interface des cartes | PCI-Express 16x | PCI-Express 16x |

| Fillrate (Mtexels) | 2 200 Mtexels/s | 6 720 Mtexels/s |

| Fillrate (Mpixels) | 1 100 Mpixels/s | 4 480 Mpixels/s |

| Pipelines de rendu | 2 | 8 |

| Unité de texturing | 4 | 12 |

| Unité de Vertex Shader | 3 | 5 |

| Fréquence puce | 550 MHz | 560 MHz |

| Finesse de gravure | 0,09 µ | 0,09 µ |

| Nombre de transistors | 112 millions | 177 millions |

| Version DirectX | 9c | 9c |

| Version Pixel Shader | 3.0 | 3.0 |

| Type de mémoire | GDDR | GDDR3 |

| Mémoire (en général) | 128 Mo | 256 Mo |

| Fréquence mémoire | 400 MHz (x2) | 700 MHz (x2) |

| Bus mémoire | 64 bits | 128 bits |

| Bande passante maximale | 6,4 Go/s | 22,4 Go/s |

| Sortie vidéo | 2x VGA | 2x VGA + 2x TDMS |

| RAMDAC | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware, WMV9 semi-hardware | MPEG2 hardware, WMV9 semi-hardware |

| Support multi-GPU | – | 2 |

Notons que des versions portables moins rapides (7200 Go) et plus rapides (7400 Go) ont été proposées. De plus, une version 80 nm du G73 a aussi éte vendues par NVIDIA.

G80 et G92 : NVIDIA et la 8800, GeForce 8 ou GeForce 9 ?

Novembre 2006, NVIDIA annonce le G80. Cette puce, et ses dérivés auront une durée de vie très élevée : en mai 2008, les cartes les plus rapides utilisent encore une puce très proche de ce G80 (le G92). NVIDIA va user jusqu’à la corde les cartes à base de G80 et le passage en 65 nm avec le G92 va permettre à la société de faire des économies sur le coût de la puce. NVIDIA va modifier le nombre de processeurs de flux, la largeur du bus mémoire et la fréquence pour proposer énormément de versions des GeForce 8800 et 9800. Une version équipée de 2 GPU existe même, la GeForce 9800GX2. Les GeForce 8800 sont toutes DirectX 10 et NVIDIA a réussi un coup de maître avec cette série, en attendant les GeForce GTX.

| Date de sortie | Novembre 2006 | Avril 2008 |

| Interface des cartes | PCI-Express 16x | PCI-Express 16x (2.0) |

| Fillrate (Mtexels) | 18 400 Mtexels/s | 43 875 Mtexels/s |

| Fillrate (Mpixels) | 13 800 Mpixels/s | 10 800 Mpixels/s |

| Pipelines de rendu | 24 | 16 |

| Unités de texturing | 32 | 64 |

| Stream Processors | 128 | 128 |

| Fréquence puce | 575 MHz | 675 MHz |

| Fréquence shaders | 1 350 MHz | 1 688 MHz |

| Finesse de gravure | 0,09 µ | 0,065 µ |

| Nombre de transistors | 681 millions | 754 millions |

| Version DirectX | 10 | 10 |

| Version Pixel Shader | 4.0 | 4.0 |

| Type de mémoire | GDDR3 | GDDR3 |

| Mémoire (en général) | 768 Mo | 512 Mo |

| Fréquence mémoire | 900 MHz (x2) | 1 100 MHz (x2) |

| Bus mémoire | 384 bits | 256 bits |

| Bande passante maximale | 86,4 Go/s | 70,4 Go/s |

| Sortie vidéo | NVIO | 2x TDMS (DualLink), HDCP |

| RAMDAC | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware, WMV9 semi-hardware | MPEG2 hardware, H.264 hardware |

| Support multi-GPU | 3 | 3 |

Rions un brin, et vérifions toutes les GeForce 8800 sorties : 8800GS 374, 8800GS 768, 8800GTS 320, 8800GTS 640, 8800GTS 640 v2, 8800GTS 512, 8800GT 256, 8800GT 512, 8800GT 1024, 8800GTX 768 et 8800 Ultra 768. Rajoutons les 9600GSO 512, 9600GSO 384 et 9600GSO 768 ainsi que les 9800GX2 et 9800GTX et n’oublions pas les futures 9800GTS et 9800GT. Nous sommes sympathiques, nous n’avons pas parlé des versions mobiles.

G8x et G94 : GeForce 8 en entrée de gamme

Pour arriver à vendre des cartes en entrée de gamme, NVIDIA a dû sévèrement modifier le G80. Étant donné le nombre de transistors de ce dernier, il était hors de question de l’utiliser tel quel. La société a proposé trois puces (globalement) : GeForce 8400 (G86), GeForce 8600 (G84) et GeForce 9600 (G94). D’autres versions existent (GeForce 8300, 8500, etc.) mais ces trois modèles sont les plus importants. Notons que le G84 a été beaucoup utilisé dans les PC portables, comme carte haut de gamme, alors que dans les PC de bureau il s’agit d’un (faible) milieu de gamme.

| Date de sortie | Avril 2007 | Juin 2007 | Février 2008 |

| Interface des cartes | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x (2.0) |

| Fillrate (Mtexels) | 3 600 Mtexels/s | 8 640 Mtexels/s | 20 800 Mtexels/s |

| Fillrate (Mpixels) | 1 800 Mpixels/s | 4 320 Mpixels/s | 10 400 Mpixels/s |

| Pipelines de rendu | 4 | 8 | 16 |

| Unités de texturing | 8 | 16 | 32 |

| Stream Processors | 16 | 32 | 64 |

| Fréquence puce | 450 MHz | 540 MHz | 650 MHz |

| Fréquence shaders | 900 MHz | 1 180 MHz | 1 625 MHz |

| Finesse de gravure | 0,08 µ | 0,08 µ | 0,065 µ |

| Nombre de transistors | 210 millions | 289 millions | 505 millions |

| Version DirectX | 10 | 10 | 10 |

| Version Pixel Shader | 4.0 | 4.0 | 4.0 |

| Type de mémoire | DDR2 | GDDR3 | GDDR3 |

| Mémoire (en général) | 256 Mo | 256 Mo | 512 Mo |

| Fréquence mémoire | 400 MHz (x2) | 700 MHz (x2) | 900 MHz (x2) |

| Bus mémoire | 64 bits | 128 bits | 256 bits |

| Bande passante maximale | 6,4 Go/s | 22,4 Go/s | 57,6 Go/s |

| Sortie vidéo | 2x TDMS (DualLink), HDCP | 2x TDMS (DualLink), HDCP | 2x TDMS (DualLink), HDCP |

| RAMDAC | 400 MHz | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware, H.264 hardware | MPEG2 hardware, H.264 hardware | MPEG2 hardware, H.264 hardware |

| Support multi-GPU | – | 2 | 2 |

Autant le G80 est les GeForce 8800 sont un succès autant les GeForce 8600 et Geforce 8400 sont des cartes très moyennes. L’écart entre le haut de gamme et le milieu de gamme (avant l’arrivée des GeForce 9600) est très important sur cette génération, ce qui est problématique dans les jeux.

Les GTX 2xx, une franche réussite en haut de gamme

En juin 2008, après quelques errances avec les GeForce 9, NVIDIA annonce la GeForce GTX 280. Cette carte est basée sur le GT200, une puce énorme — 1,3 milliard de transistors en 65 nm — et coûteuse. Performantes avec ses 240 processeurs de flux et sa mémoire GDDR3 sur 512 bits, la carte est malgré tout assez peu vendue, à cause de son prix élevé. La puce a été déclinée en quelques versions (GTX 260, 275, 285 et 295) et NVIDIA a proposé, en 2009, une version en 55 nm, plus simple à produire. La GTX 295, une carte bi-GPU haut de gamme, a longtemps été la carte la plus rapide disponible.

| Date de sortie | Juin 2008 | Janvier 2009 |

| Interface des cartes | PCI-Express 16x (2.0) | PCI-Express 16x (2.0) |

| Fillrate (Mtexels) | 48 100 Mtexels/s | 92 000 Mtexels/s |

| Fillrate (Mpixels) | 19 200 Mpixels/s | 32 200 Mpixels/s |

| Pipelines de rendu | 32 | 56 (2x 28) |

| Unités de texturing | 80 | 160 (2x 80) |

| Stream Processors | 240 | 480 (2x 240) |

| Fréquence puce | 602 MHz | 576 MHz |

| Fréquence shaders | 1 296 MHz | 1 242 MHz |

| Finesse de gravure | 0,065 µ | 0,055 µ |

| Nombre de transistors | 1,4 milliard | 2 x 1,4 milliard |

| Version DirectX | 10 | 10 |

| Version Pixel Shader | 4.0 | 4.0 |

| Type de mémoire | GDDR3 | GDDR3 |

| Mémoire (en général) | 1 024 Mo | 896 Mo (2x 896 Mo) |

| Fréquence mémoire | 1 107 MHz (x2) | 999 MHz (x2) |

| Bus mémoire | 512 bits | 896 bits (2x 448 bits) |

| Bande passante maximale | 141,7 Go/s | 223,8 Go/s |

| Sortie vidéo | 2x TDMS (DualLink), HDCP | 4x TDMS (DualLink), HDCP |

| RAMDAC | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware, H.264 hardware | MPEG2 hardware, H.264 hardware |

| Support multi-GPU | 3 | 2 |

Notons que les cartes basées sur le GT200 et le GT200b sont restées longtemps dans les bacs et que NVIDIA semble avoir du mal à lancer la carte suivante, la GTX 480 alias Fermi.

GeForce 100, 200 et 300 : descente aux enfers

Après la sortie de la GeForce GTX 280 en juin 2008 et jusqu’en 2010, NVIDIA n’a pas annoncé de véritables nouveaux produits. Et la société, pour combler le vide médiatique que l’absence de produits créait, a décidé de renommer ses cartes. Concrètement, les GeForce 100, 200 et 300 sont soit des puces renommées soit des adaptations des puces existantes. En effet, NVIDIA a réussi, après de longs mois, à produire une gamme de produits d’entrée de gamme en 40 nm et compatible DirectX 10.1.

| Date de sortie | Mars 2009 | Octobre 2009 | Février 2010 |

| Interface des cartes | PCI-Express 16x (2.0) | PCI-Express 16x (2.0) | PCI-Express 16x (2.0) |

| Fillrate (Mtexels) | 12 000 Mtexels/s | 10 000 Mtexels/s | 7 600 Mtexels/s |

| Fillrate (Mpixels) | 8 000 Mpixels/s | 5 000 Mpixels/s | 3 800 Mpixels/s |

| Pipelines de rendu | 16 | 8 | 8 |

| Unités de texturing | 24 | 16 | 16 |

| Stream Processors | 48 | 48 | 48 |

| Fréquence puce | 500 MHz | 625 MHz | 475 MHz |

| Fréquence shaders | 1 250 MHz | 1 360 MHz | 1 100 MHz |

| Finesse de gravure | 0,055 µ | 0,04 µ | 0,04 µ |

| Nombre de transistors | 505 millions | 486 millions | 486 millions |

| Version DirectX | 10 | 10.1 | 10.1 |

| Version Pixel Shader | 4.0 | 4.1 | 4.1 |

| Type de mémoire | DDR2 | DDR3 | DDR2 |

| Mémoire (en général) | 768 Mo | 1 024 Mo | 512 Mo |

| Fréquence mémoire | 500 MHz (x2) | 790 MHz (x2) | 790 MHz (x2) |

| Bus mémoire | 192 bits | 128 bits | 64 bits |

| Bande passante maximale | 24 Go/s | 25,3 Go/s | 12,6 Go/s |

| Sortie vidéo | 2x TDMS (DualLink), HDCP | 2x TDMS (DualLink), HDCP | 2x TDMS (DualLink), HDCP |

| Gestion de l’audio | – | HD Audio | HD audio |

| RAMDAC | 400 MHz | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware, H.264 hardware | MPEG2 hardware, H.264 hardware | MPEG2 hardware, H.264 hardware |

| Support multi-GPU | 2 | 2 | 2 |

Bien évidemment, cette situation n’est intéressante ni pour les constructeurs (qui doivent essayer de vendre des produits identiques sous plusieurs noms) ni pour les utilisateurs, qui considèrent (à raison) la gamme comme confuse.

ION, la renaissance ?

En octobre 2008, Intel annonce le MCP79, qui deviendra par la suite (avec la sortie de l’Atom) la plateforme ION. Ce chipset est très intéressant : il intègre (dans une seule puce) une GeForce 9, un northbridge (DDR2 et DDR3) et un southbridge. Très populaire, il sera à la base d’une majorité de machines d’Apple en 2009 et présent dans beaucoup de netbooks. L’ION aura aussi une seconde vie en 2010 avec ION « next gen » qui — fidèle à la récente réputation de NVIDIA — est un simple renommage d’une GeForce 210…

| Date de sortie | Octobre 2008 | Mars 2010 |

| Interface des cartes | Interne | PCI-Express 1x |

| Fillrate (Mtexels) | 3 600 Mtexels/s | 4 712 Mtexels/s |

| Fillrate (Mpixels) | 1 800 Mpixels/s | 2 356 Mpixels/s |

| Pipelines de rendu | 4 | 4 |

| Unités de texturing | 8 | 8 |

| Stream Processors | 16 | 16 |

| Fréquence puce | 450 MHz | 589 MHz |

| Fréquence shaders | 1 100 MHz | 1 402 MHz |

| Finesse de gravure | 0,065 µ | 0,04 µ |

| Nombre de transistors | 282 millions | 260 millions |

| Version DirectX | 10 | 10.1 |

| Version Pixel Shader | 4.0 | 4.1 |

| Type de mémoire | DDR2/DDR3 partagée | DDR3 |

| Mémoire (en général) | 256 Mo partagés | 512 Mo |

| Fréquence mémoire | 400 MHz (x2) / 533 MHz (x2) | 790 MHz (x2) |

| Bus mémoire | 128 bits | 64 bits |

| Bande passante maximale | 25,6 Go/s / 34,1 Go/s (partagée) | 12,6 Go/s |

| Sortie vidéo | 2x TDMS (DualLink), HDCP | 4x TDMS (DualLink), HDCP |

| Gestion de l’audio | HD Audio (chipset) | HD Audio (dans la puce) |

| RAMDAC | 400 MHz | 400 MHz |

| Gestion vidéo | MPEG2 hardware, H.264 hardware | MPEG2 hardware, H.264 hardware |

| Support multi-GPU | – | – |

Dans les faits, ION était une bonne surprise à la base mais il manque de puissance dans sa seconde version, à cause des limitations imposées par Intel (notamment au niveau du PCI-Express). Notons que les netbooks 10 pouces ont une version moins rapides d’ION, limitée à 8 processeurs de flux.

La GeForce GTX 480, une déception

La GeForce GTX 480, c’est une déception. Attendue en novembre 2009 avec 512 processeurs de flux, elle sort à la fin du mois de mars avec 480 processeurs de flux, elle chauffe énormément et elle n’est que marginalement plus rapide que la Radeon HD 5870, sortie en septembre 2009. Plus gênant, la consommation est extrêmement élevée (pas loin de 300 W) et le prix est assez haut. Dans les faits, la carte semble par contre (très) performante en GPGPU, même si ce n’est pas un domaine qui intéresse les joueurs.

| Date de sortie | Mars 2010 |

| Interface des cartes | PCI-Express 16x (2.0) |

| Fillrate (Mtexels) | 42 000 Mtexels/s |

| Fillrate (Mpixels) | 33 600 Mpixels/s |

| Pipelines de rendu | 60 |

| Unités de texturing | 48 |

| Stream Processors | 480 |

| Fréquence puce | 700 MHz |

| Fréquence shaders | 1 401 MHz |

| Finesse de gravure | 0,04 µ |

| Nombre de transistors | 3,2 milliards |

| Version DirectX | 11 |

| Version Pixel Shader | 5.0 |

| Type de mémoire | GDDR5 |

| Mémoire (en général) | 1 536 Mo |

| Fréquence mémoire | 924 MHz (x4) |

| Bus mémoire | 384 bits |

| Bande passante maximale | 177 Go/s |

| Sortie vidéo | 2x TDMS (DualLink), HDCP |

| Gestion de l’audio | HD Audio |

| RAMDAC | 400 MHz |

| Gestion vidéo | MPEG2 hardware, H.264 hardware |

| Support multi-GPU | 3 |

Au final, la carte déçoit, tout comme son pendant moins onéreux la GeForce GTX 470.

Le futur

Dans le futur, NVIDIA devrait proposer une nouvelle puce dans les prochains mois. Basée sur Fermi, alias la GeForce GTX 480, elle serait moins rapide, mais plus simple à produire. Pour le reste, cet article a permis de montrer que NVIDIA n’a pas connu que des réussites et que les débuts de la société ont été difficiles, mais il montre aussi que la firme au caméléon a réussi, avec AMD, à supprimer la majorité de la concurrence dans le domaine des cartes graphiques pour les joueurs. Rappelons tout de même que la société qui vend le plus de solutions graphiques pour PC n’est ni NVIDIA ni AMD/ATI mais bien Intel, avec 50 % du marché environ. De plus, nous avons volontairement omis de donner les caractéristiques des cartes graphiques professionnelles (les Quadro) et les versions mobiles. Les premières parce que la différence intervient essentiellement sur le prix et les pilotes, les secondes car NVIDIA ne fait que recommander des fréquences et pas imposer, ce qui fait qu’il peut y avoir d’énormes différences entre deux cartes portant le même nom. De même, nous n’avons fait que survoler les IGP, d’une part parce qu’ils sont rares, d’autre part parce que les performances 3D sont généralement risibles (et qu’il s’agit dans tous les cas d’une version intégrée de l’architecture d’entrée de gamme), même si ION a un peu changé la donne.