Introduction

Le monde du stockage est dans une phase d’évolution intéressante. Alors qu’il y a quelques années les disques durs étaient le seul dispositif de stockage viable, depuis quelque temps on voit apparaître une alternative : la mémoire flash. Elle a le vent en poupe actuellement, car elle est de plus en plus rapide et de moins en moins onéreuse, et les constructeurs commencent à lui trouver de l’intérêt. Il y a bientôt 4 ans, nous avions écrit un dossier sur les SSD, qui commençaient à pointer leur nez. Il nous a paru pertinent de mettre à jour ce dossier afin de prendre en compte les dernières évolutions dans ce domaine.

Les SSD (pour Solid State Drive, contrôleur à semi-conducteurs) sont des dispositifs qui utilisent autre chose que la technologie magnétique des disques durs pour stocker des données. Un appareil comme l’iRAM est un SSD, par exemple, mais on utilise essentiellement l’acronyme pour les dispositifs à base de mémoire flash.

Pour mémoire, dans le premier dossier qui date de mai 2007 nous testions des SSD en interface PATA, capables d’atteindre 50 Mo/s en lecture pour le premier et 20 Mo/s pour le second. La capacité était de 32 et 8 Go et le prix du modèle de 32 Go frôlait les 1 000 €. Actuellement, les SSD de la dernière génération atteignent plus de 500 Mo/s en lecture et offrent 512 Go de capacité pour le même prix.

MAJ : Consultez notre comparatif de SSD

La mémoire flash, comment ça fonctionne ?

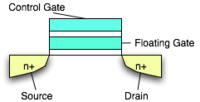

La mémoire flash NAND est une mémoire de stockage qui utilise des transistors comme support. Son fonctionnement est basé sur l’effet tunnel (plus précisément l’effet Fowler-Nordheim).

En simplifiant, les transistors utilisés dans la mémoire flash contiennent deux grilles, une de contrôle et une deuxième, appelée grille flottante, qui est en suspension dans un oxyde, le tout est placé sur un substrat qui contient deux électrodes.

Pour écrire une donnée, on doit faire passer un courant électrique (7 V) entre les deux électrodes (drain et source) et une tension plus élevée (aux environs de 12 V) dans la grille de contrôle. L’effet Fowler-Nordheim implique qu’une partie des électrons qui passent entre les électrodes va se déplacer vers la grille flottante, à travers l’oxyde. Une fois la grille saturée avec des électrons, elle devient isolante et est considérée comme un 0 binaire.

L’effacement d’une cellule s’effectue de la même façon, mais en faisant passer une tension négative dans la grille de contrôle. Les électrons se déplacent alors de la grille flottante vers le substrat. Une fois la grille flottante « vidée » de ses électrons, elle est considérée comme un 1 binaire.

Pour la lecture, c’est assez simple : il faut mesurer la résistance de la grille flottante, en faisant passer une tension faible (5 V) dans la grille de contrôle et dans une des électrodes. Si les électrons passent entre la grille de contrôle et l’électrode, la grille flottante n’est pas isolante, on a un 1 binaire. Si le courant ne passe pas, on a un 0 binaire. La lecture est donc plus rapide que l’écriture ou l’effacement, car on ne doit pas remplir ou vider la grille flottante avec des électrons.

Mémoire SLC et mémoire MLC

Notons qu’il existe deux types de NAND, la SLC (Single Layer Cell) qui stocke un seul bit dans la grille flottante, et la MLC (Multi Layer Cell), qui stocke plusieurs bits dans la même cellule. Techniquement, la MLC divise la grille flottante en deux parties, avec une différence de tension entre les deux parties. On peut donc doubler la capacité de stockage en gardant la même taille physique, ce qui est évidemment avantageux. La mémoire MLC a cependant des défauts : comme on doit travailler avec plusieurs tensions différentes, l’écriture et l’effacement des données sont plus lents qu’avec de la SLC. La lecture reste rapide, mais pas autant qu’avec de la mémoire SLC (environ 80 % du débit d’une SLC équivalente).

La flash NAND et l’organisation en blocs

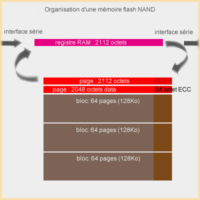

La mémoire flash NAND travaille avec un bus série, en accès séquentiel. Il est impossible d’accéder directement à un bit en particulier, contrairement à la mémoire NOR. Pour accéder à une information précise, on doit charger entièrement une partie des données dans une petite mémoire RAM, et ensuite lire ce que l’on veut dans cette mémoire.

Dans un système classique (une mémoire de 16 Go par exemple) on va travailler avec des blocs de 256 ou 512 ko. Le bloc est divisé en 64 ou 128 pages de 4 ko. En réalité, une « page » fait plus que 4 ko : on a 4 096 octets accessibles, et 128 octets qui servent de contrôle (gestion ECC, etc.). Les anciens systèmes (ou ceux de faible capacité) travaillent plutôt avec des pages de 2 ko avec des 64 octets de gestion et des blocs de 128 ko.

Pour ce qui est de l’accès, on travaille en shadowing : le système accède en fait à une mémoire RAM qui contient les données demandées. On n’accède jamais directement aux données stockées dans la mémoire NAND. Le contrôleur s’occupe de gérer la copie de la page dans la mémoire en question et de la gestion des blocs.

Lecture sur une page, écriture sur un bloc

L’interface séquentielle oblige aussi à travailler avec la page comme unité minimale pour la lecture. Si on veut accéder à un bit précis, il faut charger entièrement une page. Cette particularité explique que la mémoire flash manque parfois d’efficacité avec les très petits fichiers : la lecture d’un fichier de la taille d’une page (généralement 4 ko) et d’un fichier plus petit prend le même temps.

Pour l’écriture, on travaille au niveau du bloc : la moindre écriture oblige à effacer entièrement le bloc de données avant d’écrire une nouvelle valeur. On a donc le même problème qu’en lecture, écrire 1 bit ou écrire 256 ko (taille typique d’un bloc) nécessite le même temps au final : on doit reprogrammer entièrement le bloc. En pratique, l’écriture de petits fichiers (sous les 256 ko) est donc assez lente avec de la mémoire flash.

Parlons un peu performances : du fait de son mode de fonctionnement (séquentiel), l’accès aux données n’est pas instantané. Il faut compter environ 25 µs pour un accès à une page (temps de copie dans la RAM interne). L’accès aux autres pages du bloc est plus rapide (environ 0,03 µs), alors que l’effacement d’un bloc prend environ 2 ms.

En comparaison, sur des mémoires de type NOR, la lecture aléatoire d’une donnée est de 12 µs (quel que soit l’emplacement de celle-ci) et l’effacement d’un bloc est très lent : 750 ms.

Dans les contrôleurs actuels, une mémoire cache permet de regrouper en partie les écritures pour éviter d’effacer des blocs en masse, même si le fonctionnement de cette mémoire cache varie en fonction des contrôleurs utilisés et que tous les contrôleurs n’utilisent pas cette technique.

La durée de vie de la mémoire flash

Une des remarques que l’on voit le plus dès que l’on parle de la mémoire flash, c’est sa durée de vie. Nous allons expliquer la raison de cette durée de vie limitée, et pourquoi ce n’est pas véritablement un problème actuellement.

Pourquoi la durée de vie est-elle limitée ?

Il y a deux raisons à la durée de vie limitée de la mémoire flash. La première vient de l’oxyde utilisé pour séparer les grilles. Comme nous l’avons vu, les électrons doivent traverser cet oxyde pour passer dans la grille flottante ou en sortir. De temps en temps, il peut arriver que des électrons restent captifs de cet oxyde, et soient relâchés plus tard, ce qui peut perturber les écritures et la lecture.

La deuxième vient de la structure de la grille flottante elle-même : avec le temps, les tensions élevées peuvent l’endommager, ce qui à terme va la rendre inutilisable. On considère généralement qu’une cellule de mémoire SLC peut subir environ 100 000 écritures avant destruction, et que la mémoire MLC est moins endurante : entre 3 000 et 10 000 cycles d’écriture, en fonction de la finesse de gravure. Une mémoire intermédiaire, la eMLC, atteint 30 000 cycles.

Comment remédier au problème ?

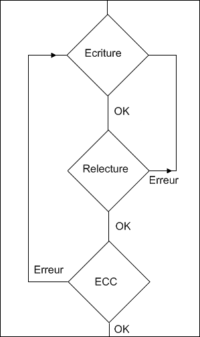

La majorité des dispositifs utilisant de la mémoire flash disposent d’un contrôleur interne, qui va gérer les accès à la mémoire. Il est utilisé pour les transferts de données, mais aussi pour vérifier que le dispositif fonctionne bien.

Ce contrôleur vérifie automatiquement les écritures en relisant la dernière donnée écrite. S’il lui est impossible de la relire, le bloc complet est déterminé comme défectueux et l’écriture est relancée sur un autre bloc. Donc sauf si la mémoire flash est entièrement utilisée ou défectueuse, les données seront écrites sur le support.

La deuxième vérification s’effectue aussi durant l’écriture, avec la correction d’erreurs ECC. Toutes les puces de mémoire flash disposent de bits de contrôle, qui servent à la vérification des données écrites. En général, le contrôle ECC permet de corriger les erreurs de 1 bit et de détecter les erreurs sur 2 bits. Dans ce deuxième cas, le bloc est indiqué comme défectueux et l’écriture relancée sur un autre bloc.

Une petite explication sur le fonctionnement. On dispose de 3 octets d’ECC par bloc de 512 octets (donc 24 bits). À chaque écriture, le code ECC est calculé et écrit dans la zone inutilisée des blocs de données. Pendant la relecture, le code ECC des données est calculé et comparé au code ECC de départ (celui calculé à l’écriture). Si les deux codes sont identiques, le travail continue. Le premier cas intervient s’il y a une erreur sur 1 bit, à ce moment-là c’est corrigé et l’écriture continue. Enfin, il se peut qu’il y ait une erreur de 2 bits, ou une erreur dans le code ECC lui-même. Ces deux cas spécifiques ne sont pas corrigibles, et l’écriture est relancée sur un autre bloc et le bloc est indiqué comme défectueux. La mémoire réservée, dont nous parlons dans les prochaines pages, sert à gérer ce genre de cas.

La gestion de l’usure

Bien évidemment, les constructeurs se sont penchés sur ce problème de la durée de vie, et ils ont implémenté plusieurs techniques pour limiter l’usure de la mémoire NAND, c’est ce qu’on appelle le Wear Leveling, ou gestion de l’usure.

Dans une clé USB ou un périphérique de stockage comme une carte mémoire le fonctionnement est simple : le contrôleur va intercepter les écritures et les distribuer aléatoirement sur des blocs situés dans l’espace libre. Comme les écritures ne seront plus concentrées sur le même bloc physique, on ne risque pas de détruire un bloc en particulier si un programme écrit en permanence sur le même fichier. Le problème de cette technique est simple : si l’espace libre est trop faible, les écritures vont se faire fréquemment sur les mêmes blocs, qui vont s’user et donc devenir inutilisables.

Le Static Wear Leveling

La technique utilisée est bien plus complexe. Le contrôleur enregistre le nombre d’écritures sur chaque bloc, et la dernière date d’utilisation de celui-ci. Il est donc capable de déterminer la fréquence d’utilisation d’un bloc et son usure. Si on doit écrire une donnée, il va d’abord chercher le bloc qui a subi le moins de cycles. S’il est libre, le contrôleur l’utilise. Par contre, si le bloc contient des données, il va vérifier la dernière fois qu’il a été écrit et déterminer si c’est une donnée statique (pas d’écriture depuis x temps) ou bien dynamique (le bloc a été écrit récemment).

Si c’est une donnée statique, il va la déplacer vers un bloc usé et mettre la nouvelle donnée à sa place. Si c’est une donnée dynamique qui se trouve sur le bloc, il va en chercher un autre. L’intérêt de la technique consiste à placer les données qui ne sont pas souvent écrites sur des blocs usés et de placer les données souvent modifiées sur des blocs qui ont subi peu d’écriture. Cette technologie permet de garder une usure constante sur le support, et de ce fait d’augmenter la durée de vie globale.

Une explication en image

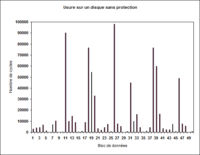

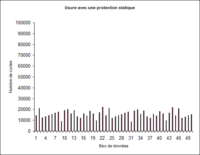

Voici deux graphiques qui montrent l’usure schématique d’un SSD après un usage simulé de quelques mois (le même nombre de cycles a été effectué dans les deux cas). Ces graphiques sont théoriques, mais se rapprochent assez de ce qui se passe en pratique pour être intéressants à analyser.

Ce graphique montre un SSD sans protection après un usage simulé de quelques mois. On remarque qu’un certain nombre de blocs ont été utilisés énormément et qu’une grande partie des blocs ont été peu écrits. Des pics d’usures sont présents, et peuvent potentiellement empêcher l’usage du support. C’est une estimation, car les constructeurs ne permettent pas de mesurer l’usure d’un support de façon complète : dans le meilleur des cas, on récupère l’usure de la cellule la moins usée, celle de la cellule plus usée et l’usure moyenne.

Sur ce graphique, on remarque que l’usure moyenne est un peu plus élevée, mais qu’il n’y a pas un seul pic d’usure. Comme on écrit souvent sur un disque, les données vont tourner sur tout le support, ce qui explique qu’on a une vague à la place d’une ligne droite. Si à un instant T, une donnée statique est sur le bloc le plus usé, à l’instant T+10, ce bloc peut devenir le moins usé, et donc les données sont en rotation sur l’entièreté du support. On a une moyenne d’utilisation faible, mais pas totalement homogène.

Conclusion sur la durée de vie

Au final, selon les constructeurs, avec les blocs de réserve et la technique du Static Wear Leveling, la durée de vie des SSD est supérieure à celle des disques durs. Point intéressant, la durée de vie augmente avec la capacité, étant donné qu’on dispose de plus de blocs pour distribuer les écritures.

De plus, la majorité des pannes sur les supports de stockage vient en général d’une défaillance mécanique, et les SSD sont dépourvus de pièces en mouvement, ce qui les protège évidemment de ce type de panne.

Durée de vie : on est en train de tester

Pour la durée de vie, nous sommes en train d’effectuer quelques tests. Même s’ils ne sont pas représentatifs de la réalité, ils vont servir à une chose : définir le comportement d’un SSD quand il est complètement usé.

Dans nos tests, nous écrivons en boucle sur un SSD basé sur un contrôleur Indilinx. La mémoire de ce modèle est gravée en 43 nm et est en théorie capable d’encaisser 10 000 cycles d’écriture. Pour l’usure, nous avons donc décidé de remplir le SSD de 128 Go et de laisser uniquement l’espace nécessaire à la copie (et la suppression) en boucle d’un fichier de 1 To.

Actuellement, le test est en cours depuis environ 3 mois et nous avons écrit pas loin de 450 To sur le SSD. Pour se donner une idée, les constructeurs indiquent qu’un utilisateur moyen écrit entre 2 et 3 Go de données par jour, alors qu’un utilisateur « avancé » est aux alentours de 10 Go. Dans nos tests, nous écrivons en moyenne 5 To par jour.

Nous vous invitons à aller lire les comptes-rendus de notre test, qui sont publiés à intervalles réguliers sur Tom’s Hardware.

- Durée de vie des SSD : on va tester [1]

- Durée de vie des SSD : premier bilan [2]

- Durée de vie des SSD : en 25 nm il serait mort (3)

- Durée de vie des SSD : presque 250 To (4)

- Durée de vie des SSD : en 34 nm, il serait mort (5)

- Durée de vie des SSD : on a passé 400 To (6)

- Durée de vie des SSD : d’autres SSD testés (7)

La capacité en question

La mémoire flash, comme la mémoire RAM, offre une capacité qui est une puissance de deux. Une puce de 8 « Go » offre en fait une capacité réelle de 8 Gio, soit 8 589 934 592 octets. Dans les SSD, une partie de cette mémoire est réservée, c’est ce que l’on appelle l’overprovisioning. Cette mémoire réservée sert à plusieurs choses : à la gestion de l’usure, en cas de problèmes quand un bloc est défectueux, etc.

Généralement 7,3 %

Dans un SSD classique, la mémoire réservée est de 7,3 %, c’est la différence entre la taille annoncée en Go (base 10) et en Gio (base 2). Quand une puce offre 8 Go (8 000 000 000 d’octets), elle a une capacité réelle de 8 Gio (8 589 934 592 octets). Certains constructeurs jouent plus ou moins sur les mots et il n’est pas rare de trouver des modèles de 120 Go qui n’offrent pas réellement 120 000 000 000 octets.

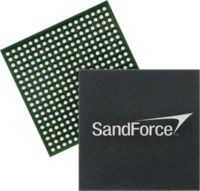

SandForce et les professionnels

Dans le monde professionnel, la réservation varie en fonction des modèles et des contrôleurs, mais elle est dans presque tous les cas supérieure aux 7,3 % classiques, dans un souci de durée de vie.

La gestion du TRIM

La commande TRIM est une solution à la perte de performances induite par le fonctionnement des SSD. Comme nous l’avons vu, la gestion de l’usure implique de devoir chercher une cellule vide ou à défaut une cellule peu usée. Le problème, c’est que le contrôleur n’est pas capable de déterminer directement si une cellule est vide, étant donné que les systèmes de fichiers n’effacent pas réellement les données. La solution est simple : implémenter un moyen de permettre au contrôleur de déterminer si des données ont été effacées.

Sitôt dit, sitôt fait, tout du moins quand toute la chaîne est compatible. Concrètement, la commande TRIM consiste à indiquer au SSD que les données sont effacées, contrairement à la technique habituelle qui consiste à marquer les données supprimées sans les effacer réellement et sans que le SSD puisse le savoir. Avec le TRIM, le SSD est capable de voir où sont les données effacées et donc évite de chercher à les trouver. L’intérêt, c’est que passer la commande est simple : elle ne nécessite pas de ressources spécifiques. En effet, c’est un simple indicateur qui va permettre au SSD de mettre à jour sa table interne et lui permettre de connaître le statut d’une cellule. Il n’y a pas d’effacement physique des données, le fonctionnement au niveau du système d’exploitation ne change pas, mais le contrôleur du SSD sait maintenant si une cellule est effacée (logiquement).

Un problème dans la chaîne, rien ne va

Le Wiper, solution intermédiaire

Avant le TRIM, Indilinx proposait une solution intermédiaire, qui avait l’avantage d’être utilisable avec la majorité des Windows, le Wiper. Le Wiper est un petit programme, utilisable sur certains SSD (en fonction du firmware) qui sert en fait à synchroniser le SSD et le système d’exploitation. Cas simple : vous avez un SSD de 32 Go, que vous avez rempli avec votre système d’exploitation et un fichier provenant d’un DVD que vous avez compressé. Sans le TRIM, supprimer le fichier est une action que le SSD ne verra pas, pour lui, il est toujours là. Le Wiper sert à faire correspondre la base du système de fichier avec la base du SSD, pour lui faire comprendre que le fichier a été supprimé. Défaut de la technique (outre des bugs sur les Windows 64 bits), il faut lancer le programme périodiquement, ce n’est pas automatique. De plus, le Wiper n’est utilisable qu’en NTFS (une version Linux, en bêta, existe malgré tout). Dans la pratique, c’est plus une solution pour revenir à la normale qu’une façon pérenne de corriger le problème.

Les SSD et les optimisations

Parlons d’un sujet intéressant : les « optimisations » des SSD. Si certains s’inquiètent de la durée de vie et essayent de limiter au maximum les écritures sur le SSD en déplaçant le fichier d’échange ou le cache de certains logiciels sur un autre périphérique de stockage, d’autres ne font strictement rien et utilisent un SSD comme un disque dur classique. Dans la pratique, on se situe en fait entre ces deux extrêmes.

Passer à un OS récent

Première chose à faire, passer à un système récent comme Windows 7. En effet, ce dernier est capable de détecter les SSD, tout du moins les modèles récents, et il applique quelques optimisations. La première, c’est la désactivation de la défragmentation automatique, car le fonctionnement intrinsèque des SSD fait que la fragmentation du système de fichiers n’a pas d’impact réel sur les performances. La seconde, c’est l’intégration du TRIM au niveau du système lui-même. La troisième, c’est l’alignement des partitions.

Aligner les partitions

Avec un vieux SSD ou un vieux système

Avec certains « vieux » SSD, Windows 7 n’arrive pas à déterminer si le périphérique de stockage est un SSD. En effet, la détection est simple habituellement : une commande de la norme ATA-8 envoie la vitesse de rotation, et elle est à 0 si c’est un SSD. Mais sur les anciens modèles, qui datent d’avant 2009, la commande n’est pas nécessairement implantée. Dans ce cas précis — rare —, il faut appliquer les optimisations à la main. De même, pour les personnes encore sous Windows XP, Windows Vista ou une ancienne version de Linux, il est nécessaire d’optimiser quelques points à la main. Le premier, c’est vérifier que la partition est alignée et le cas échéant le faire. Le second point, c’est éviter la défragmentation. Le dernier, c’est d’utiliser un outil de TRIM manuel, comme le Wiper d’Indilinx, de façon régulière.

Les autres optimisations que l’on voit parfois sur certains sites Internet n’ont généralement pas d’impact réel et sont parfois contre-productives. Certains conseillent par exemple de désactiver le cache du SSD, ce qui a un impact très net sur les performances : elles s’effondrent.

Nuisances sonores et consommation

Un des avantages des SSD vient des nuisances sonores. C’est simple, on n’entend strictement rien. Comme il n’y a pas de pièces en mouvement, ils sont totalement silencieux. Pour ceux qui veulent laisser un ordinateur allumé dans une chambre, par exemple, c’est vraiment très intéressant. Attention, même si ce n’est pas le cas ici, certaines mémoires flash ont tendance à siffler pendant les accès. C’est un phénomène aléatoire et assez rare, mais présent de temps en temps.

Température

Consommation et autonomie

Autant les premiers SSD offraient un gain en autonomie substantiel, autant les SSD récents sont très proches des disques durs. Il y a deux raisons : la quantité de mémoire flash augmente, ce qui a un impact direct sur la consommation, et les disques durs s’améliorent avec le temps. S’il n’était pas rare de gagner 30 minutes de batterie en 2007, l’impact est mineur en 2011. Un SSD consomme entre 1 W et 5 W actuellement, selon les modèles et la capacité, et la différence de consommation avec un disque dur est assez faible. En dehors des ultraportables, où le moindre watt est important, la différence est trop faible que pour avoir un impact visible sur l’autonomie.

Conclusion, le futur

Il nous a paru intéressant de confronter notre analyse originale sur l’évolution des SSD, parue dans la version originale de l’article en mai 2007, avec la réalité actuelle. Voici l’analyse de l’époque :

Le futur des SSD (en mai 2007)

Les SSD vont évoluer, et doivent évoluer, c’est un fait. Les prochaines générations devraient être plus rapides (environ 65 Mo/s en lecture) et offrir une capacité plus élevée (au moins 64 Go). Le prix, quant à lui, devrait diminuer un peu, mais pas assez pour rendre la solution SSD vraiment intéressante. Le problème principal vient de la mémoire utilisée : la mémoire SLC rapide vaut actuellement entre 15 et 20 $ le Go, et son prix ne devrait pas baisser énormément, car la demande dépasse la production. Les constructeurs espèrent pouvoir utiliser à terme de la MLC pour les SSD, ce qui permettrait de doubler la capacité des SSD sans surcoût réel, mais elle est pour le moment trop lente en écriture pour être utilisée dans d’autres appareils que les téléphones ou les baladeurs MP3. On peut considérer que des SSD de 64 Go aux environs de 300 € devraient être disponibles au début de l’année 2008, ce qui commencerait tout juste à devenir intéressant en terme de prix et de capacité.

La réalité (en mars 2011)

En mars 2011, les SSD de 64 Go valent moins de 100 € et atteignent plus de 300 Mo/s en lecture sur les modèles haut de gamme. La mémoire SLC a définitivement laissé sa place à la mémoire MLC dans la majorité des produits et même les modèles professionnels passent progressivement à la MLC. Le prix de la mémoire diminue constamment et il est d’environ 1,5 $ par Go pour l’acheteur final actuellement. De plus, l’écart entre les disques durs et les SSD diminue : en 2007, les SSD atteignaient 32 Go, les disques durs 2,5 pouces étaient à 250 Go. Actuellement, les SSD atteignent 512 Go et les disques durs se limitent réellement à 1 To (800 Go et 1,5 To si on passe dans des épaisseurs non conventionnelles). L’écart se ressert donc assez fortement. Et actuellement, les SSD sont proposés en standard dans certains PC portables, sans même un disque dur en option.

Le futur

Pour le futur, on devrait voir une augmentation des performances séquentielles, avec la généralisation du SATA 6 gigabits/s, et toujours une augmentation de la capacité des SSD couplée à une diminution du prix. Les modèles actuels utilisent de la mémoire en 34 nm dans la majorité des cas et l’arrivée de la mémoire en 25 nm devrait permettre à terme de doubler la capacité maximale — et donc d’atteindre 1 To — et de diminuer les prix. Même si la mémoire elle-même coûte environ deux fois moins cher, les prix ne suivront pas cette courbe : les SSD contiennent aussi des contrôleurs et de l’électronique classique dont le coût varie peu dans le temps. On devrait donc voir le prix des modèles d’entrée de gamme stagner et le prix des modèles de grande capacité diminuer de façon plus importante. C’est une chose que nous constatons déjà : un SSD de 256 Go a souvent un prix au Go plus intéressant qu’un modèle de 32 Go.