Introduction

Outre le fait d’afficher un gabarit massif et un poids considérable, les moniteurs CRT renfermaient plusieurs composants au nom exotique comme par exemple un tube cathodique ou encore un canon à électrons. Ce dernier envoyait un faisceau d’électrons vers l’écran pour éclairer les points lumineux que l’on appelle pixels. Le balayage était conduit pixel par pixel de la gauche vers la droite, ligne par ligne du sommet de l’écran jusqu’à sa base. A l’époque, il était délicat de modifier la vitesse du canon à électron après chaque rafraîchissement complet et cela ne s’imposait pas comme une nécessité, vu que les premiers jeux 3D sont sortis plusieurs dizaines d’années après les premiers moniteurs CRT. Les CRT et standards vidéo analogiques associés ont donc été conçus avec des fréquences de rafraîchissement fixes.

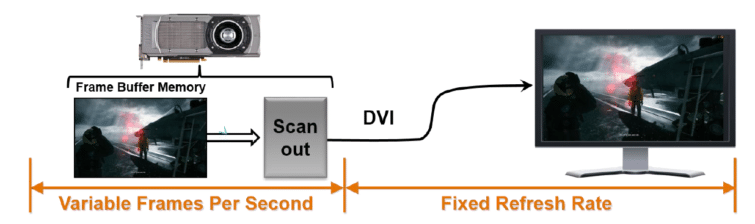

Début 2000, les LCD ont commencé à remplacer progressivement les CRT, de même que les connexions numériques (DVI, HDMI et DisplayPort) ont pris la suite des connexions analogiques (VGA). Cependant, les organismes chargés de définir les signaux vidéo (à commencer par le VESA) en sont restés à des fréquences de rafraîchissement fixes. Après tout, les programmes TV comme les films s’appuient encore aujourd’hui sur un signal d’entrée dont le débit d’images est fixe. Encore une fois, le rafraîchissement variable n’est pas apparu comme une nécessité.

Débit d’image variable et fréquences fixes ne font pas bon ménage

Le fait que les écrans aient une fréquence de rafraîchissement fixe n’a donc jamais posé problème jusqu’à l’avènement des jeux 3D. Le problème s’est révélé à partir du moment où nous avons commencé à avoir des GPU puissants : la cadence à laquelle ils rendent les images (le nombre d’ips) n’est pas constante. Un carte graphique peut par exemple générer 30 ips au cours d’une scène particulièrement chargée pour atteindre 60 ips quelques instants plus tard lorsque l’on regarde un ciel dégagé par exemple.

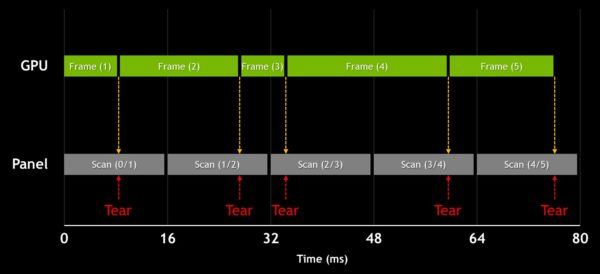

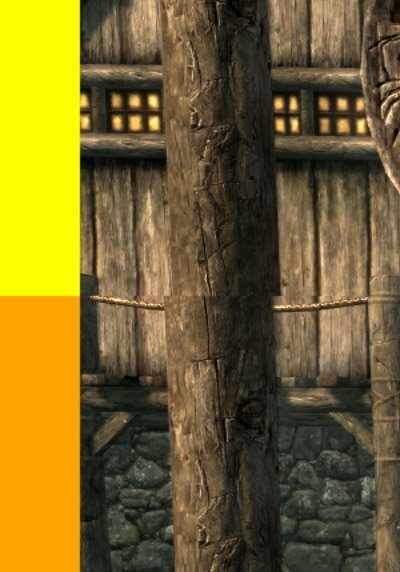

Le débit d’images irrégulier d’une carte graphique et la fréquence de rafraîchissement fixe d’un moniteur ne font pas bon ménage : on assiste à un phénomène de déchirement de l’image, le tearing, lorsque deux images ou plus sont rendues lors d’un seul cycle de rafraîchissement du moniteur. Concrètement, les deux portions de l’image apparaissent alors comme étant mal alignées, une anomalie qui résulte du mouvement.

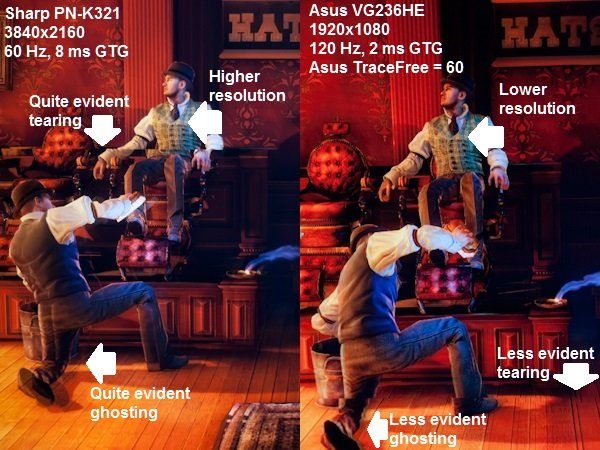

L’image ci-dessus montre deux anomalies bien connues et assez courantes, mais pourtant pas évidentes à illustrer. Étant donné qu’il s’agit d’anomalies d’affichage, on ne les voit pas sur les captures d’écran réalisées en cours de partie. Elles sont en revanche bien perceptibles sur un moniteur. Il faut un appareil photo très rapide pour capturer ces anomalies et les isoler, à moins d’avoir une carte d’acquisition vidéo comme celle que nous utilisons pour nos benchmarks FCAT : on peut alors enregistrer un flux vidéo non compressé depuis le port DVI et clairement voir la transition d’une image à l’autre. Quoi qu’il en soit, le meilleur moyen d’apprécier le phénomène est de l’observer à l’œil nu.

On peut voir cet effet de tearing sur les deux images ci-dessus, prises avec un appareil photo (ou bien celle qui figure ci-dessous, capturée avec une carte d’acquisition). L’image est coupée à l’horizontale et semble mal alignée. L’image de gauche est obtenue avec un moniteur Sharp 60 Hz tandis que celle de droite est générée par un écran Asus 120 Hz. Naturellement, le tearing est moins prononcé sur le second grâce à une fréquence de rafraîchissement deux fois plus élevée. Cependant, l’anomalie reste perceptible dans les deux cas. Elle est par ailleurs caractéristique du fait que les captures ont été réalisées sans V-sync.

L’autre problème rencontré avec BioShock: Infinite est le ghosting, particulièrement apparent dans le coin inférieur gauche de l’image. Le phénomène est dû à la réactivité de l’écran : pour résumer, les pixels sont trop longs à changer de couleur, provoquant ainsi une trainée. Cette anomalie est nettement plus dérangeante en conditions de jeu que par le biais d’une image. Une dalle proposant un temps de réponse gris à gris de 8 ms, comme celle de Sharp, provoquera des effets de flou dès lors que l’on a des mouvements rapides à l’écran. De ce fait, ces dalles ne sont généralement pas recommandées pour jouer aux fps.

V-sync : résoudre un problème par un autre

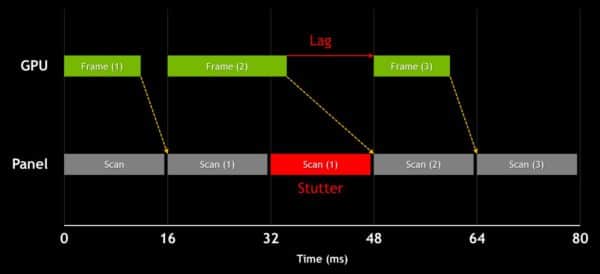

La synchronisation verticale (V-sync) est une vieille solution au problème de tearing. Pour résumer, cette technologie demande à la carte vidéo de se synchroniser avec la fréquence de rafraîchissement de l’écran, éliminant donc complètement le tearing. Cependant, si la carte graphique en question n’arrive pas à maintenir un minimum de 60 ips (sur un écran 60 Hz), le nombre d’ips affichées à l’écran ne cesse de varier sur la base de multiples entiers de la fréquence de l’écran (60, 30, 20, 15 ips et ainsi de suite), provoquant ainsi des saccades (stutter).

La carte vidéo étant contrainte d’attendre et parfois de s’appuyer sur un troisième tampon mémoire, la V-sync peut engendrer également du retard dans l’affichage, le fameux input lag qui peut vous couter la vie dans les FPS multijoueurs. Cette technologie peut donc être soit une excellente solution soit un remède pire que le mal, vu que l’on élimine le tearing au prix de deux nouveaux problèmes. Après avoir réalisé un sondage rapide au sein de la rédaction, il est apparu que la majorité d’entre nous n’active la V-sync qu’à partir du moment où le tearing devient insupportable.

NVIDIA lance G-SYNC

Lors du lancement de la GTX 680, NVIDIA a ajouté une fonctionnalité dans ses pilotes répondant au nom d’Adaptative V-sync. Cette dernière tente de réduire les défauts de la V-sync classique en s’activant lorsque le nombre d’ips est supérieur à la fréquence de l’écran pour se désactiver rapidement dans le cas contraire. Bien que cette technologie ait rempli son office, il s’agit plus d’un contournement du problème qu’autre chose vu que le tearing n’est pas complètement éliminé lorsque le nombre d’ips est inférieur à la fréquence de l’écran.

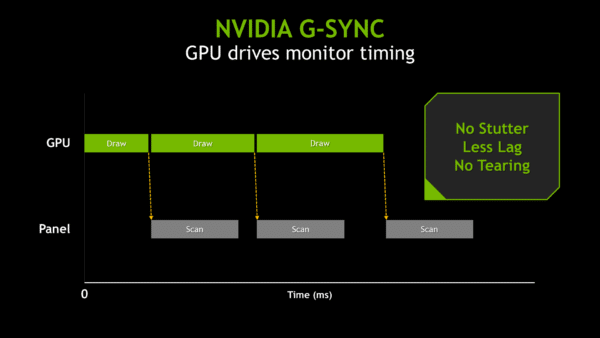

L’arrivée de G-SYNC est bien plus intéressante : NVIDIA nous montre qu’au lieu de forcer les cartes graphiques à afficher les jeux sur des moniteurs à fréquence constante, il est possible de faire fonctionner certains écrans avec une fréquence de rafraîchissement variable.

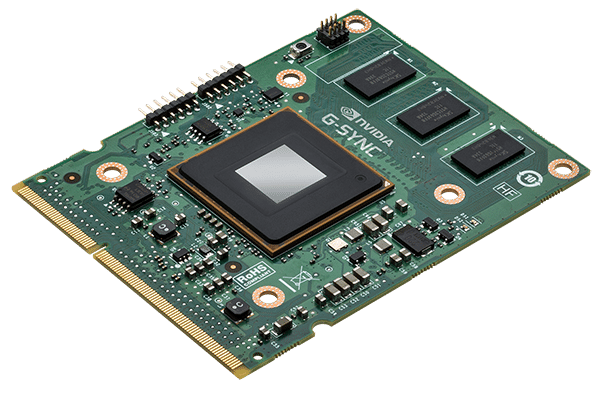

Le DisplayPort, plus particulièrement son protocole de transmission de données par micro-paquets, a offert une opportunité. En utilisant les VBI (Vertical Blanking Interval) du signal vidéo DisplayPort et en remplaçant le contrôleur du moniteur par un module capable de fonctionner avec un signal à VBI, il est possible de faire varier la fréquence de ce moniteur pour l’aligner sur le débit d’images de la carte graphique (dans la limite des fréquences gérées par l’écran bien entendu). En pratique, NVIDIA a opté pour une approche créative en utilisant des possibilités offertes par le DisplayPort, faisant ainsi d’une pierre deux coups.

Avant même de passer aux tests, soulignons le caractère particulièrement innovant de cette approche, puisqu’elle vise à résoudre un problème très concret qui touche globalement les jeux PC. Mais comment G-SYNC fonctionne-t-il en pratique ?

NVIDIA nous a envoyé un prototype de l’écran Asus VG248QE dont le contrôleur a été remplacé par le module G-SYNC. Ce moniteur est bien connu puisqu’il s’agit d’un des meilleurs modèles qui soit pour jouer à l’heure actuelle grâce à son excellente réactivité.

3D LightBoost, mémoire embarquée, standards et 4K

En parcourant la documentation fournie par NVIDIA à la presse, nous nous sommes posé plusieurs questions vis-à-vis de la technologie G-SYNC à l’heure actuelle, ainsi que son rôle à l’avenir. Une visite chez la firme au caméléon nous a permis de trouver quelques réponses.

G-SYNC et 3D LightBoost

La première chose que nous avons remarquée tient au matériel qui nous a été envoyé, à savoir un moniteur Asus VG248QE modifié pour prendre en charge G-SYNC. Ce modèle gère également ce que NVIDIA appelle 3D LightBoost, une technologie lancée pour améliorer la luminosité des contenus en 3D stéréoscopique qui est depuis longtemps également utilisée (de manière non-officielle) en 3D « classique ». Dans le second cas, le rétroéclairage de la dalle par impulsions lumineuses sert à réduire le ghosting (ou motion blur) que nous avons évoqué sur la page précédente. Bien entendu, nous voulions savoir s’il serait possible d’associer les deux technologies.

NVIDIA nous a répondu par la négative. Cette utilisation simultanée a beau être idéale sur le papier, un rétroéclairage de la dalle par impulsions à des fréquences de rafraîchissement variables engendre pour l’instant des problèmes de scintillement et de luminosité. La situation est très compliquée puisqu’il s’agit d’ajuster la luminance tout en contrôlant les impulsions lumineuses. NVIDIA travaille donc sur le problème mais il faut pour l’instant faire un choix entre LightBoost et G-SYNC.

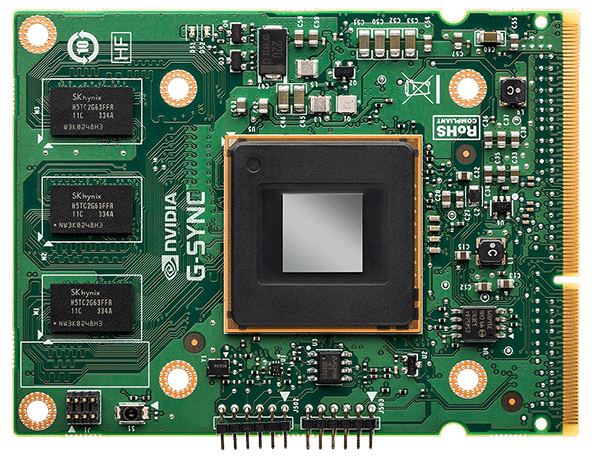

La mémoire embarquée du module G-SYNC

Comme nous le savons déjà, G-SYNC élimine la latence additionnelle causée par la V-sync, étant donné qu’il n’est plus nécessaire d’attendre que la dalle effectue un balayage. Ceci étant dit, nous avons remarqué que le module G-SYNC dispose de mémoire embarquée. Mettrait-il lui-même les images en tampon ? Si tel est le cas, quel est le temps nécessaire à une image pour qu’elle traverse intégralement le nouveau circuit de rendu ?

D’après NVIDIA, les images ne sont jamais mises en tampon dans la mémoire de G-SYNC. Les données arrivent, elles sont affichées à l’écran tandis que la mémoire est sollicitée pour d’autres tâches. Le temps de traitement induit par G-SYNC est nettement inférieur à une milliseconde, au point de s’avérer similaire à celui que l’on rencontre sans V-sync suivant l’environnement (jeu, pilote graphique, souris et ainsi de suite).

G-SYNC sera-t-il standardisé un jour ?

Cette question a été récemment soulevée lors d’une séance de questions/réponses avec AMD, par un lecteur qui voulait connaitre la réaction de la firme de Sunnyvale par rapport à G-SYNC. Nous voulions également avoir une réaction directe de NVIDIA pour savoir si l’entreprise comptait mettre en avant sa technologie pour qu’elle devienne un standard industriel. En théorie, NVIDIA pourrait proposer G-SYNC comme une évolution du standard DisplayPort avec fréquence de rafraîchissement variable. Après tout, NVIDIA est membre du VESA, principal organisme chargé de la définition des standards vidéo.

Le fait est que l’ajout d’une nouvelle fonctionnalité au DisplayPort, HDMI ou DVI n’est pas à l’ordre du jour. G-SYNC est déjà fonctionnel avec le DisplayPort 1.2, ce qui veut dire qu’un changement de standard n’est pas nécessaire.

Comme nous l’avons déjà évoqué, NVIDIA travaille à la compatibilité de G-SYNC avec ce qui s’appelle pour l’instant 3D LightBoost (la technologie changera bientôt de nom). La firme au caméléon tente également de faire baisser les coûts du module pour rendre G-SYNC plus accessible.

G-SYNC en Ultra HD

La foire aux questions sur le site de NVIDIA nous promet des moniteurs G-SYNC allant jusqu’à une définition de 3840×2160. Cependant, le moniteur dont nous faisons un aperçu aujourd’hui est en 1920×1080. À ce jour, les rares moniteurs Ultra HD s’appuient sur un contrôleur STMicro Athena, lequel utilise deux « scalers » pour créer une image en « tuiles », comme l’Asus PQ321Q que nous avons vu en octobre dernier. Ceci a piqué notre curiosité : le module G-SYNC peut-il prendre en charge une configuration MST (Multi-Stream Transport) ?

A vrai dire, il va falloir attendre un bon moment avant de voir des écrans 4K avec fréquence de rafraîchissement variable : il n’y a pour l’instant aucun contrôleur mono-puce capable de gérer des définitions 4K. Dans le meilleur des cas, les premières annonces seront faites ce trimestre pour un début de commercialisation dans le courant du second semestre. Etant donné que le module G-SYNC remplace le contrôleur, les dalles compatibles avec la technologie de NVIDIA ne commenceraient donc à voir le jour qu’après cette période. Fort heureusement, il gère nativement l’Ultra HD.

Que se passe-t-il à moins de 30 Hz ?

La fréquence de rafraîchissement variable permise par G-SYNC descend jusqu’à 30 Hz. Ceci s’explique par le fait qu’avec une fréquence très basse, l’image produite par une dalle LCD finit par se détériorer et engendrer des anomalies. Si la source descend en dessous de 30 ips, le module G-SYNC sait gérer automatiquement la fréquence de rafraîchissement pour éviter ces problèmes. Ceci peut amener à afficher la même image plus d’une fois, mais le seuil est donc défini à 30 Hz pour garantir la meilleure expérience visuelle possible.

Dalles 60 Hz, SLI, Surround et disponibilité

La technologie est-elle réservée aux dalles les plus réactives ?

On remarque que le premier moniteur accueillant G-SYNC après modification disposait déjà d’une fréquence de rafraîchissement très élevée (laquelle dépasse largement la plage optimale pour la technologie de NVIDIA) ainsi qu’une définition de 1920×1080. L’écran d’Asus a cependant ses propres limites, comme par exemple une dalle TN 6 bits. Nous voulions donc savoir si NVIDIA prévoyait de limiter G-SYNC aux moniteurs les plus réactifs, ou bien si l’on pourrait également voir cette technologie sur des modèles 60 Hz plus courants. Par ailleurs, nous souhaitons pouvoir accéder à des moniteurs en 2560×1440 le plus rapidement possible.

NVIDIA a de nouveau insisté sur le fait que G-SYNC donne le meilleur de lui-même lorsque la carte graphique débite entre 30 et 60 ips. En conséquence, la technologie peut réellement bénéficier aux moniteurs 60 Hz équipés a posteriori d’un module G-SYNC.

Pourquoi donc commencer avec un moniteur 144 Hz ? Il semble que bon nombres de marques veulent activer la fonctionnalité qui limite le flou de mouvement (3D LightBoost), laquelle nécessite des fréquences de rafraîchissement élevées. Mais pour tous ceux qui sont prêts à faire sans cette fonctionnalité (pourquoi pas, d’autant plus qu’elle est de toute manière incompatible avec G-SYNC pour le moment), il est théoriquement possible d’obtenir un moniteur avec G-SYNC pour un coût nettement inférieur.

Pour ce qui est de la définition, le premier moniteur 2560×1440 pixels G-SYNC a été annoncé la semaine dernière : il s’agit de l’Asus ROG SWIFT PG278Q, lequel est prévu pour le début du deuxième trimestre. Notons qu’il s’agit d’une dalle TN « 120+ Hz ».

SLI et G-SYNC sont-ils compatibles ?

La foire aux questions de NVIDIA précise clairement que G-SYNC et SLI sont compatibles, une bonne nouvelle quand on pense aux futurs moniteurs 1440p orientés vers le jeu. La carte graphique reliée au moniteur est alors celle qui gère la technologie de rafraîchissement variable.

Ce point mérite toutefois quelques explications supplémentaires. Nous avons longuement discuté avec AMD au sujet du Frame Pacing (technologie permettant de corriger le problème de micro-saccades) que la firme de Sunnyvale a implémenté dans ses Catalyst. NVIDIA traite le problème différemment, par le biais d’un circuit logique au sein de l’architecture Kepler. Quoi qu’il en soit, cette même technologie qui permet d’afficher les images à un rythme régulier sans V-sync en SLI est nécessaire pour que G-SYNC puisse fonctionner correctement. Aucune tâche supplémentaire n’est nécessaire : les images sont affichées depuis le GPU « maître », lequel gère également G-SYNC.

Quelles sont les conditions nécessaires pour bénéficier de G-SYNC en Surround ?

L’idée d’associer plusieurs cartes graphiques pour jouer sur un moniteur 1080p n’a pas vraiment d’intérêt : même une carte milieu de gamme basée sur Kepler devrait parvenir à un débit d’image suffisant pour l’immense majorité des jeux avec cette définition. Par ailleurs, il est actuellement impossible d’utiliser un SLI composé de deux cartes graphiques avec trois moniteurs G-SYNC en Surround.

Ceci est une limitation inhérente à la connectique des cartes NVIDIA, laquelle inclut généralement deux ports DVI, un HDMI et un DisplayPort. G-SYNC nécessite du DisplayPort 1.2 sachant qu’un adaptateur ou un répartiteur DisplayPort MST ne permettent pas de contourner le problème. La seule manière d’accéder au Surround consiste donc à utiliser trois cartes graphiques, chacune reliée à son propre moniteur. Cependant, il nous semble que les partenaires de NVIDIA sont susceptibles de commercialiser à moyen terme des GeForce « G-SYNC Edition » mieux équipées en connectique DisplayPort.

G-SYNC et Triple Buffering

L’activation du triple-buffering est-elle nécessaire pour avoir un rendu aussi fluide que possible avec G-SYNC, de manière comparable à ce que l’on fait avec la V-sync ? La réponse est négative : G-SYNC n’a pas besoin du triple-buffering parce que le circuit de rendu n’est jamais encombré. Au contraire, l’association des deux est même contre-productive puisque l’on crée ainsi une latence supplémentaire sans gain de performances. Malheureusement, le triple-buffering est souvent paramétré par les jeux eux-mêmes sans que l’on ait la possibilité de le désactiver manuellement.

Qu’en est-il des jeux qui réagissent mal à l’absence de V-sync ?

Des titres comme Skyrim, lequel fait partie de notre suite de tests, sont conçus pour être joués avec V-sync sur une dalle 60 Hz (malgré le fait que certains parmi nous s’arrachent les cheveux face à l’input lag ainsi engendré). Pour tester ces jeux, il faut donc modifier quelques fichiers .ini. Comment G-SYNC se comporte avec des jeux basés sur les moteurs Gamebryo ou Creation, lesquels sont sensibles à la V-sync ? La fréquence est-elle plafonnée à 60 Hz ?

Etant donné qu’il s’agit d’une caractéristique du jeu, G-SYNC ne la change pas, tout comme le fait de jouer sur un moniteur 120 ou 144 Hz avec V-sync n’a pas d’influence. Toutefois, NVIDIA affirme que sa technologie devrait bien cohabiter avec des jeux comme Skyrim sous réserve qu’ils soient limités au débit d’images attendu par leur moteur. Dans ce genre de cas, il convient de définir une fréquence de 60 Hz puis d’activer G-SYNC afin que la fonctionnalité se conforme au débit d’images maximal adéquat.

Quelle est la disponibilité et le prix de G-SYNC ?

A ce stade, NVIDIA s’attend à ce que ses partenaires commencent à commercialiser les premiers moniteurs G-SYNC au cours du premier trimestre 2014. A en croire la firme au caméléon, le prix sera moins problématique que ce à quoi l’on s’attendait compte tenu du fait que le module G-SYNC remplace le scaler du moniteur. Si l’on envisage les choses de manière strictement rationnelle, le delta entre ces deux composants devrait donc correspondre à l’écart tarifaire.

Mieux vaut avoir une souris rapide

Enfin, NVIDIA attire notre attention sur le fait qu’une souris rapide est vivement conseillée pour une configuration avec G-SYNC. Une fréquence d’échantillonage du positionnement de la souris (polling rate) à 1000 Hz permet de s’assurer que le périphérique n’influe pas négativement sur les temps de réaction.

Prérequis matériel et configuration du test

G-SYNC ne fait donc partie d’aucun standard et NVIDIA ne prévoit pas de militer pour inclure sa technologie dans une prochaine révision du DisplayPort. En conséquence, G-SYNC nécessite quelques prérequis avant de pouvoir fonctionner.

En premier lieu, il faut une carte NVIDIA et plus spécifiquement une GeForce GTX 650 Ti ou mieux. Kepler est la première architecture graphique munie d’un contrôleur d’affichage qui peut être programmé pour G-SYNC, ce qui veut dire que la technologie sera tout simplement incapable de fonctionner avec une carte basée sur Fermi, aussi puissante soit-elle. L’architecture Maxwell ayant été spécifiquement conçue pour prendre en charge G-SYNC, toutes les cartes à venir seront compatibles.

Le second prérequis est un moniteur équipé du module G-SYNC. Etant donné que ce dernier remplace le contrôleur de l’écran, il est impossible d’ajouter G-SYNC à un moniteur Ultra HD en tuiles par exemple. Dans l’immédiat, nous utilisons un prototype basé sur l’Asus VG248QE capable d’atteindre 1920×1080 à 144 Hz, mais il faut imaginer l’écho que pourrait trouver G-SYNC si les constructeurs commencent à associer le module à des dalles 60 Hz moins coûteuses.

Enfin, il faut nécessairement utiliser un câble DisplayPort 1.2 : DVI et HDMI ne sont tout simplement pas pris en charge. Pour le moment, cela signifie qu’il faut une carte graphique par écran lorsque l’on veut bénéficier de G-SYNC en Surround puisque les GeForce ont au mieux une seule sortie DisplayPort.

Ajoutons à cela qu’il faut également une prise en charge au niveau des pilotes, ce qui est le cas depuis les 331.93 beta.

Configuration du test

| Composants | |

|---|---|

| Processeur | Intel Core i7-3970X (Sandy Bridge-E) 3,5 GHz par défaut, O/C @ 4,3 GHz, LGA 2011, 15 Mo partagés de cache L3, Hyper-Threading et économies d’énergie activées |

| Carte mère | MSI X79A-GD45 Plus (LGA 2011) chipset X79 Express, BIOS 17.5 |

| DRAM | G.Skill 32 Go (8 x 4 Go) DDR3-2133, deux kits F3-17000CL9Q-16GBXM @ 9-11-10-28 pour 1,65 V |

| Stockage | SSD Samsung 840 Pro 256 Go SATA 6Gb/s |

| Cartes graphiques | Nvidia GeForce GTX 780 Ti 3 Go |

| Nvidia GeForce GTX 770 2 Go | |

| Alimentation | Corsair AX860i 860 Watts |

| Logiciels et pilotes | |

| OS | Windows 8 Professionnel 64 bits |

| DirectX | Version 11 |

| Graphiques | NVIDIA GeForce 331.93 Beta |

A ce stade, il est important de bien saisir quel est le champ d’activité sur lequel G-SYNC se montre le plus efficace. La majorité d’entre nous utilise des écrans 60 Hz et bien qu’il existe des écrans 120 et 144 Hz spécifiquement destinés aux jeux, NVIDIA estime (à raison) que son plus gros marché est constitué par tous ceux qui sont bloqués à 60 Hz.

A 60 Hz avec V-sync, les anomalies les plus dérangeantes se produisent lorsque le débit en ips varie brusquement entre 30 et 60 plutôt que de se stabiliser à 60. C’est dans ce contexte que l’on rencontre un phénomène prononcé de micro-saccades. Sans V-sync, les scènes particulièrement dynamiques ou comptant de nombreux mouvements horizontaux accentuent le tearing. Ce phénomène est parfois tellement dérangeant que l’on active la V-sync immédiatement quitte à devoir supporter les micro-saccades et l’augmentation d’input lag qui en résulte.

En passant à 120 ou 144 Hz avec un débit d’images plus conséquent, le moniteur se rafraîchit plus régulièrement et réduit donc le temps passé à balayer plusieurs fois une même image dans le cas où les performances ne suivent pas. Cependant, les problèmes liés à l’activation/désactivation de la V-sync persistent. Par souci d’exhaustivité, nous avons conduit des tests à 60 et 144 Hz, avec et sans G-SYNC.

G-SYNC contre V-sync

Ici, sortir la carte d’acquisition vidéo et le Raid de SSD pour commencer les benchmarks serait une erreur. En effet, il n’est pas question de performances mais de qualité.

Les benchmarks ne peuvent nous renseigner que sur un point : quel est le nombre d’ips à tel moment du benchmark. Rien ne nous dit à quel point G-SYNC influe positivement ou pas sur l’expérience de jeu. Il faut donc expliquer le ressenti avec des mots plutôt que de faire une démonstration chiffres à l’appui.

Pourquoi ne pas avoir tout simplement enregistré une vidéo sur laquelle chacun aurait pu se faire son propre avis ? Car une caméra enregistre généralement à une fréquence fixe de 60 Hz, tout comme les moniteurs actuels génèrent un affichage sans variation de fréquence. G-SYNC étant par définition variable, on ne verrait rien à l’écran.

Avec un nombre de jeux suffisant, les possibilités de tests semblent sans fin : avec/sans V-sync, avec/sans G-SYNC, 60 Hz, 120 Hz, 144 Hz et ainsi de suite. Commençons par régler notre moniteur sur une fréquence de 60 Hz avec V-sync.

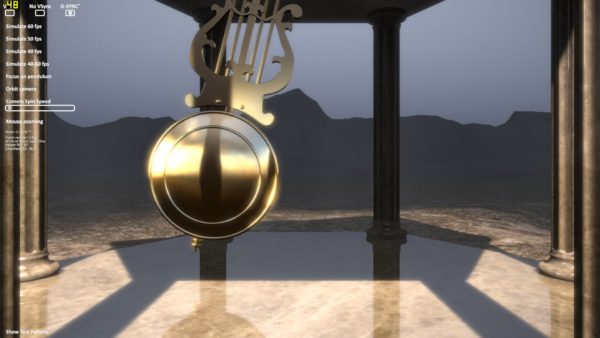

Le test le plus facile à réaliser s’appuie sur la démo fournie par NVIDIA, à savoir une pendule qui effectue des mouvements aller-retour, sachant que ce dernier peut être réglé pour reproduire un débit de 60, 50 ou 40 ips. Il est également possible de paramétrer des fluctuations entre 40 et 60 ips. Quel que soient les réglages effectués à ce stade, il est alors possible d’activer/désactiver V-sync et G-SYNC. Bien que ce test puisse être particulièrement artificiel, il s’agit probablement du meilleur exemple possible pour mettre en avant la technologie de NVIDIA. On peut commencer le test à 50 ips avec V-sync et penser qu’il y a franchement pire : on décèle ce qui ressemble à une micro-saccade de temps à autre mais il n’y a pas mort d’homme. Après cela, on active G-SYNC et le discours change radicalement : c’est le jour et la nuit, au point que l’on se demande comment on a a pu se contenter des compromis consentis jusqu’ici.

A ce stade, il faut rester mesuré : il s’agit juste d’une démonstration technique après tout. Pour en avoir le cœur net, mieux vaut se faire un avis avec de vrais jeux que l’on sait gourmands, comme par exemple Arma III.

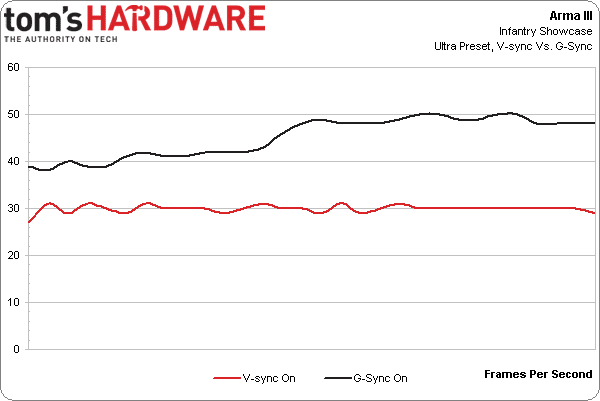

Sur ce titre, on peut se contenter d’une GeForce GTX 770 pour jouer avec les réglages graphiques au maximum sur notre configuration de test. On obtient alors entre 40 et 50 ips sans V-sync. En revanche, on plonge aux alentours de 30 ips avec V-sync. Les performances sont alors trop faibles pour régulièrement fluctuer entre 30 et 60 ips : c’est un cas de bridage sévère.

Etant donné qu’il n’y avait pas de micro-saccades, le rendu avec G-SYNC ne change pas radicalement si ce n’est que l’on gagne 10 à 20 ips supplémentaires. L’input lag doit également diminuer vu que le moniteur ne balaye plus à plusieurs reprises des images identiques. Précisons cependant qu’Arma III nous semblait moins saccadé que bon nombre de jeux, raison pour laquelle nous n’avons pas perçu de latence.

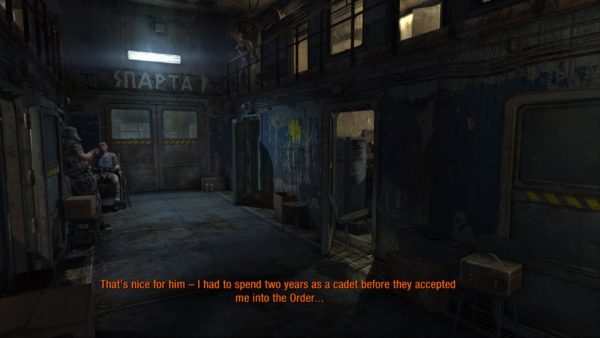

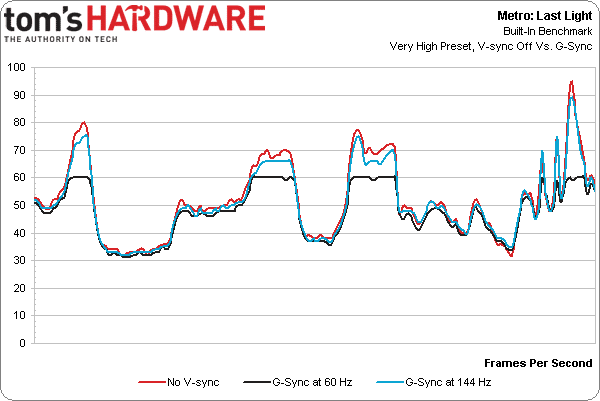

Metro: Last Light est un jeu qui met G-SYNC plus en valeur. Avec une GTX 770, il est possible d’y jouer en 1920×1080 avec un niveau de détails très élevé, AF 16x, tessellation et motion blur en normal. A partir de là, on peut régler le SSAA sur 1x, 2x ou 3x pour voir le nombre d’ips baisser proportionnellement.

Le fait que le jeu démarre dans un couloir dans lequel les mouvements latéraux sont forcément limités aide à préserver les performances. Nous avons donc chargé une partie avec V-sync à 60 Hz pour nous rendre à la surface : Fraps rapportait alors des performances inférieures à 30 ips avec SSAA 3x et proches de 60 ips sans anti-aliasing. Les micro-saccades comme le lag étaient insignifiants. Le fait de désactiver le SSAA permet de se déplacer avec un débit d’image parfaitement fluide puisque l’on reste à 60 ips. Avec SSAA 2x, les fluctuations entre 30 et 60 ips font ressentir une saccade à chaque fois qu’une image est répétée. Ce fps fait partie donc partie des jeux sur lesquels nous avons l’habitude de désactiver la V-sync tout en faisant abstraction du tearing. Il s’agit d’une habitude que nous avons prise depuis des années.

G-SYNC élimine complètement ce compromis. On ne se surprend plus à regarder les chiffres affichés par Fraps, guettant les creux en dessous de 60 ips qui poussent à baisser les réglages graphiques. A vrai dire, on peut même les augmenter : quand bien même on descend à 50 ou 40 ips, on ne ressent plus de micro-saccades. L’alternative consiste à désactiver la V-sync, choix qui n’est pas sans conséquences comme nous allons le voir maintenant.

G-SYNC contre V-sync désactivée

Après avoir fait un petit sondage non-officiel parmi les rédacteurs du site et quelques amis accessibles par Skype (autrement dit, l’échantillon est très réduit), il s’est avéré que la majorité qui comprend le principe de la V-sync et surtout ses effets secondaires préfère la désactiver. Les sondés ne l’activent que par contrainte, c’est-à-dire lorsque le tearing devient insupportable.

Comme on peut l’imaginer, on remarque tout de suite l’absence de V-sync même si l’effet est largement conditionné par le jeu et les détails graphiques choisis.

Prenons Crysis 3 par exemple. On a très vite fait de mettre sa carte graphique à genoux avec les réglages graphiques au maximum. Fps oblige, Crysis nécessite énormément de mouvements rapides, ce qui peut faire apparaitre un tearing assez considérable. L’image ci-dessus est un extrait de la capture vidéo depuis FCAT entre deux images : les branches sont complètement disjointes.

En revanche, la désactivation forcée de la V-sync dans Skyrim provoque un tearing nettement moins prononcé. Précisons tout de même que nous avons un débit d’image extrêmement élevé : plusieurs images parviennent à l’écran à chaque balayage. La quantité de mouvement par image est donc relativement faible. Skyrim pose encore quelques problèmes dans ce cas de figure, signe que les réglages ne sont pas optimum. Il faut surtout retenir que sans V-sync, l’expérience de jeu varie d’un titre à l’autre.

Voici un troisième exemple avec Tomb Raider, sur lequel l’épaule de Lara est franchement mal alignée (tout comme ses cheveux et la bretelle de son haut). Accessoirement, Tomb Raider est l’un des rares jeux de notre suite de test à laisser le choix entre double et triple-buffering quand on utilise la V-sync.

On peut voir sur ce dernier graphique que les performances de Metro : Last Light avec G-SYNC à 144 Hz sont à peu près les mêmes que sans V-sync. Cependant, G-SYNC a l’avantage d’éliminer le tearing. A 60 Hz, G-SYNC limite les performances à 60 ips tout en éliminant les micro-saccades et l’input lag qu’engendrerait la V-Sync.

Pour toute personne ayant passé des heures et des heures devant les mêmes benchmarks tournant en boucle, l’exercice n’a rien d’inhabituel : c’est de cette manière que nous testons les performances absolues des cartes graphiques. Il peut donc être assez pénible de répéter ces mêmes séquences avec G-SYNC pour apprécier une fluidité similaire à la V-Sync activée, sans les inconvénients ou encore le tearing inhérent à la désactivation de cette dernière. Nous souhaitions publier une vidéo pour illustrer les différences, mais le résultat n’est pas probant. Le mieux est encore de se faire un avis en face d’un écran.

Compatibilité : très satisfaisante la plupart du temps

Outre Arma III et Metro : Last Light, nous avons passé du temps avec Crysis 3, Tomb Raider, Skyrim, Bioshock : Infinite et Battlefield 4. A l’exception de Skyrim, tous ces jeux tirent parti de G-SYNC. Le ressenti a beau être différent d’un titre à l’autre, une fois que l’on a vu G-SYNC en action, les phénomènes inconsciemment occultés auparavant sautent aux yeux.

Il peut cependant y avoir des effets secondaires. L’aliasing est nettement plus perturbant lorsque le mouvement est fluide, raison pour laquelle on finit par augmenter l’anti-aliasing autant que possible pour s’épargner les effets d’escaliers qui n’étaient pas aussi pénibles jusque-là.

Skyrim : un cas particulier

Le Creation Engine sur lequel s’appuie le dernier Elder Scrolls a la particularité d’activer la V-sync par défaut. Il faut donc rajouter manuellement une ligne « iPresentInterval=0 » à l’un des fichiers .ini du jeu pour pouvoir exécuter les benchmarks à plus de 60 ips.

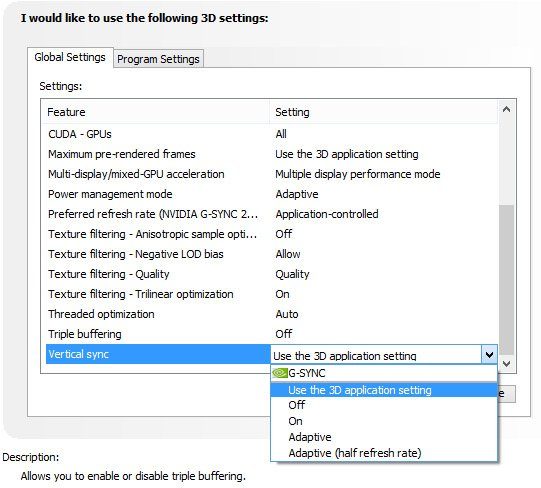

Il y a donc trois manières de tester les performances sous Skyrim : par défaut en laissant le pilote NVIDIA « utiliser le paramètre d’application 3D », en forçant G-SYNC via le pilote sans modifier le jeu et enfin en forçant G-SYNC tout en désactivant la V-sync par le fichier .ini du jeu.

Après avoir réglé notre écran prototype sur 60 Hz, le premier essai a rapporté sans surprise un débit constant de 60 ips en Ultra avec une GeForce GTX 770. En conséquence, les mouvements sont complètement fluides. En revanche, les commandes souffrent d’un input lag épouvantable, de même que l’on constate beaucoup de motion blur en déplacement latéral. Soulignons tout de même que la majorité d’entre nous a joué à Skyrim sur PC dans ces conditions. Le fait de passer à 144 Hz élimine le motion blur, mais vu que la GTX 770 débite entre 90 et 100 ips, on se retrouve avec des micro-saccades sensibles vu que le moteur du jeu fait du yo-yo entre 144 et 72 ips.

A 60 Hz, G-SYNC se montre nuisible, vraisemblablement parce que la V-sync est forcée alors que la technologie de NVIDIA a été conçue pour fonctionner sans. Les déplacements latéraux (tout particulièrement le long des murs) engendrent des micro-saccades assez conséquentes. Cette situation est donc problématique pour tous les écrans G-SYNC limités à 60 Hz, tout du moins sur des titres comme Skyrim. Fort heureusement, un moniteur comme l’Asus VG248Q permet de passer à 144 Hz et malgré le fait que la V-sync soit encore active, G-SYNC semble fonctionner avec un nombre d’ips élevé sans micro-saccades.

La désactivation de la V-sync par le fichier .ini rend le contrôle à la souris bien plus réactif sur ce titre, au prix d’un peu de tearing (sans parler d’autres anomalies graphiques comme l’eau scintillante). Avec G-SYNC, on souffre de micro-saccades à 60 Hz qui s’estompent à 144 Hz. Si nous effectuons la totalité des benchmarks sans V-sync pour les tests de cartes graphiques, nous déconseillons de la désactiver dans ce cas particulier.

Pour Skyrim, l’approche la plus propre est donc de désactiver G-SYNC tout en restant à 60 Hz, à condition de ne jamais descendre sous le seuil de 60 ips (ce qui n’est pas difficile compte tenu des ressources GPU qu’il nécessite).

Conclusion

Avant même de commencer les tests avec le moniteur G-SYNC prototype d’Asus, nous étions satisfaits de voir NVIDIA s’attaquer à un réel problème des jeux PC qui n’avait pas de solution jusqu’ici. En effet, nous étions limités à l’activation/désactivation de la V-sync sachant que dans les deux cas, il fallait consentir à un compromis nuisible à l’expérience de jeu. Lorsque l’on est réduit à jouer sans V-sync, à moins que le tearing ne soit insupportable sur un titre en particulier, il nous semble que l’on se contente de choisir non pas la meilleure solution mais la moins mauvaise.

G-SYNC vise à résoudre le problème en donnant au moniteur la capacité de se rafraîchir à fréquence variable. Ce genre d’innovation est indispensable à l’univers des jeux PC pour sortir de sa routine et tirer parti de sa supériorité technique sur les consoles et autres plateformes de jeu. Il ne fait aucun doute que NVIDIA est critiquable pour avoir choisi une approche propriétaire plutôt qu’un standard ouvert, laissant ainsi la liberté à d’autres marques de l’adopter. Cependant, cette même approche a le mérite de s’appuyer sur le DisplayPort 1.2, une connectique d’ores et déjà disponible. En conséquence, G-SYNC est disponible deux mois après son annonce.

La vraie question devient la suivante : les promesses sont-elles tenues ?

Il est naturellement difficile de répondre au-delà du buzz quand quatre des plus grands développeurs John Carmack, Tim Sweeney, Johan Anderson et Mark Rein, excusez du peu ! communiquent sans détour sur les mérites d’une technologie que l’on n’a pas encore pu voir en action. Si l’on commence par le test de la pendule pour se faire un avis, on en vient à se demander si l’énorme différence est réaliste ou bien s’il s’agit d’un cas particulier trop beau pour être vrai.

Bien entendu, le constat est plus nuancé quand on passe à des conditions de jeu réelles. Les réactions varient entre émerveillement et simple perception du changement. C’est en passant d’un écran 60 Hz à un moniteur 144 Hz avec G-SYNC que la différence est la plus spectaculaire, mais nous avons tout de même essayé de faire des tests à 60 Hz pour se faire une idée du rendu sur les moniteurs plus accessibles (on l’espère) à venir. Dans certains cas, le passage de 60 à 144 Hz est l’évolution la plus marquante, a fortiori quand on a la/les carte(s) graphique(s) capable de maintenir un excellent débit d’ips.

A l’heure actuelle, on sait déjà qu’Asus souhaite proposer G-SYNC sur une nouvelle version de son VG248QE, laquelle est annoncée à 400 $ avec une date de sortie dans les mois à venir. Sa dalle propose une définition native de 1920×1080 avec une fréquence maximale de 144 Hz. Le ROG SWIFT PG278Q poussera la définition à 2560×1440 sur une diagonale de 27 pouces, avec une fréquence maximale de 120 Hz (au minimum) pour 799 $. Cependant, il s’agit de dalles TN 6 bits dans les deux cas, ce qui pose problème à nos yeux. Nous attendons avec impatience les premiers modèles 1440p en IPS, quitte à se contenter de 60 Hz si nécessaire pour qu’ils soient proposés à un prix raisonnable.

CES oblige, les constructeurs commencement à communiquer sur leurs modèles à venir, leur prix ainsi que leur disponibilité qui parait globalement calée sur le second trimestre 2014. En revanche, la commercialisation du module G-SYNC en France n’est pas encore acquise, ce qui serait fort regrettable vu que NVIDIA estime à 20 minutes le temps nécessaire pour faire évoluer un Asus VG248QE première version.

On peut cependant dire que l’attente sera récompensée. G-SYNC saute aux yeux sur certains jeux et se montre un peu moins sur d’autres, mais cette technologie a le mérite de résoudre ce vieux dilemme quant à l’activation de la V-sync.

Autre point intéressant, la réponse d’AMD avec FreeSync. Les premières démonstrations sont convaincantes sur portable, mais qu’en est-il sur un moniteur relié à une tour ? Entre Battlefield 4 optimisé par Mantle, l’architecture Maxwell à venir chez NVIDIA, G-SYNC, le CrossFire géré par le moteur xDMA d’AMD ainsi que les rumeurs quant à la sortie de nouvelles cartes bi-GPU, le début de l’année s’annonce particulièrement intéressant !