Introduction

Plus de deux ans après la dernière carte graphique haut de gamme d’AMD, la R9 Fury X, les Radeon RX Vega débarquent enfin sur la marché grand public, après une Vega Frontier Edition destinée aux professionnels. La R9 Fury X était parvenu à bien concurrencer le meilleur de l’époque chez NVIDIA (GTX 980 Ti et autre Titan X Maxwell), la question se pose aujourd’hui pour les RX Vega 64 et 56, que l’on espère à la hauteur, même si nos premières anticipations sur la Vega FE les plaçaient plutôt face aux GTX 1080 et 1070.

Pour la petite histoire, la carte nous a été envoyée dans un bundle collector, avec une flopée de goodies en tout genre et même une puce Vega 10 seule, pour la postérité ! Ceci nous laisse penser que les cartes ont aussi été bien choisies, avec un GPU de bonne qualité (voir Golden Sample). Les performances, température et consommation que vous verrez dans ce test seraient alors en plein potentiel de Vega 10, mais nous ne pouvons pas le confirmer pour l’instant.

MSI Radeon RX Vega 56 HMB2 – 8 Go

AMD Radeon RX Vega 64

AMD Radeon RX Vega 56 – Promo

Caractéristiques des Vega 64 et 56

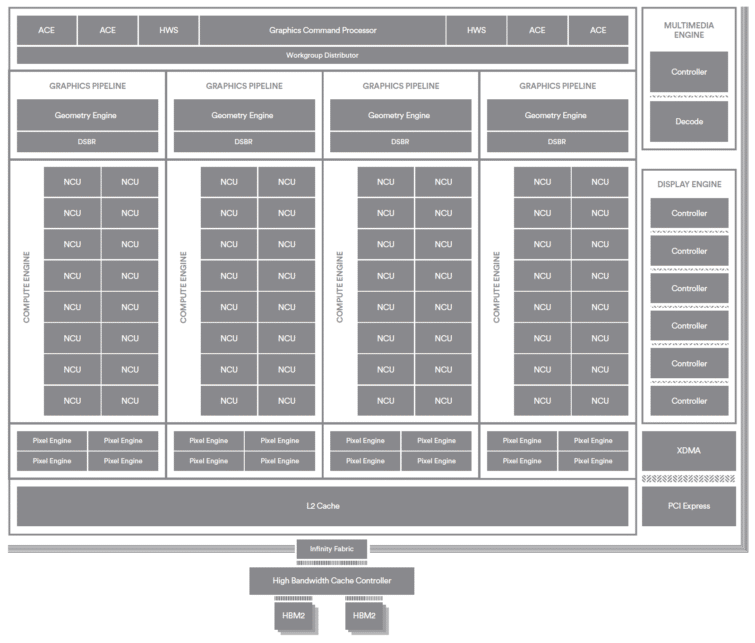

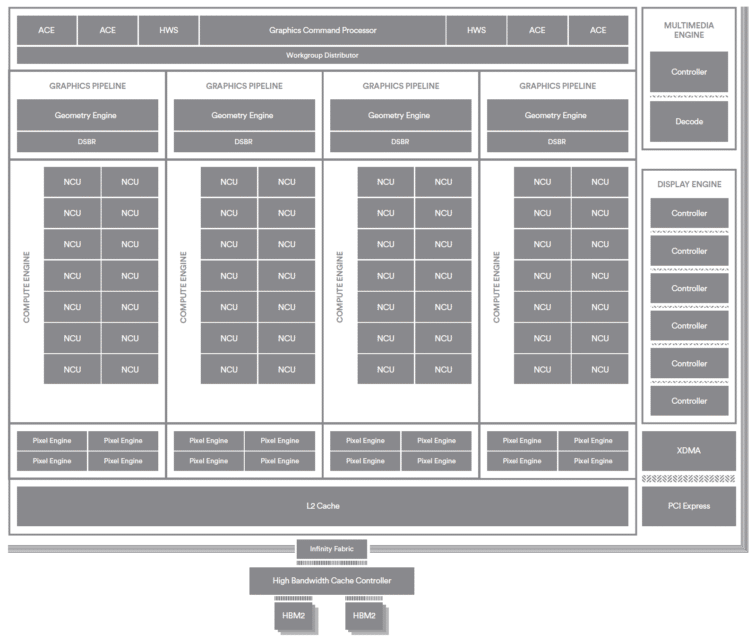

Les Vega 64 et 56 ont la même architecture, dont l’organisation est similaire à celle des précédentes puces Fiji des Radeon R9 Fury X : quatre shader engines (appelés graphics pipeline sur le diagramme), chacun avec ses propres unités de géométrie et de rasterisation. Dans ces moteurs, il y a plusieurs Compute Units (unités de traitement) embarquant chacune 64 processeurs de flux (Stream Processors) et quatre unités de texture.

Il y aura 16 CU par moteur sur la Vega 64 (4096 processeurs de flux et 256 unités de texture) et 14 CU sur la Vega 56 (3584 processeurs de flux et 224 unités de texture). Les deux puces ont 64 ROP. Ajoutez à cela des fréquences inférieures pour le GPU de la Vega 56, et vous obtenez une bonne différence de puissance théorique.

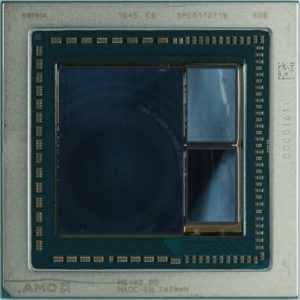

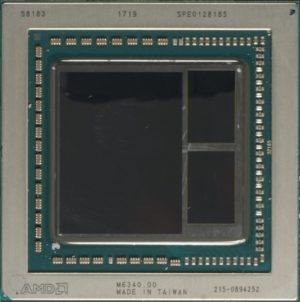

Le mystère de l’appellation est ainsi résolu : à gauche, le GPU complet de la Vega 64 avec ses 64 CU. A droite, le GPU de la Vega 56 et ses 56 CU !

Notez que ces puces intègrent 4 Mo de mémoire cache L2, mais qu’elles totalisent en leur sein 45 Mo de SRAM, ce qui est énorme. Du coup, les Vega 10 regroupent 12,5 milliards de transistors sur une surface de 486 mm² ! C’est encore plus que le GPU GP102 de NVIDIA. Les Vega 10 sont gravés selon le processus 14 nm FinFET de GlobalFoundries.

| Modèle | RX Vega 64 | RX Vega 56 |

|---|---|---|

| Processeur de flux | 4096 | 3584 |

| Unités de texture | 256 | 224 |

| ROP | 64 | 64 |

| Fréquences (MHz) | 1247 – 1546 | 1156 – 1471 |

| TFLOPS | 12,66 | 10,5 |

| RAM | 8 Go | 8 Go |

| Bus mémoire | 2048 bits | 2048 bits |

| Débit RAM | 1,89 Gbit/s | 1,6 Gbit/s |

| Bande passante mémoire | 484 Go/s | 410 Go/s |

Profils de fonctionnement

Les deux Radeon RX Vega embarquent deux BIOS et trois profils d’utilisation dans WattMan. Elles ont donc un total de 6 modes de fonctionnement plus ou moins agressif. Notez que nous avons testé les cartes dans les jeux selon leur configuration par défaut (BIOS 1 mode équilibré en gras sous le tableau). Nous avons testé les autres profils : l’un sacrifie les performances, l’autre l’efficacité. Le mode équilibré en BIOS 1 est définitivement le meilleur compromis.

| Modèle | Refroidissement | BIOS | Profil de consommation | ||

|---|---|---|---|---|---|

| RX Vega 64 | Economie | Equilibré | Turbo | ||

| Air | Primaire | 165 W | 220 W | 253 W | |

| Secondaire | 150 W | 200 W | 230 W | ||

| Eau | Primaire | 198 W | 264 W | 303 W | |

| Secondaire | 165 W | 220 W | 253 W | ||

| RX Vega 56 | Air | Primaire | 150 W | 165 W | 190 W |

| Secondaire | 135 W | 150 W | 173 W | ||

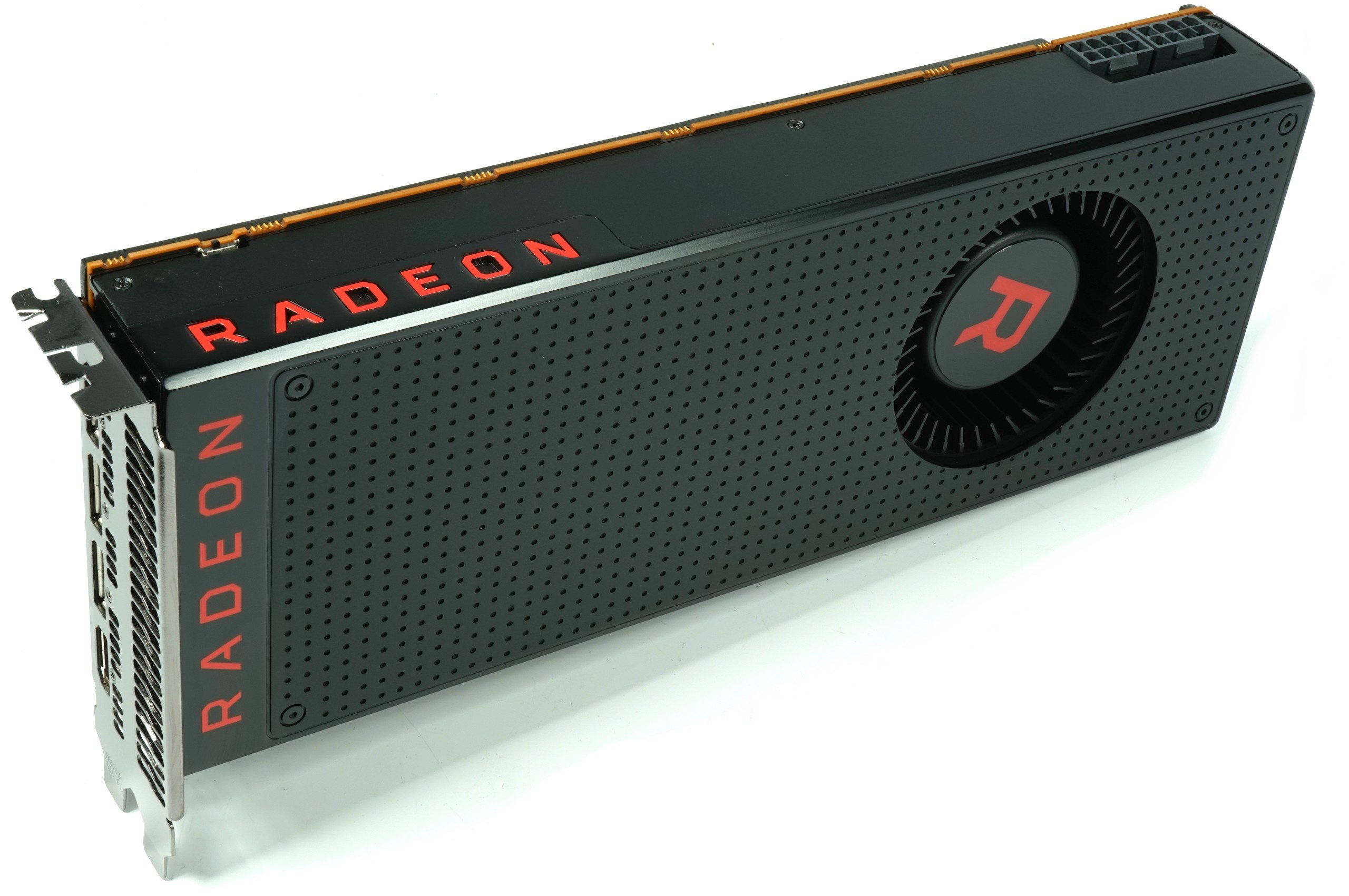

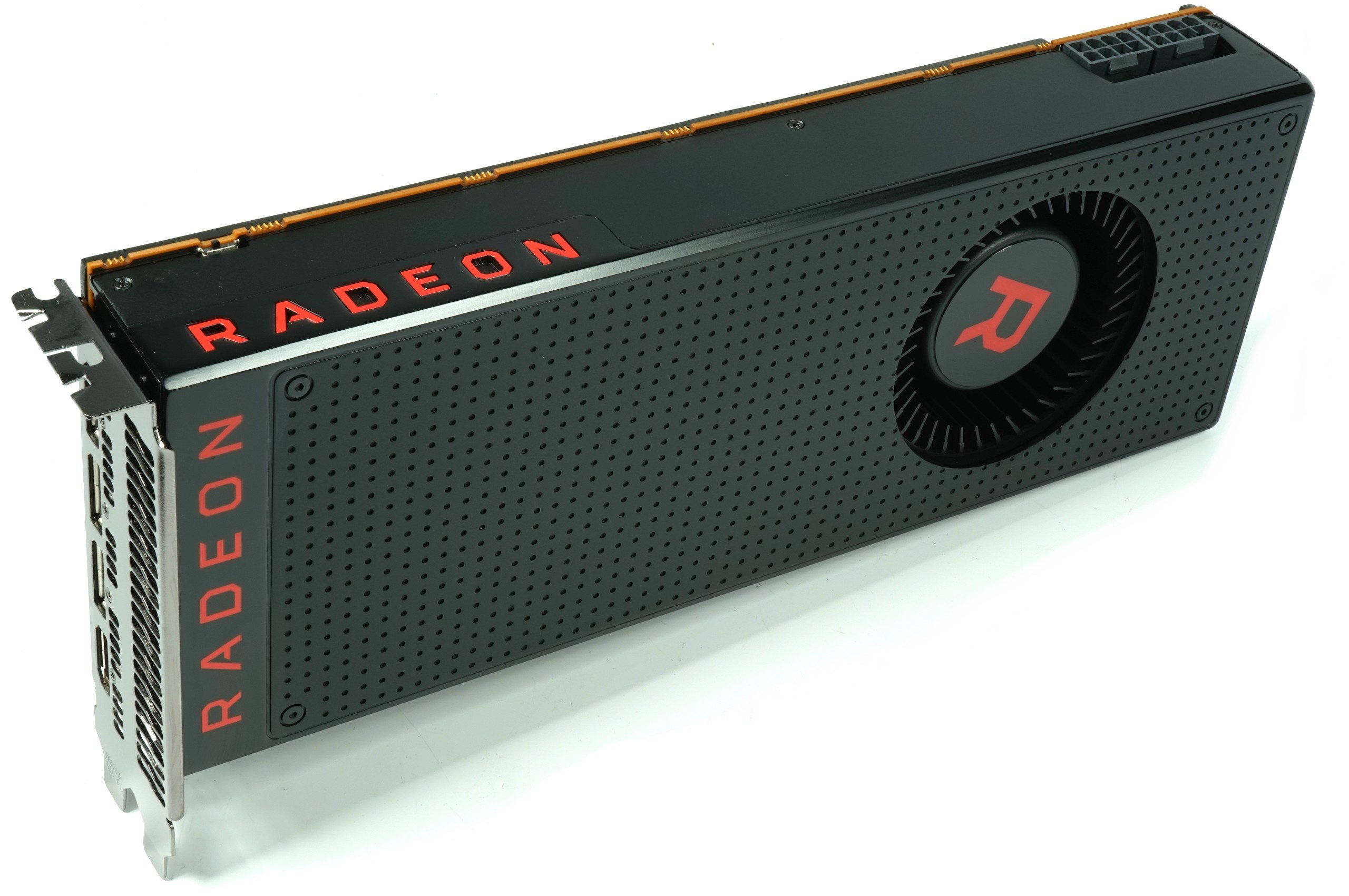

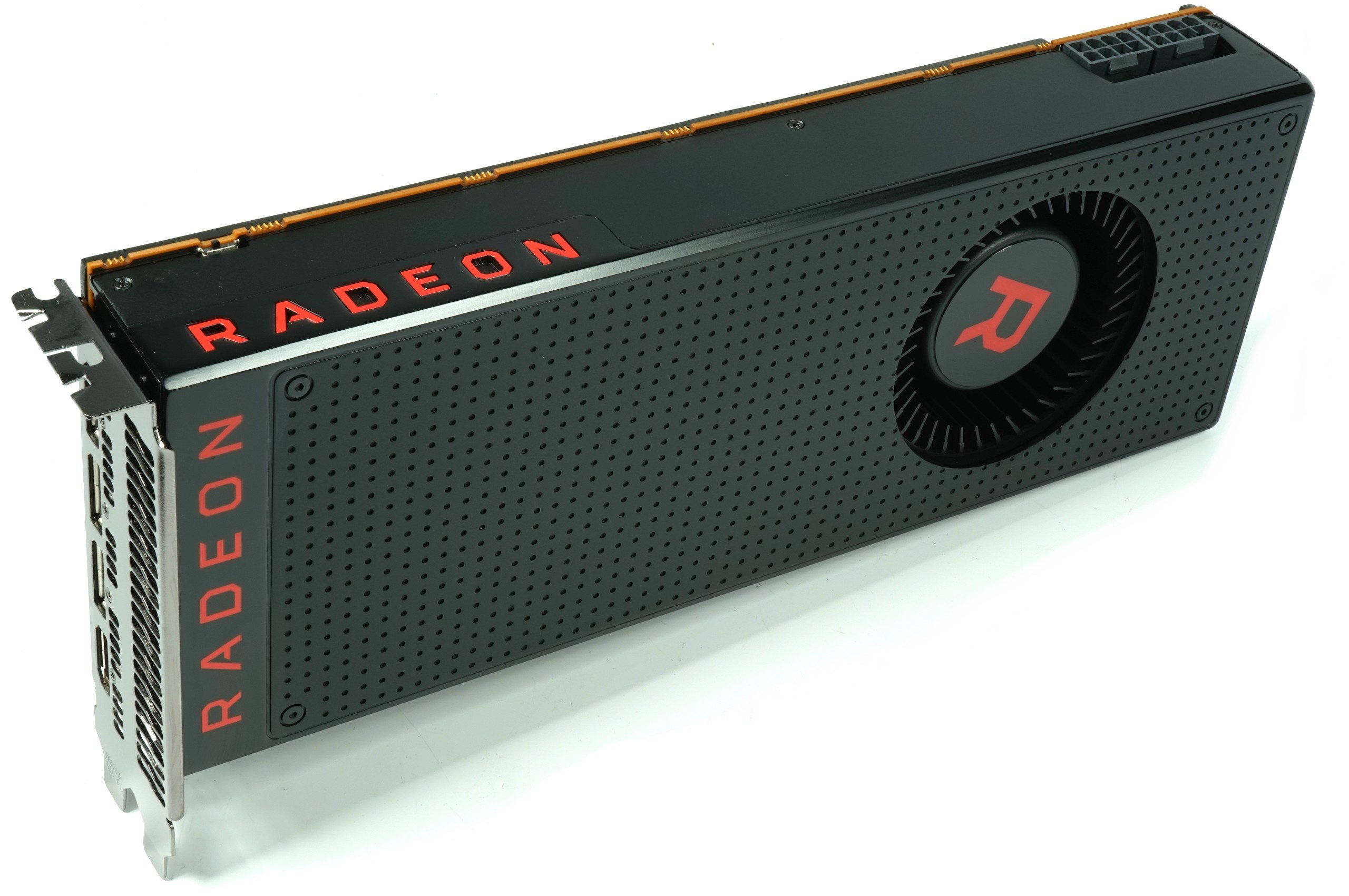

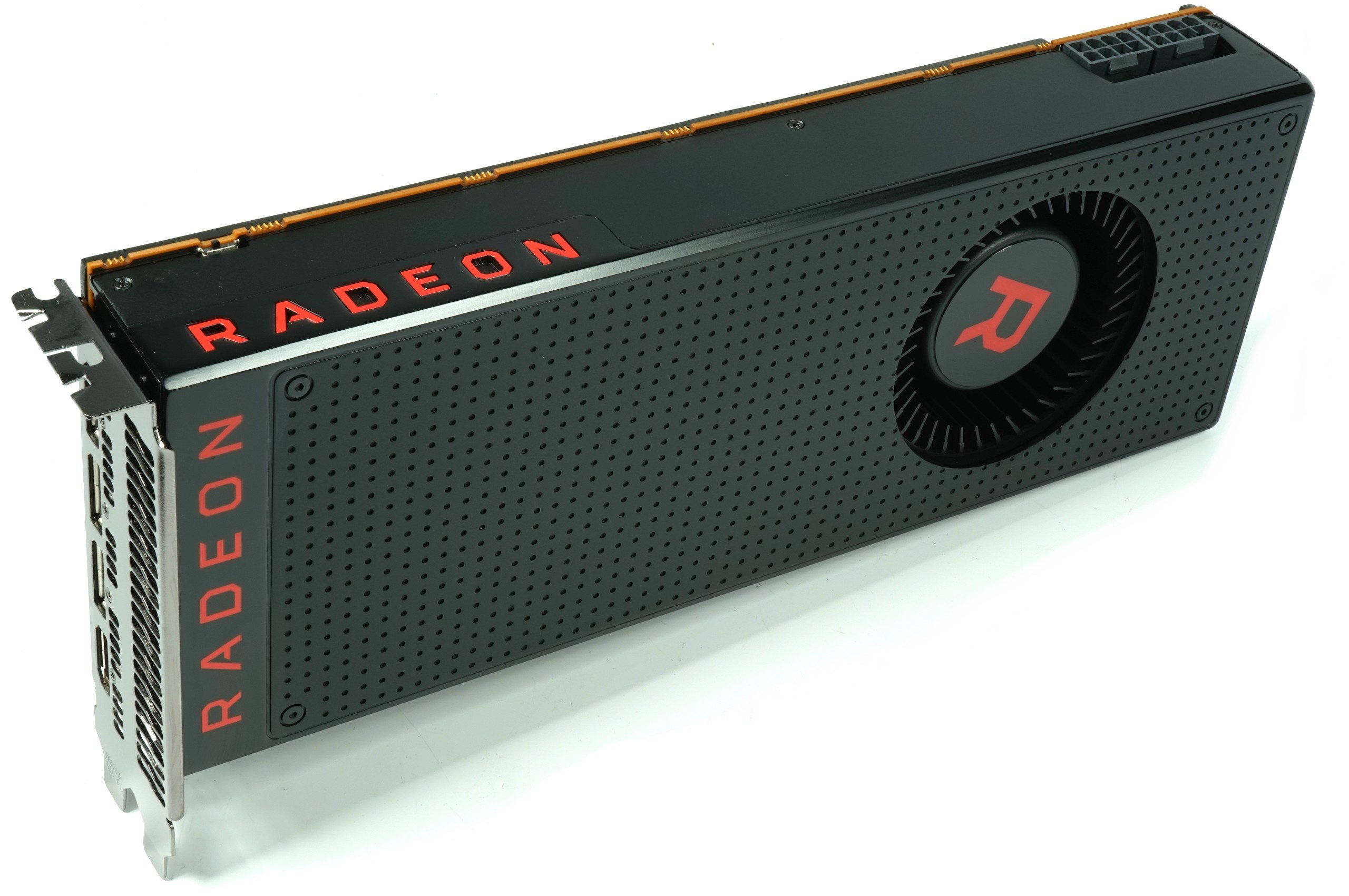

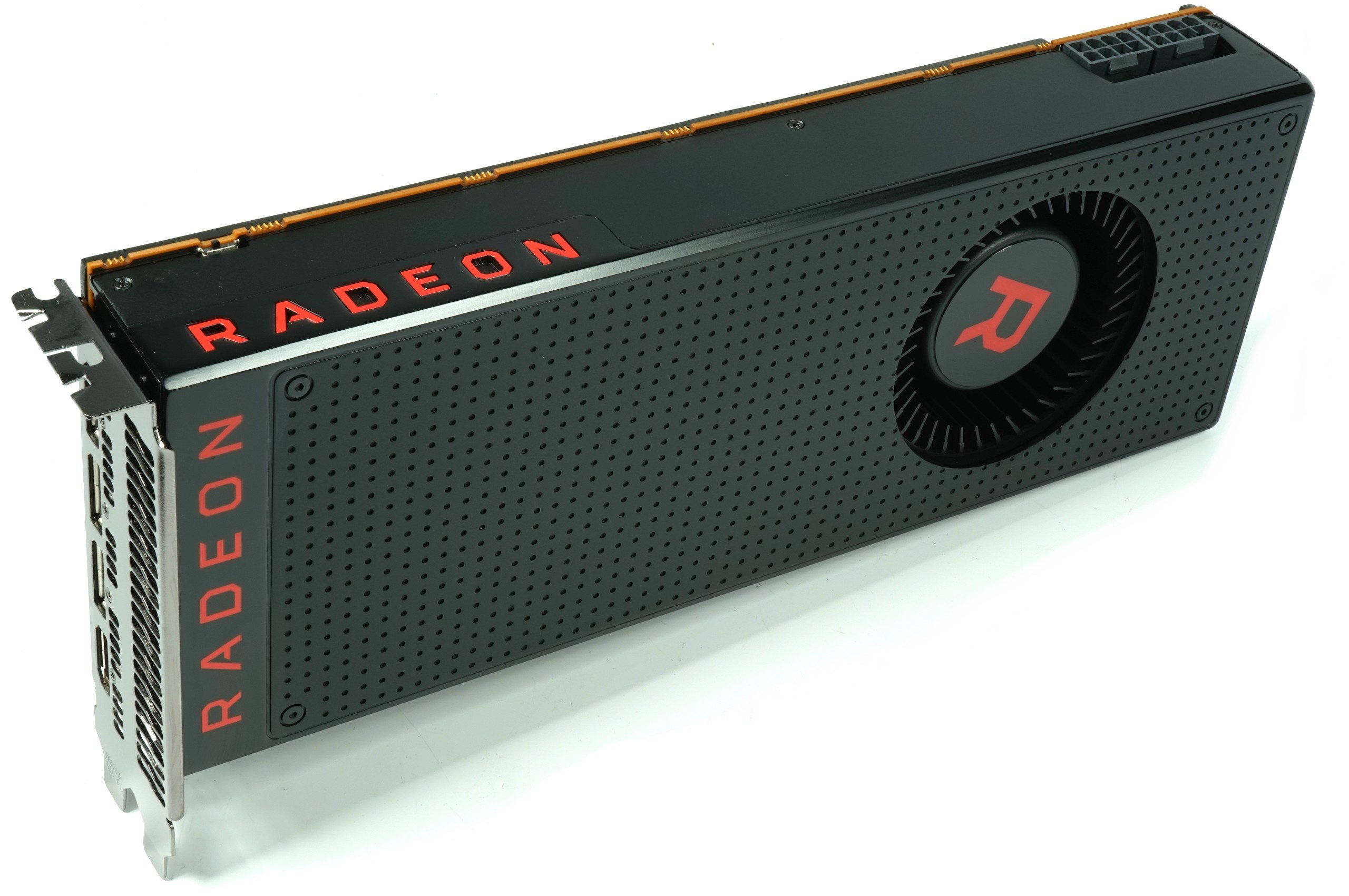

Design exterieur et connectique

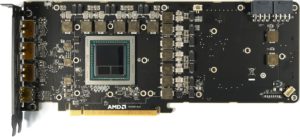

Autant le dire tout de suite : les Vega Frontier Edition, RX Vega 64 et 56 sont toutes identiques, avec le même PCB, les mêmes composants (hormis le GPU) et le même système de refroidissement. Seules les couleurs changent.

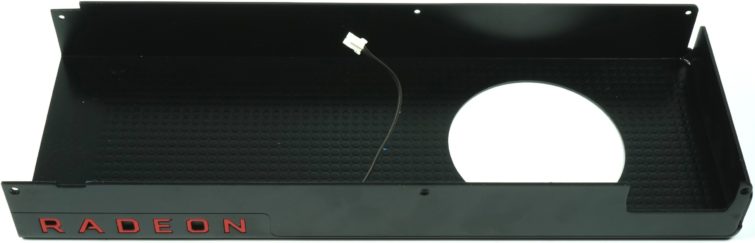

La RX Vega 64 fait 1066 grammes et mesure 26,8 x 10,5 x 3,8 cm. Une carte plutôt compacte qui s’intègrera facilement sur un double slot (la plaque arrière ajoute 4 mm d’épaisseur).

Le boîtier frontal de la carte et la plaque arrière sont en aluminium anodisé, ce qui donne une allure très haut de gamme à la carte. Même les vis sont peintes en noir mat.

Le switch pour passer d’un BIOS à l’autre est situé en bas à droite de la carte sur le PCB (juste sous le A de Radeon). La carte embarque aussi trois connecteurs Displayport et un HDMI 2.0. Pas de port DVI pour faciliter l’évacuation de l’air chaud hors du PC.

Démontage de la carte

Les Radeon RX Vega 64 et 56 sont strictement identiques : même PCB, mêmes composants, même dissipateur, même matériaux. Seul le BIOS et le GPU changent en fonction du modèle.

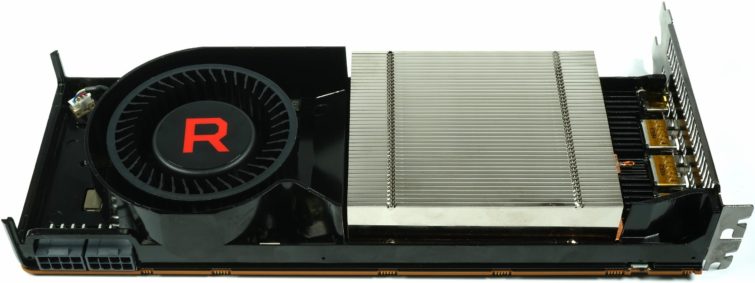

Dissipateur

AMD opte donc pour un dissipateur évacuant l’air chaud hors du boîtier, une solution plus adaptable pour les fabricants d’ordinateurs. Le dissipateur est identique à celui de la Vega Frontier Edition (tout comme la carte). Seule la couleur change.

La plaque arrière est en aluminium anodisé. L’esthétique est son seul objectif, car elle ne participe pas à la dissipation thermique, en l’absence de contact avec le PCB. Nous avons tenté de placer des pads thermiques aux endroits stratégique pour améliorer la dissipation, mais sans résultats probants, excepté au niveau des doubleurs des MOSFET. Bref, inutile de vous épuiser !

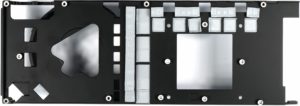

En revanche, la plaque frontale participe fortement au refroidissement de la carte, en contact avec tous les composants de l’étage d’alimentation, même les bobines. Elle est très bien conçue.

Le corps du radiateur du processeur est composé de fines ailettes en aluminium, posées sur une grande chambre à vapeur en contact avec le GPU et sa mémoire. Notez que si vous cassez la soudure de la chambre à vapeur (en bas au centre sur la photo de droite), la chambre à vapeur ne remplira plus du tout sa fonction. Soyez prudent !

Le ventilateur radial fait 7 cm de diamètre, avec un rotor à roulement à bille signé Delta. C’est une première pour AMD, qui devrait permettre à la carte d’être moins bruyante que les précédentes. Les anciens ventilateurs pouvaient monter à 10 000 tpm, celui-ci se limite à 5000 tpm maximum, ce qui est déjà beaucoup. L’objectif d’AMD est à 40 ou 41 % de cette vitesse, soit environ 2000 tpm. Les cartes sonnent donc plutôt comme les GeForce Founders Edition, sauf avec certains profils de BIOS…

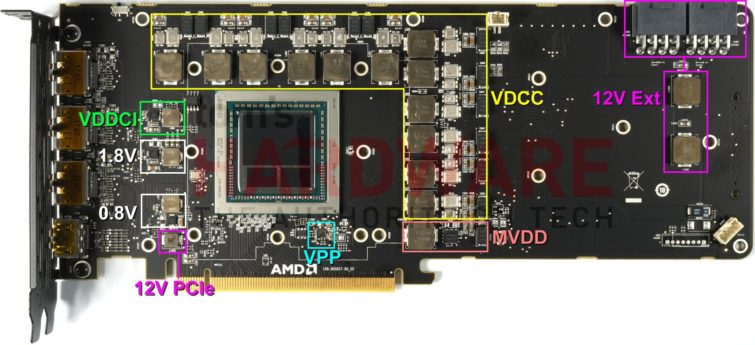

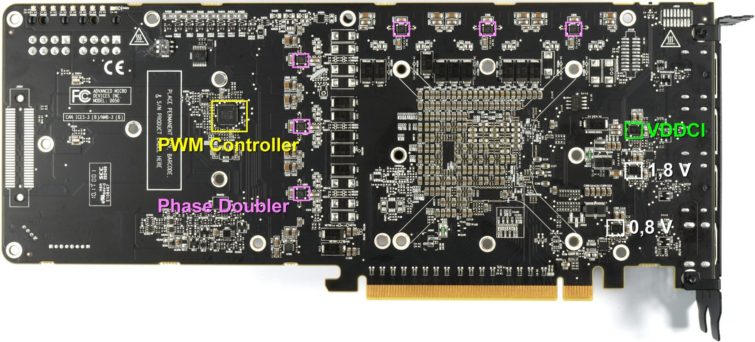

Voilà le PCB totalement nu. On peut y voir le GPU et sa RAM HBM au centre, entouré de son étage d’alimentation, détaillé en page suivante.

La question épineuse du, ou des, GPU

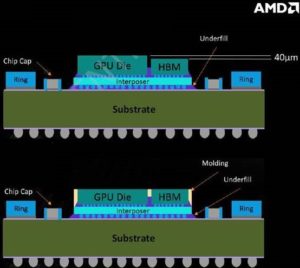

Nous avons trouvé plusieurs type de GPU, certains nivelés, avec de la résine époxy, d’autres sans résine, avec des puces de mémoire qui ne sont pas à la même hauteur. Ce qui va poser quelques difficultés de production aux fabricants de cartes graphiques, comme nous l’expliquons en détail dans cette actualité. Ajoutons ici quelques explications supplémentaires :

Le problème, c’est qu’AMD utilise actuellement les deux variantes du packaging, lesquelles proviennent de deux usines différentes, ce qui pose naturellement de gros problèmes aux constructeurs de cartes. Dans le passé, AMD envoyait les puces fonctionnelles à SK Hynix en Corée du Sud qui ajoutait les modules HBM au package avant de les renvoyer. Les packages des cartes que nous avons reçues sont issues cette fois-ci des usines ASE basées à Taiwan.

Mais où est le problème ? C’est que les package non recouverts ne sont pas parfaitement plats : la surface de la mémoire HBM2 est 40 μm plus basse que celle du GPU et l’underfill n’est pas non plus identique d’un exemplaire à l’autre, ce qui entraine des retards dans la production des cartes partenaires. Outre les problèmes dans le processus SMT, les partenaires doivent opérer des ajustements supplémentaires.

Selon nos informations, certains fabricants se voient obligés de fixer le bloc de refroidissement non pas avec quatre vis mais six vis, ce qui les oblige à modifier voire jeter les blocs de refroidissement et les plaques arrières déjà produits pour les packages sans résine.

Il y a aussi des problèmes au niveau des pâtes thermiques dont la consistance et l’épaisseur seraient inappropriées : ce qui était idéal pour les packages fondus dans une masse peut s’avérer inapproprié sur les packages non fondus. La pression nécessaire au bon contact peut aussi varier, ce qui pose de grands problèmes dans une chaine de production, puisque le fabricant ne sait jamais quel type de package il va recevoir. Nous suivrons les suites de cette problématique dans les prochaines semaines.

PCB et composant

Encore une fois, nous rappelons que les deux Radeon Vega 56 et 64 ont exactement le même PCB et les mêmes composants. Seul le BIOS et le GPU changent selon le modèle. Et c’est d’ailleurs pareil pour la Vega Frontier Edition.

Tous les détails des composants et du PCB sont donc déjà disponibles sur cette page du test de la Vega Frontier Edition.

Notez que la longueur du PCB est uniquement faite pour accueillir le grand dissipateur de la carte. Une carte personnalisée petit format est donc parfaitement envisageable, et AMD semble déjà en avoir une en préparation pour succéder à la R9 Nano.

L’étage d’alimentation est composé de 6+1 phases dédoublées.

Methode de test

Nous avons armé notre configuration de test d’un processeur plus puissant pour nos tests de performances (un 7700K qui reste au top pour les jeux). Nous avons testé les RX Vega avec leur configuration en sortie de boîte : BIOS le plus agressif en mode équilibré. Il existe un second BIOS plus économe et des modes plus ou moins demandeurs en énergie.

Nous avons évidemment comparé les cartes au très haut de gamme de NVIDIA, la 1080 Ti, sans oublier les 1080 et 1070, et en retestant aussi les vieilles R9 Fury X et même la R9 390X, qui se débrouille toujours très bien.

Les mesures sont toujours faites avec notre interpréteur de données couplé à PresentMon et OCAT 1.1.0 pour collecter toutes les données nécessaires. Les pilotes utilisés étaient les 384.94 chez NVIDIA et Crimson ReLive Edition 17.7.2.

Systèmes de test

Nous avons détaillé notre système de test complet dans cet article, il est aujourd’hui équipé d’un oscilloscope de plus et d’un nouvel écran, avec un nouveau processeur, et quelques petits détails pour améliorer l’ensemble.

Allemagne Intel Core i7-6900K @4,3 GHz MSI X99S XPower Gaming Titanium Corsair Vengeance DDR4-3200 Toshiba OCZ RD400 1 To (M.2, Système) 2 Toshiba OCZ TR150 960 Go (Stockage, images) Be Quiet Dark Power Pro 11, 850 Watts Windows 10 Pro Creators Update Etats-Unis Intel Core i7-7700K MSI Z270 Gaming Pro Carbon G.Skill F4-3200C14Q-32GTZ 1x 500 Go Crucial MX200 be quiet! Dark Power Pro 11, 850 Watts Windows 10 Pro (Creators Update) |

| Germany Alphacool Eiszeit 2000 Chiller Alphacool Eisblock XPX Thermal Grizzly Kryonaut |

| Eizo EV3237-BK |

| Lian Li PC-T70 modifié, mode ouvert ou fermé |

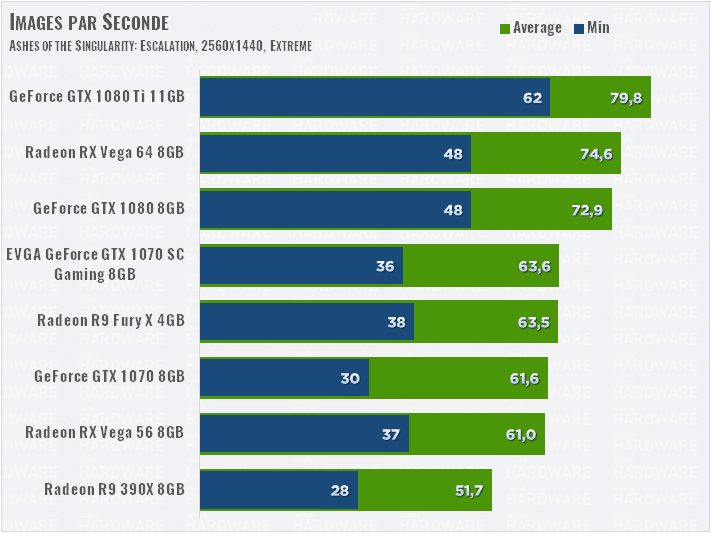

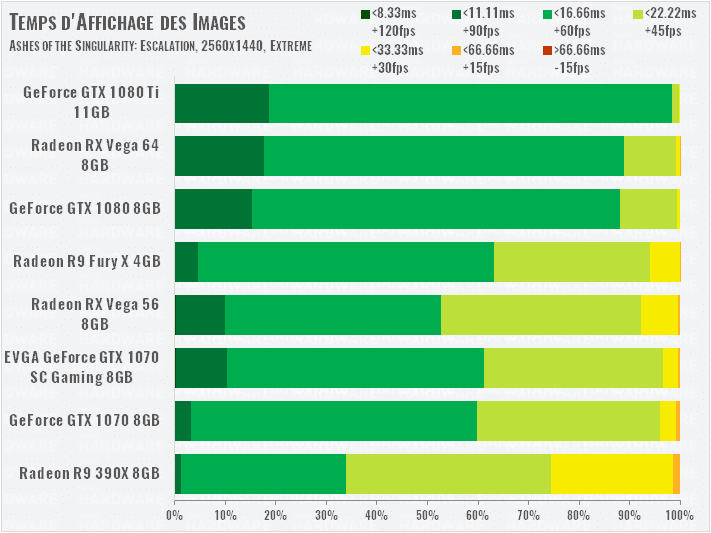

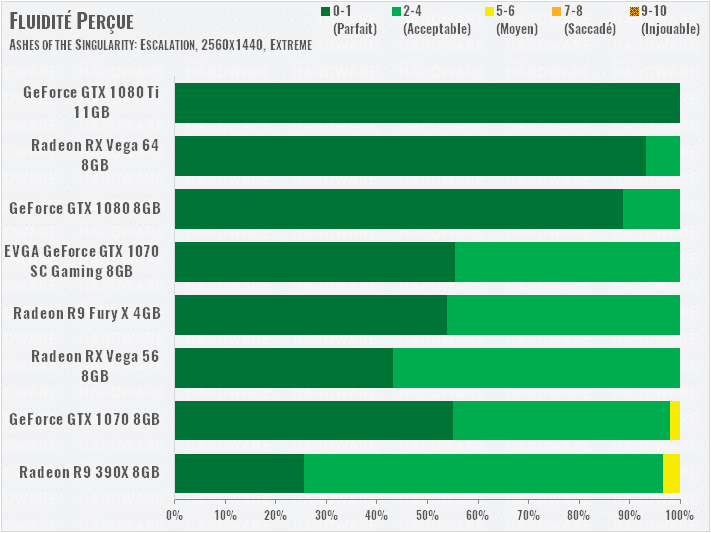

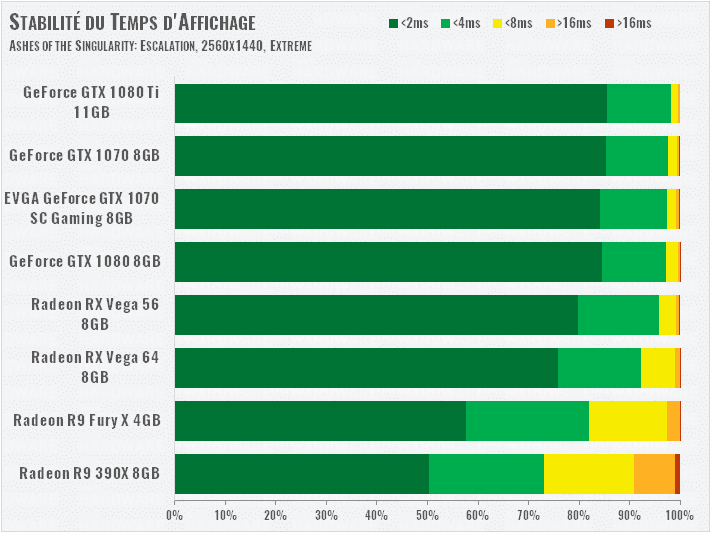

Ashes of the Singularity: Escalation (DirectX 12)

2560×1440

La Vega 64 parvient à surpasser la GTX 1080 de peu, mais les cartes AMD ont un temps d’affichage un peu moins stable que celles de NVIDIA. La GTX 1070 a toutefois de plus fortes variances plus fréquentes au delà des 16 ms. Côté Vega 56, la carte offre 82 % des performances de la Vega 64 et garde une bonne position face à la GTX 1070.

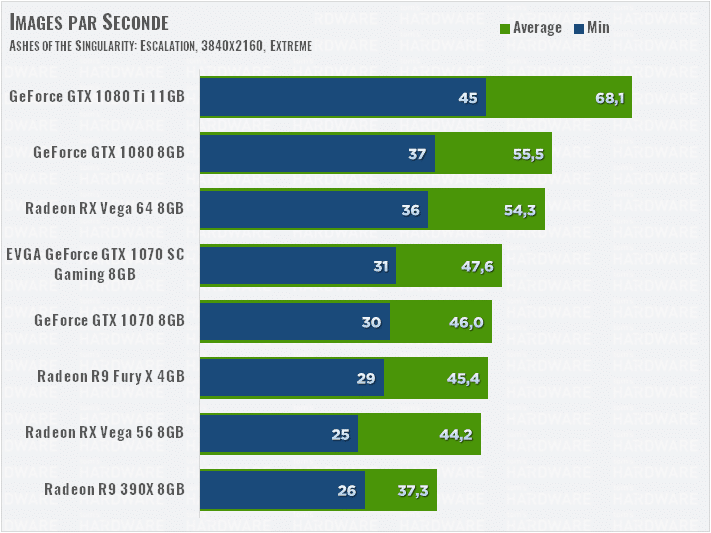

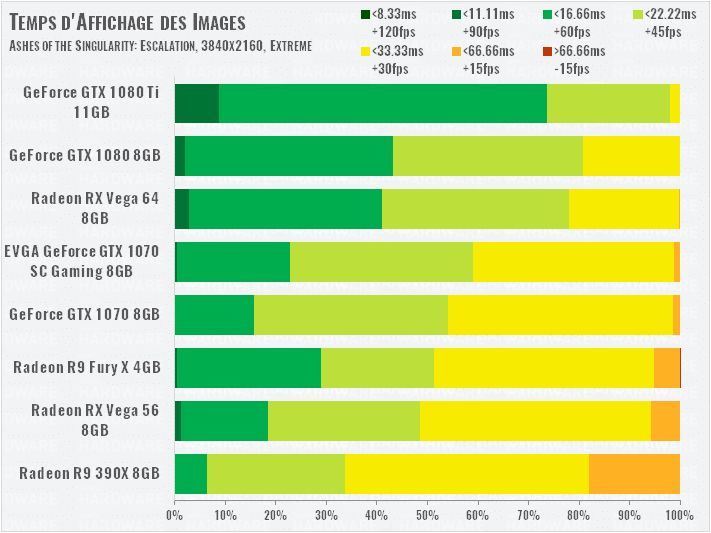

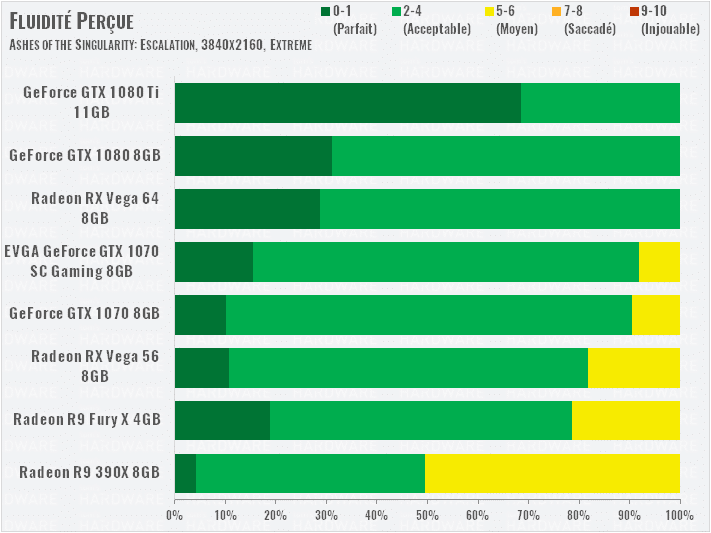

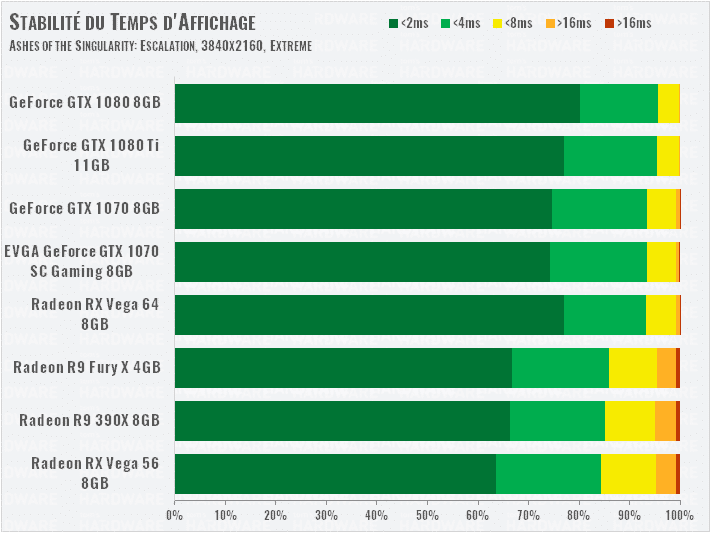

3840×2160

En 4K, la Vega 64 se retrouve derrière la GTX 1080, mais de peu. La Vega 56 perd encore plus de terrain face à la GTX 1070, surtout qu’elle présente plus de variations de temps d’affichage supérieures à 16 ms, la fluidité perçue est alors impactée.

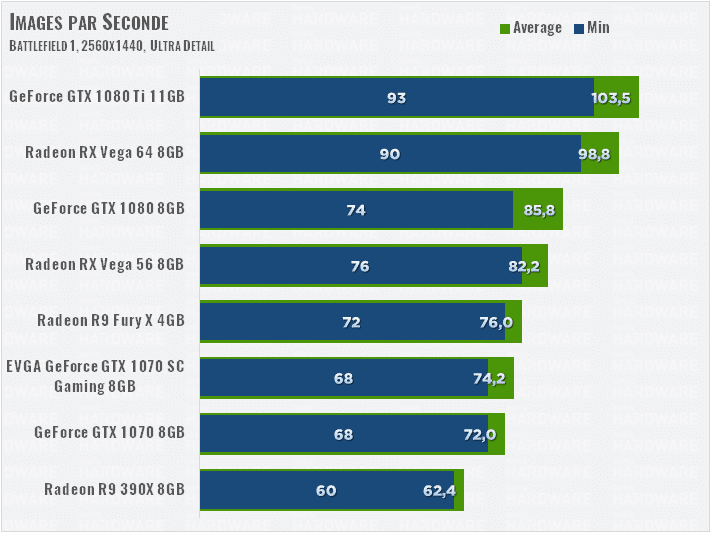

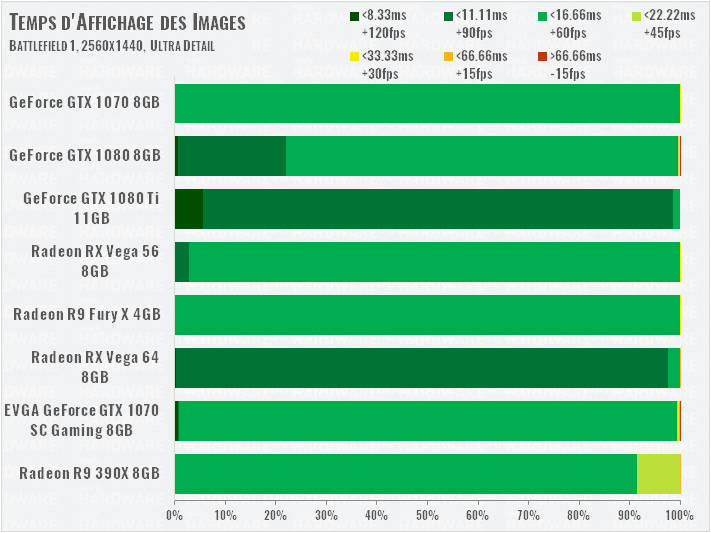

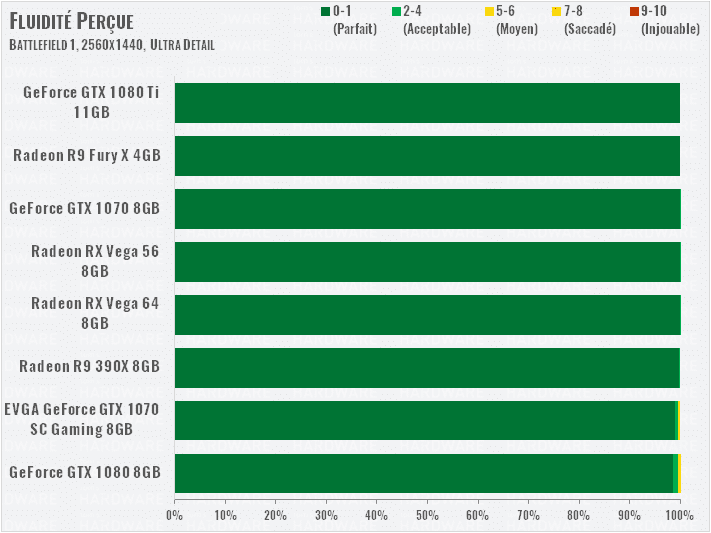

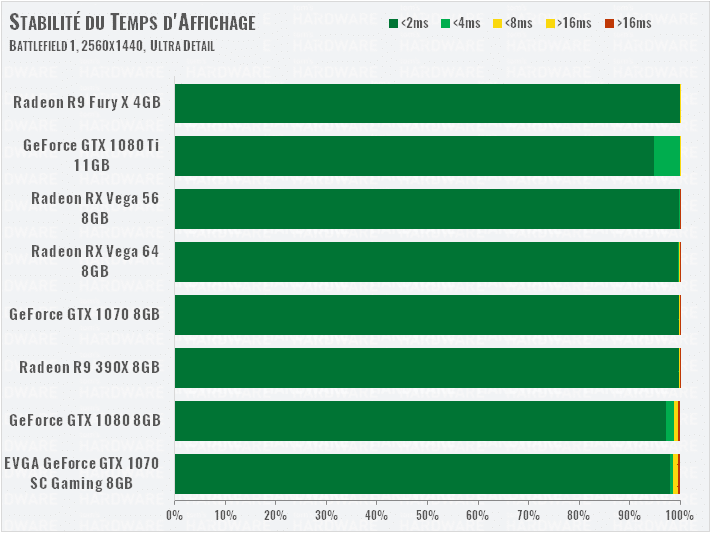

Battlefield 1 (DirectX 12)

2560×1440

Carton plein d’AMD pour ce jeu DirectX 12 : les Vega surpassent nettement les GTX 1080 et 1070. La RX Vega 64 parvient même à taquiner la GTX 1080 Ti, ce qu’on aimerait voir dans plus de jeux ! Notez que les 1080 et 1070 souffrent de petits pics de temps d’affichage bien supérieurs à 16 ms, ce qui impacte (très peu), la fluidité générale de notre séquence de test.

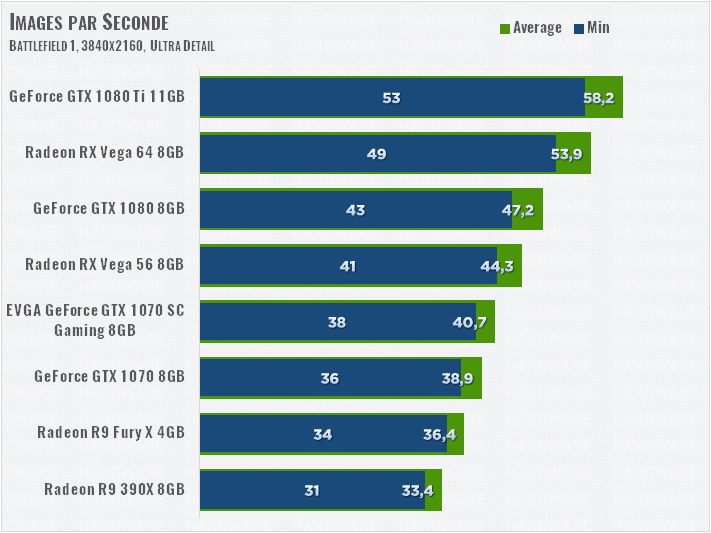

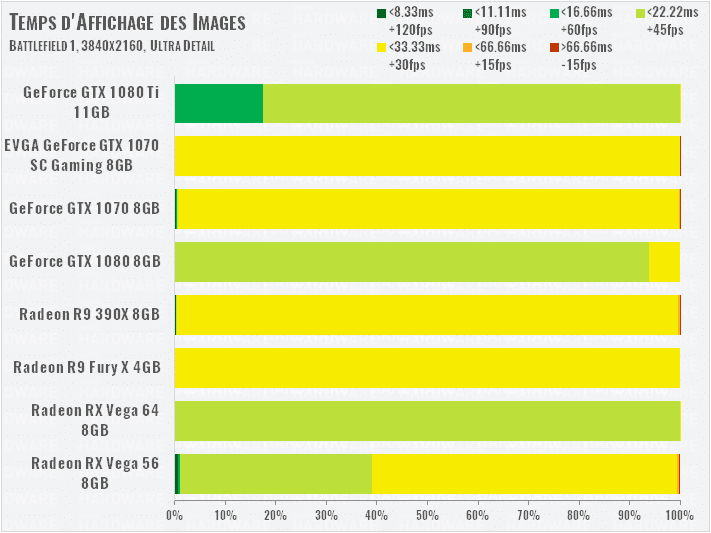

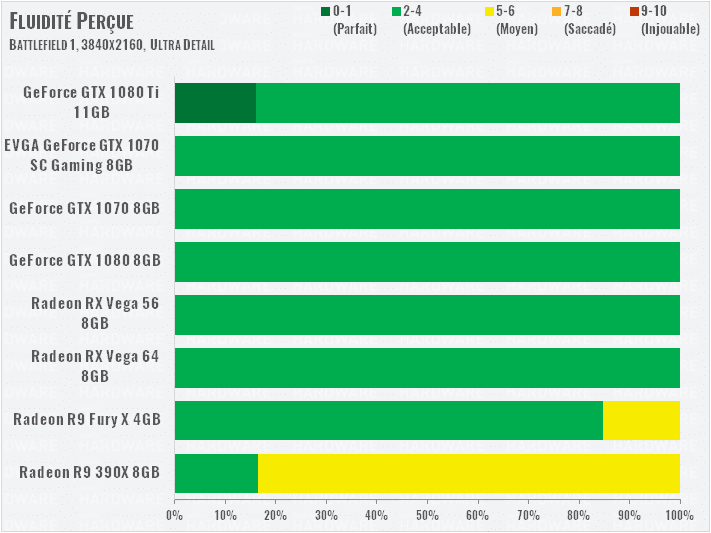

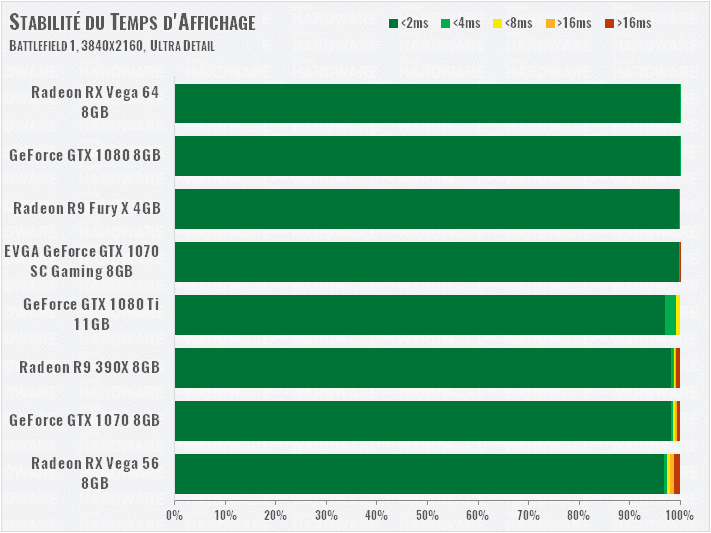

3840×2160

La Vega 56 parvient à offrir un framerate jouable, jamais sous les 40 ips. Encore une fois, même en 4K, les performances des Vega dans ce jeu sont impressionnantes.

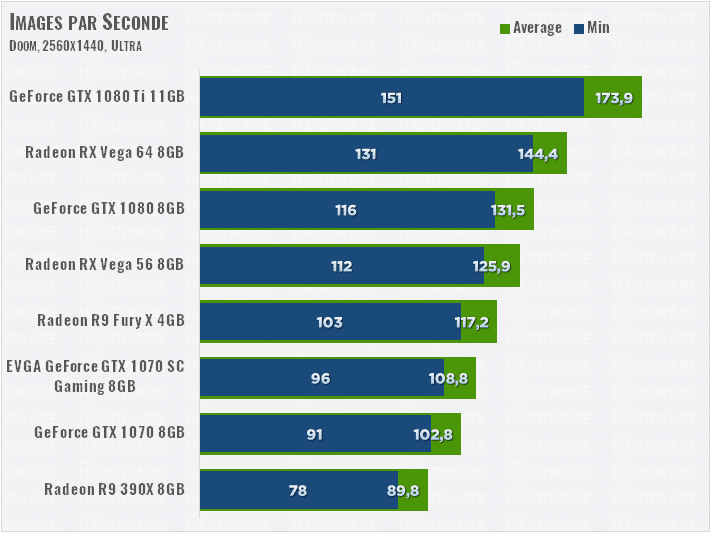

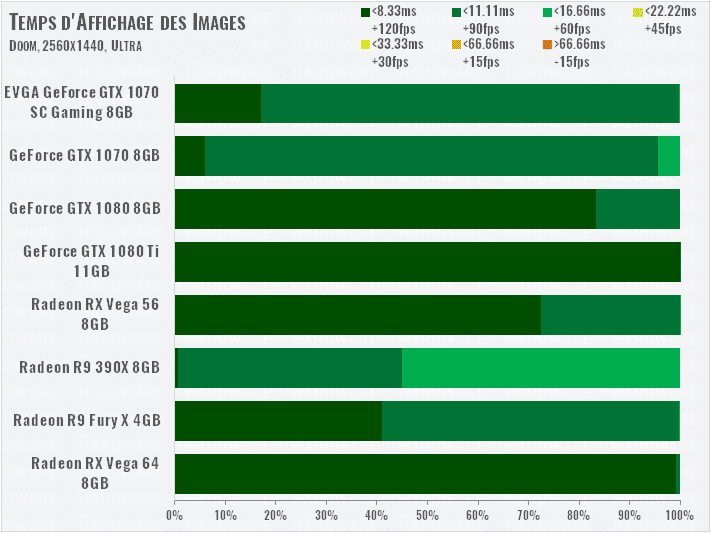

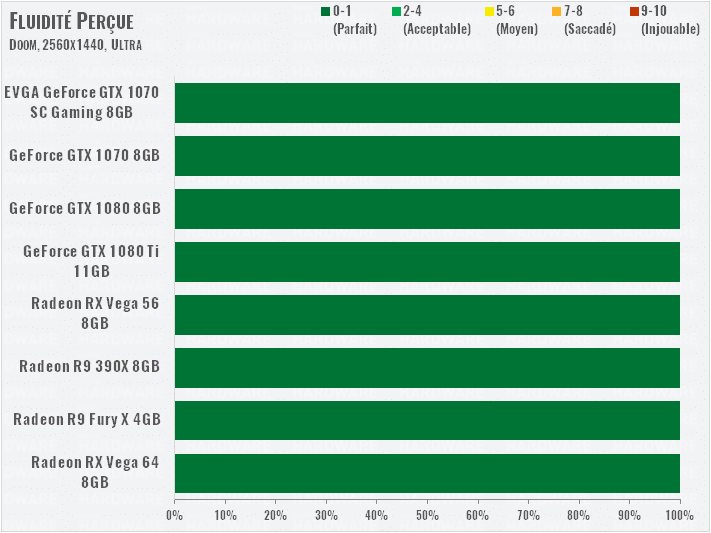

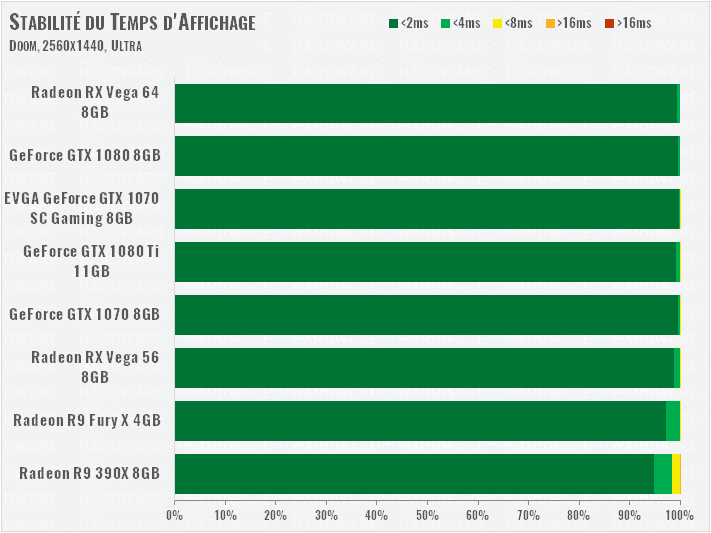

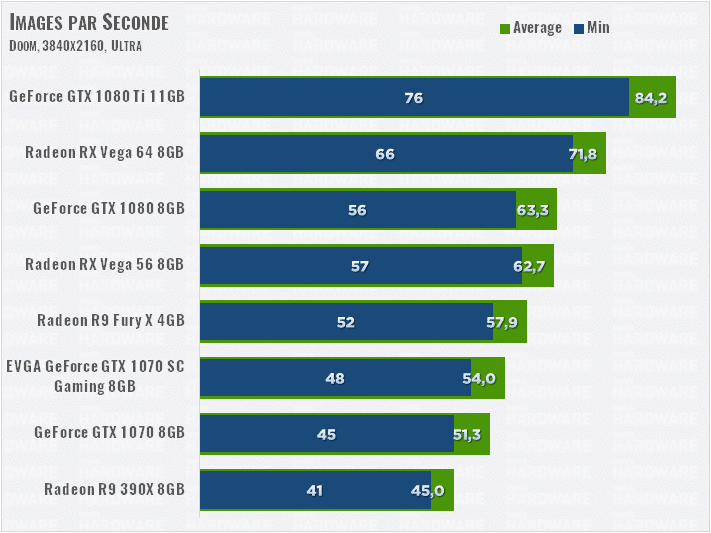

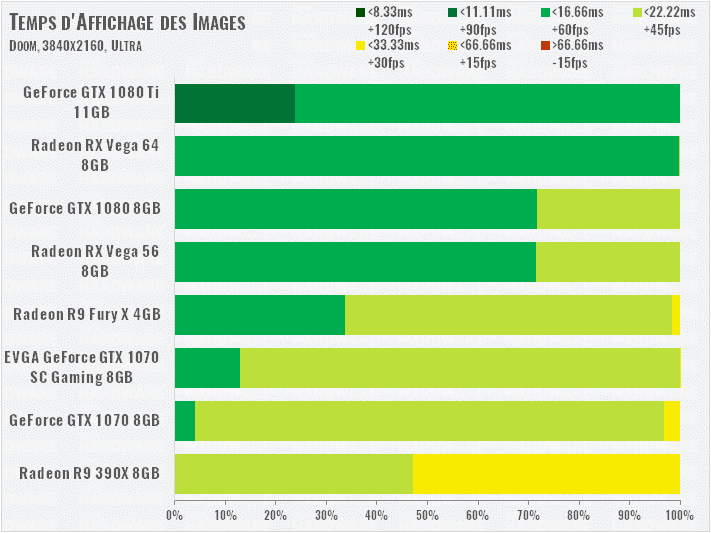

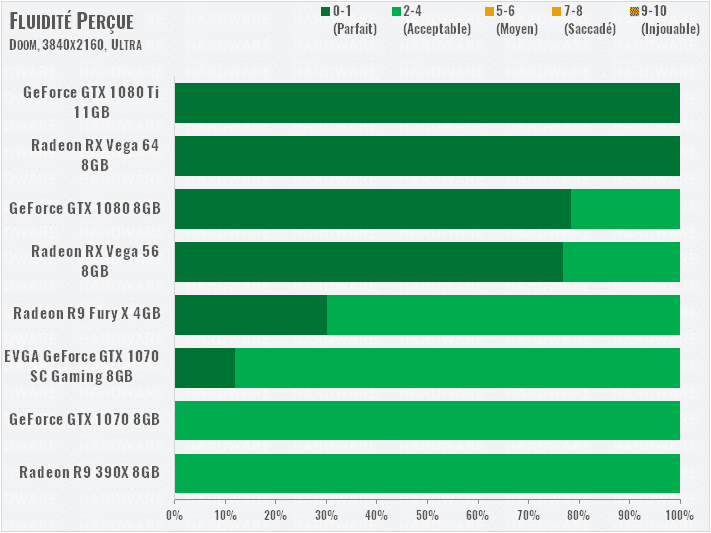

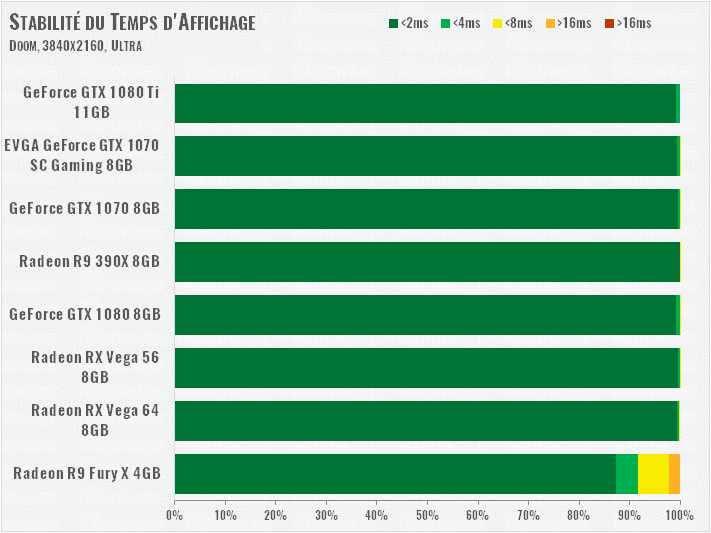

Doom (Vulkan)

2560×1440

Ce jeu sous API Vulkan fait aussi le bonheur des Vega, qui surpassent leur concurrentes GTX 1080 et 1070 de manière assez nette. Même la R9 Fury X 4Go surpasse la GTX 1070 overclockées d’EVGA, ce qui montre à quel point l’architecture d’AMD est à l’aise dans ce jeu (ou sous cette API !).

3840×2160

L’écart est encore plus net en 4K, ou même la RX Vega 56 est à deux doigts d’égaler la GTX 1080. Même en UHD, le jeu est très fluide au maximum de ses options graphiques, en témoigne notre graphique de fluidité perçue.

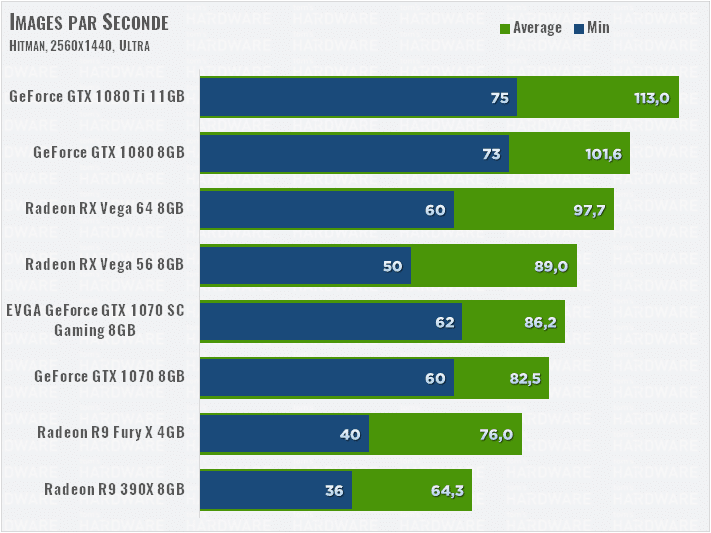

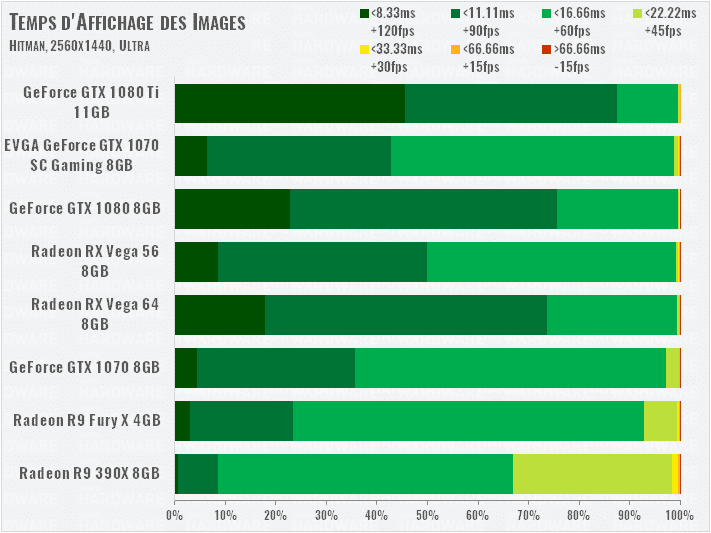

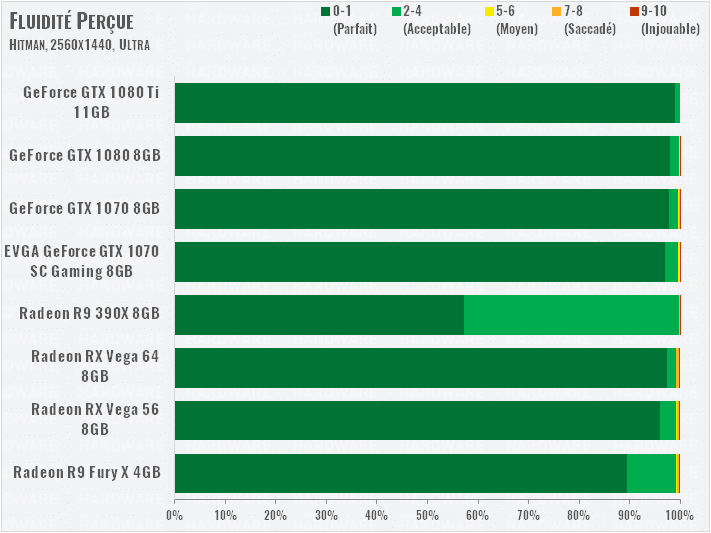

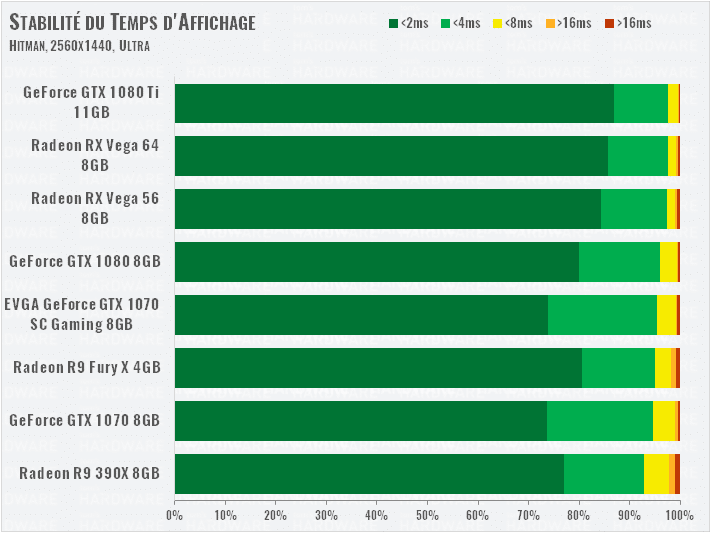

Hitman (DirectX 12)

2560×1440

Dans ce jeu DirectX 12, les Vega s’en sortent encore bien, mais la GTX 1080 domine. Reste que la RX Vega 56 est au dessus de la GTX 1070, même overclockée, ce qui montre encore que DX12 aime bien AMD (ou l’inverse !). Le jeu souffre tout de même de pas mal de pics de temps d’affichage, qui se feront ressentir rarement, mais seront présents…

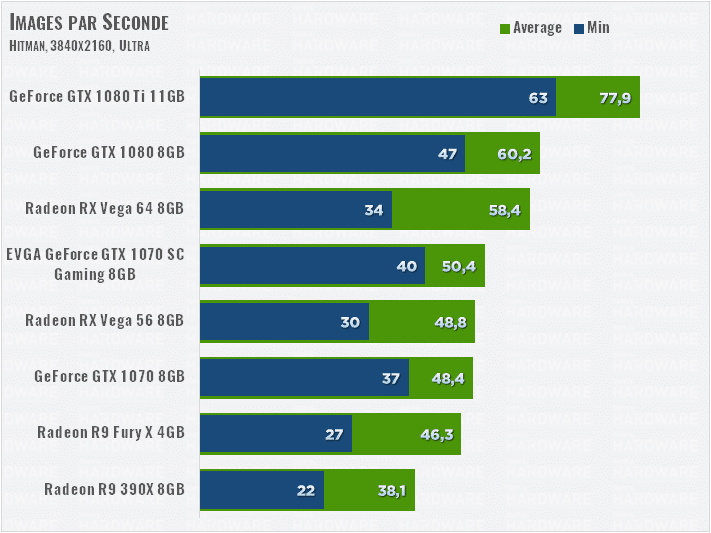

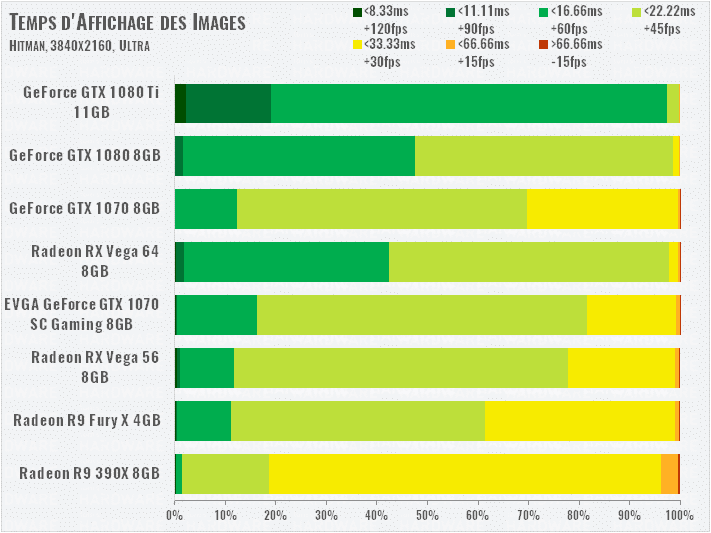

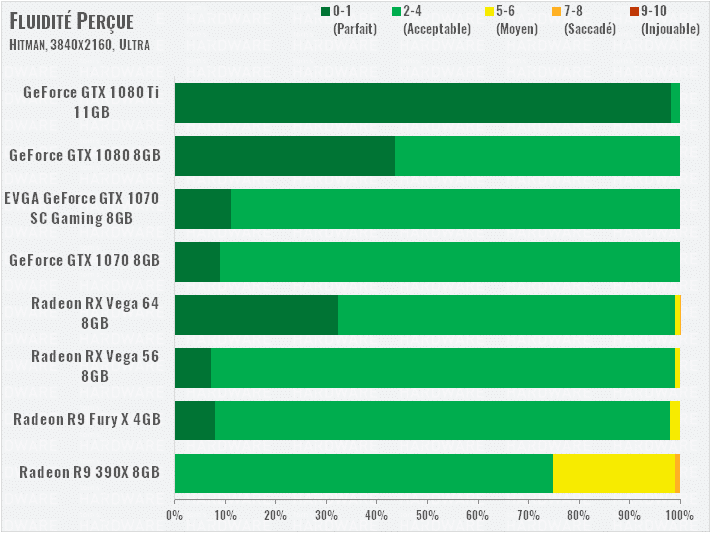

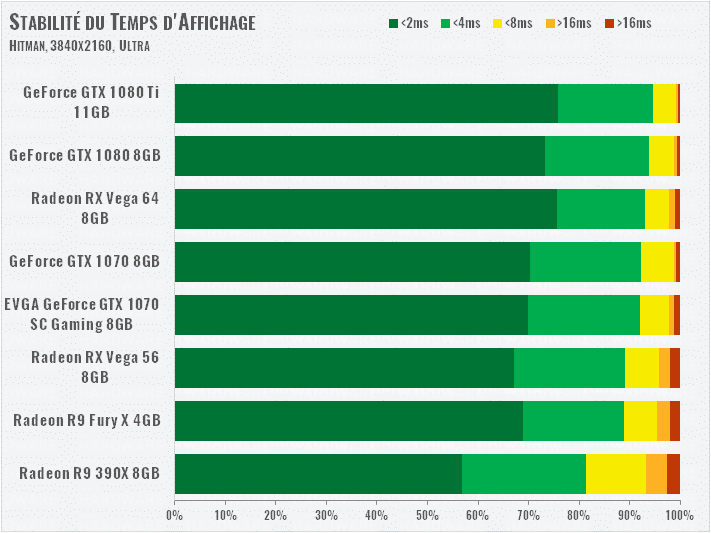

3840×2160

Les cartes souffrent en UHD, et la GTX 1070 overclockée repasse devant la Vega 56. La Vega 64 parvient à se tenir, mais globalement, la fluidité perçue sera bien meilleure sur les cartes NVIDIA.

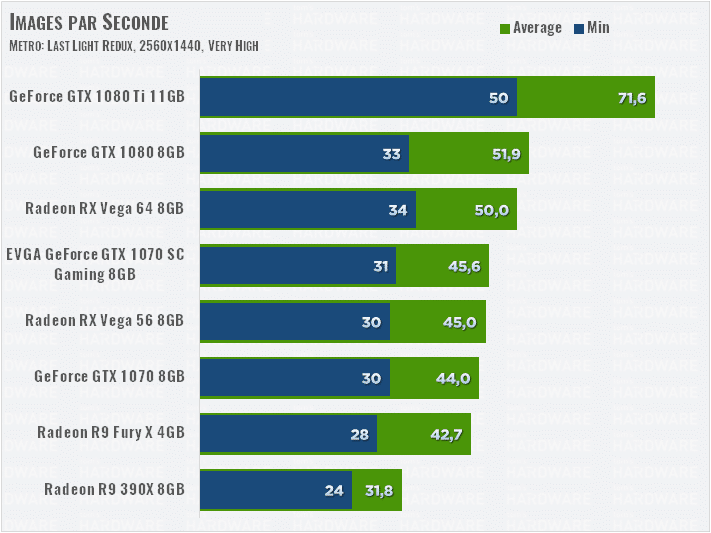

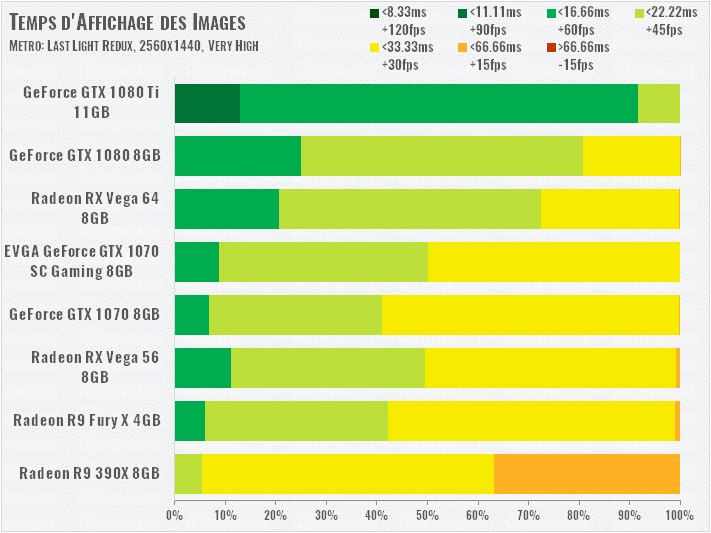

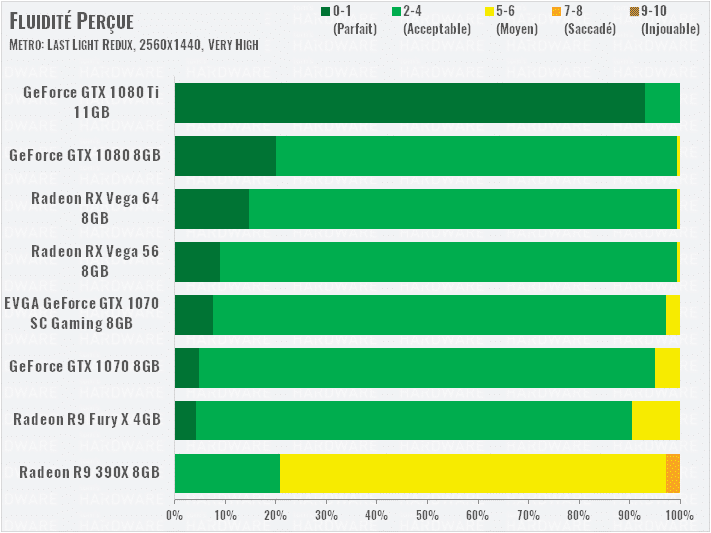

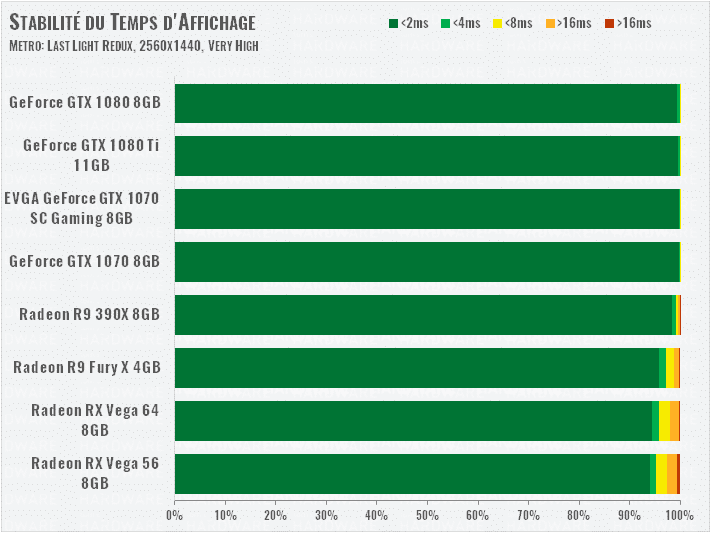

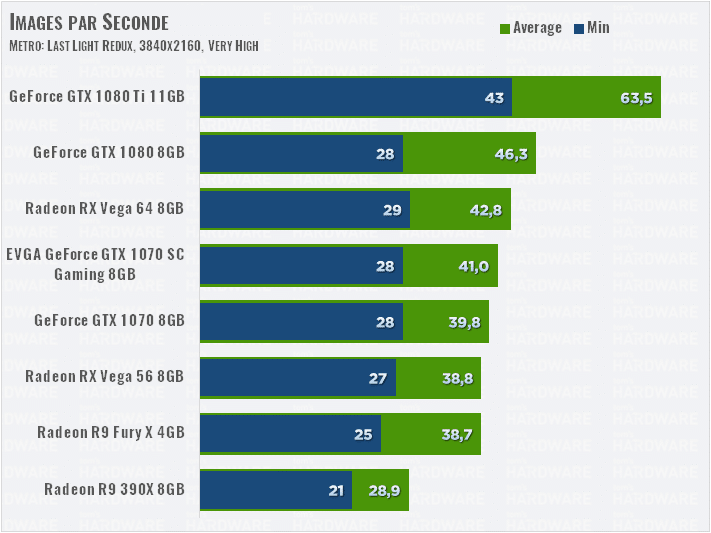

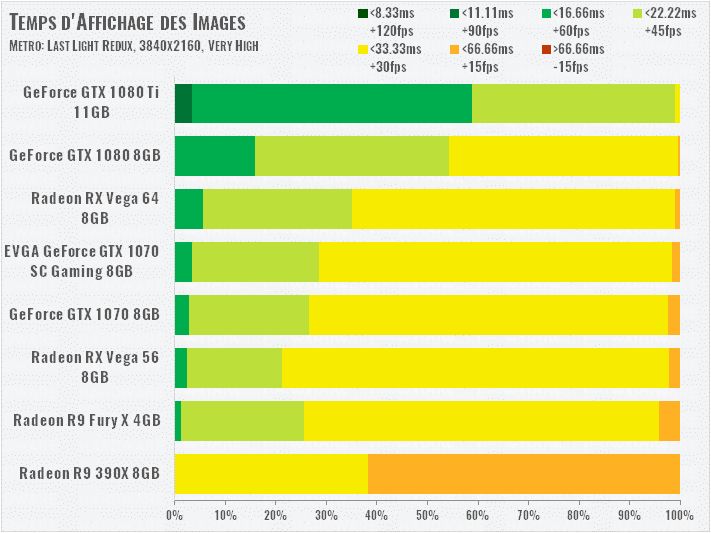

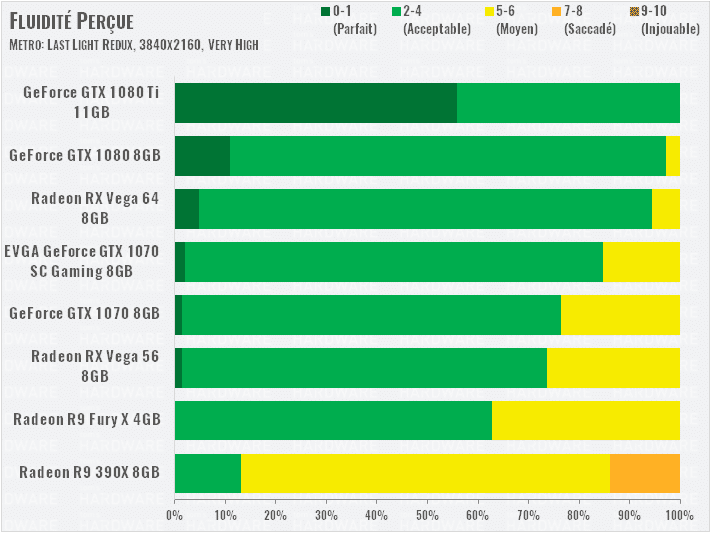

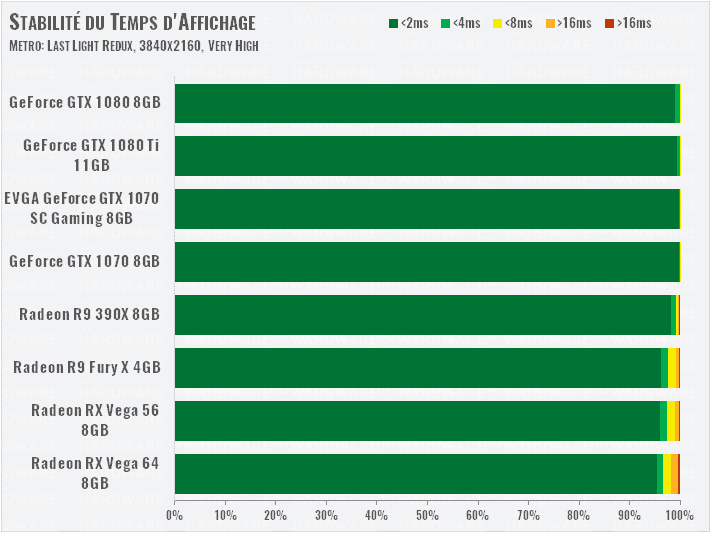

Metro: Last Light Redux (DirectX 11)

2560×1440

Les cartes NVIDIA sont légèrement plus rapides, mais de très peu. La R9 Fury surprend en se maintenant bien face à la GTX 1070. Les Vega s’en sortent bien pour ce jeu DirectX 11, surtout la Vega 56, qui surpasse la GTX 1070 Founders Edition.

3840×2160

Les Vega devront sacrifier plus de détails graphiques dans ce jeu pour offrir une meilleure fluidité. Les GeForce restent plus rapides, avec nettement moins de pics de temps d’affichage.

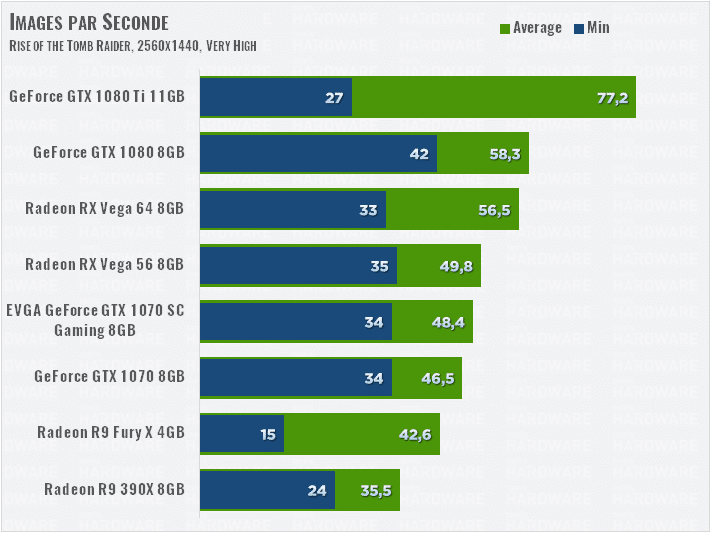

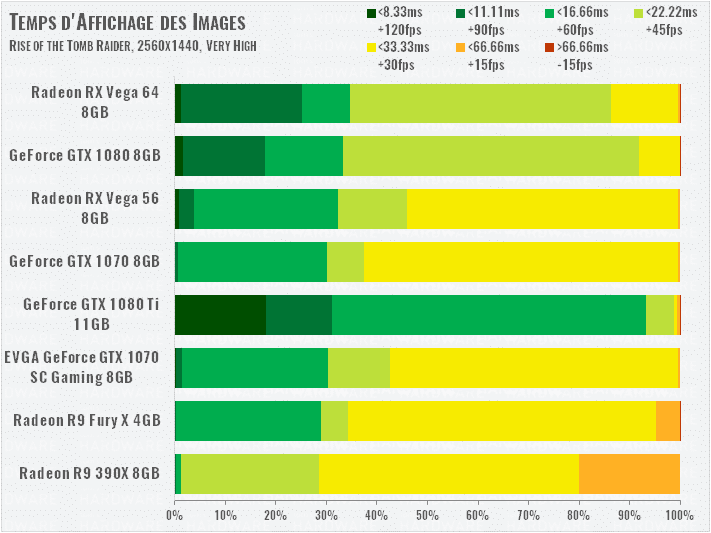

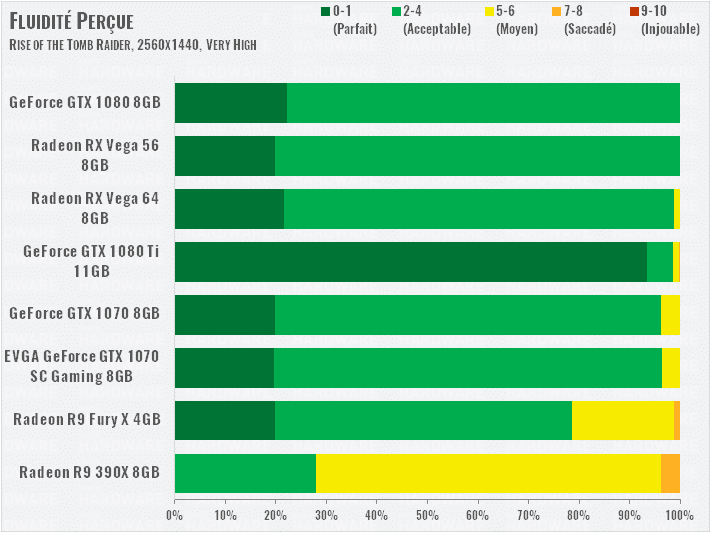

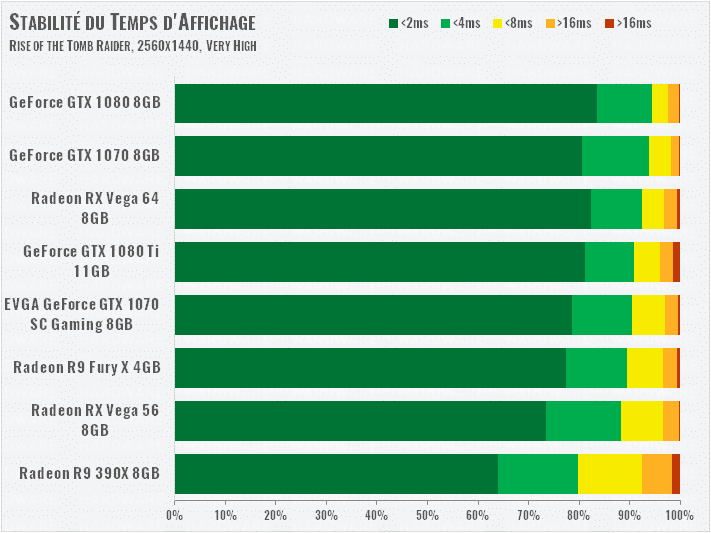

Rise of the Tomb Raider (DirectX 12)

2560×1440

DirectX 12 met encore les Vega à l’aise : la 64 talonne la GTX 1080 et la 56 surpasse les GTX 1070. Notez que la GTX 1080 Ti accuse de lourds pics de temps d’affichage dans ce test.

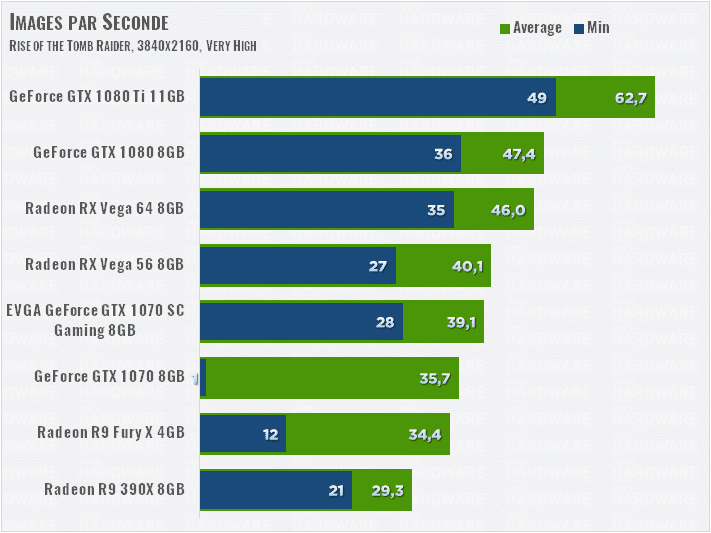

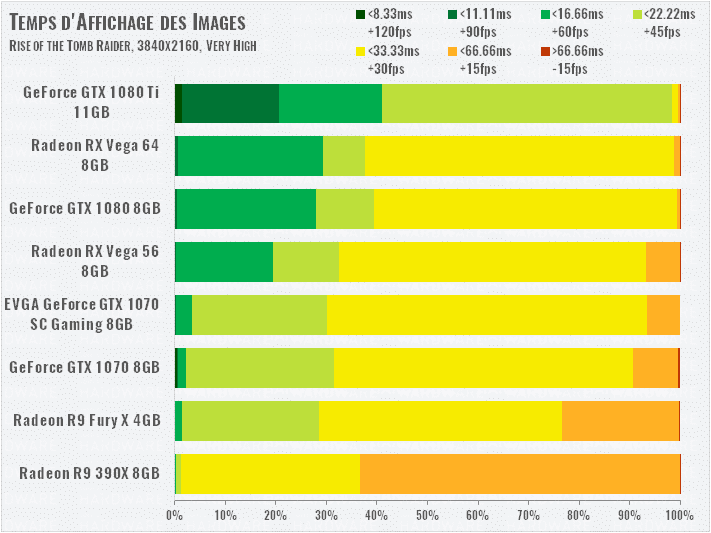

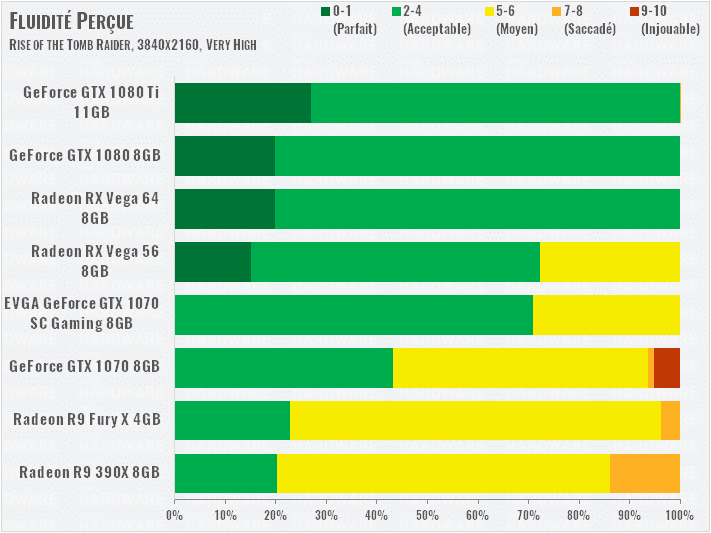

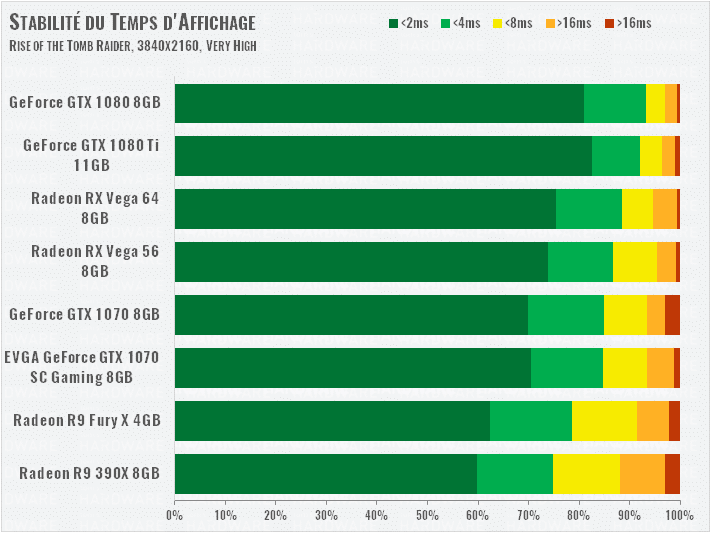

3840×2160

En UHD, ce jeu exige une 1080 Ti ou une Titan Xp pour tourner vraiment bien, les autres cartes devront réduire les options graphiques pour s’en sortir. La hiérarchie des cartes ne change toutefois pas dans cette définition.

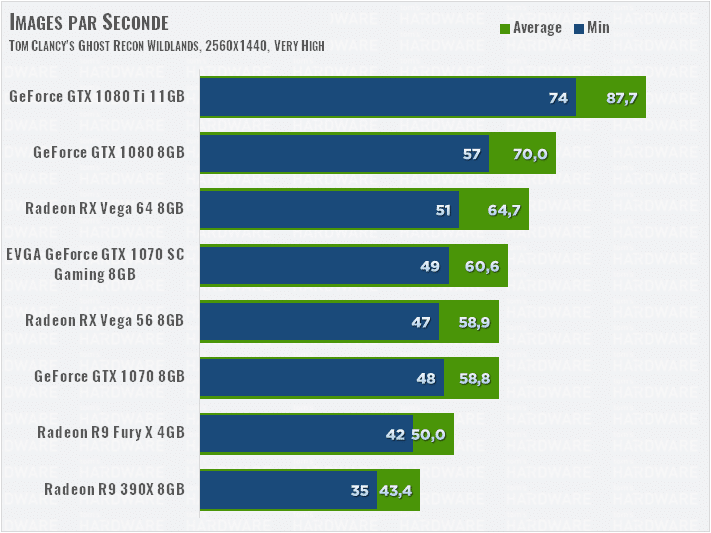

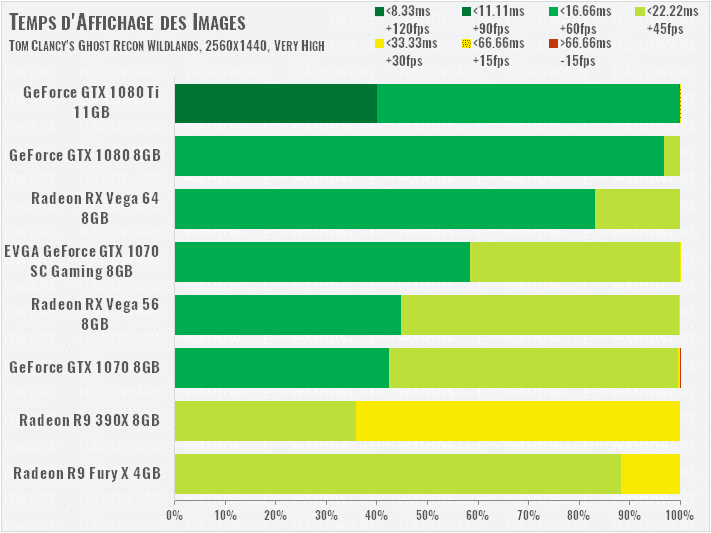

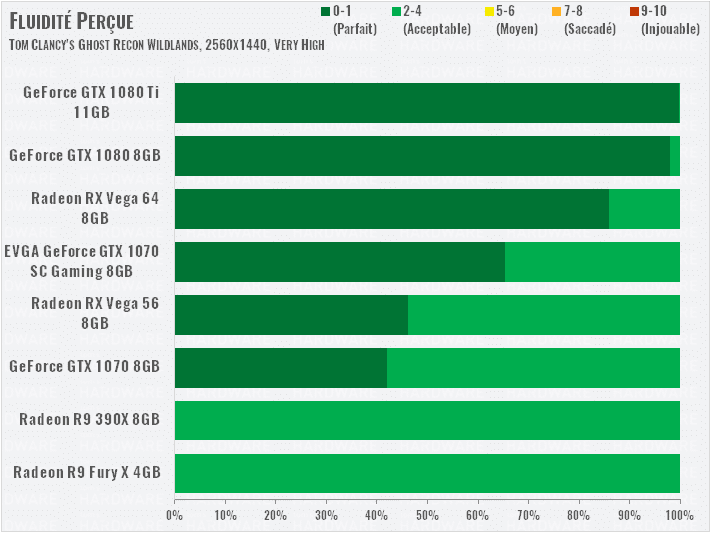

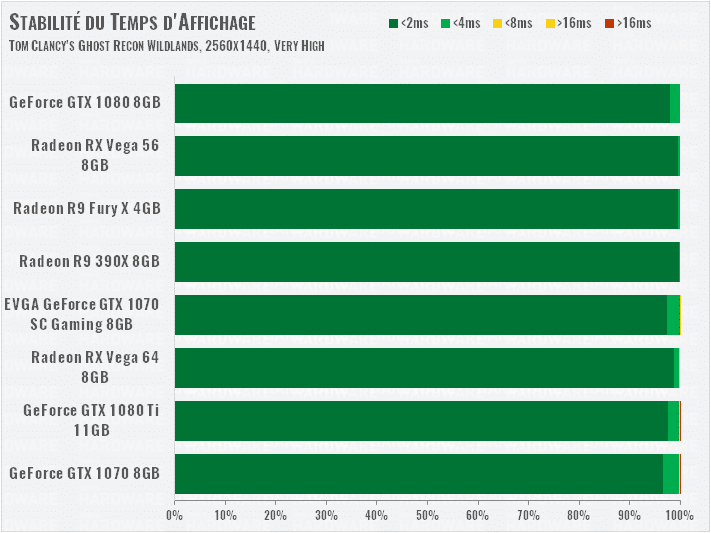

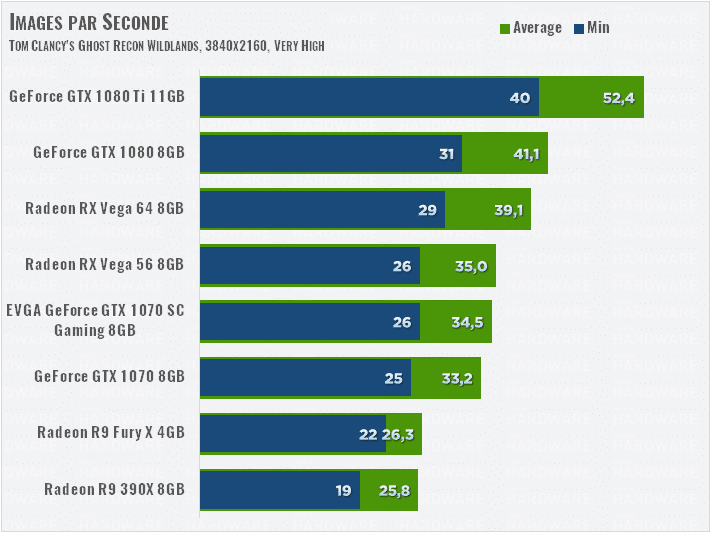

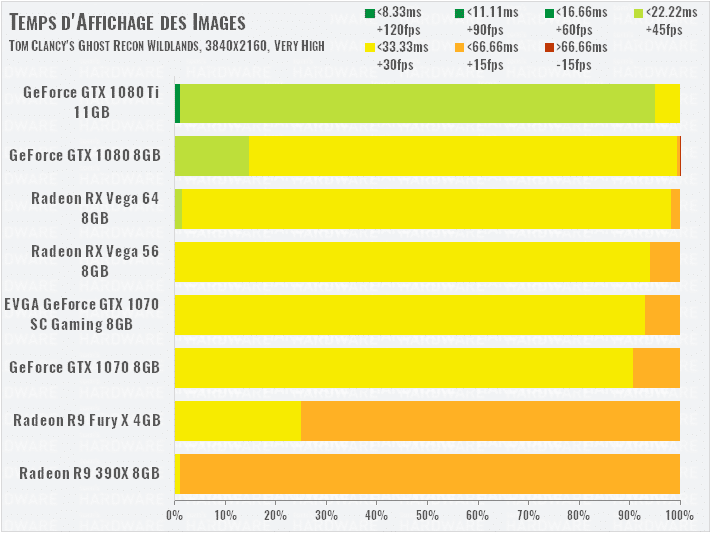

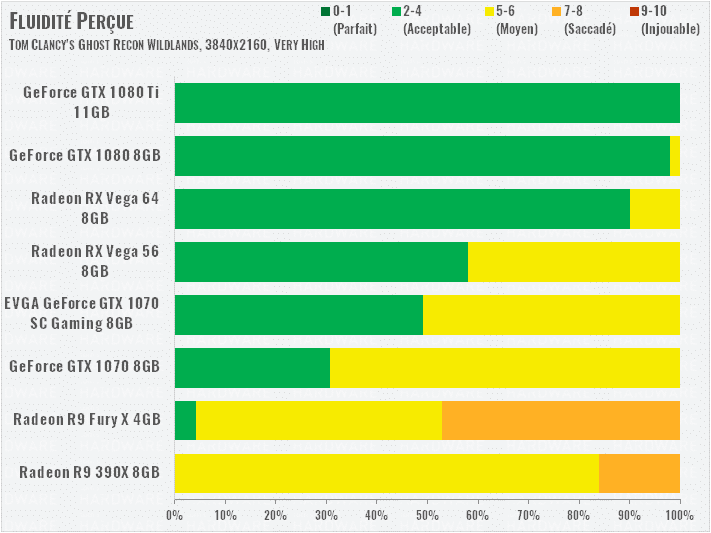

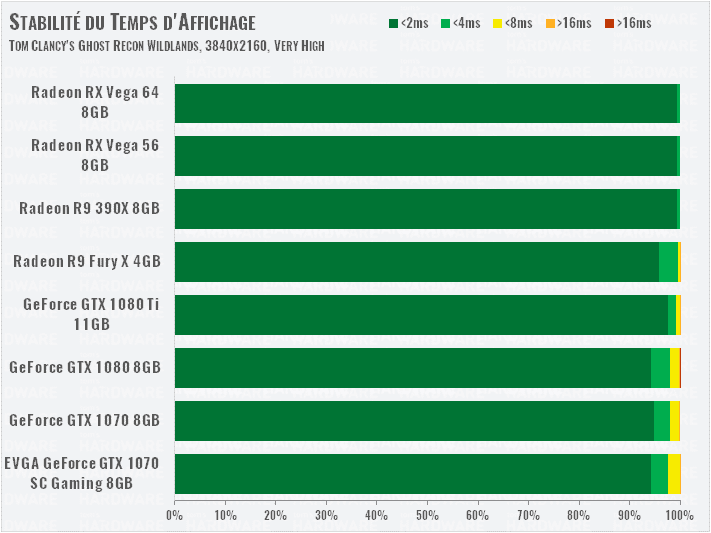

Tom Clancy’s Ghost Recon Wildlands (DirectX 11)

2560×1440

En DirectX 11, les GeForce GTX reprennent l’avantage, assez net pour la 1080, un peu moins pour la 1070, qui devra être overclockée pour surpasser la Vega 56. Notez que nous ne mettons pas ce jeu en mode de qualité graphique maximale, qui impacte grandement les performances, et active le Turf Effect de NVIDIA pour le comportement physique de l’herbe.

3840×1260

Seul changement, la Vega 56 dépasse cette fois les deux GTX 1070 dans cette définition, mais les cartes affichent une fluidité réelle assez similaire. Il y a tout de même plus de pics de temps d’affichage chez la GTX 1070.

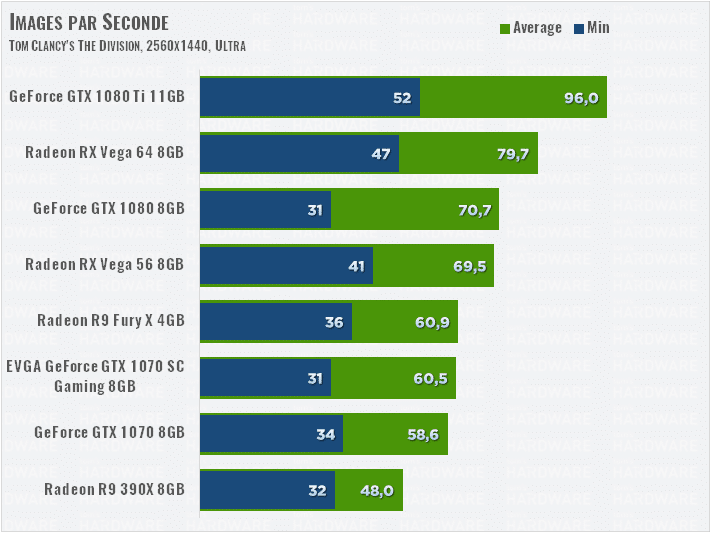

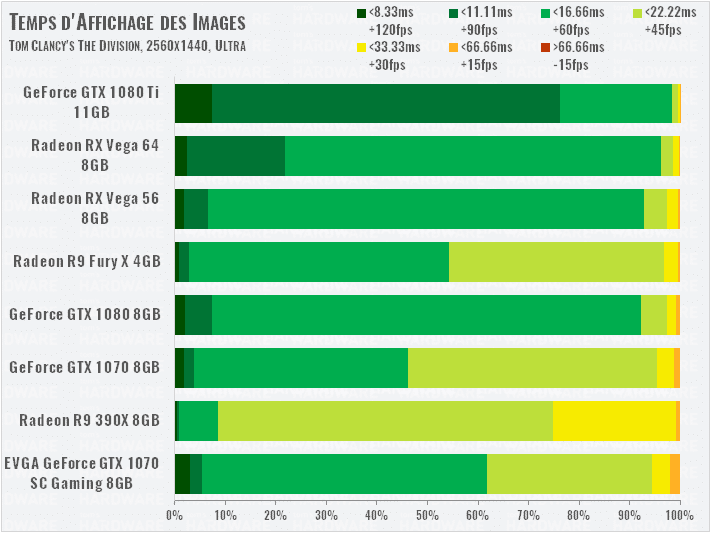

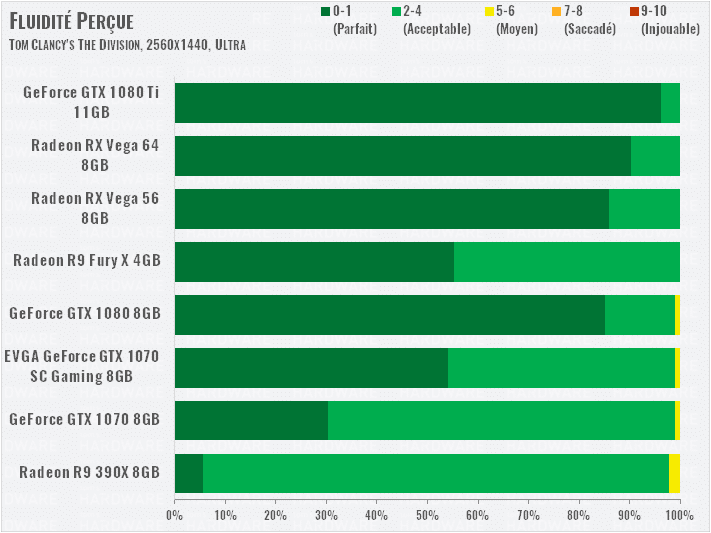

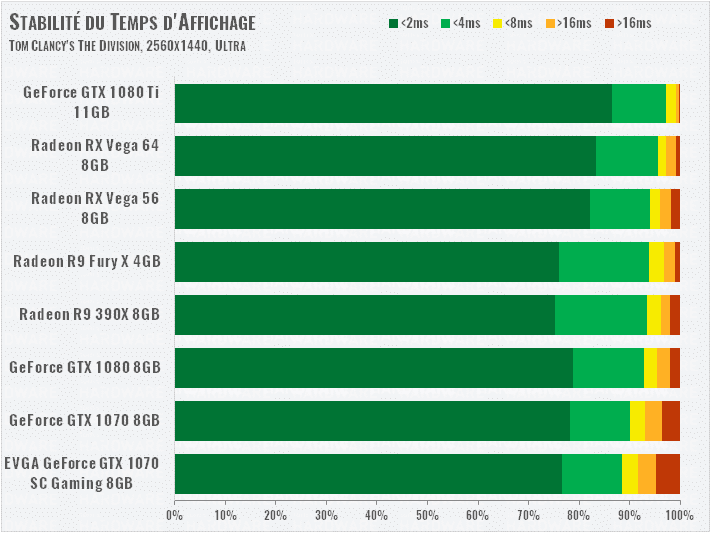

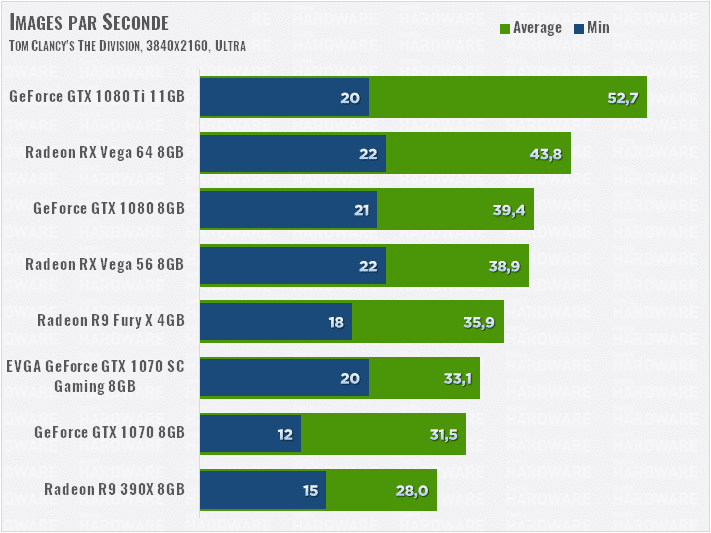

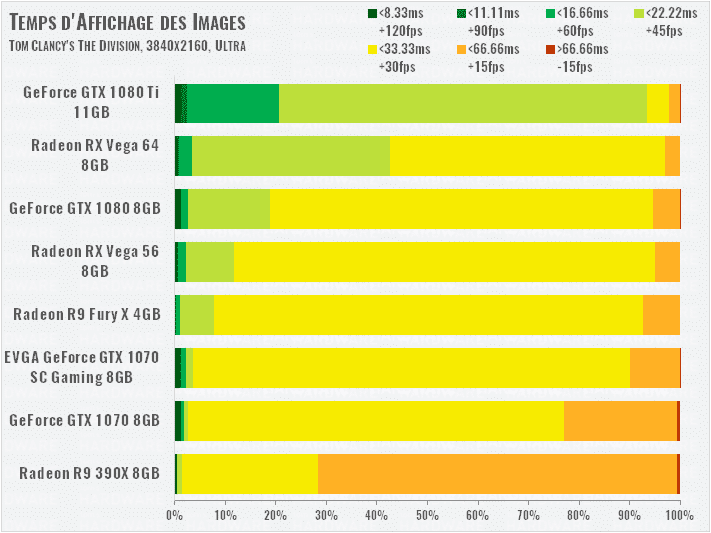

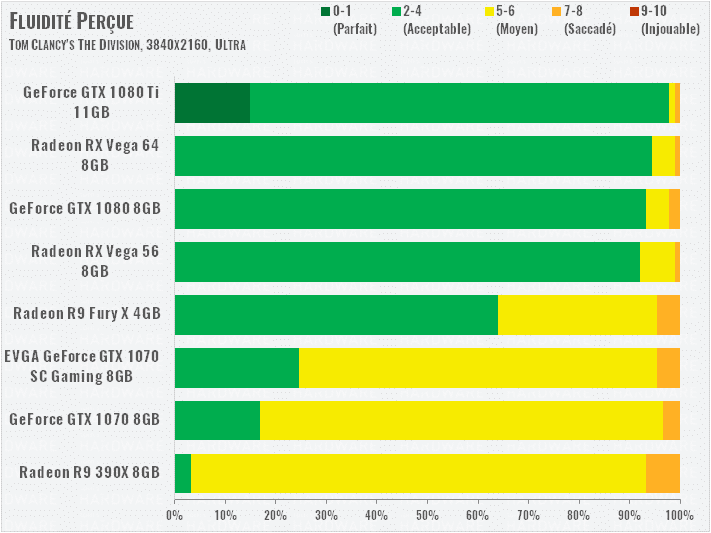

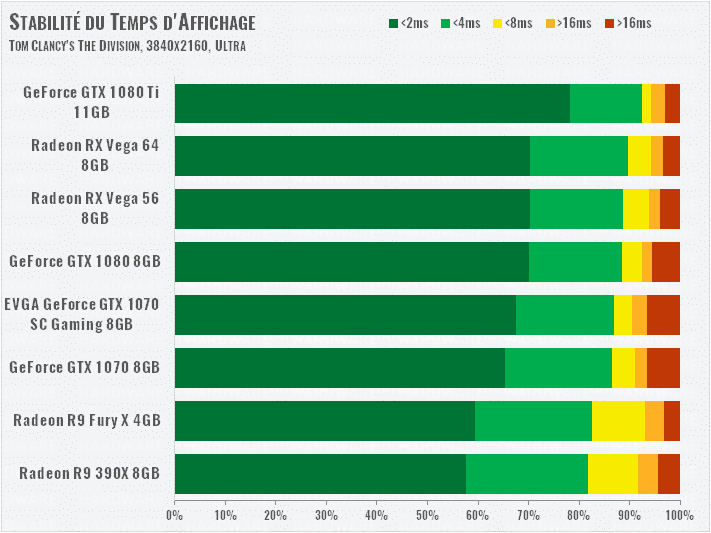

Tom Clancy’s The Division (DirectX 12)

2560×1440

Encore une fois, les RX Vega profitent grandement de DirectX 12 grâce aux calculs asynchrones. AMD cite d’ailleurs ce jeu en exemple pour montrer l’efficacité de son architecture en la matière : 13 % de boost en DX12, selon le fabricant. Ici, on constate effectivement que les RX Vega surpassent nettement les GTX 1080 et 1070, même la R9 Fury X est en fête !

3840×2160

Seules les GTX 1080 Ti et Titan Xp peuvent ici s’en sortir en 4K dans ce jeu. Les autres cartes passeront la majorité de leur temps entre 30 et 45 fps, ce qui reste acceptable en termes de fluidité, mais reste assez limite, surtout que de nombreux pics de temps d’affichages viennent apporter des petites saccades notables.

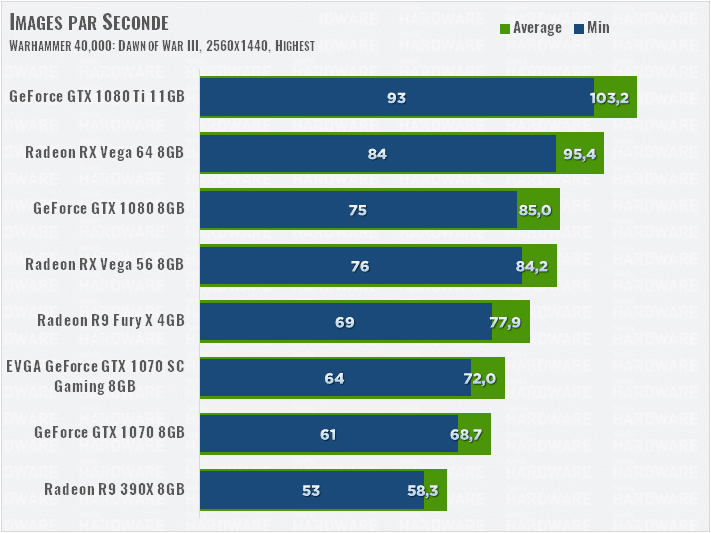

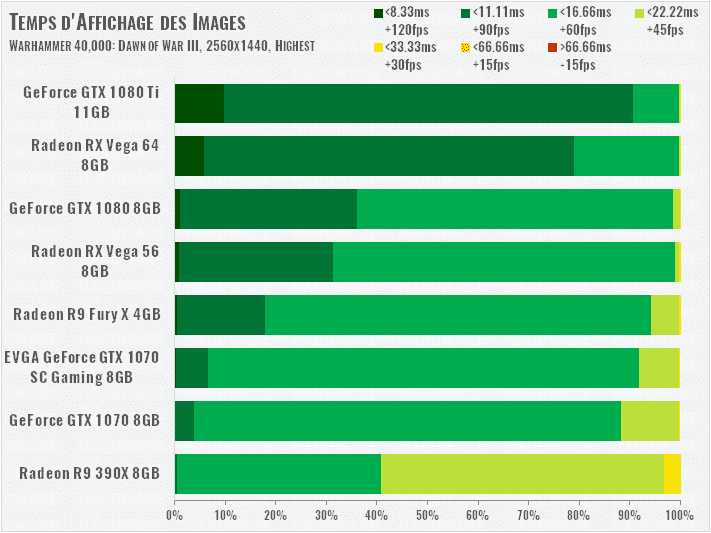

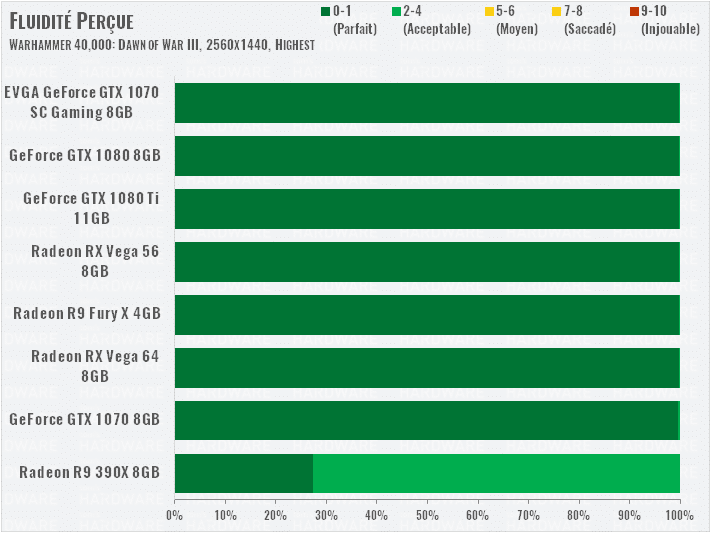

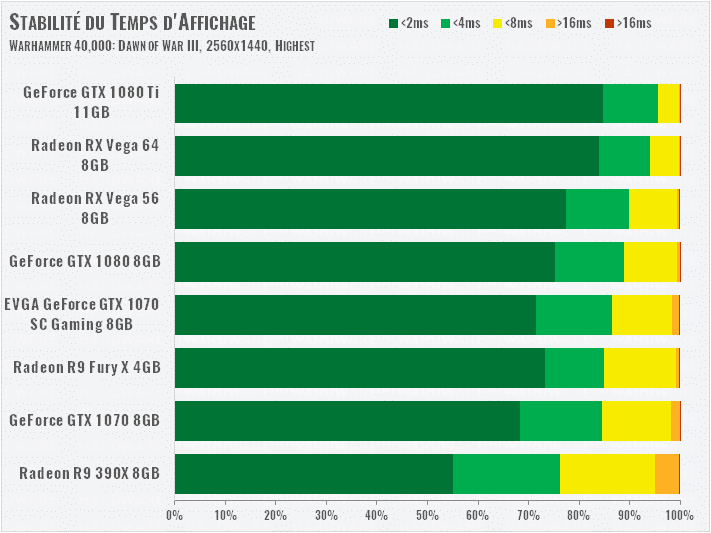

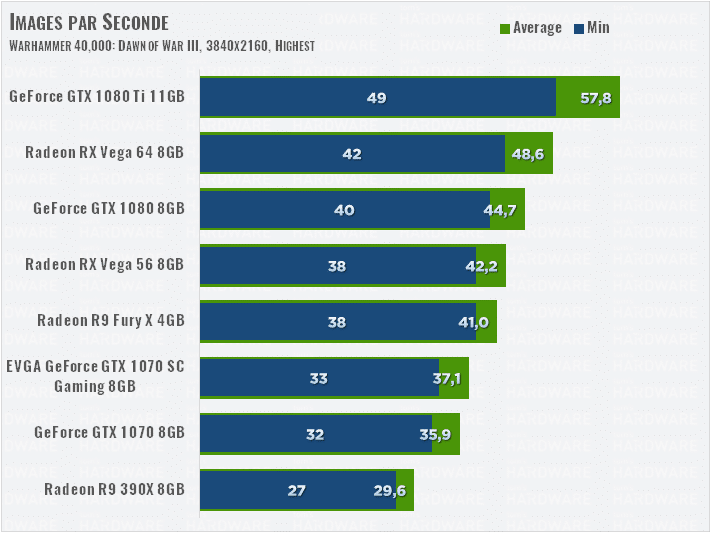

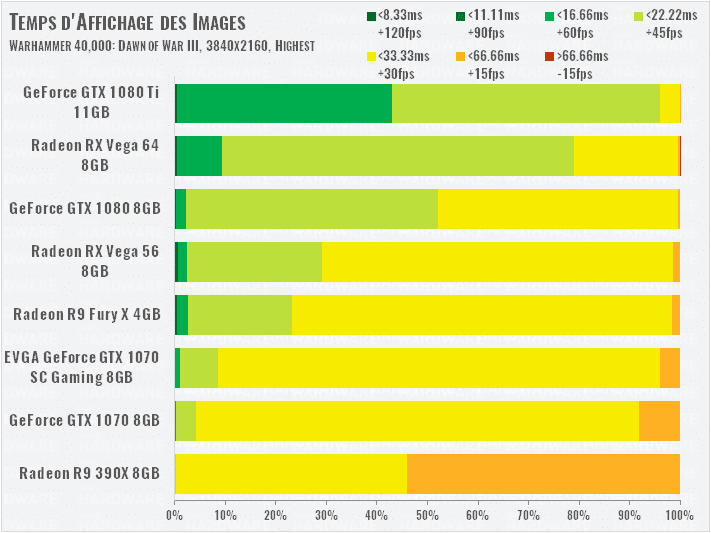

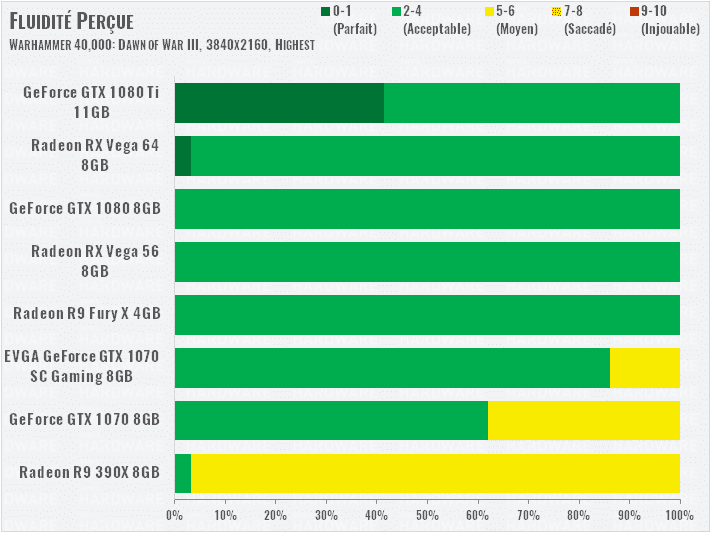

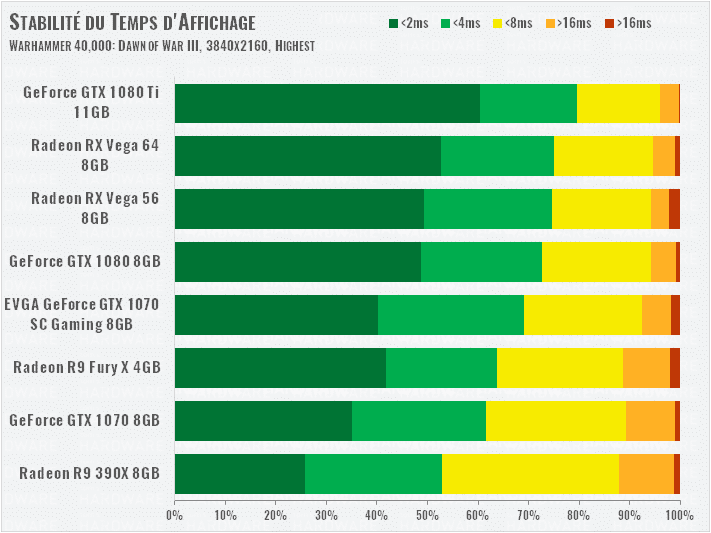

Warhammer 40,000: Dawn of War III (DirectX 11)

2560×1440

Voilà bien un jeu qui renforce clairement la position d’AMD, car les Vega s’en sortent beaucoup mieux que les GeForce dans une API DirectX 11, ce qui est assez rare pour être noté. La Vega 56 surpasse la GTX 1070 de 17 % !

3840×2160

Même classement en UHD. Notez que même la R9 Fury X reste devant la GTX 1070 malgré ses 4 Go de mémoire vive. Les 12 % de performances supplémentaires de la Vega 64 face à la GTX 1080 impressionnent !

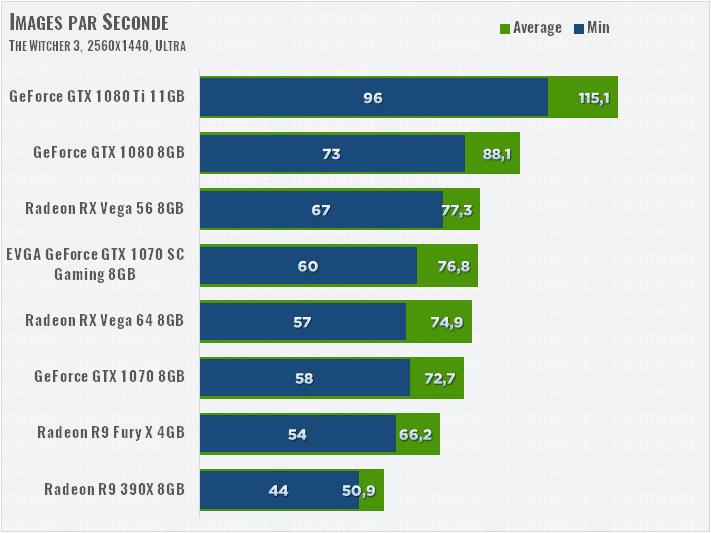

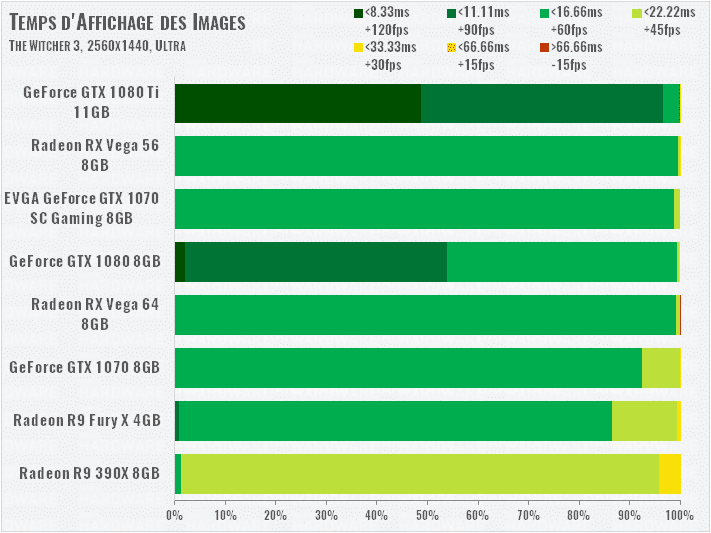

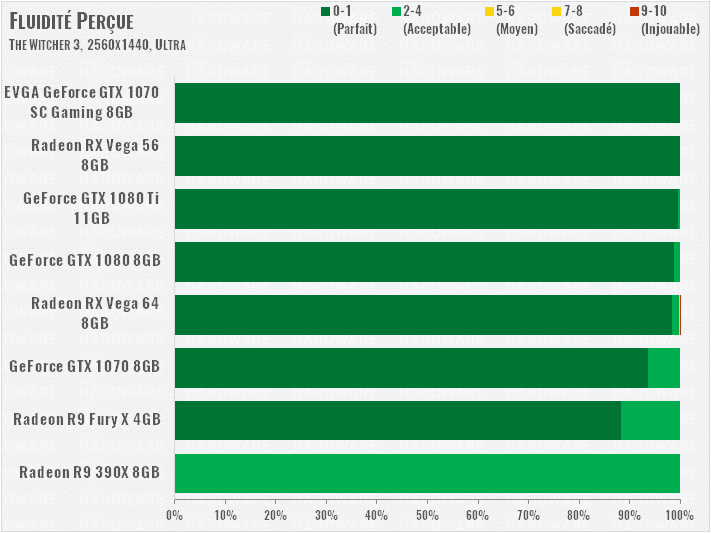

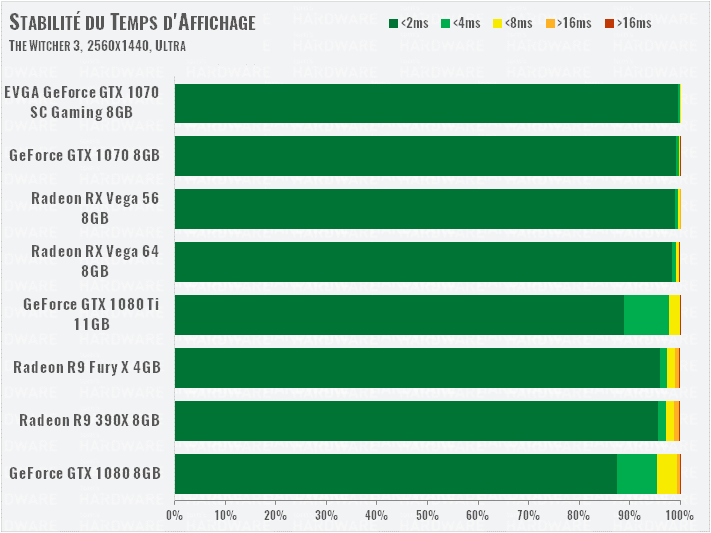

The Witcher 3 (DirectX 11)

2560×1440

Nous désactivons la technologie HairWorks de NVIDIA pour mieux comparer les cartes dans ce test. La surprise ici, c’est que la Vega 56 surpasse la Vega 64 ! Nous pensons que le jeu ne parvient pas à utiliser toutes les ressources du GPU, ou alors que la consommation très élevée qu’il implique ferait ralentir la Vega 64 pour ne pas dépasser sa limite de puissance.

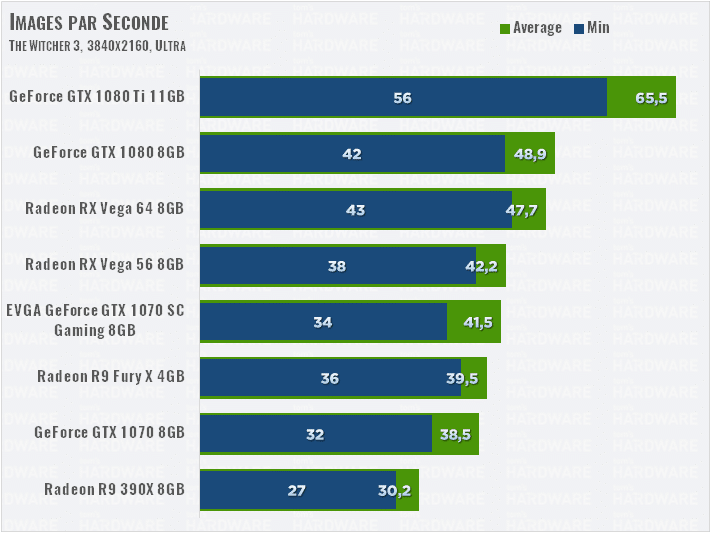

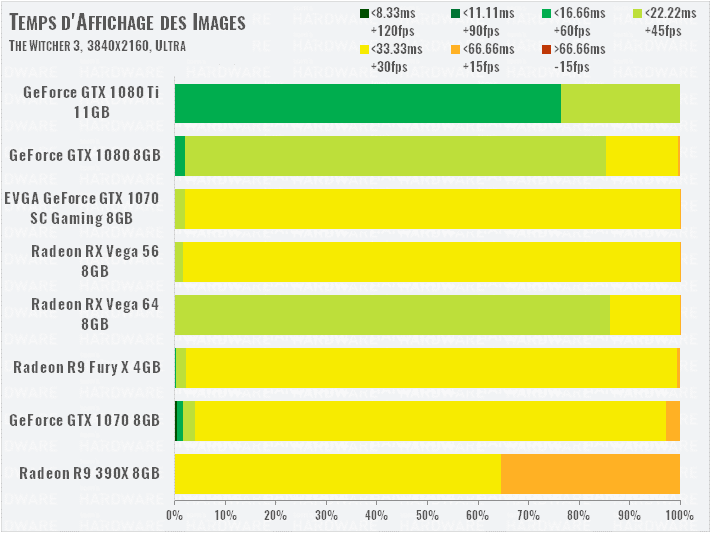

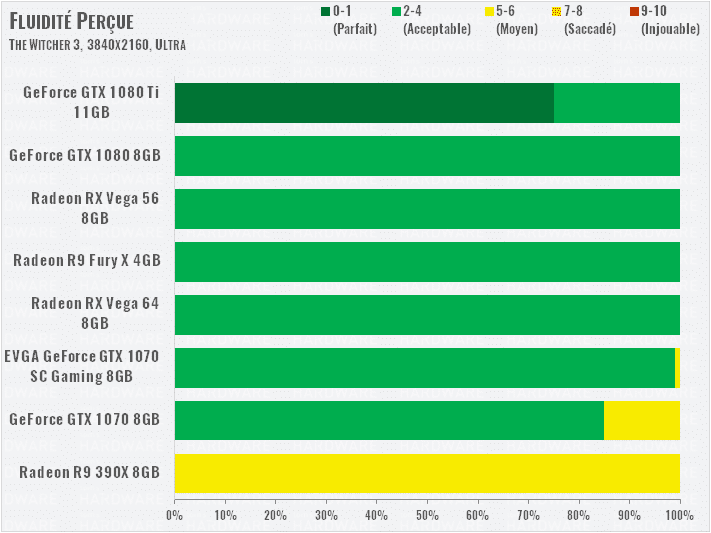

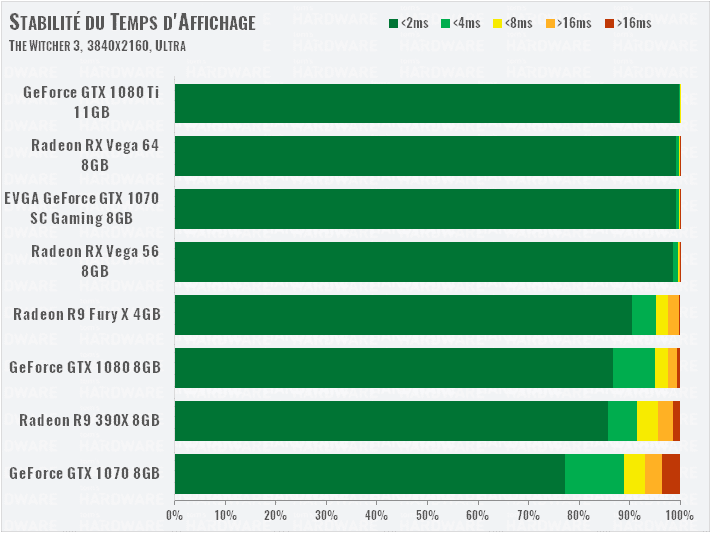

3840×2160

En 4K, retour à la normale : la Vega 64 remonte devant la 56, et talonne la GTX 1080. La Vega 56 reste devant la GTX 1070 overclockée d’EVGA.

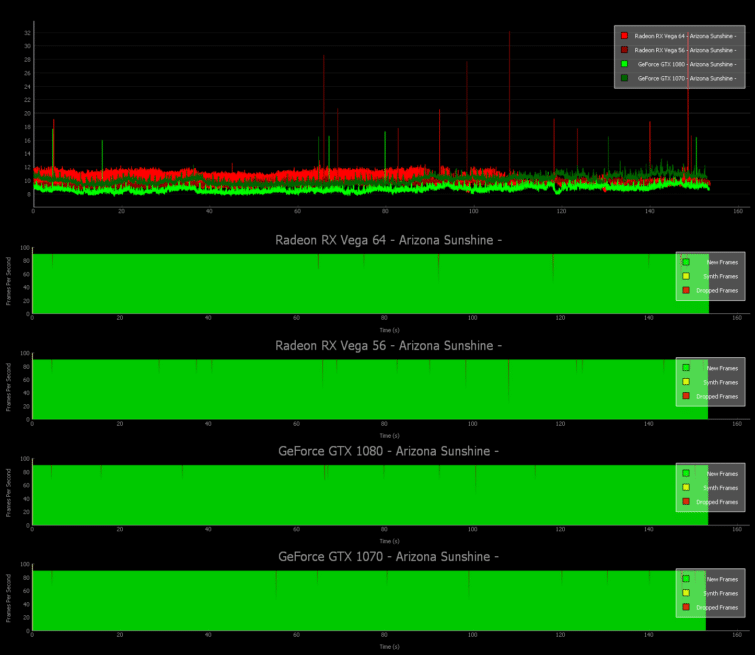

VR : Arizona Sunshine (DirectX 11)

Les outils ainsi que la méthodologie de test en réalité virtuelle sont expliqués et détaillés dans le dossier suivant : FCAT VR: GPU And CPU Performance in Virtual Reality (en anglais). La plateforme de test est identique à celle utilisée dans les pages précédentes, avec un Oculus Rift en plus.

Le temps de rendu des images au cours du test Arizona Sunshine apparait cohérent sur toute la durée du bench. La GeForce GTX 1080 atteint toutefois les temps les plus bas – donc les meilleurs – tandis que la Radeon RX Vega 56 semble légèrement meilleure que la GTX 1070.

En observant la limite des 90 images par seconde, on remarque qu’aucune carte ne fait appel à l’Asynchronous Space Warp pour suivre l’Oculus. Il y a bien quelques images perdues, mais nous n’observons aucune image synthétisée.

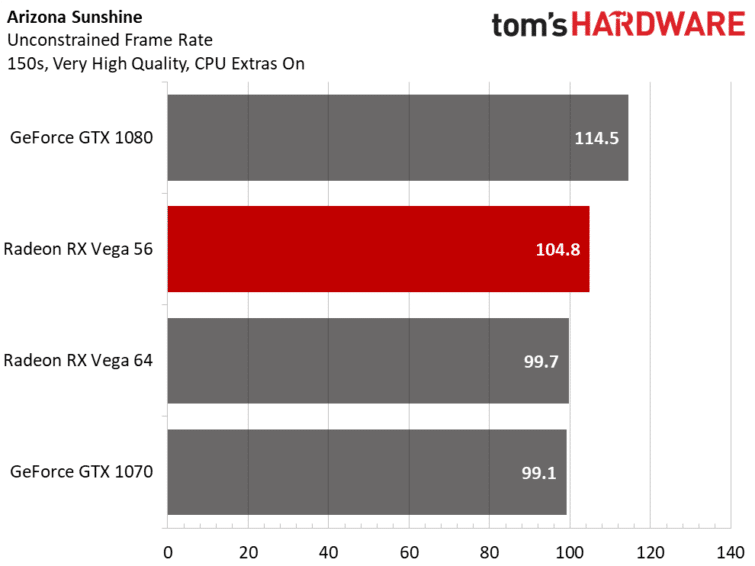

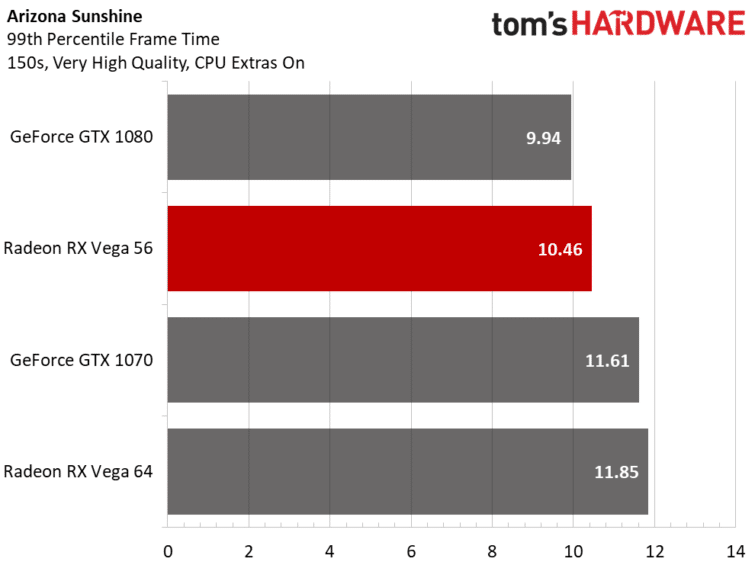

A partir du temps de rendu des images, il est possible de calculer un taux d’image par seconde non limité. Autrement dit, ce sont les performances qu’il serait possible d’atteindre si les casques de réalité virtuelle actuels n’étaient pas limités à 90 images par seconde.

Ces chiffres confirment que la GeForce GTX 1080 possède la marge la plus importante de performances au delà des 90 images par seconde. Les deux Radeon RX Vega occupent les positions intermédiaires, mais pas dans l’ordre auquel on pourrait s’attendre. La GeForce GTX 1070 arrive enfin très légèrement derrière la RX Vega 64.

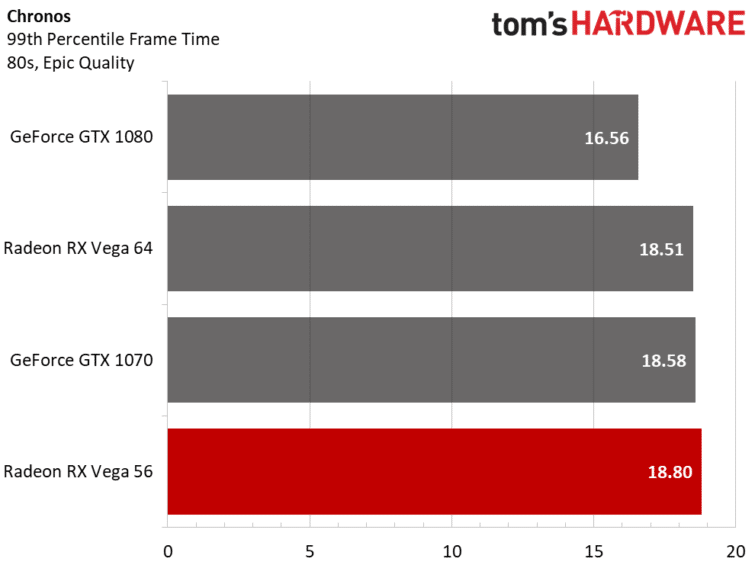

Bien que nous sachions que 90 images par seconde donne 11,1 ms par image, notre graphique des 99 percentiles de temps de rendu par image montre que les Radeon RX Vega 64 et GeForce GTX 1070 s’approchent des 12 ms. Comment est-ce possible ? Tout simplement parce que cette limite des 11,1 ms n’est pas absolue et peut légèrement varier grâce aux mécanismes et optimisations du runtime VR (file d’attente, parallélisation…). Les optimisations restent toutefois insuffisantes si le temps de rendu reste supérieur à cette limite pendant un temps prolongé.

Les temps de rendu d’image moyen des quatre cartes se situe aux environs des 10 ms, donc il reste encore de la marge pour les cas les plus défavorables, même si certaines images sont en pratique abandonnées (les pics rouges dans nos graphiques).

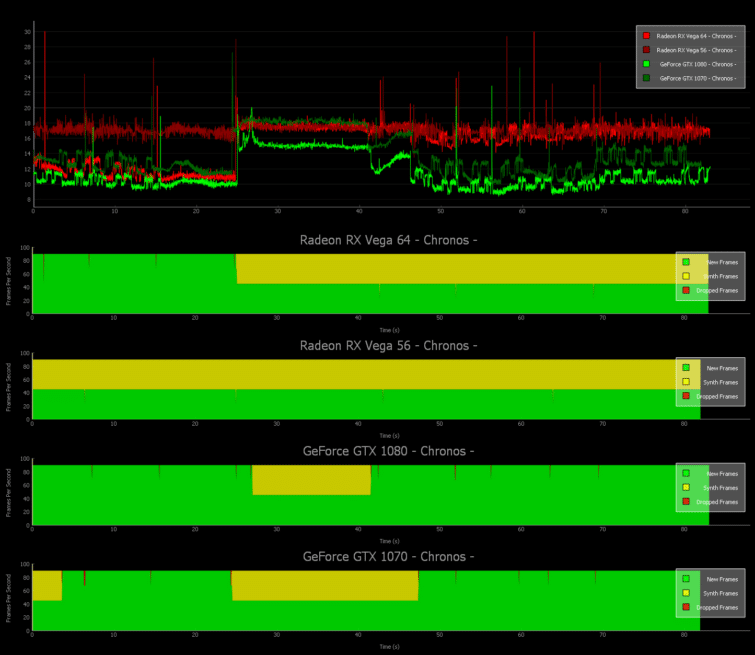

VR : Chronos (DirectX 11)

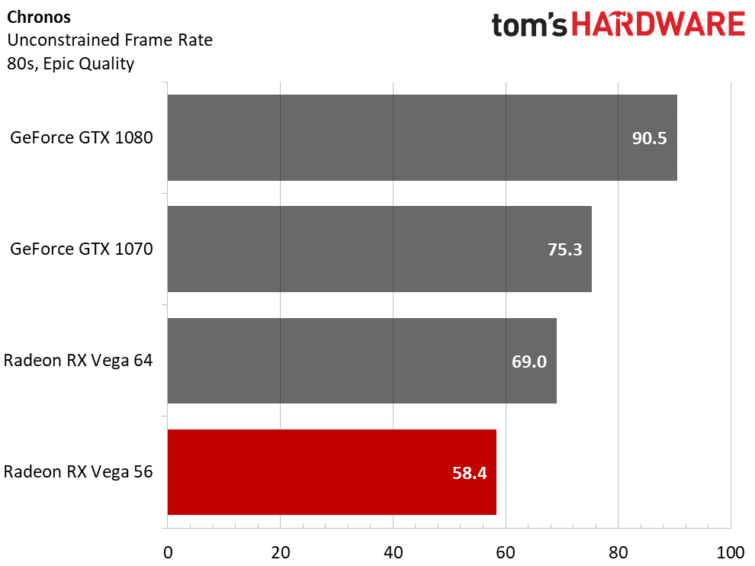

Avec les réglages les plus élevés disponibles, Chronos est particulièrement gourmand, même pour les cartes graphiques les plus puissantes du moment. Mais c’est également un jeu reposant sur le moteur UE4, ce qui privilégie les cartes graphiques de NVIDIA.

La GeForce GTX 1080 passe un court moment en mode ASW, le reste du temps les images sont nouvellement rendues. La GeForce GTX 1070 doit compter un peu plus sur les images synthétisées pour offrir une expérience acceptable, mais recommence à fournir de nouvelles images dès que possible.

La Radeon RX Vega 64 débute le test en offrant des images nouvellement générées, et commence elle aussi à faire appel aux images synthétisées au même moment où les GeForce passent en mode ASW. En revanche, elle ne parvient plus à se passer des images synthétisées jusqu’à la fin du test. La RX Vega 56 doit quand à elle faire appel aux images synthétisées dès le début du test, dans un ratio de 1:1.

Un taux d’image par seconde non limité montre que la RX Vega 56 a encore un peu de réserve pour maintenir son ratio de une image réelle pour une image synthétisée. Certaines cartes comme la RX 470 demandent la plupart du temps deux images synthétisées pour chaque image réelle, ce qui est bien plus gênant. D’un autre côté, la Radeon RX Vega 56 apparait bien plus lente que la GeForce GTX 1070 dans Chronos.

Les 99 percentiles des temps de rendu d’images montre pourquoi ces différentes cartes ont besoin de basculer en mode ASW pour une partie au moins du bench Chronos.

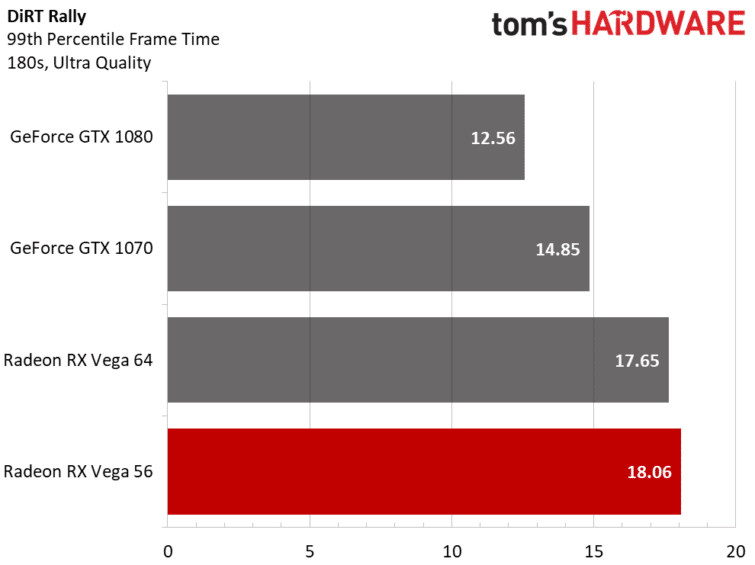

VR : DiRT Rally (DirectX 11)

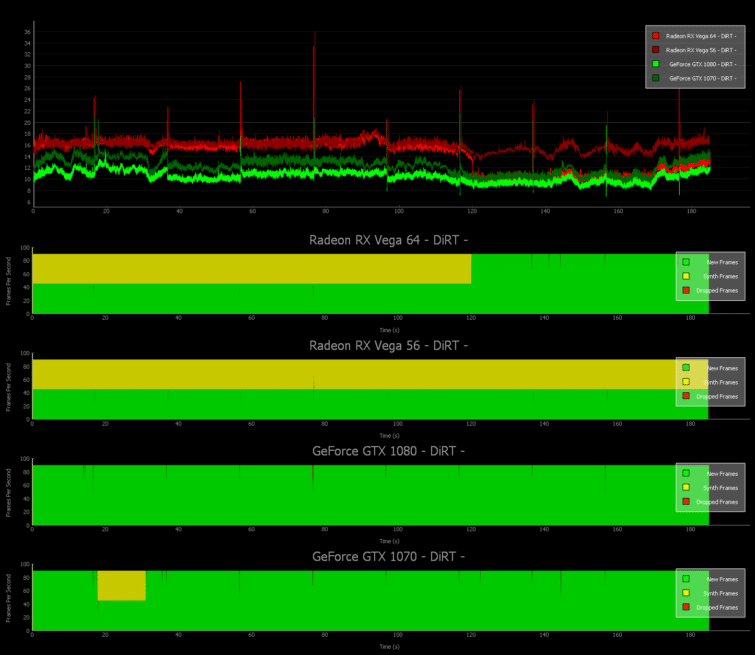

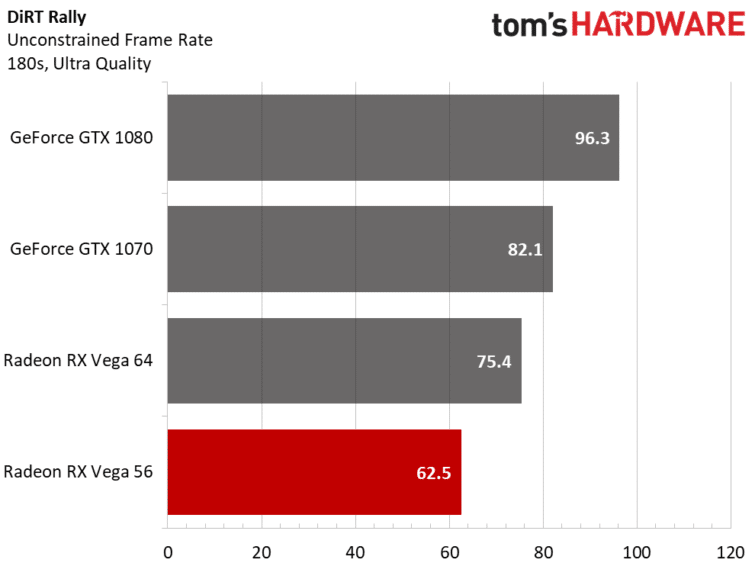

DiRT Rally nous propose l’une des expériences de réalité virtuelle les plus contrôlables possibles avec un benchmark intégré. Le graphique suivant est plutôt cohérent, avec chaque changement de perspective entrainant au même moment un pic avec toutes les cartes.

Bien que la GeForce GTX 1080 perde quelques images lors de notre test de 180 secondes, c’est la seule carte à ne pas faire appel au mode ASW.

On voit clairement le moment où la Radeon RX Vega 64 sort du mode ASW. La Vega 56 n’a en revanche jamais cette chance : elle génère 8312 images tandis que le moteur d’Oculus en synthétise 8324…

Intéressons-nous de nouveau au taux d’image par seconde non limité par le V-Sync : si la Radeon RX Vega 56 ne sort jamais du mode ASW, elle parvient quand même à délivrer un taux d’images par seconde largement supérieur à 45 IPS.

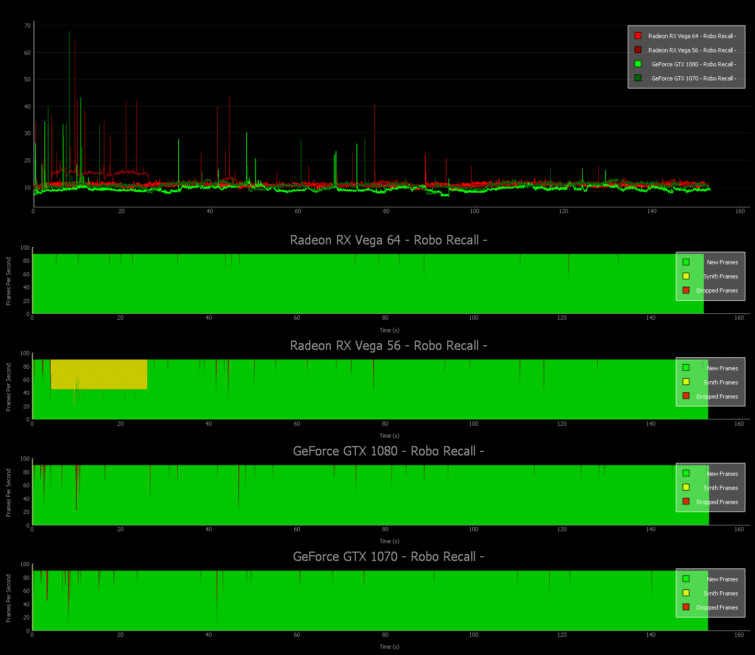

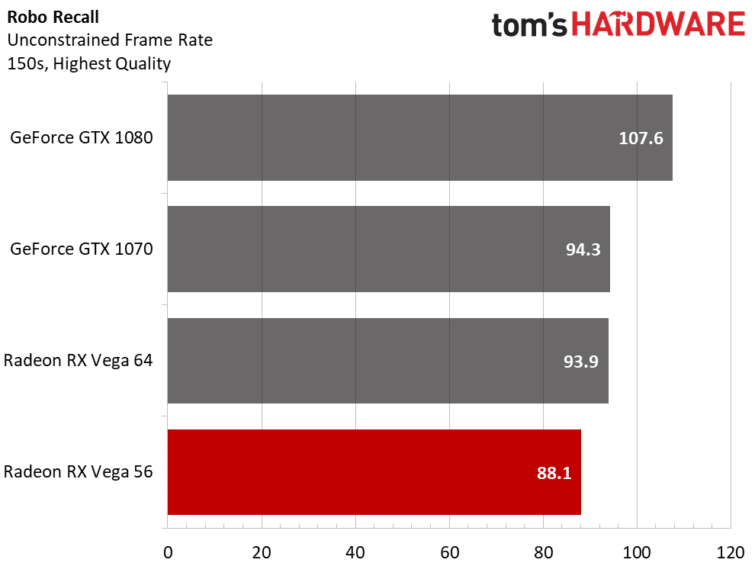

VR : Robo Recall (DirectX 11)

Comme Chronos, Robo Recall est basé sur le moteur UE4. Du coup, cela ne sent pas forcement bon pour AMD…

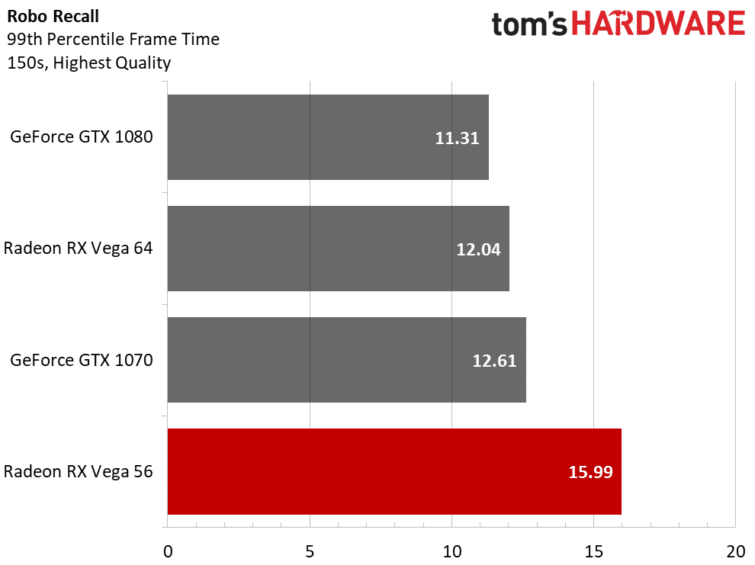

Bien que la GeForce GTX 1080 atteigne un temps de rendu plus faible – donc meilleur – que la RX Vega 64, celle-ci parvient à ne jamais passer en mode ASW et ne perd que 19 images sur toute la durée du test. La 1080 fait même moins bien de ce côté là, avec 83 images perdues.

Étrangement, la GeForce GTX 1080 apparait 15% plus rapide dans notre test non limité d’images par seconde, basé sur le frametime. La RX Vega 64 se place même derrière la GTX 1070. Avec un taux d’image par seconde sous la barre des 90 IPS, il devient logique que la RX Vega 56 fasse appel au mode ASW (1000 images synthétisées sur environ 13700).

Bien que la GeForce GTX 1070 affiche un taux d’images par seconde non contraint légèrement plus élevé (et donc un frametime légèrement plus bas), la Radeon RX Vega 64 atteint un meilleur 99 percentile de temps d’affichage des images.

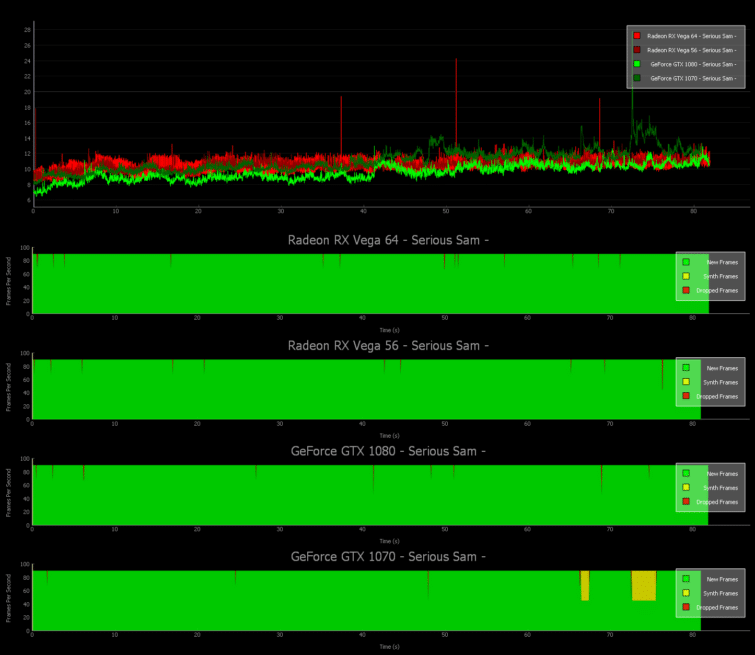

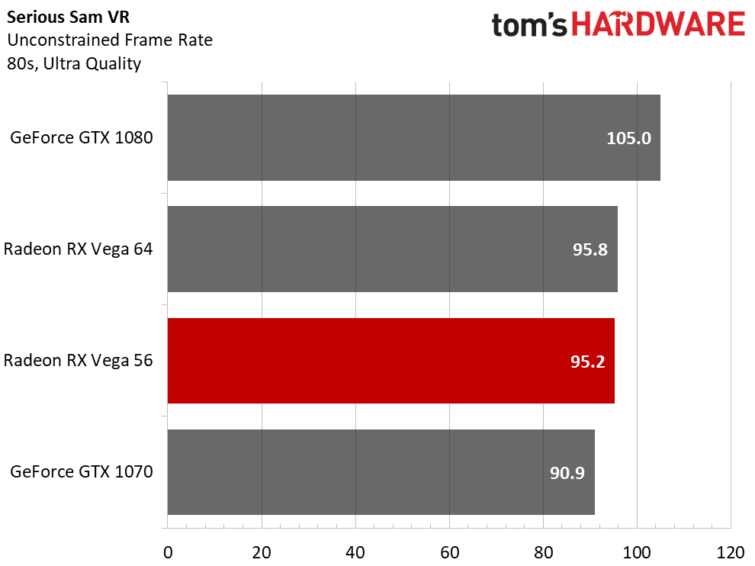

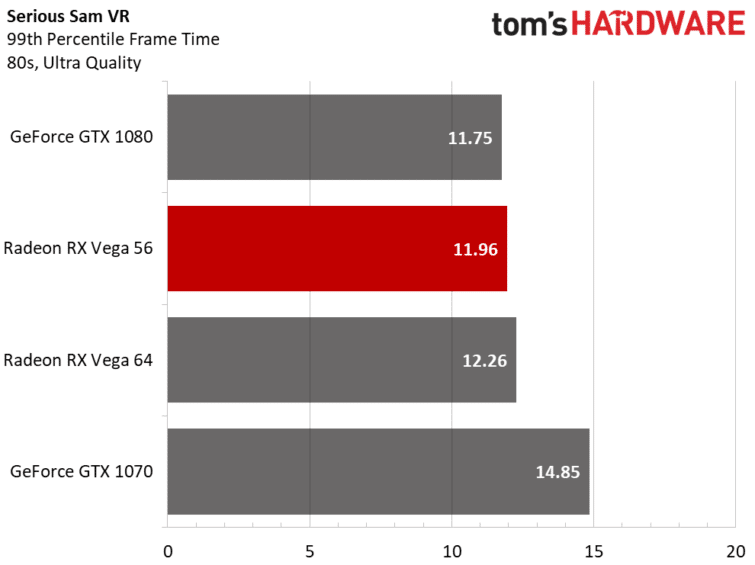

VR : Serious Sam VR: The Last Hope (DirectX 11)

Serious Sam VR utilise le moteur maison Serious Engine 4.5 de Croteam. La GeForce GTX 1080 ne perd qu’une poignée d’images, tandis que les Vega 64 et 56 suivent juste derrière. La GeForce GTX 1070 est en revanche obligée d’utiliser à quelques moments le mode ASW.

Les trois premières cartes atteignent la barre des 90 images par seconde en utilisant les réglages les plus élevés, tandis que la GeForce GTX 1070 atteint une moyenne de 87,7 images par seconde en raison de sa brève chute à 45 images par seconde. Les taux d’images par seconde non limités sont naturellement plus élevés.

Le passage en mode ASW se ressent logiquement sur les 99 percentiles du temps de rendu des images. On notera au passage que la RX Vega 56 est devant sa grande sœur.

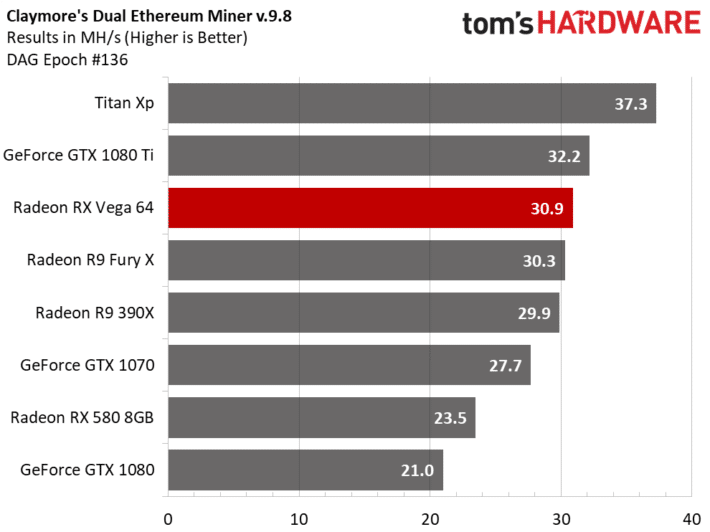

Performances de minage Ethereum

La dernière version du logiciel Dual Ethereum AMD/Nvidia GPU Miner (v9.8) de Claymore supporte la Radeon RX Vega, c’est donc ce logiciel de mining que nous avons utilisé pour nos tests.

Toutes les cartes d’AMD fonctionnent en mode ASM, ce qui demande un réglage fin à l’aide de la commande -dcri. Notre Radeon R9 Fury X voit son taux de MH/s le plus élevé avec -dcri 85, alors que le réglage optimal pour notre Radeon R9 390X est -dcri 20. Après de nombreux essais, nous obtenons le hashrate le plus élevé avec notre Radeon RX 580 8GB en utilisant le kernel ASM alternatif (-asm 2). La Radeon RX Vega 64 ne semble pas aussi sensible à ce genre d’ajustements : modifier le réglage par défaut (-dcri 30) n’apporte pas grand chose en terme de performances.

Ce qui saute aux yeux, c’est probablement les mauvaises performances de la GTX 1080. Mais cela n’est pas une surprise : le mining d’Ethereum est particulièrement sensible aux timings de la mémoire graphique, et la GDDR5 est plus performante que la GDDR5X à ce petit jeu. Les GTX 1080 Ti et Titan Xp réglent ce problème avec une interface mémoire 384-bit. Si vous aviez la possibilité de fabriquer votre propre carte graphique à partir de composants de chez NVIDIA, il faudrait donc choisir un GP102 avec un bus 384-bit, associé à de la GDDR5 9Gbps overclockée à 10 Gbps. Ah, si seulement c’était aussi simple…

La Radeon RX Vega 64 d’AMD n’est pas le monstre de minage tant attendu, en tout cas avec la version actuelle du mineur de Claymore.

Nous savons que les mineurs professionnels modifient en profondeur le firmware de ces cartes graphiques, en modifiant particulièrement les timings et la fréquence de la mémoire embarquée, afin d’atteindre des hashrates sensiblement plus importants. Gardez simplement en tête que les performances que nous avons mesurées proviennent de cartes sorties d’usine, avant qu’elles soient optimisées pour du minage d’ETH.

Etant donné le prix de la RX Vega 64, les mineurs devraient plutôt se tourner vers les Radeon R9 300 Series et autres RX400/500 en vente sur Ebay, plutôt que de dépenser plus de 500 euros dans une carte graphique Vega…

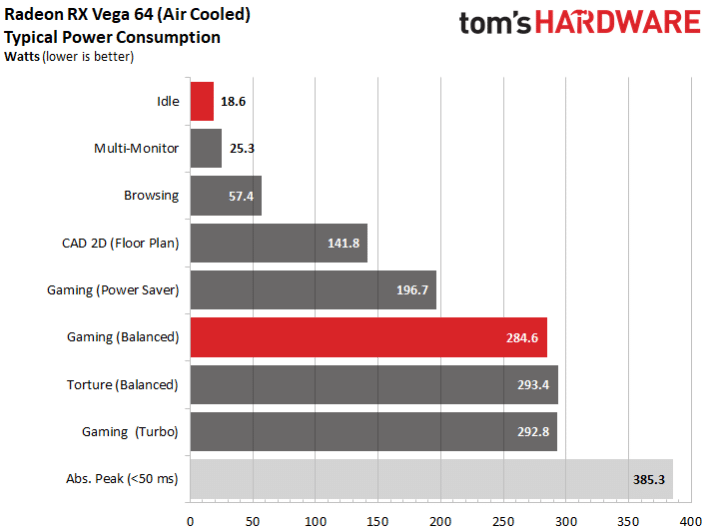

RX Vega 64 : consommation

Comme nous avons déjà pu le mentionner, les cartes Vega disposent de plusieurs profils de fonctionnement dans le logiciel WattMan du fabricant : mode équilibré par défaut, mode économie d’énergie, et un mode Turbo. En plus, nous avons deux BIOS, le second permettant de diminuer la consommation de la carte.

Voilà qui sonne plutôt bien, seulement voilà : le mode économie d’énergie compromet les performances, et le mode Turbo sacrifie l’efficacité énergétique de la carte. Nous avons utilisé la configuration d’usine (mode équilibré) pour tester la Vega 64, le seul valable en pratique. Nous avons toutefois testé les trois modes et les deux BIOS avec la Vega 56 en page suivante.

Consommation selon l’activité

La carte ne consomme que 19 W au repos, ce qui est plutôt bien, mais nous aurions espéré encore moins. Avec deux moniteurs identiques, la consommation au repos monte à 25 W (40 W avec trois moniteurs), mais cette valeur peut varier en fonction de la nature et de la combinaison des moniteurs (définition, fréquence de rafraichissement).

Notez que le mode Turbo est un peu inutile à relever, car la carte atteint vite sa limite de température, ne laissant pas assez de temps pour évaluer sa consommation, et ensuite, il y a le bruit du ventilateur…

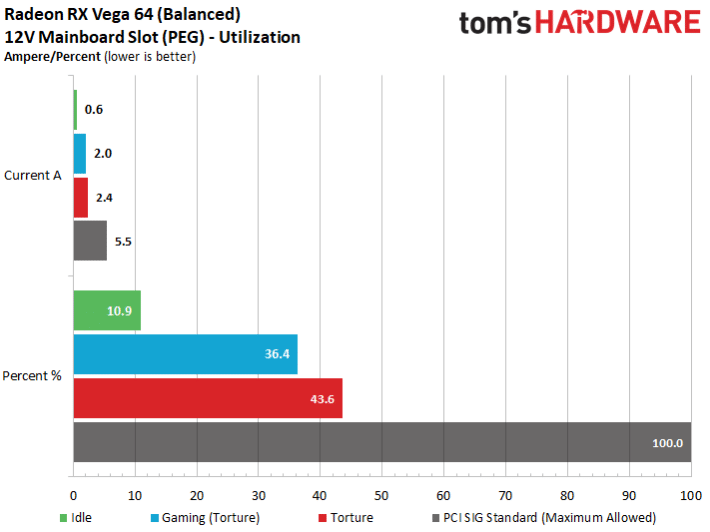

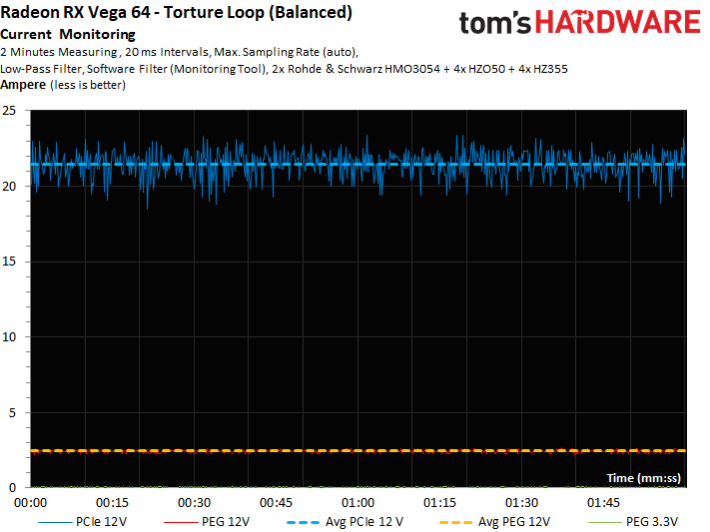

Charge sur le slot PCIe

Depuis la sortie de la RX 480, nous tenons à mesurer la consommation de chaque carte sur le slot PCIe de la carte mère. Pour la Vega 64, aucun problème à signaler !

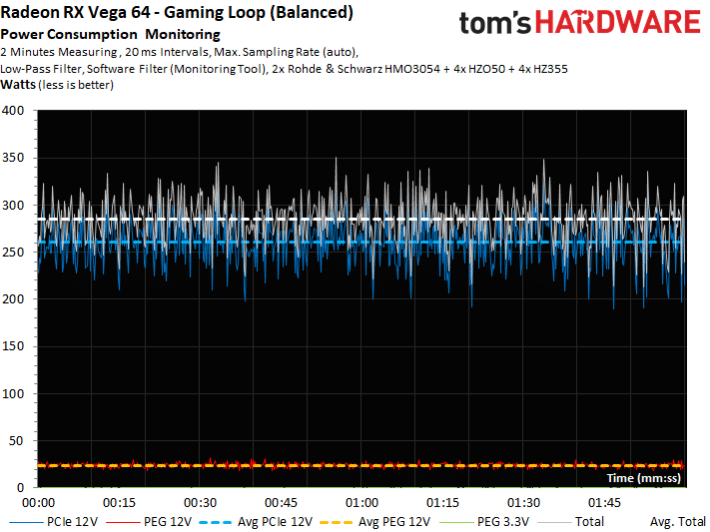

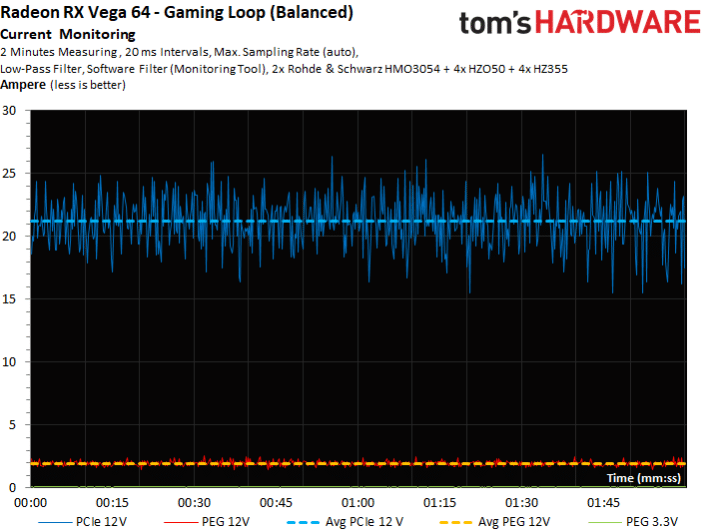

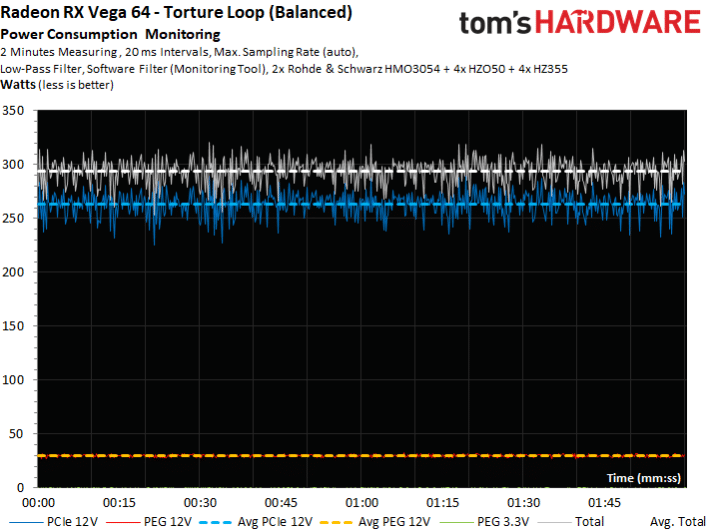

Courbes détaillées sur le temps

RX Vega 56 : consommation

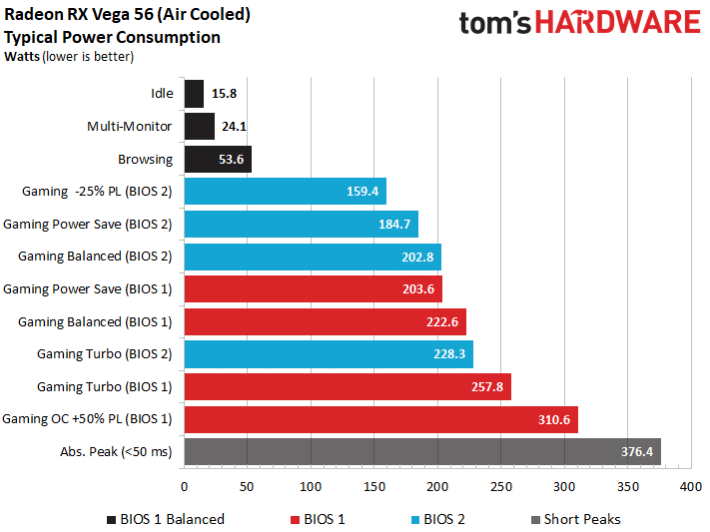

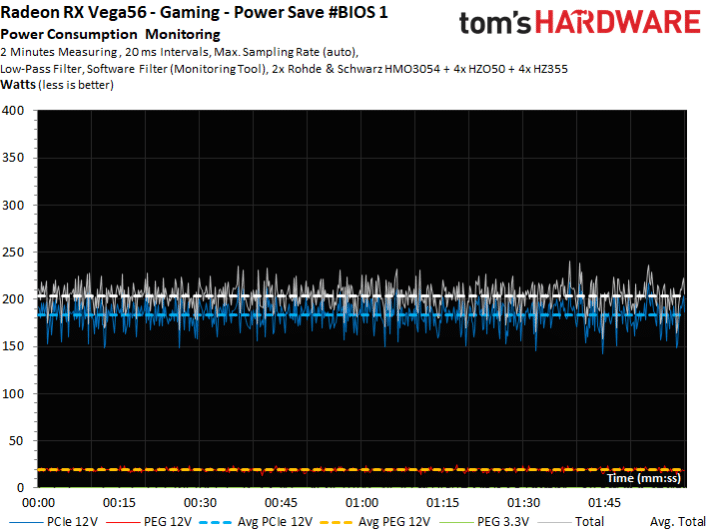

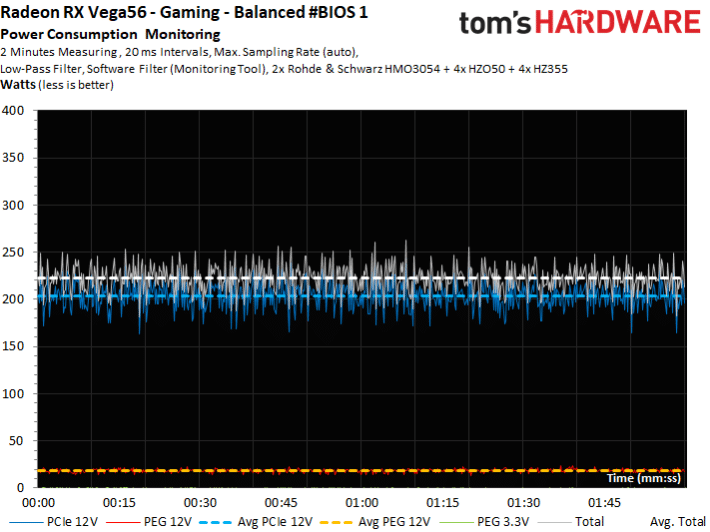

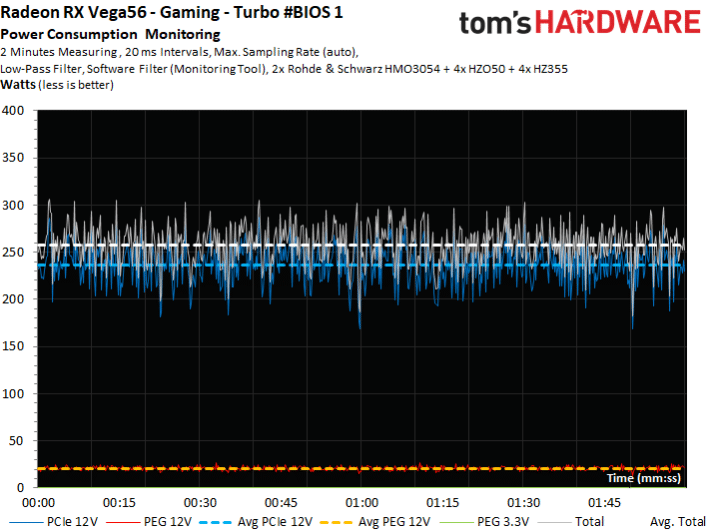

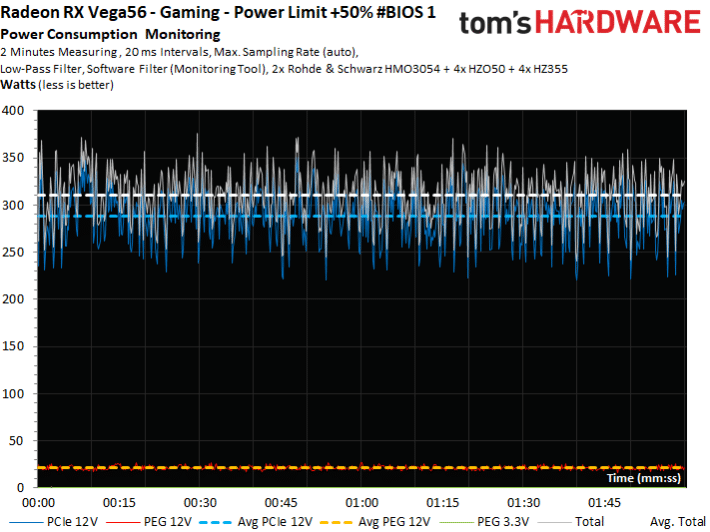

Comme nous l’avons précisé, il existe donc 6 modes de fonctionnement différents, et pour la Vega 56, nous en avons testé plusieurs, alors que nous sommes restés sur le profil par défaut sur la Vega 64.

Consommation selon l’activité

AMD a équipé la Vega 56 du même interrupteur que sur la Vega 64 et qui permet de choisir entre deux versions du BIOS différentes. La limite de consommation (Power Target) est fixée à 260 W pour le BIOS 1 et 230 W pour le BIOS 2. Ces valeurs sont seulement atteintes lorsqu’on active le mode « turbo » dans Wattman. On peut en outre choisir le mode « équilibré » (par défaut) ou « économie d’énergie ».

Nous avons testé les six cas de figure en situation de jeu intense (The Witcher 3 en 4K). De plus, nous avons effectué d’une part un léger underclocking (baisse manuelle de la fréquence) avec le BIOS 2 accompagné d’une baisse de la limite de consommation de 25 %, et d’autre part, avec le BIOS 1, un léger overclocking accompagné d’une augmentation de 50 % du Power Target. Dans ces huit cas de figure, nous avons évalué la performance, la fréquence, les températures et les nuisances sonores engendrées.

Observons tout d’abord la consommation dans les différentes configurations :

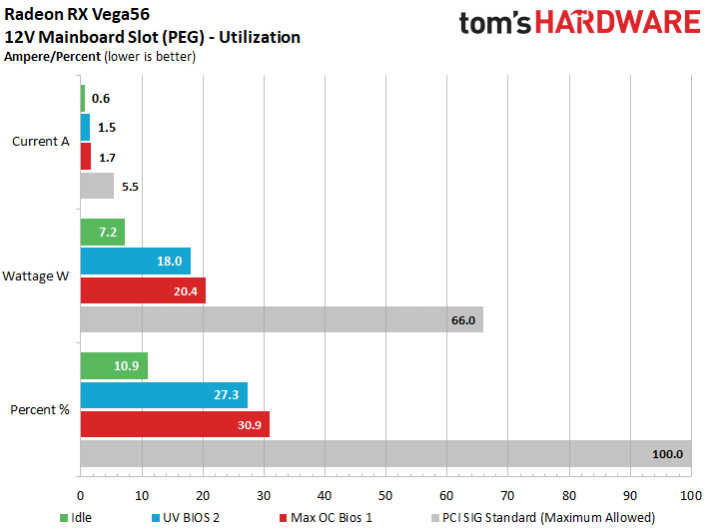

Notre overclocking permet de s’assurer que même dans ce cas extrême, la carte ne tire pas trop de courant sur le slot de la carte mère. Avec 1,7 A quand la norme PCI SIG préconise 5,5 A, la carte consomme donc au maximum seulement 27% de ce qui est permis. Pas de quoi tirer la sonnette d’alarme comme c’était le cas pour la Radeon RX 480.

A notre avis, cette histoire de double BIOS est plutôt compliquée (il faut éteindre la machine et ouvrir le boitier pour accéder au fameux interrupteur) et n’apporte pas grand-chose en pratique puisque le mode « économies d’énergie » du BIOS 1 est peu ou prou équivalant au mode « équilibré » du BIOS 2.

En baissant le Power Target de 10 % dans le BIOS 1, on atteindrait aussi le mode « économie d’énergie » du BIOS 2. On aurait tout simplement pu se passer du deuxième BIOS en ajoutant dans Wattman deux options supplémentaires. Pourquoi faire compliqué quand on peut faire simple ?

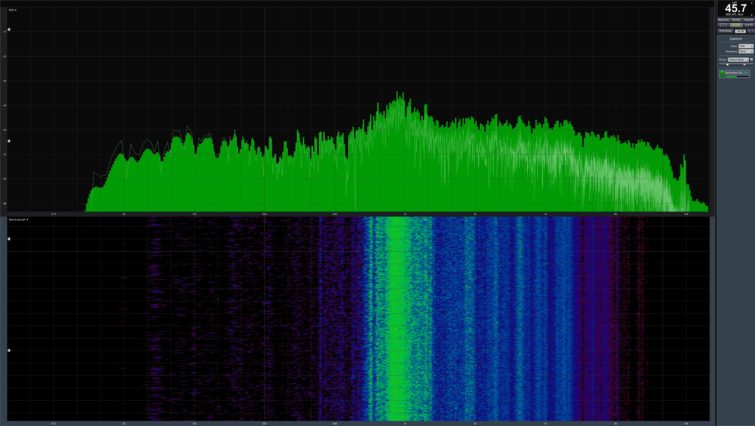

Consommation détaillée dans le BIOS 1

Nous présentons tout d’abord pour chacune des options du BIOS 1 le graphique d’évolution de la consommation sur les différentes entrées ainsi que la consommation totale.

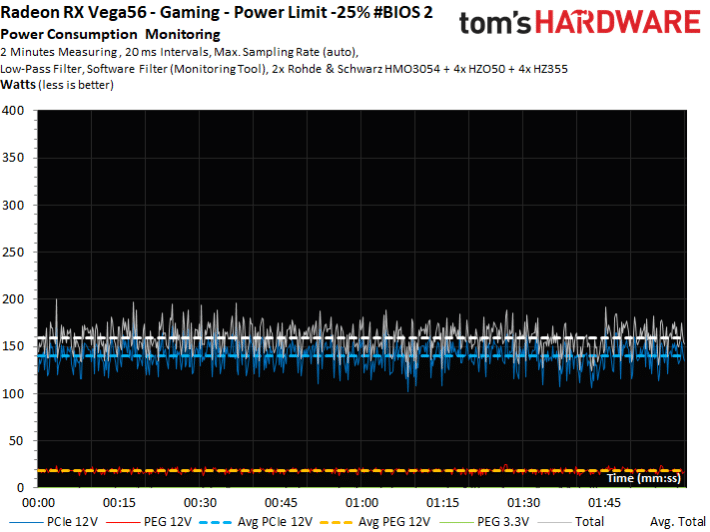

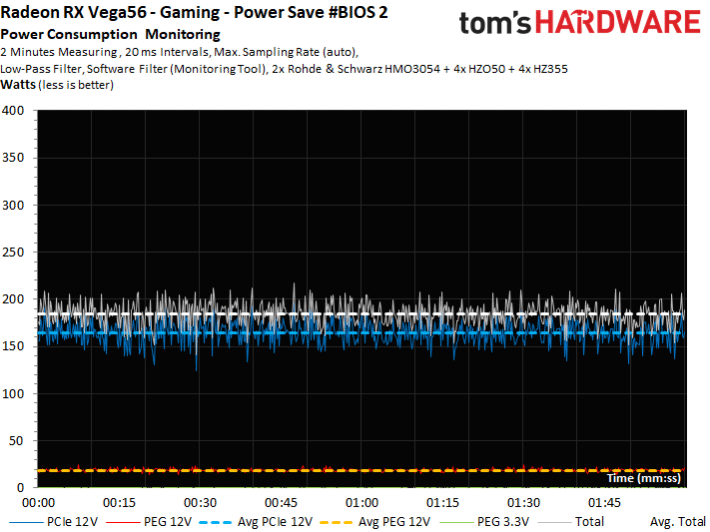

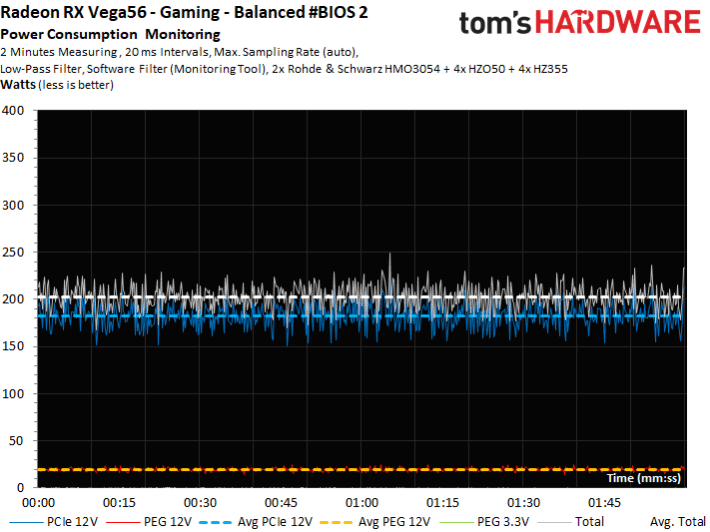

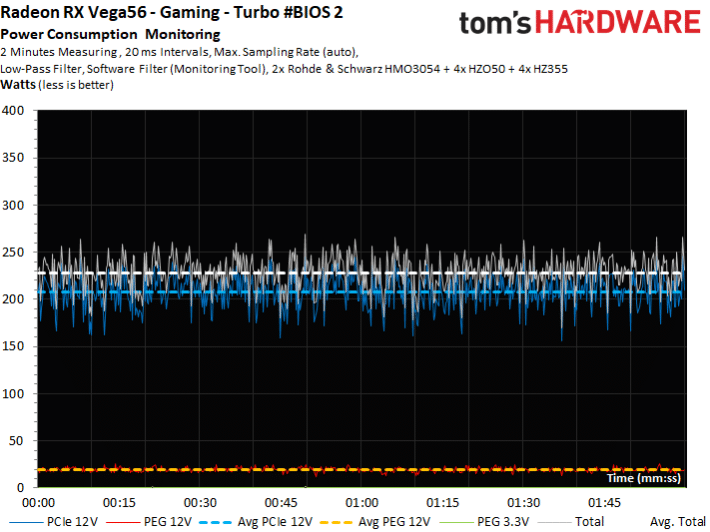

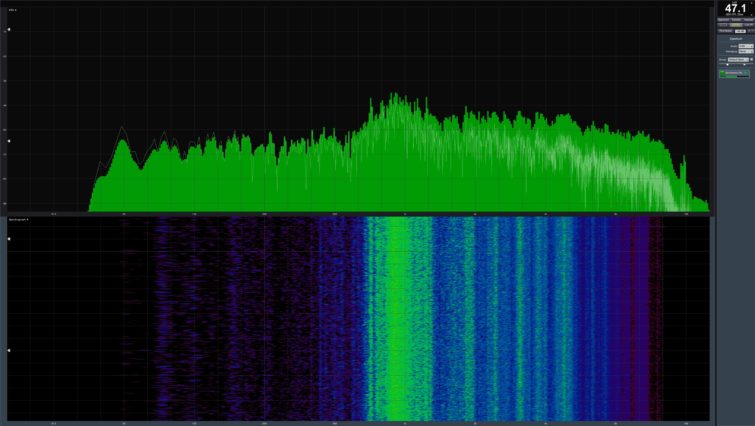

Consommation détaillée avec le BIOS 2

Passons aux résultats pour le BIOS 2, underclocking inclus.

RX Vega 64 : températures, bruit, fréquences

Températures et fréquences

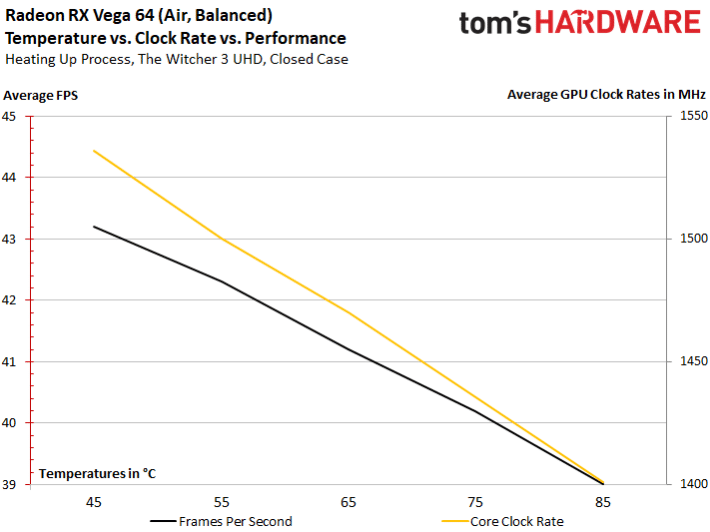

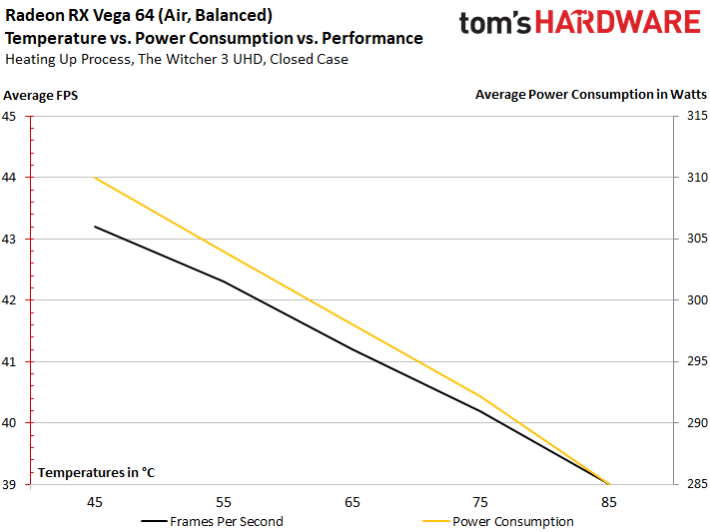

La température maximale de 85°C est atteinte assez rapidement à cause du mode de fonctionnement très restrictif du ventilateur. A ce moment là, la carte perd environ 6 % de performances, à mettre sur le compte de la réduction de la fréquence du GPU d’environ 9 %. Le GPU commence à 1533 MHz, puis termine à 1401 MHz une fois que le GPU est au plus chaud.

Températures et consommation

C’est là que ça commence à devenir intéressant. Une fois chaud, le GPU tourne donc à 1401 MHz en moyenne, avec une consommation de 285 W. Avant, le GPU est à 1533 MHz avec une consommation de 310 W. Voilà donc une consommation en hausse de 9 % plus une fréquence en hausse de 9 %, et des performances en hausse de 6 %. Bref, la courbe d’efficacité tend à baisser… La carte est déjà réglée à bloc par le fabricant.

On peut aussi dire que les pertes dues aux fuites de courant ont un rôle négligeable. Les jours où l’on pouvait économiser 40 W de consommation en gardant sa carte graphique au frais sont révolus.

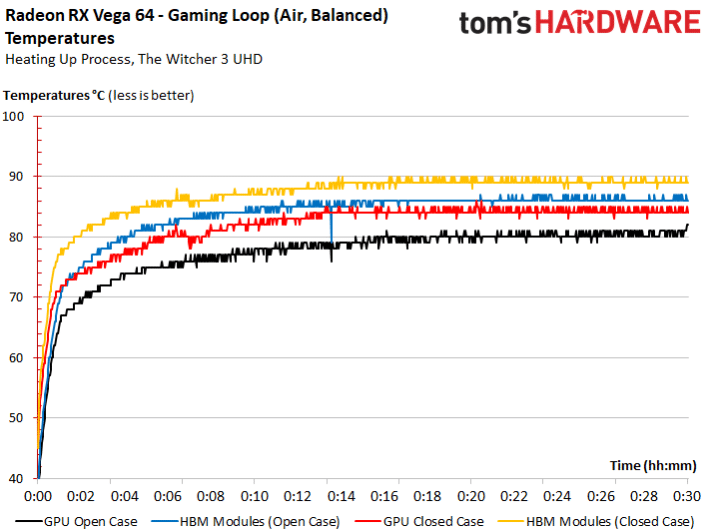

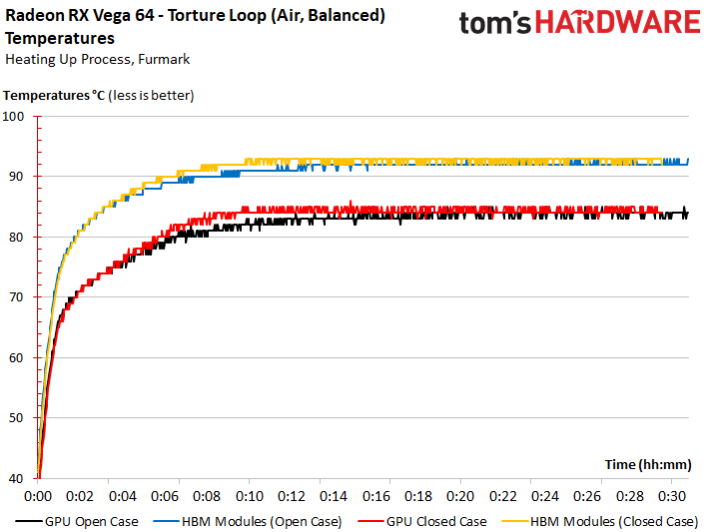

Température du GPU et de la RAM HBM2

A moins que les capteurs ne soient pas fiables, la température maximale du GPU est de 84-85°C, alors que la mémoire HBM2 peut monter à 90°C, et même 94°C en pic en test de torture. Il nous reste encore à confirmer la fiabilité des capteurs dans de prochains tests.

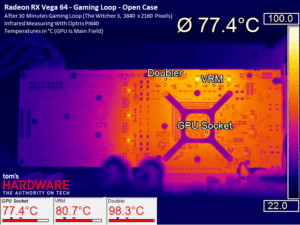

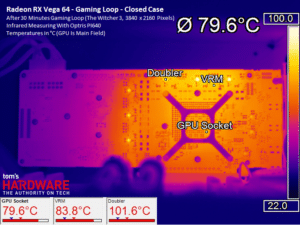

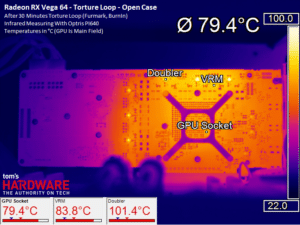

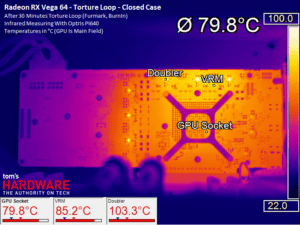

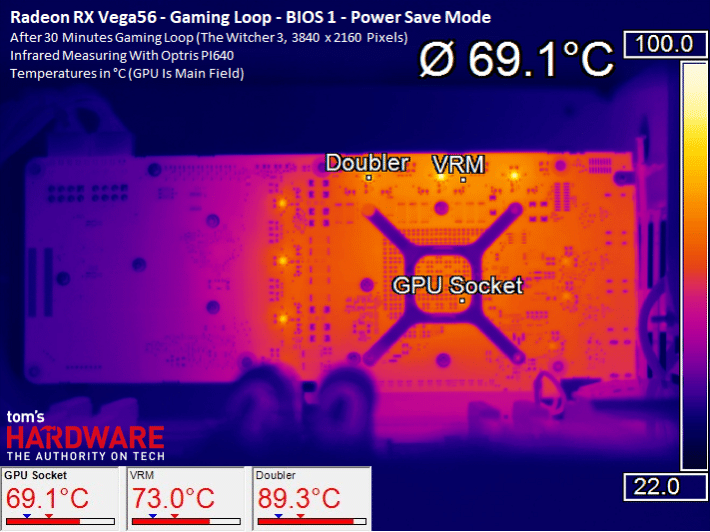

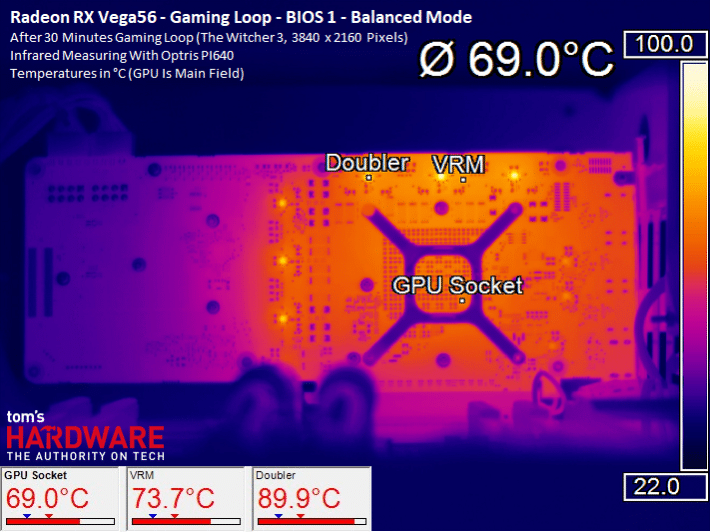

Températures sur la carte

On constate que les températures relevées sous le GPU sont environ 5 °C inférieures à celles des sondes internes du GPU. En cause, la structure sur laquelle sont posés le GPU et les deux puces de RAM HBM2. Cette dernière (interposer) n’est pas en contact direct avec le package de la puce, fixé au PCB. Cet espace vide agit comme une petite isolation thermique, ce qui réduit l’intérêt d’aller refroidir le GPU derrière le PCB.

En torture les températures sont moins élevées car le ventilateur tourne plus vite et le GPU est en réduction de fréquence.

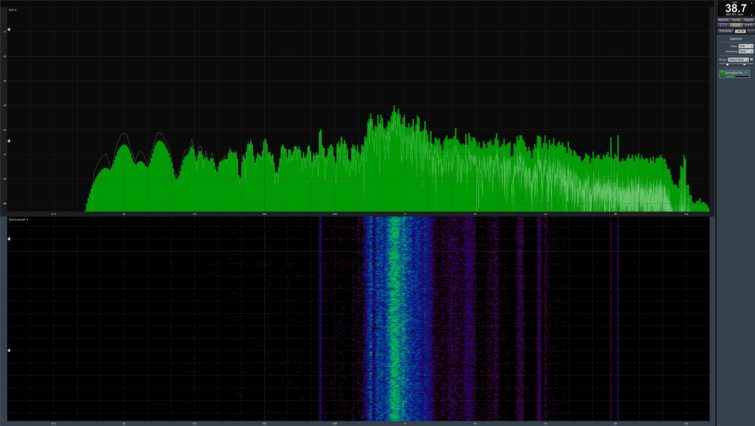

Bruit

Par défaut (premier BIOS, mode équilibré), la carte dégage 48,2 dB. En mode Turbo, elle monte à 50 dB.

Nous avions salué la bonne dissipation de la Frontier Edition, mais son murmure devient une petite tornade sur la Vega 64, à cause d’une puissance largement revue à la hausse. Toutefois, la GTX 1080 Ti Founders Edition, limitée à 295 W, est presque aussi bruyante.

RX Vega 56 : températures, fréquences

Fréquences et performance dans les jeux

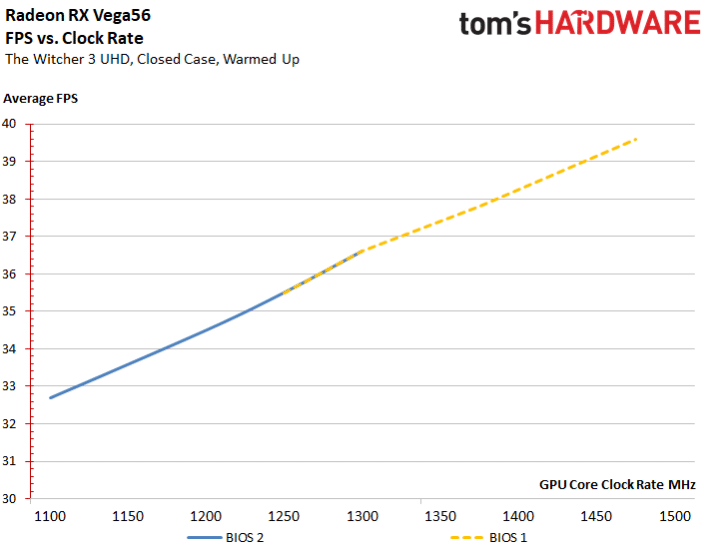

Nous évaluons la fréquence GPU et le nombre FPS dans The Witcher 3 en 4K. Nous commençons avec les réglages par défaut avec le BIOS réglé sur « équilibré » et obtenons 36,6 ips pour 1305 MHz. Ces premiers résultats nous servent de base pour la suite.

En activant le BIOS 2 et en baissant le Power Target de 25 %, le GPU monte encore à 1101 MHz pour 32,7 ips. On atteint alors encore 85 % de la fréquence et 89 % de la performance en jeu !

À l’inverse, la carte overclockée atteint presque 1500 MHz pour 39,9 ips. L’augmentation de 15 % de la fréquence ne se traduit alors que par une augmentation de 8 % de la performance jeu.

L’écart de fréquence entre ces deux extrêmes est donc de 36,4 % tandis que la performance n’augmente que de 21,1 %. On ne peut pas dire que ce soit un résultat brillant, mais ce n’est pas non plus catastrophique, loin de là. Si on passe à la différence de consommation, là l’écart se creuse de manière bien plus importante !

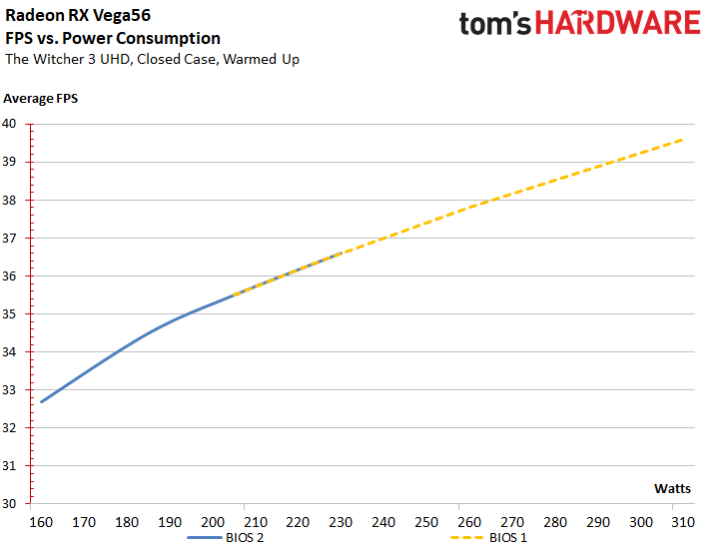

Le BIOS 2 activé et le Power Target réduit de 25 %, la carte consomme 159,4 W pour 32,7 ips. On atteint donc 89 % de la performance obtenue avec les réglages par défaut avec seulement 71,6 % de la consommation.

Dans le pire des cas, la carte overclockée atteint 310,6 W et le nombre d’images par seconde 39,6. Une surconsommation de 39,5 % ne permet qu’un maigre gain de 8 %. La courbe de l’efficacité énergétique diminue donc fortement avec une consommation qui explose pour quelques MHz de plus.

Entre les deux extrêmes, la consommation va presque du simple au double (94% de plus) alors que la performance n’augmente que de 21,1 %. Un doublement de la conso pour à peine un cinquième de performance en plus : voilà un constat bien peu reluisant et de mauvais augure pour les cartes partenaires overclockées.

Efficacité énergétique et recherche du réglage optimum

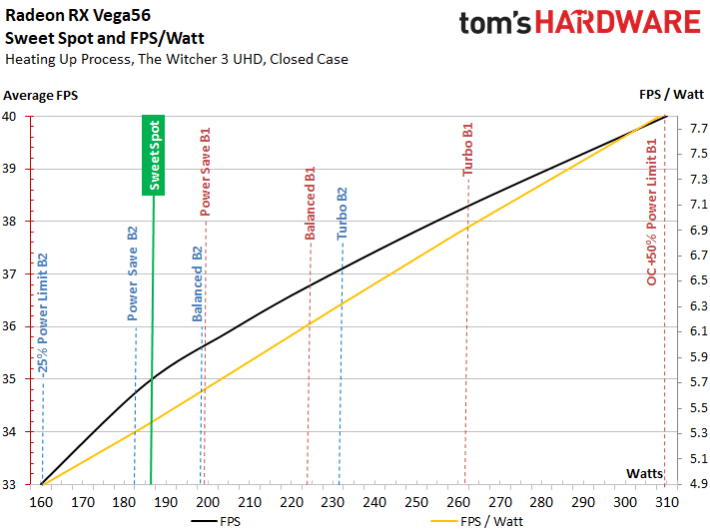

Si on compare maintenant les valeurs obtenues dans un graphique récapitulatif, on obtient une sorte d’arc représentant l’efficacité de la carte en FPS par Watt, c’est à dire la performance en jeu par rapport à la consommation électrique.

Là où l’écart entre les deux courbes est le plus important se situe le « sweet spot », c’est à dire la valeur où la carte est la plus efficace énergétiquement parlant. Ce point se situe entre 188 et 190 W. Étonnamment, aucune des six options proposées par AMD dans Wattman n’est placée à ce niveau !

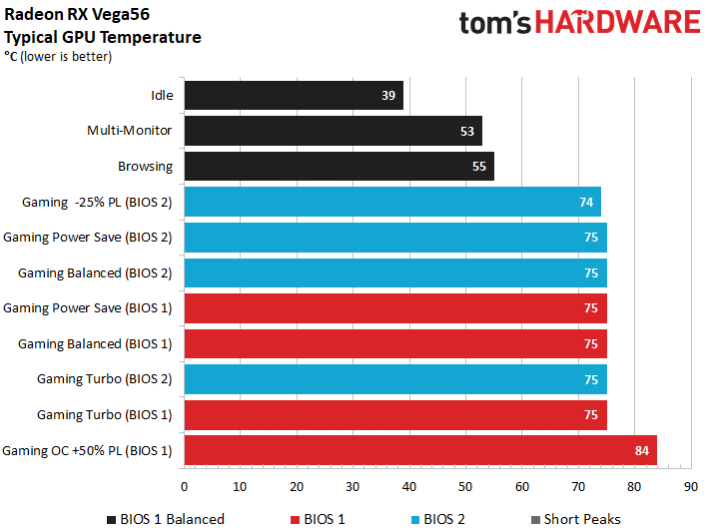

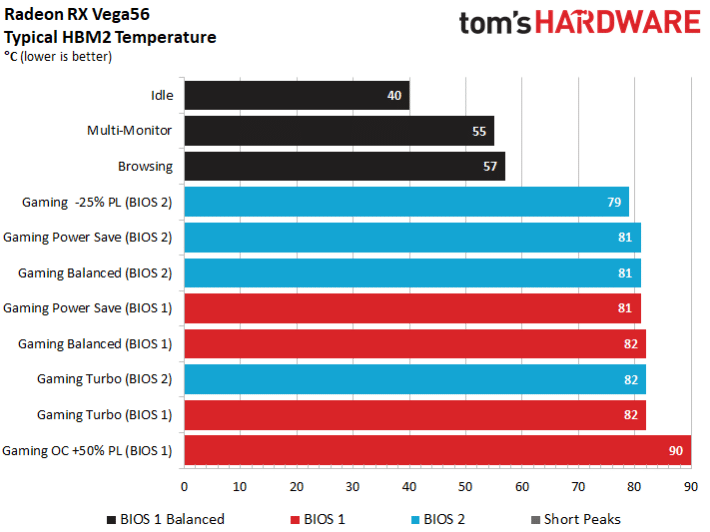

Température du GPU et de la mémoire

Les températures des six profils prédéfinis sont très semblables, c’est le ventilateur qui s’adapte et monte parfois très haut dans les tours quand la consommation augmente. La gestion du ventilateur est donc plutôt agressive. C’est seulement lors de notre overclocking manuel, en relevant le Power Target de 50 %, que le refroidissement est pris en défaut : la température augmente de 10°C par rapport aux profils prédéfinis.

La température de la mémoire HBM2 est, elle, au maximum 6°C plus élevée que le GPU. Lors de notre overclocking, nous sommes donc parvenus à dépasser les 90°C, une température assez préoccupante.

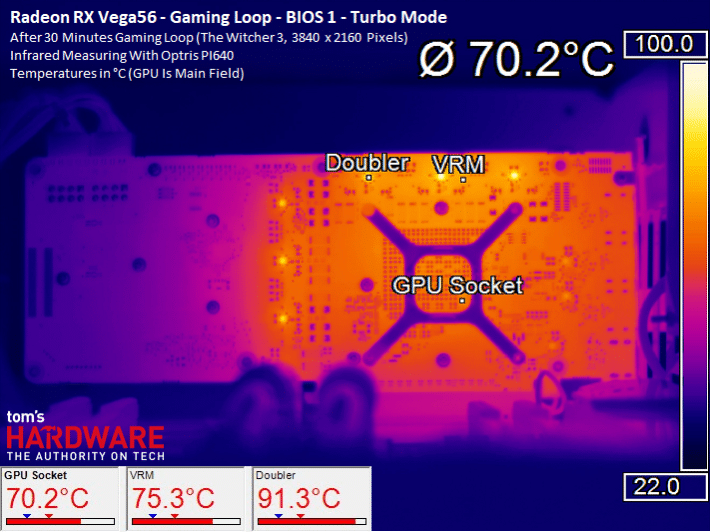

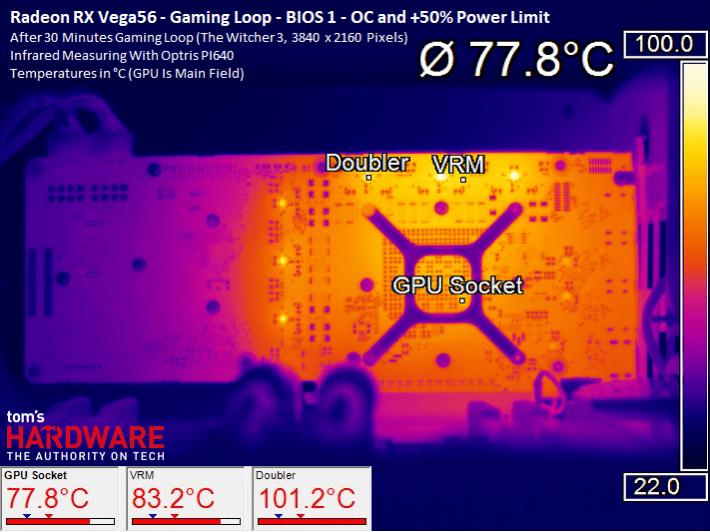

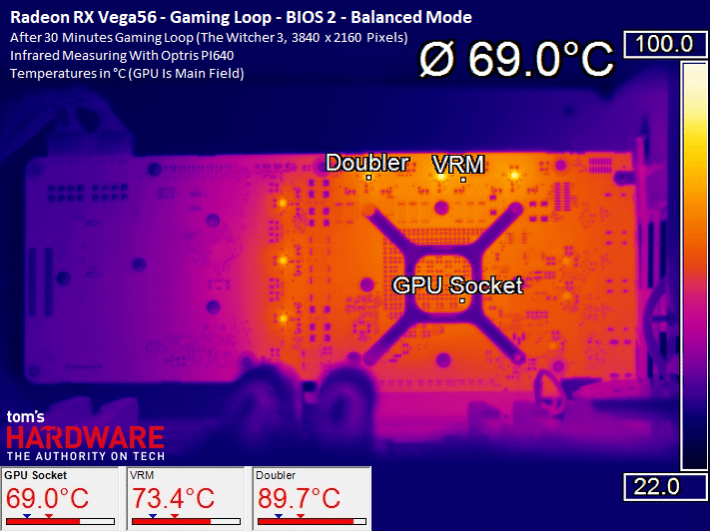

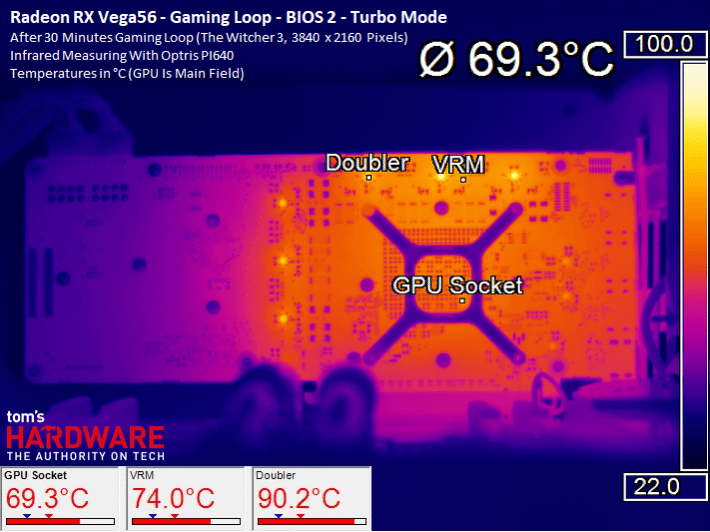

Images détaillées des températures pour les différents modes du BIOS 1

Pour chaque réglage du BIOS, nous montrons l’image infrarouge des températures relevées sur le PCB à l’aide de notre caméra thermique. Cela permet de voir l’impact de l’augmentation de la consommation et de la vitesse de rotation du ventilateur sur l’ensemble de la carte. On peut déjà dire que les températures sont plutôt semblables, puisque le ventilateur augmente dans les tours pour obtenir la température cible fixée du GPU à 74 – 75°C, sans égards pour nos oreilles.

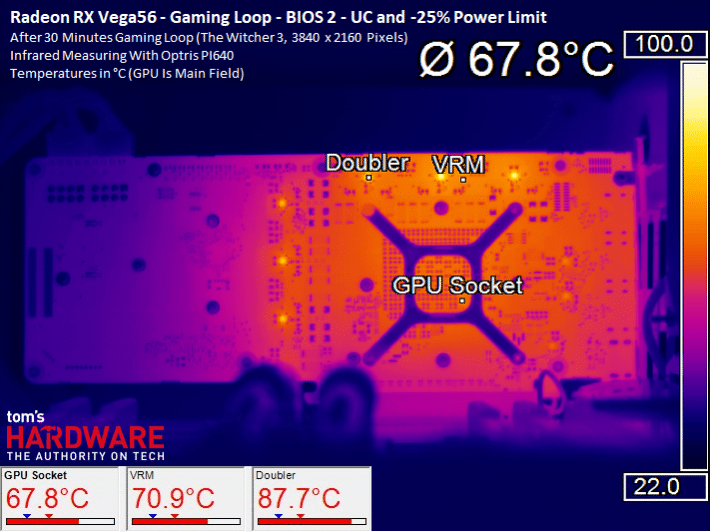

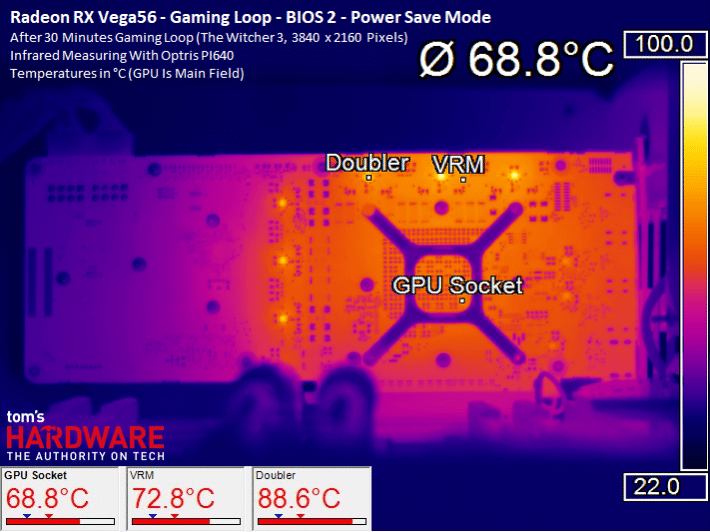

Températures avec les réglages du BIOS 2

Nous commençons avec la consommation minimale de 160 W qui diffère un peu de celle des autres, mais moins qu’en overclocking. Dans les autres modes, les températures augmentent légèrement, mais c’est surtout le ventilateur qui adopte progressivement un ton de sèche-cheveux.

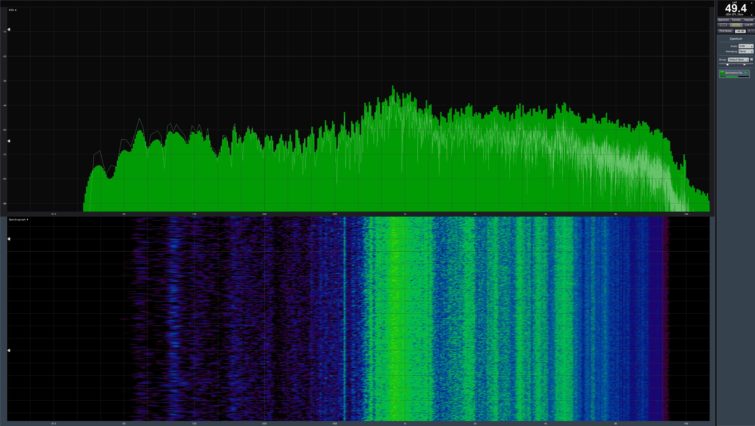

RX Vega 56 : ventilation et bruit

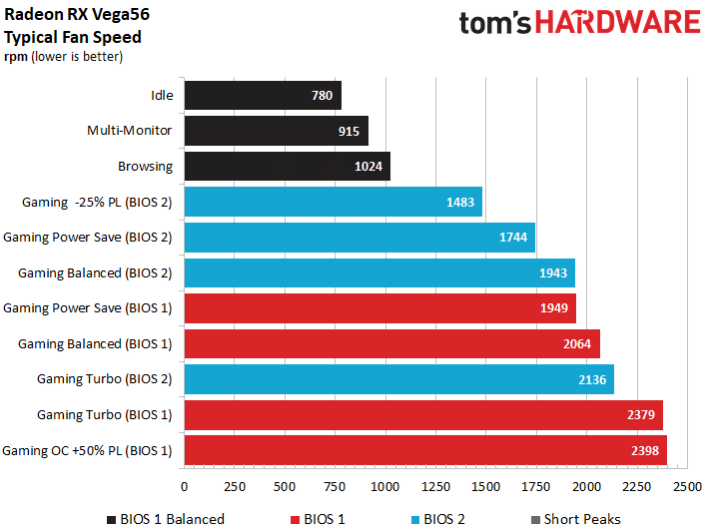

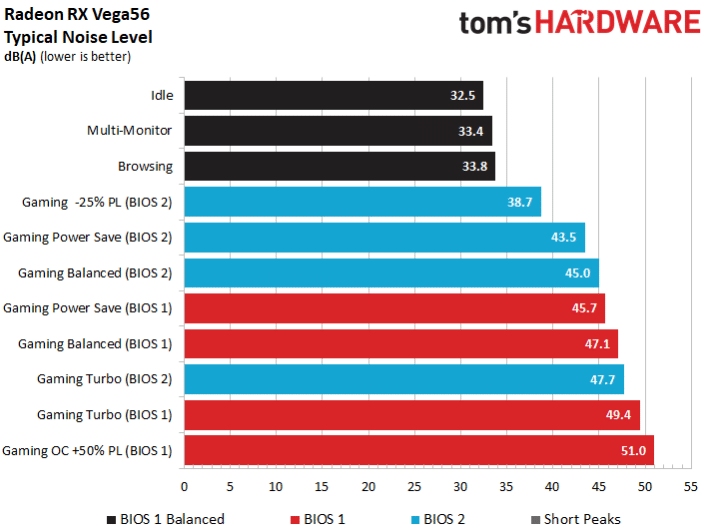

Vitesse de rotation du ventilateur

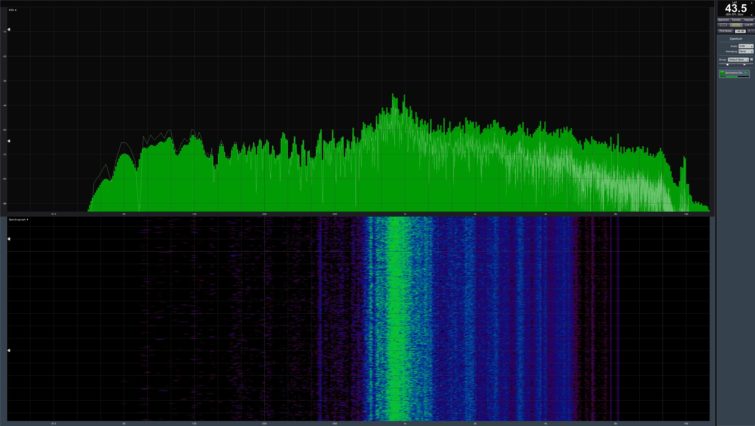

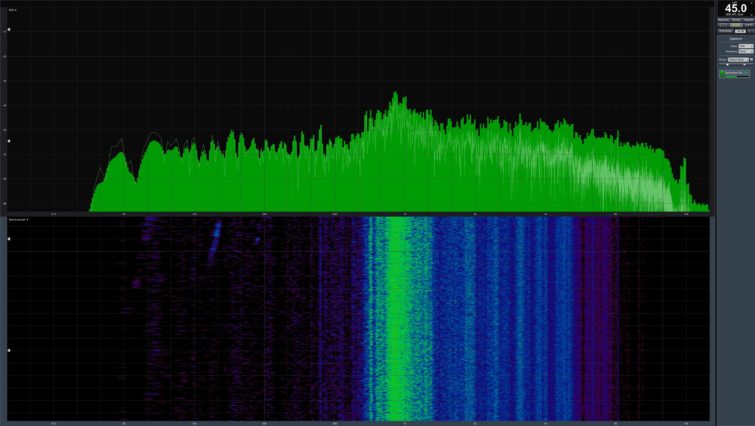

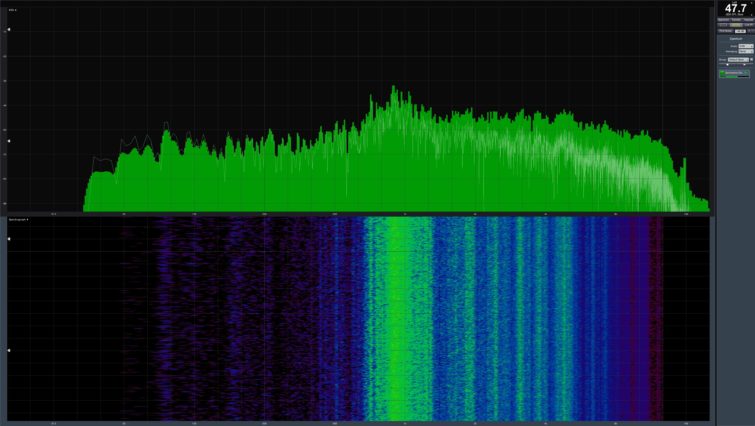

Nous l’avons vu, AMD donne la priorité au respect de la température cible GPU sur les nuisances sonores. Observons tout d’abord les vitesses de rotation des ventilateurs dans les différents modes testés :

Les nuisances sonores engendrées vont du discret à l’intolérable comme en témoigne l’écart de pas moins de 12,3 dB entre nos deux valeurs extrêmes !

Le ressenti subjectif du bruit engendré par le ventilateur a déjà été traité dans l’article du test de la Radeon Vega 64. Ici, on peut simplement dire que tout ce qui se situe au-dessus du mode « économie d’énergie » du BIOS 2 est insupportable pour les oreilles. La seule carte aussi bruyante testée jusqu’à présent était la carte de référence de la Radeon R9 290X, laquelle dépassait encore plus nettement les 50 dB.

En overclocking, les réglages d’origine AMD pour le ventilateur n’arrivent plus à contenir le dégagement de chaleur. Les températures sont donc nettement plus élevées, comme nous l’avons vu. Si on laissait le ventilateur augmenter jusqu’à 100 % de sa puissance, on atteindrait même 60 dB ! Impossible alors de rester durablement dans la même pièce.

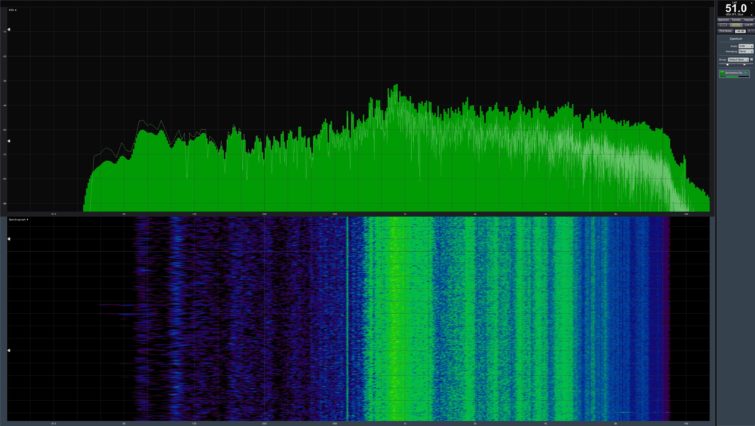

Mesures sonores pour le BIOS 2

Nous avons aussi mesuré les nuisances sonores pour les options du BIOS 2 du réglage le plus économe (et discret) au plus déraisonnable. Là aussi, ça décoiffe !

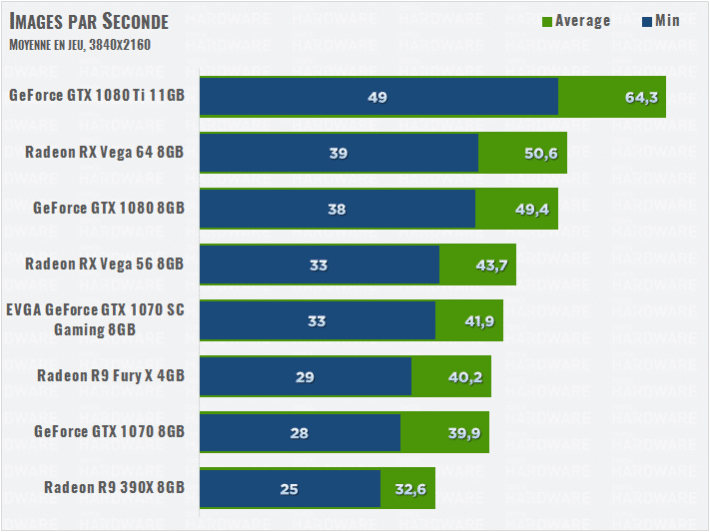

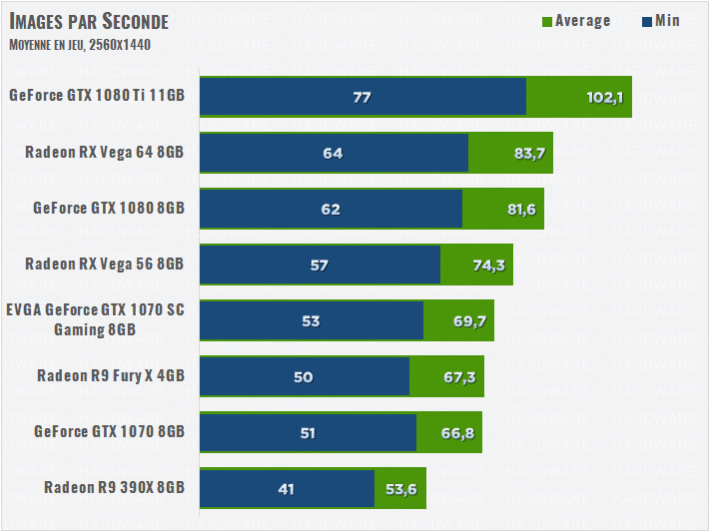

Moyenne des perfs, conclusion

Moyenne des performances

Non vous ne rêvez pas : les moyennes des performances sur nos 10 jeux testés montrent que les RX Vega 64 et 56 surpassent respectivement les GTX 1080 et 1070. Attention cependant, notre batterie de test regroupe 6 jeux DirectX 12 et Vulkan, et 4 jeux DirectX 11. L’architecture d’AMD s’en sort mieux, comme de coutume, dans les nouvelles API, et c’est comme ça qu’elle prend l’avantage dans nos moyennes.

Mais pour l’avenir, nous pensons que tester une majorité de jeux sur les dernières API permet de mieux coller à l’augmentation du nombre de jeux DX12 et Vulkan sur le marché. Et quoi qu’il en soit, les RX Vega obtiennent leur très bonne moyenne aussi grâce à leur performances en DirectX 11 dans le jeu Warhammer 40K !

Conclusion

Les Radeon RX Vega font plus grise mine quand on regarde leur consommation et leur température élevées, sans oublier leur prix incertain. Pour l’instant, AMD semble vouloir indexer le tarif de ses deux cartes sur leurs performances moyennes, en exagérant un peu… Le problème, c’est que face à leur consommation et leur nuisance sonore plus élevées, les GeForce GTX 1080 et 1070 restent très intéressantes, surtout si elles se révèlent moins chères ! N’oubliez toutefois pas un dernier détail : opter pour une carte AMD permet d’économiser sur l’écran grâce au FreeSync, en moyenne 100 euros moins cher que G-Sync.

AMD Radeon RX Vega 56 – Promo

Notez qu’effectivement, la Radeon Vega 56 est en promo de lancement à 405 euros chez un gros revendeur français, mais peut-on vraiment rendre une conclusion sur une promo ? Une chose est claire : à ce prix-là, aucun doute, la RX Vega 56 devient très intéressante malgré ses défauts.

Voici nos conclusions pour chaque carte :

AMD Radeon RX Vega 64

- Performances similaires/supérieures aux GTX 1080

- Avantage du coût du Freesync

- Bons espoirs pour l'avenir DX12 et Vulkan

- Consommation élevée

- Dissipation moins bien gérée que sur Frontier Edition

- Reste à gagner le soutient des développeurs

- Bruit

- OC peu rentable

La Radeon RX Vega 64 est en retard, certes. Mais ses performances sont bonnes dans les jeux, particulièrement en DX12 et sous Vulkan. La carte consomme toutefois bien plus que la GTX 1080 pour un gain de performance qui n’est pas proportionnel, sans compter qu’elle fait plus de bruit. Son succès sera donc conditionné par son prix, qui est malheureusement aujourd’hui plus proche des 640 euros, alors qu’on peut trouver des GTX 1080 à 500 euros.

AMD Radeon RX Vega 56

-

€

amd radeon rx vega 5626.50€

-

26.50€

-

32.17€

-

33.29€

- Plus rapide que la GTX 1070

- 30 % moins gourmande que Vega 64

- Excellente en QHD

- Bien plus gourmande que la GTX 1070

- Dissipation bruyante

- Prix trop incertain, actuellement trop élevé

- OC peu rentable

Encore une fois, la Radeon RX Vega 56 affiche des performances qui n’ont pas à rougir face à sa concurrente directe la GTX 1070. Reste que les choses se compliquent pour tout le reste : la carte est bruyante, gourmande et elle est surtout actuellement trop chère, alors que certaines GTX 1070 peuvent se trouver à 100 euros de moins.