Introduction

Plus d’un an et demi : c’est la période durant laquelle la 8800 GTX sera restée ce que l’on peut qualifier de haut de gamme de NVIDIA. Oh bien sûr, six mois après sa sortie et, heureuse coïncidence, juste avant l’arrivée du R600, on a bien vu débarquer une 8800 Ultra offrant des fréquences légèrement supérieures, mais rien de folichon. Il y a deux mois et demi, l’arrivée de la 9800 GTX laissait présager d’une augmentation substantielle de performance mais au final cette carte n’offrait qu’un gain limité sur notre bonne vieille GTX et restait derrière la version Ultra. Si les possesseurs de ces cartes pouvaient se réjouir de leur investissement, il était quand même temps de proposer mieux que quelques MHz grappillés de ci de là ou de recourir à des associations de deux GPU sur une même carte.

Enfin NVIDIA nous a entendus : la GTX 280 offre le premier véritable remaniement de l’architecture G8x. On connaît maintenant le mode de fonctionnement de la firme Californienne : introduire une nouvelle architecture sur un procédé de gravure éprouvé. En effet, du fait du nombre souvent très élevé de transistors la puce est coûteuse à produire et les cartes l’utilisant restent chères mais cela permet d’occuper le terrain. Pendant les années qui suivent NVIDIA dérive son architecture sur tout le segment de la gamme en utilisant une gravure plus fine mais moins optimisées pour les hautes fréquences. Enfin lorsque le nouveau procédé est maîtrisé NVIDIA en fait bénéficier son haut de gamme qui devient ainsi beaucoup plus abordable. On a connu ça avec le G70/G71, le G80/G92 et l’histoire se répète : voici donc le GT200, véritable monstre de 1.4 milliard de transistors gravés en 0.65µm.

Les GeForce GTX 200

A nouvelle génération, nouvelle dénomination. Le passage par la case « 10 000 » gêne visiblement les constructeurs. Là où ATI a résolu son souci en introduisant les chiffres Romains, NVIDIA change pour sa part complètement sa façon de nommer ses cartes. Désormais il faudra parler de GeForce GTX 200. Mais une question nous brule les lèvres : qu’est il arrivé aux GeForce GTX 100 ?

| Carte | 260 GTX | 280 GTX |

|---|---|---|

| Fréquence GPU | 576 MHz | 602 MHz |

| Fréquence ALU | 1242 MHz | 1296 MHz |

| Fréquence RAM | 999 MHz | 1107 MHz |

| ALU | 192 | 240 |

| Unités de texture | 64 | 80 |

| ROP (Raster OPeration unit) | 28 | 32 |

| Contrôleur mémoire | 448 bits (7 canaux 64 bits) | 512 bits (8 canaux 64 bits) |

| Type de RAM | GDDR3 | GDDR3 |

Comme nous le verrons plus loin, NVIDIA présente une nouvelle architecture mais pas question pour autant de repartir de zéro : si la genèse du G80 était partie d’une page blanche, cette architecture s’est avérée d’une redoutable efficacité. L’objectif du GT200 était donc de corriger toutes les petites erreurs de jeunesse de l’architecture et de mieux armer la puce pour les exigences des jeux à venir. Un peu à l’image de ce qu’avait été le G70 pour le NV40, on se retrouve donc avec tout un tas de petites améliorations mais surtout un gros gain en puissance de calcul.

Ainsi là où la 8800 GTX offrait une puissance de calcul flottant de 518 GFlops, la GTX 280 flirte pour sa part avec le Teraflop en affichant un impressionnant 933 GFlops. En réalité l’écart est encore plus important car ce chiffre de 518 GFlops pour le G80 repose sur l’exécution de 3 opérations flottantes par cycle (1 MAD et 1 MUL) qu’il est, du fait des limitations du G80, quasiment impossible d’obtenir en pratique. Avec le GT200 NVIDIA assure tests à l’appui que ce souci est résolu. Pour quasiment doubler la performance de calcul de son précédent GPU, NVIDIA a augmenté de façon substantielle le nombre de multiprocesseurs : de 16 on passe désormais à 30.

NVIDIA et AMD s’accordent à dire que les jeux du futur auront un besoin nettement plus élevé en puissance arithmétique qu’en puissance de texturing, par conséquent dans le même temps on ne sera pas surpris de constater que le nombre d’unités de textures augmente de façon beaucoup plus mesurée. Ainsi de 64 sur la 9800 GTX on passe modestement à 80 sur la GTX 280 (et si l’on compare la 8800 GTX à la 280 GTX cette fois, on passe d’un rapport théorique instructions arithmétiques / nombre de texels filtrés de 14,1:1 à 19,4:1). Sans plus attendre, illustrons ce point.

Puissance arithmétique (tests)

Pour ce faire, les tests synthétiques utilisant les textures procédurales (très calculatoires) sont généralement indiqués. Bien sûr, NVIDIA met pour cela en avant 3DMark Vantage et son Bruit de Perlin, sur lequel nous avons effectivement mesuré une augmentation de 129 % des performances entre la 9800 GTX et la 280 GTX. Mais vu l’importance qu’accorde toujours le constructeur à ce test et la facilité avec laquelle il est possible d’optimiser de nouveaux drivers (différents pour la 280 GTX et la 9800 GTX du reste) de manière à faire ressortir ce que l’on veut de ce test (voir notre article), voyons tout d’abord ce que nous indique une version oubliée de RightMark 3D avec ses Pixel Shaders 2.0 (Direct3D 9.0). Les valeurs des différents tests étant très variables, nous avons exprimé les résultats en différence de performance pour les faire figurer sur le même graphe, la référence étant la 9800 GTX.

L’amélioration est nettement plus mesurée, bien que réelle : elle reste en fait modérée su les shaders procéduraux et nettement plus marquée avec les éclairages complexes, avec jusqu’à 78 % de mieux. Passons maintenant à la version 2 de RIghtmark et ses shaders arithmétiques 4.0 (Direct3D 10.0).

Ici aussi les gains, sans être inexistants, sont plus proches de l’augmentation du ratio puissance de calcul flottant :textures que les chiffres obtenus sous 3DMark Vantage…

ROP

Bonne surprise au niveau des ROP, leur nombre augmente lui aussi, passant de 24 sur les G80 (16 sur le G92) à 32. Pour être sûr de pouvoir les exploiter correctement NVIDIA introduit à son tour un bus 512-bit qui sera, vu les caractéristiques de son GPU, certainement plus utile que sur le R600.

Avec 78 % de gain mesuré entre la 280 GTX et la 9800 GTX, nous retombons donc exactement sur le chiffre théorique, puisque le doublement de ROP est impacté de la baisse de la fréquence (qui atteint 675 MHz sur la 9800 GTX).

Puisque nous évoquions AMD soulignons qu’il devient de plus en plus urgent pour ce dernier de revoir ses GPU haut de gamme qui restent désespérément figés à 16 unités de texture et 16 ROP depuis les X800 en 2004 ! Alors que ses GPU restent compétitifs sur le plan de la puissance de calcul brute, sur ces points en revanche l’écart ne cesse de se creuser avec NVIDIA qui les améliore à chaque génération. Espérons que la nouvelle architecture d’AMD qui ne devrait pas tarder corrigera ces lacunes.

Ceci étant dit le résultat de la HD 3870 X2 nous permet de rappeler que si ATI est effectivement largement dépassé du côté du nombre d’unités par puce, n’oublions pas que la nouvelle stratégie du constructeur est d’opposer des cartes bi-GPU aux cartes single-GPU de NVIDIA ! Ce point couplé à une fréquence GPU toujours supérieure (825 MHz pour rappel) permet à la 3870 X2 de rester devant sur ce test très synthétique mais réel.

Et Direct 3D 10.1 ?

Au vu de la campagne menée depuis quelques temps par NVIDIA sur l’inutilité de cette API ce n’est pas vraiment une surprise d’apprendre que les GTX 200 ne supportent pas cette révision de l’API de Microsoft. Pas de surprise donc mais une déception malgré tout. D’après NVIDIA le support de l’API a été initialement envisagé mais selon les développeurs qu’ils ont interrogés ce n’était « pas important ». Certes Direct 3D 10.1 n’apporte pas de nouveautés révolutionnaires comme nous le disions lors de la sortie des Radeon HD 38×0, il s’agit essentiellement de correction de failles laissées dans les spécifications de Direct3D 10. Mais au milieu de tout ça on trouve quelques nouvelles fonctions intéressantes et qui pourraient s’avérer utiles aux moteurs de rendu de type deferred shading qui sont de plus en plus populaires, ou à des algorithmes de rendu de surface transparentes sans tri.

Alors oui tout ça peut sembler un peu superflu à l’heure où Direct 3D 10 ne montre toujours pas une supériorité flagrante sur la version 9 mais ça ressemble quand même à une excuse un peu facile de la part de NVIDIA. Dire que Direct 3D 10.1 est inutile à l’heure actuelle n’est pas totalement faux (encore qu’Assassin’s Creed prouve le contraire) mais c’est un peu un cercle vicieux : sans le support de NVIDIA il est clair que l’API ne peut pas vraiment être utilisée sérieusement par les développeurs. On a déjà connu une situation de ce type mais inversée : à la sortie du NV40 quels développeurs utilisaient le Shader Model 3 ? Surtout sur les premières GeForce 6 où les principales fonctions comme le Vertex Texture Fetch ou les branchements dynamiques dans les shaders n’étaient pas des plus performants. Et pourtant à cette époque la firme se vantait d’être à l’avant-garde des API 3D.

Notre avis n’a donc pas changé par rapport à cette époque : même si ce n’est pas utile immédiatement, nous sommes favorables à l’inclusion des dernières technologies dans les nouvelles puces 3D pour permettre aux développeurs de se familiariser avec. Nous en tenions rigueur à l’époque à ATI et cette fois c’est à NVIDIA que nous décernons ce petit coup de gueule.

Une architecture SIMT ?

Vous connaissiez les termes SIMD et MIMD, mais avec le GT200 NVIDIA décrit ses Shader Multiprocessors comme des unités SIMT. Qu’est ce que ça signifie ? Tout d’abord l’acronyme signifie Single Instruction Multiple Threads, la principale différence avec le mode SIMD est que la taille des vecteurs traités n’a pas une largeur prédéfinie. Concrètement avec un nombre suffisant de threads le processeur se comporte comme un processeur scalaire. Pour bien comprendre la différence rappelons la manière dont fonctionnaient les unités de pixel shaders dans les architectures précédentes.

Le rasterizer générait des quads, des carrés de 2×2 pixels, chaque pixel étant pour sa part composé d’un vecteur de 4 valeurs flottantes simple précision (R,G, B, A) ou (X, Y, Z, W) qui sont les formats les plus utilisés dans les calculs 3D. Ces quads passaient ensuite dans une ALU qui travaillait de façon SIMD à 16 voies : appliquant la même instruction aux 16 nombres flottants. Ceci est une simplification pour illustrer le principe, en pratique les GeForce 6 et 7 offrait un mode appelé co-issue pour exécuter deux instructions par vecteur.

Depuis le G80 ce mode de fonctionnement a été remanié : le rasterizer génère toujours des quads, qui sont placés dans un buffer. Lorsque 8 quads (32 pixels, un « warp » en terminologie CUDA – voir notre article pour plus de détails) sont présents dans le buffer ils peuvent être exécutés par un multiprocesseur de façon SIMD. Quelle différence alors ? La façon dont les données sont organisées : au lieu de travailler sur 4 vecteurs de 4 nombres flottants organisés de cette façon (R, G, B, A, R, G, B, A, R, G, B, A, R, G, B, A), les multiprocesseurs travaillent sur des vecteurs de 32 flottants formés d’une seule composante de chacun des 32 threads :

(R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R, R) puis

(G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G, G) etc…

En programmation SIMD, le premier agencement des données s’appelle AoS (Array Of Structure), le second s’appelle SoA (Structure of Array). Cette deuxième organisation permet de meilleures performances : en effet pour peu que l’on dispose de suffisamment de données pour remplir un vecteur le processeur se comporte du point de vue du programmeur comme un processeur scalaire : les unités SIMD sont toujours utilisées à 100% quelle que soit la largeur des données qu’il manipule. A l’inverse la première organisation obtient sa performance de crête uniquement lorsqu’on applique la même instruction aux 4 composantes de chaque vecteur.

Scalable Processor Array

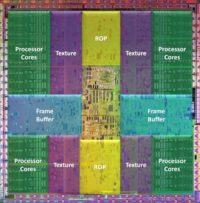

Pas de bouleversement de l’architecture qui repose toujours sur ce que NVIDIA appelle Scalable Processor Array (ou Streaming Processor Array selon votre interlocuteur). Le SPA du G80 était organisé ainsi :

8 TPC (Texture Processor Clusters) chacun équipé d’une unité de texture et deux Streaming Multiprocessor (SM). Avec le GT200 NVIDIA a revu le nombre d’unités à la hausse :

10 TPC, chacun toujours équipé d’une unité de texture mais désormais de trois multiprocesseurs. Ce changement traduit bien l’orientation des shaders modernes qui mettent l’accent sur les instructions arithmétiques.

Les unités de texture de chaque TPC reprennent le modèle de celles utilisées pour le G84 ou le G92 : on retrouve donc autant de capacité d’adressage que de capacité de filtrage contrairement au G80 qui offrait deux fois plus de capacité de filtrage que d’adressage. Dans un mode de filtrage simple et sur des textures RGBA8 (nearest ou bilinear) les unités de texture du G84/G92/GT200 sont donc deux fois plus performantes que celles du G80. Avec des modes de filtrage plus évolués ou des textures RGBA16 cette modification n’apporte rien.

Amélioration plus spécifique au GT200, NVIDIA affirme employer désormais un ordonnanceur plus efficace pour gérer les opérations de texturing permettant de se rapprocher plus près de la performance de crête qu’un G92. Vérifions cela sous Fillrate Tester :

Le passage de 64 à 80 unités de texturing couplé à la différence de fréquence GPU devrait conférer à la 280 GTX un avantage de seulement 11 % sur la 9800 GTX. Nous mesurons pourtant 43 % en quad texturing, et jusqu’à 118 % en dual texturing ! L’amélioration de l’ordonnanceur ne peut expliquer à elle seule cette évolution cependant, l’augmentation du nombre de ROP (doublés) jouant également. Il est cependant clair que la 280 GTX est nettement plus proche des valeurs théoriques du fillrate en single ou dual texturing (97%) que la 9800 GTX (entre 80 et 91%), les améliorations de NVIDIA à ce niveau ont donc porté leurs fruits en pratique. Comme nous l’avons expliqué précédemment, la carte bi-GPU d’AMD, cadencée plus rapidement par ailleurs que celles de NVIDIA ne s’avère que 32 % derrière la 280 GTX en quad texturing.

Voyons maintenant ce qui se passe avec les shaders 4.0 de texturing de RightMark3D 2.0, qui testent les texture lookups.

Le résultat sur le premier shader (Fur) est surprenant : 14 % de gain, c’est peu vu les optimisations sur le blending, les geometry shaders et le fillrate, tout dépendant là encore de l’implémentation du shader encore une fois. En revanche les 59 % de gain observés en Steep Parallax Mapping sont plus spectaculaires et attendus, et de bon augure.

Des Streaming Multiprocessors remaniés

Outre leur nombre plus important chaque multiprocesseur a bénéficié de plusieurs optimisations. En premier lieu le nombre de threads actifs par multiprocesseur a augmenté : de 768 on passe à 1024 (de 24 warps de 32 threads on passe à 32). Un plus grand nombre de threads est particulièrement utile pour masquer la latence des opérations de texturing. Sur l’ensemble du GPU on passe donc de 12 288 threads actifs à 30 720.

Le nombre de registres par multiprocesseur a pour sa part été doublé : de 8192 registres on passe à 16384. Etant donné que le nombre de threads a augmenté dans le même temps, le nombre de registres utilisables simultanément par un thread passe de 10 registres à 16. Comme nous l’avons vu dans notre article sur CUDA la limite des 10 registres par thread peut être rapidement dépassée. Sur les G8x/G9x notre algorithme a une utilisation de 67% des unités de calcul, sur un GT200 il aurait une utilisation de 100%. Couplé aux deux unités de texture les performances devraient être substantiellement plus élevées que sur le G80 que nous avions utilisé pour notre test. Malheureusement CUDA 2.0 impose l’utilisation d’un driver encore en version beta qui ne reconnaît pas les GeForce GTX 200. Dès que la branche principale des drivers introduira ce support nous ne manquerons pas de refaire le test.

Ce n’est pas la seule amélioration dont ont bénéficié les multiprocesseurs, NVIDIA nous annonce avoir optimisé le mode dual-issue. Pour rappel depuis le G80 les multiprocesseurs sont censés pouvoir exécuter deux instructions par cycle : un MAD et un MUL flottant. Nous précisons « censés » car à l’époque nous n’étions pas parvenus à voir ce comportement dans nos benchs synthétiques, sans savoir si c’était une limitation du hardware ou des drivers. Plusieurs mois et quelques révisions de drivers plus tard force est de constater que le MUL n’est toujours pas facile à isoler sur le G80 ce qui laissait supposer un problème au niveau du hardware.

Mais comment fonctionne ce mode dual-issue ? A l’époque du G80 NVIDIA ne donnait pas de détails mais depuis un brevet nous renseigne un peu plus sur la façon dont sont exécutés les instructions par les multiprocesseurs. Tout d’abord le brevet spécifie clairement que les multiprocesseurs ne peuvent démarrer l’exécution que dune seule instruction à chaque cycle GPU (la fréquence « lente »). Alors où est ce fameux mode dual-issue ? Et bien il s’agit d’une particularité du hardware : une instruction prendra 2 cycles GPU (4 cycles ALU) pour être exécutée sur un warp (32 threads exécutés par des unités SIMD 8 voies) mais le front-end du multiprocesseur peut cependant lancer l’exécution d’une instruction à chaque cycle pour peu qu’il s’agisse d’instructions de types différents : MAD dans un cas, SFU dans l’autre.

Streaming Multiprocessors (suite, test)

Outre les opérations transcendantales et l’interpolation des valeurs de chaque sommet, l’unité SFU est aussi capable d’exécuter une multiplication flottante. En alternant l’exécution d’instructions MAD et d’instructions MUL on obtient un recouvrement de la durée des instructions. Ainsi on obtient à chaque cycle GPU le résultat d’un MAD ou un MUL sur un warp c’est-à-dire sur 32 valeurs scalaires. Alors que d’après la description de NVIDIA on pourrait penser obtenir le résultat d’un MAD et d’un MUL tous les deux cycles GPU. En pratique ça revient au même mais d’un point de vue hardware ça simplifie grandement le front-end qui se charge de lancer l’exécution des instructions vu qu’une seule démarre à chaque cycle.

Qu’est ce qui limitait cette capacité sur les G8x/G9x et a été corrigé sur le GT200 ? NVIDIA ne nous donne malheureusement pas d’indication précise : ils précisent juste qu’ils ont revu des points comme l’allocation de registres, l’ordonnancement des instructions ou leur lancement. En tout cas comptez sur nous pour poursuivre nos investigations.

Essayons maintenant de voir si les modifications apportées par NVIDIA se révèlent utiles en pratique dans un test synthétique : GPUbench.

A titre de comparaison nous avons ajouté les scores de la 9800 GTX sur le graphe. Cette fois c’est net : on observe bien un débit plus élevé dans le cas d’instructions MUL comparativement aux instructions MAD. On est encore loin du double toutefois puisqu’on observe un gain d’environ 32% par rapport au débit obtenus dans le cas d’instructions MAD mais c’est toujours bon à prendre. Au passage il ne faut pas tenir compte des résultats obtenus avec les instructions DP3 ou DP4 dont les scores ne sont pas cohérents. De la même façon le résultat des instructions POW doit résulter d’un problème de driver.

Dernière modification apportée aux Streaming Multiprocessors : le support de la double précision (nombre flottants sur 64 bits au lieu de 32). Soyons clairs, la précision supplémentaire n’a qu’une utilité toute relative dans les algorithmes graphiques. Mais on le sait le GPGPU devient de plus en plus important pour NVIDIA et dans certaines applications scientifiques sans double précision point de salut !

NVIDIA n’est pas le premier à faire ce constat : IBM a récemment modifié son processeur Cell pour rendre les SPU plus performantes sur ce type de données. En termes de performance l’implémentation du GT200 laisse en revanche un peu à désirer : les flottants double précision sont gérés par une unité dédiée des Streaming Multiprocessors. Avec une unité capable d’effectuer un MAD double précision par cycle on obtient donc une performance de crête de : 1.296 x 10 (TPC) x 3 (SM) x 2 (Multiply+Add) = 77.78 GFlops soit entre 1/8ème et 1/12ème de la performance simple précision. AMD a pour sa part introduit ce support en utilisant les mêmes unités de calcul pendant plusieurs cycles et obtient des résultats nettement meilleurs : entre 2 et 4 fois plus lents que les calculs simple précision.

ROP : performances

Comme nous l’avons vu le nombre de ROP a augmenté mais ils n’ont pas gagné en fonctionnalités. Il faut dire que les ROP du G8x étaient déjà particulièrement complets : support des frame buffers flottants 16 et 32 bits avec blending et antialiasing, antialiasing jusqu’à 8x ou 16x en mode CSAA, rendu Z 8 fois plus rapides… Il n’y avait pas grand-chose à ajouter. NVIDIA s’est donc attardé à optimiser les performances. Ainsi en cas de blending dans des framebuffers RGBA8 les G8x/G9x voyaient leurs performances divisées par deux avec 12 pixels par cycle. Sur le GT200 cette limitation a été levée, couplé à un bus de 512 bit offrant une bande passante de plus de 140 Go/s les nouveaux ROP devraient faire des nouvelles GeForce de véritables monstres de fillrate. A ce sujet, voyons ce qu’est devenu le Z pixel rate :

Côté performances brutes, les résultats sont effectivement là avec un nouveau record atteint, 75 537 Mpixels/s à battre ! Pourtant, ce score reste décevant dans la mesure où il ne constitue qu’une multiplication par 4 et non par 8 du fillrate de base. Sur la 9800 GTX, nous retrouvons la valeur de 5,2 que nous avions mesurée lors du test de la 8800 GTX, et qui est donc un peu meilleure tout en restant là encore nettement en-dessous de la théorie.

Geometry Shader, autres

Les performances des précédents GPU Direct3D 10 de NVIDIA en Geometry Shading n’étaient pas particulièrement impressionnantes, la faute à des buffers internes sous dimensionnés. Rappelons le selon Direct3D 10 un Geometry Shader est capable de générer jusqu’à 1024 valeurs flottantes simple précision par sommet entrant. En cas d’amplification importante de la géométrie ces buffers étaient donc vite saturés et empêchaient les unités de continuer à calculer. Avec le GT200 ces buffers ont vu leur taille multipliée par six augmentant sensiblement les performances dans certains cas comme nous allons le voir. Pour bénéficier de l’augmentation de taille de ces buffers, NVIDIA a aussi du revoir l’ordonnancement des threads de Geometry Shading.

Sur le premier shader Galaxy, l’amélioration reste très modérée : 4 % de mieux. En revanche, celle-ci atteint pas moins de 158 % sur Hyperlight et montre bien l’amélioration potentielle sur ce type de shaders, tout dépendant de leur implémentation et de leur gourmandise (nombre de flottants générés par sommet entrant). La 280 GTX comble donc son retard et dépasse légèrement la 3870 X2 sur ce même shader.

Voyons maintenant le test Point Sprites (en Vertex Shading 2.0) de Rightmark 3D.

Pourquoi traitons-nous ce test dans la partie liée aux Geometry Shaders ? Tout simplement parce que depuis Direct3D 10, les point sprites passent par les Geometry Shaders, ce qui explique le doublement de performances entre 9800 GTX et 280 GTX !

Améliorations diverses

NVIDIA a également optimisé divers points de son architecture. La mémoire cache de post-transformation a vu sa taille augmentée. Le rôle de ce cache est d’éviter de devoir retransformer plusieurs fois le même sommet dans le cas de primitives indexées ou de triangles strips en sauvegardant le résultat des vertex shaders.

Du fait de l’augmentation du nombre de ROP, les performances en Early-Z rejection ont été améliorées : le GT200 est capable de rejeter jusqu’à 32 pixels masqués par cycle avant d’appliquer un pixel shader. NVIDIA annonce enfin avoir optimisé les communications des données et des commandes entre le driver et le front-end du GPU.

Performances Vertex/Pixel Shading

Devant tirer partie ne serait-ce que du quasi-doublement du nombre d’ALU, voyons d’abord comment se comportent les cartes sous les vertex shaders de Rightmark (donnant tous les mêmes performances).

De façon surprenante et malgré différents réglages et tests successifs, la 280 GTX n’est non seulement pas plus performante que la 9800 GTX, mais s’avère 12 % moins performante ! Des résultats que NVIDIA a également obtenu et n’est parvenu qu’à inverser en activant l’antialiasing 4X, surprenant pour un test de géométrie. Soulignons toutefois que si la puissance de calcul (et donc de transformation) a fortement augmenté, le setup engine n’a pour sa part pas été modifié. Il n’est, comme sur la 9800 GTX, capable que de générer un triangle par cycle. Or cette dernière conservant un avantage de fréquence (675 MHz contre 600 MHz) cela peut expliquer la différence observée.

Comme d’habitude sur Rightmark 2.0, le premier shader ne montre aucune amélioration avec la nouvelle carte, alors que le second permet d’observer un gain de 25 %. Si nous avons déjà largement évoqués les pixels shaders évolués via les tests précédents (arithmétiques notamment), voyons des shaders plus simples, avec celui d’éclairage par pixel de FillrateTester que nous utilisons depuis 4 ans maintenant (et qui donnait 188 Mpixels/s sur une… 9700 Pro !).

Que de chemin parcouru depuis ! Toutefois, avec seulement 40 % de gain, on pouvait légitimement attendre mieux de la 280 GTX. De même et sans représenter tous les résultats, assez lourds, de ShaderMark (qui utilise des Pixel Shaders 3.0), les gains restent bornés entre 20 et 26 % sur les 6 derniers shaders, et n’atteignent au mieux que 43 %.

Tous les résultats de cette page restent surprenants et montrent en tout cas l’écart entre l’augmentation théorique de la puissance (qui devrait notamment se mesurer sur les Vertex et Pixel shaders même anciens) et le gain obtenu effectivement dans des applications. Gageons que les drivers ne sont pas encore entièrement optimisés et n’oublions pas que même en utilisant un bench très spécifique il reste toujours difficile d’isoler un point précis sans être influencé par le reste du pipeline, a fortiori avec les architectures actuelles.

Spécifications : mieux !

Comme souvent, NVIDIA rend disponible deux cartes pour son lancement : une version très haut de gamme, la GeForce 280 GTX, et une carte légèrement plus abordable mais toujours haut de gamme, la GeForce 260 GTX. Voyons les autres caractéristiques de ces cartes comparées à leurs concurrentes.

| GPU | HD 3870 X2 | 9800 GX2 | 8800 Ultra | 260 GTX | 280 GTX |

|---|---|---|---|---|---|

| Fréquence GPU | 825 MHz | 600 MHz | 612 MHz | 576 MHz | 602 MHz |

| Fréquence ALU | 825 MHz | 1500 MHz | 1512 MHz | 1242 MHz | 1296 MHz |

| Fréquence mémoire | 900 MHz | 1000 MHz | 1080 MHz | 999 MHz | 1107 MHz |

| Largeur du bus mémoire | 2×256 bits | 2×256 bits | 384 bits | 448 bits | 512 bits |

| Type de mémoire | GDDR3 | GDDR3 | GDDR3 | GDDR3 | GDDR3 |

| Quantité de mémoire | 2 x 512 Mo | 2×512 Mo | 768 Mo | 896 Mo | 1024 Mo |

| Nombre d’ALU | 640 | 256 | 128 | 192 | 240 |

| Nombre d’unités de texturing | 32 | 128 | 32 | 64 | 80 |

| Nombre de ROP | 32 | 32 | 24 | 28 | 32 |

| Puissance shading | 1 TFlops | (1152) GFlops | (581) GFlops | 715 GFlops | 933 GFlops |

| Bande passante mémoire | 115,2 Go/s | 128 Go/s | 103,7 Go/s | 111,9 Go/s | 141,7 Go/s |

| Nombre de transistors | 1334 millions | 1010 millions | 754 millions | 1400 millions | 1400 millions |

| Process | 0.055µ | 0.065µ | 0.080µ | 0.065µ | 0.065µ |

| Surface du die | 2 x 196 mm² | 2 x 324 mm² | 484 mm² | 576 mm² | 576 mm² |

| Génération | 2008 | 2008 | 2007 | 2008 | 2008 |

| Shader Model supporté | 4.1 | 4.0 | 4.0 | 4.0 | 4.0 |

Première spécification qui saute aux yeux : avec 1400 millions de transistors et surtout 576 mm², NVIDIA a encore créé un ogre, le plus gros GPU jamais produit, parvenant à battre le record pourtant impressionnant obtenu avec le G80 (16 % plus petit) ! Cette valeur devant pourtant rester constante au fil des générations (elle est même en diminution ces derniers temps chez les CPU « grand public »), il est clair que la production du GT200 est extrêmement coûteuse pour NVIDIA bien que la conservation d’une finesse de gravure conservatrice ait permis l’existence de cette puce à la date actuelle.

Autre fait remarquable : en conservant de la GDDR3, ce n’est plus une mais deux générations de retard qu’accuse désormais NVIDIA sur ce plan vu que la GDDR5 ferra son introduction avec la toute proche Radeon HD 4870. La remarque ne va pas au-delà du simple constat toutefois, puisque grâce au bus de 512 bits l’augmentation de bande passante mémoire atteint 64 % face aux 86,4 Go/s de la 8800 GTX. Et enfin, nous assistons à l’arrivée d’une carte haut de gamme dépassant les 512/768 Mo de mémoire effectivement utilisable ! Avec 1 Go (et tout de même 896 Mo pour la 260 GTX, une bonne chose), les performances en 2560*1600 devraient donc cesser de s’effondrer anormalement !

Dernière remarque : les fréquences retenues restent assez conservatrices, surtout en ce qui concerne les ALU qui sont plus lentes que sur la 8800 Ultra notamment.

280 GTX ou 260 GTX ?

Avec 30 % de puissance de calcul flottant en plus et 27 % de bande passante mémoire, l’écart théorique entre les deux nouvelles cartes de NVIDIA est donc réel. En pratique, les cartes sont physiquement proches l’une de l’autre, et rappellent également les dernières GeForce 9 haut de gamme du constructeur, ce qui est une conséquence un peu dommage de la généralisation de la jupe noire englobant l’ensemble des dernières cartes du caméléon. Seuls en ressort le large ventilateur radial de 8 cm, toujours légèrement incliné de façon à souffler au plus près de la base, ainsi que les inévitables connecteurs d’alimentation supplémentaires. Deux connecteurs PCI Express 6 broches ou un connecteur 6 broches + un connecteur 8 broches : voila ce qu’il en coûtera à votre alimentation pour avoir l’outrecuidance d’installer une GeForce 260 GTX ou 280 GTX. Rien de réellement nouveau cependant, ATI nous ayant habitué à ces réquisitions depuis plus d’un an avec sa 2900 XT.

Les connecteurs SLI et l’entrée S/PDIF, toujours présents, sont pour leur part cachés derrière des protections amovibles. Seule vraie différence par rapport à une GeForce 9800 GTX : bien que double-slot et dotés d’une grille sur l’équerre, une partie de l’air chaud des deux cartes est évacuée via une seconde grille située sur la tranche supérieure des cartes et se verra donc recyclée dans le boîtier, une mauvaise nouvelle. La taille des cartes atteint toujours 26,7 cm, devenu le point commun des cartes graphiques haut de gamme depuis 2 ans maintenant, et le poids reste tout juste en dessous du kilo et de la HD 3870 X2 avec 915 g et 940 g.

Comme toujours pour le très haut de gamme au moment du lancement, les cartes Leadtek que nous avons reçues et testées dans cet article se conforment au design de référence, deux autocollants à l’effigie de la marqué étant simplement apposés sur leurs faces. Sachez néanmoins que la boîte de la 280 GTX inclura le jeu NeverWinter Nights 2 (pas forcément le plus récent ni le plus révélateur de la puissance de la carte), l’adaptateur DVI->VGA, le câble HDTV (YUV et S-Vidéo), 2 adaptateurs molex vers PCI-Express 6 broches ainsi qu’un adaptateur molex vers PVI Express 8 broches.

Le test

Pour ce test, nous avons utilisé notre configuration de référence, et avons comme à notre habitude testé les jeux exclusivement avec Fraps et en conditions réelles de jeu. La plupart des jeux précédemment utilisés ont été repris et comme toujours mis à jour (derniers patchs installés), mais deux nouveautés font toutefois leur apparition : Mass Effect, le RPG space opera de Bioware qui malgré son origine Xbox 360 a fait l’objet d’un portage réussi sur le plan technique et nous est tout simplement apparu comme incontournable de par son intérêt (venant combler le manque de jeu de rôle dans notre protocole depuis l’abandon de Fable). N’oublions pas non plus Race Driver GRID, qui malgré son interface toujours aussi horripilante pour le testeur (la même que le précédent Mac Rae Dirt du même Codemasters), reste extrêmement réussi visuellement et inaugure la dernière version de l’Ego Engine.

Tous les tests synthétiques DirectX 9 ont été exécutés sous Windows XP vu leur instabilité sous Vista (Fillrate Tester, Rightmark 1050, ShaderMark 2.1, SPECViewPerf 10). Rightmark 3D 2.0 (DirectX 10) a en revanche bien sûr été exécuté sous Windows Vista (non SP1 vu son instabilité avec), contre Vista SP1 pour l’ensemble des jeux, tests CUDA, mesures environnementales et l’overclocking. Rappelons que l’UAC, Aero, Superftech et l’indexation ont été désactivés pour assurer la stabilité des résultats.

Nous n’avons enfin retenu que deux résolutions pour ce test, le 1920*1200 (23-27″), et bien sûr le 2560*1600 propre aux 30″, ici sur le Samsung 305T. Nous estimons qu’il s’agit en effet des deux seules résolutions que ce type de carte très haut de gamme est amené à exécuter : en dessous (soit jusqu’au 22″), inutile de mettre autant dans la carte 3D pour disposer d’un affichage fluide sur la majorité des jeux actuels comme nous l’avons là aussi constaté lors des derniers tests.

Configuration de test :

- Asus P5E3 Deluxe (Intel X38)

- Intel Core 2 Quad QX6850 (3 GHz)

- Crucial 2 x 1 Go DDR3 1333 MHz 7-7-7-20

- Western Digital WD5000AAKS

- Lecteur DVD Asus 12x

- Coolermaster RealPower Pro 850W

- Windows XP, Vista, Vista SP1

- ForceWare 177.34 beta (260 GTX et 280 GTX sous Vista)

- ForceWare 177.26 beta (280 GTX sous XP)

- ForceWare 175.16 WHQL (9800 GTX, 9800 GX2, 8800 Ultra)

- Catalyst 8.5 WHQL (HD 3870 X2)

Flight Simulator X

Quelle idée de tester les dernières cartes très haut de gamme avec un jeu réputé limité par le CPU ? Le but était simple : vérifier que ces nouvelles cartes faisaient au moins aussi bien que la génération précédente, et vérifier la maturité du driver, puisque comme nous l’avons vu dans les précédents tests, Flight Simulator X réserve parfois des surprises.

Effectivement, les nouvelles GeForce GT200 ne sont pas à la fête : aucune d’entre elles ne permet de dépasser les 23 images/s ce qui même sur Flight Simulator X, est limite. Au contraire, la 9800 GX2 et surtout la 8800 Ultra montent à près de 30 images/s ce qui est nettement mieux. Gageons que les prochains drivers amélioreront la situation, car il reste malgré tout paradoxale que les joueurs achetant la dernière génération de NVIDIA doivent se contenter de performances inférieures, même si un jeu où le CPU revêt une grande importance.

Call of Duty 4

Si la 280 GTX est effectivement bien placée dans Call of Duty 4, dépassant la 9800 GTX d’un écart variant entre 41% (1920*1200) et 91 % (2560*1600 + filtres), on constate toutefois que la 9800 GX2 lui oppose une belle résistance. Celle-ci parvient en effet à la dépasser en 1920*1200 (d’un écart non négligeable de 17 % par ailleurs), probablement du fait de son nombre d’unités de texturing supérieur, la seule valeur théorique sur laquelle la récente carte bi-GPU de NVIDIA conserve l’avantage sur la nouvelle. Sur un écran 30″, la bande passante mémoire et surtout la quantité de mémoire doublée permet à la 280 GTX de récupérer in extremis sa place, mais seulement lorsque l’antialiasing 4X est activé (le jeu demeurant alors jouable). Le match promet donc d’être disputé… A noter que la 260 GTX accuse un retard de 21 à 28 % sur sa grande sœur, ce qui est conforme à ses spécifications et la place nettement devant une 8800 Ultra, mais clairement derrière la 9800 GX2 ici.

Test Drive Unlimited

Sous Test Drive Unlimited, la supériorité de la nouvelle carte très haut de gamme de NVIDIA n’est plus contestée, bien que la 9800 GX2 reste proche (moins de 8 % d’écart dans les 3 premières résolutions, et 17 % dans le réglage le plus lourd). Autre bonne nouvelle pour le constructeur : la supériorité de la 280 GTX se ressent dès le 1920*1200 avec des performances doublées par rapport à la 9800 GTX (filtres activés bien sûr). Curieusement, le passage au 30″ n’accentue pas cette avance mais la réduit – elle s’établit tout de même à 50 % hors filtres et 76 % avec. Quand à la 260 GTX, son avance sur la 8800 Ultra dans cette même résolution s’affaiblit elle aussi : 11 % en moyenne.

Crysis

Crysis fait comme toujours l’objet d’une attention surprenante et toujours renouvelée, sa forte gourmandise étant doublé ici des rumeurs qui ont accompagnées la fin de la période d’embargo sur les nouvelles cartes de NVIDIA. Voyons ce qu’il en est (notez que nous avons testé le jeu sur une nouvelle scène, moins gourmande que la précédente).

Vu la gourmandise du jeu (que nous avons choisi de tester dans les mêmes résolutions que les autres cette fois), la hiérarchie dans les graphes a été établit en fonctions des résultats hors filtres, bien plus pertinents. Crysis est-il jouable en 1920*1200 sur la 280 GTX ? Oui, mais il l’est moins sur cette carte que sur la 9800 GX2 sur notre scène de test ! Seule l’activation de l’antialiasing permet à la carte de tenir son rang, mais le framerate devient alors un peu trop faible pour être jouable en mode Very High. Seul problème donc : si dans 3 des 4 résolutions la 280 GTX est nettement devant la 9800 GX2 sous Crysis, ils constituent l’ensemble des résolutions où il n’est malheureusement toujours pas possible de jouer. Ce malgré les performances plus que doublées en 2560*1600 et le fait que les nouvelles cartes soient les seules à pouvoir rendre le jeu une fois l’antialiasing rajouté, hormis la 8800 Ultra. C’est donc une petite déception à ce niveau.

World in Conflict

Lui aussi très gourmand mais néanmoins jouable en 2560*1600 hors filtres, World in Conflict invite tout d’abord une surprise en tête du graphe 1920*1200 : la Radeon HD 3870 X2 ! Une fois les filtres activés, la carte bi-GPU d’AMD qui convient à merveille à ce jeu permet en effet de jouer dans les meilleures conditions, la 280 GTX la talonnant toute fois. Sur un 30″, son avance demeure, la quantité de mémoire de la 280 GTX ne faisant la différence que dans un réglage injouable une fois encore. Ce n’est pas tout puisque dans cette même résolution, c’est in fine NVIDIA qui reprend le leadership, mais pas avec la carte escomptée puisqu’on retrouve la 9800 GX2. Si vous ne jouez qu’à World in Conflict et à Crysis, la 280 GTX n’est donc pas faite pour vous…

Supreme Commander

Devenu moins gourmand avec l’âge et par rapport à certains jeux plus récents, Supreme Commander n’en reste pas moins intéressant et inévitable en réseau. Sur une scène de bataille mais mettant en jeu assez peu d’unités (afin de ne pas être trop limité par le processeur), plutôt légère donc, à aucun moment la 280 GTX ne parvient à surpasser la 9800 GX2, dont l’avance monte à 39 % en 2560*1600. Le résultat de la 280 GTX n’est pas ridicule pour autant, restant environ 45 % supérieur à la 9800 GTX et la 8800 Ultra même si l’on pouvait légitimement espérer mieux.

Unreal Tournament 3

Le duel au sommet reste intéressant à analyser Unreal Tournament 3 : si la logique est respectée en 1920*1200, une nouvelle fois la 9800 GX2 s’invite là où elle n’est pas attendue, en 2560*1600. Malheureusement pour elle, sa quantité de mémoire limitée lui interdit l’exécution du jeu avec les filtres, ce que permet pourtant de manière fluide la 280 GTX qui reste donc en tête sur ce jeu. Quand au gain moyen de cette carte sur l’ancienne génération, à savoir la 9800 GTX, il est de 59 % ici. La 260 GTX reste intéressante car elle offre environ 83 % des performances de la 280 GTX dans 3 des 4 résolutions, ce qui en fait un excellent rapport performances/prix comme nous allons le voir.

Mass Effect

Portage Xbox 360 donc, Mass Effect tourne effectivement plutôt très bien sur la Radeon HD 3870 X2 donc, si ce n’est que cette dernière est incapable d’appliquer l’antialiasing demandé dans les drivers ici. Ce qui s’avère pourtant utile en 1920*1200 (mais pas en 2560*1600 puisque le jeu est alors irrémédiablement injouable). Autre avantage : ce fait n’empêche pas la 280 GTX de s’établir en tête de la hiérarchie, la 9800 GX2 n’appréciant pas ce jeu et étant pour une fois nettement dépassé (34 % en 1920*1200 + filtres, 62 % en 2560*1600). Le gain de la 280 GTX sur la 9800 GTX atteint 220 % en 1920*1200 + filtres, et ici la GeForce 260 GTX s’avère incontournable derrière sa grande sœur.

Race Driver GRID

Trop récent pour être profilé SLI (le prérequis indispensable au fonctionnement de cartes bi-GPU comme la 9800 GX2), la 9800 GX2 s’effondre en toute logique une nouvelle fois ici. Ce qui n’est certes pas très glorieux pour la victoire de la 280 GTX. Reste ses performances très bonnes, car si la 260 GTX n’est battue que d’environ 20 %, l’écart monte à 50 % par rapport à la 9800 GTX (hormis en 1920*1200 et en 2560*1600 + filtres). Plus important, les deux nouvelles cartes sont les seules à permettre d’envisager le jeu en 2560*1600 + antialiasing 4X, ce qui se révèle être un vrai bonheur pour les yeux.

BadaBOOM, Folding@Home, PhysX

BadaBOOM Media Converter est un transcodeur vidéo mis au point par Element Technologies, et dont le rôle est de convertir des DVD vidéos (MPEG2 uniquement donc) en H.264 adapté aux principaux PMP, essentiellement les iPhone, iPod et PSP (via des profils prédéfinis uniquement). Optimisé CUDA (via la plateforme vidéo RapiHD d’ETI), il tire partie de la puissance des GeForce compatibles (toutes les GeForce 8 et 9 donc) pour accélérer cette tâche très calculatoire, et qui avait été pour rappel introduite par AMD via l’AVIVO, il y a 2 ans et demi maintenant… Reste que le transcodeur d’Elemental est moins buggué et va bien plus loin au niveau de la vitesse de compression.

Encore en version preview malheureusement uniquement compatible avec le GT 200, nous avons ainsi pu compresser notre vidéo de test (de 400 Mo) au format iPhone (640*365) en qualité maximale en 56,5s sur 260 GTX et 49s sur 280 GTX (soit 15 % plus rapide). A titre de comparaison, l’encodeur H.264 de iTunes a pris 8 minutes en utilisant donc le CPU (en consommant plus au total mais nettement moins en pic)… Gardez toutefois en tête qu’il est loin d’être le compresseur H.264 le plus optimisé et que le manque de flexibilité de BadaBOOM est criant, même si le résultat n’en reste pas moins bon.

Folding@Home

Nous avons également eu accès à un client pre-beta (6.12 beta 1) de Folding@Home utilisant CUDA et dont la version finale devrait être disponible d’ici quelques jours, mais qui était là aussi malheureusement limité aux GeForce GT 200.

La encore, NVIDIA a plus d’un an de retard sur ATI dont les Radeon participent au projet, mais là encore les GeForce 200 (à défaut de pouvoir tester les autres) obtiennent des performances supérieures actuellement. Voici celles que nous avons obtenues en PPD (soit le temps ’frame’, une frame étant 1 % d’une WU), et que nous comparons aux valeurs moyennes obtenues avec les autres cartes/CPU (un grand merci à toTOW) :

Les nouvelles GeForce 200 GTX parviennent donc là aussi à établir un nouveau record, mais il faut noter que l’écart avec une 9800 GTX reste faible.

Ce qu’il faut bien comprendre par ailleurs, c’est que les performances peuvent facilement varier suivant l’optimisation du client pour telle ou telle architecture (les optimisations du code étant loin d’être finies dans le cas des clients ATI et NVIDIA). Ces scores vont donc aller en s’améliorant, et plus pour certains que pour d’autres. Autre problème : avec le changement de WU, obligatoire dans le cas du client GeForce, les performances évoluent également. Bref, on ne saurait à l’heure actuelle trop souligner le caractère aléatoire et temporaire des précédents résultats. Ce qui est certain c’est que l’arrivée d’un client supportant les GeForce compatibles CUDA (soit toutes celles depuis la GeForce 8, y compris en entrée de gamme) est une opportunité pour le projet puisque la base installée représente donc environ 7 000 TFlops, dont l’écrasante majorité appartient pour rappel à la team PPC qui n’attend que vous ! Pour nous rejoindre rien de plus simple, configurez votre client avec les paramètres suivant :

- Username : [PPC]_votrepseudo

- Teamnumber : 51

PhysX

N’oublions pas enfin que CUDA a permis l’élaboration d’un driver (disponible dans les prochains jours) rendant toutes les GeForce compatibles CUDA capables de supporter de façon matériel l’API PhysX (comme le PPU donc). Les possesseurs d’Unreal Tournament 3 pourront donc bénéficier de nouveaux effets physiques dans ce jeu, mais également de ceux à venir.

SPECViewPerf 10

Les GeForce et autres Radeon ne sont certes pas les cartes appropriées pour exécuter les logiciels 3D professionnels, mais vu le coût de ces dernières et ce qui se passe en pratique chez les étudiants notamment, nous avons par curiosité lancé le fameux SPECViewPerf 10. SPECViewPerf reste le benchmark de référence pour les applications 3D professionnelles, regroupant les principaux logiciels dédiés. Voici les résultats, obtenus en 1280*1024 sous Windows XP.

Evidemment limités par le driver plus qu’autre chose sur ces cartes, les résultats montrent que la 280 GTX fait soit jeu égal, soit moins bien qu’une simple 9800 GTX et presque toujours moins bien qu’une Radeon HD 3870 X2…

Consommation

1400 millions de transistors gravés en 65 nm : voilà de quoi faire peur pour la consommation de la carte. Voyons donc les variations de la consommation de l’alimentation (qui incluent donc la consommation de toute la configuration ainsi que les 20 % de pertes de l’alimentation).

Premier constat : dans les jeux, la consommation des nouvelles cartes est certes élevée mais ne bât pas de nouveaux records. Ainsi la 280 GTX engendre une consommation similaire à la 8800 Ultra et inférieure à la 9800 GX2. Et si elle est supérieure à la 3870 X2, c’est uniquement parce que cette carte est sous-exploitée sous ce jeu : à titre indicatif, sous Fillrate Tester nous avons relevé des pics de consommation bien plus élevés : 404 W pour la 3870X2, contre seulement 340 W pour la 280 GTX, et a 279 W pour la 9800 GTX. Quand à la 260 GTX, elle excède à peine la 9800 GTX ce qui est une bonne nouvelle. Au niveau de la consommation maximale des cartes, NVIDIA parle de 236 W pour la 280 GTX seule et 182 W pour la 260 GTX.

En revanche, NVIDIA a beaucoup insisté sur la consommation au repos : les cartes sont équipées de puces monitorant le taux d’occupation des GPU à chaque instant, et en fonction de ces informations le driver ajuste automatiquement la fréquence, la tension et l’activité de chaque partie de la puce. Force est de constater que les GT 200 sont particulièrement impressionnantes, parvenant à complètement refaire le retard historique des puces NVIDIA sur AMD ces derniers temps, et plus encore : la GTX 260 engendre une baisse de la consommation de l’alimentation de 20 W par rapport à la 9800 GTX, et la 280 GTX consomme elle aussi nettement moins. Soit environ 25 W à elle seule en 2D (les fréquences sont abaissées à 300 MHz pour le GPU et 100 MHz pour la mémoire !), et environ 35 W en lecture blu-ray : c’est excellent, et cela annule quasiment tout l’intérêt de l’HybridPower, contraignant à devoir changer de carte mère pour pouvoir désactiver complètement la carte 3D, et à perdre un peu en performances par ailleurs dans les jeux !

Bruit

Consommant très peu au repos et beaucoup mais pas excessivement en charge, nous étions donc relativement confiant sur le fait que NVIDIA allait pouvoir maintenir avec son GT200 sa réputation de fournisseur de cartes discrètes sur le haut de gamme depuis les GeForce 7800 GTX. A tort.

Après un démarrage sous Windows durant lequel le ventilateur du GT200 reste silencieux (restant à 516 rpm soit 30 % de sa valeur maximale), celui-ci se réveille façon machine à laver dès le lancement d’un jeu, jusqu’à atteindre un niveau franchement insupportable, surtout pour la 280 GTX. La GeForce 260 GTX s’en sort légèrement mieux mais atteint elle aussi un niveau bruyant à 1250 rpm (bruit de souffle et non du ventilateur). Il faut toutefois savoir que nos relevés au repos sont pris après que tous nos benchmarks soient effectués et quelques minutes au repos. Seul problème : la 280 GTX ne revient alors jamais à son niveau minimale, et la 260 GTX, si elle s’en sort bien mieux, voit tout de même son ventilateur tourner à 700 rpm, niveau auquel nous le qualifierions de discret.

Ces résultats au repos sont difficilement compréhensibles vu la consommation du GT200 dans ce mode, et proviennent a priori soit d’un défaut du bios (constaté pourtant sur deux exemplaires) ou des pilotes, ce qui laisse envisager un progrès possible. Dans tous les cas il reste au pire possible de ralentir manuellement la vitesse du ventilateur à l’aide d’un logiciel dédié, à condition de suivre également les températures (voir page suivante). Ils restent en tout cas particulièrement décevants pour ces cartes, d’autant qu’il faut rappeler qu’elles évacuent une partie de l’air chaud au sein du boîtier et participent donc largement à l’échauffement de la température de ce dernier et donc à l’emballement du ventilateur du GPU, sans parler des autres composants…

A noter enfin que comme pour la consommation, le résultat en charge de la 3870 X2 est anormalement bon pour la même raison : Test Drive Unlimited est un des rares jeux sous lequel un seul GPU de la carte est réellement exploité, limitant l’échauffement du radiateur.

Températures, overclocking

Voyons les températures du GPU relevées (concernant la Radeon HD 3870 X2, il s’agit du GPU actif, l’autre ne dépassant pas les 56°C en charge).

Sans surprise, les 260 GTX et 280 GTX sont très bien refroidies, ayant les plus basses températures au repos et parmi les plus faibles en charge. Sans surprise car ces cartes ne sont pas celles qui consomment le plus, et disposent en revanche d’un refroidissement très agressif comme nous l’avons vu précédemment. On reste donc très loin de la valeur de 105°C, température à partir de laquelle les fréquences sont automatiquement baissées. Cela signifie également que comme nous le supposions précédemment, NVIDIA dispose visiblement d’une bonne marge pour abaisser la nuisance sonore de ses cartes, au repos comme en charge.

Overclocking

Du côté de l’overclocking, nous avons pu pousser la GeForce 260 GTX de 576/1242/999 MHz (GPU/ALU/mémoire) à 648/1397/1184 MHz, soit 12 % et 18 % respectivement. Ce qui est bon, et nous a permis sous Test Drive Unlimited de profiter d’un gain de 16 % soit 8,4 images par seconde en 2560*1600, la carte s’avérant alors seulement 6 % plus lente que la 280 GTX !

Sauf qu’évidemment, cette dernière s’overclock également. Nous avons ainsi pu passer de 602/1296/1107 MHz à 655/1410/1290 de façon entièrement stable là aussi, soit des gains de 9 % et 16 %. Test Drive Unlimited profite une nouvelle fois de cette augmentation pour permettre une hausse du framerate de 13 %, assez appréciable même si la 9800 GTX s’établissait à 16 %. Tout cela reste cependant très cohérent, surtout pour de l’overclocking qui n’est pas une science exacte.

Bilan

Que retenir au final de ces nouvelles cartes ? Tout d’abord que le parallèle avec la GeForce 7800 GTX est évident. Elles construisent sur une architecture déjà éprouvée en améliorant les quelques points faibles qui ont été identifiés et en augmentant sensiblement la puissance de calcul. Pas de mauvaise surprise du point de vue de l’architecture donc même si l’on peut regretter l’absence de support de Direct3D 10.1 ou les performances un peu décevantes en calcul flottant double précision.

En revanche, contrairement à la situation actuelle, NVIDIA n’avait alors pas encore décliné son SLI sous forme de carte bi-GPU, façon 9800 GX2. C’est le bémol de ce lancement, puisque malgré une puissance brute presque doublée (et même largement en pratique vu l’augmentation de l’efficacité, et ce même si certains benchs synthétiques ne se sont pas envolés autant qu’on pouvait espérer) par rapport à l’ancienne génération, la GTX 280 souffre de la comparaison avec la 9800 GX2 qui la devance relativement régulièrement dans les jeux. Et bien qu’il serait complètement surréaliste de lui préférer cette dernière vu sa quantité de mémoire utile deux fois plus faible ou sa consommation bien plus élevée au repos pour ne citer que deux exemples de son manque d’attractivité désormais flagrant, cela rend forcément le tableau un peu moins idyllique pour ce nouveau très haut de gamme. Pourtant, difficile de reprocher quelque chose à NVIDIA sur ce point, tant il paraît inconcevable de rajouter le moindre ALU sur sa puce gargantuesque et vu les performances de la concurrence.

Reste plusieurs autres points légèrement regrettables, le premier étant de loin la nuisance sonore très élevée et difficilement explicable de la GTX 280 comme de sa petite sœur, alors qu’a contrario leur consommation en charge reste inférieure aux cartes bi-GPU, et que celle au repos est tout simplement très faible. On ne peut par ailleurs oublier le non support de DirectX 10.1, évidemment politique et qui va retarder voir annuler son adoption par les développeurs ce qui est condamnable au vu de l’affaire Assassin’s Creed notamment. Le tarif de la GTX 280 (550 €, disponibilité prévue dès demain), habituel pour le très haut de gamme, a par ailleurs du mal à passer vu celui explosif de la « petite » GTX 260 : 18 % moins performante en moyenne que sa grande sœur, elle est pourtant affichée à un prix quasiment divisé par 2 à 309 € ! Autant dire que sa disponibilité, annoncée pour le 26 juin, risque d’être particulièrement tendue vu qu’elle embarque le même GT 200.

Impossible enfin de refermer cette conclusion sans évoquer les perspectives d’application désormais très concrètes de CUDA : alors qu’il y a 1 an et demi il était bien difficile d’associer cet élément aux points positifs de la GeForce 8, c’est désormais sans problème le cas, ne serait-ce que via les 3 premières retombées déjà ou très prochainement utilisables : le transcodeur vidéo BadaBOOM et le client beta GeForce Folding@Home, qui laissent le CPU sur place à l’heure actuelle, mais également la gestion du PhysX par les GeForce, qui a permis à beaucoup plus – certes, ce n’était pas bien dur – de développeurs d’annoncer le support de cette technologie dans leurs prochains jeux. Même s’il reste à vérifier l’apport réel que leur implémentation procurent. De quoi effectivement élargir considérablement le champ d’application des GeForce compatibles CUDA (soit depuis la GeForce 8), si la sortie des logiciels optimisés et non exclusivement professionnels se poursuit et si AMD ne parvient à faire aussi bien.

- Les plus

- Les moins

- Architecture GeForce 8 améliorée

- Performances globales

- Consommation au repos

- Logiciels accélérés CUDA

- Non support de DirectX 10.1

- Performances par rapport à la 9800 GX2

- Carte bruyante

- Prix comparé à ses concurrentes NVIDIA

Nettement plus séduisante grâce à son prix très attractif, la GTX 260 est toujours bien placée dans les jeux et reprend la plupart des points positifs de la GTX 280 sauf son prix et ce qui en découle. Si elle est réellement disponible dès la semaine prochaine pour 309 €, elle sera un best-seller.

Nettement plus séduisante grâce à son prix très attractif, la GTX 260 est toujours bien placée dans les jeux et reprend la plupart des points positifs de la GTX 280 sauf son prix et ce qui en découle. Si elle est réellement disponible dès la semaine prochaine pour 309 €, elle sera un best-seller.- Les plus

- Les moins

- Architecture GeForce 8 améliorée

- Performances seulement 18 % inférieures à la GTX 280

- Consommation au repos

- Logiciels accélérés CUDA

- Non support de DirectX 10.1

- Carte bruyante

Récapitulatif des performances

Voici les moyennes obtenues pour chaque carte et chaque jeu. Les cartes n’arrivant pas à rendre un jeu dans une résolution donnée ou avec antialiasing ont obtenue un zéro, ce qui handicape lourdement toutes les cartes réellement dotées de 512 Mo de mémoire ou moins en 2560*1600 + antialiasing, ainsi que la Radeon HD 3870 X2 qui ne peut appliquer d’antialiasing sous Mass Effect.