Introduction

Les cartes graphiques récentes étant particulièrement complexes, leurs performances sont parfois sujettes à de mauvaises interprétations. Après un premier article disponible ici, nous continuons à déboulonner les mythes aujourd’hui.

Les cartes graphiques récentes étant particulièrement complexes, leurs performances sont parfois sujettes à de mauvaises interprétations. Après un premier article disponible ici, nous continuons à déboulonner les mythes aujourd’hui.

Pour résumer ce qui a été abordé lors du premier article, nous avons :

- Présenté de la notion d’enveloppe de performances

- Expliqué le fonctionnement assez complexe de la V-sync ainsi que des cas dans lesquels il est conseillé/déconseillé de l’activer.

- Observé non sans surprise la quantité de mémoire vidéo consommée par Windows 8.1 (et Windows 7 avec aero)

- Abordé les temps de réaction, l’input lag, les différentes variables qui influent sur l’input lag ainsi que les cas pour lesquels l’input lag pose vraiment problème.

- Analysé l’utilisation de la mémoire vidéo ainsi que les prérequis en la matière, afin d’avoir les éléments nécessaires pour que chacun puisse faire son choix

- Expliqué la gestion thermique des cartes graphiques récentes et abordé la notion de performances à nuisances sonores constantes au travers de quelques cartes de référence

Ce deuxième article nous permet de :

- Traiter des lignes PCI Express : combien de lignes et quel débit sont nécessaires pour qu’une carte graphique récente puise délivrer les meilleures performances ?

- Expliquer pourquoi l’architecture Maxwell de NVIDIA parvient à tirer son épingle du jeu malgré une bande passante mémoire inférieure, grâce à une fonction API méconnue permettant de mesurer la bande passante de la mémoire vidéo et l’utilisation du bus PCIe.

- Aborder les questions relatives aux écrans : faut-il voir toujours plus grand ? Que valent les TV pour jouer ? Quid des différents types d’anti-aliasing ?

- Analyser les différentes connectiques numériques : DVI, HDMI et DisplayPort, ainsi que les mérites de chacun de ces standards.

- Traiter de l’ingénierie de la performance ainsi que du rapport performances/prix.

- Résumer tout cela avant d’évoquer ce qui suivra.

Les retours suscités par le premier article nous ont donné matière à réflexion, notamment sur la valeur 40 dB(A) que nous avons choisi pour les tests à nuisances sonores constantes. Certains ont apprécié, d’autres ont estimé que l’on pouvait aller plus loin dans une optique hautes performances. Par ailleurs, de nombreuses voix se sont fait entendre pour que nous ajoutions au comparatif des Radeon autres que les modèles de référence (avec un dissipateur modifié en somme).

Ces retours ne sont pas restés lettre morte : nous échangeons avec AMD sur le sujet et proposons aux OEM de nous envoyer plusieurs Radeon de manière à faire un comparatif général avec une limite acoustique prédéfinie, probablement 40 et 50 dB(A) (rappelons tout de même que l’on perçoit une valeur de 50 dB comme étant deux fois plus bruyante qu’une valeur de 40 dB).

Les tests visant à mesurer la réactivité visuelle et auditive ont eu du succès (quand bien même ils n’ont rien de scientifique).

Certains arguments valables ont été émis par rapport à l’importance de l’input lag pour les jeux streamés via Twitch ainsi que la réalité virtuelle. L’input lag a clairement une importance à ce niveau : on peut très rapidement avoir la nausée à cause d’un viseur sujet au lag !

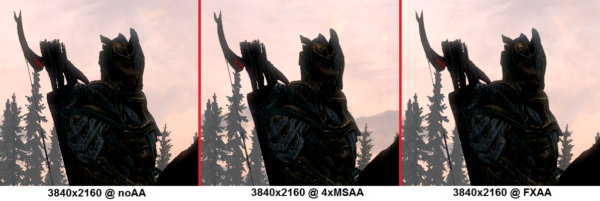

L’analyse de la quantité de mémoire vidéo nécessaire et plus particulièrement l’utilité de passer de 2 à 4 Go a soulevé des questions, tout particulièrement vis-à-vis de cartes comme les GeForce GTX 760 et 770. Comme les statistiques matérielles Steam publiées lors du premier article le démontraient, la plupart des utilisateurs ont encore 1 Go de mémoire si ce n’est moins. La généralisation des cartes embarquant 2 Go de mémoire ne fait que commencer et s’il peut s’avérer utile dans certains cas d’avoir 4 Go (imaginons par exemple un SLI de deux ou trois GTX 770 pour jouer en 4K ou en 1440p avec des textures haute résolution en pack ou mod), il est très peu probable que l’industrie considère cela comme étant la norme dans un futur prévisible. Par ailleurs, n’oublions pas que les 8 Go de mémoire que proposent Xbox One et PS4 sont partagés : seule une partie de cette mémoire est utilisable pour les graphismes, le reste étant consommé par l’OS, le code du jeu/programme et les données. En revanche, on peut effectivement avoir à sacrifier le MSAA pour du FXAA/MLAA quand on joue en haute définition (1440p et plus) avec une carte graphique 2 Go. Chacun se fera son propre avis quant au caractère acceptable ou pas de ce compromis.

Enfin, nous avons vu quelques critiques qui nous ont paru infondées, tout particulièrement par rapport au faut d’overclocker une carte tout en maintenant la vitesse de son/ses ventilateur(s) (à nuisances sonores constantes donc). Peut-être que nous n’avons pas été suffisamment clairs dans notre démarche : le but était de montrer que les performances à un certain niveau acoustique sont relativement peu affectées par l’overclocking à partir du moment où la régulation thermique rentre en jeu (une augmentation de la consommation électrique/dégagement calorifique entrainera une régulation plus sévère des fréquences). D’autre part, le concept d’enveloppe de performances nous a permis d’illustrer le fait que l’on pouvait bien souvent réaliser un meilleur overclocking au prix de nuisances sonores plus importantes – là encore, chacun se fera son propre avis sur ce compromis. Si nos intentions ont pu être mal interprétées, nous sommes désolés. Pour être clairs, nous ne recommandons absolument pas d’overclocker une carte graphique à vitesse de ventilation constante.

PCIe : le PCI express expliqué en quelques lignes

Mythe : un port PCIe au format 16x est toujours relié à 16 lignes PCI Express

En tant que standard, le PCI Express est parfois perturbant. Commençons par l’aspect physique des ports PCIe : ceux-ci sont généralement désignés 1x, 4x, 8x ou 16x. Cette nomenclature caractérise leur format physique ainsi que le nombre maximal de lignes PCIe accessibles sur un port donné.

S’il est possible de brancher une petite carte sur un port plus grand qu’elle (par exemple, une carte 1x ou 8x dans un port 16x), l’inverse est déconseillé car vous serez limité soit physiquement par le port en lui-même, et a minima par la bande passante disponible pour votre carte. A quelques rares exceptions près, les cartes graphiques sont conçues pour communiquer sur 16 lignes et nécessitent donc un port 16x. En théorie, les spécifications PCIe permettent un maximum de 32 lignes par port, mais nous n’avons jamais vu de ports dont le format dépasse 16x.

Prenons un cas courant : on branche aisément sa carte graphique dans un port au format 16x. Les données vont-elles circuler sur 16 lignes pour autant ? Ce n’est pas toujours le cas. En effet, le nombre de lignes actives pour chaque port dépend de l’architecture de la plateforme (Haswell vs Haswell-E par exemple), la présence d’éventuels ponts (comme le PEX 8747 de PLX) ainsi que le nombre de cartes branchées sur les autres ports (sachant que le la plupart des cartes mères reconfigurent le câblage des ports en fonction de leur utilisation). C’est donc ainsi qu’un port au format 16x peut fonctionner sur 16, 8, 4 ou même une seule ligne. On peut s’en assurer avec un utilitaire comme GPU-Z bien que cette méthode ne soit pas infaillible (pour minimiser les risques, toujours télécharger la dernière version du logiciel lorsque l’on change de carte graphique et utiliser le test de rendu intégré pour exercer une charge sur le GPU).

Sans aller trop loin dans les détails, une différence majeure entre le socket LGA 2011 haut de gamme (compatible avec les processeurs Ivy Bridge-E comme les Core i7-4820K, 4930K et 4960X) et le socket LGA 1150 milieu de gamme (compatible avec les CPU Haswell comme le Core i7-4770K) tient au nombre de lignes PCI Express. Le socket haut de gamme propose un maximum de 40 lignes PCIe 3.0 en natif, ce qui suffit pour deux cartes en 16x/16x, trois cartes en 16x/16x/8x ou encore quatre cartes en 16x/8x/8x/8x. De son côté, le socket LGA 1150 est limité à 16 lignes, une connectivité suffisante pour une carte en 16x, deux cartes en 8x/8x ou encore un CrossFire de trois cartes en 8x/4x/4x (NVIDIA ne permet pas d’utiliser le SLI avec les ports câblés en 4x).

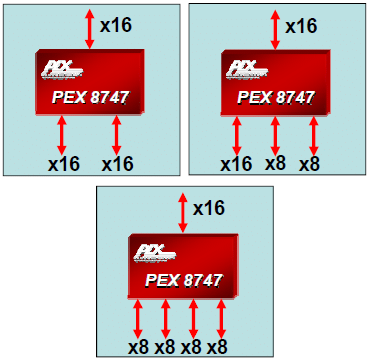

Les fabricants de cartes mères peuvent contourner la limitation de connectivité du socket LGA 1150 avec ce que l’on appelle des ponts PCI Express, c’est-à-dire des puces qui fonctionnent comme des interrupteurs et permettent d’accéder à un plus grand nombre de lignes. La référence la plus connue est le PEX 8747 de PLX, un pont PCI Express 3ème génération qui reste assez cher :plus de 130 euros chez Mouser pour de petits volumes. Bien entendu, les fabricants de cartes mères négocient des tarifs nettement moins élevés en commandant des quantités nettement plus importantes, mais cette puce reste un composant onéreux dans l’absolu : elle contribue très largement à l’écart de prix entre des cartes mères LGA 1150 aux alentours de 200 euros et les modèles haut de gamme à 300 euros et plus.

Comment ceci se traduit en termes de bande passante ?

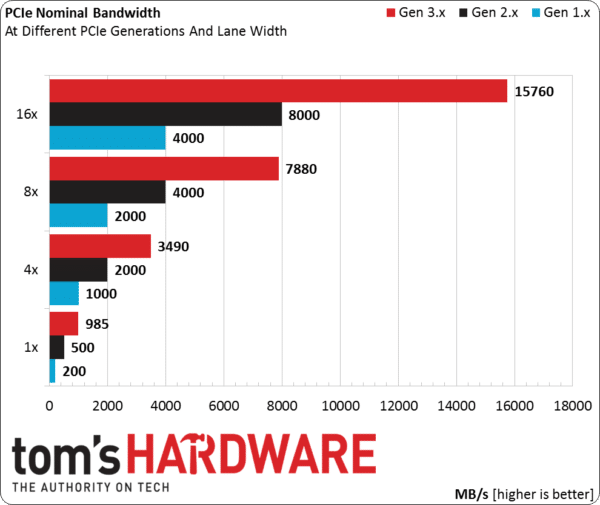

Comme on le voit ci-dessus, chaque génération PCIe permet à peu près de multiplier par deux la bande passante de la précédente. Quatre lignes PCIe 3.0 équivalent à environ huit lignes PCIe 2.0 et ainsi de suite.

Prévue pour 2015, la quatrième génération maintiendra la compatibilité avec les technologies actuelles. Ceci dit, on peut s’attendre à ce que les cartes graphiques PCIe 3.0 (et 2.0) restent d’actualité un certain temps, tout du moins d’un point de vue interface. Pour les plus curieux, PCI-SIG a d’ores et déjà publié une page de questions/réponses relative au PCI Express 4.0 (en anglais) sur son site.

Voyons maintenant en pratique de quelle bande passante a-t-on vraiment besoin.

PCIe 16x et 8x sur trois générations : une bande passante de 15,75 à 2 Go/s

Mythe : le PCIe x16 (3ème génération) est essentiel pour de bonnes performances

L’UEFI de notre ASRock Z87 Extreme6 permet de changer le débit PCIe de chacun des ports, une fonctionnalité à laquelle on ne voudrait absolument pas toucher en temps normal mais qui s’avère extrêmement précieuse pour cet article.

Contrairement à l’Extreme9, l’Extreme6 n’embarque pas de puce PLX PEX 8747 et se retrouve donc limitée à 16 lignes PCIe. De plus, le câblage des ports varie automatiquement en fonction du nombre de cartes installées, passant de 16x/0x/0x à 8x/8x/0x ou 8x/4x/4x.

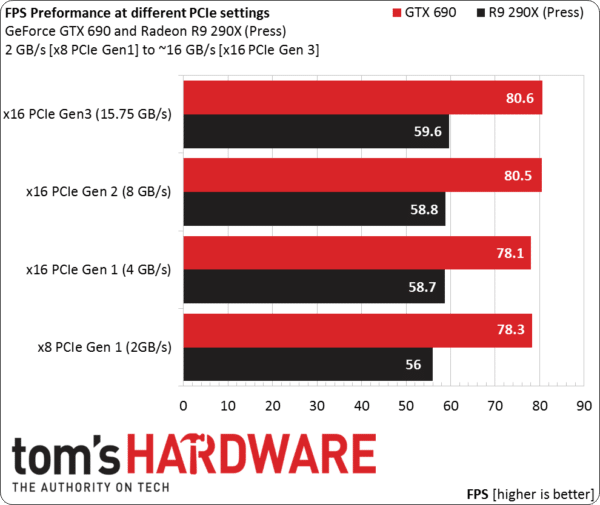

Ceci nous a donc permis de tester les débits PCIe en 8x et 16x sur trois générations avec des cartes haut de gamme AMD comme NVIDIA. Gardons cependant à l’esprit le fait que nous testons les cartes à titre individuel ici, y compris en 8x : il n’est donc pas question d’extrapoler les performances en CrossFire/SLI.

Les tests s’appuient sur le benchmark Unigine Valley 1.0. Nous avons systématiquement laissé les cartes atteindre leur seuil de régulation thermique pour ensuite commencer les tests avec des performances et températures quasi-stables. Il s’agit donc de performances parfaitement réalistes : ces cartes sont certes capables de faire mieux, mais pas dans la durée, à moins de sortir d’un cadre d’utilisation normal.

Comme on le voit ci-dessus, la GeForce GTX 690 ne gagne que 2,9 % de performances supplémentaires en passant d’un port PCIe 8x 1ère génération à un port PCIe 16x 3ème génération, tandis que la Radeon R9 290X (version presse) profite plus du changement avec un gain de 6,4 %. Dans les deux cas, les cartes ne sont pas significativement bridées sous Unigine Valley 1.0 par une bande passante de 2 Go/s (PCIe 8x 1ère gen.) : on a beau passer à une bande passante de 15,75 Go/s (PCIe 16x 3ème gen.), les performances n’augmentent pas significativement.

Rappelons que nous ne testons pas ici un cas de figure extrême avec trois ou quatre cartes en SLI/CrossFire. Ceci étant dit, au vu de la bande passante utilisée, nous sommes prêts à parier qu’il n’y aurait pas de gain de performance significatif au-delà d’une liaison PCIe 2.0 8x : libre à chacun de nous prouver le contraire dans les commentaires !

A ce stade, on peut conclure que les cartes graphiques haut de gamme ne sont pas très gourmandes en bande passante PCIe, y compris les modèles haut de gamme comme la GeForce GTX 690 ou la Radeon R9 290X. Peu importe que l’on utilise du PCIe 2.0 ou 3.0, une liaison 8x ou 16x avec une seule carte graphique : les performances ne s’en ressentent presque pas. Bien entendu, on aura tout intérêt à utiliser un port PCIe 3.0 16x dans la mesure du possible, mais il ne faut pas s’attendre à voir les performances bondir pour autant. Par extension, l’achat d’une carte mère ou d’un processeur prenant en charge le PCIe 3.0 n’est pas justifiable par la seule bande passante PCIe lorsque l’on n’utilise qu’une seule carte graphique.

NVAPI : mesurer facilement la mémoire graphique utilisée

Par l’intermédiaire de ses pilotes, NVIDIA propose une interface de programmation (« NVAPI ») qui permet entre autres de recueillir des mesures de performance. Voici les informations techniques que l’on peut lire dans le fichier nvapi.h

FUNCTION NAME: NvAPI_GPU_GetDynamicPstatesInfoEx

DESCRIPTION: This API retrieves the NV_GPU_DYNAMIC_PSTATES_INFO_EX structure for the specified physical GPU. Each domain’s info is indexed in the array. For example:

– pDynamicPstatesInfo->utilization[NVAPI_GPU_UTILIZATION_DOMAIN_GPU] holds the info for the GPU domain. There are currently four domains for which GPU utilization and dynamic P-state thresholds can be retrieved: graphic engine (GPU), frame buffer (FB), video engine (VID), and bus interface (BUS).

Au-delà de cette description, la fonctionnalité spécifique de l’API n’est pas documentée. Les informations qui suivent constituent donc la meilleure interprétation que l’on puisse proposer de son fonctionnement, tout en insistant sur le fait que cette interprétation repose essentiellement sur des conjectures.

- L’indicateur graphic engine (GPU) est censé représenter le goulet d’étranglement dans la plupart des jeux. Si cette mesure n’est pas à 100 % ou proche de cette valeur, alors c’est un autre composant qui limite les performances (CPU ou mémoire).

- L’indicateur frame buffer (FB) est intéressant, pourvu qu’il fonctionne comme prévu à la base. Vu son nom, on pourrait croire qu’il mesure la quantité de mémoire graphique utilisée (en pourcentage), mais ce n’est pas le cas : il semble plutôt refléter le taux d’occupation du contrôleur mémoire. Si tel est le cas, cet indicateur mesurerait donc la bande passante réellement utilisée par le contrôleur, information à laquelle on ne peut pas accéder autrement quelle que soit la méthode.

- A contrario, l’indicateur video engine (VID) nous intéresse beaucoup moins : ce dernier n’est généralement pas sollicité en jeu, ce qui se traduit par un indicateur nul. On peut voir une augmentation, mais à condition d’encoder des vidéos via Shadowplay ou encore de faire du streaming depuis un PC vers la Shield Tablet/Shield Portable.

- Enfin, l’indicateur bus interface (BUS) illustre l’utilisation du contrôleur PCIe, là encore exprimée en pourcentage. Précisons que l’on retrouve une mesure correspondante sous EVGA PrecisionX/MSI Afterburner sous le nom « GPU BUS Usage ».

Nous avons contacté NVIDIA pour avoir quelques explications sur le fonctionnement détaillé de NVAPI. La firme au caméléon nous a confirmé que l’indicateur FB représentait bien l’utilisation de la bande passante en mémoire vidéo, avant de nous dire que l’indicateur BUS était « considéré comme pas fiable et donc pas utilisé en interne »

Bien entendu, nous avons également interrogé AMD pour savoir s’il existait une API ou fonction permettant les mêmes mesures sur les Radeon. Les représentants de la marque sont revenus vers nous après vérification avec une réponse négative. En conséquence, il a malheureusement été impossible de conduire les mêmes tests sur les Radeon et ce malgré notre volonté.

De la théorie à la pratique …

Mythe : il est impossible de mesurer directement l’utilisation du bus PCIe, tout comme la bande passante en mémoire vidéo

La quantité de données échangées entre la carte graphique et le processeur puis en sens inverse est énorme, d’où la nécessité d’avoir des contrôleurs mémoire élaborés et capables de fournir une bande passante à la mesure du besoin. Dans le cas de la Radeon R9 290X, on parle de 320 Go/s, tandis que la GeForce GTX 780 Ti est donnée à 336 Go/s en pointe. En comparaison, le débit PCIe est nettement moins impressionnant (15,75 Go pour une liaison sur 16 lignes en révision 3.0), mais il est vrai que les besoins sont beaucoup plus modestes. Ceci étant dit, le but est de savoir précisément quelle quantité de bande passante mémoire est utilisée à un moment donné. Existe-t-il un goulet d’étranglement potentiel à ce niveau ? Jusqu’ici, il était difficile de répondre à ces questions, mais le couple Kepler & NVAPI permet d’obtenir des informations précises, en théorie tout du moins.

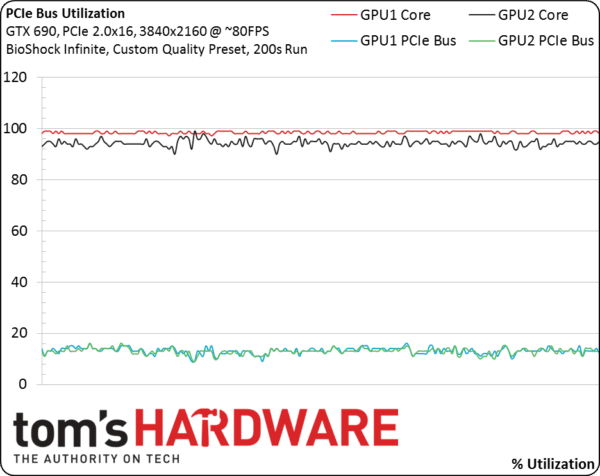

Nous avons commencé par observer l’indicateur BUS sur une GeForce GTX 690 : bien que NVIDIA nous ait alertés sur le manque de fiabilité de cet indicateur, nous avons voulu voir par nous-mêmes ce que l’on on pouvait en tirer. Hélas, un autre problème s’est posé : la GTX 690 est constitué d’une paire de GK104 qui ne sont pas directement reliés au bus PCIe mais à un pont PLX PEX 8747. En conséquence, peu importe la révision ou le nombre de lignes PCIe utilisée par la carte mère, les GPU de cette GeForce fonctionnent toujours avec des signaux PCI Express 3.0 à moins de minimiser la consommation au repos. C’est pour cela que GPU-Z rapporte un bus PCIe 3.0 quand bien même on utilise la GTX 690 sur une carte mère limitée au PCI Express 2.0. Le pont PEX 8747 s’occupe de réguler les débits pour les faire correspondre à la norme PCIe 2.0 du côté de la carte mère.

Le bus de chaque GPU fonctionnant en PCIe 3.0 sur 16 lignes, l’utilisation à 100 % devrait correspondre à un débit de 15,75 Go/s. Ceci étant dit, cette information ne nous avance pas à grand-chose à elle seule. Il est impossible de quantifier la part du débit allant vers le PC et celle qui concerne les échanges entre les deux GPU (le pont PLX ne nous permet pas non plus d’accéder à des données plus fines). A ce stade, on se retrouve donc avec un cas de figure extrême : l’intégralité du trafic pour chaque GPU provient de la configuration hôte, il n’y a pas de multidiffusion.

Passé cette explication, observons le graphique ci-dessus : ce dernier représente une boucle de 200 secondes sous BioShock: Infinite avec des réglages graphiques personnalisés en 3840x2160pour une moyenne de 80 ips. L’utilisation du bus PCIe se situe aux alentours des 15 % pour chacun des GK104. Même dans le pire des cas de figure décrit plus haut, on utilise environ 30 % du débit proposé par 16 lignes PCIe 3.0 ou encore ~60 % du débit de 16 lignes PCIe 2.0. Il faut insister sur le fait qu’il s’agit pourtant de conditions de tests assez brutales puisque ce ne sont pas moins de 663,6 millions de pixels qui sont rendus chaque seconde (3840×2160 * 60 ips) sur une carte contenant deux GPU en SLI sur un même pcb. A titre de comparaison, un débit de 60 ips en 1920×1080 correspond à 124,4 millions de pixels par seconde.

Vu les limites de la GTX 690, passons à des modèles plus dociles et plus accessibles pour ce test, à savoir la GTX 750 Ti et la GTX 650 Ti qu’elle a remplacée. Les sept graphiques qui suivent représentent beaucoup de données à digérer, mais il faut vraiment les considérer dans leur ensemble.

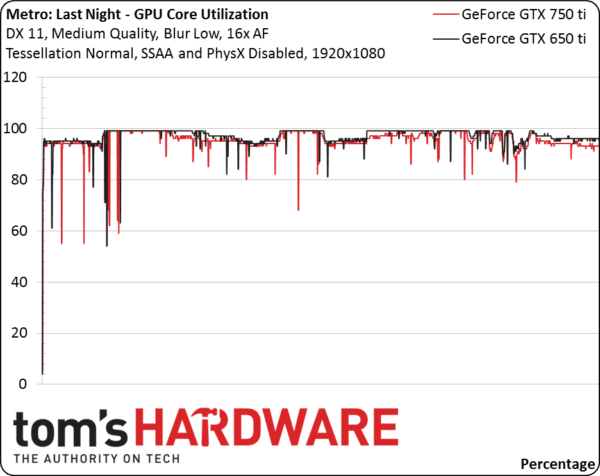

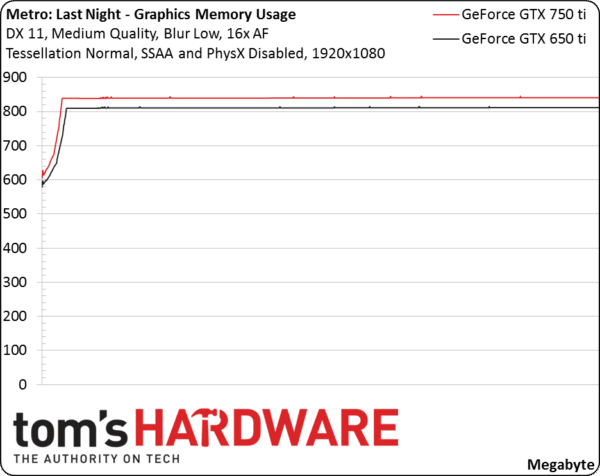

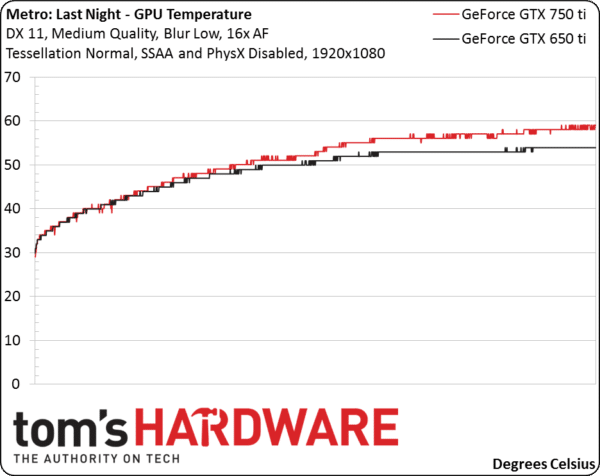

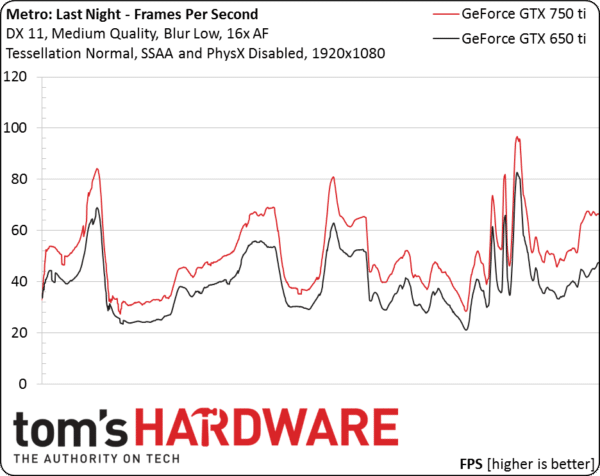

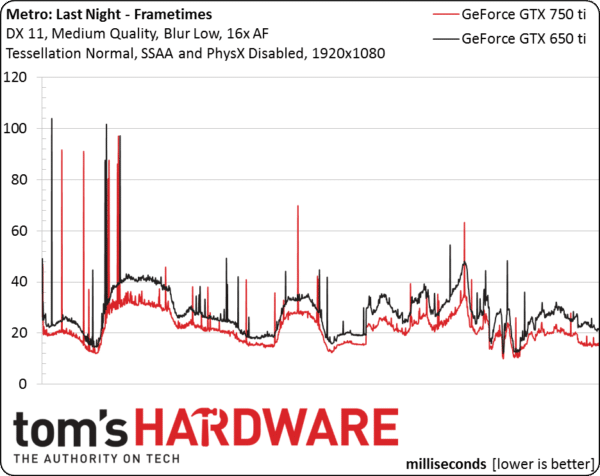

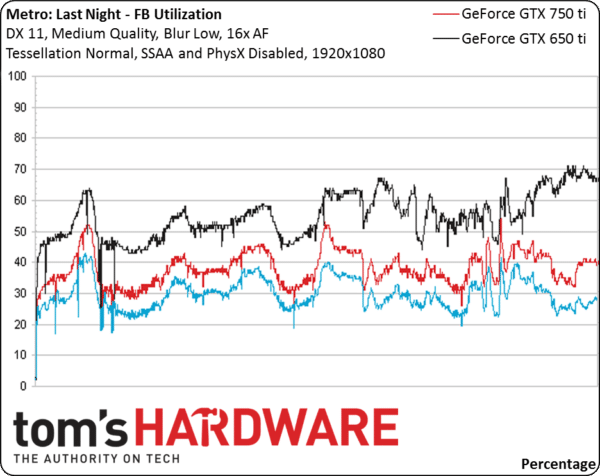

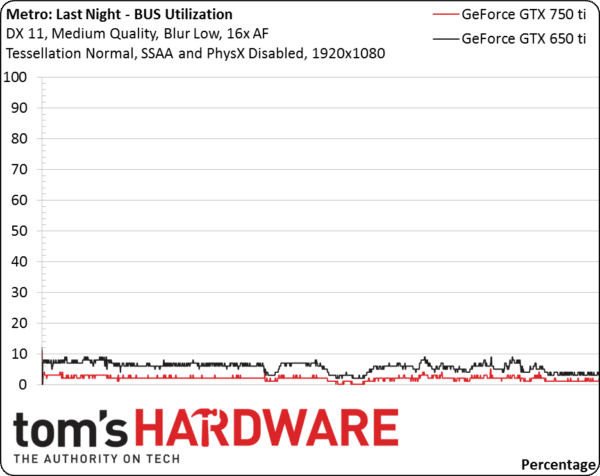

On y voit systématiquement les deux cartes utilisées dans la même configuration sous Metro : Last Light, avec dans l’ordre : l’utilisation du GPU (%), la consommation de mémoire graphique (Mo), la température GPU (°C), le nombre d’images par seconde, la variance interimages (millisecondes), l’utilisation du « FB »(%) et enfin l’utilisation du « BUS ». Précisons que nous avons délibérément omis les fréquences GPU et mémoire puisque celles-ci se sont stabilisées au maximum (valeurs GPU Boost) sur les deux cartes.

Le taux d’utilisation GPU nous montre que le principal goulet d’étranglement ce situe à ce niveau sur les deux cartes : près de 100 % la plupart du temps, ce qui est tout à fait normal et logique.

La consommation en mémoire vidéo semble stable, systématiquement sous le seuil d’un Go, quantité qui correspond justement à ce que propose la GTX 650 Ti.

En toute logique, les GPU chauffent. Ceci étant dit, les températures restent assez faibles par rapport à ce que l’on peut observer sur des cartes graphiques haut de gamme.

Au niveau du débit d’images, la logique est une fois encore respectée puisque la GTX 750 Ti surpasse la GTX 650 Ti, mais ce n’est pas l’objet de cet article : les performances relatives en ips nous serviront comme mesure de débit pour un ajustement que nous verrons plus loin.

Les pics que l’on observe au niveau du délai d’affichage ont pour effet d’augmenter la variance interimages. Précisons que ces pics correspondent à un débit d’image plus élevé et une utilisation du GPU plus faible. On pourrait tenir ici le signe d’une limitation processeur mais dans le cas présent, elle est assez négligeable puisque l’utilisation du GPU reste aux alentours de 95 %. Si la limitation processeur était prononcée, ce pourcentage serait nettement plus faible.

Voici une des nouvelles mesures de performances accessibles grâce aux requêtes NVAPI : l’utilisation du frame buffer (FB). Exprimé en pourcentage, cet indicateur porte mal son nom puisqu’il représente en fait le taux d’utilisation du contrôleur mémoire de chaque GPU dans le temps et par ricochet, la consommation en bande passante.

Nous n’avons pas choisi ces deux cartes graphiques au hasard : toutes deux proposent la même interface 128 bits ainsi qu’une fréquence de 1350 MHz pour un débit maximal de 84,6 Go/s. A débit égal (en ips), leur utilisation en bande passante devrait donc être directement comparable. Ceci dit, les deux cartes n’affichent pas les mêmes performances : comme on l’a vu plus haut, la GTX 750 Ti propose un débit d’images plus élevé. L’indicateur est donc normalisé pour cette dernière en fonction des performances de la GTX 650 Ti, ce qui se traduit concrètement par la ligne bleue sur le graphique.

Les résultats sont impressionnants : un GPU Maxwell semble proposer 25 % d’ips en plus par rapport à un GPU Kepler dans la même tranche tarifaire, tout en diminuant la consommation en bande passante d’environ 33 %. Pour dire les choses autrement sur la base des performances par image, les besoins de la GTX 750 Ti en bande passante mémoire sont divisés par deux par rapport à ceux de la GTX 650 Ti sur le benchmark de Metro: Last Light.

Ce fait pourrait avoir des implications conséquentes pour les GTX 980 et 970 : la surface dédiée à l’interface mémoire est susceptible d’être réduite en faveur de celle dédiée aux SMM (bloc contenant unités de calcul et unités de texturing), permettant ainsi d’apporter un surplus de performances ou de réduire la taille du die et donc des coûts de fabrication.

Le dernier graphique de cette page a un double intérêt : il montre directement (par rapport à l’approche indirecte via les mesures d’ips) et pour la première fois à quel point les besoins en bande passante PCIe des cartes graphiques récentes sont faibles (sous réserve que ces mesures soient pertinentes, sachant que NVIDIA ne les considère pas comme étant fiables). Pour remettre les choses en perspectives, le PCI Express 2.0 nous a permis d’arriver à un débit bidirectionnel de 8 Go/s sur 16 lignes : les deux cartes consomment à peine 10 % de cette capacité en se maintenant systématiquement sous 0,8 Go/s. Dans le cas d’une seule carte graphique sur une carte mère Haswell, on parle alors d’à peine 5 % de la bande passante PCIe disponible.

Conclusions relatives à la bande passante pour la mémoire vidéo

Nos tests confirment deux points :

- La consommation en mémoire vidéo propre à l’architecture Maxwell est extrêmement impressionnante : les besoins sont essentiellement divisés par deux par rapport à la précédente génération. NVIDIA nous a d’ailleurs confirmé a posteriori que cette conclusion était juste.

- L’énorme réduction des besoins en bande passante mémoire a forcément des implications considérables en termes d’architecture. Comme évoqué plus tôt, nous nous attendons à voir arriver des contrôleurs mémoire encore plus réduits, ce qui permettrait d’ajouter des SMM grâce à la surface récupérée sur le die. L’écart en termes de rendement et performances en faveur de Maxwell par rapport à Kepler peut donc se creuser encore plus.

Quitte à nous répéter, on apprécierait le fait de pouvoir conduire des tests similaires sur les Radeon à l’avenir, mais encore faudrait-il que AMD propose des fonctionnalités semblables au niveau des Catalyst.

Téléviseurs contre moniteurs, anti-aliasing

Mythe : mon TV 120/240/480 Hz est meilleur qu’un moniteur 60 Hz pour les jeux

Mis à part les écrans 4K, presque tous les téléviseurs sont limités par une définition maximale de 1920×1080. Les moniteurs PC peuvent quant à eux aller jusqu’en 3840×2160.

A ce jour, certains moniteurs PC sont capables de fonctionner à une fréquence maximale de 144 Hz. Quand bien même les constructeurs usent d’effets marketing pour annoncer 120, 240 voire 480 Hz, les téléviseurs restent limités à 60 Hz : les hautes fréquences annoncées sont obtenues par interpolation (le procédé consiste généralement à intercaler des images noires), ce qui tend à ajouter du lag. Ceci ne pose pas de problèmes pour des émissions TV mais au-delà d’une certaine limite, nous avons déjà pu montrer que le phénomène était nuisible pour les jeux.

Par rapport aux moniteurs, l’input lag des téléviseurs peut être énorme (50, voire 75 ms). Cette valeur s’ajoute par ailleurs au lag engendré par les autres composants, ce qui finit forcément par se ressentir. Pour peu que l’on veuille vraiment jouer sur un téléviseur, il faut choisir le mode « jeux » qui tend à réduire la latence dans la majorité des cas. En parallèle, nous suggérons de désactiver le réglage 120/240/480 Hz qui n’apportera rien aux jeux, bien au contraire. Le but ici n’est pas de dire que tous les téléviseurs sont inadaptés aux jeux, certains étant même capables de parvenir à de bons résultats dans ce domaine. Cependant, le rapport performances/prix plaide généralement en faveur des moniteurs PC à moins de vouloir en premier lieur regarder des films/programmes TV et/ou ne pas avoir le budget ou la place pour deux écrans.

Ecrans : faut-il voir toujours plus grand ?

Mythe : il faut privilégier le plus grand écran possible

S’agissant d’écrans, une mesure particulière semble prendre le pas sur toutes les autres : la taille ou plutôt la diagonale mesurée en pouces (24, 27, 30″ etc.).

Cette notion était assez juste pour les téléviseurs SD et reste encore assez pertinente pour les téléviseurs HD qui prennent des signaux dont la définition est fixée à l’avance. Cependant, on ne peut pas en dire autant des moniteurs.

Au-delà de sa taille, la première caractéristique d’un moniteur est sa définition native. Si la majorité des moniteurs dans le commerce sont maintenant en 1920×1080, la plus haute définition proposée au grand public est le 3840×2160, ce qui revient à quatre fois plus de pixels. L’image ci-dessus montre deux captures d’écran pour illustrer l’écart. Notons la mention persistante « Level Up » sur l’image de gauche : il s’agit d’un des nombreux bugs mineurs d’interface qui faut résoudre/tolérer en tant que précurseur sur le 4K.

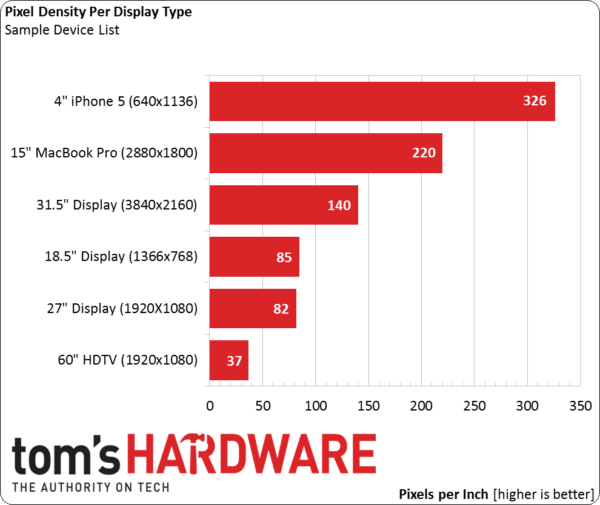

La définition d’un moniteur détermine la densité de ses pixels au regard de sa diagonale. L’essor des produits mobiles à écran de type Retina nous a donné l’occasion de voir le terme ppi (pixels par pouce) remplacé par le terme ppd (pixels par degré), mesure plus généraliste qui prend en compte la densité des pixels mais aussi la distance par rapport aux yeux. Ceci étant dit, la distance entre utilisateur et moniteur est relativement constante, raison pour laquelle nous continuons à parler en ppi.

Il y a un peu plus de quatre ans, Steve Jobs déclarait qu’une densité de 300 ppi constitue une sorte de valeur magique pour les appareils utilisés à 25-30 cm des yeux, ce qui a provoqué de nombreux débats. Le fait est que cette affirmation tient encore debout, au point d’être la valeur généralement considérée comme référence pour les écrans à haute définition.

Comme on le voit ci-dessus, les moniteurs ont encore un long chemin à parcourir pour ce qui est de la densité des pixels. Quoi qu’il en soit, on devrait presque systématiquement privilégier la définition sur la diagonale entre deux moniteurs aux qualités égales par ailleurs, à moins d’être plus loin de son moniteur que la normale.

Avantages et inconvénients des définitions plus élevées

Définition en hausse = plus de pixels à l’écran. Si l’augmentation du nombre de pixels se traduit généralement par une image plus nette, elle augmente aussi la charge sur le GPU. Il est donc assez courant de changer de carte graphique quand on change d’écran pour maintenir le débit d’images ou à défaut, s’assurer un confort de jeu suffisant.

La montée en définition a par ailleurs un autre effet bénéfique : celui de réduire le besoin de filtres anti-aliasing lourds (et gourmands). Bien qu’il reste présent et apparait clairement sous forme de vibrations/scintillements avec des scènes dynamiques, l’aliasing est nettement moins prononcé avec une définition élevée. Ceci est d’autant plus important que les ressources nécessaires à l’anti-aliasing augmentent elles aussi proportionnellement à la montée en définition.

Tous les algorithmes d’anti-aliasing ne se valent pas

Mythes : le FXAA/MLAA est supérieur au MSAA ou CSAA/EQAA/TXAA/CFAA … FXAA/MLAA et MSAA sont des alternatives

L’anti-aliasing est un autre sujet entouré de confusion, ce qui est tout à fait compréhensible vu la profusion de technologies et d’acronymes (semblables pour ne rien arranger), sans oublier le buzz marketing. De plus, certains jeux comme Rome II et BioShock: Infinite ne précisent même pas le type d’anti-aliasing implémenté.

Il existe seulement deux grandes catégories d’anti-aliasing : ceux qui s’appuient sur le multi-échantillonnage et ceux qui travaillent post-traitement. Bien que ces deux techniques visent à résoudre le même problème graphique, l’approche est très différente tout comme les compromis qu’elles engendrent. Signalons par ailleurs l’existence de techniques expérimentales qui sont rarement implémentées dans les jeux.

A l’occasion, on peut aussi croiser des techniques obsolètes (la plus connue étant le SSAA, extrêmement coûteux en ressources, qui a survécu sous le nom « ubersampling » dans The Witcher 2) ou qui n’ont pas su se faire une place (le SLI AA de NVIDIA étant un exemple). Par ailleurs, certaines sous-techniques travaillent avec des textures transparentes en MSAA. Il ne s’agit pas de catégories d’anti-aliasing distinctes mais plutôt d’adaptations du MSAA. De ce fait, nous ne les abordons pas ici.

Voici un tableau pour illustrer les deux grandes catégories d’anti-aliasing. Précisons que la classification A+/A/B a pour but de simplifier les choses, il ne s’agit pas de standards officiels.

Nom générique/tiers | Implémentation propriétaire AMD | Implémentation propriétaire NVIDIA | |

|---|---|---|---|

Classe A+ : techniques hybrides multi-échantillonnage, post-traitement et temporelles | SMAA, CMAA, plusieurs variantes du MLAA | / | TXAA (partiellement) |

Classe A : techniques basées sur le rendu (multi-échantillonnage) | MSAA (Multi-Sample Anti-Aliasing) | CFAA, EQAA | CSAA, QSAA |

Classe B : techniques post-rendu | PPAA (Post-Process Anti-Aliasing) | MLAA | FXAA |

L’avantage des techniques MSAA, surtout celles qui travaillent sur un nombre d’échantillons plus élevée, est leur propension à préserver le piqué de l’image. En comparaison, MLAA/FXAA tendent à adoucir l’image, voire à la rendre légèrement floue. Cette qualité d’image se paye toutefois très cher en termes de mémoire vidéo et de fill-rate, vu qu’il faut rendre un plus grand nombre de pixels. Nous classons donc le MSAA parmi les techniques de catégories A.

Pour dire les choses plus simplement, les techniques d’anti-aliasing classe A traitent des pixels supplémentaires (par rapport à la définition de l’écran). Le nombre d’échantillons est exprimé sous forme de multiplicateur, comme par exemple MSAA 4x. Plus ce chiffre est élevé, meilleure est la qualité d’image. Encore faut-il avoir assez de mémoire vidéo et un débit d’image suffisant.

Les techniques de catégorie B sont quant à elles appliquées après rendu d’une scène en raster. Elles n’utilisent presque pas de mémoire vidéo (cf. notre précédent article) et s’avèrent beaucoup plus rapides que les techniques de catégorie A, c’est-à-dire nettement moins coûteuses en termes de débit d’images. A partir du moment où l’on arrive à faire tourner un jeu sur sa configuration sans anti-aliasing, la seule activation d’un de ces algorithmes est presque toujours possible et se traduit par une amélioration visuelle. Voilà pourquoi nous qualifions SMAA/MLAA/FXAA de techniques d’anti-aliasing de catégorie B. Précisons que ces dernières ne travaillent pas sur des échantillonnages supplémentaires : il n’y a pas de FXAA 2x ou MLAA 4x par exemple. En clair, ces techniques sont soit actives, soit désactivées.

Comme on peut le voir, AMD comme NVIDIA implémentent MSAA et FXAA/MLAA de manière propriétaire. S’il peut y avoir de légères variations dans la qualité d’image, les principales catégories d’anti-aliasing n’en sont pas modifiées pour autant. Il faut simplement garder à l’esprit le fait que le MLAA d’AMD est un peu plus coûteux mais aussi légèrement meilleur que le FXAA de NVIDIA. De plus, le MLAA induit une consommation supplémentaire en mémoire vidéo (cf. les benchmarks de Rome II dans notre précédent article), ce qui n’est pas le cas du FXAA.

A nos yeux, le MSAA en 4K est un luxe tout à fait dispensable : il nous semble plus important de privilégier la fluidité des jeux, ce qui n’est pas toujours évident en 3840×2160. De plus, FXAA et MLAA nous semblent suffisamment bons en 4K pour ne pas aller plus loin. Plus globalement, là où le MSAA est presque une nécessité dans des définitions plus faibles pour avoir un rendu optimal, son apport est de plus en plus subjectif au fur et à mesure que l’on monte en définition.

Choisir entre fréquence de rafraîchissement élevée et faible latence ou meilleure fidélité des couleurs et angles de visions plus larges

Les dalles de grande taille tendent à être proposées selon deux catégories : les TN, généralement plus réactives mais souffrent d’une moins bonne reproduction des couleurs et d’angles de vue limitée, et les IPS moins réactives, mais un cran au-dessus en termes de fidélité des couleurs et angles de vue.

Bien que nous ayons à la rédaction plusieurs écrans IPS que nous apprécions tout particulièrement, les moniteurs TN sont généralement préférables pour jouer, si possible avec une fréquence de 120/144 Hz ainsi qu’un temps de réponse gris à gris d’1 ou 2 ms. Les écrans orientés joueurs capables de dépasser les 60 Hz procurent un ressenti plus fluide, sont moins sujets au lag et proposent assez souvent des réglages encore plus avancés. Une des fonctionnalités que l’on aimerait voir décoller en 2015 est G-Sync, ainsi que l’alternative d’AMD, FreeSync.

Pour des raisons que nous détaillons sur la page suivante, il n’existe pas à ce jour de dalles 4K (2160p) proposant une fréquence de 120 Hz et ce constat n’est pas prêt de changer. Il nous semble que les écrans orientés jeux devraient rester à une définition de 1080p ou 1440p pendant quelques années. Par ailleurs, les écrans IPS 120 Hz sont rarissimes. Certes, quelques moniteurs coréens proposent un overclocking permettant parfois d’atteindre cette fréquence, mais le résultat n’est pas garanti et les temps de réponse ne sont pas au niveau des meilleurs écrans TN de toute manière.

A ce jour, les moniteurs 1080p constituent encore le meilleur rapport performances/prix. L’Asus PG278Q ROG Swift propose 70 % de pixels supplémentaires, mais à 700 euros environ, la facture est salée. En 1080p, les moniteurs haut de gamme (120/144 Hz) se trouvent à partir de 250 euros environ. Valeur sûre, l’Asus VG248QE est disponible à 266 euros. Parmi les alternatives, citons les BenQ XL2420Z/XL2720T ou encore le Philips 242G5DJEB.

Avec un budget plus serré, il faut faire une croix sur les 120 Hz. La situation n’est pas désespérée pour autant sachant qu’il existe pléthore de moniteurs réactifs en 60 Hz 1080p avec un ticket d’entrée situé aux alentours de 100 €. Proposé à 134,42 €, le Iiyama Prolite E2483HS-B1 fait partie des valeurs sûres.

DVI, DislplayPort, HDMI : tous numériques, mais pas égaux

Les cartes graphiques récentes tendent à proposer trois types de connecteurs vidéo : DVI, DisplayPort et HDMI. Quelles sont les différences ? Quel connecteur doit-on privilégier ?

Mythe : tous les connecteurs numériques se valent

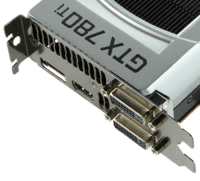

La GeForce GTX 780 Ti que l’on voit ci-dessus propose quatre sorties vidéo : de gauche à droite, DisplayPort, HDMI, DVI-D dual-link (haut) et DVI-I dual-link (bas).

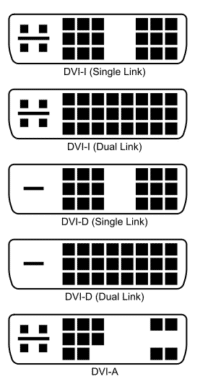

Le DVI ou les premiers pas vers un monde (plus) numérique

Lancé en 1999 pour remplacer le VGA (interface analogique), le DVI a bien accompli sa mission. Il se décline en plusieurs variantes : le DVI-A est exclusivement analogique, le DVI-D est exclusivement numérique tandis que le DVI-I propose une interface numérique + analogique intégrée. Pour compliquer un peu plus les choses, il faut savoir que DVI-D et DVI-I peuvent être proposés en single-link ou en dual-link.

La plupart des cartes graphiques récentes ont des interfaces dual-link (l’image ci-contre permet de s’en assurer). Attention aux câbles DVI single-link ! La seule chose qui les distingue visuellement des câbles dual-link est la disposition des broches : quelle que soit la variante, on voit toujours un espace entre les deux blocs de neuf broches sur les câbles single-link. L’utilisation de ces derniers peut limiter la définition maximale d’une configuration.

Le DVI reste probablement le connecteur le plus courant pour les PC, mais il accuse son âge et sera considéré comme obsolète dès 2015. Contrairement aux alternatives plus récentes, le DVI ne peut pas véhiculer un signal audio (bien qu’une variante embarquant l’USB et donc le son ait été créée). Par ailleurs, le format DVI est celui qui nécessite le plus gros connecteur.

TV HD : l’avènement du HDMI

Le HDMI a grandement facilité les choses sur les téléviseurs HD grâce à sa capacité à véhiculer son et image. Décliné en plusieurs tailles, il a par ailleurs simplifié les choses en évitant les configurations I/A/D et concepts single-link/dual-link inhérents au DVI.

Le principal désavantage du HDMI tient au fait qu’il s’agit d’un standard propriétaire, lequel induit donc des coûts de licence. Chaque fabricant de câbles HDMI doit payer des frais fixes ainsi que des royalties en fonction du volume. Notons que la présence du logo HDMI permet de faire baisser ces coûts de licence, d’où le fait qu’on le retrouve de manière évidente sur bon nombre d’emballages.

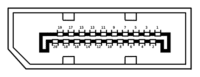

DisplayPort : liberté (pas de royalties) et fonctionnalités avancées

Lorsque le DVI a commencé à accuser son âge vers 2005, la VESA (Video Electronics Standards Association) a conçu un nouveau standard amélioré pour le remplacer, ce qui a donné lieu à l’arrivée du DisplayPort en 2006. Tout comme le HDMI, le DisplayPort peut transporter des signaux vidéo et audio en simultané. De plus, la version 1.3 sortie cette année est celle qui propose la meilleure bande passante (32,4 Go/s max. théorique pour 25,92 Go/s de vidéo non compressée) de tous les connecteurs d’imagerie disponibles pour le grand public.

Précisons que le Thunderbolt d’Intel intègre PCIe, DisplayPort et courant continu en un seul câble. Ceci étant dit, le Thunderbolt se comporte comme un câble DisplayPort 1.1 pour ce qui est du signal A/V, raison pour laquelle nous ne l’abordons pas en détail. Le Thunderbolt 2, notamment implémenté sur l’Apple MacBook Pro Retina sorti fin 2013, intègre quant à lui le DisplayPort 1.2a.

L’avenir à court terme : HDMI 2.0 et DisplayPort 1.3

En décembre 2010, plusieurs acteurs majeurs comme AMD et Intel ont discuté de l’abandon des connectives DVI-I, VGA et LVDS entre 2013 et 2015 pour se concentrer sur le DisplayPort et l’HDMI. Notons que le DisplayPort 1.2 était alors considéré par ce groupe d’acteurs comme la solution d’avenir pour les moniteurs PC, tandis que le HDMI 1.4a se destinait plus aux TV HD.

Le HDMI 2.0 est officiellement sorti le 4 septembre 2013 et vu son jeune âge, il est logique que les appareils compatibles soient rares. Cette interface prend en charge le 4K à 60 Hz en natif, ainsi que d’autres fonctionnalités particulièrement intéressantes pour les téléviseurs.

Le DisplayPort 1.3 a quant à lui été officiellement annoncé le 15 septembre par la VESA. Cette nouvelle révision permet d’atteindre un débit maximal de 32,4 Go/s, à comparer avec les 18 Go/s du HDMI 2.0. Encore plus intéressant pour le jeu, le projet FreeSync de AMD a récemment été incorporé au DisplayPort 1.2 : le standard Adaptive-Sync permettant une fréquence de rafraichissement dynamique a ainsi vu le jour. Reste à voir si ce dernier sera capable de rendre G-Sync obsolète.

4K à 120 Hz ?

Mythe : on pourra bientôt jouer en 4K à 120 Hz

Pour jouer en 4K à 120 Hz, il faut passer par deux connecteurs HDMI 2.0 ou deux connecteurs DisplayPort 1.2a, ainsi qu’une carte graphique capable de gérer ces sorties. A ce jour, seules deux modèles en sont capables : les GTX 970 et 980. Vu la complexité d’une telle configuration, l’absence totale de dalles 4K capables de fonctionner à 120 Hz et la puissance graphique nécessaire pour arriver à 60 ips dans ces conditions, la possibilité de jouer en 4K à 120 Hz semble encore éloignée. Il nous semble donc que le choix entre 120 Hz en 1440p et 60 Hz en 2160p perdurera encore au moins deux ans.

Conclusion sur les connecteurs

Vu l’absence de royalties, ses fonctionnalités avancées, sa compatibilité étendue et un large soutien de l’industrie, le DisplayPort est destiné à succéder au DVI comme connecteur idéal pour les moniteurs. Le HDMI reste une alternative viable, mais cette technologie se destine plus particulièrement aux téléviseurs.

Pour ce qui est du présent, peu importe que l’on utilise du DVI, DisplayPort ou HDMI à moins d’être dans l’un des cinq cas de figure suivants :

- Vouloir jouer dans une définition supérieure à 2560×1600, auquel cas il faut passer par du DisplayPort 1.2a

- Vouloir utiliser G-Sync, ce qui pousse là aussi vers le DisplayPort 1.2a (seule connectique prise en charge)

- Vouloir connecter plusieurs écrans sur une seule et même sortie (via un hub) : ceci nécessite une configuration DisplayPort 1.2a

- Vouloir envoyer du son vers un moniteur ou un téléviseur avec le même câble que le signal vidéo, auquel cas il faut passer par du HDMI ou du DisplayPort

- Avoir besoin de la rétrocompatibilité avec des appareils VGA, cas de figure qui force à utiliser du DVI-I (ou passer par un adaptateur actif).

Technologies constructeur à valeur ajoutée : Mantle, ShadowPlay, TXAA …

Avant d’aller plus loin, il faut saluer le travail de pionnier accompli par AMD et NVIDIA pour ce qui est de repousser les limites du possible sur PC.

API de bas niveau : AMD Mantle

Mantle a été conçu pour offrir aux développeurs un contrôle plus direct des composants, suivant ainsi les pas distants de Glide. Les plus jeunes parmi nous ne saisiront pas pourquoi cette comparaison est importante, alors qu’elle l’est vraiment.

Glide a été lancé par 3dfx pour compléter et refléter de très près les capacités graphiques de sa carte graphique Voodoo. OpenGL constituait un sacré morceau pour les composants des années 1990, tandis que Glide contenait un sous-ensemble de fonctionnalités plus réduit qui était plus faciles à apprendre et à implémenter. Le principal point faible de cette API tenait à sa compatibilité exclusive avec les produits 3dfx, tout comme Mantle est (pour l’instant) spécifique aux solutions AMD.

Au fil du temps, les pilotes DirectX et OpenGL complet ont gagné en maturité, de nouveaux produits sont sortis (qui se souvient de la Riva TNT ?). Ceci a fini par sonner le glas pour Glide en tant qu’API grand public.

Mantle constitue un pari intéressant : avec des écosystèmes OpenGL et DirectX bien établis, le besoin d’une nouvelle API de bas niveau est discutable et ce malgré le fait que les développeurs la réclament si l’on en croit AMD.

A ce stade, la compatibilité Mantle reste limitée à une poignée de jeux. Le SDK est au stade beta et AMD le réserve pour l’instant à une poignée de développeurs triés sur le volet. Comme nos tests l’ont montré en juillet dernier, Mantle contribue en premier lieu à réduire les latences CPU et apporte donc les gains de performances les plus spectaculaires lorsqu’un processeur modeste est associé à une carte graphique haut de gamme.

Il nous semble que le succès de Mantle dépendra de deux facteurs essentiels :

- La facilité avec laquelle l’API se code, de manière à ce que les portables DirectX/OpenGL ne soient pas pénibles pour les développeurs

- Sa capacité à proposer des gains de performances sur les configurations haut de gamme.

TXAA : l’anti-aliasing temporel selon NVIDIA

Il arrive parfois que des idées aussi simples que brillantes passent longtemps inaperçues sans qu’aucune raison valable ne puisse l’expliquer. Pour prendre un exemple concret, il aura fallu envoyer des hommes sur la lune avant de prendre conscience du fait qu’il était vraiment judicieux d’ajouter des roulettes à une valise. MLAA et FXAA que nous avons abordés un peu plus tôt font partie de ces innovations.

Exclusivement disponible sur les GeForce et compatible avec une poignée de jeux, le TXAA constitue un autre point de vue sur l’anti-aliasing : on part du constant qu’un des effets les plus agaçants de l’aliasing se traduit par des scintillements/vibrations engendrées en mouvement. En analysant non pas une image mais une séquence, il est possible de prédire où les artéfacts vont apparaitre et de compenser en conséquence.

Le TXAA est une variation du MSAA. D’après NVIDIA, « … le TXAA combine une série d’échantillons (à l’intérieur et en dehors des pixels) aux valeurs des images précédentes … ». On peut donc s’attendre à ce que la qualité d’image soit même supérieure à celle que propose les algorithmes d’anti-aliasing de classe A, aux prix d’une consommation mémoire et de besoins en ressources graphiques plus élevés.

Sous réserve qu’elles se bonifient avec le temps, les technologies d’anti-aliasing temporel multi-échantillons pourraient être définies comme faisant partie de ce que nous appelons la classe A+. On aimerait également voir une déclinaison du MLAA/FXAA qui soit capable d’inclure l’image précédente aux calculs post-rendu : ce genre d’information supplémentaire pourrait contribuer à améliorer la qualité d’image.

G-Sync et FreeSync : fini les compris entre V-sync active/désactivée

Nous avons abordé G-Sync en détail il y a bientôt un an.

De même, nous avons déjà parlé de FreeSync qui a été ajouté au standard DisplayPort 1.2 en tant qu’amendement Adaptive-Sync. AMD a récemment annoncé sa collaboration avec MStar, Novatek et Realtek afin de produire des scalers capable de gérer la génération de moniteurs compatibles FreeSync à venir. D’après le géant de Sunnyvale, les plus récentes Radeon gèrent déjà le rafraichissement variable en jeu, le reste de l’écosystème devant commencer à se mettre en place en 2015.

Les deux rivaux méritent d’être salués : NVIDIA pour avoir innové sur ce point, et AMD pour avoir proposé un standard libre et gratuit qui puisse bénéficier au plus grand nombre.

Enfin, voici une liste de technologies propres à AMD ou NVIDIA qui méritent d’être mentionnées. Elles fonctionnent sous certaines conditions comme par exemple l’utilisation de plus d’une carte graphique ou moniteur, les environnements en 3D stéréoscopique, l’enregistrement de parties etc.

Calculs physiques exécutés par le GPU

- NVIDIA PhysX

Technologies d’affichage multi-écrans

- AMD Eyefinity

- NVIDIA (3D) Surround

Enregistrement de parties

- NVIDIA Shadowplay

Rendu coopératif

- AMD Radeon Dual Graphics

Technologies de jeu en 3D stéréoscopique

- AMD HD3D

- NVIDIA 3D Vision/3D Vision 2

Gestion de librairies de calcul

- AMD Open Compute

- NVIDIA OpenCL

Technologies de rendu multi-GPU

- AMD CrossFire

- NVIDIA Scalable Link Interface (SLI)

Ingénierie de la performance et rapport performances/prix sur la durée

Mythe : l’optimisation des performances est un art, pas une science

L’ingénierie de la performance repose intégralement sur les débits et les goulets d’étranglement. En principe, l’ajustement des performances d’un PC orienté jeux diffère des réglages effectués sur un ordinateur central (mainframe) chargé d’une tache bien précise. Ceci étant dit, le concept essentiel est le suivant : les performances d’une configuration sont limitées par le composant dont le débit est le plus faible. Dans l’hypothèse où l’on joue en haute résolution avec les réglages graphiques au maximum, le point faible sera probablement le GPU.

Il existe toutefois de rares cas où le processeur constitue le goulet d’étranglement, c’est-à-dire des calculs intenses au niveau de la physique ou de l’intelligence artificielle, ce qui est plutôt rare dans les jeux modernes. Par ailleurs, certains jeux qui ne brillent pas par leur complexité graphique peuvent afficher un débit d’image très élevé (Skyrim sans textures HD ou mod par exemple), lequel est également limité par le processeur.

La quantité de mémoire vidéo d’une carte graphique, sa bande passante mémoire, la quantité de mémoire système (DRAM), la connectivité PCIe et le trafic au niveau du bus ne limitent que rarement les performances graphiques. Les rares exceptions sont les configurations proche du minimum requis par telle version de Windows ou bien des jeux mal optimisés (X: Rebirth nous revient malheureusement à l’esprit).

Cela ne veut pas dire qu’un kit de DRAM plus rapide n’augmentera pas les performances en jeu, mais le gain procuré par l’amélioration d’un composant que l’on peut considérer comme non critique tend à être réduit voire négligeable.

A l’opposé, le fait de renouveler le(s) composant qui bride les performances tend à procurer un gain de performances nettement plus important, lequel s’approche de la linéarité : à partir du moment où la carte graphique est identifiée comme goulet d’étranglement, le fait de passer d’une carte entrée de gamme à un modèle supérieur proposant un potentiel deux fois plus important permet presque de multiplier les performances par deux.

L’optimisation d’un PC orienté jeux tient donc de la science et non pas de l’art.

Où trouver le meilleur rapport performances/prix ?

Mythe : il faut acheter le processeur le plus performant qui soit dans la limite de son budget

Les arguments relatifs à la valeur des composants sont difficilement attaquables vu leur nature éminemment subjective. Les observations qui suivent relèvent donc bien plus de l’opinion que de faits irréfutables : chacun est susceptible d’être dans une situation différente en fonction de ses besoins et de sa configuration actuelle.

Parmi tous les composants que l’on peut acheter, celui qui tend à durer le plus longtemps à nos yeux est le moniteur. Nous avons par exemple acheté un Apple Cinema Display 30 pouces en Asie il y a dix ans de cela et aujourd’hui, il reste un excellent écran secondaire malgré son âge. Nous suggérons donc de rarement changer de moniteur, mais de ne pas y aller avec le dos de la cuillère lorsque l’occasion se présente.

Pas loin des moniteurs, les hauts parleurs et casques audio figurent vers le haut de notre liste. Un équipement audio de qualité ne devient presque jamais obsolète. De plus, les composants audio tendent à garder une certaine valeur, ce qui permettra toujours d’en tirer un prix décent à la revente pour prendre mieux.

On ne soulignera jamais assez l’importance d’avoir une alimentation de qualité. Bien qu’il ne s’agisse pas du composant le plus sexy d’une configuration, une alimentation qui tourne mal peut non seulement mettre un système d’exploitation hors service mais aussi endommager d’autres composants, voire initier un incendie dans le pire des cas. De plus, les alimentations font partie des composants dont le changement est des plus chronophages lorsqu’ils commencent à montrer des signes de faiblesse. Il n’est pas nécessaire d’acheter un modèle 1000 Watts, mais il ne faut pas non plus systématiquement solliciter l’alimentation à plus de 80 % de sa capacité sous peine de nuisances sonores plus importantes, d’un rendement et d’une durée de vie en baisse.

Claviers et souris finissent loin en quatrième position. Le décès d’une MX510 après six ans d’honorables (et intenses) services a suscité une certaine émotion à la rédaction.

Les autres composants tendent à vieillir rapidement : carte mère et CPU sont rarement produits plus de deux ou trois ans, tout comme les GPU. Le stockage semble ne jamais baisser de prix (sauf cas exceptionnels). Les gains de performances en jeu dus à la DRAM sont minimes. Les routeurs Wi-Fi et autres boitiers CPL s’améliorent d’année en année. Les boitiers PC peuvent toujours être recyclés pour une configuration secondaire, mais les plus récents tendent à proposer des améliorations notables. Les ventilateurs et dissipateurs (air ou eau) étant des composants mécaniques, ils sont destinés à rendre l’âme un jour où l’autre pour être réparés ou changés.

Par ailleurs, l’innovation s’est considérablement ralentie dans le monde des processeurs. Le récent lancement de Haswell-E sur LGA 2011-v3 et celui d’Haswell sur LGA 2011 il y a bientôt un an et demi n’ont franchement pas impressionné en termes de performances ludiques.

A fréquence égale (4 GHz), même un Core i7-4770K ne propose pas de performances franchement supérieures à celles d’un Core i7-950 (pourtant sorti il y a 5 ans) avec une GTX 690 bien overclockée, comme on peut le voir avec ce comparatif sous 3DMark. Le 4770K ne parvient qu’à faire légèrement mieux sur le sous test Physics et le test combiné. Il faut pousser Haswell jusqu’à 4,6 GHz pour creuser un écart à peine égal à 1 ips sur les sous-tests graphiques comme démontré sur cet autre comparatif. En clair, il n’est pas nécessaire de changer de processeur à partir du moment où l’on possède déjà un quad core ayant cinq ans ou moins.

La donne est radicalement différente pour les GPU : l’augmentation du budget dédié à ce composant fait vraiment la différence, même si l’on finit par rencontrer un phénomène de rendement décroissant. Un mot sur les configurations SLI/CrossFire : si leur rapport performances/prix peut s’avérer très attractif sur le papier, il ne faut pas oublier que l’échelonnement des performances n’est pas toujours optimal. De plus, tous les jeux ne sont pas nécessairement compatibles avec ces technologies. En conséquence, il est plus prudent d’investir dans une seule carte haut de gamme.

Conclusion

Ce faisant, nous avons présenté deux nouveautés : le test à 40 dB(A) constants ainsi que la classification A+/A/B des différents types d’anti-aliasing (ce qui nous semble nécessaire vu la profusion de variantes disponibles de nos jours).

Les mesures et comparaisons en bande passante pour ce qui est de la mémoire vidéo sont sans précédent à notre connaissance, de même que les comparaisons entre GPU avec enveloppe thermique et réduction des fréquences tranche avec les performances brutes sans contraintes thermiques que l’on voit d’habitude.

Nous espérons avoir démystifié la liaison PCIe et sa propension à constituer un goulet d’étranglement, le fonctionnement de l’anti-aliasing, le fonctionnement de la mémoire vidéo, les différences entre les différents connecteurs A/V et la gestion thermique des cartes graphiques récentes. Toutes ces informations ont été réunies sur deux articles qui pourront être utile pour tirer le meilleur de sa configuration.

La notion de rapport performances/prix n’a pas été oubliée pour autant : nous avons opté pour une approche plus nuancée que le nombre d’ips en moyenne, les performances dans le temps ou encore la variance interimages sans omettre les variables plus délicates à quantifier comme par exemple les technologies propriétaires d’AMD et NVIDIA.

A l’avenir, nous souhaitons généraliser le test à 40 dB(A) constants pour les prochaines cartes (y compris celles proposant un dissipateur personnalisé) et ajouter un test identique à 50 dB(A). Les retours suscités par le précédent article ne sont donc pas restés lettre morte !