Introduction

Les choses ne vont pas au mieux chez AMD. Jusqu’à il y a quelques jours, son offre en matière de cartes graphique ne valait essentiellement que pour deux cartes : la Radeon HD 2900 XT, plus performante que la GeForce 8800 GTS 640 Mo pour un prix similaire (mais un bruit et une consommation nettement supérieurs en charge), et à la rigueur la Radeon HD 2600 XT pour les amateurs de Home Cinéma uniquement. Un trou béant restait présent entre ces deux cartes, mais leur positionnement tarifaire respectif était presque cohérent. Le constructeur s’apprêtait à le combler avec les Radeon HD 3850 et 3870 qu’il lance seulement aujourd’hui. Jusqu’à ce que, coup de tonnerre, son ami de toujours lui coupe l’herbe sous le pied en lançant une carte qui a surpris tout le monde, y compris nVidia : la GeForce 8800 GT 512 Mo et son rapport performances/prix exceptionnel actuellement.

La situation en devient ironique, puisque actuellement le très haut de gamme AMD se fait donc battre par une carte vendue à 250 €. Une situation qui a tendance à nous rappeler un temps que l’on croyait oublié, celui des toutes premières Radeon. Reste que le lancement précipité des GeForce 8800 GT se matérialise par une disponibilité plus que problématique de ces cartes, et qui devrait rester tendu jusqu’à janvier. Qu’est donc désormais en mesure de nous proposer AMD dans cette gamme de prix pour cette fin d’année ?

Direct3D 10.1 : incompatible ?

Avec sa nouvelle série de GPU, les Radeon HD 3800, AMD est le premier à supporter la prochaine version de Direct3D : Direct 3D 10.1 mais que nous réserve cette nouvelle révision de l’API de Microsoft ?

Incompatible ?

Lorsque les premières informations sur Direct 3D 10.1 ont commencé à filtrer cet été, certains sites web se sont fait l’écho d’une rumeur inquiétante : cette nouvelle version serait incompatible avec la précédente ! Immédiatement des réactions de colère se sont manifestées un peu partout sur la toile à la suite de cette nouvelle. Il faut dire que Microsoft récoltait un peu le retour de bâton du buzz qu’il avait généré autour de Direct 3D 10 (voir cet article). Les joueurs avaient en effet déjà du accepter que cette version ne serait pas compatible avec les précédentes et qu’elle serait définitivement liée au dernier OS de la firme de Redmond : Vista, mais Microsoft avait promis que tout cela était nécessaire pour garantir une nouvelle API future-proof. Et voilà que quelques mois plus tard on parle déjà d’une révision et que celle-ci se paierait le luxe d’être, encore une fois, incompatible. Pour beaucoup la coupe était pleine.

Oui mais voilà, comme c’est souvent le cas sur le web une montagne a été générée à partir de rien du tout car Direct3D 10.1 est tout ce qu’il y a de plus compatible avec son prédécesseur. Mais détaillons plutôt ce que l’on veut dire lorsqu’on parle de versions d’API compatibles. Jusqu’à la version 9 les différentes versions de DirectX se sont succédées et ont conservées la compatibilité descendante : lorsque vous installiez une nouvelle version de DirectX vous pouviez jouer à tous vos anciens jeux qui utilisaient les versions précédentes. De la même façon, il était possible pour un jeu de créer une interface DirectX 9 mais de s’en servir uniquement comme d’une interface DirectX 8. Cela permettait notamment aux développeurs de n’avoir qu’un seul code à maintenir pour gérer deux types de carte en réservant le support des fonctionnalités avancées aux cartes qui supportaient véritablement DirectX 9. Pour cela le programmeur avait accès à une structure lui donnant la liste détaillée des capacités réelles de la carte. A l’inverse avec Direct3D 10 cette compatibilité n’existe plus. Pour pouvoir permettre de jouer aux anciens jeux sous Vista Microsoft a intégré à son dernier OS les deux API qui cohabitent ainsi en parallèle.

De la même façon une interface Direct3D 10 ne donne pas accès aux API de la version 9, plusieurs ayant été supprimées. Si un développeur souhaite que son jeu supporte Direct3D 9 et 10 il est donc contraint de prévoir deux versions distinctes de son jeu, ce qui n’est pas vraiment différent de ce qu’il devrait faire s’il voulait supporter OpenGL et Direct3D. On parle donc d’API incompatibles dans ce cas précis.

A l’inverse il est tout à fait possible de créer une interface Direct3D10.1 sur une carte seulement Direct3D 10, la nouvelle version de l’API étant un sur ensemble strict de la précédente tout ce qui était présent dans Direct3D 10 se retrouve dans sa grande sœur. Tout ce qui est à la charge du développeur est donc de s’assurer de ne pas faire d’appel à des fonctionnalités uniquement présentes dans Direct3D 10.1 sur une carte Direct 3D 10 ce qui était déjà de son devoir dans les versions précédentes de l’API.

Car oui évidemment les GPU Direct 3D 10 déjà disponibles (G8x, G9x et R6x0) ne supportent pas les apports de la dernière API, cela semble couler de source et pourtant c’est ce point qui semble-t-il a généré une certaine confusion. A propos du support de ces GPU plus anciens justement, Microsoft avait promis la disparition des Caps bits avec Direct3D 10, ils ont tenus parole… en quelque sorte : désormais les Caps bits n’existent plus elles sont remplacées par ce que Microsoft appelle un Feature Level en français : un niveau de fonctionnalités. La principale différence est donc qu’il n’est plus nécessaire de s’assurer que chaque fonctionnalité est supportée individuellement, il suffit de vérifier si le niveau de fonctionnalités est Direct3D 10 ou Direct 3D 10.1 ce qui suffit à déterminer précisément ce qui est supporté par le GPU.

Direct3D 10.1 : les nouveautés

Soyons clairs d’entrée : les nouveautés apportées par cette nouvelle API ne sont pas révolutionnaires. Direct3D 10 était une grande opération de remise à plat et dans de telles entreprises il y a toujours de petites erreurs, Direct 3D 10.1 doit donc être vue comme une mise à jour incrémentale : corrigeant avec le recul les petites failles de la précédente API, et apportant quelques ajouts afin de supprimer les quelques restrictions qui existaient encore. Les nouveautés peuvent donc se résumer en trois catégories :

- Des spécifications plus strictes afin de limiter les divergences entre les multiples implémentations.

- Quelques nouvelles fonctionnalités

- Un accent nettement marqué sur la qualité du rendu et plus précisément de l’antialiasing

Des spécifications plus strictes

Avec Direct 3D 10.1 Microsoft en profite pour rendre son API encore un peu plus orthogonale en supprimant quelques cas particuliers : ainsi il est désormais nécessaire de supporter le filtrage des textures FP32 alors que c’était optionnel avec Direct 3D 10 (mais les GPU Direct 3D 10 des deux constructeurs le supportaient déjà malgré tout). De la même façon le blending dans des buffers entiers 16 bits est devenu obligatoire alors que là encore la liberté était laissée à l’implémentation avec Direct 3D 10. Microsoft renforce aussi ses spécifications au niveau de la précision des opérations qu’il s’agisse du blending ou des opérations dans les shaders. Ainsi plusieurs opérations (addition, soustraction, multiplication et division) sont désormais conformes à la norme IEEE-754 ce qui, il faut bien l’avouer, n’est pas très excitant pour les joueurs mais ne manquera pas de ravir les chercheurs adeptes de GPGPU.

Les nouvelles fonctionnalités

Microsoft a su se montrer raisonnable au niveau des ajouts à la nouvelle API, les développeurs sont encore en train d’assimiler toutes les nouveautés de Direct 3D 10 et de déterminer ce qu’ils peuvent réellement en faire. Il n’est donc pas question des les noyer tous les ans sous un flot de nouvelles fonctionnalités. En premier lieu on trouve donc les Cube Map Arrays. Avec Direct 3D 10 Microsoft avait introduit les Texture Arrays, des tableaux de textures qui pouvaient être indexés directement dans les shaders. A première vue les Texture Arrays ressemblent aux textures 3D qui existent depuis longtemps, mais en pratique leur comportement est très différent. Ainsi lors de l’accès à un élément d’une texture 3D il y a un filtrage entre les diverses couches, c’est logique car une texture 3D est volumique. A l’inverse les textures stockées dans un tableau peuvent n’avoir aucun rapport entre elles par conséquent il n’y a aucun filtrage entre des éléments voisins. De plus lors de l’utilisation du mipmapping une texture 3D est divisée par 2 selon ses 3 dimensions, ce n’est pas le cas des Texture Arrays : si les différentes textures qui le composent voient leur taille diminuer, la taille du tableau elle reste constante. Direct 3D 10.1 généralise ces Texture Arrays en apportant le support des tableaux de Cube Maps alors que jusqu’à présent seuls les tableaux de textures 1D ou 2D étaient supportés.

Au niveau du Shader Core, Direct 3D 10.1 introduit le Shader Model 4.1 qui apporte quelques nouveautés comme le Gather-4 qui n’est autre qu’un nouveau nom pour le Fetch-4 apparut à la précédente génération de cartes ATI). Pour rappel cette instruction permet de récupérer 4 éléments non filtrés d’une texture à une seule composante en un seul échantillonnage ce qui permet d’implémenter des filtres personnalisés dans les shaders plus efficacement. Une autre instruction ajoutée au Shader Model 4.1 permet de récupérer le niveau de détail (niveau de mipmap) lors de l’échantillonnage d’une texture. Microsoft rehausse aussi certaines limites notamment le nombre d’éléments en entrée et en sortie des vertex shaders, on passe ainsi de 16 vecteurs 128-bit (4 flottants simple précision) à 32.

En ce qui concerne le blending, nous avons déjà parlé du nouveau format supporté : Int16 mais ce n’est pas la seule nouveauté : Direct 3D 10.1 autorise désormais de spécifier des modes de blending indépendant lors d’un rendu simultané dans plusieurs buffers (MRT : Multiple Render Targets).

Direct3D 10.1 : qualité, en pratique

Objectif qualité

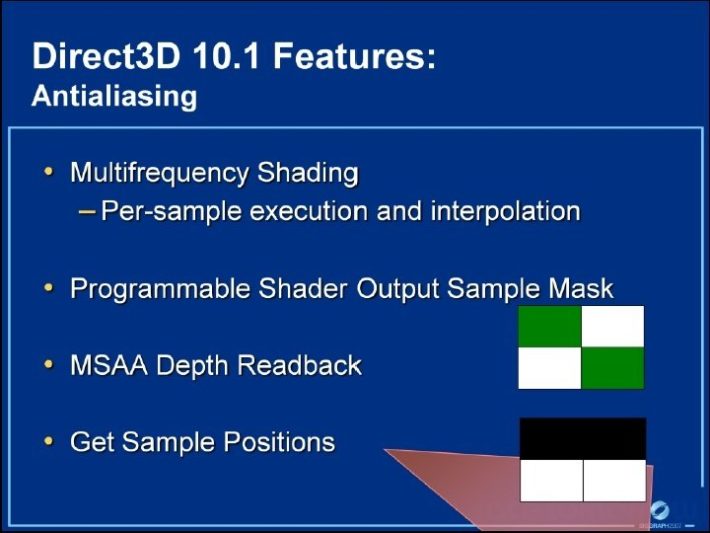

Avec Direct 3D 10.1 Microsoft a plus mis l’accent sur la qualité du rendu que sur les nouvelles fonctionnalités à proprement parler. Et le point sur lequel ils se sont le plus concentrés est l’antialiasing. Première nouveauté désormais le support de l’antialiasing 4x au minimum est obligatoire aussi bien pour les buffers 32-bit (RGBA8) que 64-bit (RGBA16). De plus la position des échantillons est aussi spécifiée par l’API et elle doit être paramétrable : sans aller jusqu’à la possibilité de programmer librement la position des échantillons, une application doit au moins pouvoir choisir entre plusieurs patterns prédéfinis.

Au-delà de ces spécifications plus strictement définies, Microsoft a aussi cherché à rationaliser un peu la gestion de l’antialiasing en offrant un plus grand contrôle au programmeur et en recourant moins aux petites recettes de cuisine des fabricants de GPU. Il faut dire que jusqu’ici l’utilisateur avait accès à un nombre d’options assez déroutants pour le néophyte : outre le niveau d’antialiasing (2x, 4x, 8x), l’utilisateur avait aussi accès au transparency antialiasing pour filtrer les textures alpha soit en mode multisampling, soit en mode supersampling et à cela s’ajoutait les fonctionnalités spécifiques à chaque IHV : CSAA ou CFAA… Avec Direct 3D 10.1 le programmeur peut enfin spécifier s’il désire du multisampling ou du supersampling par primitive, il a aussi accès au masque de couvrance de chaque pixel ce qui lui fournit un contrôle sur les échantillons sur lesquels appliquer un shader.

Enfin alors que Direct 3D 10 permettait l’accès aux échantillons d’un color buffer multisamplé, il est désormais possible de faire de même dans un depth buffer multisamplé. Concrètement la plupart de ces fonctionnalités ne sont pas nouvelles, chaque constructeur les implémentait plus ou moins à sa façon et permettait de les activer dans ses drivers. Ce qui est nouveau c’est surtout que Direct 3D 10.1 permet enfin d’exposer tout cela aux programmeurs de jeux. Ainsi ce ne sont plus les programmeurs de drivers qui se chargeront de développer de nouveaux modes d’antialiasing mais les programmeurs de jeux qui pourront s’en charger en fonction des besoins spécifiques de leurs moteurs un peu à l’image de ce que pouvait déjà faire les programmeurs consoles qui avaient un accès de plus bas niveau au hardware. Microsoft fournit ainsi ce qu’il y a de mieux au développeur en attendant des ROP totalement programmables qui rendraient tout ceci encore plus flexible et plus clair.

Et en pratique ?

En pratique il ne faut pas espérer grand-chose pour le moment, on attend encore que les développeurs maîtrisent Direct 3D 10 et surtout ne soient plus bridés par les versions Direct 3D 9 de leurs moteurs qu’ils doivent toujours faire évoluer alors il y a peu de chance qu’ils se ruent sur Direct 3D 10.1 : le hardware vient tout juste d’apparaître et l’API ne le sera pas avant la disponibilité du Service Pack 1 de Vista en 2008.

Malgré tout les quelques fonctionnalités apportées devraient permettre des effets sympathiques. Les Cube Map Arrays pourraient notamment simplifier les réflexions dynamiques, même s’il ne faut pas oublier l’impact sur d’autres portions du pipeline. Ainsi dans les jeux actuels les réflexions dynamiques ne sont gérées, en général, que sur les éléments principaux, et la fréquence de mise à jour des réflexions est nettement moins soutenue que celle de rafraîchissement de l’écran pour économiser le fillrate. Si les Cube Map arrays lèvent une restriction sur le nombre de réflexions simultanées ils ne suppriment pour autant pas les autres, on attendra donc de juger sur pièce dans des jeux plutôt que dans quelques démos formatées par AMD ou Microsoft.

Les modes de blending indépendants pour chaque buffer dans le cadre de l’utilisation des MRT devraient faciliter le développement de moteurs de rendu de type deferred shading. Couplé aux possibilités de lecture des échantillons d’antialiasing des color et depth buffer ces moteurs ne seront plus contraints d’abandonner l’antialiasing au profit d’un vague flou à l’intérêt discutable. Les autres nouveautés sont surtout un confort supplémentaire pour les développeurs que véritablement pour le joueur.

Radeon HD 3000 : une nouvelle architecture ?

Contrairement à ce que leur nom laissent penser, dissipons d’entrée de jeu l’écran de fumée marketing dont AMD n’a une nouvelle fois pas pu s’empêcher : non, les Radeon HD 3000 n’introduisent en rien une nouvelle architecture, ni même une évolution importante par rapport aux Radeon HD 2900. Le nom de ces cartes aurait du commencer par Radeon HD 2xxx et rien d’autres (à l’instar des Radeon 1900 en leur temps, et qui représentaient pourtant une plus grande évolution), et il est navrant de constater à quel point la marque a tendance à s’appuyer sur ce genre de recours à chaque fois qu’elle est en position difficile, comme elle l’avait déjà fait dans d’autres domaines au moment de la présentation de la Radeon HD 2900 XT. Passons.

A l’instar de la GeForce 8800 GT, la Radeon HD 3800 n’a pu voir le jour que grâce à l’amélioration de la finesse de gravure. Et à ce petit jeu, AMD conserve son avance puisqu’il passe de 80 nm au 55 nm, alors que nVidia n’a pu dépasser le 65 nm. Il faut dire que le travail des canadiens a été à priori un peu moins difficile, au moins du point de vue comptable avec 666 millions de transistors pour cette nouvelle puce, contre 754 millions pour rappel sur le G92 de la 8800 GT. A l’inverse de chez nVidia donc, le nombre de transistors est donc en baisse par rapport à la précédente puce puisque le R600 totalisait 700 millions de transistors.

Pourtant, le nombre d’unités de calcul demeure inchangé (alors qu’il est en légère baisse chez nVidia) avec 320 stream processors, toujours seulement 16 unités de texturing (quelle faute de ne pas en avoir profité pour corriger cette limitation !), et 16 ROP. Seules améliorations : une optimisation du contrôleur mémoire, chargé de faire un meilleur usage de la bande passante, le constructeur allant jusqu’à parler de performances équivalentes au Radeon HD 2900 à fréquence égale malgré une interface mémoire limitée à 256 bits (le bus en anneau passant lui à 512 bits, ou plus exactement 2 x 256 bits). Le support du PCI Express 2.0 fait lui aussi son apparition, mais ne devrait une fois encore ne montrer quelques gains qu’avec les cartes limitées par la quantité de mémoire (cartes HyperMemory ou HD 3850 256 Mo), et ce en haute résolution, hormis bien sûr les applications GPGPU. Tout comme l’UVD, pourtant absent pour rappel de la HD 2900 XT, mais la GeForce 8800 GT reprenant le PureVidéo 2, le canadien n’avait pas le choix et c’est tant mieux. Le support de DirectX 10.1 est enfin à prendre en compte bien que les Radeon HD 2000 en étaient déjà proches.

Le PowerPlay n’est plus réservé aux portables

En voilà une bonne idée sur le principe ! Nous avons toujours regretté que les technologies permettant d’abaisser significativement la consommation dans certaines situations soient réservées aux composants destinés aux ordinateurs portables, que ce soit pour les CPU, les GPU, les chipsets ou autres. AMD franchit donc une étape en permettant d’activer le PowerPlay des Radeon Mobility sur les Radeon HD 3800.

En pratique, le mode qui correspondait au réglage “autonomie maximale” devrait faire son apparition. Il s’agit donc simplement de réduire les fréquences du GPU et de la mémoire à des valeurs intermédiaires entre celles du repos et de charge. Reste que l’intérêt d’un tel mode reste plus discutable sur un PC. Autre soucis : les drivers actuels n’activent aucune page dédiée à la gestion du PowerPlay, et nos tests sous des applications 2D ou 3D légères n’ont mis en évidence aucun mode intermédiaire automatique. Encore des promesses en l’air pour AMD donc…

Triple et quad-crossfire, spécifications

Le Crossfire passe la troisième et la quatrième… enfin bientôt

Alors que chez nVidia, l’échec du quad-SLI semble avoir été si marquant qu’il n’a jamais existé (du nouveau dans ce domaine bientôt…), AMD en profite donc pour lui “voler la vedette” si l’on peut vraiment le dire, en introduisant sur ses Radeon HD 3800 la possibilité de coupler 2, mais aussi 3 ou 4 cartes identiques. En pratique il ne s’agit que d’une annonce toutefois, puisque les drivers ne devraient pas être vraiment prêt avant le mois prochain au mieux, AMD lui-même parlant de gains maximum de seulement 3.3x avec 4 cartes actuellement. La démo de Global Illumination que nous avons pu voir chez le constructeur fonctionnait d’ailleurs sur une telle machine avec des pilotes en version beta et n’était clairement pas stable.

Spécifications

Comment expliquer cette baisse du nombre de transistors au final ? Probablement par la présence dans le R600 d’unités redondantes mais désactivées, destinées à améliorer le yield vu la taille et la finesse de gravure de cette puce. Il est probable aussi que certaines des fonctionnalités inaugurées sur ce RV670 étaient déjà présentes sur le R600 mais désactivées car buggées.

| GPU | HD 3850 | HD 3870 | 8800 GT |

|---|---|---|---|

| Fréquence GPU | 670 MHz | 775 MHz | 600 MHz |

| Fréquence shaders | 670 MHz | 775 MHz | 1500 MHz |

| Fréquence mémoire | 833 MHz | 1125 MHz | 900 MHz |

| Largeur du bus mémoire | 256 bits | 256 bits | 256 bits |

| Type de mémoire | GDDR3 | GDDR4 | GDDR3 |

| Quantité de mémoire | 256 Mo | 512 Mo | 512/256 Mo |

| Nombre de Pixels/Vertex Pipelines | (80) | (80) | (28) |

| Nombre d’unités de texturing | 16 | 16 | 56 |

| Nombre de ROP | 16 | 16 | 16 |

| Puissance | 429 GFlops | 496 GFlops | 336 GFlops |

| Bande passante mémoire | 53,3 Go/s | 72 Go/s | 57,6 Go/s |

| Nombre de transistors | 666 millions | 666 millions | 754 millions |

| Process | 0.055µ | 0.055µ | 0.065µ |

| Surface du die | 196 mm² | 196 mm² | 324 mm² |

| Génération | 2007 | 2007 | 2007 |

| Shader Model supporté | 4.1 | 4.1 | 4.0 |

Bonne nouvelle en tout cas, le recours au 55 nm permet à AMD de disposer d’une puce d’une surface deux fois inférieure à celle du R600, et plus important encore, significativement plus petite que le G92 avec 41 % de moins ! Un arme réelle dans la guerre des prix si importante que se livrent les 2 constructeurs sur ce marché, bien qu’encore une fois il faut prendre en compte le fait que les yields d’AMD sont probablement moins bons avec ce 55 nm que le G92 de nVidia.

Les Radeon HD 3850 et 3870

La différence entre les deux Radeon HD 3800, pourtant basées sur la même puce, est importante et avant tout physique. Si la Radeon HD 3850 parvient à conserver un design single-slot, certes long mais très proche de celui des HD 2600 XT de référence, la HD 3870 pour sa part n’échappe pas à un refroidissement occupant deux slots. Plutôt une bonne chose donc, puisque cette carte ferra donc office de ventilateur de boîtier et permettra de soulager la ventilation interne, tout à l’inverse de la HD 3850. En fait le ventirad de référence utilisé par la HD 3870 rappelle furieusement celui de la Radeon 1950 XTX et mis au point Artic Cooling. Et pour cause puisque son ventilateur radial de 7,5 cm à pales droites est identique. Un peu dommage car la X1950 XTX dispose en pratique d’un niveau sonore significativement plus élevé que celui des GeForce 8800 GTX, même s’il faut la replacer dans son contexte, cette carte succédant à l’horripilante X1900 XTX et parvenant à réduire significativement son niveau de bruit.

Côté mémoire, la HD 3850 est accompagnée de 256 Mo de GDDR3 cadencés à 833 MHz, mais une version 512 Mo, plus onéreuse, pourrait voir le jour. A l’inverse, la HD 3870 devrait être limitée à sa version 512 Mo, qui est nettement plus rapide que la HD 3850 et que la 8800 GT puisque cadencée à 1125 MHz, et ce malgré la fréquence de puces GDDR4 certifiées à 1.2 GHz. Une fréquence que nous avons effectivement pu atteindre et même dépasser comme nous le verrons plus loin.

Le test

Outre Unreal Tournament 3 et Crysis introduits lors du test de la GeForce 8800 GT, Call Of Duty 4 fait également son apparition. Il a comme le reste des jeux été testé en condition réelle avec Fraps (aucun timedemo). Les derniers patchs ont été appliqués juste avant le test.

Les performances ont été évaluées en DirectX 9 et sous Windows XP. Nous l’avons vu, le mode DirectX 10 des jeux actuels n’est pas optimisé et consomme donc énormément de puissance GPU pour un résultat souvent décevant, et n’est donc pas le plus recommandé pour des cartes de milieu de gamme. De même, la grande majorité d’entre vous n’êtes pas passé à Windows Vista qui ne modifie de toute façon plus beaucoup la donne.

Côté résolutions, le 1280*1024 a été rajouté aux 1600*1200 et au 1920*1440 afin d’avoir une très large palette et pour ne pas pénaliser encore les cartes dotés de seulement 256 Mo de mémoire (HD 3850 et 8600 GTS) qui ne se destinent pas au grandes résolutions. Pour rappel, les écrans LCD 17″ et 19″ 4/3 disposent d’une résolution native de 1280*1024 ; le 1680*1050 des moniteurs 22″ est seulement 8 % moins gourmand que le mode 1600*1200 et en est donc très proche. Quand au 1920*1200, il représente une charge de calcul 17 % moins élevée que le 1920*1440.

La configuration de test a légèrement évolué depuis la dernière fois.

Configuration de test :

- Asus P5K3 Deluxe

- Intel Core 2 Duo E6850 (3 GHz)

- Kingston 2 x 1024 Mo configurés en DDR-3 800 5-5-5-15-21

- Hitachi T7K250 250 Go

- Lecteur DVD Asus 12x

- Tagan U15 Easycon 530 W

- Windows XP Pro

- ForceWare 169.04

- ForceWare 169.09 (toutes GeForce sous Crysis)

- Catalyst 8.43 (7.11 beta)

Test Drive Unlimited

Sous Test Drive Unlimited, la Radeon HD 3870 parvient à talonner la GeForce 8800 GT : hors filtre, elle se montre 10 % moins performante, cet écart montant tout de même à 16 % une fois l’activation de l’antialiasing. AMD n’a visiblement pas pu corriger ses ROP buggués à ce niveau et doit toujours recourrir aux shaders, la Radeon HD 2900 XT affichant un profil identique. Seule exception : le 1920*1440 + filtres où la 3870 passe devant la 8800 GT, mais avec un framerate insuffisant pour TDU.

La Radeon HD 3850 pour sa part se place un cran derrière la GeForce 8800 GTS 320 Mo avec entre 7 et 23 % d’écart, là encore sauf en 1600*1200 + filtres et ce malgré les 64 Mo de mémoire supplémentaire de la 8800 GTS. Elle reste cependant très largement devant la GeForce 8600 GTS.

Supreme Commander

Sous Supreme Commander, la Radeon HD 3870 reste devant la HD 2900 XT mais comme elle, encaisse mal le passage au 1600*1200 alors qu’avec les GeForce, il faut généralement attendre le 1920*1440 pour voir une perte importante. La GeForce 8800 GTS 640 Mo reste toutefois dépassée. En revanche, la version 320 Mo reste devant la HD 3850 bien que l’écart soit très réduit hors filtres, la Radeon parvenant même à surpasser la 8800 en 1280*1024.

Age of Empires 3

Curieusement, la HD 3870 ne parvient vraiment à décoller de la HD 2900 XT sous Age of Empires 3. Il faut dire que ce jeu reste très sensible à la puissance de shading et très peu à la bande passante mémoire ; or il faut rappeler qu’en matière de puissance brute la supériorité de la HD 3870 sur sa grande sœur n’est que de 4 %. Aussi, la GeForce 8800 GT affiche ici une nette suprématie sur sa rivale, avec 17 à 31 % de mieux, hormis en 1920*1440 + filtres une fois encore.

Quand à la Radeon HD 3850, elle accuse un retard de 7 à 19 % par rapport à la 8800 GTS 320 Mo, mais reste environ 2 fois plus rapide que la 8600 GTS.

The Elder Scrolls IV: Oblivion

Oblivion permet de voir clairement le coût plus important engendré par l’antialiasing (ici activé via les pilotes) chez AMD que chez nVidia, avec des performances 1280*1024 + filtres supérieures à celles en 1920*1440 hors filtres uniquement avec les cartes du caméléon. La hiérarchie n’est cependant pas bouleversée bien que la HD 3870 ne surpasse la 8800 GTS 640 Mo plus que sans antialiasing : une fois activé, la carte nVidia reprend le dessus.

STALKER

De part son recours au deferred rendering, le moteur 3D de STALKER ne permet pour rappel d’activer qu’un antialiasing basé sur les shaders, très peu convaincant au final et difficile à activer vu le niveau de performances déjà bas sans, d’où son absence ici.

STALKER place pour la première fois la Radeon HD 3870 en-dessous de la 8800 GTS 640 Mo hors filtres. L’écart ne dépasse pas 5 % mais est présent, sauf en 1920*1440 où les deux cartes font jeu égal. Quand à la 3850, elle confirme le constat que l’on a pu faire jusque là, à savoir des performances en 1920*1440 globalement équivalentes à celles de la 8600 GTS… en 1280*1024 !

World in Conflict

Sous World In Conflict, les Radeon montrent une nouvelle fois leur fragilité une fois l’antialiasing activé, avec toutefois des performances assez variables suivant les cartes et les résolutions. Aussi une nouvelle ici ne mesure-t-on pas de vraie supériorité pour la HD 3870 comparativement à la HD 2900 XT. La supériorité de la version 640 Mo de la 8800 GTS par rapport à la version 320 Mo est en revanche assez marquée, surtout avec les filtres.

Unreal Tournament 3

Curieusement, comme la dernière fois la Radon HD 2900 XT se montre particulièrement véloce sous cette démo d’Unreal Tournament 3 puisque non contente de dépasser la 8800 GT, elle surpasse également la HD 3870 ! On remarque par ailleurs que peu gourmand, Unreal Tournament 3 affiche cependant de gros écart entre chaque résolution et un gros surcoût lié à l’activation de l’antialiasing. Tout cela concourre donc donner à cette démo le comportement d’un vieux jeu qui serait surtout limité par la bande passante mémoire, seul domaine dans lequel la HD 2900 XT surpasse les HD 3800. Ironique.

Crysis

Crysis a une nouvelle fois droit à un traitement de faveur : d’une part, il est le seul jeu avec lequel nous devons baisser d’un cran les résolutions et les réglages graphiques (et malgré cela les moyennes relevées sont les plus faibles de tous les jeux), et d’autre part il nécessite d’utiliser un driver spéciale côté nVidia (169.09) afin de supprimer un bug douteux de SLI favorisant les GeForce utilisées seules et au sujet duquel le constructeur communique le moins possible. Regrettable.

Malgré cela, la situation ne change pas vraiment en haut du tableau, avec un retard de 16 % pour la HD 3870 par rapport à la 8800 GT hors filtres, et d’environ 21 % une fois l’antialiasing activé, hors 1920*1440. Quand à la HD 3850, son retard par rapport à la 8800 GTS 320 Mo ne dépasse pas 4 à 6 % dans les deux seules résolutions les plus faibles, et ne dépasse pas 15 % en 1920*1440, un mode de toute façon complètement injouable sur ces deux cartes. Bon point pour la HD 3850 donc ici !

Call of Duty 4

Peu surprenant par son gameplay, bien que toujours aussi convaincant, Call of Duty 4 nous a plus étonné par ses graphismes. Très impressionnants sans atteindre ceux de Crysis, ils sont cependant obtenus de façon moins « noble » par le recours à des textures très détaillées, ce qui se traduit par une dépendance bien moins marquée à la puissance de calcul du GPU.

Comme UT3, mais plus logiquement, Call of Duty 4 s’avère sensible à la bande passante mémoire et place une nouvelle fois la Radeon HD 2900 XT légèrement devant la HD 3870 avec ou sans filtres, et devant même la 8800 GT hors filtres uniquement. Plus bas, la Radeon HD 3850 est décrochée par la 8800 GTS 320 Mo avec des performances entre 13 et 25 % inférieures. Mais toujours largement supérieures à la 8600 GTS.

Consommation

Voici la consommation totale de l’alimentation, qui regroupe donc la consommation de la configuration dans son ensemble, ainsi que les pertes de l’alimentation Tagan U15 530 W qui sont de 20 % sur la plage de puissance considérée ici.

Sans réelle surprise, les HD 3800 amènent une grosse baisse de la consommation par rapport à la HD 2900 XT, mais dont l’ampleur nous étonne tout de même : la réduction de la consommation totale en charge atteint tout de même 109 W en charge en passant de la 2900 XT à la 3870 aux performances légèrement supérieures ! Le 55 nm est passé par là, mais ne permet malheureusement pas aux HD 3800 de passer en-dessous de la 8800 GT en charge (et ce malgré une consommation maximale annoncée à 105 W pour la HD 3870, comme nVidia, contre 95 W pour al 3850). AMD conserve donc son avance technologique mais le rapport performances/consommation reste malgré cela du côté de nVidia, ce qui est donc décevant pour AMD.

A noter tout de même que l’avantage lié à l’utilisation du plus fin process s’affiche au niveau de la consommation au repos, peut-être la plus importante in fine côté facture d’électricité et gaspillage d’énergie, avec un nouveau record atteint par la HD 3850, la 3870 s’affichant pour sa part au même niveau que la 8600 GTS. Au final, c’est donc beaucoup mieux pour AMD qui revient à un niveau de consommation raisonnable, mais moins bon que nVidia en charge tout de même.

Bruit, overclocking

Bruit

Un petit doute était permis au niveau de la nuisance sonore, vu les ventirads retenus par AMD. Voyons ce qu’il en est des différences entre chaque carte à l’aide d’un sonomètre placé à 7 cm du ventilateur.

Finalement, la situation reste très acceptable. La HD 3850 n’est pas plus bruyante que la GeForce 8800 GT et reste inaudible tout le temps. En revanche, la HD 3870 ne l’est qu’au repos : son ventilateur accélère en charge pour devenir audible mais rester relativement discret.

Côté températures, le RV670 de la HD 3870 affiche 70 °C au repos et monte à 92°C en charge. Des valeurs élevées dans l’absolu mais très courantes pour des cartes graphiques qui ont traditionnellement des tolérances bien plus élevées que les processeurs, et qui ne nous choquent donc pas.

Overclocking

La Radeon HD 3850 de référence s’est montrée plutôt joueuse, puisque nous avons pu passer de 670 MHz à 776 MHz pour le RV670 (+ 16 %), et de 833 MHz à 1050 MHz pour la GDDR3 (+ 26 %). Le gain sous Age Of Empires III en 1600*1200 atteint bien 16 %, ce qui est intéressant, en sachant que le gain est plus élevé sur les jeux plus dépendants de la bande passante.

Concernant la Radon HD 3870 de Sapphire, il est clair qu’AMD a poussé le RV670 plus haut et qu’il ne dispose plus de beaucoup de marge pour l’augmenter encore sans voir ses yields s’effondrer : nous avons ainsi atteint la limite de la stabilité à 839 MHz contre 775 d’origine (+ 8 %). Ce n’est pas le cas de la mémoire : la GDDR4 était certifiée à 1200 MHz, et a pu atteindre 1270 MHz sur notre exemplaire, contre une fréquence officielle de 1125 MHz pour rappel, soit + 13 %. Le gain au final atteint 9 %, soit seulement 2 % de moins que la 8800 GT : on reste dans les mêmes proportions cependant.

Conclusion

Au final, la Radeon HD 3870 est donc loin de révolutionner le genre malgré ce que son nom et sa compatibilité avec Direct3D 10.1 pourraient laisser penser. A défaut, elle parvient grâce à sa fréquence légèrement supérieure due à une finesse de gravure en forte baisse (55 nm) à dépasser la HD 2900 XT dans une majorité de jeux malgré sa bande passante plus faible (voir les moyennes page suivante), mais sans parvenir à atteindre la GeForce 8800 GT qui reste 11 % supérieure hors filtres, et 18 % avec. Cela reste toutefois plus que cohérent avec son prix agressif, puisqu’à 200 € elle s’avère 20 % moins chère que la 8800 GT dont la disponibilité demeurera faible jusqu’à janvier. Le rapport performances/prix est donc en l’état légèrement meilleur chez AMD, qui en a profité pour corriger le tir côté consommation et bruit, sans atteindre toutefois là encore le niveau de nVidia.

Il reste cependant dommage qu’une fois encore AMD n’ait pas de carte offrant un niveau de performances dépassant le nouveau milieu de gamme actuel à proposer. En outre, on ne peut s’empêcher de regretter que le constructeur n’ait pas profité de sa nouvelle puce pour corriger ses problèmes d’antialiasing et de nombre d’unités de texturing, vu la débauche de puissance et de bande passante qu’il doit faire preuve afin de pouvoir rester compétitif. Cet apport aurait été autrement plus judicieux que le support du futur Direct3D 10.1 ou du quad-Crossfire. Il reste enfin à vérifier que les prix annoncés par AMD soient bien respectés, et voir ce que donnera la GeForce 8800 GT 256 Mo attendue pour la fin du mois.

- Les plus

- Les moins

- Meilleur rapport performances/prix que la 8800 GT 512 Mo actuellement

- Consommation au repos très faible et bruit largement en baisse

- Présence de l’UVD et de l’AVP

- Evacuation de la chaleur à l’extérieur du boîtier (design double-slot)

- Performances inférieures à la 8800 GT malgré une puissance brute et une bande passante supérieure et une finesse de gravure inférieure

- Consommation et bruit en charge raisonnables mais supérieures à la 8800 GT

- Ne corrige pas les défauts de l’architecture R600

- Les plus

- Les moins

- Meilleur rapport performances/prix des cartes milieu de gamme actuelles

- Consommation et bruit faibles au repos comme en charge

- Présence de l’UVD et de l’AVP

- Les 256 Mo de mémoire limitent fortement l’activation de l’antialiasing

- Ne corrige pas les défauts de l’architecture R600

Récapitulatif des performances

Ces moyennes obtenues pour chaque carte et pour chaque jeu excluent néanmoins Crysis, ce dernier ne changeant pas la hiérarchie mais n’ayant pu être testé dans les mêmes résolutions que les autres jeux. De même, les performances obtenues sous STALKER font partie des moyennes hors filtres, mais le jeu n’ayant pas été testé avec antialiasing, il est exclut des moyennes avec filtres ce qui les fait remonter un peu, STALKER étant très gourmand.

A noter que la Radeon HD 3870 se situe en-dessous de la HD 2900 XT alors qu’il n’y a que 3 jeux dans lequel c’est le cas, mais ces jeux (TDU, UT3 et Call of Duty 4) sont ceux ou le nombre d’images par secondes est élevé et pèsent donc plus lourd.