GP106 en détail, test en multi-GPU DX12

Deux mois après ses débuts sur le marché, l’architecture Pascal complète peu à peu l’offre de NVIDIA. Après les GeForce GTX 1080 et GTX 1070 que nous avons testées dès leur lancement, voici donc la GeForce GTX 1060, qui vient combler le milieu de gamme du géant de la puce graphique. Annoncé il y a un peu plus d’une semaine, la carte sera vendue 280 euros pour les modèles les moins chers, et 320 euros pour la version Founders Edition de NVIDIA.

| A lire aussi : – Notre comparatif permanent de GPU – Comparatif : 6 GeForce GTX 1080 et 1070 en test, pour commencer… ! – GeForce GTX 1070 en test : la petite Pascal domine – Le grand test de la GeForce GTX 1080 : la nouvelle reine |

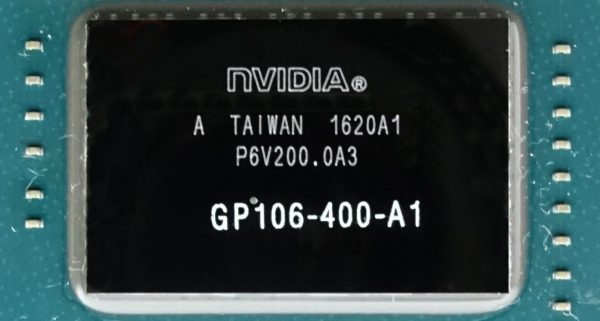

La GeForce GTX 1060 est basée sur le GPU GP106, moins puissant que les GP104 des GTX 1080 et 1070, mais aussi moins gourmand (120 W). NVIDIA affirme que cette carte offre la puissance d’une GeForce GTX 980, lancée il y a deux ans au prix de 600 euros environ. C’est ce que nous allons vérifier, sans oublier de comparer la carte avec la Radeon RX 480, car la GTX 1060 a été lancée en avance pour tenter de tuer dans l’oeuf la dernière carte d’AMD.

La GeForce GTX 1060 est basée sur le GPU GP106, moins puissant que les GP104 des GTX 1080 et 1070, mais aussi moins gourmand (120 W). NVIDIA affirme que cette carte offre la puissance d’une GeForce GTX 980, lancée il y a deux ans au prix de 600 euros environ. C’est ce que nous allons vérifier, sans oublier de comparer la carte avec la Radeon RX 480, car la GTX 1060 a été lancée en avance pour tenter de tuer dans l’oeuf la dernière carte d’AMD.

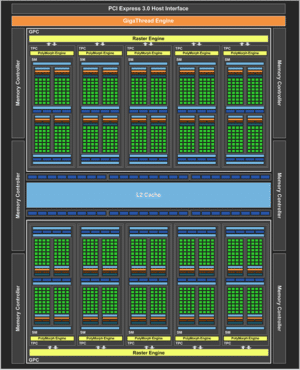

Le GP106 en détail

La GTX 1080, fleuron de NVIDIA, est basée sur la puce GP104, dotée de quatre GPC (Graphics Processing Clusters) activés. Cela donne une carte avec 2560 coeurs CUDA et 160 unités de textures. La GTX 1070 embarque trois GPC, soit 1920 coeurs CUDA et 120 unités de textures. La GTX 1060 se contente de deux GPC, soit 1280 coeurs CUDA et 80 unités de textures. En clair, c’est une GTX 1080 coupée en deux.

Voici un rappel de notre premier test de la GeForce GTX 1080 :

« Chaque TPC offre un Streaming Multiprocessor (SM) et une unité PolyMorph. Le SM intègre 1278 coeurs CUDA en simple précision, un fichier de registre de 256 Ko, 96 Ko de mémoire partagés, 48 Ko de cache L1/texture et huit unités de texture. Le moteur PolyMorph inclut quant à lui un nouveau bloc logique qui se situe à la fin du pipeline géométrique et juste avant l’unité de rastérisation. Il rend ainsi possible la technologie Simultaneous Multi-Projection. »

| GP106 contre GM204 | ||

|---|---|---|

| GPU | GeForce GTX 1060 (GP106) | GeForce GTX 980 (GM204) |

| SMs | 10 | 16 |

| Coeurs CUDA | 1280 | 2048 |

| Fréquence de base | 1506 MHz | 1126 MHz |

| Fréquence Boost | 1708 MHz | 1216 MHz |

| GFLOPS | 3855 | 4612 |

| Unités de textures | 80 | 128 |

| Texel Fill Rate | 120.5 GT/s | 144.1 GT/s |

| Mémoire | 8 Gbit/s | 7 Gbit/s |

| Bande passante | 192 Go/s | 224 Go/s |

| ROPs | 48 | 64 |

| Cache L2 | 1,5 Mo | 2 Mo |

| TDP | 120 W | 165 W |

| Transistors | 4,4 milliards | 5,2 milliards |

| Die Size | 200 mm² | 398 mm² |

| Process Node | 16 nm | 28 nm |

Bus mémoire réduit

Six contrôleurs mémoire offrent un bus mémoire d’une largeur totale de 192 bits. Chaque contrôleur est associé à huit ROPs et 256 Ko de mémoire cache L2. On a donc 48 ROPs et 1,5 Mo de cache L2 au total. Les 6 Go de mémoire vive GDDR5 offrent une bande passante totale de 192 Gbits/s. C’est moins que les 224 Gbits/s de la GTX 980, mais n’oubliez pas que NVIDIA intègre dans sa nouvelle architecture de meilleures techniques de compression sans perte, pour économiser de la bande passante mémoire :

« La technique de compression des delta des couleurs de la GP104 réduit de moitié la place que prennent ces informations et un nouveau mode 4:1 permet de réduire les ressources nécessaires lorsque les informations entre plusieurs pixels sont très légèrement différentes. Il y a aussi un mode 8:1 qui utilise la compression 4:1 sur des blocs de 2×2 pixels, en offrant une compression de 2:1 sur les différences entre eux. »

(de notre test de la GTX 1080)

Evidemment, la puce GP106 est produite selon le même processus de gravure TSMC 16 nm FinFET+ que le GP104. Par rapport à ce dernier, le GP106 passe de 7,2 milliards à 4,4 milliards de transistors FinFET, et de 314 à 200 m² de surface. Une puce plus simple, dont le TDP est donc réduit à 120 W.

Une première : pas de SLI pour le milieu de gamme

Vous aurez remarqué l’absence de connecteur SLI sur le PCB de la carte. C’est la carte la plus haut de gamme que nous nous rappelons être dénuée de technologie SLI. La GeForce GTX 750 Ti ne proposait pas non plus de SLI, certes, mais la 760 pouvait se coupler en SLI, tout comme la GTX 950.

L’explication officielle de NVIDIA est simple : peu de joueurs couplent des cartes graphiques milieu de gamme, et la firme souhaite plutôt se concentrer dans l’optimisation du SLI pour les cartes graphiques Pascal haut de gamme. Au delà de cette explication, il faut remarquer un changement de direction : les développeurs de jeu se concentrent plus le post-processing et les effets spéciaux basés sur du calcul GPU, deux techniques difficiles à gérer pour un SLI classique en AFR (Alternate Frame Rendering, les cartes calculent une image chacun leur tour). Avec DirectX 12, les choses vont peut-être changer, avec une nouvelle manière de gérer le multi-GPU, plus simple pour les développeurs, mais qui va contourner le travail d’optimisation de NVIDIA sur le SLI.

DirectX 12 pour le multi-GPU ?

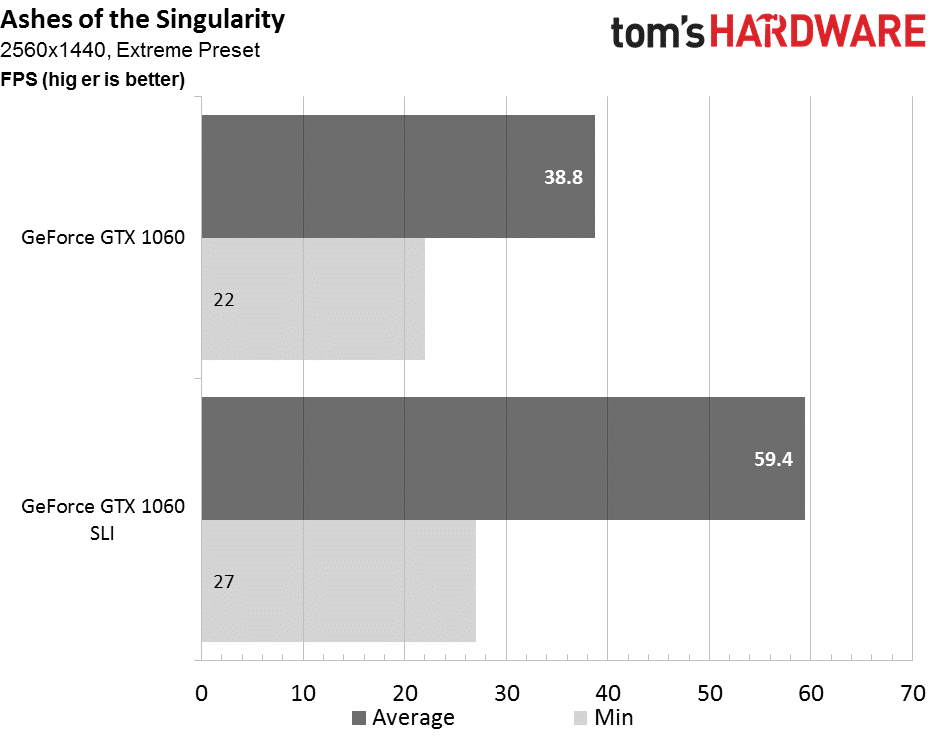

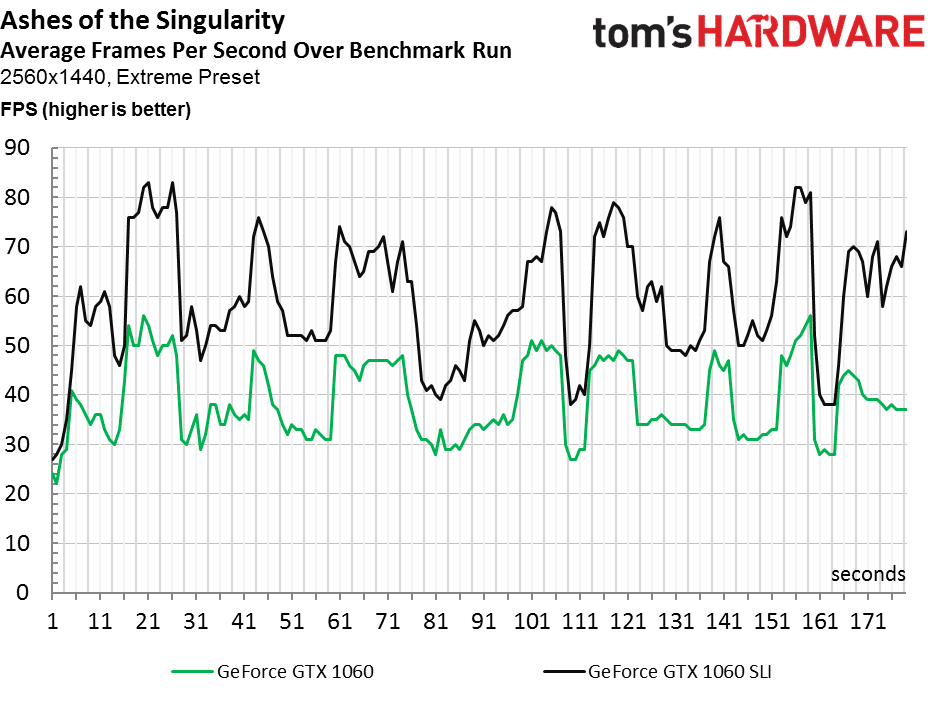

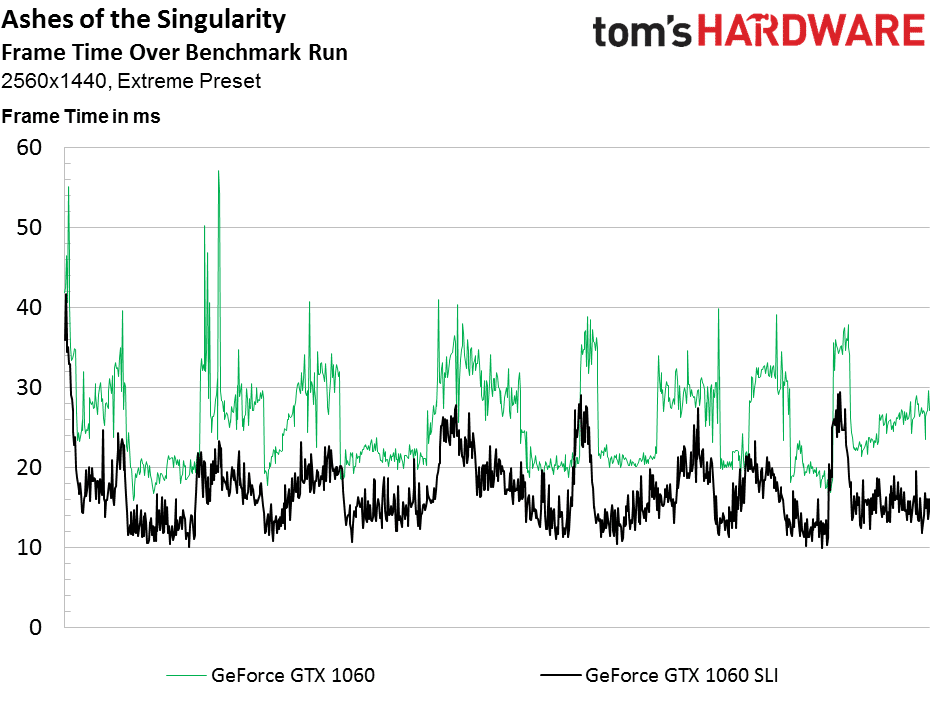

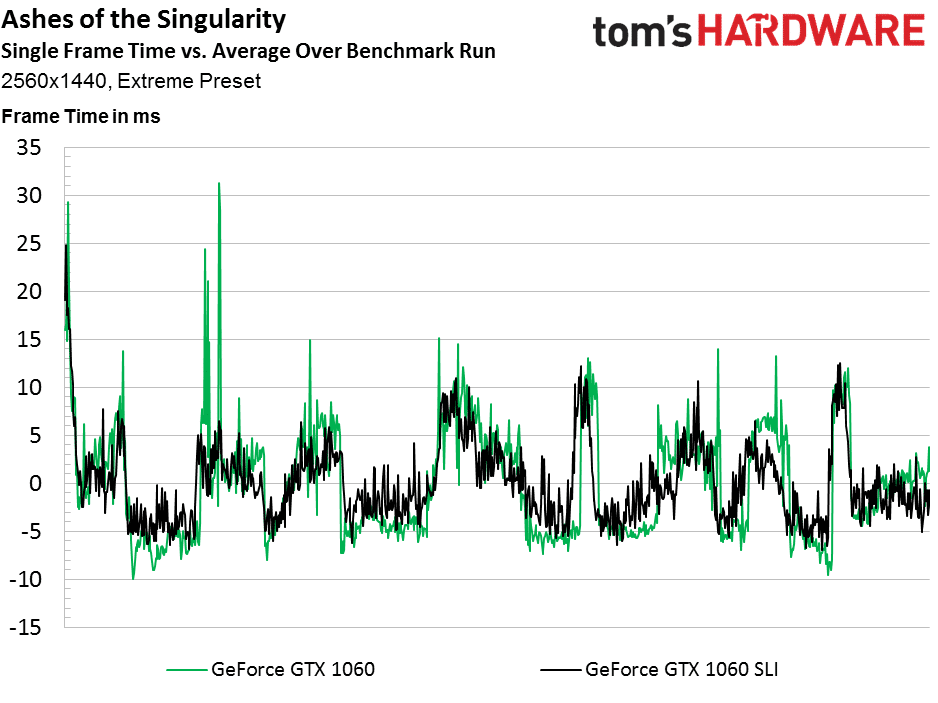

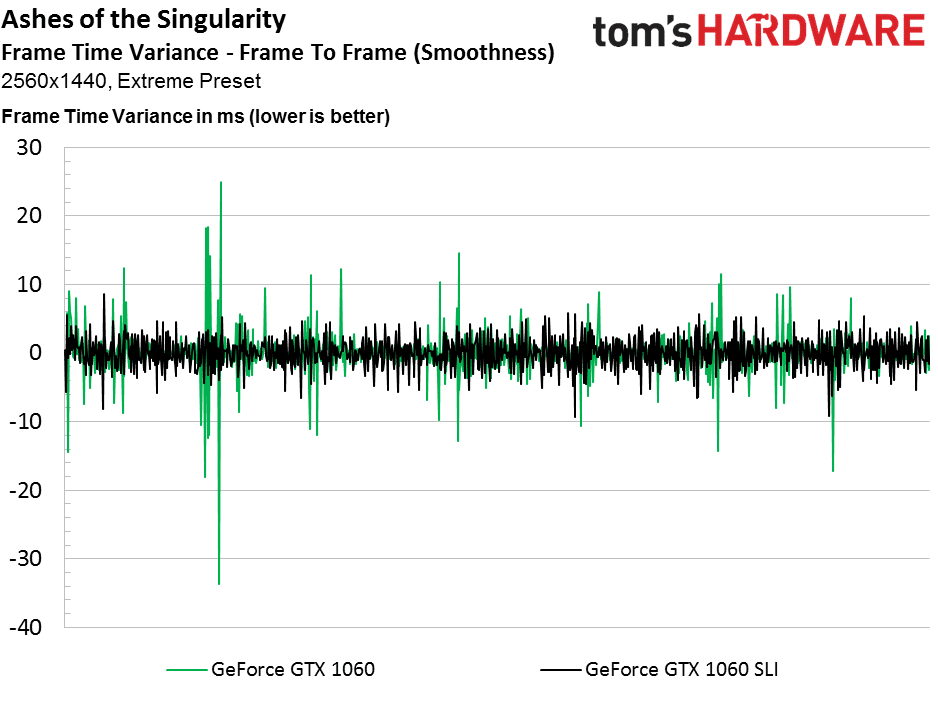

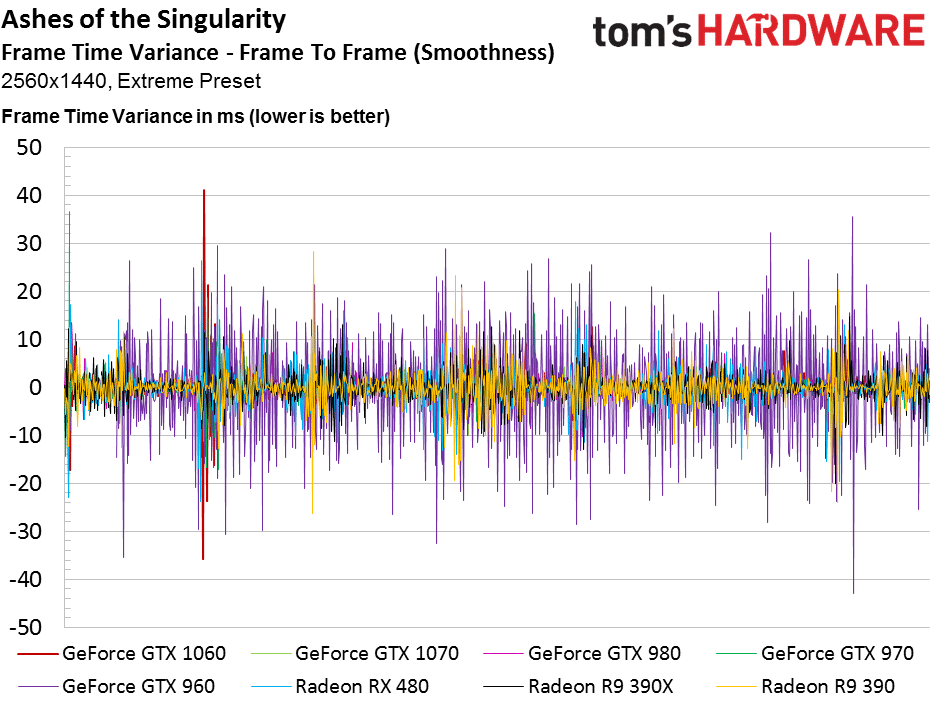

Le seul jeu de notre suite de test qui gère le multi-GPU avec DirectX 12 est Ashes of the Singularity. Après avoir ajouté une seconde GTX 1060, et cliqué sur l’option de gestion multi-GPU, voici les gains de performances :

Ce n’est pas le genre de gain de performances qu’on pouvait voir avec un SLI, mais environ 50 % de performances en plus, c’est plutôt bon. Notez que ce type de gain est donc impossible a obtenir avec les jeux en DirectX 11, et même avec les jeux DirectX 12 sans gestion multi-GPU intégrée.

Sachant que la GTX 1060 est une carte destinée à la définition 1080p, Nvidia pourrait très bien activer un SLI via l’interface PCI Express, par une simple mise à jour de pilotes. On espère que ce sera le cas, car bon nombre de jeux DirectX 11 pourraient en profiter.

Examen de la GTX 1060 Founders Edition

NVIDIA continue sur sa lancée, avec une carte Founders Edition, autrement dit un modèle de référence qui reprend le look et le design de refroidissement des GTX 1080 et 1070 Founders Edition. Avec une implémentation que l’on présume moins coûteuse.

Toutefois, celà ne signifie pas que la carte est petite. Elle fait 25,4 cm de long (avec son dissipateur), 10,7 cm de large, et 3,8 cm d’épaisseur. En fait, la carte est plus fine (3,5 mm), mais sont équerre PCI dépasse de 0,3 mm. La carte pèse enfin 845 grammes.

Design, impressions et interfaces

Encore une fois, NVIDIA utilise un couvercle en métal et plastique. Il est toutefois plus simple que chez les GTX 1080 et 1070. Tout le boîtier peut être retiré en une fois, même avec le ventilateur. Le logo GeForce GTX reste illumé en vert, et on trouve cette fois un seul connecteur 6 broches pour l’alimentation.

Le verso de la carte montre un PCB beaucoup plus court que celui de GTX 1080 et 1070, c’est le ventilateur qui dépasse du PCB pour donner sa réelle longueur à la carte. Et, certainement pour des raisons d’économies, il n’y pas de plaque arrière (backplate).

Le reste de la carte ne change pas vraiment. On remarque la présence d’un port DVI dual-link, de trois ports DisplayPort 1.2 et un port HDMI 2.0. Notez que d’autres GTX 1060 custom pourront avoir des interfaces avancées, notamment Displayport 1.3 ou 1.4.

Dissipateur, PCB et alimentation

La position du connecteur 6 broches est inhabituelle : il est placé hors du PCB, sur la partie qui dépasse avec le ventilateur, et relié au PCB par des câbles électriques. Le PCB fait seulement 17,5 cm de long, mais il n’y a pas de place libre pour un connecteur 6 broches, ce qui imposera aux fabricants partenaires de faire des PCB personnalisés pour rendre la carte plus courte. Dommage.

Le dissipateur se compose d’un gros radiateur en cuivre avec une plaque de métal juste en dessous. Un dissipateur sans chambre à vapeur, assez similaire à celui des GTX 1070. Certainement de quoi offrir de bonnes performances face au TDP de 120 W de la 1060.

La plaque à la base de la carte tient deux rôles : celui de rigidifier le PCB et de dissiper les autres composants de la carte, comme l’étage d’alimentation et la RAM, via des pads thermiques. Notez que les câbles du connecteur 6 broches sont… soudés à la carte.

Le PCB de la GTX 1060 permettrait de placer jusqu’à 8 Go de mémoire vive GDDR5, mais deux emplacements ne sont pas occupés. Les puces sont des Samsung K4G80325FB-HC25 GDDR5, qui tournent entre 1,305 V et 1,597 V, en fonction de leur fréquence. Le contrôleur PWM n’est pas documenté, c’est un uPI uP9509, une version inférieure à celui des GTX 1080 et 1070 (uP9511P).

Les puces de mémoire et une phase de l’alimentation du GPU exploitent l’alimentation du slot de l’interface PCI Express. Les deux autres phases du GPU sont alimentées par le connecteur 6 broches. Nous verrons la distribution de la consommation en détail dans les pages suivantes.

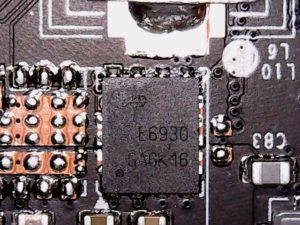

Pour la régulation de la tension, NVIDIA n’utilise qu’un seul MOSFET Dual N-Channel, le E6930, pour chaque phase. Un composant hautement intégré qui permet de libérer de la place sur le PCB. Les trois phases du GPU sont largement suffisantes, et leur distribution a plus de sens que celle de la Radeon RX 480.

Excepté le connecteur 6 broches qui semble avoir pris un mauvais virage lors de la conception de la carte, la GTX 1060 de référence de NVIDIA se présente très bien. Au regard de son faible TDP, son ventilateur radial ne semble pas être un mauvais choix.

Méthode de test

La GeForce GTX 1060 est surtout prévue pour du jeu en définition 1080p, même si elle offre des performances confortables en 1440p. Nous avons donc testé la carte dans ces deux définitions : 1920 x 1080 pixels et 2560 x 1440 pixels, comme la Radeon RX 480. Nous avons, cette fois, ajouté la GTX 1070, même si elle ne joue pas dans la même division, car elle est le modèle juste au dessus. Et nous avons refait tous les tests de la RX 480 avec les nouveaux pilotes Crimson Edition 16.7.2, qui corrigent les problèmes de consommation de la carte.

Les autres cartes NVIDIA sont testées avec les pilotes GeForce 368.39, et les Radeon R9 390 avec les Crimson Edition 16.6.2. La plateforme de test reste la même par rapport au test de la GTX 1080, sous Windows 10 Pro :

« Au lieu de notre Haswell-E Core i7-5930K à 3,5 GHz, nous avons utilisé un Skylake Core i7-6700K à 4 GHz, ce qui nous a permis de sauter une architecture et gagner 500 MHz. Nous avons donc dû changer de carte mère pour passer à une MSI Z170A Gaming M7 et nous avons utilisé 16 Go de DDR4-3000 sous la forme des G.Skill F4-3000C15Q-16GRR. Nous gardons notre SSD Crucial MX200, le ventilateur Noctua NH-12S et l’alimentation be quiet! Dark Power Pro 10 850W. Nous avons enfin formaté le support de stockage et installé Windows 10 Professionnel ainsi qu’une nouvelle série de jeux DirectX 11 et DirectX 12. »

Les cartes comparées ne sont pas toutes des modèles de références, et leurs fréquences sont parfois overclockées. Voici un tableau complet des fréquences des cartes en présence :

| Fréquence GPU et RAM de la carte | Fréquence GPU et RAM de référence | |

|---|---|---|

| Nvidia GeForce GTX 1060 | 1506/2000 MHz | 1506/2000 MHz |

| Nvidia GeForce GTX 1070 | 1506/2000 MHz | 1506/2000 MHz |

| AMD Radeon RX 480 | 1266/2000 MHz | 1266/2000 MHz |

| MSI R9 390X Gaming 8G | 1080/1500 MHz | 1050/1500 MHz |

| MSI R9 390 Gaming 8G | 1040/1500 MHz | 1000/1500 MHz |

| MSI GTX 980 Gaming 4G | 1190/1752 MHz | 1126/1752 MHz |

| Gigabyte GTX 970 G1 Gaming | 1178/1752 MHz | 1050/1752 MHz |

| MSI GTX 960 Gaming 2G | 1190/1752 MHz | 1127/1752 MHz |

Les jeux testés ne changent pas non plus :

| Ashes of the Singularity |

| DirectX 12, mode Extreme quality, benchmark intégré |

| Battlefield 4 |

| DirectX 11, mode Ultra quality, test Tom’s Hardware (Tashgar jeep ride), enregistrement Fraps de 100 secondes |

| Grand Theft Auto V |

| DirectX 11, mode Very High quality, 4x MSAA, benchmark intégré (test five), enregistrement Fraps de 110 secondes |

| Hitman (2016) |

| DirectX 11, mode Ultra, FXAA, texture High, benchmark intégré, enregistrement Fraps de 100 secondes |

| Metro Last Light Redux |

| DirectX 11, mode Very High, SSAA désactivé, 16x AF, Normal Motion Blur, Normal Tessellation, benchmark intégré, enregistrement Fraps de 145 secondes |

| Project CARS |

| DirectX 11, mode Ultra, High anti-aliasing, texture High, Nürburgring Sprint, enregistrement Fraps de 100 secondes |

| Rise Of The Tomb Raider |

| DirectX 11, mode qualité Custom, détails Very High, benchmark intégré, enregistrement Fraps de 80 secondes |

| Tom Clancy’s The Division |

| DirectX 11, mode qualité Custom, options Ultra, Supersampling temporal AA, benchmark intéré, enregistrement Fraps de 90 secondes |

| The Witcher 3: Wild Hunt |

| DirectX 11, mode Highest quality, HairWorks désactivé, test Tom’s Hardware, enregistrement Fraps de 100 secondes |

Tests Ashes of the Singularity, Battlefield & GTA V

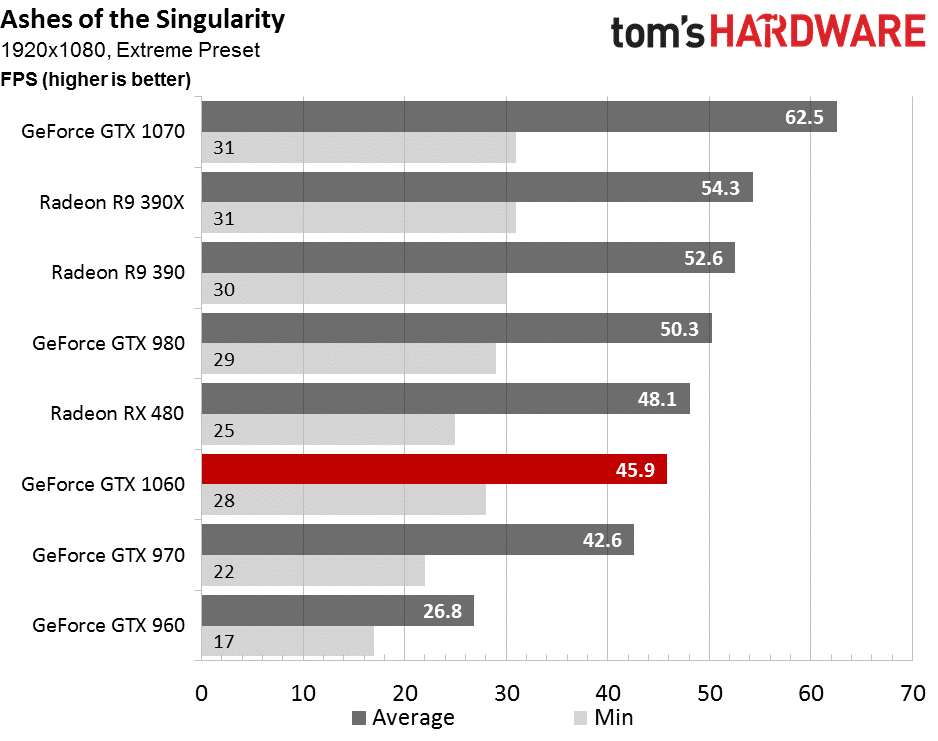

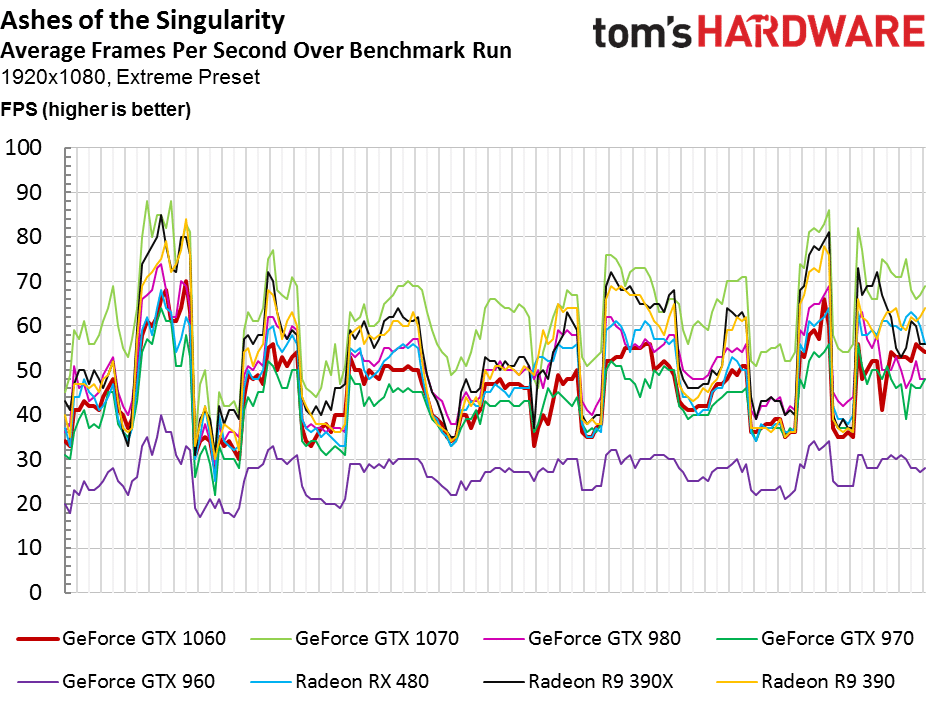

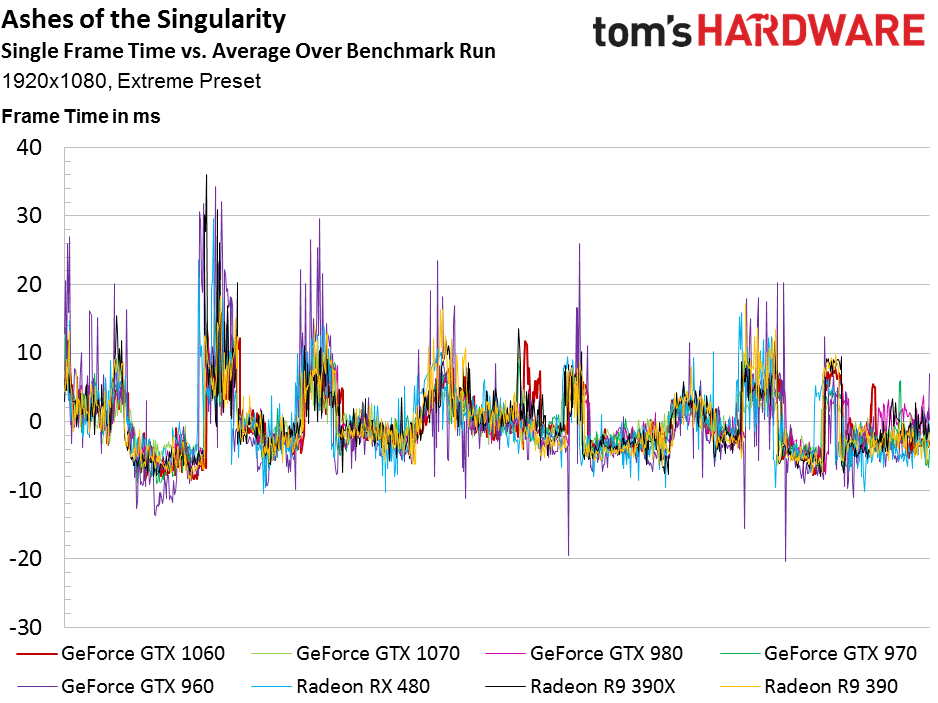

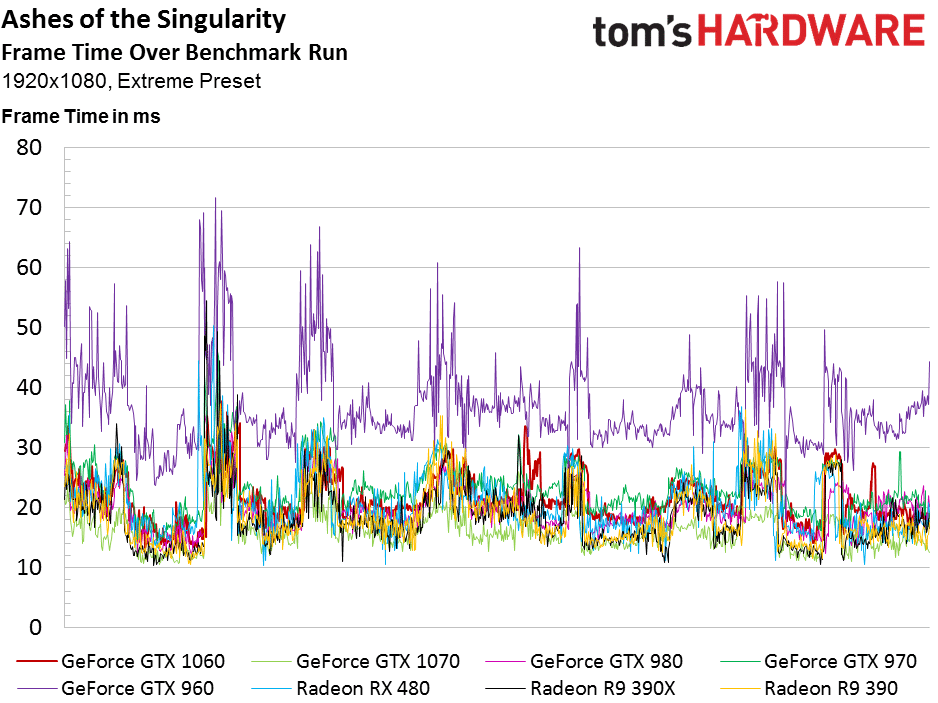

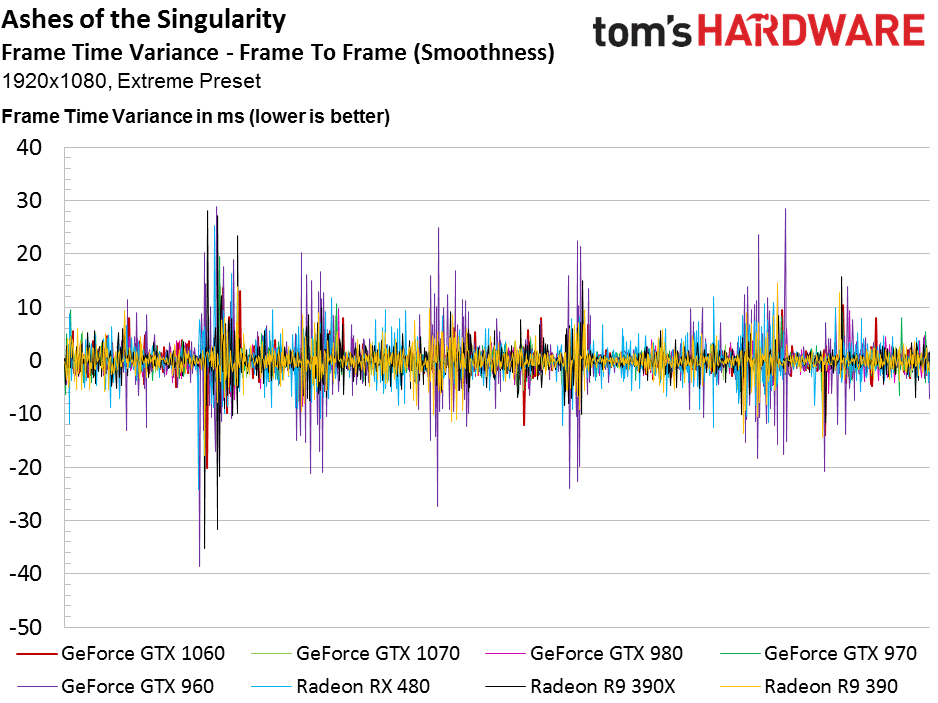

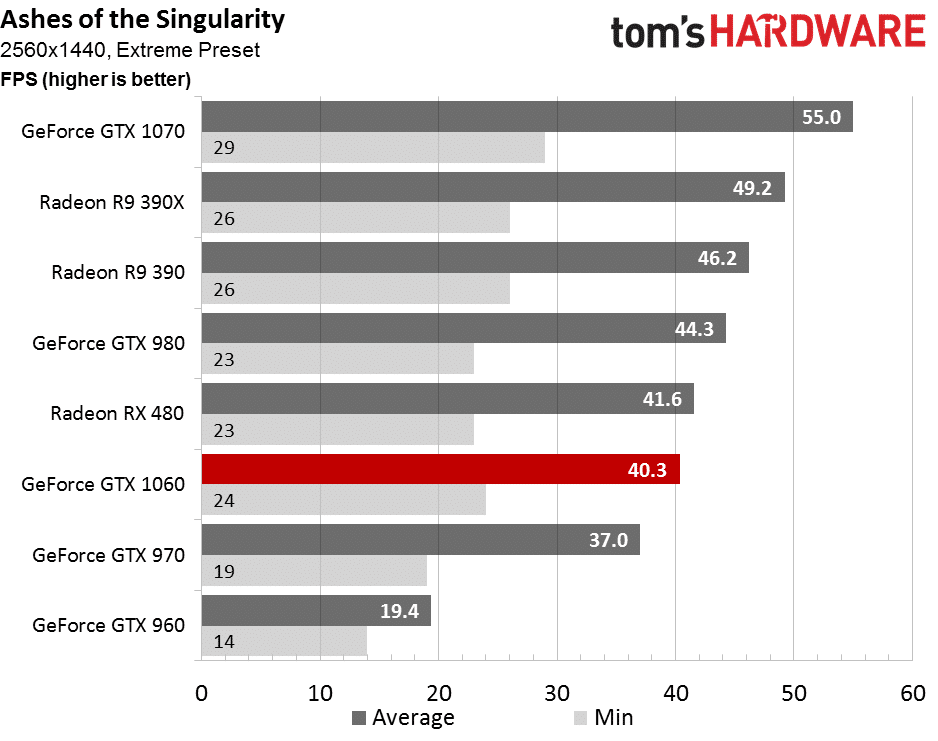

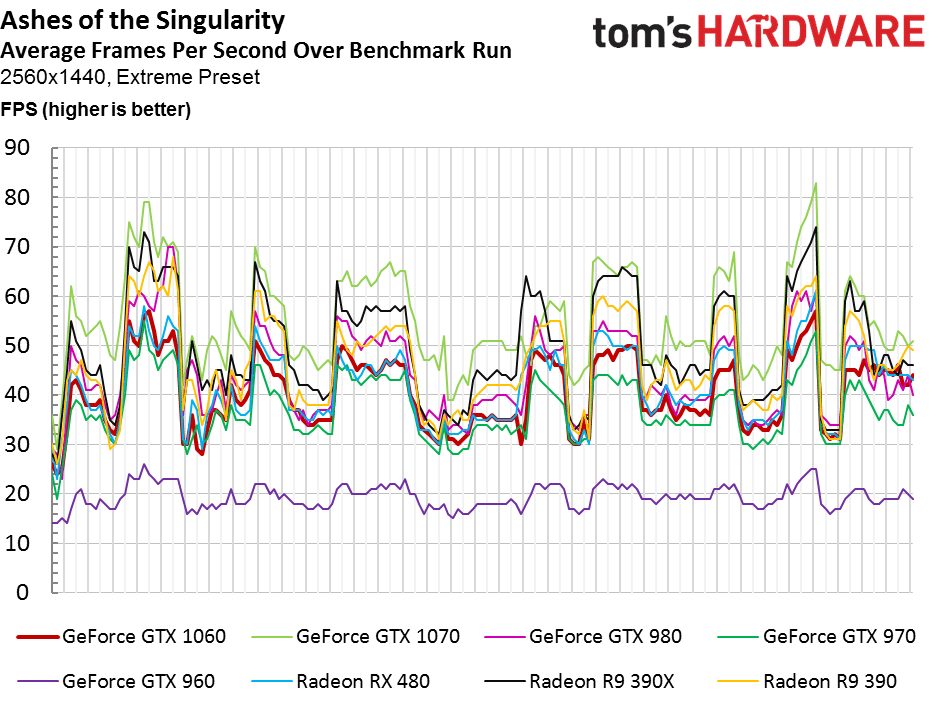

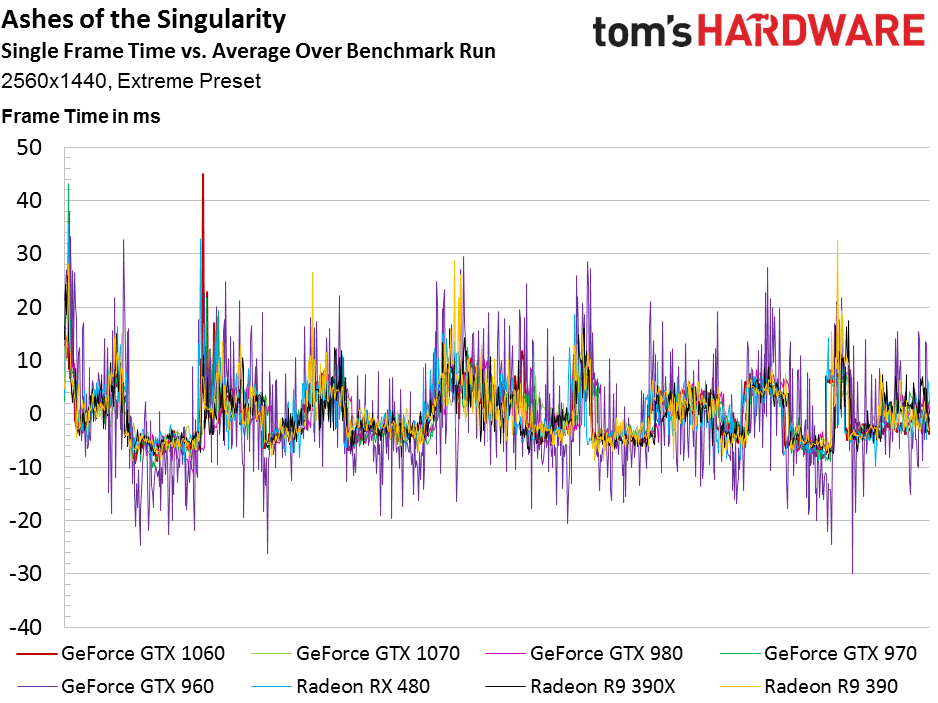

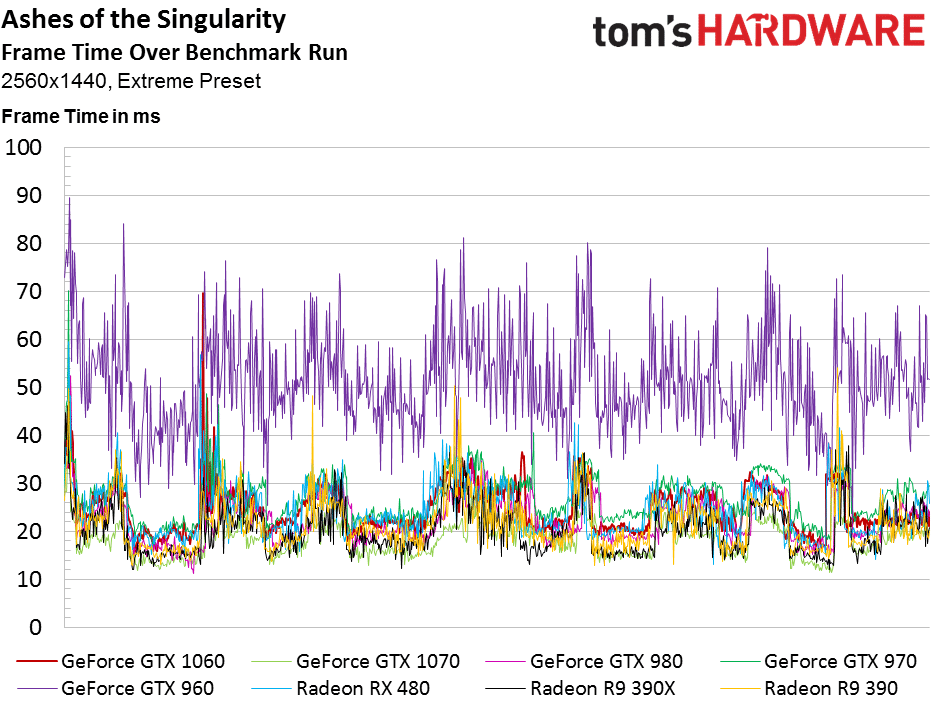

Ashes of the Singularity (DX12)

Les solides performances de la Radeon RX 480 dans ce test repoussent NVIDIA hors de son territoire. En fait, la GTX 1060 termine plutôt proche de la GTX 970, moins rapide que la GTX 980 qu’elle est censée remplacer. La GTX 1070 se trouve en première place, mais les Radeon R9 390 tiennent encore très bien la route.

Sans grande surprise, la tendance reste la même, avec une GTX 980 qui dépasse la carte Polaris 10 d’AMD, mais qui coûte beaucoup plus cher. Les cartes d’AMD sont impressionnantes dans ce test.

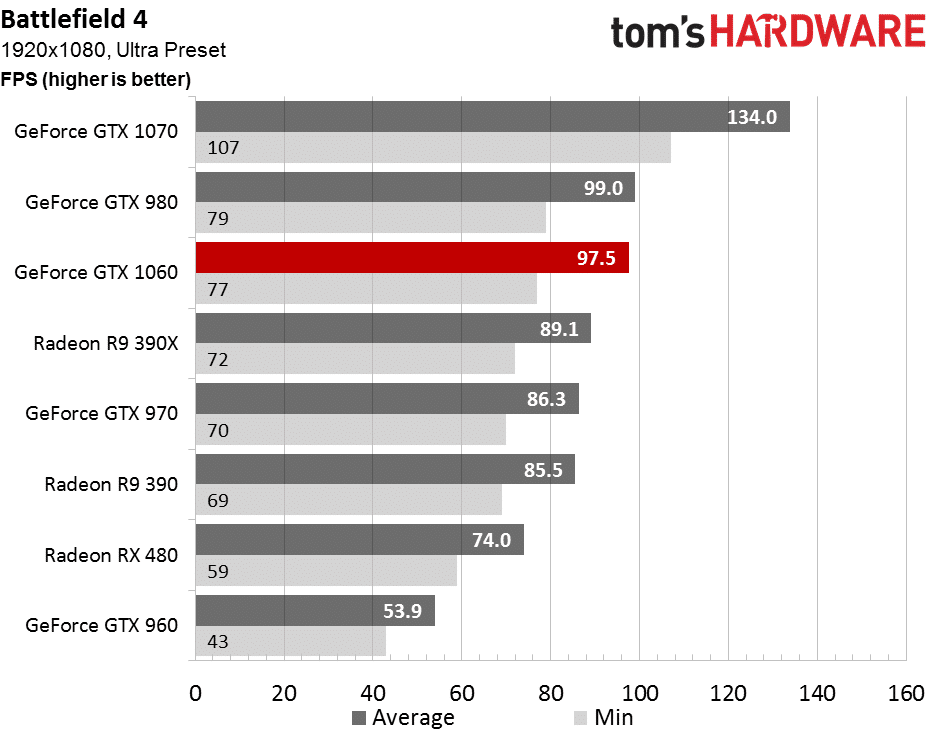

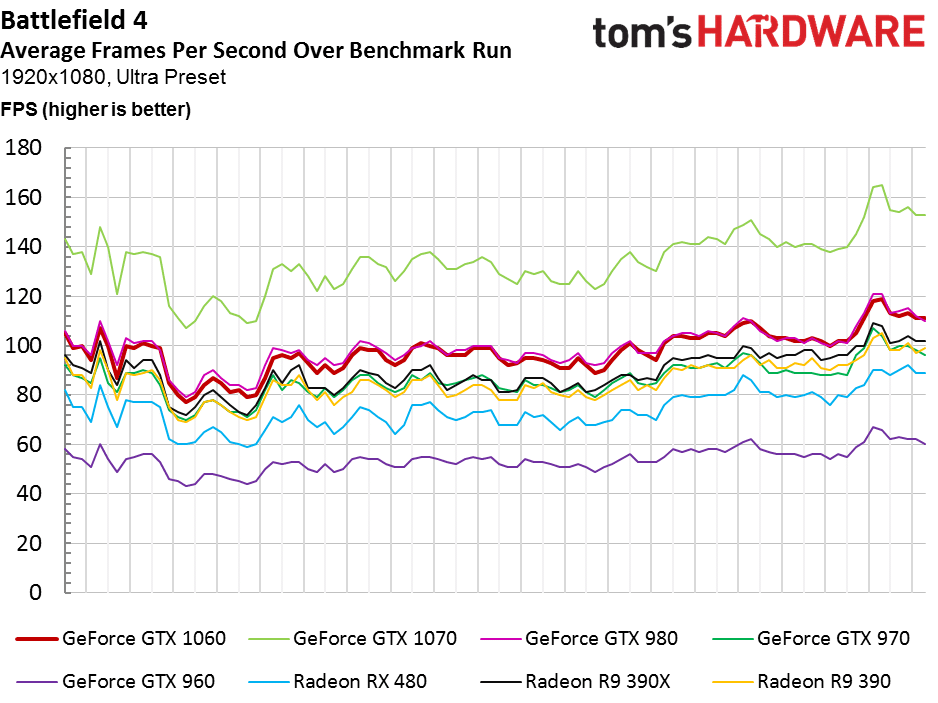

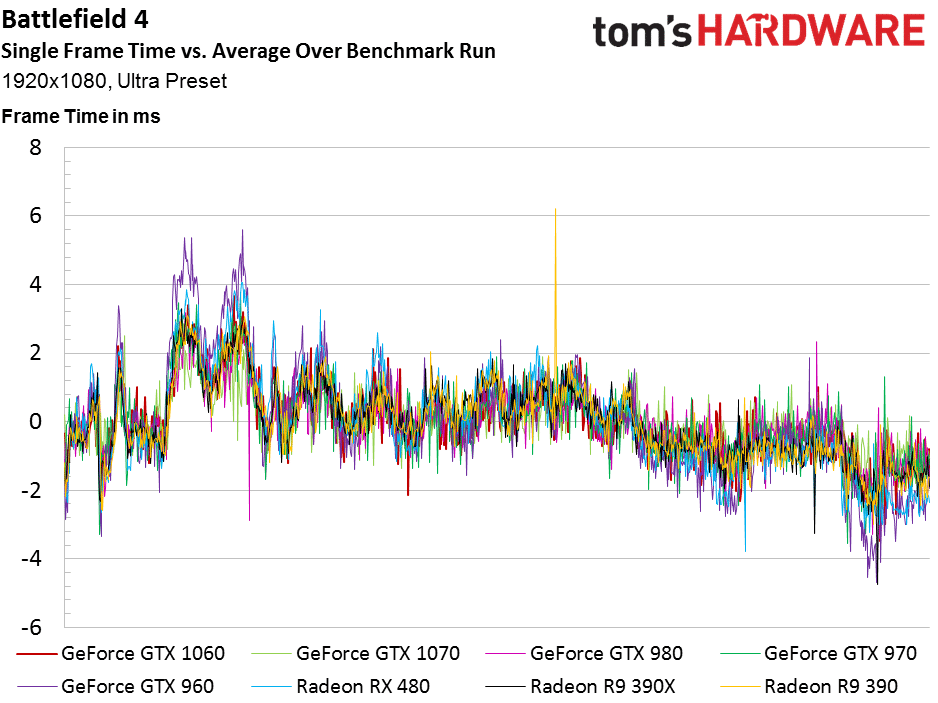

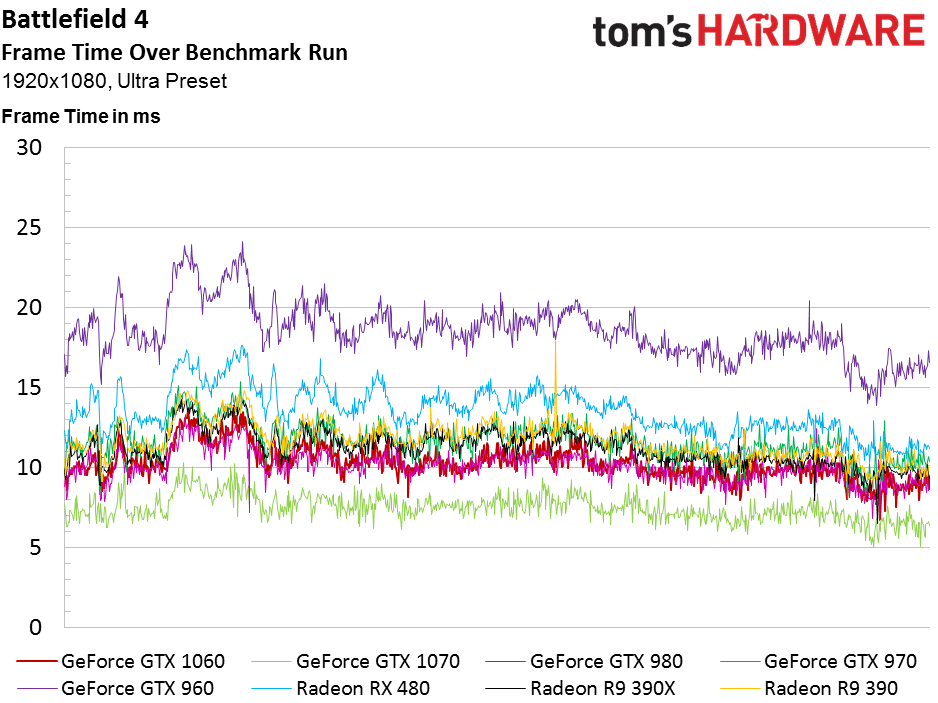

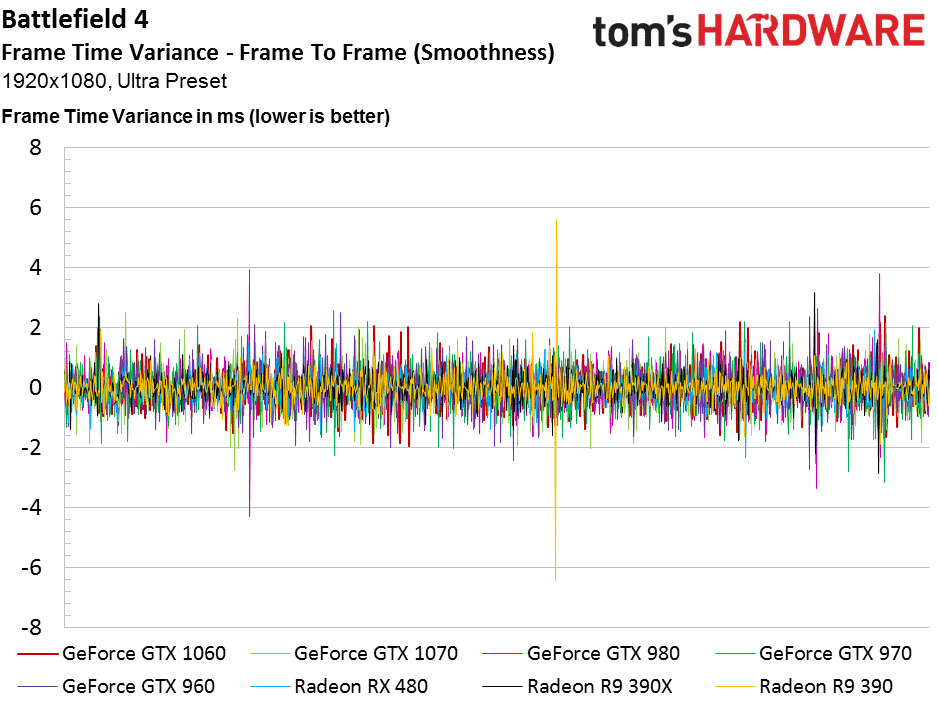

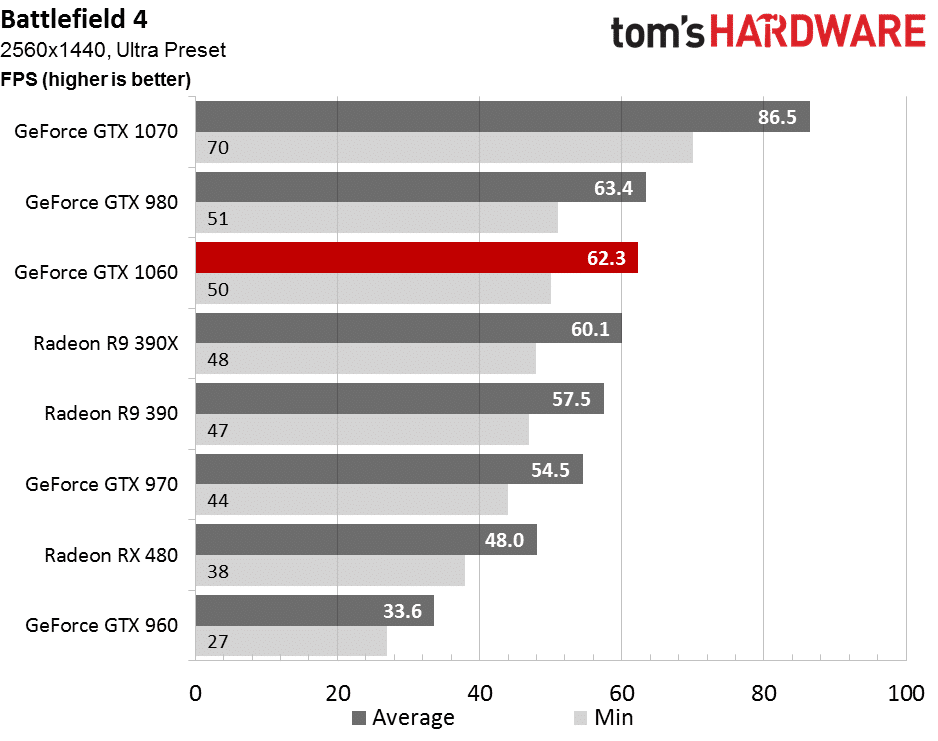

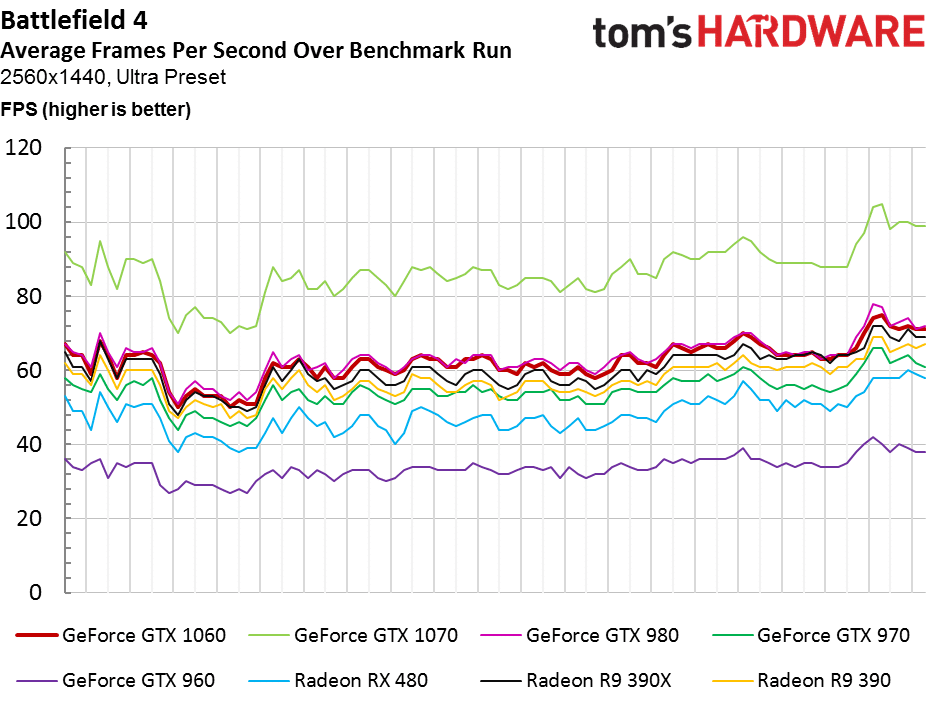

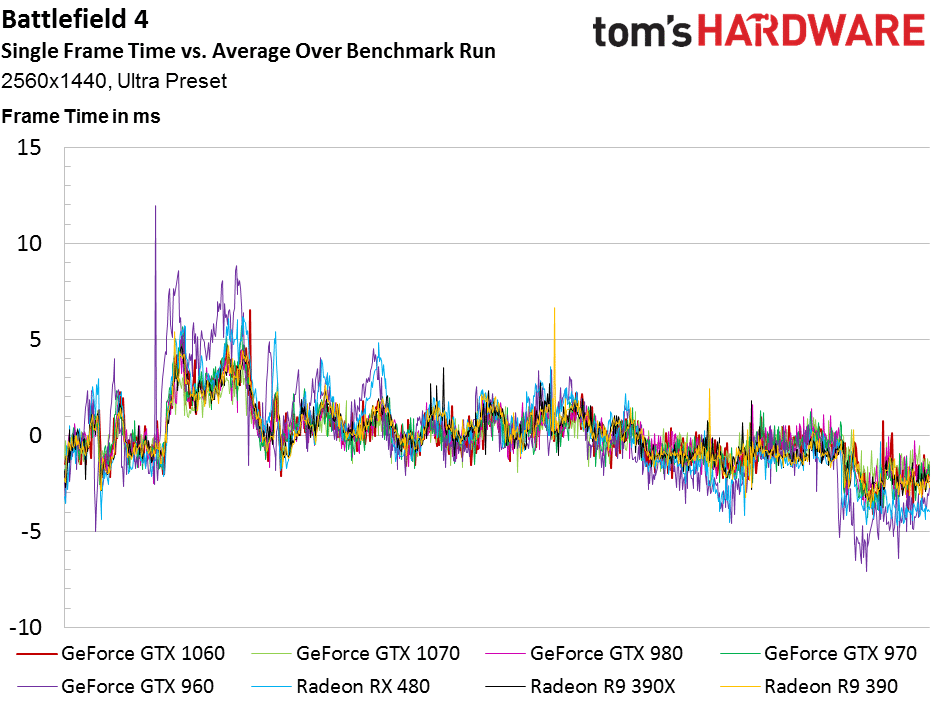

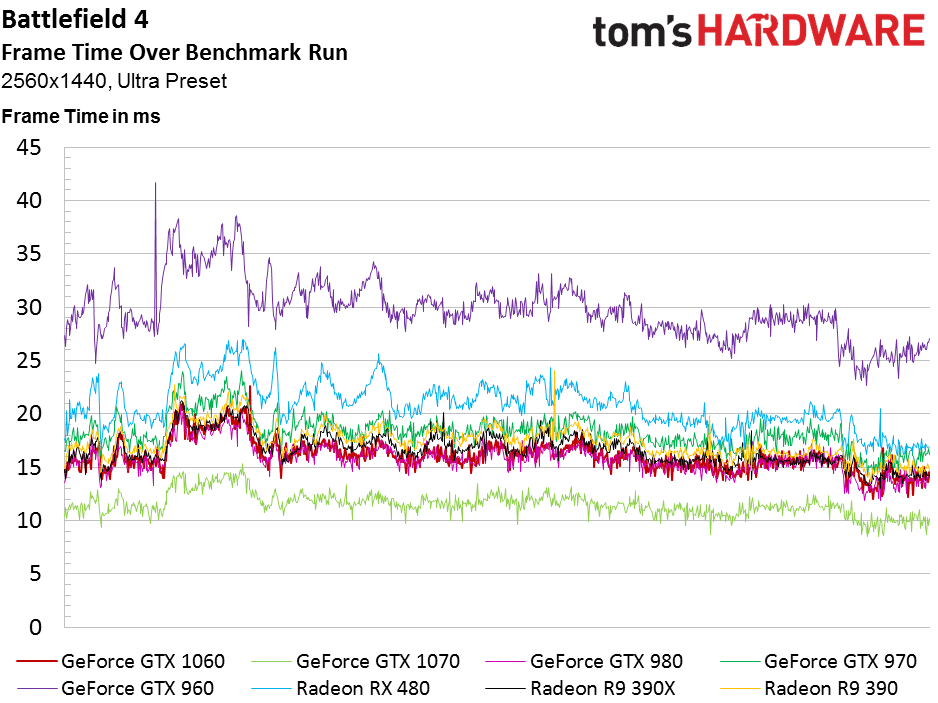

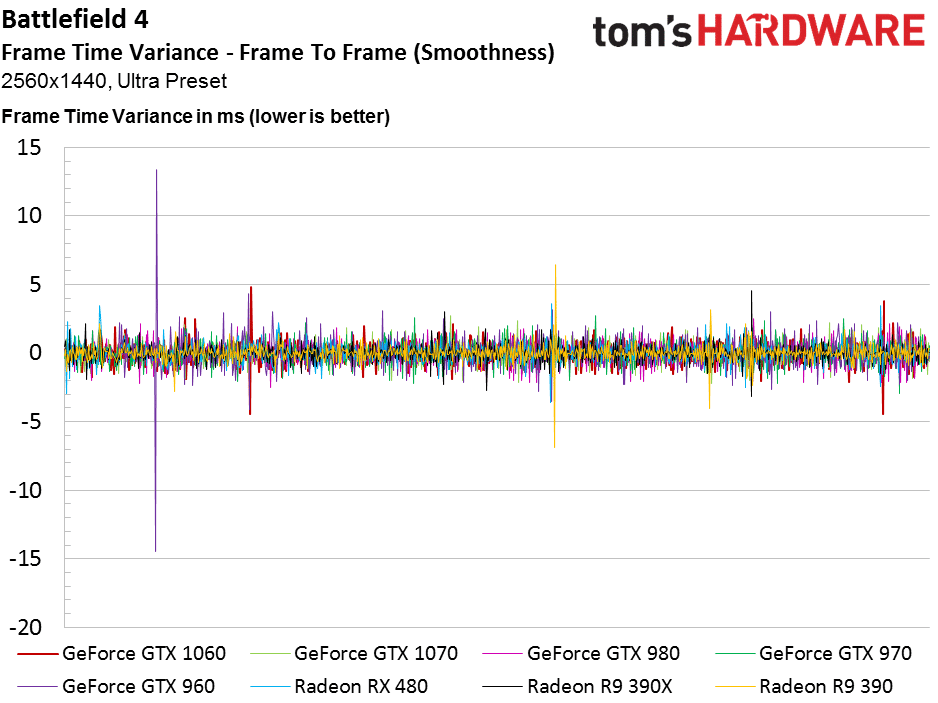

Battlefield 4 (DX11)

La GTX 1060 ne parvient pas à dépasser la 980 dans Battlefield 4, mais elle est très proche. Elle dépasse toutefois nettement les Radeon R9 et surtout la RX 480.

Le seul changement dans cette définition, c’est la GTX 970 qui perd une place au profit de la Radeon R9 390. La RX 480 reste en bas de tableau, sous la GTX 970.

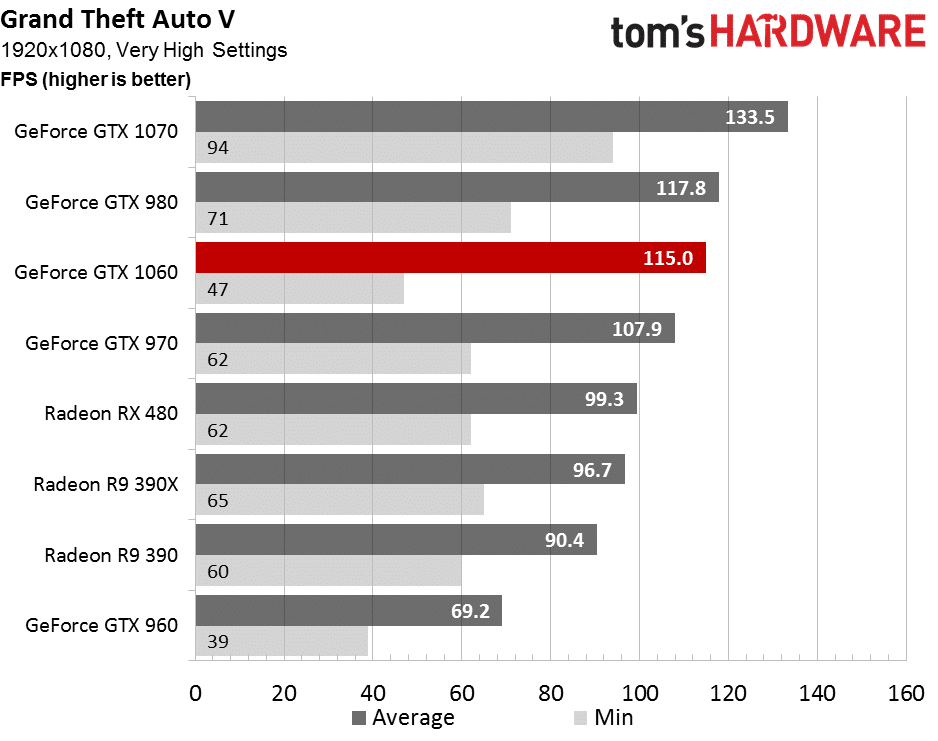

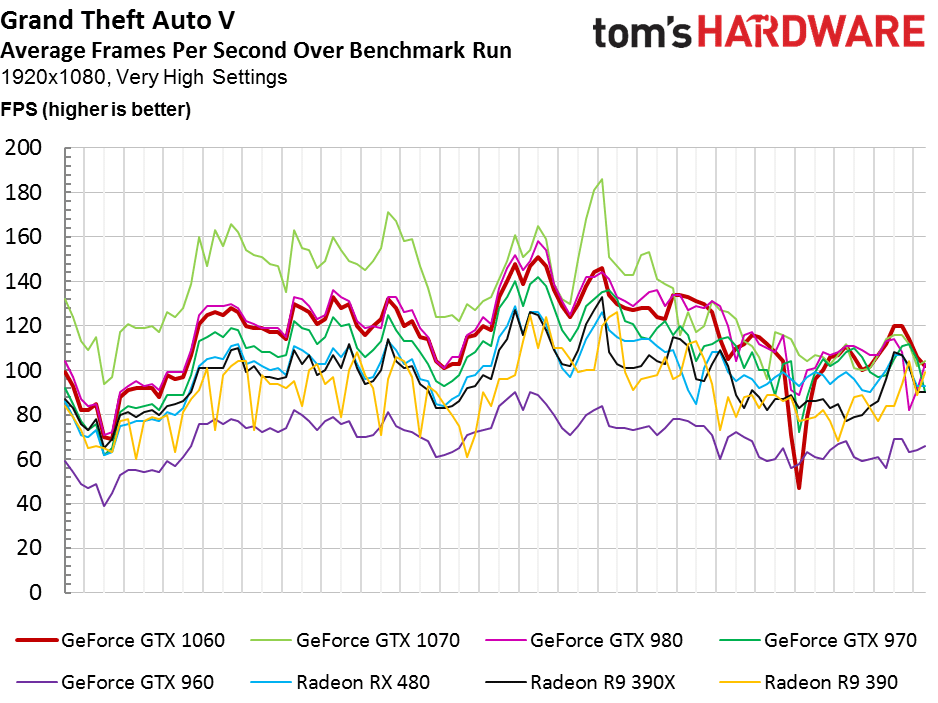

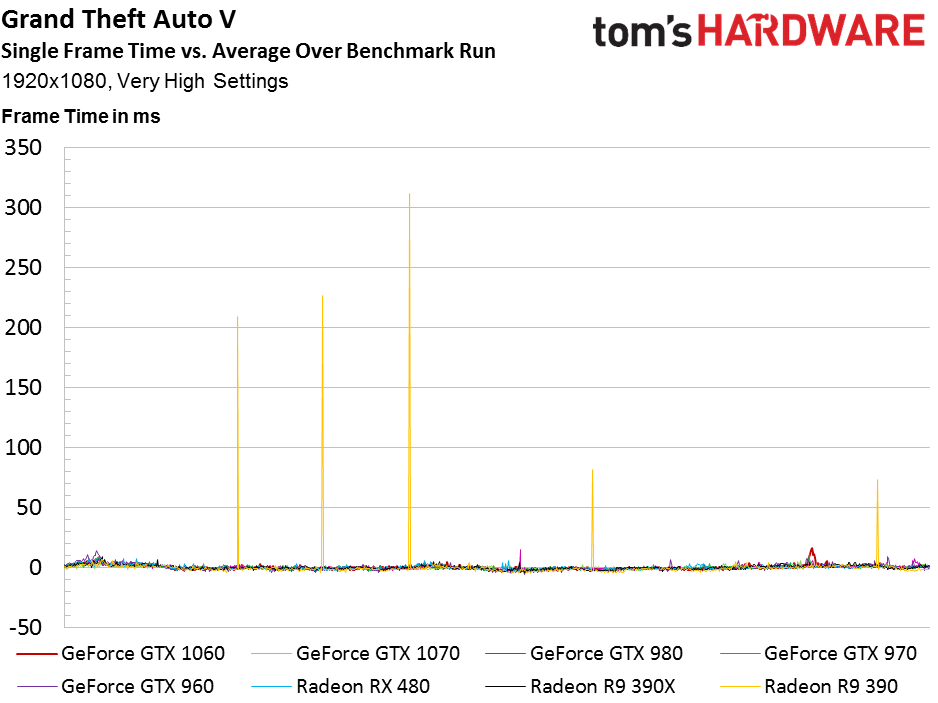

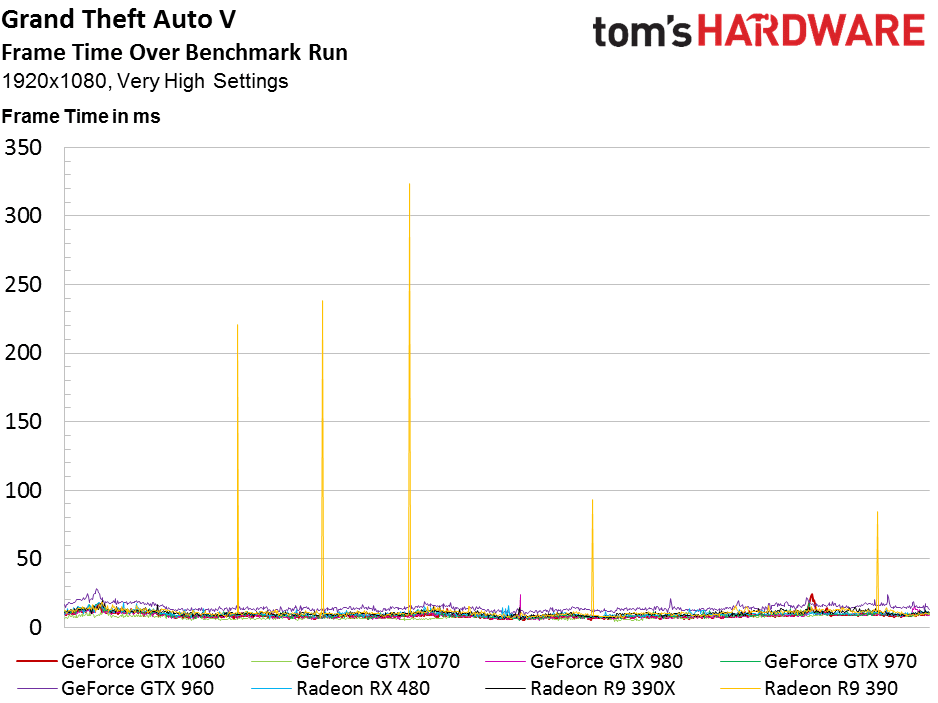

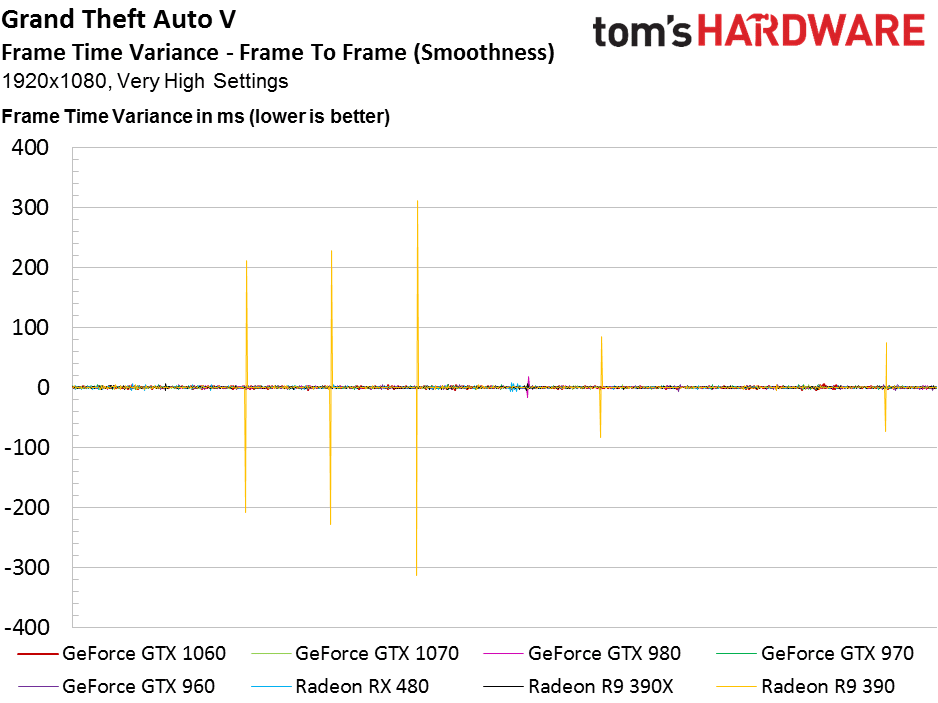

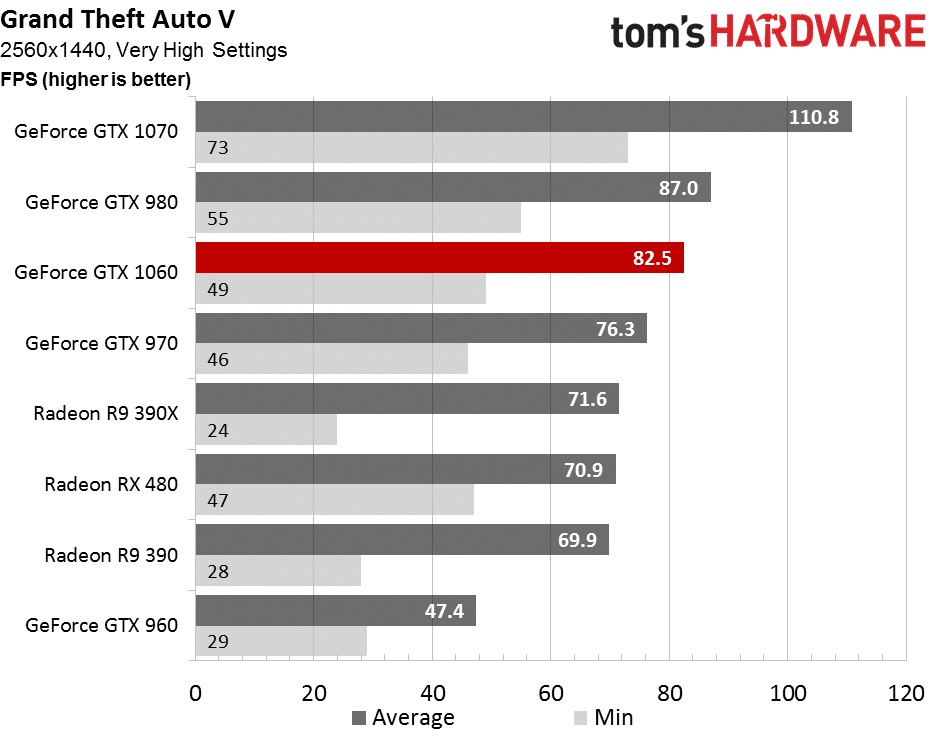

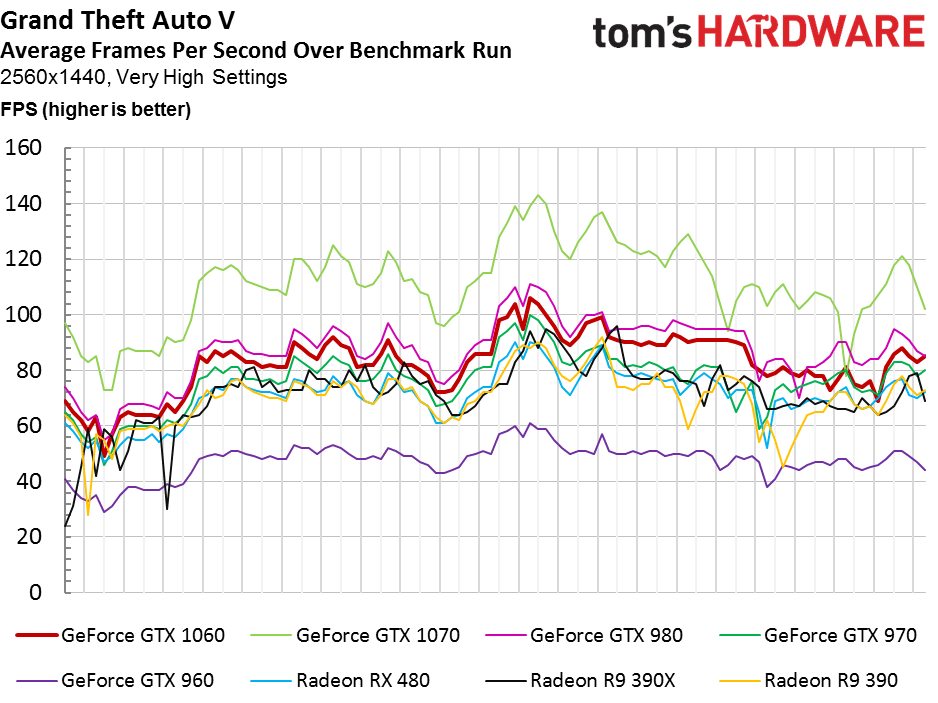

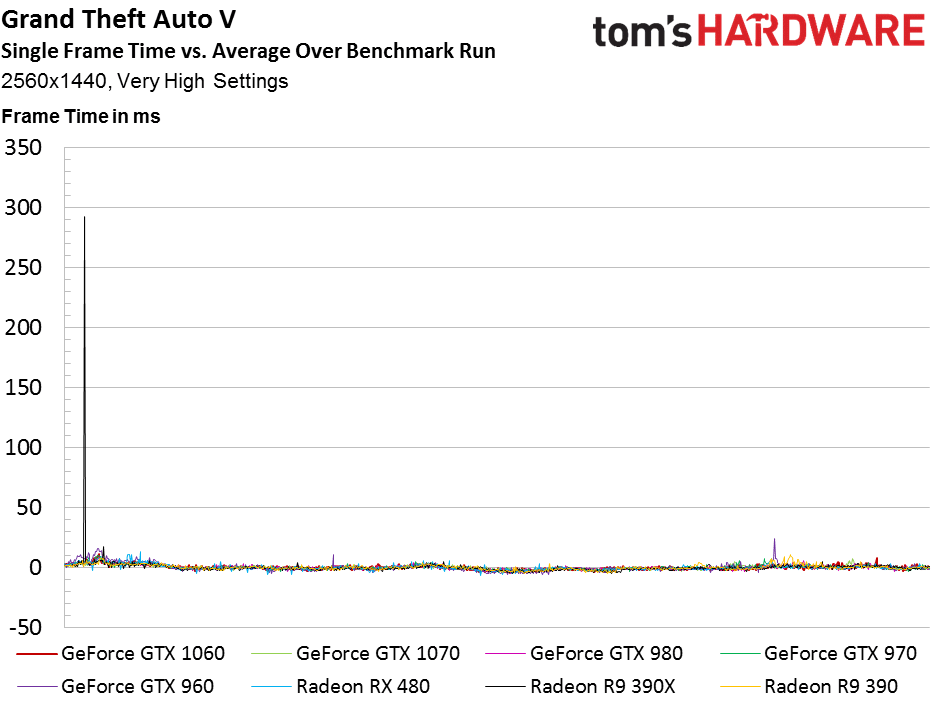

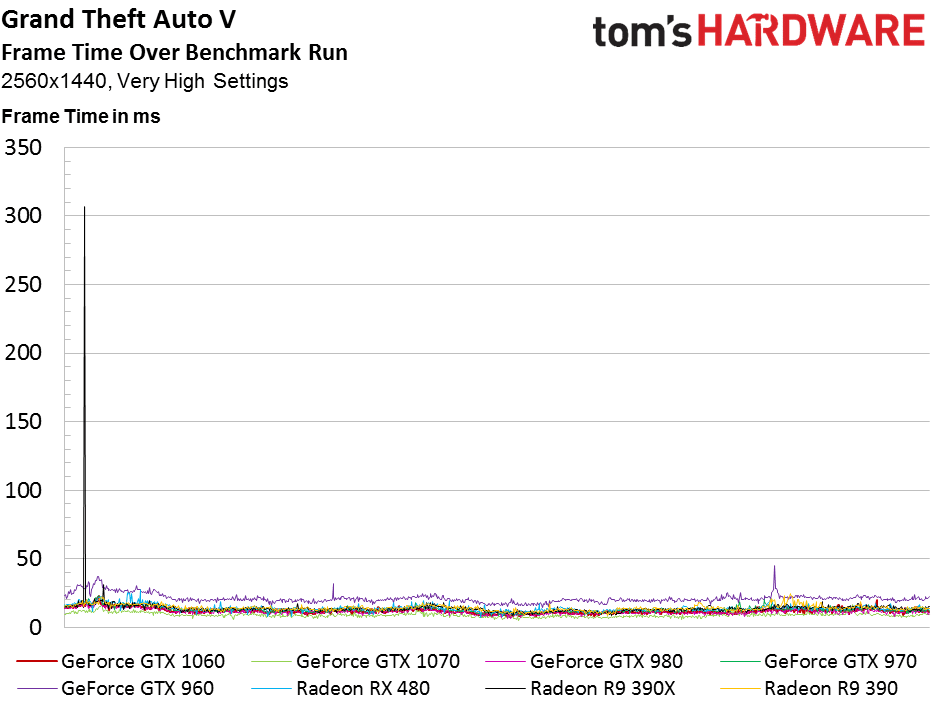

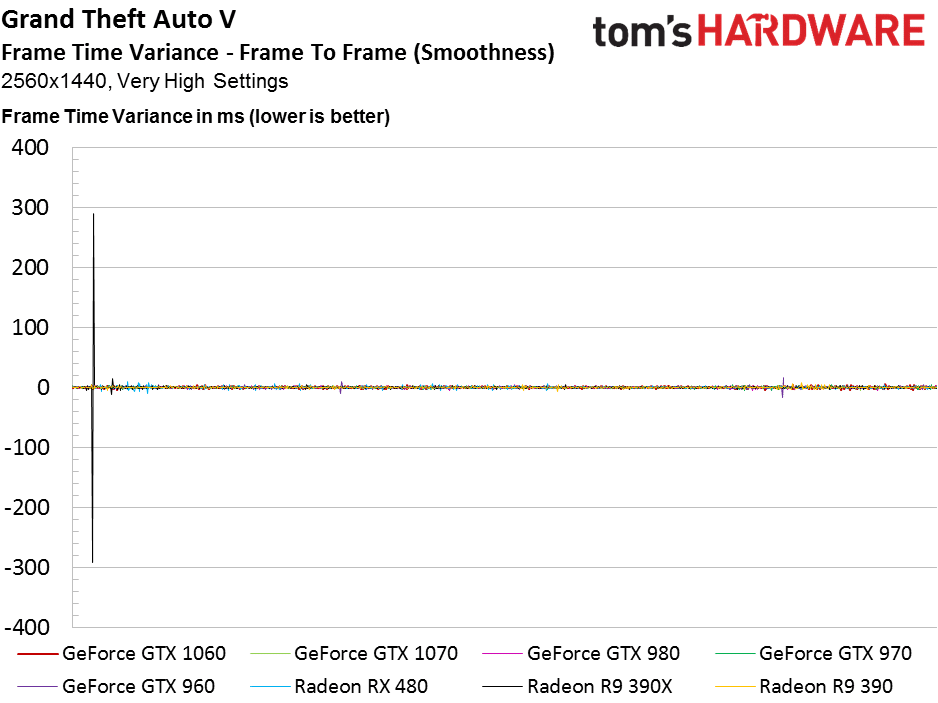

Grand Theft Auto V (DX11)

La GTX 1060 est, encore une fois, presque au même niveau que la GTX 980 dans GTA V, mais elle souffre à la fin du benchmark. La RX 480 dépasse les Radeon R9 390 en Full HD, mais reste sous la GTX 970.

Dans cette définition plus élevée, la GTX 1060 maintient un taux d’image par seconde jouable, toujours légèrement inférieur celui de la GTX 980. Mais elle est à peine plus rapide que la GTX 970, qui commence à être vendue à un prix nettement moins élevé.

Tests Hitman, Metro: Last Light Redux & Project CARS

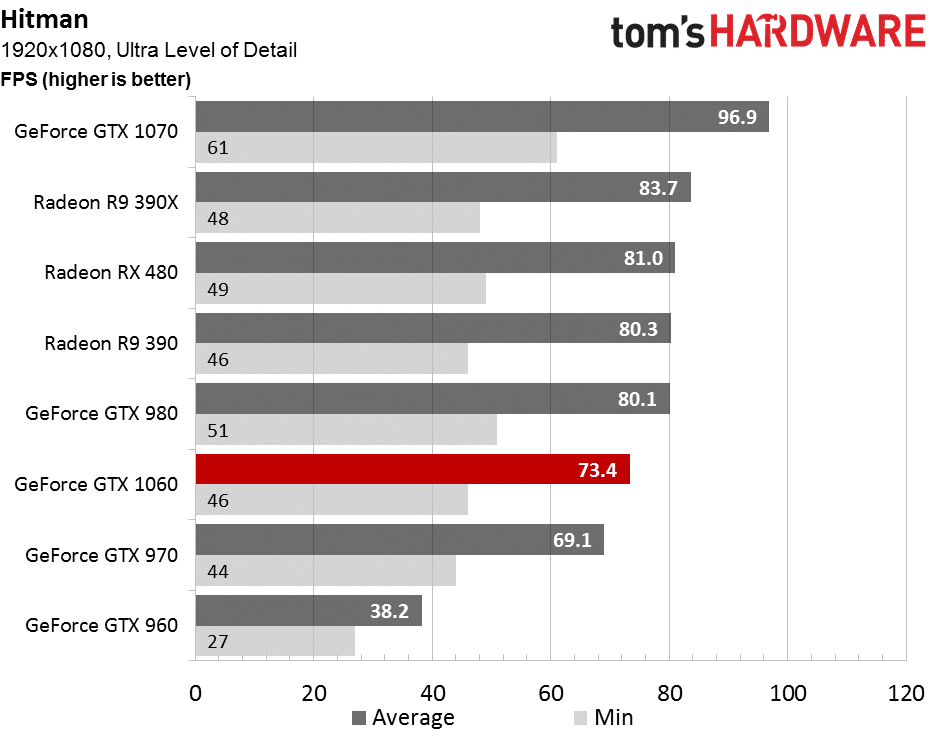

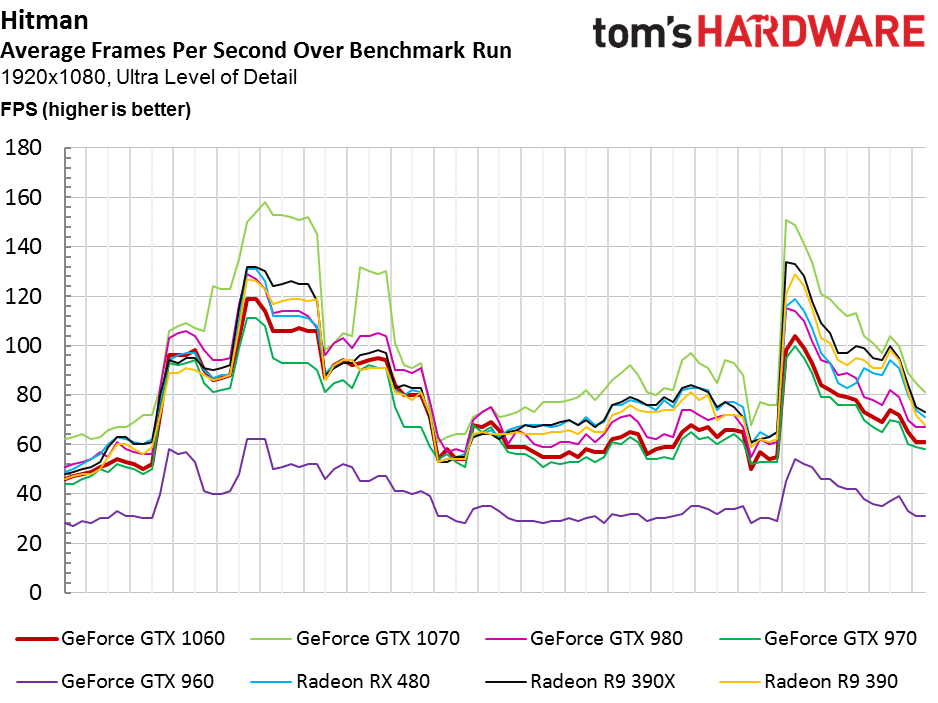

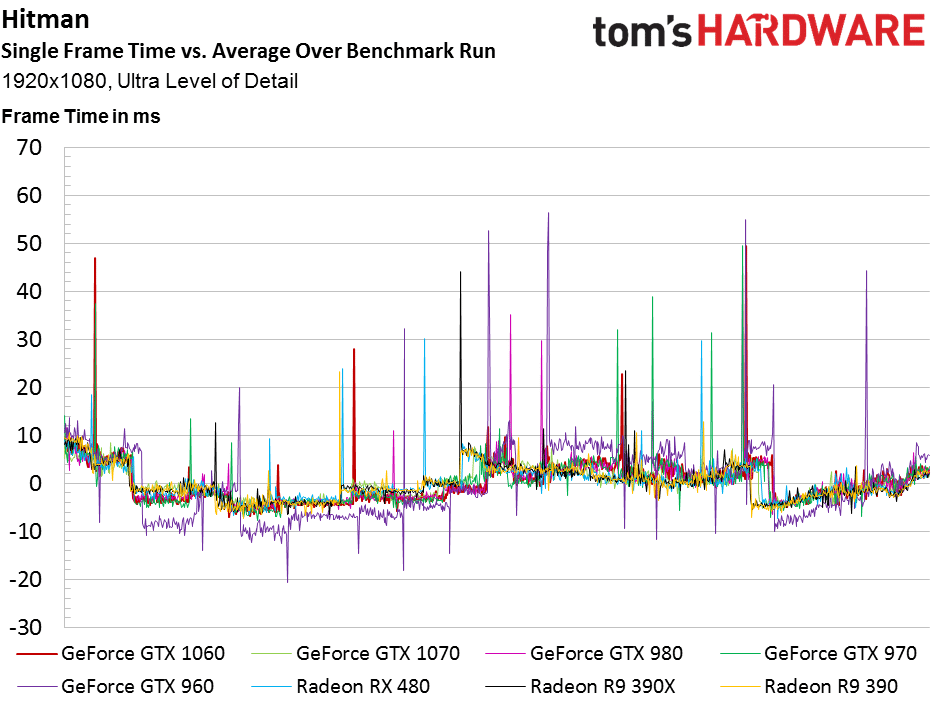

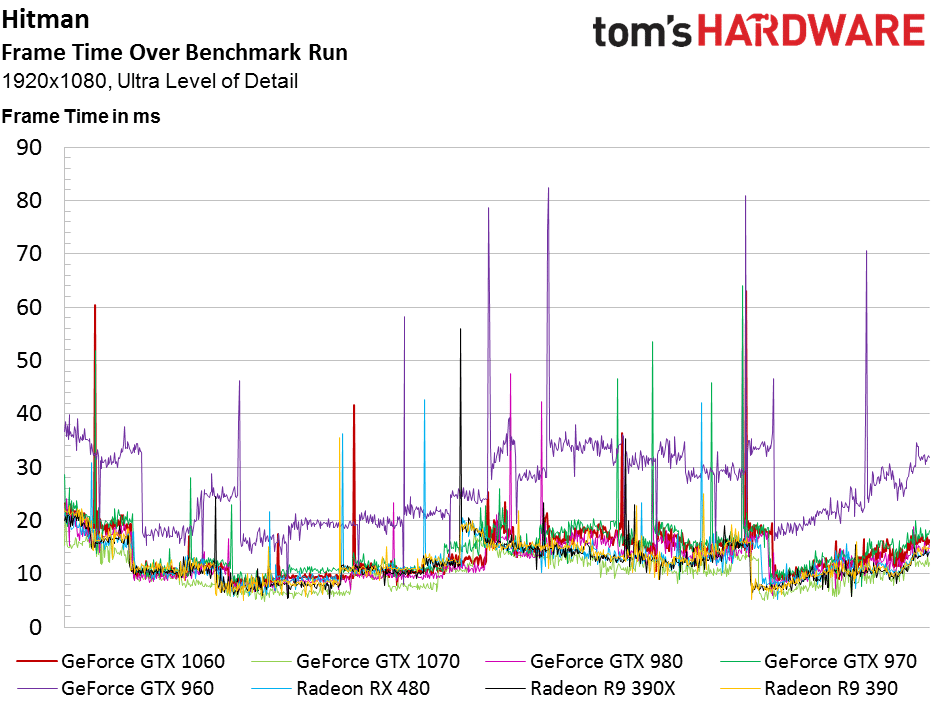

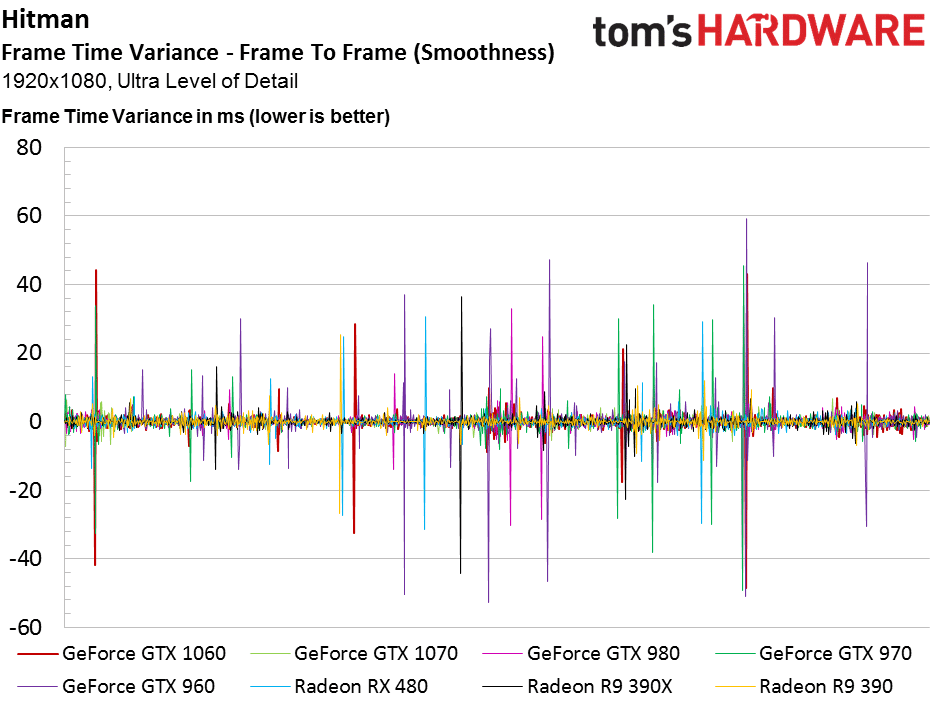

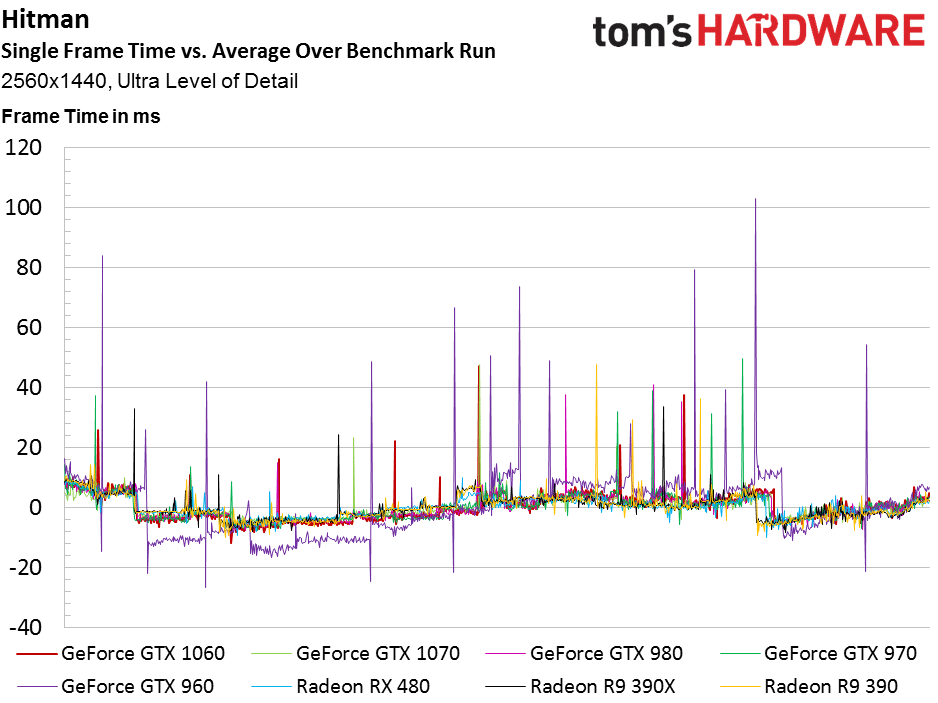

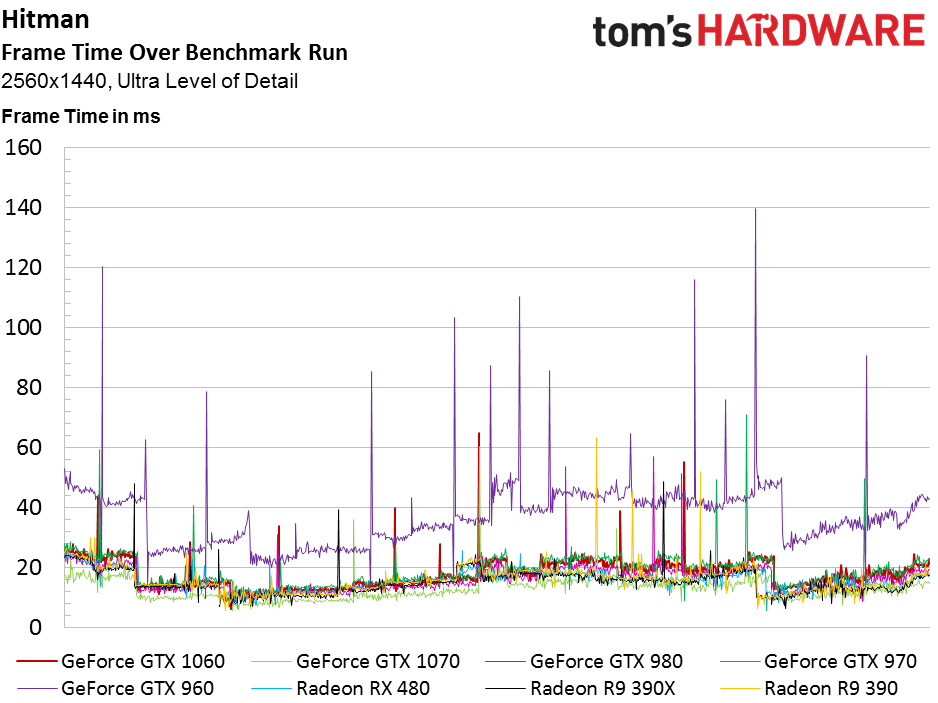

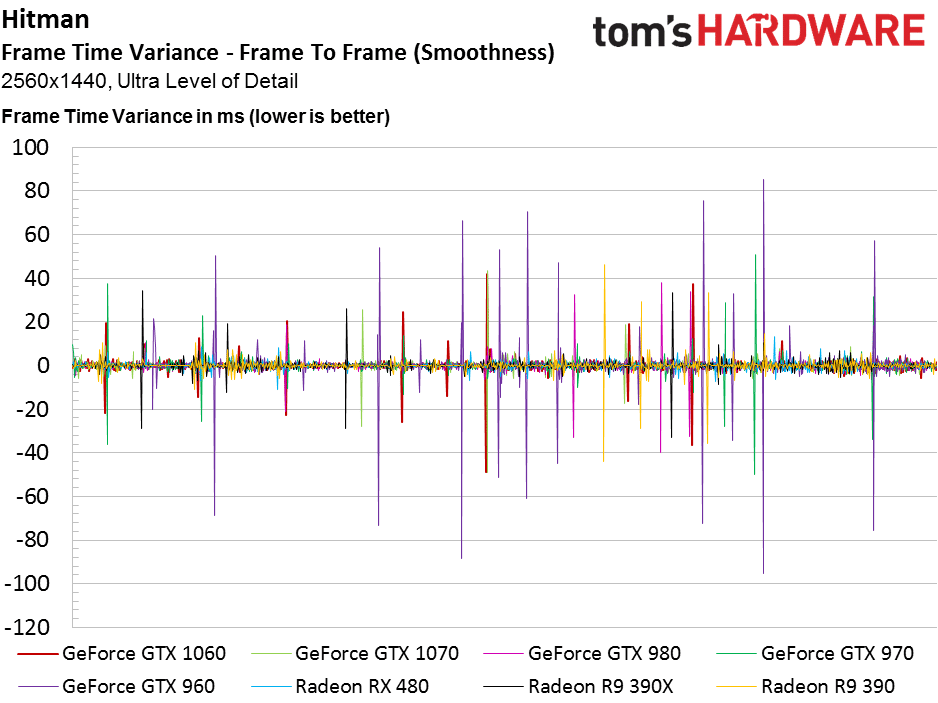

Hitman (DX11)

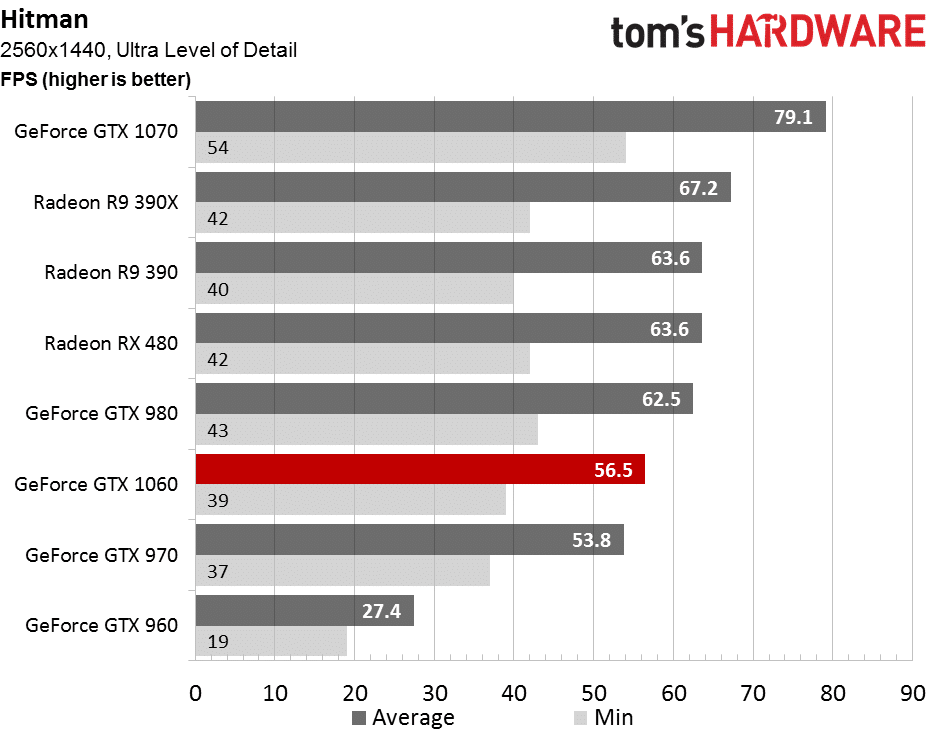

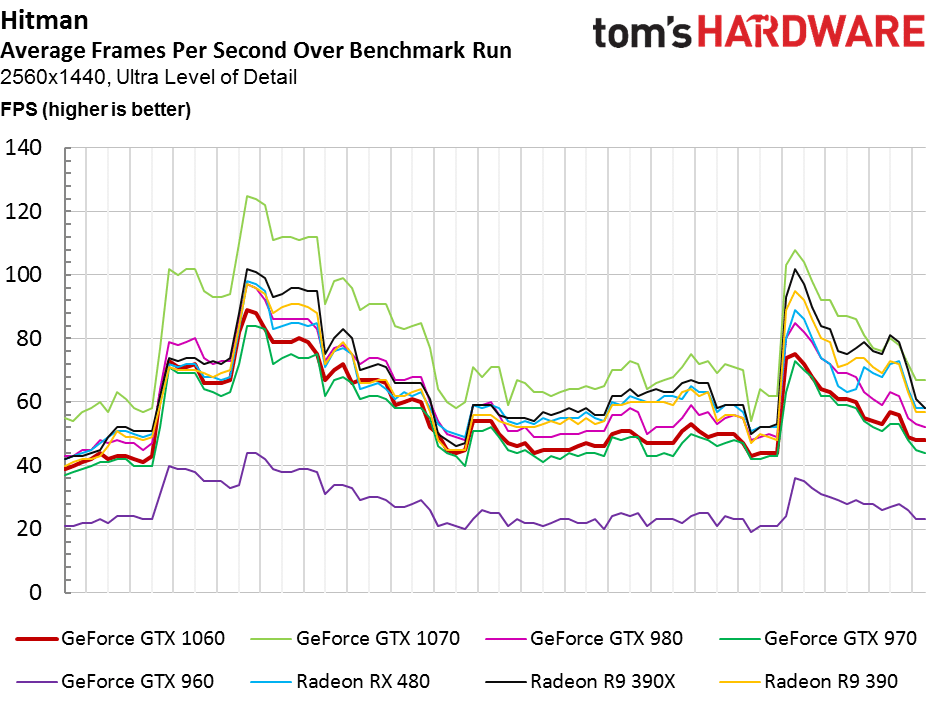

L’architecture GCN d’AMD est particulièrement à l’aise dans Hitman. Les Radeon R9 390 et RX 480 sont nettement au dessus de la GTX 1060, qui se maintien toutefois assez bien entre la GTX 980 et la 970. Cependant, pour une carte à 319 euros, c’est un peu juste.

Même tendance dans cette définition plus élevée. Notez que la RX 480 s’en sort encore très bien, plus rapide que les GTX 1080 et 970. La GTX 960 est totalement larguée, avec beaucoup de saccades visuelles.

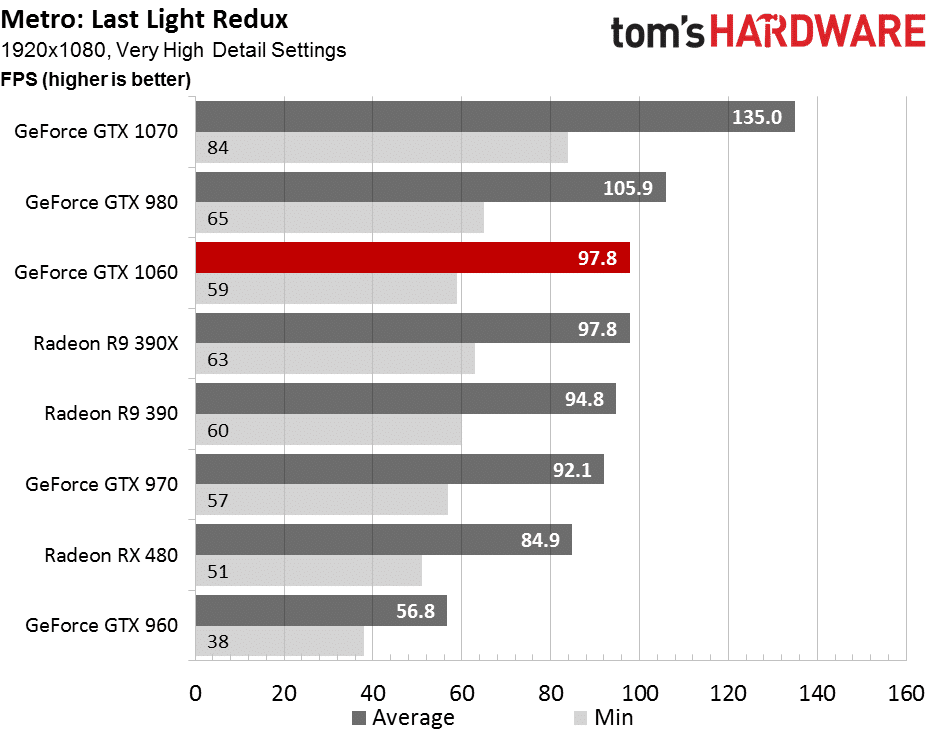

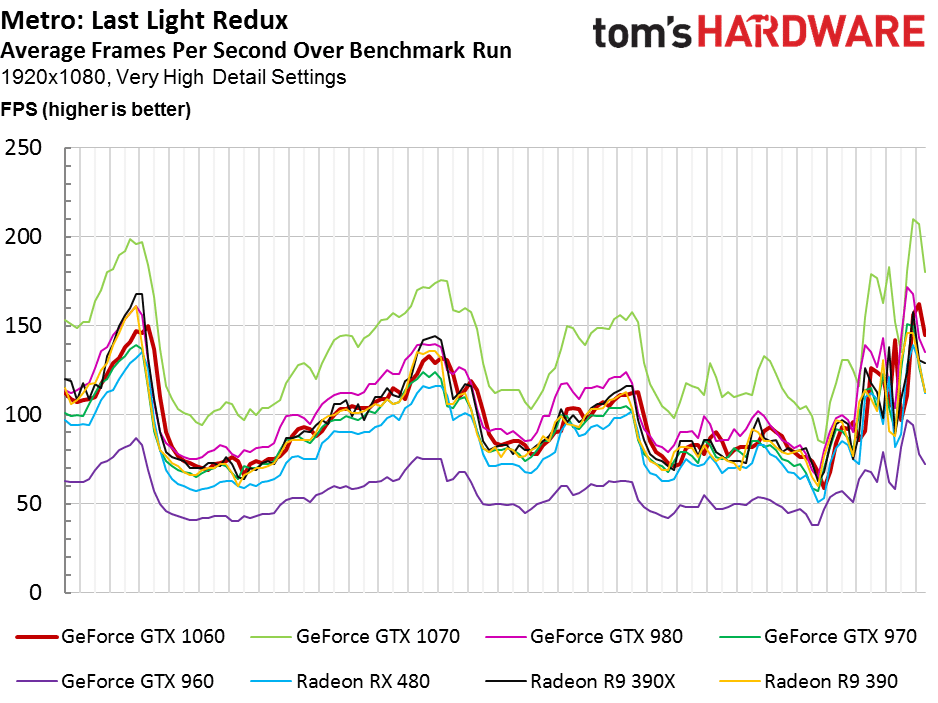

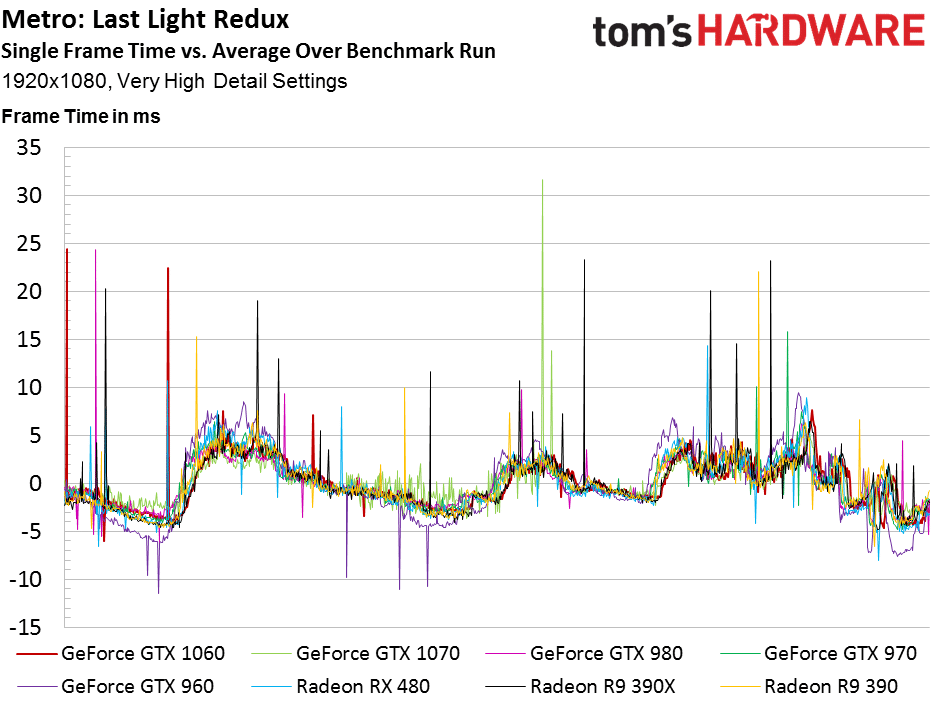

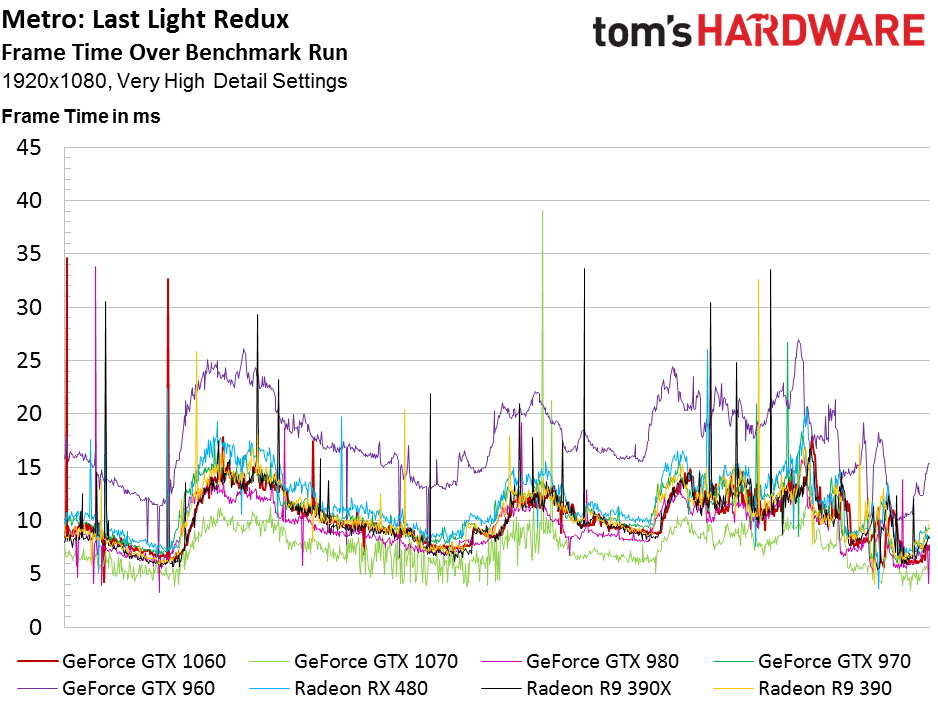

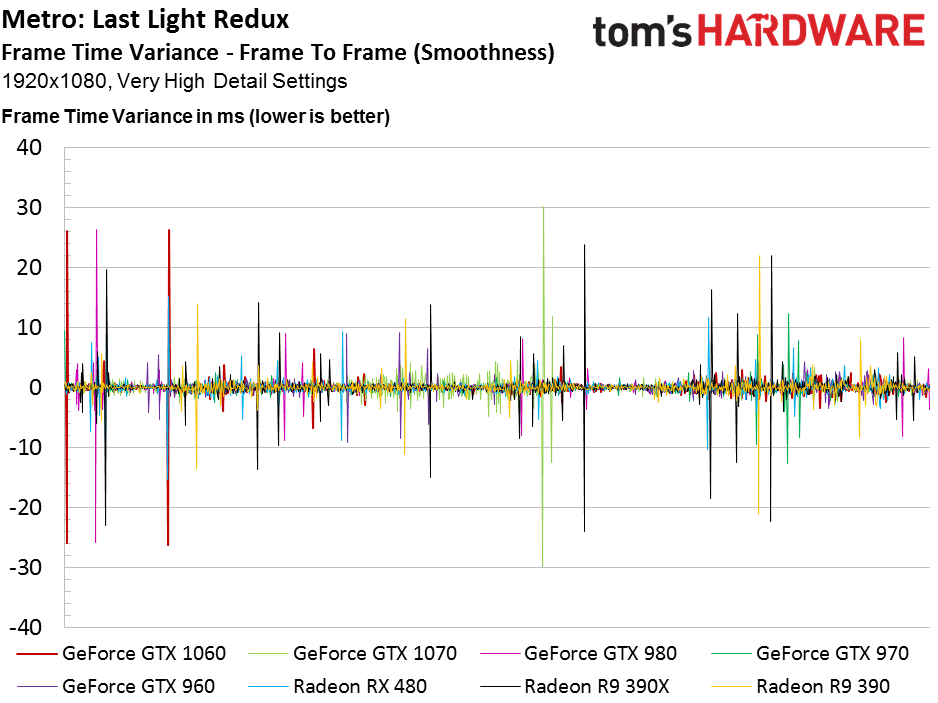

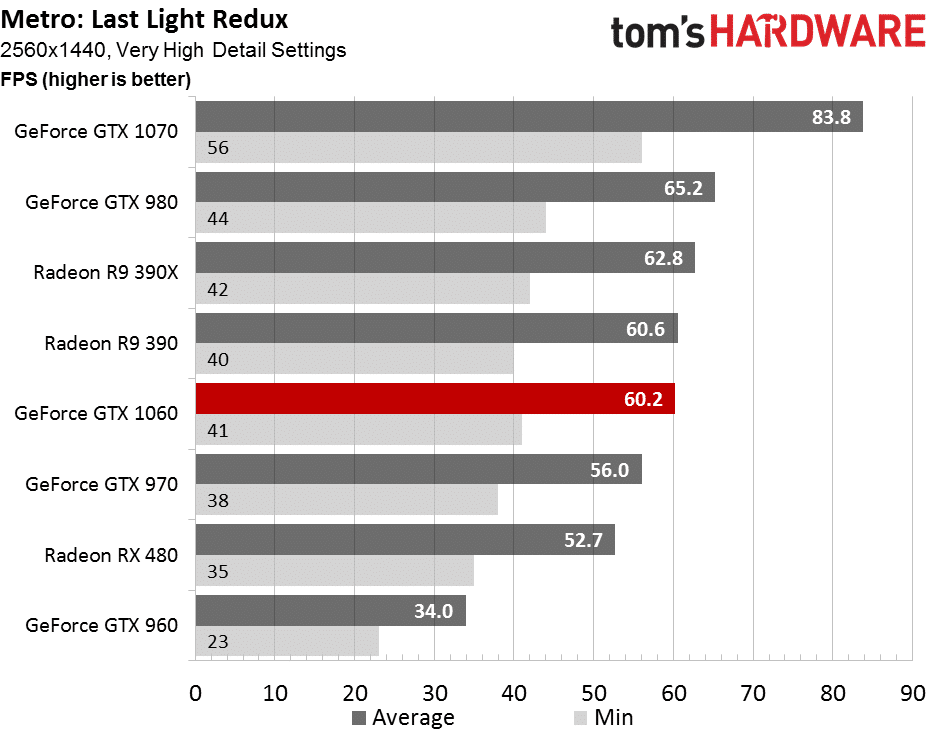

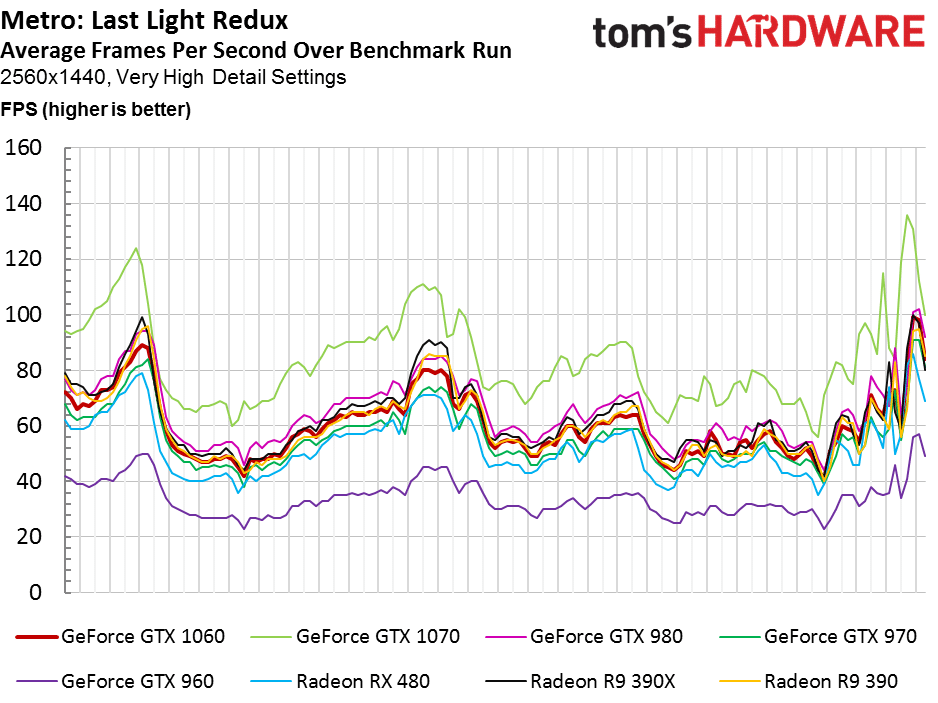

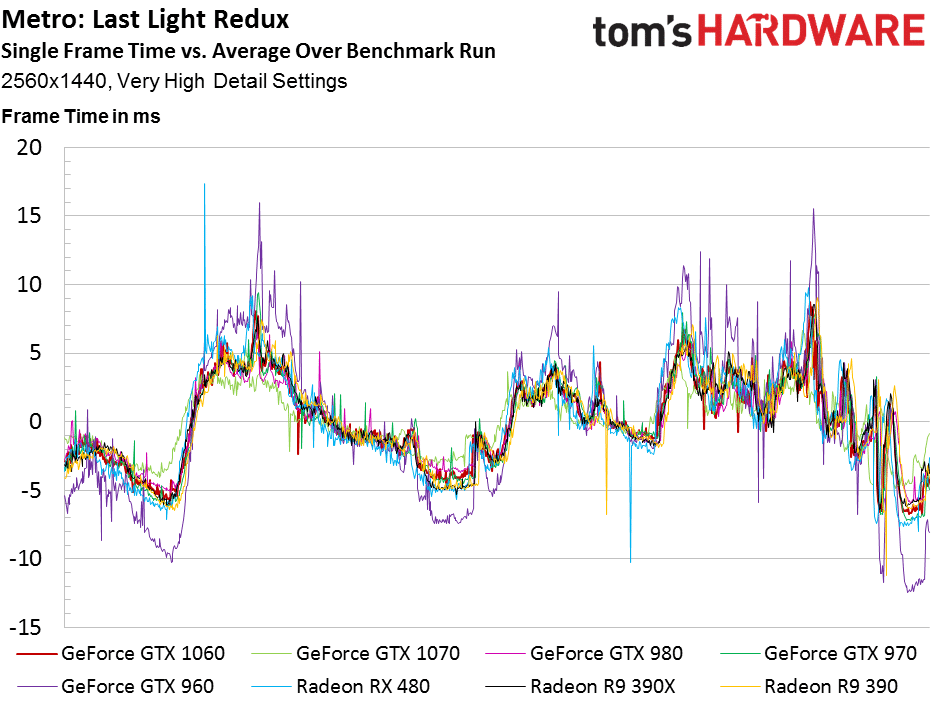

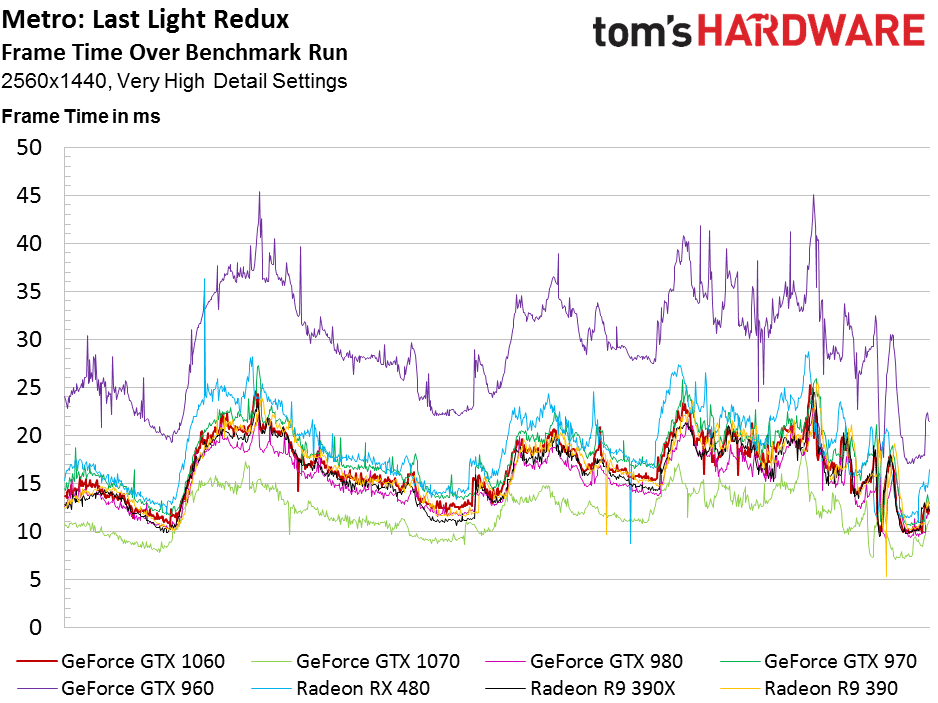

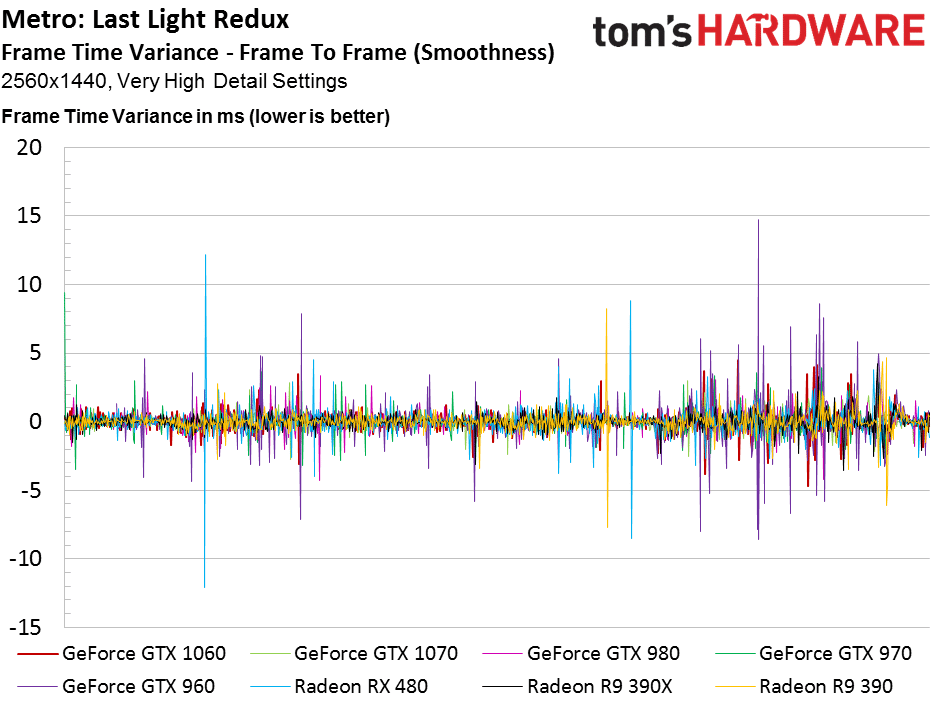

Metro: Last Light Redux (DX11)

La GTX 1060 s’en sort mieux dans ce jeu, mais la GTX 980 reste plus rapide.

Alors que la GTX 980 se maintient en seconde place dans cette définition, la GTX 1060 souffre beaucoup et perd en performances. Les Radeon se trouvent beaucoup plus résistantes à la montée en définition, et certaines R9 390 sont bien moins chères.

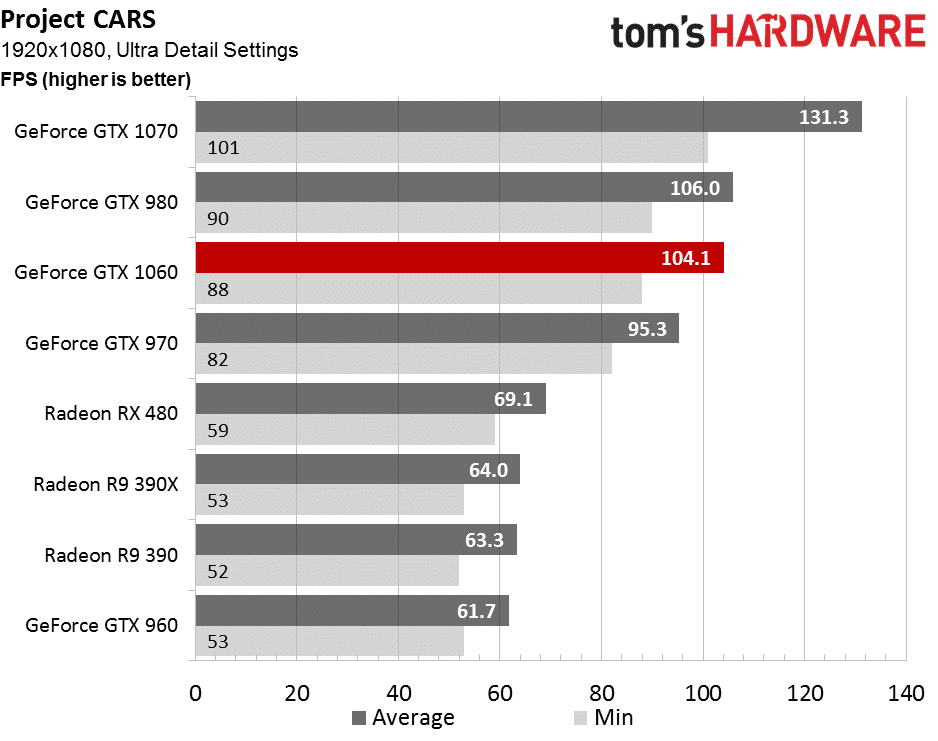

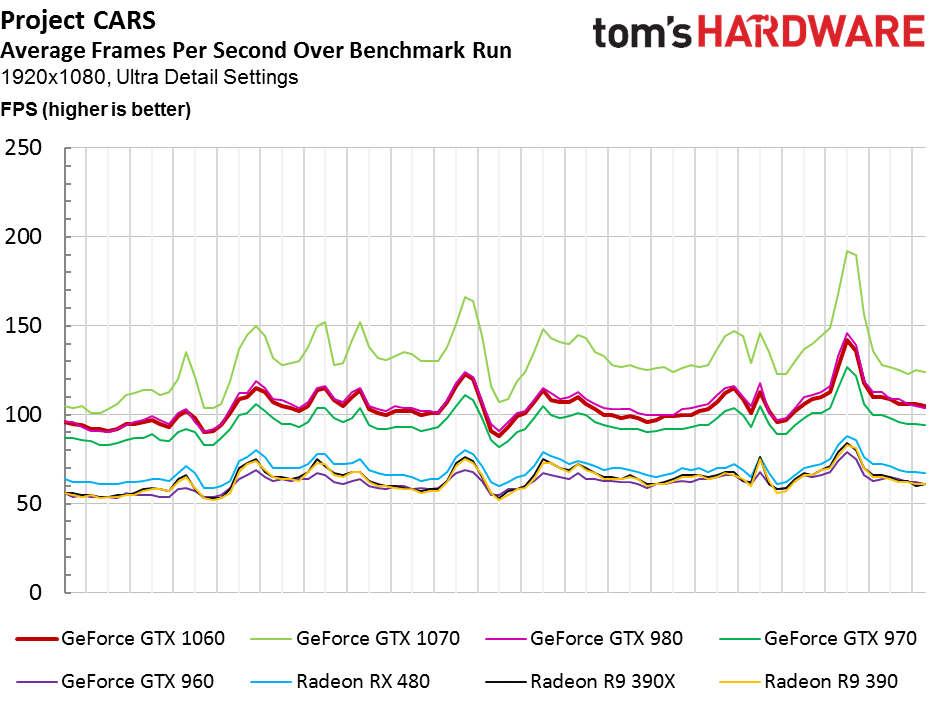

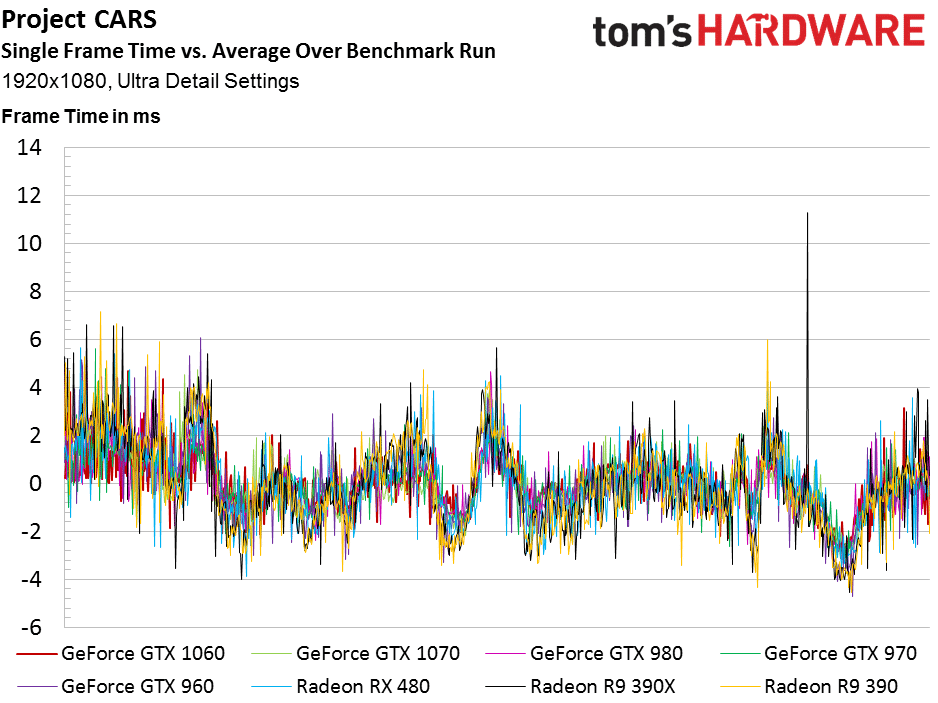

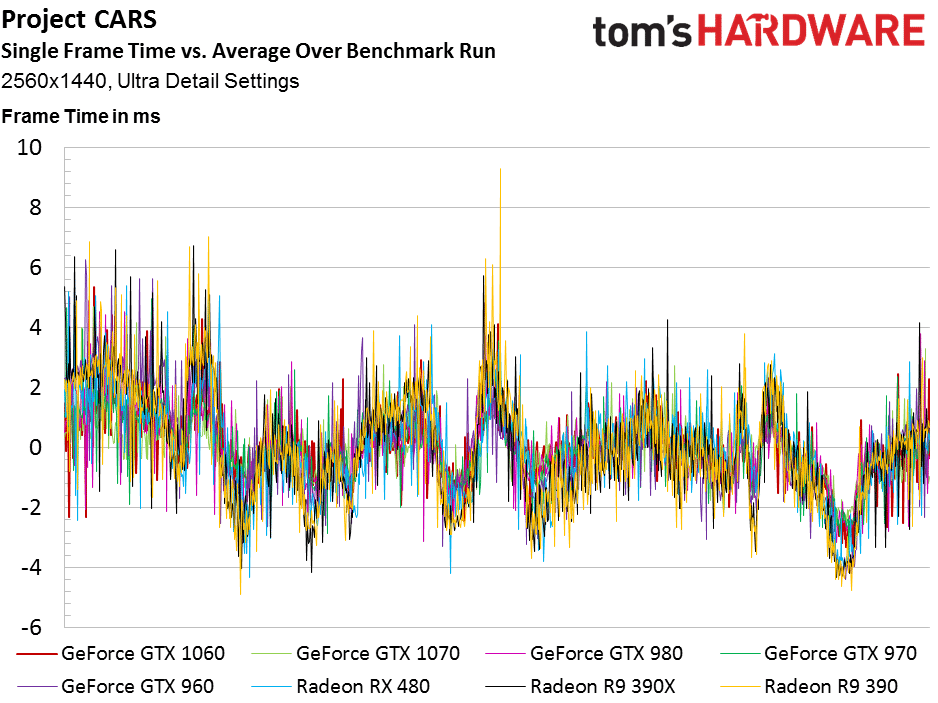

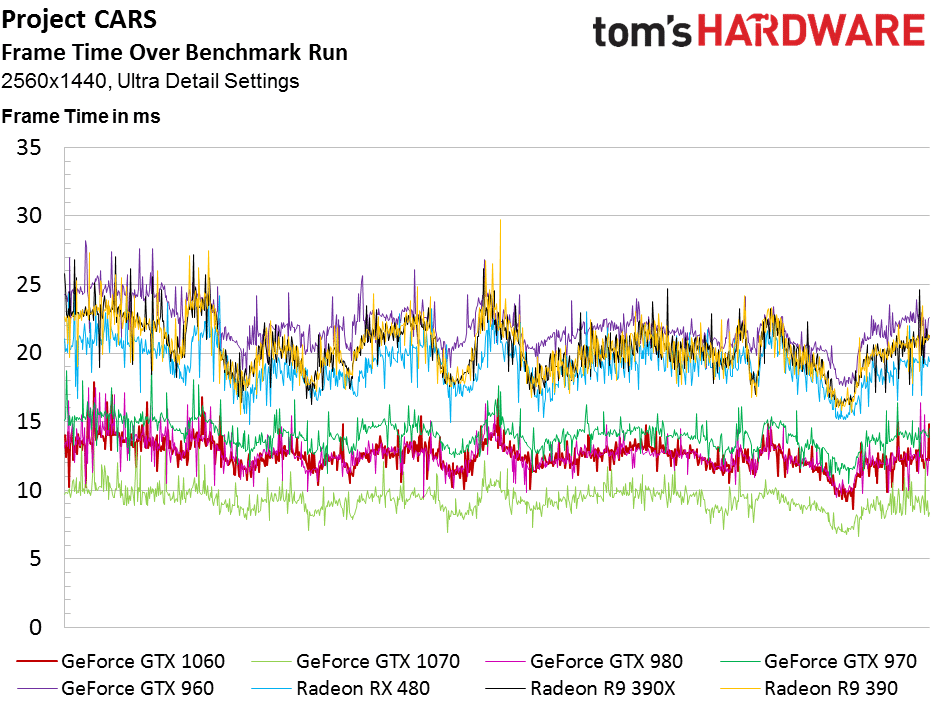

Project CARS (DX11)

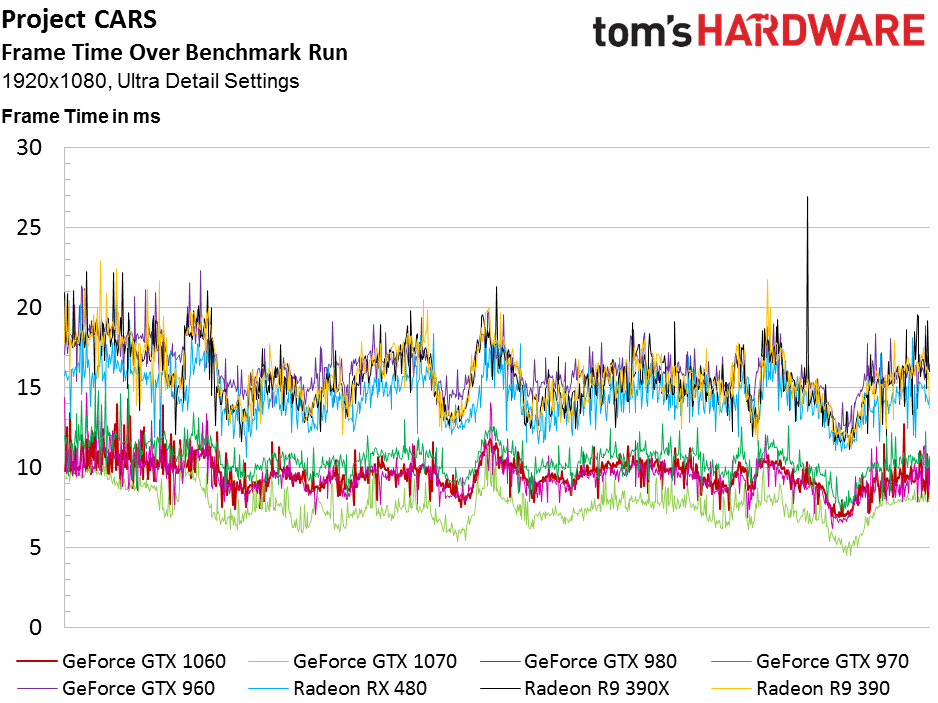

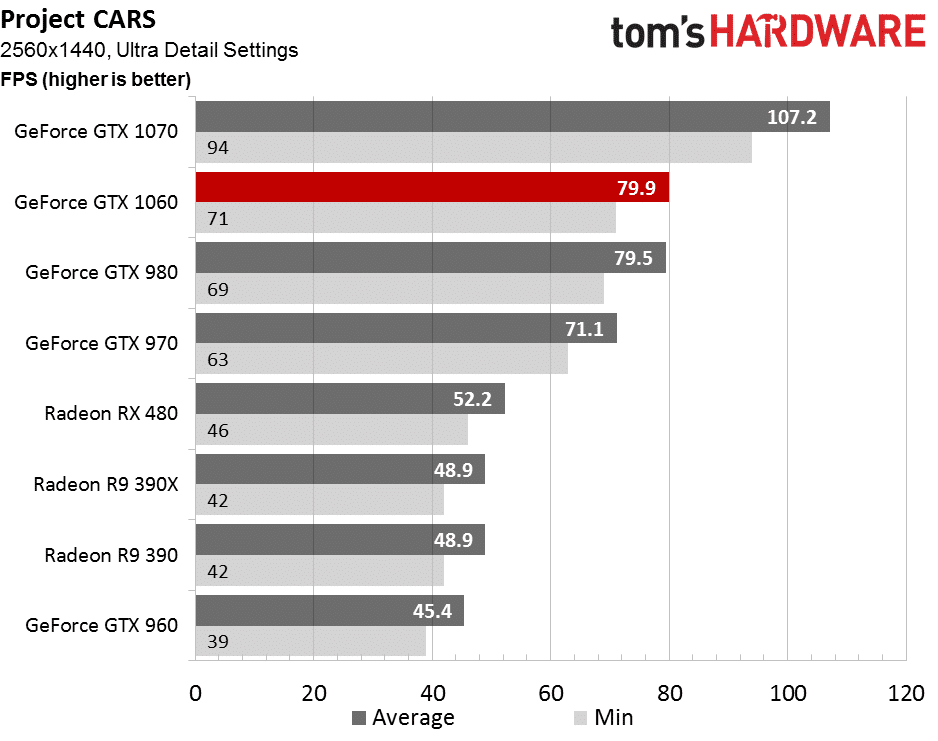

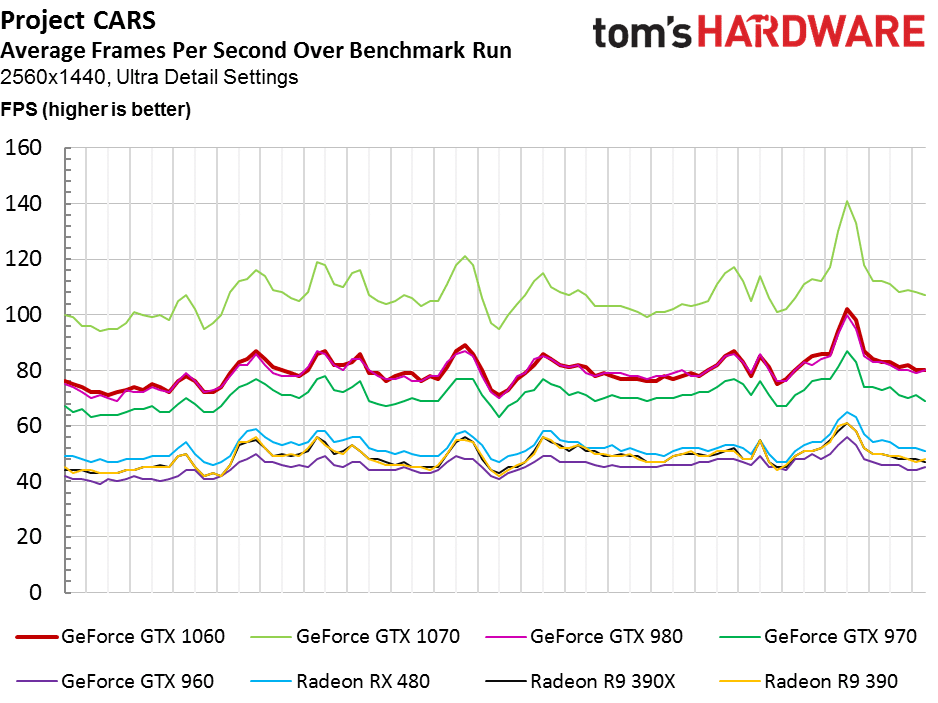

Project CARS pose depuis longtemps de grosses difficultés aux cartes d’AMD, et l’éditeur soutient qu’il n’y a aucune optimisation de son moteur 3D au profit de la concurrence. NVIDIA est bien au dessus dans ce jeu, avec une GTX 1060 qui talonne toujours la GTX 980, parechoc contre parechoc !

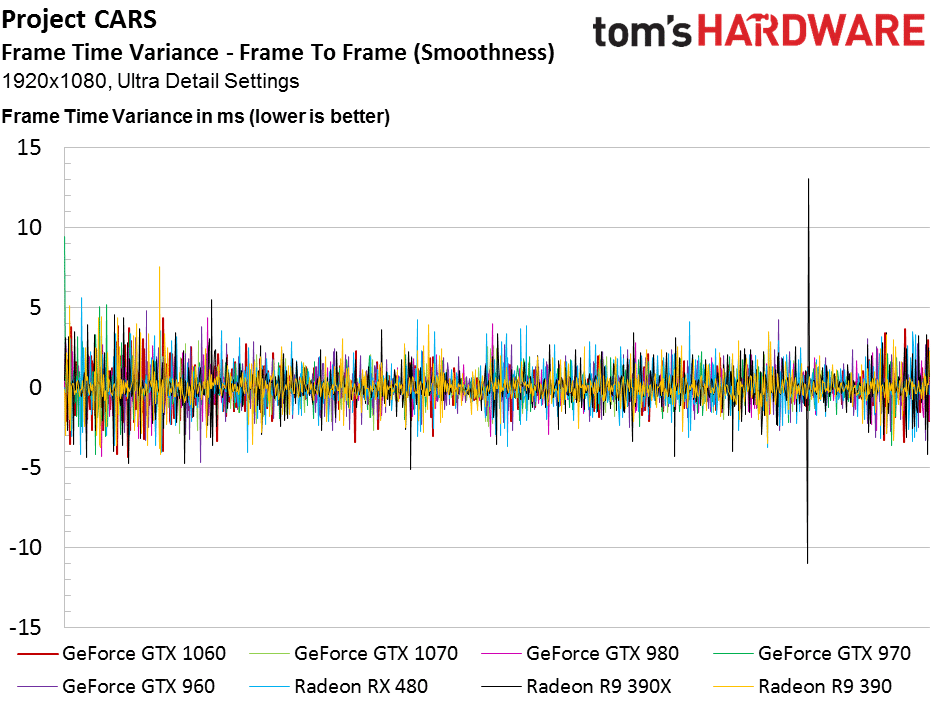

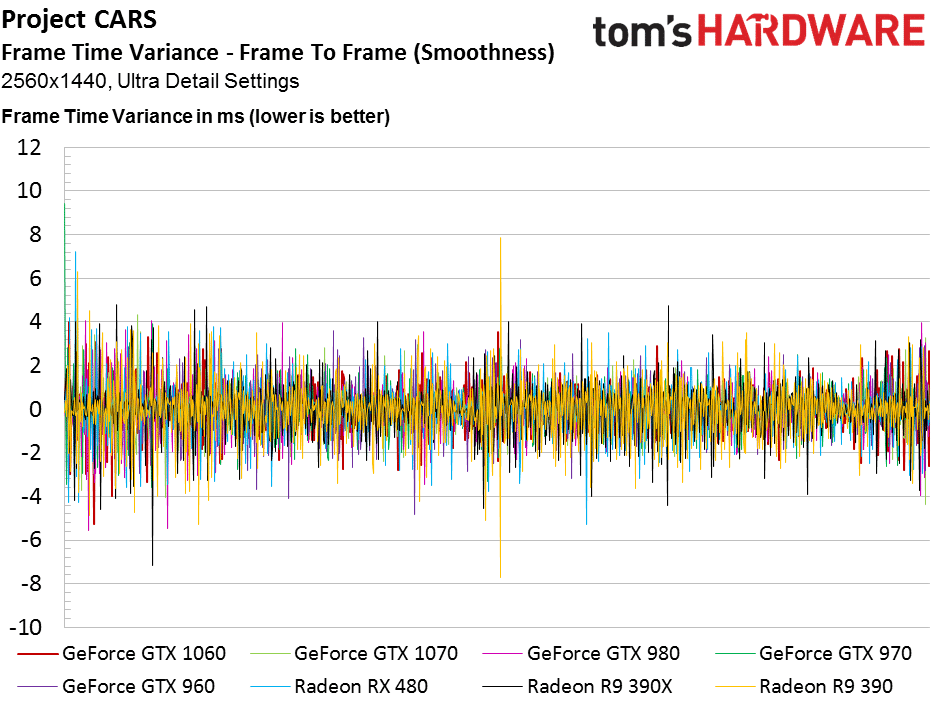

Toujours la même tendance ici, NVIDIA reste bien supérieur dans Project CARS, au dessus des 60 ips en définition QHD. Notez que le temps d’affichage de chaque image reste très stable dans ce jeu, ce qui montre qu’il est jouable de manière assez confortable sur une large variété de cartes, même AMD.

Tests Rise of the Tomb Raider, The Division & The Witcher 3

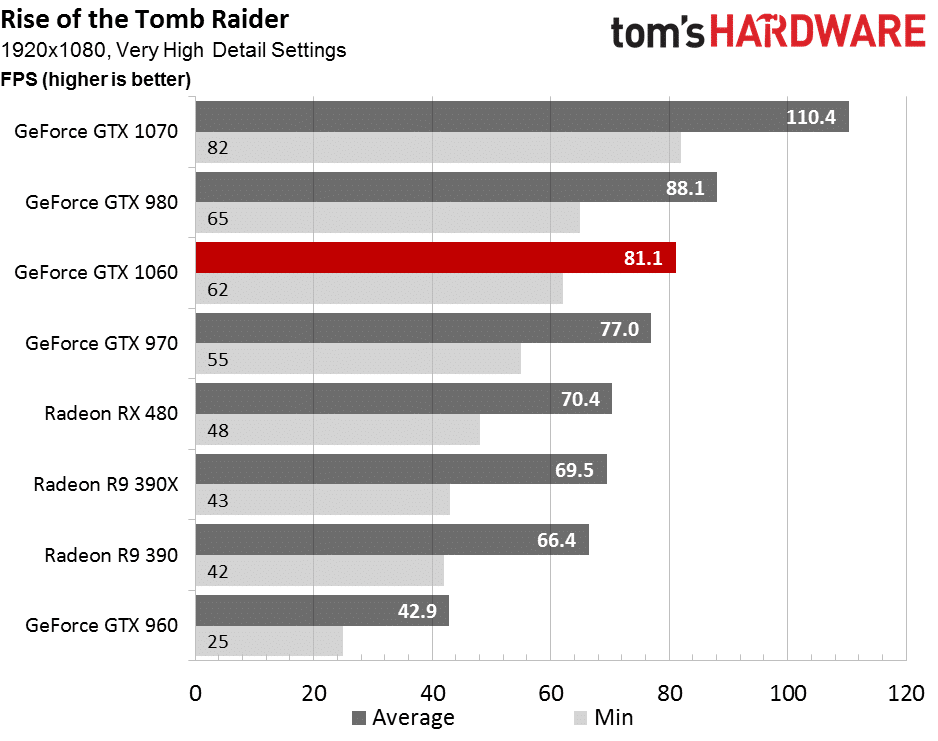

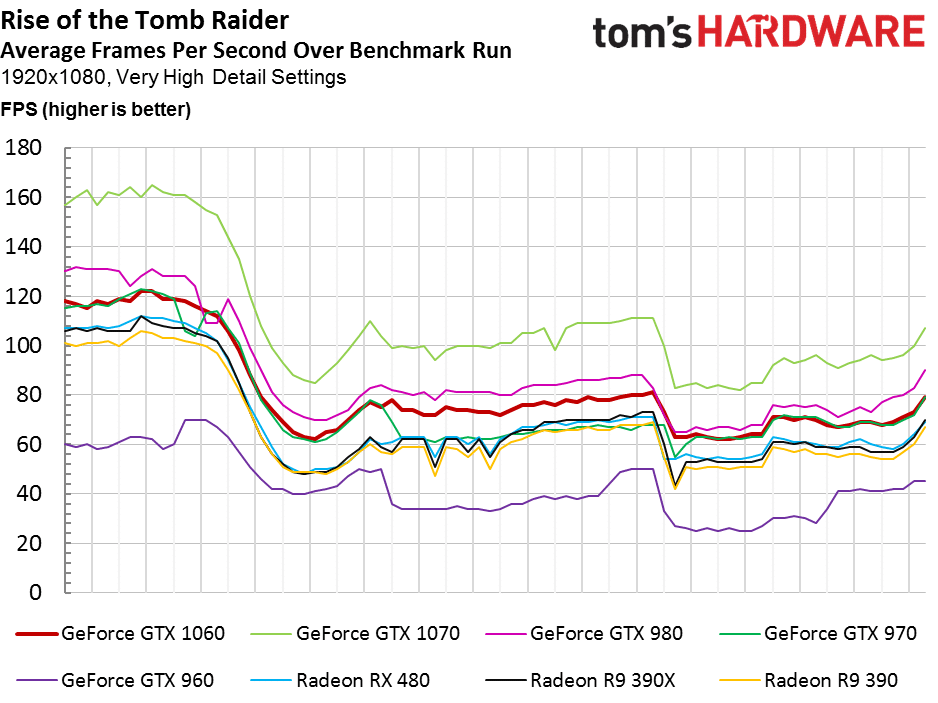

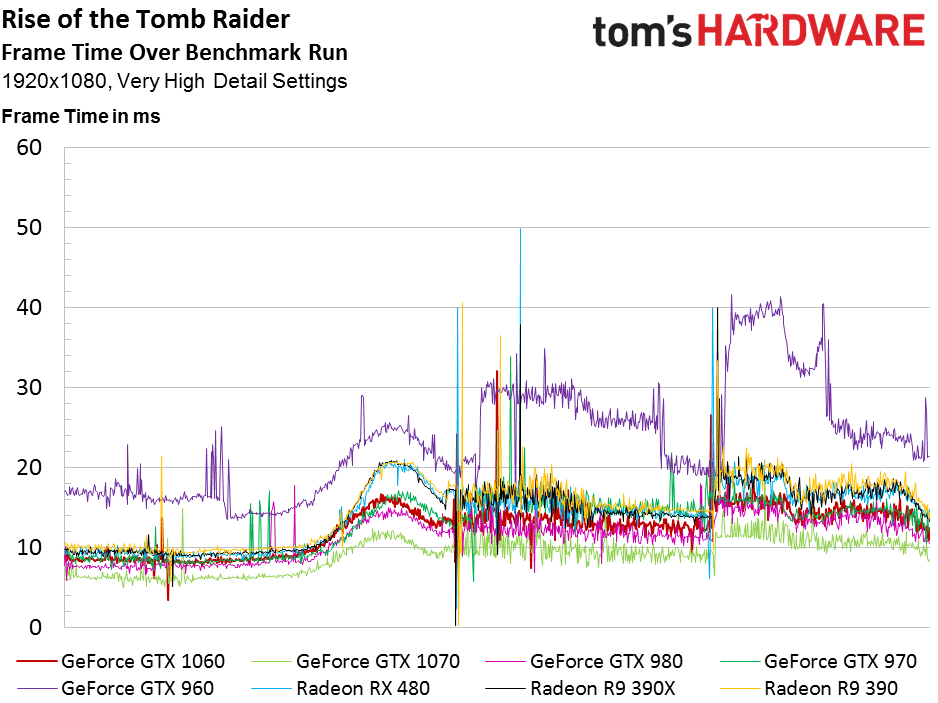

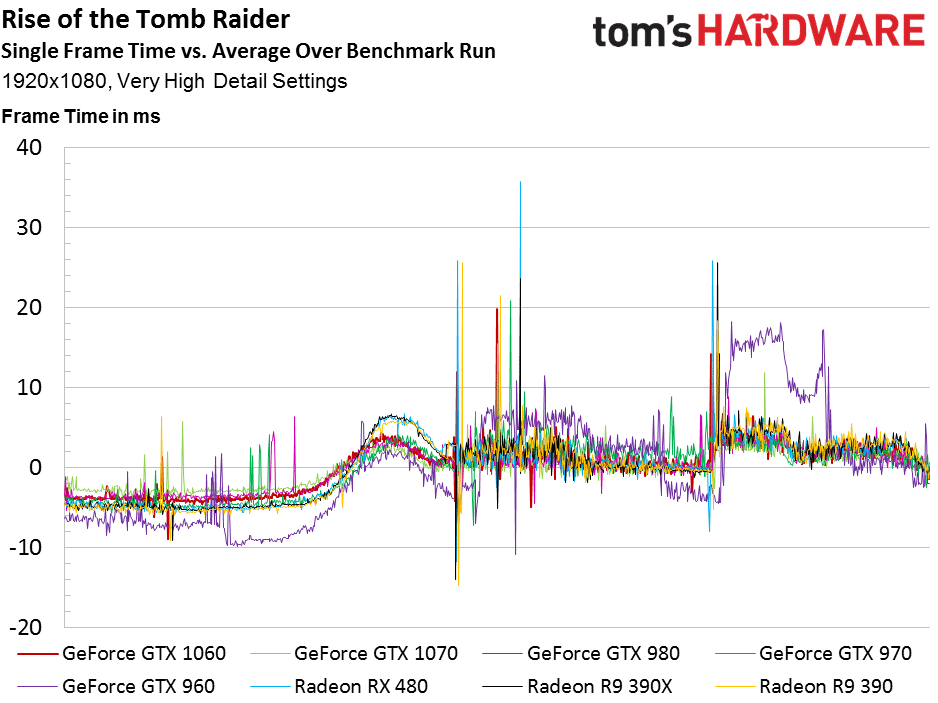

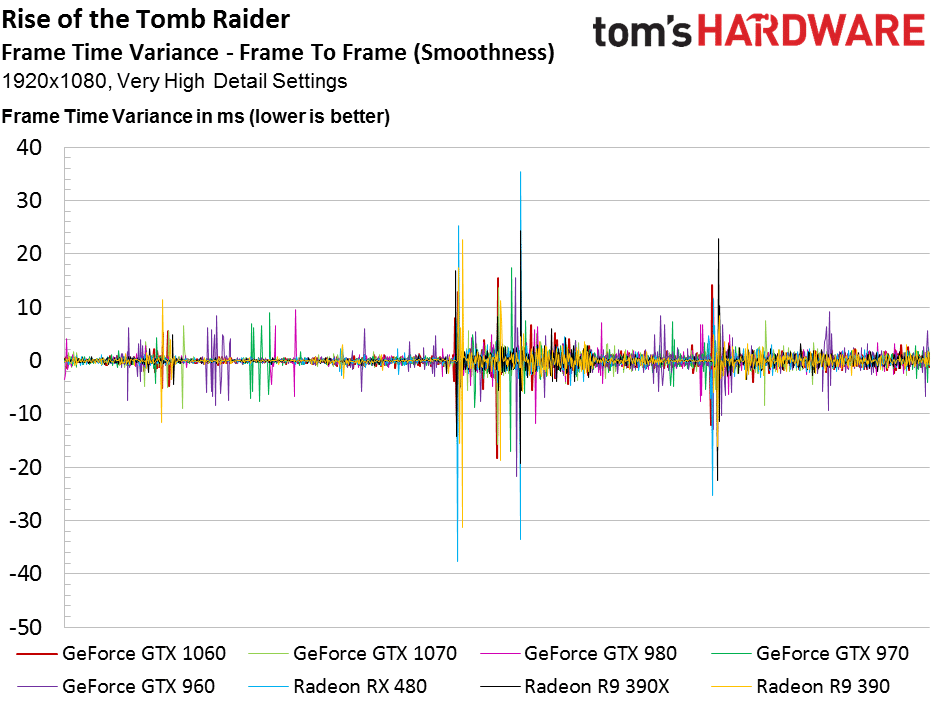

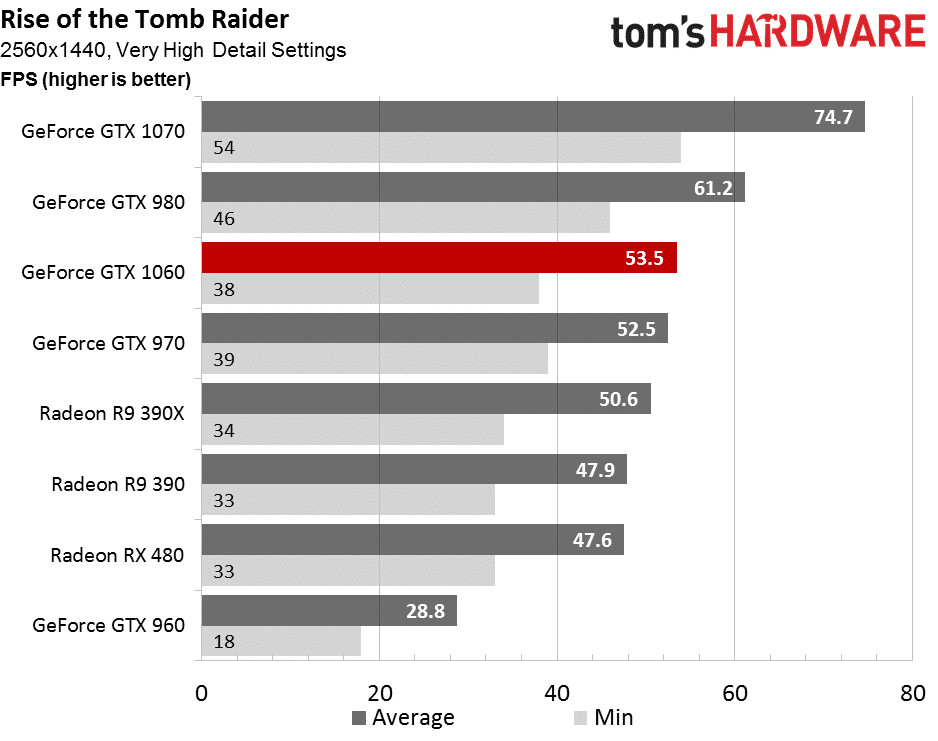

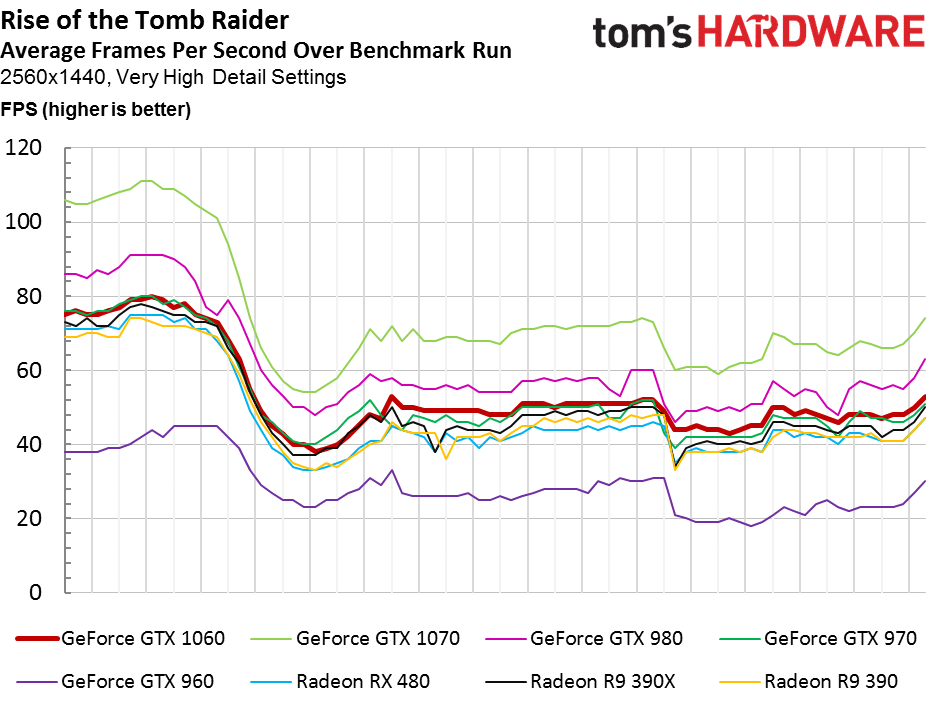

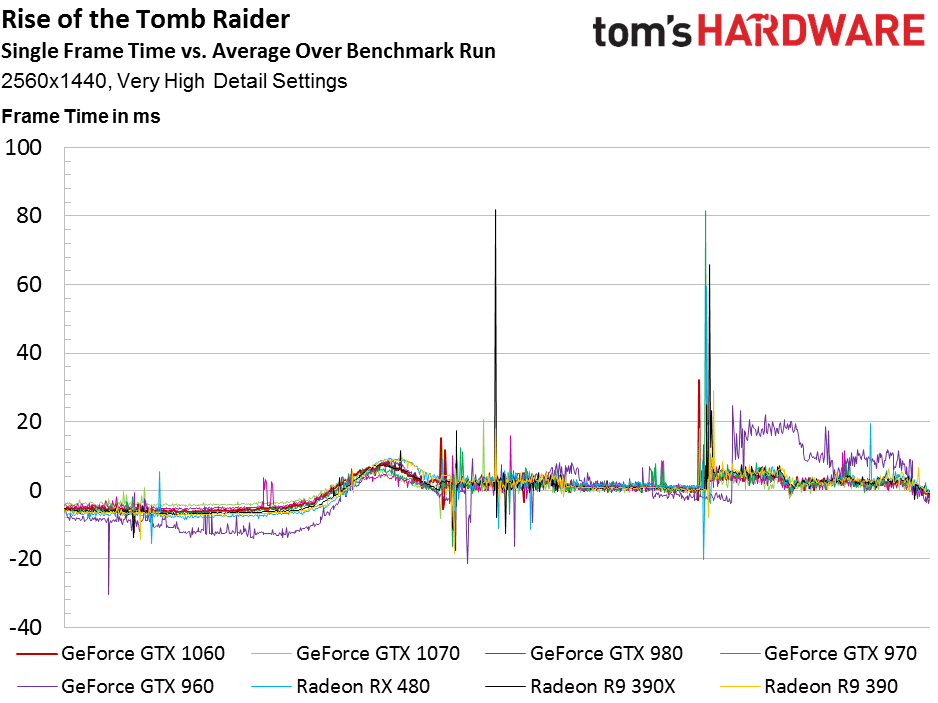

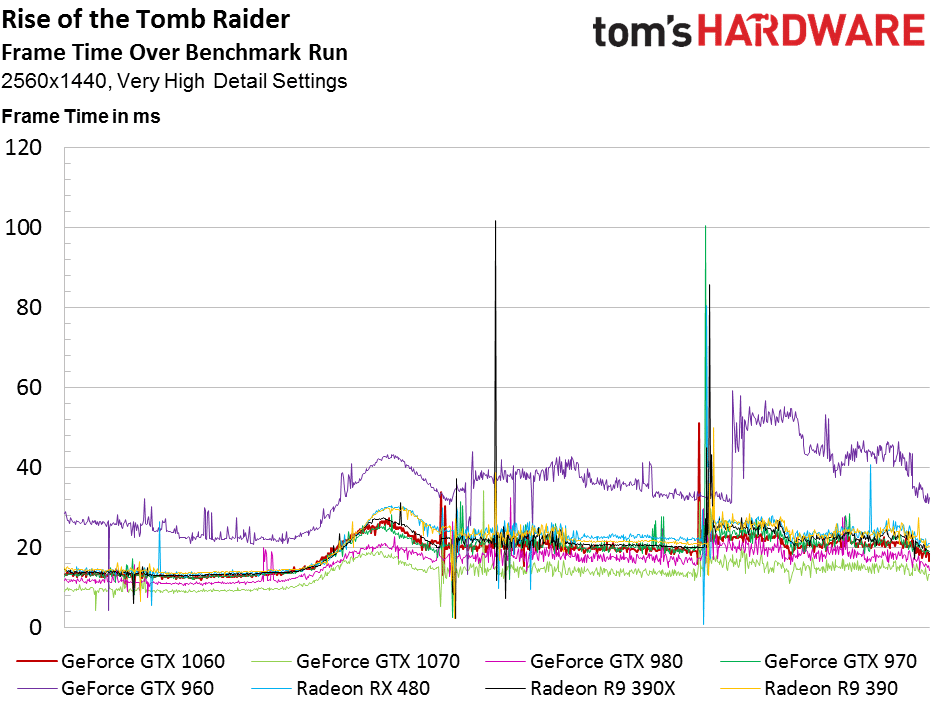

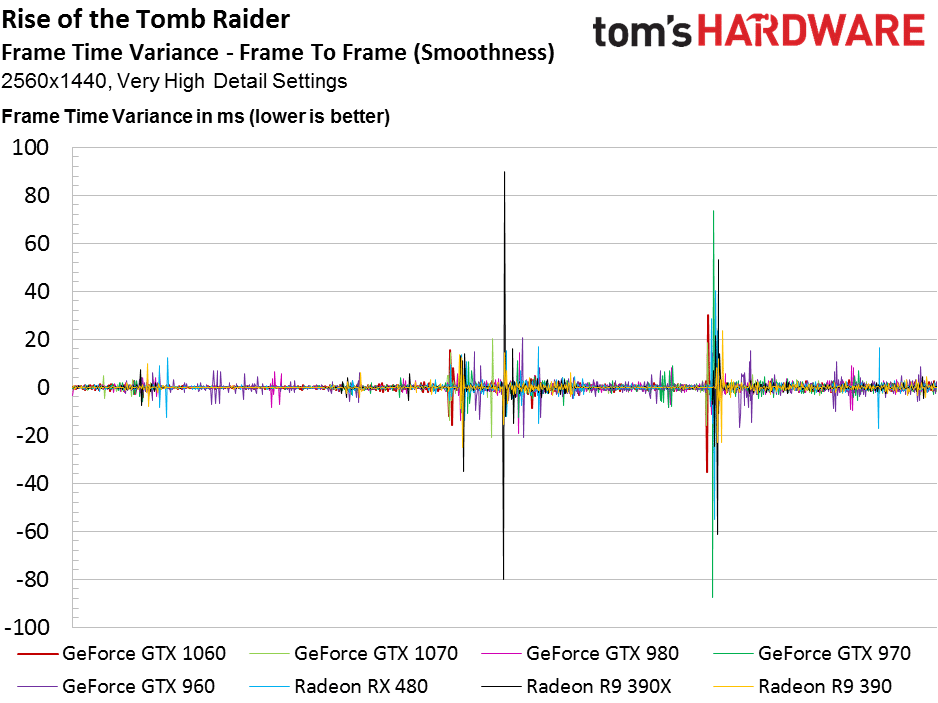

Rise of the Tomb Raider

Rise of the Tomb Raider est aussi un jeu qui sépare clairement les cartes AMD des cartes NVIDIA, au profit du second. La GTX 1060 y apparaît à sa place habituelle : entre la GTX 980 et la 970. La RX 480 dépasse la précédente génération des cartes AMD, mais reste sous la GTX 970.

Dans cette définition supérieure, la GTX 1060 garde sa place, mais c’est surtout la RX 480 qui chute. Dommage que la GTX 1060 s’éloigne de la GTX 980 pour se rapprocher un peu trop de la GTX 970. Pour ceux qui nous demandent de tester ce jeu en DirectX 12, nous ne pensons pas que cela ait un quelconque intérêt: les performances stagnent, voire chutent pour toutes les cartes.

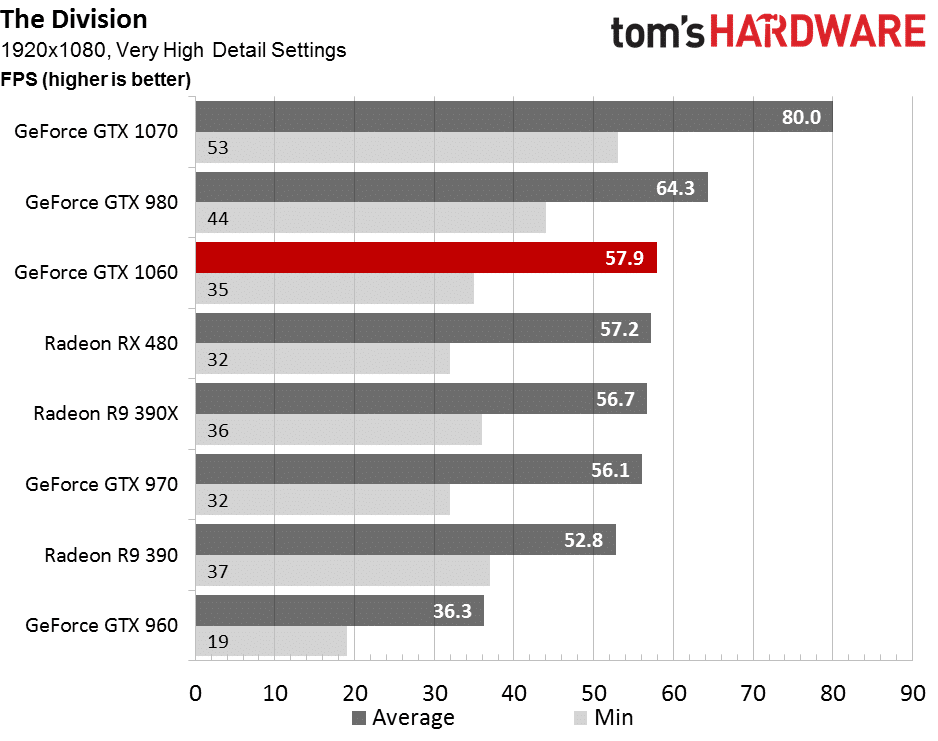

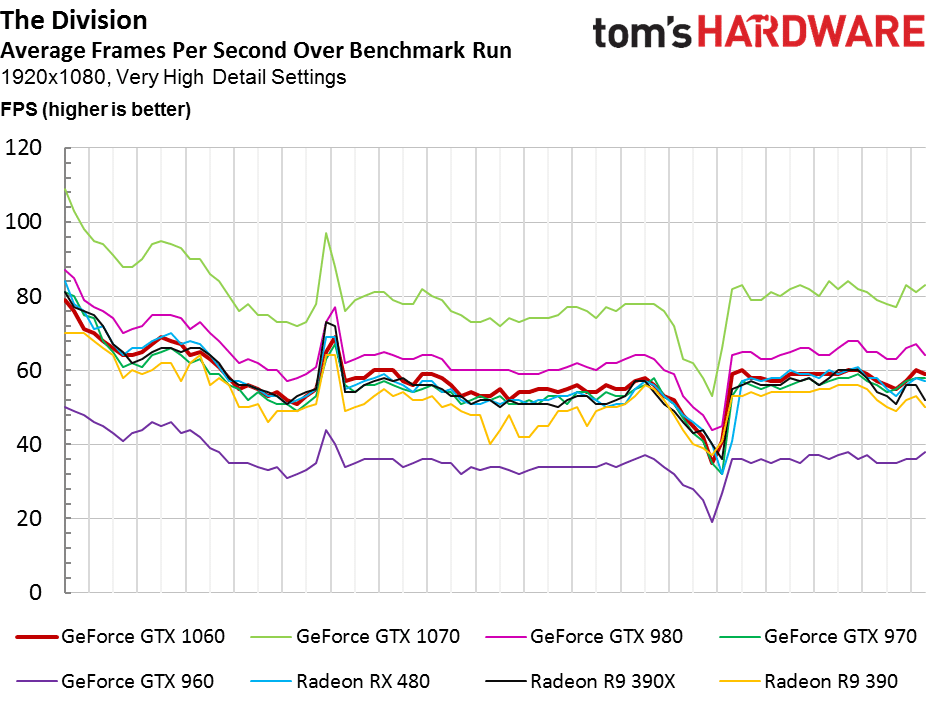

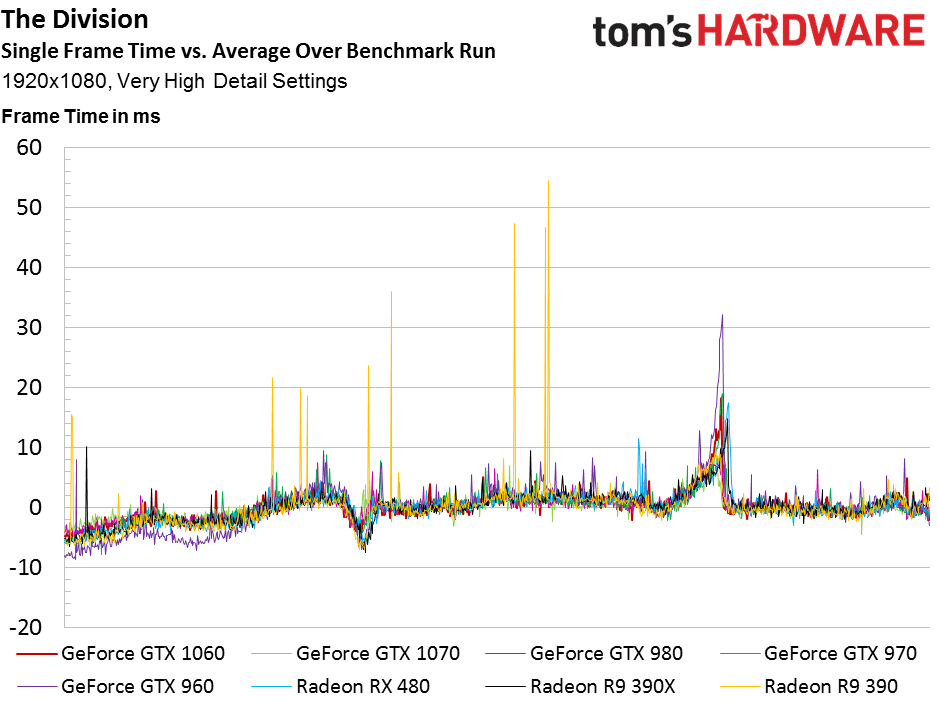

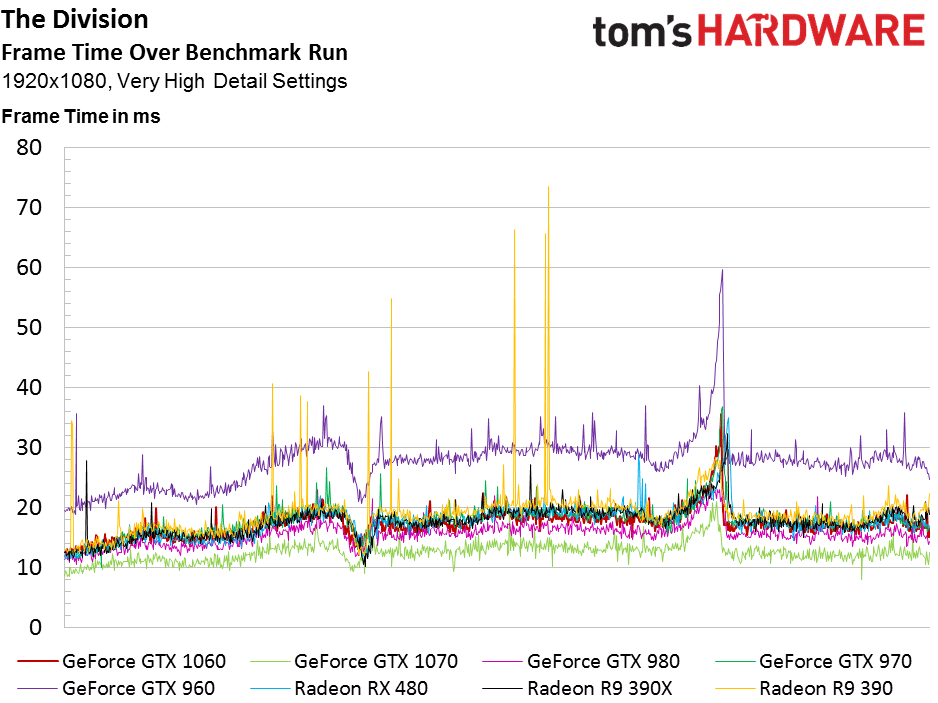

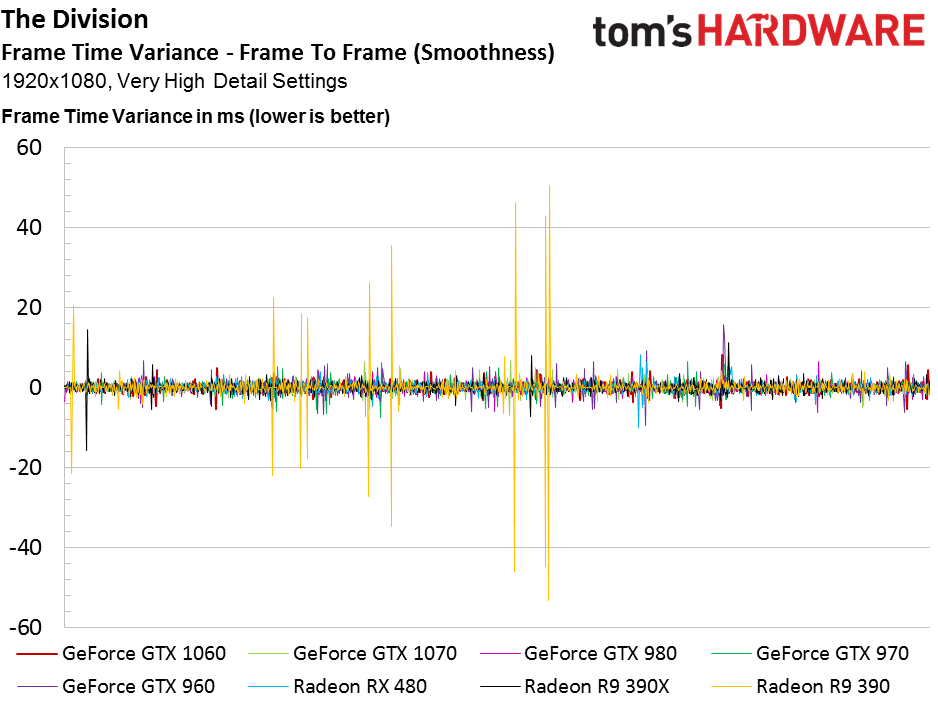

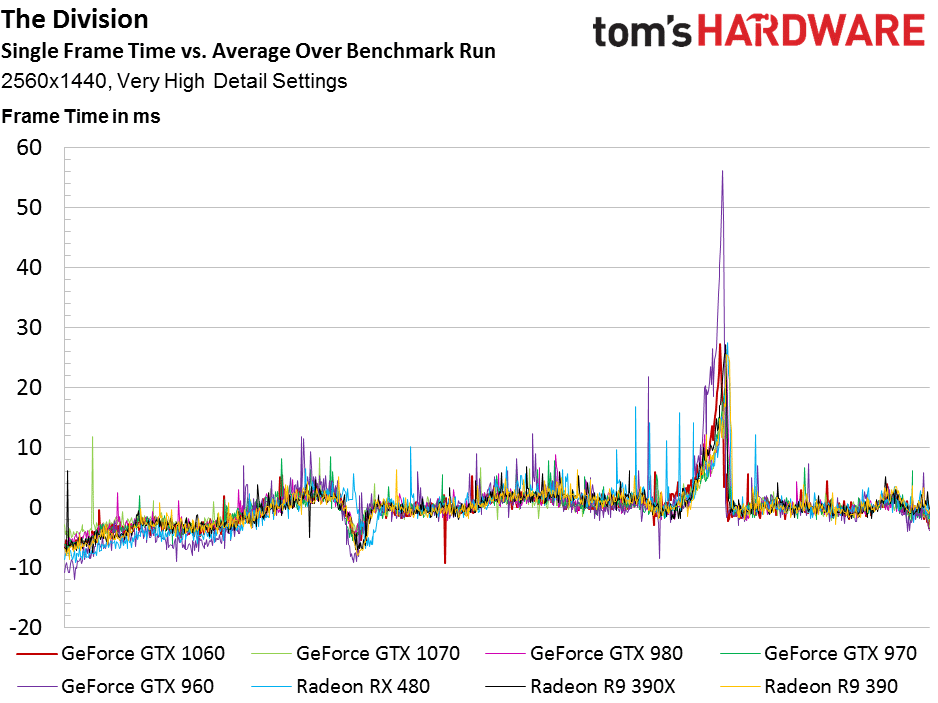

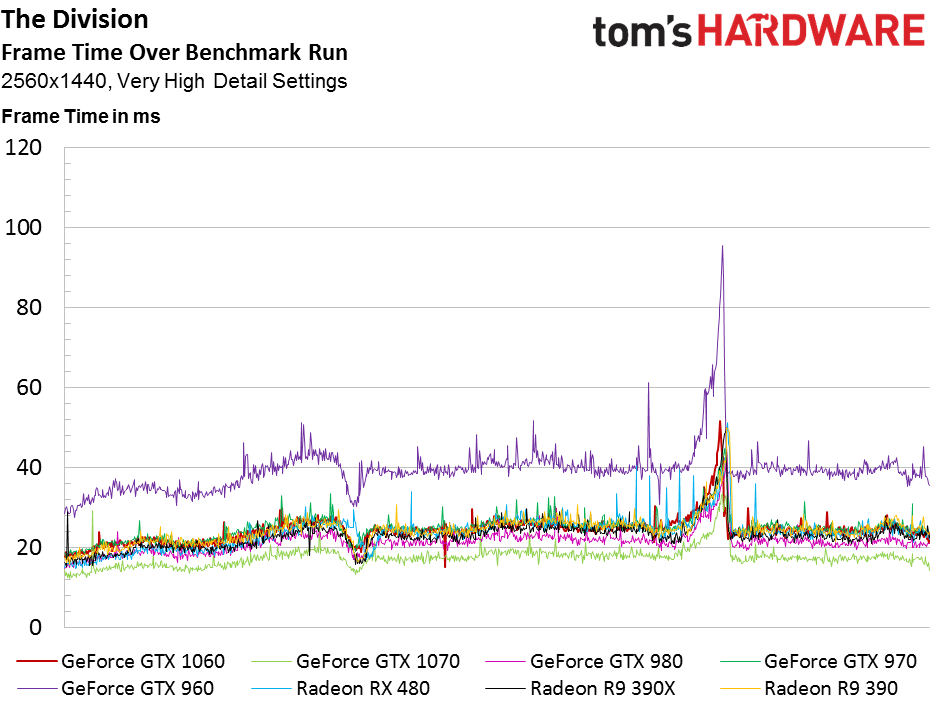

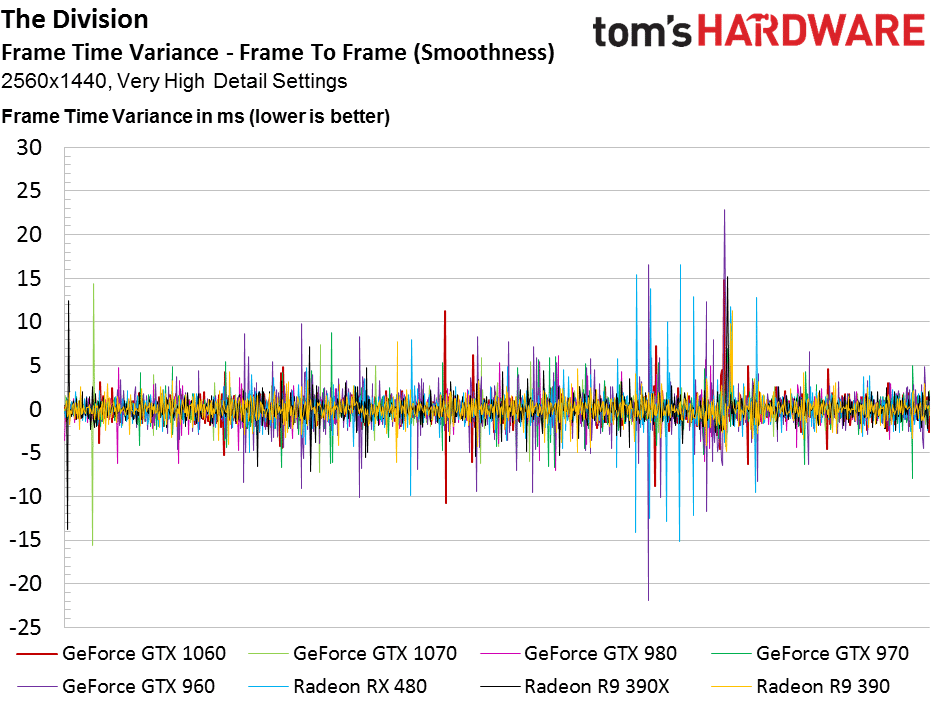

The Division

Les GeForce GTX 1060, Radeon RX 480, Radeon R9 390X, et GeForce GTX 970 offrent des résultats très similaires en Full HD dans The Division. Les R9 390 ne sont pas loin, mais posent problème en termes de fluidité, ce que montrent par nos tests de temps d’affichage des images. On voit encore que la GTX 1060 se comporte plus comme une GTX 970 qu’une GTX 980.

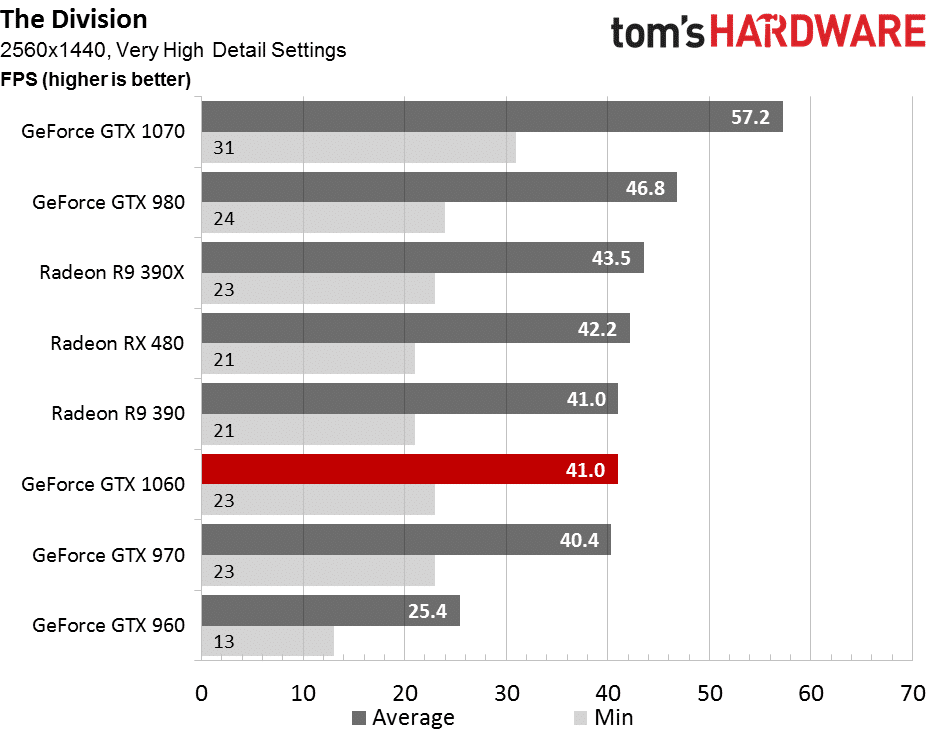

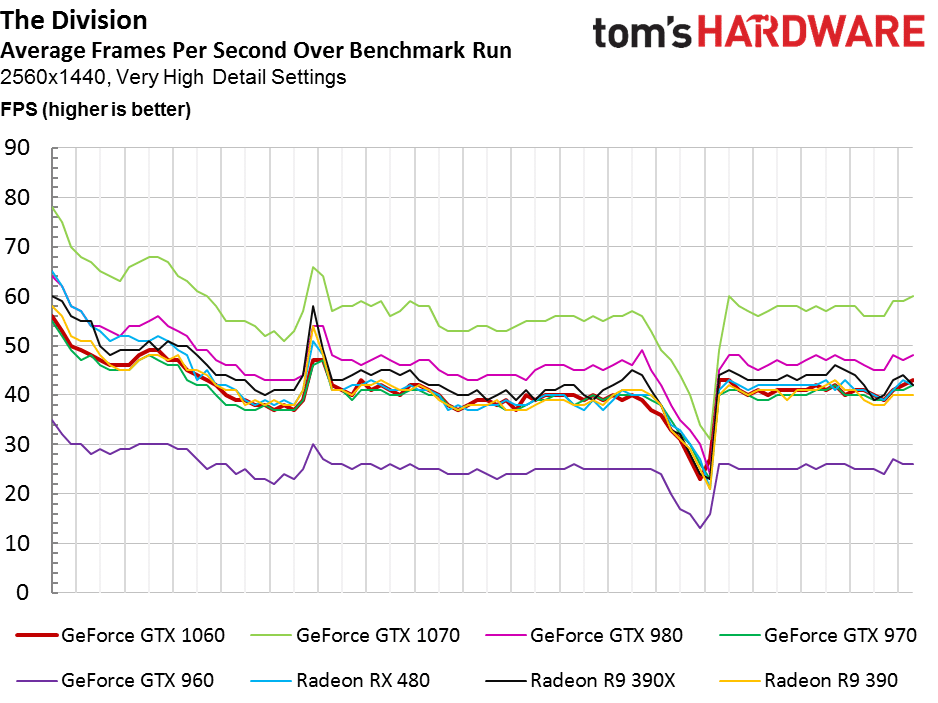

Dans cette définition, la GTX 1060 est durement touchée. Elle chute en 6ème place, mais reste heureusement au dessus de la GTX 970. La Radeon RX 480 résiste mieux.

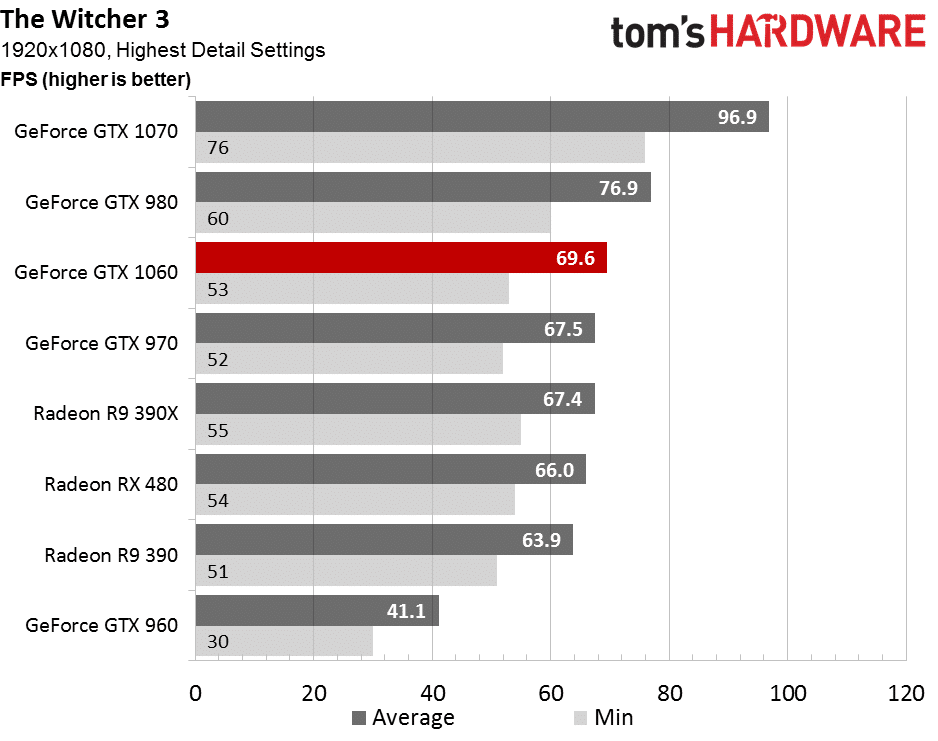

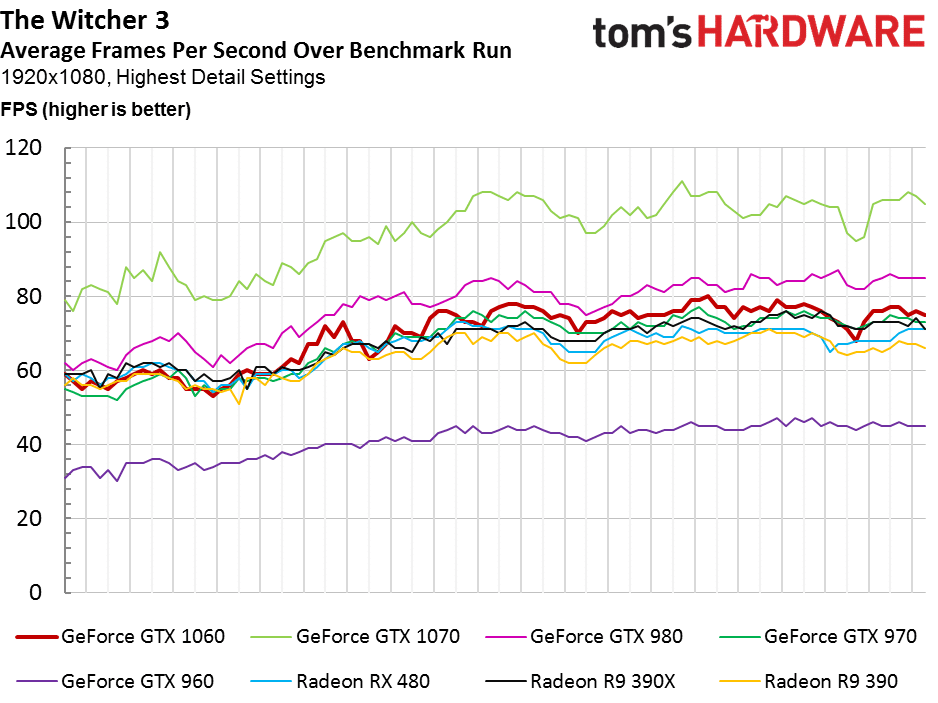

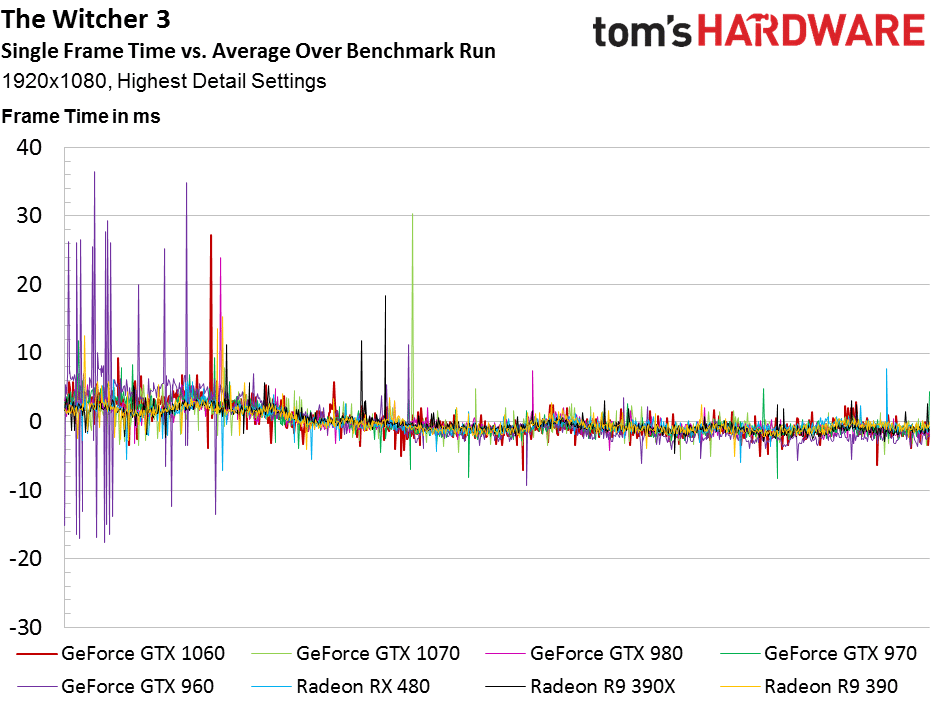

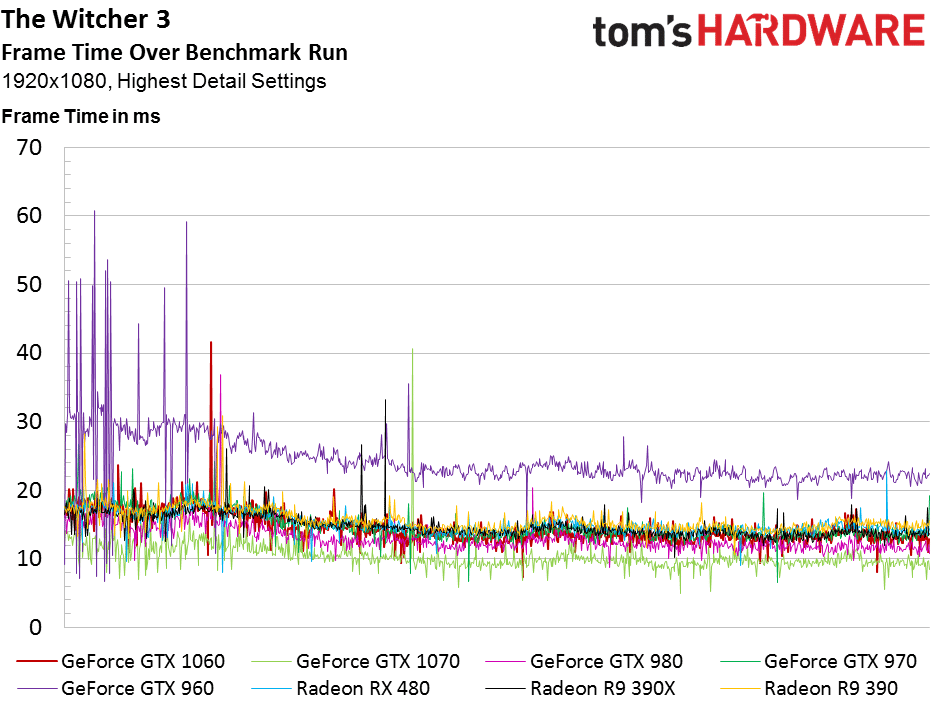

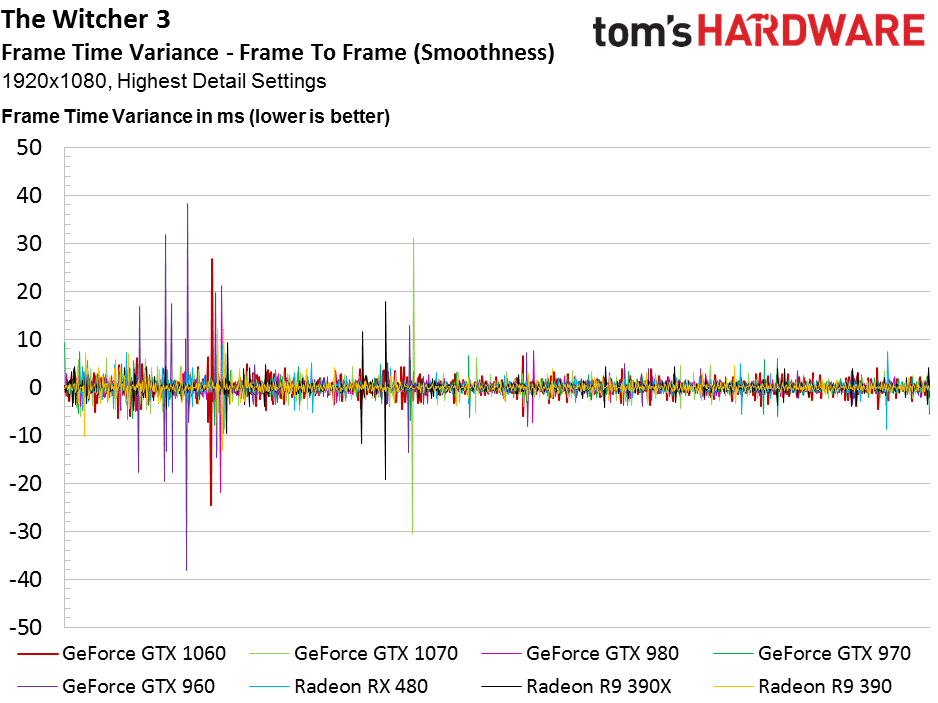

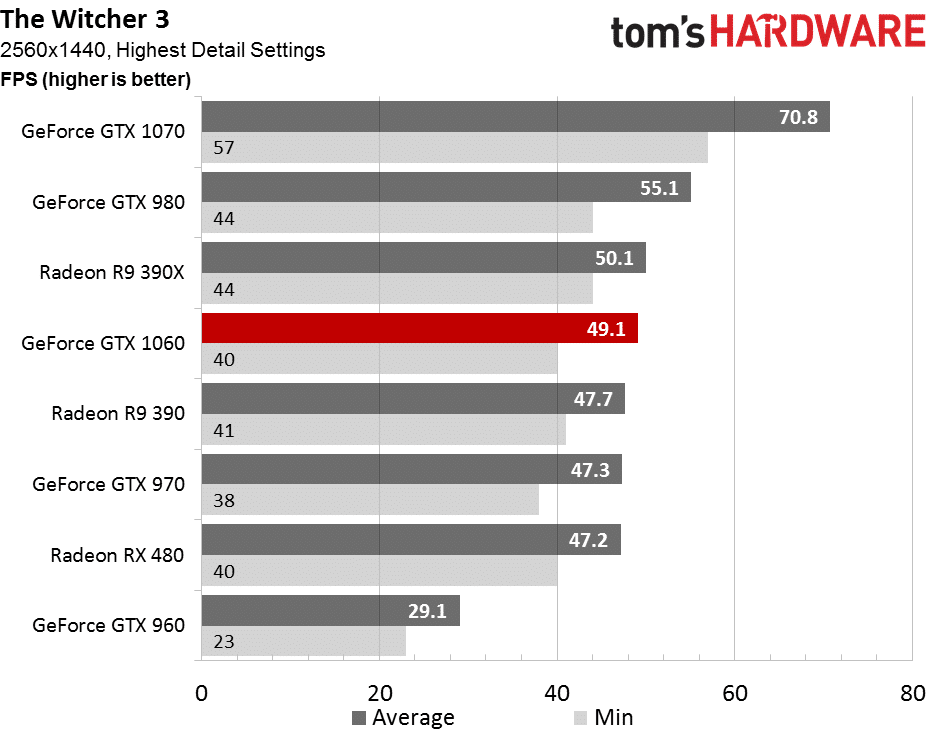

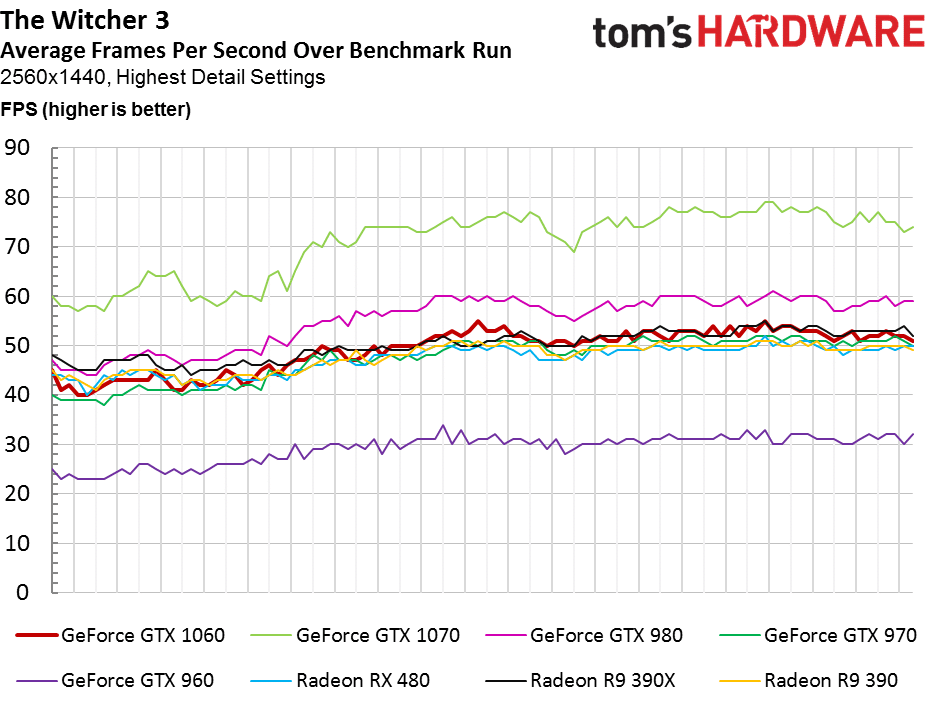

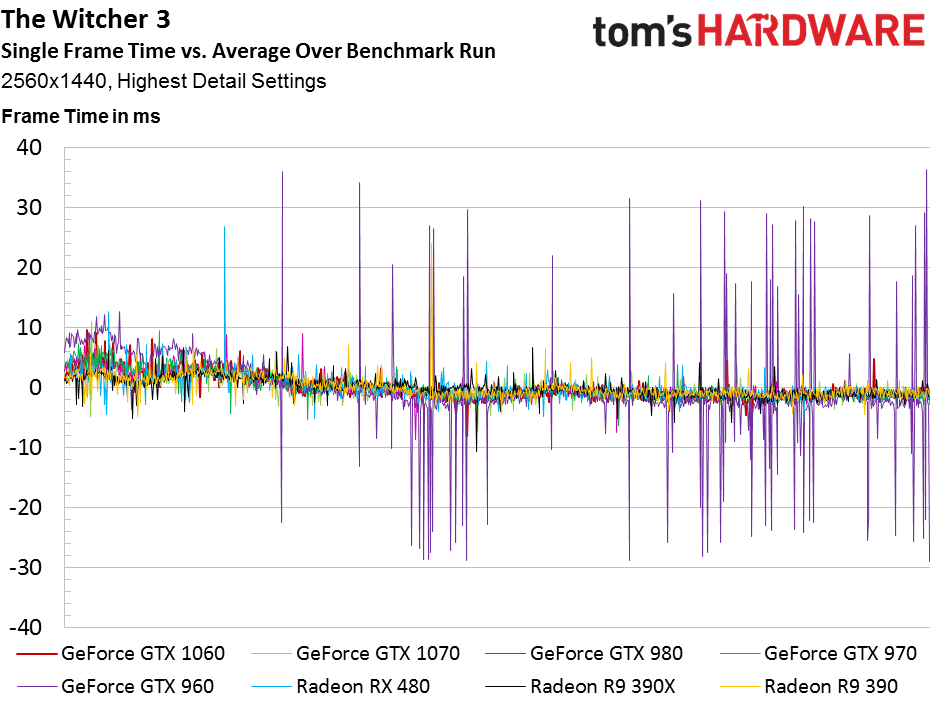

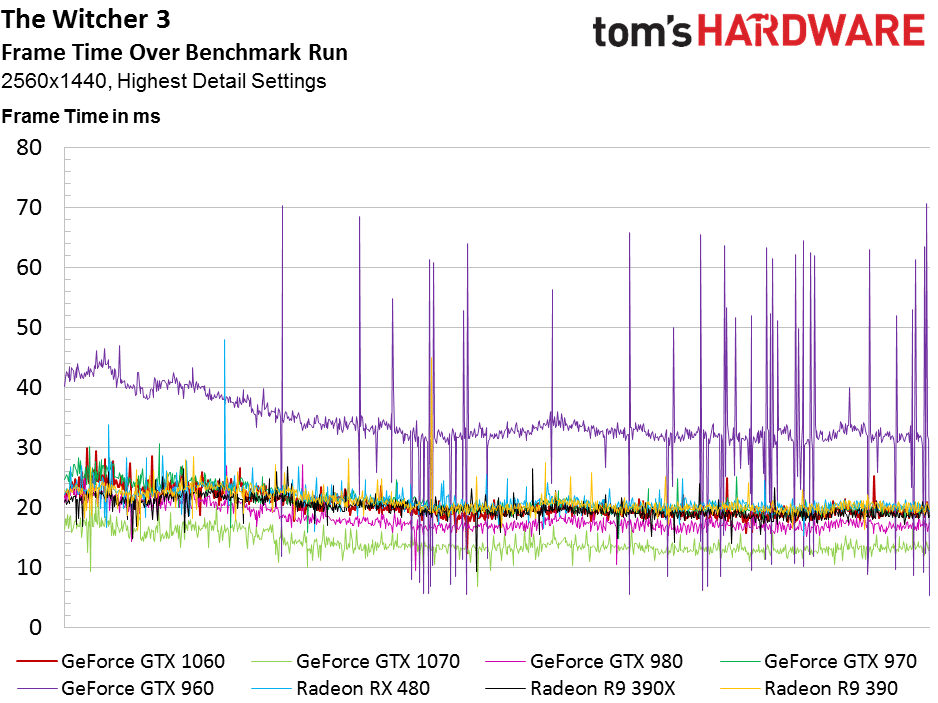

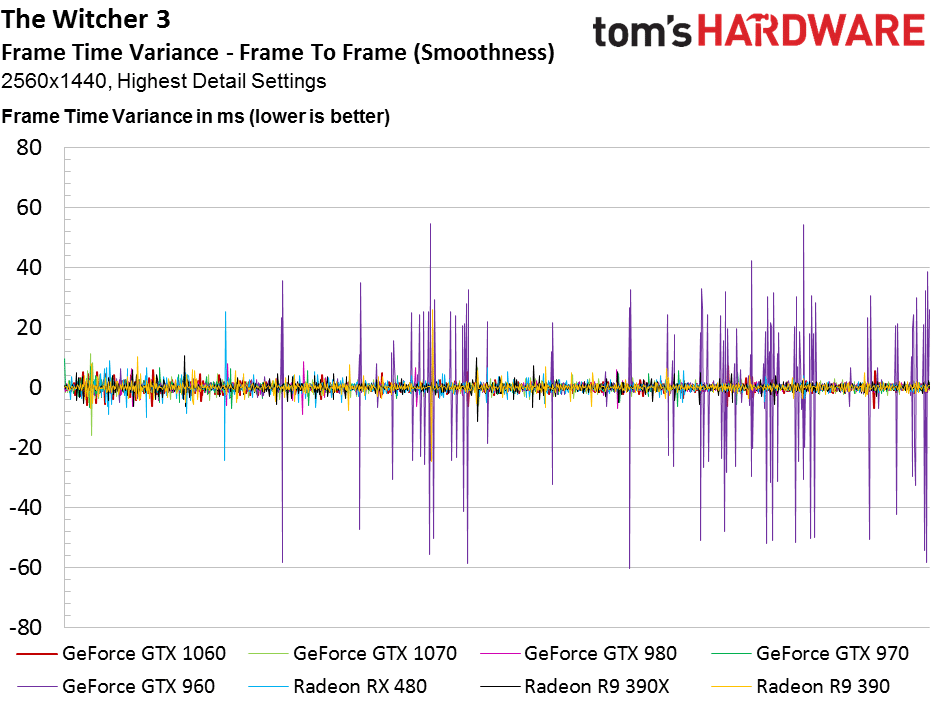

The Witcher 3

Ce jeu met les quatre GeForce en premières places, mais le groupe de cartes entre la Radeon R9 390 et la GTX 1060 montrent des performances très comparables dans nos tests de temps d’affichage des images. La GTX 1060 tendrait donc à devenir trop chère dans cette situation (au moins la Founders Edition).

Le même groupe de cartes en milieu de graphique nous pousse encore une fois à penser au prix de la GTX 1060, tandis que de nombreuses Radeon R9 390 sont vendues à un tarif largement inférieur.

Tests de consommation électrique

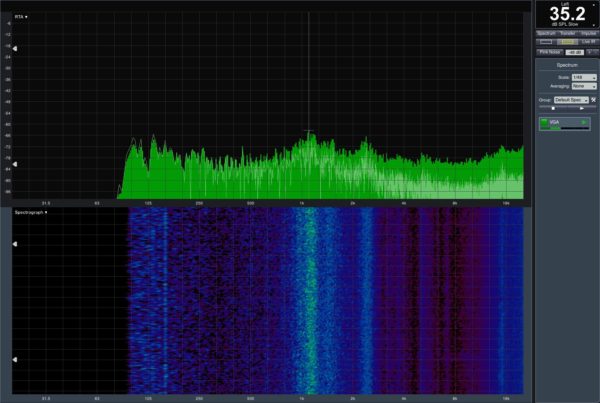

Méthodologie

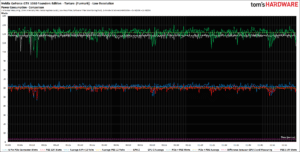

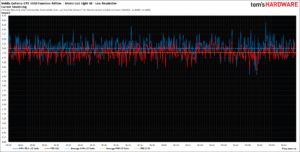

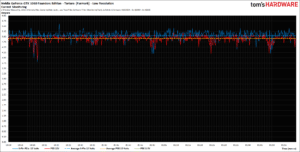

Après les retours des lecteurs et des fabricants, nous avons changé la manière dont nous présentons cette partie de nos tests. Nous appliquons un filtre passe-bas au taux d’échantillonnage maximal pour adoucir les graphiques.

Pour rendre nos courbes plus compréhensibles, nous avons aussi augmenté significativement les intervalles de mesures, et utilisons un nouveau logiciel d’analyse pour évaluer les moments où de brèves fluctuations de charges surviennent, en jaugeant leur plausibilité. Les courbes qui en résultent sont bien plus douces que les anciennes.

Notre équipement de test :

| Consommation | |

|---|---|

Méthodologie | Mesure au slot PCIe Mesure au niveau du câble de l’alimentation Mesure à l’alimentation |

Equipement | Oscilloscopes : 2 x Rohde & Schwarz HMO 3054, 500 MHz Digital multi-canal Sondes : 4 x Rohde & Schwarz HZO50 (1 mA – 30 A, 100 kHz, DC) 4 x Rohde & Schwarz HZ355 (sondes 10:1, 500 MHz) Multimètre : 1 x Rohde & Schwarz HMC 8012 Digital |

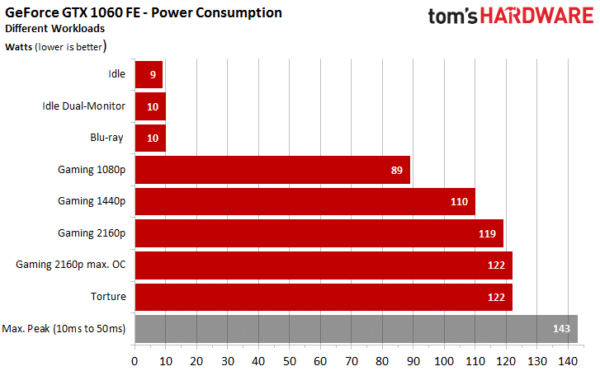

Consommation à différentes charges

Remarquez que nous avons ajouté une mesure de consommation moyenne dans les jeux vidéo à différentes définitions. Elle est basée sur une scène de Metro: Last Light de 170 secondes, très variée (mode High, Tesselation normale, SSAO désactivée). Nous en discuterons plus en détail lors de nos tests de rendement, dans les pages suivantes.

La barre grise représente le pic maximal de consommation basé sur les mesures pourtant lissées de nos courbes de consommation. Fondamentalement, cette barre n’a pas d’incidence pratique, car la durée de ces pics est trop brève pour être importante.

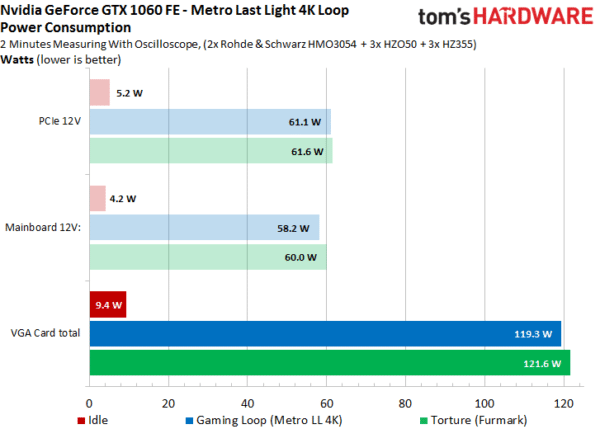

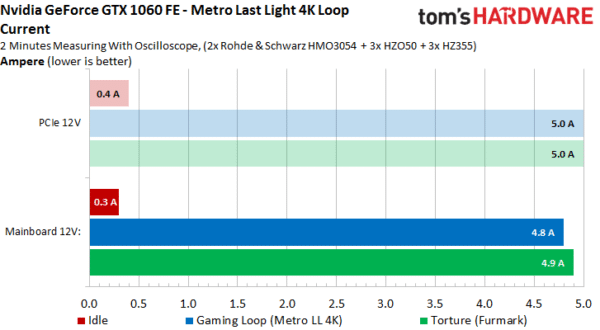

Distribution de la charge

NVIDIA parvient à bien distribuer la charge entre le slot PCI Express de la carte mère et le connecteur PCI Express de la carte. Le rail 3,3 V n’est plus du tout utilisé, c’est pourquoi vous ne le voyez pas dans nos graphiques.

Cliquez pour voir nos courbes détaillées de consommation sur le temps dans une meilleures définition.

Avec moins de 5 Ampères pour la carte mère, NVIDIA assure un minimum de risque pour la GTX 1060, le maximum normé du PCI-SIG est de 5,5 A.

Voici encore nos courbes plus détaillées sur le temps :

Consommation face à d’autres cartes

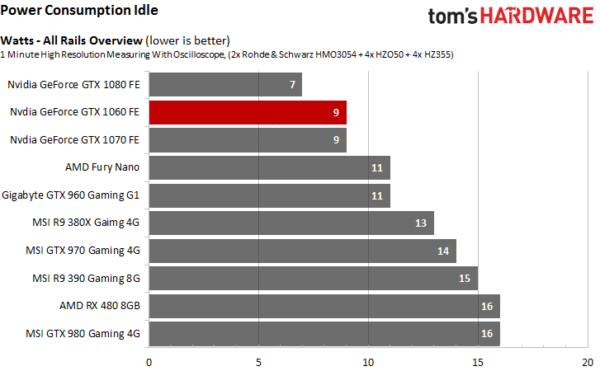

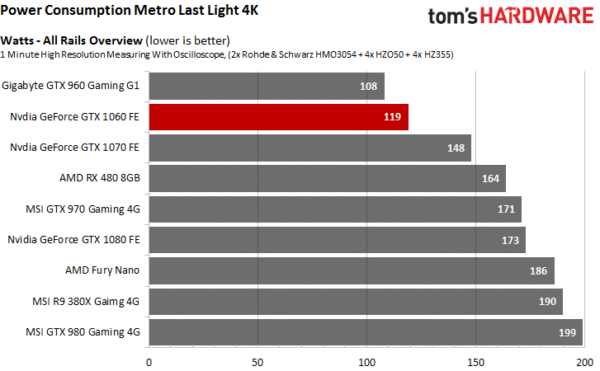

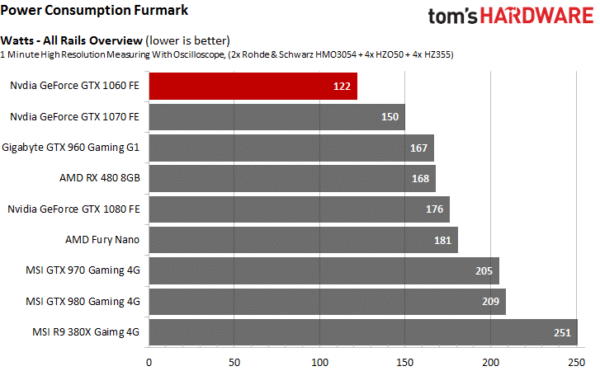

Maintenant, nous pouvons examiner comment la GTX 1060 se comporte face à la concurrence. Nous utilisons le pic de consommation, comparable à nos précédentes mesures.

La GeForce GTX 1060 enregistre une consommation légèrement plus élevée que la GTX 960 dans notre test en jeux vidéo. Toutefois, cela change dans nos test de torture sous FurMark. Ce qui nous permet de conclure, de toute manière, que la GTX 1060 est la carte la plus rapide dans la catégorie 120 W.

Rendement et Overclocking, underclocking

Notre sélection de tests

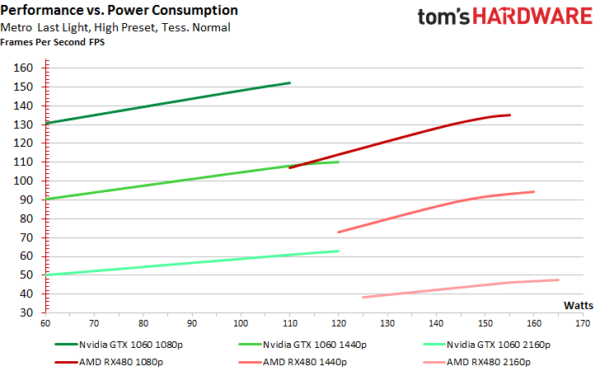

Difficile de choisir le bon benchmark pour ce type de test, car il y a tellement de données qu’il faut sélectionner une mesure représentative. Il nous faut environ deux jours pour compléter cette section. Nous avons choisi d’utiliser Metro: Last Light à nouveau. Le jeu offre un bon équilibre entre les cartes NVIDIA et AMD, et continue d’offrir un bon rapport entre les demandes en performance et la consommation. Nous avons néanmoins changé les paramètres en réponse à vos commentaires.

Nous testons trois définitions : 1920×1080, 2460×1440, et 3840×2160. Le jeu tourne maintenant à un niveau de détail élevé au lieu de très élevé. Nous avons choisi ce paramètre pour être sûrs que la GTX 1060 et la RX 480 n’atteignent pas les limites de consommation lorsque l’on utilise les définitions les plus élevées.

Consommation et fréquences obtenues

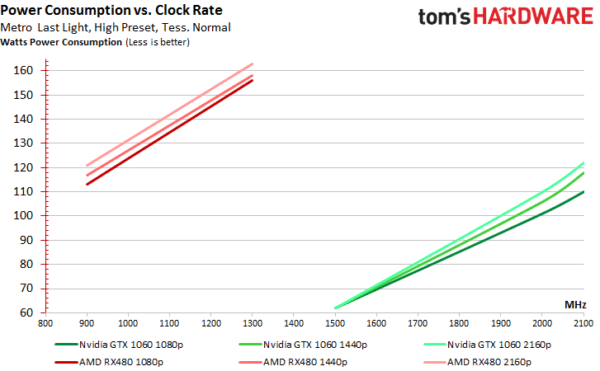

Les résultats obtenus sur la Radeon RX 480 sont inclus à titre de référence.

Nous avons établi la consommation minimale et la fréquence maximum. Puis, petit à petit, nous avons lancé les tests entre les deux extrêmes pour obtenir une courbe pertinente. L’abscisse représente les fréquences GPU Boost et l’ordonnée suit la consommation.

La GeForce GTX 1060 démarre entre 60 W et 62 W, quelle que soit la définition, ce qui correspond à un GPU Boost d’environ 1500 MHz. Lorsque l’on accroît l’objectif de consommation à 116 % et que l’on paramètre manuellement le ventilateur à 100 %, la fréquence monte entre 2050 MHz et 2100 MHz, tout comme sur les 1070 et 1080.

La Radeon RX 480 démarre à des fréquences se situant entre 850 MHz et 900 MHz lorsqu’on utilise notre mode d’économie d’énergie et que nous limitons la tension à 0,85 V. La plus haute fréquence que nous avons pu atteindre est 1300 MHz, ce qui est seulement 50 MHz de plus que les 1250 MHz standard.

Performances sous les jeux et consommation

La consommation des cartes concurrentes est sur l’abscisse et le taux d’image par seconde est sur l’ordonnée. Ce graphique nous permet de comprendre que la GeForce GTX 1060 demande 61 W pour atteindre 130 ips en 1920×1080, contre 139 W pour la RX 480, malgré une tension ajustée. Pour arriver à 90 ips en 2560×1440, la GTX 1060 demande un peu moins de 62 W, contre 146 W pour la RX 480.

Le test n’est pas parfait, mais aucun autre test n’améliorera les performances des cartes AMD de façon significative pour obtenir un rendement nettement meilleur. Le fait est que lorsqu’on limite la consommation des GTX 1070, 1080 et 980 Ti, les rendements sont très intéressants, mais cette solution n’est pas sans défaut.

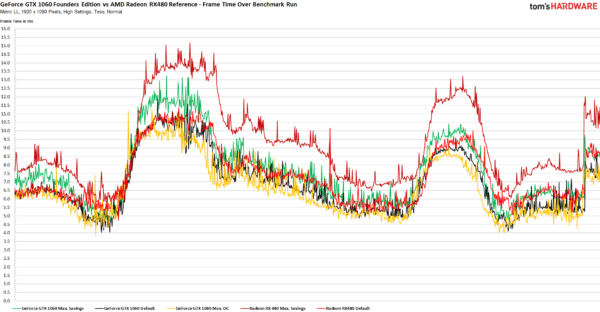

Vérification des résultats : stabilité du taux d’ips dans le temps

Le taux d’image par seconde moyen n’offre qu’une partie de l’image globale. Il faut une certaine stabilité pour offrir une image fluide. En 1920×1080, la RX 480 offre une expérience légèrement plus fluide. Par contre, réduire la consommation de la RX 480 réduit la stabilité, contrairement à la 1060, qui s’améliore lorsqu’elle est overclockée. Cela signifie que ceux qui souhaite économiser de l’énergie et jouer en 1920×1080 ne doivent pas descendre sous les 90 W.

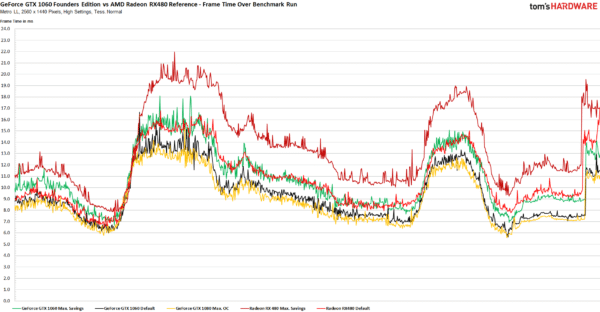

Les choses sont similaires en 2560×1440.

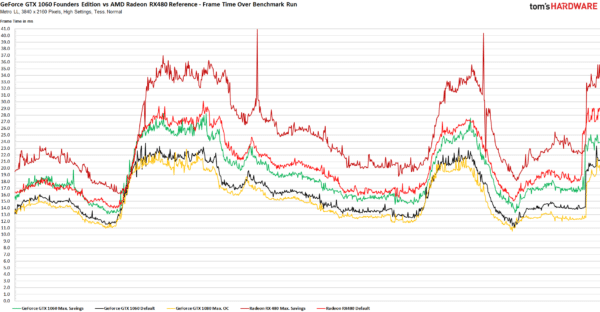

En 3840×2160 le taux d’image par seconde de la RX 480 prend un sacré coup. Overclocker la GTX 1060 a de sérieux avantages, même s’il faut réduire le niveau de détail au minimum. Il faut néanmoins rappeler que ces cartes ne sont pas faites pour jouer en 4K.

Conclusion

La GTX 1060 n’est pas très overclockable, mais il est possible d’extraire des performances supplémentaires. A fortiori, il est aussi possible d’économiser de l’énergie avec cette carte, qui peut se maintenir à 62 W si on la fixe à sa fréquence de base.

La Radeon RX 480 est une alternative pour les joueurs qui se préoccupent moins de la consommation et de la chaleur dégagée. Si vous possédez une alimentation limitée ou seulement un connecteur d’alimentation à six broches, il est préférable de passer par une GeForce GTX 1060.

Fréquences max, températures et bruit

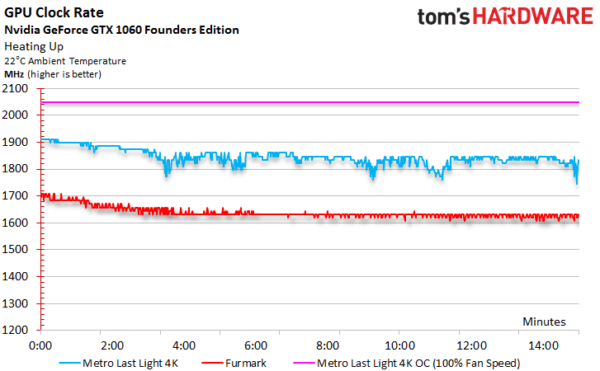

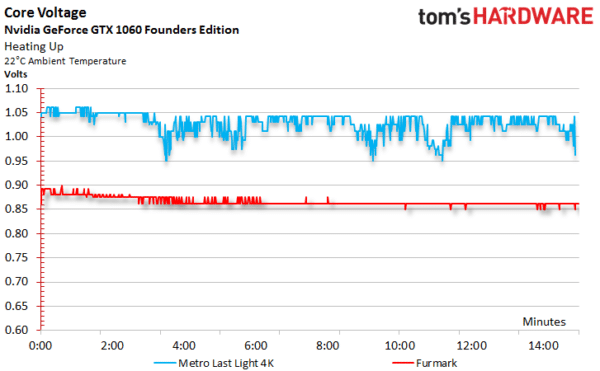

Fréquences Boost et tensions

Avec la GeForce GTX 1060, nous avons pu accroître la fréquence Boost, la consommation (jusqu’à 116 %), ainsi que la vitesse du ventilateur, et le résultat est impressionnant. Les 2050 MHz étaient stables sur notre exemplaire de test, même durant les tests les plus cruels.

Comparativement, en condition normale d’utilisation, la tension et la fréquence Boost tombent rapidement une fois les limites atteintes.

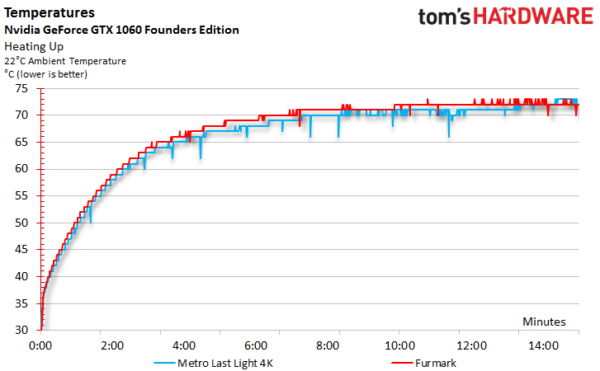

Températures

La consommation de GeForce GTX 1060 est similaire dans les deux cas mesurés ci-dessous. Il n’est donc pas surprenant que les deux courbes de température soient assez proches. Le GPU Boost 3.0 offre peu de marge de manœuvre, en ajustant la fréquence et la tension pour maintenir la carte aux niveaux prédéfinis.

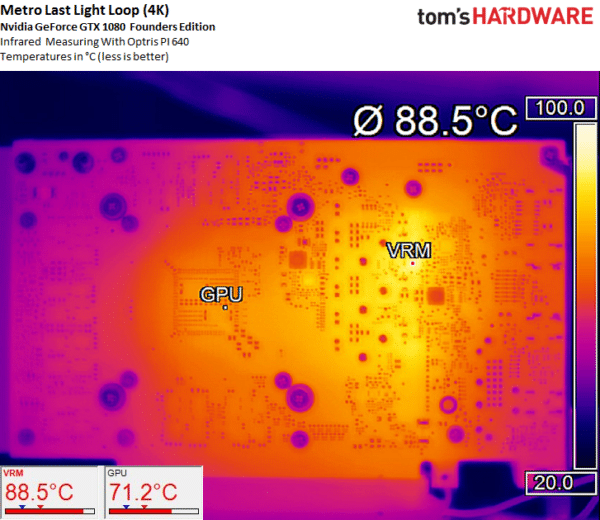

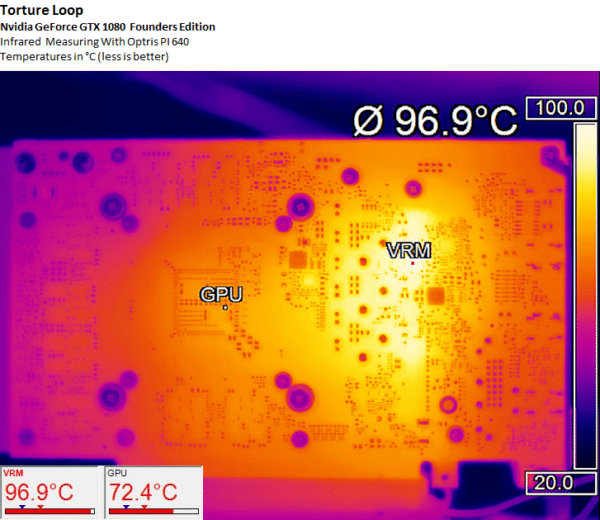

Les images prises avec les captures infrarouges montrent que les solutions de refroidissement font du bon travail. Les quatre convertisseurs de tensions sont aussi en bonnes conditions de fonctionnement.

Durant les tests intensifs, les trois convertisseurs de tension ont atteint 97 °C, ce qui est dans les normes. Sachant que personne ne lance des benchmarks intensifs pendant des heures, ces résultats sont avant tout théoriques.

Ventilateur et bruit

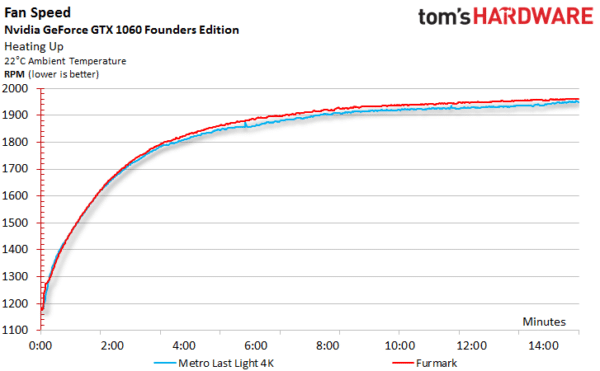

Encore une fois, les deux courbes sont similaires, ce qui n’est pas surprenant puisque les températures sont aussi très proches les unes des autres.

Au repos, nous mesurons un niveau sonore de 31,2 dB(A), ce qui est à peine plus que le bruit d’un salon. Le bruit émis par le ventilateur de NVIDIA est aussi nettement plus appréciable que celui du design de référence de la Radeon RX 480, même s’il est un peu plus fort.

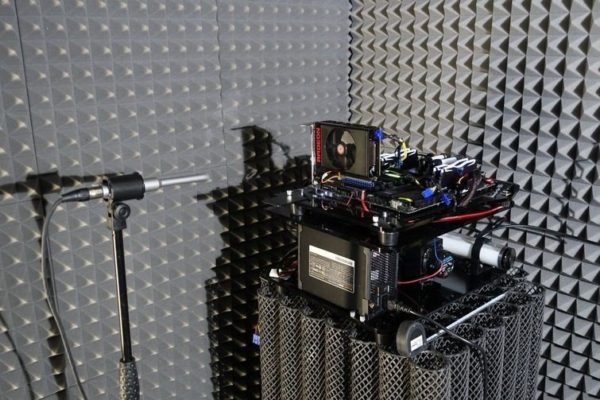

| Configuration de test | |

|---|---|

| Microphone | NTI Audio M2211 (avec fichier de calibration, Low Cut at 50 Hz) |

| Amplificateur | Steinberg UR12 (avec Phantom Power pour le microphone) |

| Configuration | – Intel Core i7-5930K @ 4,2 GHz, Watercooling – Crucial Ballistix Sport, 4x 4 Go DDR4-2400 – MSI X99S XPower AC – 1x Crucial MX200, 500-GB SSD (systèmes) – 1x Corsair Force LS, 960-GB SSD (Applications, données) – Be Quiet! Dark Power Pro, 850W |

| Watercooling | – Alphacool VPP655 Pump (sous-alimentée) – Alphacool NexXxos CPU Cooler – Phobya Balancer – Alphacool 24-cm Radiator – 2x 12-cm Noiseblocker eLoop Fan @400 tpm |

| Logiciel | Smaart v.7 |

| Chambre de test | Chambre personnalisée, 3.5 x 1.8 x 2.2 m (LxPxH) |

| Position de la mesure | Perpendiculaire au centre de la source, placé à 50 cm |

| Données mesurées | – Niveau du bruit en dB(A) (Lent), Analysateur de fréquences en temps-réel (RTA) – Spectre du bruit généré |

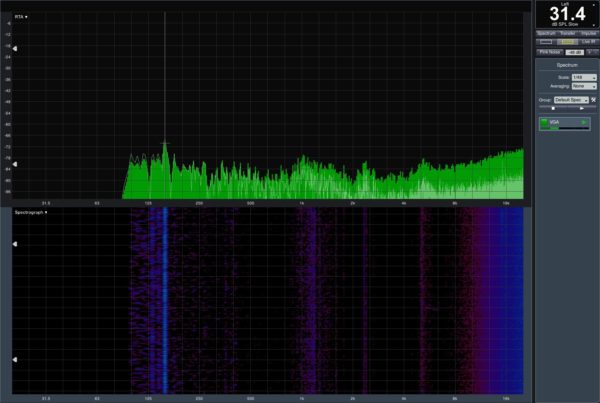

Après avoir atteint sa température maximum, la GeForce GTX 1060 émet juste 35,4 dB(A). Le roulement à billes et le moteur ne se font pas entendre. Le son n’est pas aussi bas et disgracieux que sur la carte d’AMD, qui monte à plus de 41 dB (voir notre test de la RX 480).

Il est vite clair que la majorité du bruit de la GTX 1060 est généré par les lames du ventilateur et la circulation de l’air. Le circuit de régulation de la tension est inaudible. La solution de refroidissement est donc très efficace. Il faut dire aussi que dissiper 120 W n’est pas un très grand défi non plus.

Conclusion

La GeForce GTX 1080 fut la première à présenter l’architecture Pascal au grand public, et cette carte graphique nous a époustouflée en dominant les cartes d’anciennes générations à des prix similaires. La GTX 1070 a aussi légèrement devancé les Maxwell les plus rapides, tout en coûtant quelques centaines de dollars en moins, et en consommant moins. Qu’en est-il de la GTX 1060 ?

La question piquante du prix

Voilà maintenant la GeForce GTX 1060 Founders Edition à 319 euros, tandis que NVIDIA préfère laisser ses partenaires sortir des cartes à haut volume démarrant à 279 euros. Le principe de la Founders Edition n’est donc pas convaincant dans ce cas précis, parce que payer 20 % de plus pour un design de référence, même sexy, n’a pas de sens. Il est préférable d’investir dans une carte plus performante. Les constructeurs devraient sortir des 1060 overclockées coûtant moins que la Founders Edition et qui seront surement plus prisées par les gamers.

Si l’on met de côté la Founders Edition pour se concentrer sur la GTX 1060 à 279 euros, on remarque que la nouvelle puce de NVIDIA est tout de même plus chère que la plupart des Radeon RX 480 8 Go. On retrouve les mêmes niveaux de performances pour la réalité virtuelle, mais le prix supérieur de la GTX 1060 peut se justifier par la technologie de multi-projection simultanée… à condition que cette technique soit exploitée. Il y a aussi Ansel pour ceux qui sont fans des captures d’écran dans les jeux.

AMD écrasé par le rendement de Pascal

Il y a ensuite la consommation et le rendement qui donnent un avantage certain à NVIDIA. Plus nos tests sont poussés et plus le rapport performance-watt joue en faveur de l’architecture en 16 nm de NVIDIA au détriment du 14 nm d’AMD qui se fait écraser.

Si l’on se penche uniquement sur les performances, la GeForce GTX 1060 devance la Radeon RX 480 dans sept de nos neuf benchmarks. Si l’on prend la moyenne des différences en pourcentage, la Geforce GTX 1060 est 13,5 % plus rapide en 1920 x 1080, et 12,5 % en 2560 x 1440. Elle ne permet toutefois pas de jouer à des définitions plus élevées. On reste donc aux niveaux des GeForce GTX 970, Radeon R9 390 et RX 480.

Pas de SLI, stocks limités

On regrette l’absence de SLI, et même si DirectX 12 permet de prendre en charge plusieurs 1060, le fait que NVIDIA n’offre pas une solution liant plusieurs cartes entre elles est décevant. Néanmoins, alors que les développeurs explorent de nouveaux effets de rendus et les calculs asynchrones, la technologie de NVIDIA, qui consiste à alterner le rendu des images sur les multiples cartes, n’est plus aussi efficace. Maintenant, plus que jamais, il est avant tout préférable d’avoir un GPU rapide, plutôt que plusieurs GPU plus lents.

Dans les faits, la GeForce GTX 1060 aura des stocks très limités. La puce sera donc principalement vendue sur des cartes partenaires, tandis que la Founders Edition sera uniquement disponible sur le site Nvidia.fr. La rédaction a reçu des GeForce GTX 1060 Gaming X 6G avec un GPU à 1595 MHz et une mémoire légèrement overclockée. C’est une carte impressionnante qui est attendue autour de 300 euros. Il y aura d’autres cartes qui démarreront à 279 euros, mais même à ce prix-là, il est difficile d’oublier la Radeon RX 480 4 Go à environ 220 euros, si l’on ne compte faire que du jeu en 1080p.