OpenAI chosit Google pour de nouvelles puces IA, se passant de Nvidia pour de nouveaux serveurs pour l’instant. L’objectif est avant-tout de réduire les coûts.

OpenAI, l’un des plus grands clients de puces d’intelligence artificielle de Nvidia, a récemment commencé à louer les puces d’IA de Google pour alimenter ChatGPT et d’autres produits. Cette décision marque la première fois qu’OpenAI utilise des puces non-Nvidia de manière significative, selon une source impliquée dans cet arrangement.

Objectif : réduire les coûts

Le passage aux puces de Google, connues sous le nom de Tensor Processing Units (TPUs), est motivé par le désir d’OpenAI de réduire ses coûts opérationnels. Jusqu’à présent, OpenAI s’appuyait principalement sur des partenariats avec Microsoft et Oracle pour utiliser les GPUs de Nvidia afin d’entraîner et de déployer ses modèles d’IA. Cependant, avec l’introduction récente d’une nouvelle plateforme de génération d’images, OpenAI a connu une augmentation significative de ses coûts, ce qui a conduit à cette décision stratégique.

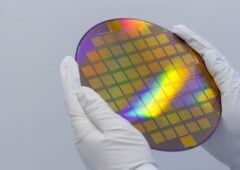

Google a lancé ses TPUs de septième génération en avril, affirmant qu’il s’agissait de sa première puce d’inférence d’IA. Ces puces ont déjà été utilisées par Apple pour entraîner sa plateforme Apple Intelligence, démontrant leur capacité à rivaliser avec les solutions de Nvidia.

Quel risque pour Nvidia ?

Ce changement stratégique d’OpenAI pourrait avoir des implications majeures pour Nvidia, qui domine actuellement le marché des puces d’IA. La décision d’OpenAI de diversifier ses fournisseurs de puces pourrait inciter d’autres entreprises à explorer des alternatives aux GPUs de Nvidia, surtout si ces alternatives offrent des avantages en termes de coûts et de performance.

Google, de son côté, cherche à étendre l’utilisation de ses TPUs à d’autres fournisseurs d’infrastructure de cloud computing. Si Google parvient à convaincre ces fournisseurs d’adopter ses puces, cela pourrait encore réduire la part de marché de Nvidia, déjà sous pression en raison de la pénurie d’approvisionnement et des prix élevés de ses GPUs.

De plus en plus de concurrence sur le calcul IA

Le marché des puces d’IA est en pleine croissance, avec une demande croissante pour des solutions performantes et économiques. Nvidia reste le leader incontesté, mais des alternatives émergent, offrant des économies potentielles et des avantages de performance. Pour les entreprises développant des modèles d’IA, le choix de la puce dépendra de plusieurs facteurs, notamment le coût, la performance et le support logiciel.

OpenAI a également exploré la possibilité de développer ses propres puces d’IA, ce qui pourrait encore réduire sa dépendance à l’égard des fournisseurs externes. Cette tendance vers des solutions personnalisées pourrait devenir plus courante à mesure que les entreprises cherchent à optimiser leurs coûts et à améliorer leurs performances.

OpenAI lâche Nvidia ?

Le passage d’OpenAI aux TPUs de Google marque un tournant dans le paysage de l’IA, mettant en lumière la compétition croissante dans le marché des puces d’IA. Alors que Nvidia reste le leader, des alternatives comme les TPUs de Google offrent des options viables pour les entreprises cherchant à réduire leurs coûts et à diversifier leurs fournisseurs. Cette évolution pourrait inciter d’autres acteurs du secteur à explorer des solutions similaires, remodelant ainsi le marché des puces d’IA dans les années à venir.