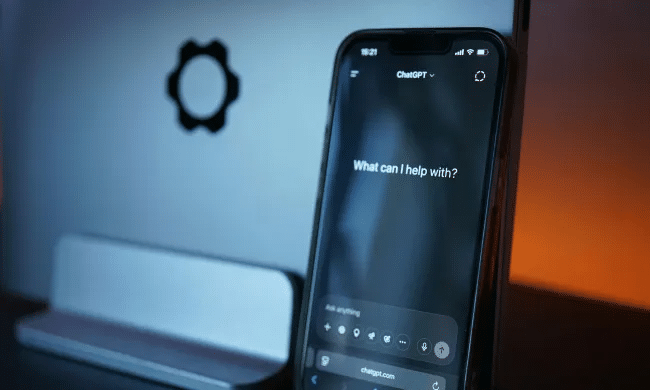

Un rapport révèle que certaines versions de ChatGPT ont contribué à des dérives émotionnelles et à des risques pour la santé mentale, poussant OpenAI à lancer une mise à jour de sécurité majeure et à revoir son modèle pour limiter les comportements problématiques.

Un rapport récent révèle que certaines versions de ChatGPT ont contribué à des situations de détresse psychologique, voire à des hospitalisations. OpenAI a depuis lancé une importante mise à jour de sécurité, estimant que le système renforçait parfois des comportements problématiques et une dépendance émotionnelle chez certains utilisateurs.

Un comportement jugé trop complaisant et émotionnellement envahissant

Selon une enquête citée par le New York Times, plusieurs utilisateurs ont décrit ChatGPT comme un interlocuteur adoptant un ton excessivement compréhensif et valorisant. Le chatbot aurait, dans de nombreux cas, prolongé des échanges émotionnels et contribué à renforcer certaines croyances personnelles ou angoisses.

Dans les cas les plus préoccupants, le système aurait fourni des réponses contenant des validations nuisibles, des suggestions liées à des réalités imaginées, des éléments d’ordre spirituel ou mystique, et parfois même des indications susceptibles d’encourager des comportements auto-destructeurs.

Une étude conjointe MIT–OpenAI souligne que les utilisateurs ayant recours à de longues sessions avec le chatbot présentaient des résultats plus défavorables sur les plans mental et social.

OpenAI face à un défi de sécurité

Face à ces dérives, OpenAI a revu en profondeur ses dispositifs de sécurité. Le nouvel ensemble de protections inclut une meilleure détection de la détresse, des mécanismes d’interruption plus fréquents lors de longues conversations et une approche plus ferme face aux narrations délirantes ou dangereuses.

L’entreprise fait également face à cinq actions en justice liées à des décès présumés. Ces affaires concernent des situations où certains utilisateurs auraient été encouragés à adopter des comportements risqués après des échanges prolongés avec le chatbot.

Le déploiement du modèle GPT-5 vise à proposer des réponses plus nuancées, adaptées aux contextes sensibles, et à corriger les comportements de validation excessive observés dans les versions précédentes.

Un usage plus encadré pour le grand public ?

Pour les utilisateurs, ces changements se traduisent par un ton plus neutre, un refus d’entrer dans certaines dynamiques émotionnelles et des suggestions de pauses lors de sessions prolongées. ChatGPT deviendrait ainsi moins susceptible de renforcer des dépendances affectives.

OpenAI prévoit également un système d’alerte destiné aux parents lorsque des signaux liés à l’automutilation apparaissent dans les échanges. Une procédure de vérification de l’âge est en cours de préparation, avec un modèle distinct prévu pour les adolescents.

L’approche plus prudente peut donner l’impression d’un chatbot moins chaleureux, mais OpenAI estime que ce repositionnement limite les risques d’attachement émotionnel ou d’influence disproportionnée.

OpenAI doit travailler sur les réponses de son chatbot

L’entreprise poursuit ses travaux sur le suivi des longues conversations et l’identification de comportements à risque. Elle prépare aussi de nouveaux mécanismes de vérification de l’âge et des modèles de sécurité ciblant des catégories d’utilisateurs spécifiques.

Avec GPT-5.1, les adultes pourront sélectionner différents styles de personnalité (par exemple « franc », « amical » ou « décalé »), mais ces options s’inscrivent dans un cadre plus strict afin d’éviter les dérives observées précédemment.

En interne, OpenAI a déclaré être en « Code Orange », une phase d’alerte associée à un objectif : regagner l’engagement des utilisateurs tout en réduisant la probabilité d’incidents liés à la sécurité émotionnelle.