NVIDIA et SK hynix co-développent pour 2027 un “AI SSD” capable d’atteindre 100 millions d’IOPS pour optimiser les charges de travail d’inférence, un projet qui risque de provoquer une pénurie majeure et une hausse des prix sur le marché mondial des puces NAND.

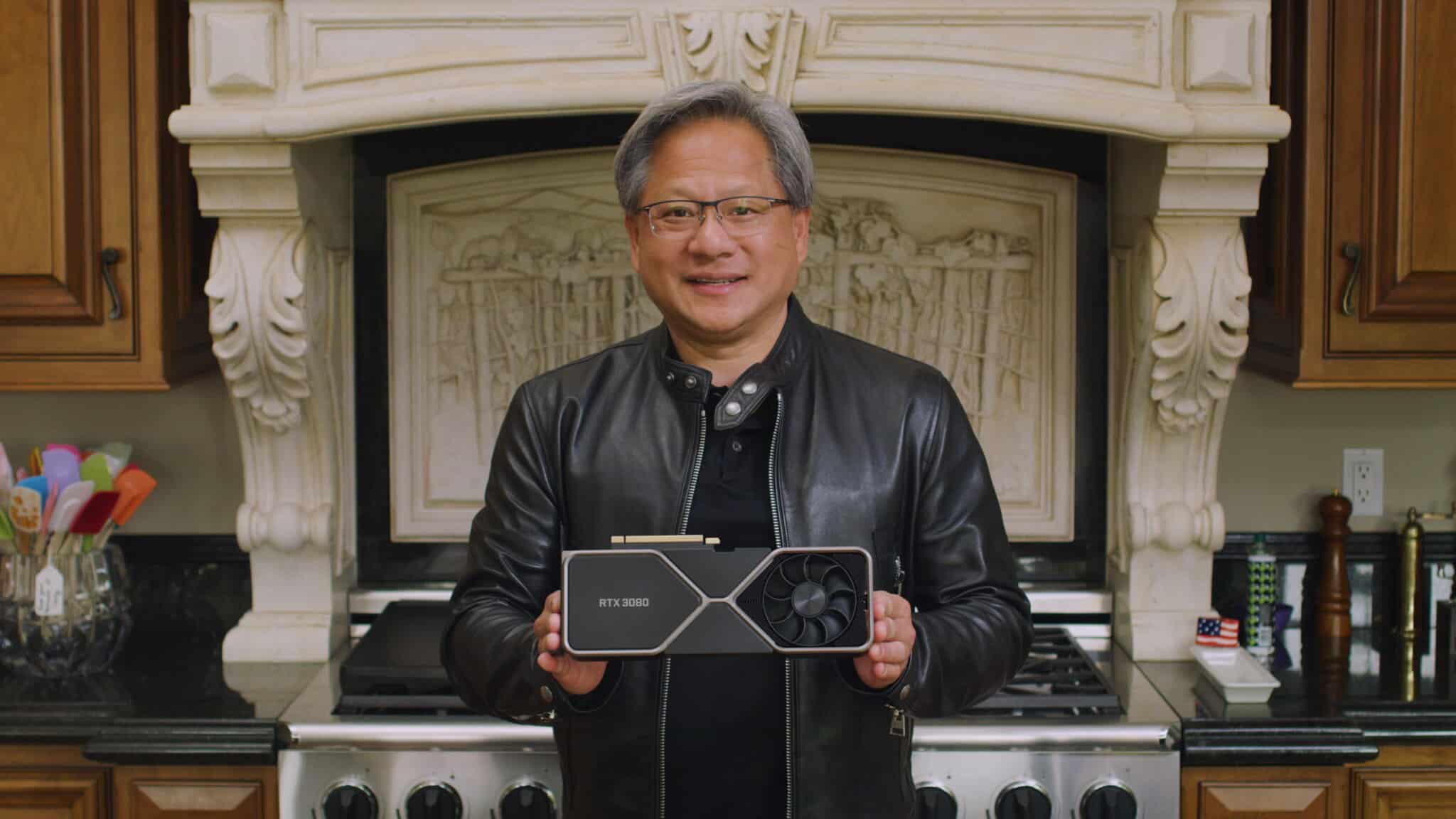

L’industrie de l’intelligence artificielle s’apprête à bouleverser une nouvelle fois le paysage du matériel informatique. Face à l’évolution des besoins vers l’inférence, NVIDIA et SK hynix collaborent sur un projet secret baptisé “Storage Next”. Ce futur “AI SSD”, promettant des performances décuplées pour 2027, fait déjà craindre des tensions majeures sur l’approvisionnement mondial en puces NAND.

Un stockage jusqu’à 10 fois plus rapide

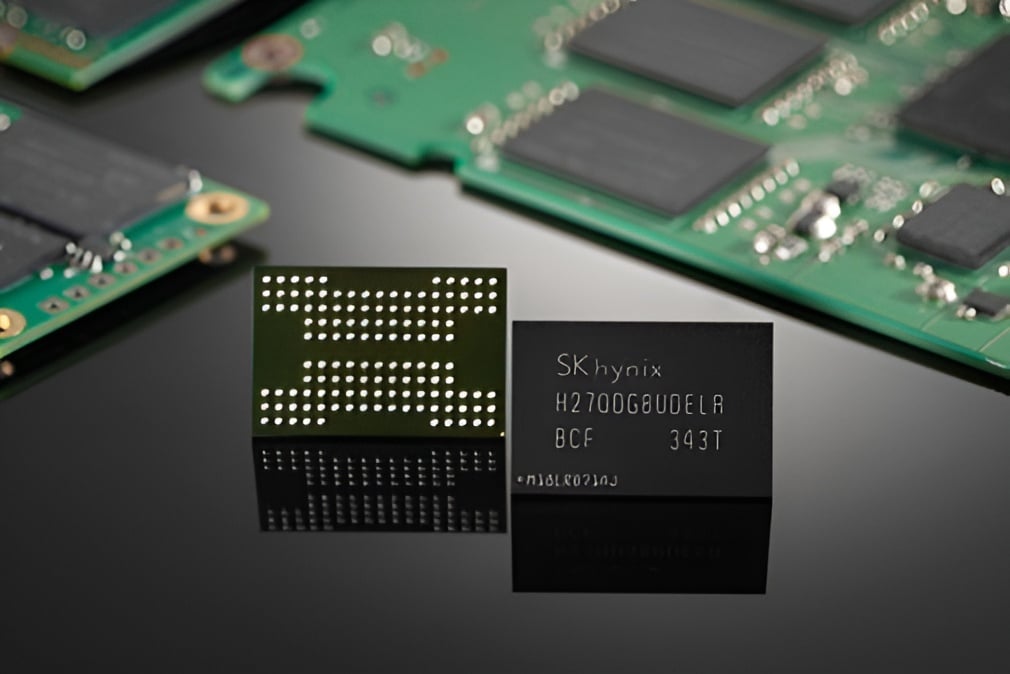

Dans une démarche visant à redéfinir les standards du stockage pour l’IA, le géant coréen SK hynix et le leader des GPU NVIDIA co-développent une nouvelle solution de stockage interne. Selon les informations disponibles, SK hynix prévoit de présenter un prototype d’ici la fin de l’année prochaine, avec une introduction sur le marché estimée à 2027.

L’ambition technique de ce projet est colossale. Cet “AI SSD” est conçu pour atteindre jusqu’à 100 millions d’IOPS (opérations d’entrée/sortie par seconde). Ce chiffre représente une performance 10 fois supérieure à ce que proposent actuellement les SSD d’entreprise traditionnels. L’objectif principal est d’améliorer considérablement le débit et l’efficacité énergétique grâce à des architectures de contrôleurs et de NAND avancées.

Un SSD qui se comporterait comme de la RAM

Cette course à la performance s’explique par un changement structurel dans les charges de travail de l’IA. Alors que l’industrie se déplace de l’entraînement des modèles vers l’inférence, la pile technologique doit évoluer pour garantir un environnement à faible latence et à haut débit.

Les structures actuelles nécessitent un accès continu à des paramètres de modèles massifs. Or, les solutions existantes, qu’il s’agisse de la mémoire HBM (High Bandwidth Memory) ou de la DRAM à usage général, ne peuvent plus accommoder efficacement ces volumes de données.

L’AI SSD agirait ainsi comme une pseudo-couche de mémoire, spécifiquement optimisée pour ces nouvelles exigences. Cette stratégie fait écho à la décision récente de NVIDIA d’intégrer de la mémoire GDDR7 dans son GPU Rubin CPX, signalant une tendance lourde vers la diversification des types de mémoire pour l’IA.

La crise des puces de DRAM retarderait le projet

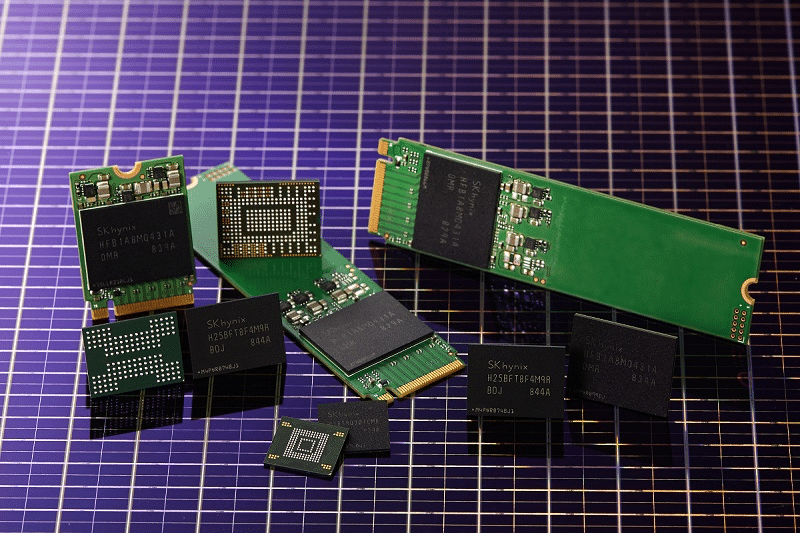

Si la prouesse technologique suscite l’enthousiasme, elle soulève également de vives inquiétudes économiques. Les lignes d’approvisionnement en NAND sont déjà sous une pression massive en raison de la demande croissante des fournisseurs de services cloud (CSP) et des géants de l’IA.

L’article souligne un risque réel de perturbation des chaînes logistiques existantes. Si cette solution de SSD pour l’IA devient courante, le marché pourrait connaître une situation similaire à celle de la DRAM, où les prix des contrats s’aggravent quotidiennement. Le coût élevé nécessaire pour faciliter ces charges de travail IA laisse peu de temps aux consommateurs et aux fournisseurs pour s’adapter à cette nouvelle dynamique offre-demande. Il semble que la mémoire NAND soit la prochaine sur la liste des composants à risque de pénurie et d’inflation.