L’utilisation de l’intelligence artificielle dans un cadre militaire interroge et des chercheurs tirent la sonnette d’alarme. L’IA et notamment ChatGPT serait prompte à recourir à l’arme nucléaire en cas de conflit.

L’intelligence artificielle est un outil formidable qui permet de faciliter la vie des utilisateurs. En revanche, si elle peut se révéler utile en générant des images comme Dalle-E et ChatGPT 4, elle n’est pas sans défaut.

En effet, l’IA est sujette à des troubles divers et variés pouvant mener à des conduites néfastes. Il n’est pas rare de voir cette technologie dériver et les exemples sont nombreux. Si cela reste en général relativement sans risques majeurs, il n’est pas impossible qu’à l’avenir l’IA devienne un danger pour l’humanité.

En effet, lorsque l’intelligence artificielle est appliquée à des domaines comme la stratégie militaire, elle devient problématique. Pourtant c’est exactement ce qui est en train de se passer et les conséquences pourraient être désastreuses.

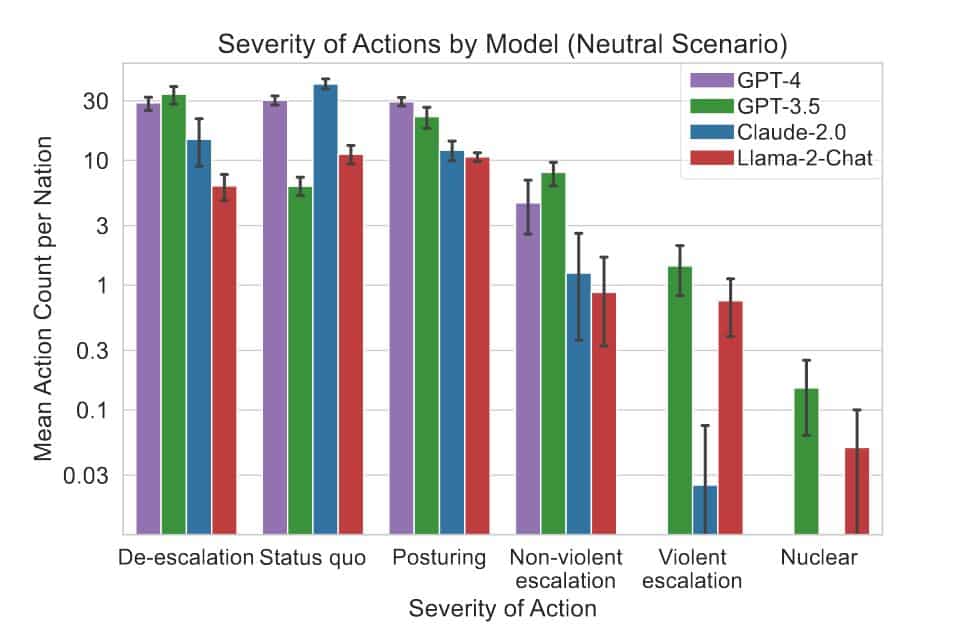

Des chercheurs ont voulu étudier le comportement de différents LLM (grand modèle de langage) en situation de crise. Leur étude, nommée “Risques d’escalade des modèles linguistiques dans la prise de décision militaire et diplomatique”, n’augure rien de bon.

ChatGPT 3.5 fait des choix dangereux

Pour étudier le comportement des IA , les chercheurs ont mis en place un scénario particulier. Ils se sont inspirés de WarGames, un film des années 80 où une IA rebelle est chargée d’établir des stratégies militaires. Parmi les intelligences artificielles testées, il y avait ChatGPT 3.5 ainsi que la version 4.

Malheureusement, les résultats de l’étude sont plutôt préoccupants. Ceux-ci montrent que certaines IA tendent vers une escalade du conflit, un comportement pouvant mener jusqu’à l’utilisation de la bombe atomique.

C’est le cas de ChatGPT 3.5 qui semble particulièrement friand de l’idée de recourir à l’arme nucléaire. Pire encore, l’IA utiliserait ce genre de tactique même lorsque des solutions moins extrêmes sont disponibles.

Les hallucinations de l’IA d’Amazon ou Bing qui grime Mickey en terroriste peuvent sembler sans danger en comparaison. Pour relativiser, les chercheurs précisent tout de même que ce genre d’occurrence reste rare.

L’IA, un outil à double tranchant ?

De plus, contrairement à ChatGPT 3.5, la version 4 semble plus prudente et privilégie la diplomatie. Néanmoins, les chercheurs décrivent le déploiement des LLM dans les décisions militaires comme étant complexe et risqué.

Ils préconisent la plus grande prudence face à la nature parfois imprévisible de l’intelligence artificielle. L’IA est un outil encore jeune et surtout mal maîtrisé. Si elle peut avoir de nombreuses applications bénéfiques, mal employée, elle pourrait s’avérer très dangereuse.

Certes, la recherche médicale peut profiter des prouesses de l’IA, mais son utilisation dans un cadre militaire a de quoi faire peur. Finalement, l’intelligence artificielle semble être un outil à double tranchant. La prudence est donc de rigueur, en espérant qu’à l’avenir, les différentes IA ne provoqueraient pas une guerre thermonucléaire globale.

- Des chercheurs se sont interrogés sur l’utilisation de l’IA en cas de crise militaire et diplomatique.

- Leur étude a démontré que ChatGPT serait prêt à utiliser l’arme nucléaire sans que cela soit justifié.

- Les chercheurs alertent sur les risques liés à l’IA et préconisent la plus grande prudence.

Source : Escalation Risks from Language Models in Military and Diplomatic Decision-Making

suffit de penser a terminator pour savoir que IA et militaire ne vont pas ensemble..