Les benchmarks MLPerf v5.1 révèlent que la plateforme Intel Project Battlematrix, équipée des GPU Arc Pro B60 et des processeurs Xeon 6, offre un rapport performance/prix jusqu’à quatre fois supérieur à celui des solutions NVIDIA L40S et RTX PRO 6000, tout en proposant une solution intégrée optimisée pour l’inférence IA en environnement professionnel.

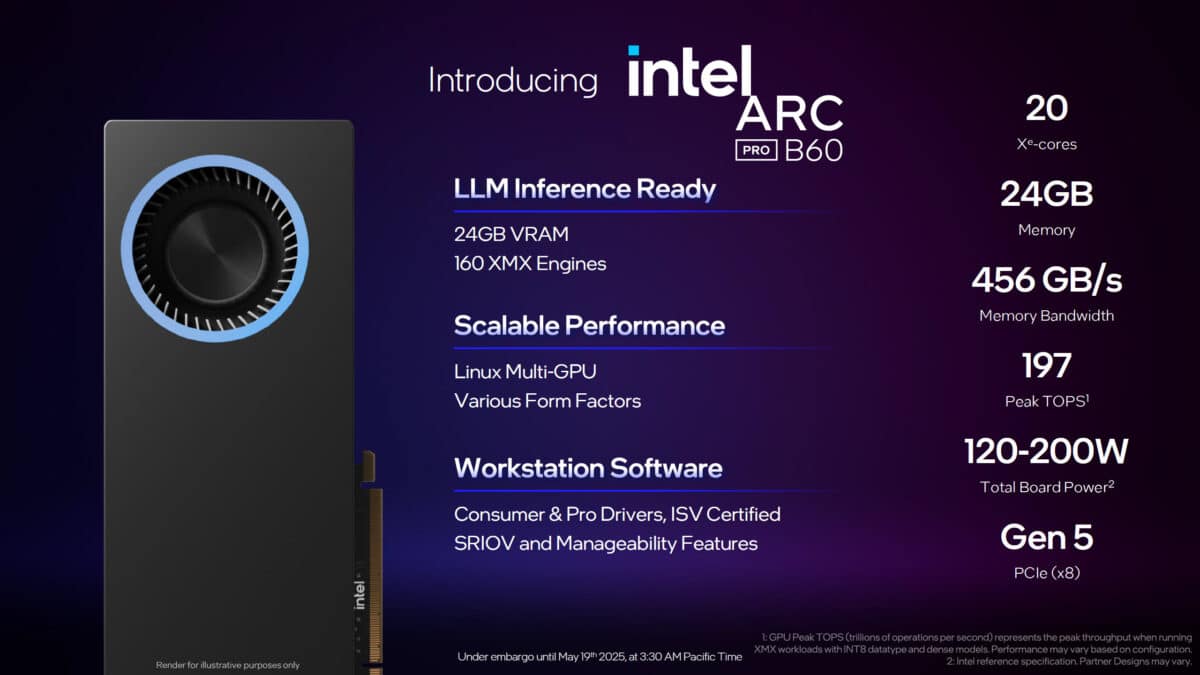

Intel a récemment publié les résultats de ses benchmarks pour le projet Project Battlematrix, une plateforme de travail dédiée à l’inférence d’intelligence artificielle (IA), équipée de ses GPU Arc Pro B60 et de processeurs Xeon 6. Ces résultats, issus des tests MLPerf Inference v5.1, mettent en avant des performances compétitives, notamment en termes de rapport performance/prix, face aux solutions concurrentes de Nvidia.

Des performances optimisées pour l’inférence IA

Selon les données communiquées par Intel et validées par MLCommons, la plateforme Project Battlematrix affiche des gains significatifs dans plusieurs scénarios d’inférence. En particulier, dans le benchmark Llama 3.1 (8B Datacenter), le système Intel atteint 6472,37 échantillons par seconde en mode hors ligne et 5348,45 requêtes par seconde, contre respectivement 1642,22 échantillons/seconde et 1 207,14 requêtes/seconde pour la carte Nvidia L40S. Comparée à la RTX PRO 6000, la solution Intel propose un avantage de 25 % en performance par dollar, tout en revendiquant un rapport performance/prix jusqu’à quatre fois supérieur à celui de la L40S.

Ces résultats soulignent l’efficacité d’une architecture entièrement Intel, combinant GPU et CPU optimisés pour les charges de travail d’inférence. Intel insiste sur la capacité de sa plateforme à répondre aux besoins des professionnels cherchant à déployer des modèles de langage (LLM) sans dépendre de solutions propriétaires ou de coûts d’abonnement élevés.

Une approche intégrée pour l’inférence

Le projet Battlematrix se distingue par une solution conteneurisée, conçue pour les environnements Linux, et optimisée pour le passage à l’échelle multi-GPU ainsi que pour les transferts de données PCIe peer-to-peer (P2P). La plateforme intègre également des fonctionnalités essentielles pour les environnements professionnels, telles que :

- La correction d’erreurs (ECC),

- La virtualisation des entrées/sorties (SR-IOV),

- La télémétrie avancée,

- La mise à jour à distance du micrologiciel.

Intel souligne que les processeurs Xeon 6 avec cœurs P jouent un rôle central dans l’orchestration des tâches d’IA, en gérant le prétraitement, la transmission des données et la coordination globale du système. Les améliorations apportées aux performances IA des CPU Intel au cours des quatre dernières années ont renforcé leur position dans les systèmes accélérés par GPU.

Un engagement continu dans l’évaluation des performances

Intel reste le seul fournisseur à soumettre des résultats de CPU serveurs aux benchmarks MLPerf, confirmant son engagement à accélérer les capacités d’inférence IA, tant au niveau des processeurs que des accélérateurs. La dernière génération de Xeon 6 affiche une amélioration de 1,9 fois en performance par rapport à la génération précédente, selon les tests MLPerf Inference v5.1.