Introduction

Au fur et à mesure que les mois s’égrènent depuis le lancement de la GeForce 8800 (plus de 5 mois maintenant), le parallèle avec la Radeon 9700 Pro devient de plus en plus évident. Outre le saut en performances, en qualité d’affichage, en génération technologique et en architecture, se sont en effet ajoutés les retards de plus en plus inattendus, et donc inquiétants, de la riposte du grand rival. Un retard tel que nVidia décline aujourd’hui son architecture sur le milieu de gamme en étant toujours le seul à disposer de puces DirectX 10, ce qui là encore n’est pas sans nous rappeler la situation qui s’est produite lors du lancement des cartes DirectX 9.

L’enjeu des puces de milieu de gamme n’a pas changé depuis des années : il s’agit selon nous des plus importantes, les seules que pourront s’offrir les joueurs au budget conséquent mais pas illimité, et qui offrent subjectivement le meilleur rapport performances/prix (les puces d’entrée de gamme ne permettant pas de prendre vraiment du plaisir à jouer, et le haut de gamme restant bien plus cher). Et force est de constater que sur les deux dernières générations, nVidia a toujours soigné celles-ci et proposé très rapidement des solutions cohérentes et performantes, ce qu’ATI a toujours mis plus de temps à trouver.

Traditionnellement, ces puces sont assez prévisibles : depuis plusieurs générations maintenant (3 chez nVidia), elles reprennent l’ensemble de la technologie des versions haut de gamme, l’émasculation ne portant que sur les unités de calcul, de traitement, sur les fréquences et sur la mémoire. L’interrogation ne porte donc essentiellement que sur les performances au final. Ce n’est pourtant pas le cas aujourd’hui, nVidia ayant réservé à ses GeForce 8600 une innovation qui risque de rendre jaloux les possesseurs de GeForce 8800. Se souviendra-t-on de ces cartes comme des mémorables Radeon 9500 Pro, ou de simples 9600 Pro ?

3D logique, mémoire toujours à 128 bits

A priori, il faut bien reconnaître que les spécifications des GeForce 8600 sont légèrement décevantes. Reprenant l’ensemble de l’architecture GeForce 8, la puce G84 qui les équipes n’est en effet dotée que de 32 stream processors, contre 128 sur la 8800 GTX et 96 sur le 8800 GTS. Alors qu’habituellement, nous avions plutôt droit à une réduction par deux, du temps des pipelines. L’explication la plus évidente est que contrairement aux précédentes puces haut de gamme de nVidia, le G80 est un monstre (près de 500 mm² de surface pour rappel), et qu’il était impensable d’avoir des coûts de production significativement plus élevés que pour la précédente génération sur le segment des cartes à 150 – 200 €, ni même d’exiger une alimentation surpuissante. Sans parler des déclinaisons mobiles qui devaient bien voir le jour (contrairement à un fort hypothétique GoForce 8800).

Ici, on retombe ainsi de 681 millions de transistors à 289 millions, et le passage d’une finesse de gravure de 0.09µ à 0.08µ permet en outre d’améliorer encore les choses : dénué de heatspreader à l’inverse du G80, nous avons mesuré la surface du G84 à seulement 169 mm² ! Ce qui reste donc dans le même ordre de grandeur que les précédentes puces de milieu de gamme nVidia, soit pour rappel 150 mm² pour les GeForce 6600 et 127 mm² pour les 7600 qui étaient particulièrement optimisées sur ce point.

Mais est-ce à dire que la puissance de la GeForce 8600 GTS est 4 fois inférieure à celle de la 8800 GTX ? Non, avant tout car les fréquences de cette carte sont les plus élevées de la gamme GeForce 8 : 675 MHz pour le GPU, 1450 MHz pour les stream processors et 1000 MHz pour les puces mémoires. Malheureusement, le bus mémoire reste inéluctablement bloqué à 128 bits, de sorte que la bande passante mémoire est de 32 Go/s ce qui reste un brin décevant même si cette valeur a tendance aujourd’hui a revêtir une importance un peu moindre. En ce qui concerne la 8600 GT, les spécifications sont en baisse de 18 % (puissance des shaders) à 30 % (bande passante mémoire).

| GPU | 8800 GTX | 8600 GTS | 8600 GT | X1950 Pro |

|---|---|---|---|---|

| Fréquence GPU | 575 MHz | 675 MHz | 540 MHz | 575 MHz |

| Fréquence shaders | 1350 MHz | 1450 MHz | 1190 MHz | 575 MHz |

| Fréquence mémoire | 900 MHz | 1000 MHz | 700 MHz | 690 MHz |

| Largeur du bus mémoire | 384 bits | 128 bits | 128 bits | 2 x 256 bits |

| Type de mémoire | GDDR3 | GDDR3 | GDDR3 | GDDR3 |

| Quantité de mémoire | 768 Mo | 256 Mo | 256 Mo | 256 Mo |

| Nombre de Pixels Pipelines | (32) | (8) | (8) | 36 |

| Nombre d’unités de texturing | 32 | 8 | 8 | 12 |

| Nombre de processeurs de vertex | (128) | (32) | (32) | 8 |

| Fillrate théorique | (43200 MPixels) | (11600 MPixels) | (9520 MPixels) | 20700 MPixels |

| Vertexrate théorique | (43200 Mtris) | (11600 Mtris) | (9520 Mtris) | 1150 MTris |

| Bande passante mémoire | 86,4 Go/s | 32 Go/s | 22,4 Go/s | 44,2 Go/s |

| Nombre de transistors | 681 millions | 289 millions | 289 millions | 330 millions |

| Process | 0.09µ TSMC | 0.08µ TSMC | 0.08µ TSMC | 0.08µ TSMC |

| Surface du die | 484 mm² | 169 mm² | 169 mm² | 238 mm² |

| Génération | 2006 | 2007 | 2007 | 2006 |

| Shader Model supporté | 4.0 | 4.0 | 4.0 | 3.0 |

| Prix | 550 € | 200 € | 150 € | 170 € |

Par ailleurs, comme à son habitude nVidia a légèrement optimisé sa puce afin d’améliorer les performances à fréquence égale avec la 8800. Le G80 disposait de 32 unités d’adressage mais chaque unité pouvait filtrer 8 texels par cycles contre 4 pour les unités du G70. Comme on ne disposait que de 32 unités d’adressage, ce surplus de puissance de filtrage pouvait être utilisé par les modes plus évolués comme le trilinéaire, l’anisotropique ou l’accès aux textures FP16 qui devenait “gratuit” (modulo l’impact sur le cache de texture). Le G84 dispose pour sa part de deux unités de textures indépendantes.

Ce changement nous rappelle le passage du NV10 (GeForce 256) au NV15 (GeForce 2 GTS) : le NV10 avait 4 unités de textures capables de faire du trilinéaire en un cycle, le NV15 avait 8 unités capables soit de faire du trilinéaire en un cycle, soit d’échantillonner deux textures différentes et de faire du multitexturing en un cycle. Aujourd’hui évidemment on ne parle plus de multitexturing mais de nombres d’instructions de textures par rapport au nombre d’instructions arithmétiques.

Pour faire simple, à quoi cela sert-il ? A avoir une meilleure efficacité dans certains cas. Lors de l’échantillonnage de nombreuses textures différentes, avec un filtrage simple (bilinéaire) les unités puissantes du G80 seront sous-employées. Le G84 devrait être plus efficace dans ce type de situations. Il reste difficile à quantifier en pratique le gain que cela peut apporter mais c’est un petit plus toujours bon à prendre sur une architecture déjà très performante.

Mais au final, l’écart de puissance entre le milieu de gamme et le haut de gamme est très clairement bien plus profond que sur les précédentes générations, et c’est sans doute une des limites de l’architecture GeForce 8 même si sa supériorité actuelle devrait lui autoriser ce genre de limitation.

PureVidéo 2 : le H.264 entièrement décodé

La plus grosse nouveauté technologique liée à l’introduction des GeForce 8600 et 8500 se situe clairement au niveau du moteur vidéo, le PureVidéo, qui passe à la version 2. Certes, les GeForce 6600 étaient elles aussi les premières GeForce à intégrer une version entièrement fonctionnelle du PureVidéo en pratique, mais cela n’était a priori pas voulu par nVidia qui l’a d’abord implémenté sur ses cartes haut de gamme. Comme le veut la tradition.

Outre le passage au PureVidéo 2 (ce moteur étant toujours clairement distingué de toute la partie 3D), les GeForce 8600 intègrent 2 nouveaux moteurs, le H.264 bitstream processor et le décrypteur AES 128 bits.

- Le PureVidéo 2 rajoute à la première version des optimisations dans la gestion de la transformée en cosinus discrète inverse (IDCT, cf notre article sur la décompression du H.264), du Motion Compensation et du deblocking. Cela concerne le MPEG 2 (DVD) ainsi que les deux formats utilisés sur les médias HD, le VC-1 et le H.264 (jusqu’à 40 Mbits/s). Autre ajout : la prise en charge du Picture in Picture, cette possibilité utilisée par certains bonus des HD DVD ou Blu-ray d’afficher une seconde vidéo (généralement SD) en sus de la première (HD).

- Le H.264 bitstream processor, comme son nom l’indique, est au contraire entièrement dédié au seul H.264 qui est en train de s’imposer comme le format de référence. Ce DSP permet d’accélérer la première et seule étape du décodage vidéo que ne prend pas en charge le PureVidéo 2, l’entropy encoding.

- Le décrypteur AES 128 bits est une puce nécessaire pour la norme AACS du décryptage HDCP. L’idée de base étant de rendre les données illisibles à chaque fois qu’un flux vidéo protégé doit passer par un bus accessible à l’utilisateur, comme le PCI Express. Cette puce n’accompagnait jusqu’alors pas nativement le PureVidéo, et c’est pourquoi seule une minorité de cartes graphiques nVidia disposent aujourd’hui de la certification HDCP : la puce devait être rajoutée sur le PCB de la carte graphique.

Au final, nVidia met en avant le fait que les GeForce 8600 soient les premières cartes graphiques à prendre en charge à 100 % la décompression du H.264, ce qui est vrai (mais pas du VC-1, MPEG 2 HD ou du WMV9 HD, qui restent moins importants il est vrai). Le constructeur parle du passage d’un taux d’occupation processeur (Core 2 Duo E6400) de 60 à 75 % avec une GeForce 7600 GT et divers HD DVD (Yozakura, The Interpreter) et Blu-ray (Open Season, Chicago) à environ 20 % avec une GeForce 8600 GTS. De sorte que n’importe quel processeur actuel serait suffisant. Ce qui, si cela se vérifie, permettra au PureVidéo de repasser devant les meilleurs logiciels de décompression H.264, qui se sont bien améliorés depuis son lancement initial. Seul problème : ce support est pour l’instant limité à Windows Vista (nVidia parle seulement de juin au mieux pour les drivers appropriés pour Windows XP) et à une version beta de WinDVD 8 Platinum. Ce qui ne nous a pas permis de vérifier l’efficacité du PureVidéo 2 comme nous le souhaitions, vu les délais impartis pour le test par ailleurs (nous reviendrons bien sûr sur cette partie dès que possible).

Quid de l’encodage par ailleurs ?

La GeForce 8600 GTS

Pour ce test, nous avons pu nous procurer la GeForce 8600 GTS HD OC de MSI que nous remercions au passage. Une carte reprenant le design de référence, qui est particulièrement discret : design single-slot, longueur limitée à 18,7 cm, PCB simple, etc. Seules 4 puces mémoires GDDR3 sont présentes, évidemment signées Samsung (K4J523240E), les mêmes que l’on retrouve en fait sur la 8800 GTX mais 3 fois plus nombreuses.

Côté ventirad, le modèle retenu est lui aussi assez petit, et composé d’un radiateur hybride cuivre (base et caloducs plats) / aluminium (ailettes), ainsi que d’un ventilateur radiale de 5 cm de diamètre et de 2,3 W de puissance maximum. Une version miniature du modèle que l’on retrouve sur les GeForce 8800, ce qui laisse présager du meilleur concernant la nuisance sonore. A noter qu’en revanche, la chaleur dégagée par la carte ne sera pas évacuée directement à l’extérieur du boîtier.

Comme bon nombre de modèles, cette carte MSI présente la particularité d’être overclockée d’origine (comme son nom l’indique). Mais dans une proportion négligeable cependant, reprise du design de référence oblige : 690 MHz pour le GPU (+2 %) et 1050 MHz pour la mémoire (+5 %), soit un gain moyen en pratique de 3 % sur l’ensemble de notre panel de test. Bien que nous ayons reçu un exemplaire nu, la version boîte intègrera un câble S-Vidéo, 2 adaptateurs DVI -> VGA, un adaptateur pour l’alimentation (Molex -> PCI Express), ainsi que le jeu Company of Heroes.

Nous avons par ailleurs réduit les fréquences de cette carte afin d’obtenir les performances de la 8600 GT, qui ne se distingue comme nous l’avons vu que sur ce point.

A noter que côté consommation, nVidia parle d’une maximum de 71 watts pour la 8600 GTS contre seulement 43 watts pour la 8600 GT, soit près de 40 % de moins ce qui nous paraît un peu surprenant vu les spécifications précédentes. On peut par ailleurs remarquer que le connecteur d’alimentation supplémentaire présent sur la 8600 GTS (mais pas sur la GT) n’est là que pour assurer une meilleure stabilité et pour l’overclocking, les spécifications du bus PCI Express autorisant un maximum théorique de 75 watts.

Le test

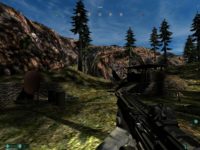

Nous avons profité de ce test pour mettre à jour notre protocole, des jeux particulièrement bons et techniquement novateurs ayant fini par apparaître après les traditionnels mois de disette d’après noël. A commencer par le FPS STALKER qui est finalement disponible depuis quelques jours, et qui sans parvenir à combler tous les espoirs qu’il avait fait naître sur le plan du gameplay, demeure visuellement impressionnant. Et devient par ailleurs le jeu le plus gourmand de notre panel, avec Supreme Commander. Point commun aux 2 titres : toutes les options n’ont pu être activés au maximum afin d’assurer un minimum de fluidité (fidélité des ombres réglé sur faible pour Supreme Commander, réglages par défaut pour STALKER) A noter que de par son recours au defered rendering, l’antialiasing que STALKER propose a un impact visuel assez faible, et vu sa forte gourmandise sans même activer ce filtre par ailleurs, nous ne l’avons pas utilisé pour ce test.

Autre jeu notable, Test Drive Unlimited fait son apparition et remplace désormais les sempiternels Need For Speed tuning. Bien qu’ayant lui aussi recours au HDR, son utilisation est ici bien plus parcimonieuse et réaliste que sur le titre d’EA.

Moins intéressants techniquement, Silent Hunter 4 et Command & Conquer 3 font tout de même leur apparition vu le succès qu’ils rencontrent. Moins afin d’analyser les performances des GeForce 8600 que pour donner aux amateurs de ces deux titres des résultats avec différentes cartes graphique (C&C 3 est par exemple basé sur un moteur assez ancien, le Sage engine, et limité à 30 images/seconde au maximum).

Enfin, FEAR est remplacé par son successeur FEAR Combat qui reste basé sur le même moteur, mais dispose de cartes plus riches et rencontre une vraie popularité en réseau.

Configuration de test :

- Intel Core 2 Quad QX6700 (2.66 GHz)

- Intel Bad Axe 2 (i975)

- Crucial 2 * 1 Go DDR2 800 MHz 4-4-4-12

- Hitachi T7K250 250 Go + Raptor 74 Go

- Lecteur DVD Asus 12X

- Tagan U15 530 Watts

Drivers utilisés (Windows XP) :

- ForceWare 93.71 WHQL (GeForce 6 et 7)

- ForceWare 158.16 (GeForce 8)

- Catalyst 7.3 WHQL (Radeon)

Test Drive Unlimited, Supreme Commander

Test Drive Unlimited

Mise à part le fait que les GeForce 6 et 7 ne permettent pas d’activer l’antialiasing une fois le HDR appliqué (ce qui est fait avec toutes les cartes), les GeForce 8600 sont certes plus à l’aise sur Test Drive Unlimited. Ainsi, la 8600 GTS parvient à faire jeu égale voir à dépasser sa concurrente directe chez AMD, la Radeon X1950 Pro, en 1280*1024 et 1600*1200. Seul problème : les derniers modèles de nVidia semblent payer un lourd tribut du fait de leur bus mémoire 128 bits, puisque l’activation de l’antialiasing se révèle désastreuse sur les performances : le framerate chute de 55 % suite à l’application de l’antialiasing 4X ! Ce qui est loin d’être le cas avec les cartes ATI, qui disposent toutes d’un bus 256 bits bidirectionnel (architecture en anneau).

Supreme Commander

Fidèle à lui-même, Supreme Commander ici évalué au cours du bombardement aérien d’une base ennemi met à genou les cartes graphiques milieu/haut de gamme actuelles. Le constat est un peu similaire à celui fait sur Test Drive Unlimited pour les GeForce 8600 : la GTS est équivalent ou légèrement supérieure à la X1950 hors filtres, mais une fois les filtres activés la chute de performances est conséquente. Le modèle GT se révèle environ 23 % moins performant que la 8600 GTS HD OC de MSI, la différence avec le modèle de référence se limitant à 21 %.

Age of Empires 3, Oblivion

Age of Empires 3

Se disputant malgré son âge la place de plus joli jeu de stratégie avec Supreme Commander (le résultat variant suivant les sensibilités de chacun), Age of Empires 3 reste très gourmand en puissance de pixel shading. Et à ce petit jeu, l’architecture unifiée et adaptable des GeForce 8 se révèle sans trop de difficulté supérieur à celle des Radeon X1900 qui faisaient jusqu’alors référence en la matière. La 8600 GTS se hisse quasiment au niveau d’une GeForce 7900 GT overclockée, alors que la “petite” GT parvient presque à faire jeu égal avec la X1950 Pro.

The Elder Scrolls IV : Oblivion

Toujours aussi riche et joué malgré son âge, Oblivion fait extrêmement ressortir le principal défaut des GeForce 8600, avec lesquelles il s’avère tout simplement impossible d’activer l’antialiasing. Ce qui est très dommageable, car les performances hors filtres sont vraiment très bonnes, et montrent bien le déséquilibre flagrant sur ce jeu entre la puissance GPU qui est finalement largement suffisante, et la bande passante mémoire (identique à la 6600 GTS ??).

F.E.A.R Combat, Command & Conquer 3

F.E.A.R. Combat

Sur la map Dead Wood, FEAR ne fait que confirmer le résultat obtenu sur nombre des précédents jeux. De par sa gourmandise en mémoire graphique, la limitation de la bande passante se fait même sentir ici dès le 1600*1200 ! Difficile dans ces conditions de classer clairement ces cartes, mais mieux vaut ne pas disposer d’un écran de résolution native supérieure au 1280*1024…

Command & Conquer 3

Limité comme nous l’avons dit à 30 images/secondes, le titre imbibé de tibérium a cependant élu chez nombre d’entre vous qui nous avez demandé de l’inclure à notre protocole. L’analyse se limite donc ici à pointer les cartes avec lesquelles la fluidité n’est pas optimum à partir de certaines résolutions. Les GeForce 8600 en font partie, en 1600*1200 + antialiasing 4X uniquement pour la GTS, alors que la GT se montre jusqu’à 28 % moins performante (26 % en prenant comme référence les fréquences d’origine de la 8600 GTS), et occasionne donc de gros ralentissements dès que l’on dépasse le 1280*1024 sur cet affrontement moyen entre forces du GDI et du NOD.

Gothic 3, STALKER, Silent Hunter IV

Gothic 3

Toujours aussi visuellement impressionnant que techniquement buggé, Gothic 3 ne fait pas apparaître la chute de performances lors de l’activation de l’antialiasing sur les 8600. Tout simplement parce que le bus mémoire semble déjà saturé dès le 1280*1024. Ainsi, la 8600 GTS reste en dessous de la GeForce 7900 GT TOP (ce qui n’est déjà pas si mal, mais reste nettement inférieur à la X1950 Pro) alors qu’il sera nécessaire de réduire la qualité graphique sur la 8600 GT, quelque soit votre écran.

STALKER

Attendu depuis bien longtemps, il est au final intéressant de noter que le retard de STALKER n’est pas de trop vu ses exigences matérielles au moment de sa sortie. Ainsi malgré les réglages par défaut (qualité visuelle élevée mais loin d’être maximum), les cartes de milieu de gamme souffrent sévèrement pour afficher la toundra de Tchernobyl. Ici la 8600 GTS fait jeu égal avec la X1950 Pro, avec toutefois un léger avantage à cette dernière. 23 à 27 % moins performante, la 8600 GT n’obtient pas un mauvais résultat en comparaison avec la 7800 GTX, il n’y a pas si longtemps le fleuron de la gamme GeForce 7, mais dans l’absolu il faudra faire l’impasse sur de nombreuses options et sur la claque visuelle pour pouvoir progresser dans le jeu avec elle.

Silent Hunter IV

Etrangement insensible au changement de résolution (mais pas à celui de l’antialiasing), Silent Hunter IV ne doit donc pas vraiment être utilisé pour analyser les performances de l’ensemble des cartes que par les amateurs de la série. Globalement les nouvelles cartes permettent toutes deux d’activer la totalité des détails tout en montant en 1600*1200 + filtres sans craindre de réels problèmes de fluidité, du moins si le processeur suit. Reste que cela ne semble pas toujours constituer un progrès comparé aux GeForce 7 selon Silent Hunter IV…

Consommation, bruit, overclocking

Consommation

Autant la GeForce 8800 GTX atteignait un record en matière de consommation, autant la logique voudrait que nous soyons raisonnablement optimistes concernant la GeForce 8600 GTS. D’une part parce que cette carte peut être, comme nous l’avons vu, assimilée à un tiers voir un quart de 8800 GTX, d’autre part parce que le G84 utilise une finesse de gravure plus fine, 0.08µ au lieu de 0.09µ.

Au repos, le résultat est plutôt bon, la carte ayant un résultat identique à la GeForce 7900 GT et similaire à la 6600 GT (en version 256 Mo toutefois). Toutefois il faut rappeler que dans ce cas seuls 11 watts séparent la carte la moins gourmande de celle qui l’est le plus, soit 8 % au niveau de la consommation totale.

Sous les jeux, le résultat n’est pas si mauvais (meilleur que celui de la X1950 Pro aux performances assez proches, soit un meilleur rapport performances/consommation). On remarquera toutefois la légère hausse que l’on observe par rapport au milieu de gamme d’il y a 2 générations, de même que l’on atteint le niveau des cartes haut de gamme de la précédente génération. Mais on reste loin de l’énorme bond provoqué par le passage des GeForce 7800/7900 GTX à la 8800 GTX !

Nuisance sonore

Nous avons relevé la nuisance sonore émise par les cartes à l’aide d’un sonomètre placé à 5 cm et perpendiculaire au système de refroidissement, les autres ventilateurs étant réduits au minimum (bruit de fond : 45 dBA, soit le niveau mesuré avec la GeForce 6600 GTS qui est dénuée de ventilateur).

Silencieuse au repos, peu bruyante en 3D (à peine plus qu’une 7800 GTX !), le résultat est donc vraiment bon pour la 8600 GTS (ventirad de référence utilisé sur le modèle MSI pour rappel) ! Cela n’était pourtant pas acquis. En effet, même si les GeForce 8800 font référence en la matière, sur la génération précédente le silence était un privilège que nVidia réservait aux acquéreurs des modèles haut de gamme, vu le bruit atteint par les GeForce 7900 GT et 7600 GT dissipant pourtant bien moins que la 7900 GTX notamment.

Overclocking

Côté overclocking nous avons utilisé PowerStrip en version 3.73 qui n’a posé aucun problème pour reconnaître les fréquences de la carte, en attendant une mise à jour de RivaTuner. Nous avons pu atteindre les fréquences de 772 MHz pour le GPU et de 1097 MHz pour la mémoire, ce qui représente des overclockings respectifs de 14 % et 10 % si l’on prend pour référence les fréquence d’origine nVidia (notre modèle MSI étant pour rappel très légèrement overclocké bien qu’entièrement similaire au design de référence). Ce qui est au-delà de nos espérances : cette carte est déjà cadencée très haut (1450 MHz pour les stream processors) et dispose des plus hautes fréquences pour une carte basée sur la GeForce 8. Les GeForce 7600 GT étant en-dessous de ces gains par ailleurs…

Bilan

Au terme de cet article, le bilan est donc mitigé pour les GeForce 8 de milieu de gamme. La puce en elle-même n’est pas aussi puissante qu’on aurait pu l’espérer vu les spécifications des GeForce 8800 GTX et GTS : alors qu’on aurait pu espérer la présence de 64 stream processors soit moitié moins que sur le modèle très haut de gamme (à l’instar de ce qui avait été réalisé entre 6600 GT et 6800 Ultra d’une part, ou encore entre 7600 GT et 7900 GT/GTX d’autre part), nous n’en disposons que de 32. Et bien que les fréquences soient en légères hausses, cela était également le cas sur les précédentes cartes.

La faute en incombe un peu malgré lui au G80, cette puce à l’origine des GeForce 8800 et qui dispose d’une surface gigantesque (d’où un coût de production très élevé) ainsi que d’une consommation record. Des données acceptables pour une puce produite en très petit nombre et vendue très chère, mais inadmissibles dès lors que l’on parle d’un marché aux volumes importants. Bien que certaines cartes plus ou moins récentes et signées ATI viennent mitiger quelque peu ces réalitées…

De plus, le bus mémoire reste limité à 128 bits alors que là encore la logique voulait que nous ayons droit à une largeur de 192 bits, même si la vitesse de 1 GHz utilisée fait que l’augmentation de la bande passante suit l’évolution observée sur les cartes de milieu de gamme précédentes.

Résultat : des performances variables, souvent excellentes hors filtres, mais régulièrement en chute libre une fois l’antialiasing activé. Heureusement pour elles, l’architecture GeForce 8 n’a rien perdu de ses qualités !

- Les plus

- Les moins

- Pérennité (compatibilité DirectX 10)

- Meilleure qualité d’image actuelle

- Carte discrète

- PureVidéo 2

- Impact de l’activation de l’antialiasing

- Les GeForce 8800 nous laissaient espérer de meilleures performances

Recapitulatif des performances

Voici les moyennes obtenues par chaque carte et pour chaque résolution sur l’ensemble des jeux. Notez que les jeux Command & Conquer 3 et Silent Hunter 4 ont été exclus de cette moyenne vu leur comportement. De même, en l’absence de résultat dans un jeu une fois l’antialiasing activé (car non supporté, par exemple pour les GeForce 6/7 dans certains cas, ou encore pour toutes les cartes sous STALKER), la moyenne exclut simplement le jeu pour la carte concernée.