Introduction

Le moins que l’on puisse dire, c’est que Nvidia fait preuve d’une sacrée dose de confiance envers sa nouvelle GeForce GTX Titan X. Comment expliquer autrement le fait que nous ayons reçu en test un unique exemplaire accompagné d’un écran Ultra HD, en l’occurrence un Acer XB280HK, le premier moniteur 4K compatible G-Sync ? La firme pense-t-elle sa nouvelle carte haut de gamme capable de faire fonctionner seule une machine de jeu en 3840 x 2160 ? Un tel exploit serait impressionnant !

La GeForce GTX 980 n’était pas suffisamment puissante pour faire tourner les jeux en 4K, du moins pas avec un niveau de détails élevé. Mais la GeForce GTX Titan X, elle, est basée sur le GPU GM200, qui contient huit milliards de transistors. Huit. Milliards. C’est presque trois milliards de plus que le GM204 de la GeForce GTX 980 et un de plus que le GK110 qui équipait la GeForce GTX Titan initiale.

Tous ensemble, ces transistors forment un die de 601 mm², environ 9 % plus grand que celui du GK110. Le GM200 est fabriqué selon le même processus, à savoir une gravure high-k metal gate en 28 nm ; il s’agit donc simplement d’un processeur plus complexe et de plus grande taille. Et pourtant le TDP de la carte est identique, à savoir 250 watts. Alors que les fréquences du GPU sont plus élevées et que la carte embarque deux fois plus de mémoire. À première vue, il semble qu’il y ait un problème dans les calculs, et pourtant…

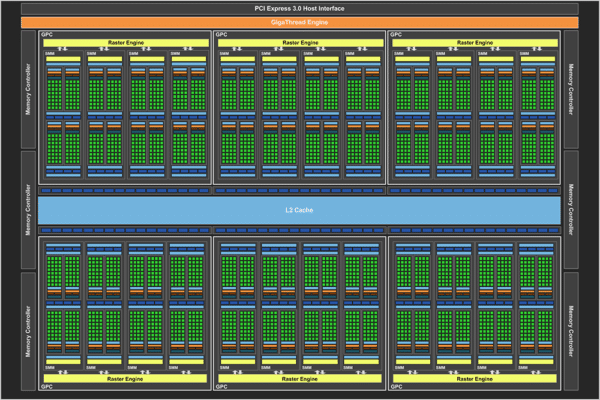

À l’intérieur du GM200

À l’instar des GeForce GTX 980 et 970 que nous avons testées en septembre dernière, le GPU GM200 repose sur l’architecture Maxwell de Nvidia, réputée pour son efficacité. La principale différence réside dans l’ajout de deux blocs GPC (Graphics Processing Clusters) aux quatre du GM204. Sachant que chaque GPC contient quatre Streaming Multiprocessors, cela nous donne un total de 24 SMM sur le GPU. Multipliez ce chiffre par le nombre de cores CUDA par SMM (128) et vous arrivez à un total de 3072 sur la GeForce GTX Titan X. Les unités de textures, quant à elles, sont au nombre de huit par SMM, soit 192 au total. Avec une fréquence de base de 1000 MHz pour le GPU, cela donne un fillrate de 192 GTex/s (à titre de comparaison, celle de la GeForce GTX Titan était de 188 GTex/s, en dépit d’un nombre d’unités de texte plus élevés).

Comme les SMM du GM204, ceux du GM200 comportent 96 Ko de cache partagé et 48 Ko de cache L1/textures, soit deux fois plus que sur le GM107 qui équipe la GeForce GTX 750 Ti. Les autres éléments d’architecture restent toutefois pratiquement inchangés : chaque SMM est divisé en quatre blocs ayant chacun leur propre tampon d’instructions, leur propre warp scheduler et deux unités de dispatch. En fait, les similarités sont telles que le module de calcul en double précision (FP64) a encore et toujours une vitesse 32 fois inférieure à celle du FP32, alors que le GM200 est censé être au sommet de la gamme Maxwell. Soit dit en passant, la nouvelle Quadro M6000 subit le même sort. Si vous avez vraiment besoin de performances en FP64, Nvidia vous recommandera probablement l’une de ses cartes Tesla.

| GeForce GTX Titan X | GeForce GTX 980 | Radeon R9 290X | GeForce GTX Titan | |

|---|---|---|---|---|

| Gravure | 28 nm | 28 nm | 28 nm | 28 nm |

| Transistors | 8 milliards | 5,2 milliards | 6,2 milliards | 7,1 milliards |

| Fréquence GPU | 1000 MHz | 1126 MHz | Max. 1 GHz | 837 MHz |

| Shaders | 3072 | 2048 | 2816 | 2688 |

| Unités de texture | 192 | 128 | 176 | 224 |

| Fillrate textures | 192 GT/s | 172,8 GT/s | 176 GT/s | 188 GT/s |

| ROP | 96 | 64 | 64 | 48 |

| Fillrate pixels | 96 GP/s | 72 GP/s | 64 GP/s | 40 GP/s |

| Bus mémoire | 384 bits | 256 bits | 512 bits | 384 bits |

| Mémoire | 12 Go de GDDR5 | 4 Go de GDDR5 | 4 Go de GDDR5 | 6 Go de GDDR5 |

| Débit mémoire | 7 GT/s | 7 GT/s | 5 GT/s | 6 GT/s |

| Bande passante mémoire | 336,5 GB/s | 224,4 GB/s | 320 GB/s | 288 GB/s |

| TDP | 250 W | 165 W | 250 W | 250 W |

Les quatre partitions ROP de la GeForce GTX 980 passent à six sur la GeForce GTX Titan X. Composées de 16 unités chacune, elles permettent donc à la carte de générer jusqu’à 96 pixels en nombre entiers de 32 bits par cycle. Les partitions ROP sont alignées avec des tranches de 512 Ko de cache L2, (le GM200 en comptant 3 Mo au total). Lors du lancement de la GeForce GTX 750 Ti, Nvidia indiquait que la grande taille du cache L2 servait à éviter les goulets d’étranglement provoqués par le bus mémoire relativement étroit de la carte (128 bits). Ce n’est plus vraiment une préoccupation avec le GM200, celui-ci disposant d’un bus de 384 bits alimenté par de la mémoire à 7 Gbit/s. Son débit maximal, annoncé à 336,5 Go/s, est identique à celui de la GeForce GTX 780 Ti et dépasse celui de la GeForce GTX Titan, de la GeForce GTX 980 et de l’AMD Radeon R9 290X.

Anatomie de la GeForce GTX Titan X

Nvidia a placé son GM200 sur un PCB de 26,5 cm qui ressemble fort aux autres cartes haut de gamme que la firme produit depuis maintenant plus de deux ans. Il existe certes des différences lorsqu’on examine l’objet de près, mais les similarités avec les modèles précédents s’étendent jusqu’aux dimensions, ce qui aura sans nul doute facilité la vie des concepteurs de cartes partenaires de Nvidia.

Même le nombre de puces mémoire entourant le GPU demeure inchangé ; par contre, celles-ci « pèsent » désormais 512 Mo pièce, ce qui porte la capacité totale de la carte à 12 Go. Sachant qu’il s’agit en outre de la GDDR5 la plus rapide de chez SK Hynix, on pourrait penser que Nvidia en fait un peu trop, même pour de la 4K. La firme indique toutefois qu’elle pense à l’avenir et que, si jamais une solution Surround composée de plusieurs écrans Ultra HD alimentés par trois ou quatre Titan X en SLI devait voir le jour, 6 Go n’auraient pas suffi.

Le PCB est recouvert d’une plaque qui refroidit plusieurs des composants disposés en surface ; elle est assortie d’une chambre de vaporisation en cuivre surmontée d’un radiateur en aluminium haut de deux emplacements. Le design de référence proposé par Nvidia reste fidèle au ventilateur centrifuge, qui aspire l’air ambiant du boîtier, le fait circuler sur la plaque et à travers le radiateur puis l’expulse par l’arrière. Bien que les ventilateurs de ce type aient tendance à générer plus de bruit que les modèles axiaux, Nvidia a amplement démontré sa capacité à limiter les nuisances sonores de ses cartes par le passé. La GeForce GTX Titan X ne fait pas exception à la règle.

L’ensemble de la carte est recouvert d’un cache en aluminium peint en noir et à la texture plus prononcée que sur les modèles précédents. Si vous vous rappelez de cette image dans notre article The Story of How GeForce GTX 690 And Titan Came To Be, dites-vous que cela y ressemble, mais sans l’éclairage verdâtre sous les ailettes du ventilateur.

Notons également que la plaque de renforcement arrière que l’on trouvait sur la GeForce GTX 980 manque ici à l’appel. Celle-ci était en partie amovible afin de faciliter la circulation de l’air lorsque plusieurs GTX 980 étaient utilisées en SLI, mais la Titan X est une carte plus gourmande en énergie, raison pour laquelle Nvidia s’en est purement et simplement débarrassé cette fois-ci, l’objectif étant de permettre aux cartes de respirer un maximum lorsqu’elles sont adjacentes. Cette omission ne nous manque pas particulièrement, mais il faut avouer que la plaque donnait à l’ensemble un look plus fini.

La GeForce GTX Titan X possède les même sorties vidéo que la GTX 980, à savoir un port DVI dual-link, un port HDMI 2.0 et trois DisplayPort pleine taille. Ces cinq connecteurs autorisent le branchement simultané de quatre écrans et, si ces derniers sont compatibles G-Sync, le trio de sorties DisplayPort 1.2 permet de monter une configuration Surround.

Tournée vers l’avenir

Outre les 12 Go de GDDR5 qui équipent la Titan GeForce GTX Titan X, Nvidia a souhaité attirer notre attention sur une série de caractéristiques qui, selon la firme, devraient lui permettre de faire face aux évolutions du marché pendant longtemps.

Lors de la dernière GDC, Microsoft a mentionné le fait que 50 % des cartes graphiques actuelles étaient compatibles DirectX 12 et que ce chiffre atteindrait les deux tiers d’ici les fêtes. Cela signifie que l’API sera prise en charge par une bonne partie du matériel disponible sur le marché d’ici la fin de l’année. Il convient toutefois de noter qu’il existera deux versions de DirectX 12 : 12.0 et 12.1. Selon Max McMullen (Microsoft), la version 12.0 permet de bénéficier de la plupart des avantages de l’API en matière de performances sur CPU, tandis que la 12.1 y ajoute la Conservative Rasterization et les Rasterizer Ordered Views (ROV), qui autorisent le développement d’algorithmes de rendu plus puissants.

Comme on peut s’y attendre de la part d’un GPU dit « tourné vers l’avenir », le GM200 prend en charge DirectX 12.1 (tout comme le GM204, soit dit en passant). Tous les GPU plus anciens, y compris le GM107 qui équipe la GeForce GTX 750 Ti, sont limités à la version 12.0. Nous avons demandé à AMD si ses puces GCN géraient DirectX 12.0 ou 12.1, mais un représentant de la firme nous a indiqué ne pouvoir répondre pour l’instant.

L’architecture Maxwell possède d’autres caractéristiques d’avenir ; certaines sont exploitables dès aujourd’hui, d’autres nécessitent que les développeurs les exploitent pour être utiles. Pour de plus amples informations sur la Dynamic Super Resolution, le Multi-Frame Samples Anti-Aliasing (une excellente manière de réduire l’incidence de l’antialiasing en 4K sur la Titan X, à ce propos), le VR Direct et la Voxel Global Illumination, nous vous conseillons de lire la page 2 de notre article consacré au lancement des GTX 980 et 970.

Protocole de test

Tous les bureaux de Tom’s Hardware ont récemment adopté un protocole de test unique, ce qui signifie que tous les tests effectués en 2015 seront et resteront comparables entre eux. Par conséquent, tous les benchmarks d’aujourd’hui sont effectués sur un Intel Core i7-5930K assorti de 16 Go de mémoire DDR4-2400. Le support de stockage est un SSD de 500 Go et l’alimentation est un modèle 850 watts, ce qui nous laisse suffisamment de marge pour tester les cartes graphiques les plus gourmandes, y compris l’AMD Radeon R9 295X2.

En ce qui concerne les pilotes, nous testons les cartes Nvidia avec les GeForce 347.84 et les AMD avec les Catalyst 14.12 Omega publiés en décembre 2014. Quelques jours avant la publication de cet article, AMD nous a fait savoir qu’il mettrait en ligne le 19 mars des pilotes compatibles FreeSync intégrant également des profils CrossFire pour Evolve et Far Cry 4 (mieux vaut tard que jamais !). Après avoir réalisé nos benchmarks habituels, nous avons donc retesté Far Cry 4 avec une version préliminaire des futurs pilotes en question.

Enfin, nous continuons à préchauffer toutes les cartes graphiques que nous testons avant de commencer à enregistrer les résultats afin d’éviter que des fréquences non-représentatives ne viennent biaiser ces derniers. Le problème est toutefois moins prononcé à l’heure actuelle qu’au moment de la sortie de la Radeon R9 290X.

Configuration de test

| Processeur | Intel Core i7-5930K (Haswell-E), 3,5/3,7 GHz, hexacore, LGA 2011-v, 15 Mo de cache L3 partagé, Hyper-Threading activé | ||||

|---|---|---|---|---|---|

| Carte-mère | MSI X99S XPOWER AC (LGA 2011-v3), Intel X99 Express. BIOS v1.6 | ||||

| Mémoire | Crucial Ballistix DDR4-2400, 4 x 4 Go, 1200MHz, CL 16-16-16-39 2T | ||||

| Cartes graphiques | Nvidia GeForce GTX Titan X GPU 1002 MHz, 12 Go de GDDR5 à 1753 MHz (7012 MT/s) Nvidia GeForce GTX 980 GPU 1126 MHz, 4 Go de GDDR5 à 1753 MHz (7012 MT/s) Nvidia GeForce GTX 780 Ti GPU 875 MHz, 3 Go de GDDR5 à 1753 MHz (7012 MT/s) Nvidia GeForce GTX Titan GPU 837 MHz, 6 Go de GDDR5 à 1502 MHz (6008 MT/s) AMD Radeon R9 295X2 GPU 1018 MHz, 2 x 4 Go de GDDR5 à 1250 MHz (5000 MT/s) AMD Radeon R9 290X GPU 1000 MHz, 4 Go de GDDR5 à 1250 MHz (5000 MT/s) | ||||

| SSD | Crucial MX200, 500 Go, SATA 6 Gbit/s | ||||

| Alimentation | Be Quiet! Dark Power Pro 10, 850 W, ATX12V, EPS12V | ||||

Logiciels et pilotes

| OS | Microsoft Windows 8 Professionnel x64 |

|---|---|

| DirectX | DirectX 11 |

| Pilotes graphiques | Cartes GeForce : Nvidia 347.25 Beta Cartes Radeon : AMD Catalyst Omega 14.12 |

Benchmarks

| Middle-Earth: Shadow of Mordor | Benchmark intégré, détails Ultra | ||||

|---|---|---|---|---|---|

| Battlefield 4 | Benchmark THG personnalisé, détails Ultra | ||||

| Metro Last Light | Benchmark intégré, détails Very High, AF 16x, flou de mouvement normal | ||||

| Thief | Version 1.7, benchmark intégré, détails Very High | ||||

| Tomb Raider | Version 1.01.748.0, benchmark intégré, détails Ultimate | ||||

| Far Cry 4 | Version 1.9.0, benchmark THG personnalisé, 60 s, Fraps, détails Ultra |

Battlefield 4, Far Cry 4 et Metro: Last Light

Battlefield 4

Nous n’avons naturellement pas eu le temps de tester Hardline avant le lancement de la Titan X, donc nous devrons une fois de plus nous contenter de Battlefield 4 et de son moteur Frostbite.

Toutes les cartes représentées sur ce graphique sont parfaitement à même de faire tourner Battlefield 4 de manière fluide en 2560 x 1440. À ce stade, la QHD ne représente plus vraiment un défi, même avec le niveau de détails réglé sur Ultra. Néanmoins, un gain de 30 % par rapport à la GeForce GTX 980 est loin d’être anecdotique pour la Titan X, d’autant plus que le GM204 nous avait déjà particulièrement impressionné il y a quelques mois.

La carte la plus rapide reste cependant la Radeon R9 295X2, dont les excellentes performances rendent le tarif encore plus attrayant (elle est moins chère que n’importe laquelle des cartes Nvidia). Notons la faiblesse de la GeForce GTX Titan Z, une carte devancée par la solution bi-GPU d’AMD.

Les GeForce GTX 780 Ti, Titan et 980 se montrent toutes un peu lentes en 3840 x 2160. Même constat pour l’AMD Radeon R9 290X, qui est légèrement à la traîne avec les détails en Ultra.

Avec 40 images/s de moyenne (et des creux à 27), la Nvidia GeForce GTX Titan X n’atteint pas vraiment les 60 images/s que la plupart des puristes considèrent comme optimaux, mais pour avoir terminé une grande partie de la campagne solo pour tester le G-Sync, nous ne pouvons qu’admettre que le jeu est largement assez fluide pour rester agréable.

N’oublions toutefois pas que l’AMD Radeon R9 295X2 affiche 27 % de performances en plus pour un prix moindre. Il faut juste ne pas être dérangé par sa consommation, son système de refroidissement par watercooling en circuit fermé et sa dépendance vis-à-vis des profils CrossFire dans les jeux…

Far Cry 4

Sur le papier, la Radeon R9 295X2 jouit d’une avance de 32 % sur la Nvidia GeForce GTX Titan X dans Far Cry 4 en 2560 x 1440 avec les réglages en Ultra, mais en pratique, l’évolution du framerate dans temps montre que les écarts ne sont que sporadiques et que par moments, elle est en réalité plus lente que la GeForce GTX Titan X, dont les performances sont plus homogènes.

Par ailleurs, la Titan X devance la GeForce GTX 980 de 30 %, et se paye même le luxe de dépasser la première Titan de 74 %.

Même sur du matériel haut de gamme et à un niveau de détails relativement modeste, il apparaît clairement que Far Cry 4 est un FPS récent qui manque encore de maturité. Face à de telles saccades, tout joueur PC aura forcément la même réaction : « allez, encore un portage console… ». En dépit de framerates similaires à ceux obtenus sous Battlefield 4, Far Cry 4 n’est malheureusement pas aussi fluide.

En 3840 x 2160, cela devient carrément problématique. Techniquement, la Radeon R9 295X2 remporte une fois encore la victoire, mais elle enregistre des creux plus profonds que la Titan X, et parfois proches des performances de la Radeon R9 290X. C’est peut-être lié au fait qu’AMD n’a pas encore officiellement publié de profil CrossFire pour Far Cry 4. Nous verrons bien dans quelques jours si la situation a évolué.

Metro: Last Light

Avec 29 % d’avance sur la GeForce GTX Titan X, la Radeon R9 295X2 se fait une petite promenade de santé dans Metro: Last Light, mais pour être parfaitement honnête, nous devons bien reconnaître que toutes les cartes testées aujourd’hui s’en sortent parfaitement bien ce titre avec les détails réglés sur Very High. La QHD n’est toutefois pas censée être un obstacle pour des cartes graphiques de ce calibre : c’est en Ultra HD que les vrais vainqueurs se démarquent.

Les performances de nos concurrentes ne nous réservent guère de surprise en 3840 x 2160 dans le titre de 4A Games. Les GeForce GTX 780 Ti, Titan et 980 affichent toutes un framerate moyen de 30 images/s, tandis que la nouvelle Titan X s’approche plus des 40 images/s. La Radeon R9 290X s’en sort admirablement au vu de son prix plancher, mais il serait difficile de la recommander à un gamer désireux de jouer en 4K avec les détails à fond. La dual-GPU d’AMD, par contre, atteint pratiquement les 60 images/s, devançant la Titan X de 41 %, pour un prix inférieur.

Middle-Earth: Shadow of Mordor, Thief et Tomb Raider

Middle-Earth: Shadow of Mordor

Notre benchmark sous Middle-Earth en 2560 x 1440 est un véritable jeu d’enfant pour toutes les cartes testées aujourd’hui, et ce, même avec le niveau de détails réglé sur Ultra. La seule aberration qui nous gêne réside dans les performances en dents de scie de la Radeon R9 295X2, qui se montre globalement plus rapide que la Titan X mais affiche régulièrement des creux la faisant passer sous cette dernière.

Les framerates moyens sont plus élevés dans Middle-Earth que dans les autres jeux testés jusqu’à présent, mais le classement final ne change pas. L’AMD Radeon R9 295X2 termine en première place grâce à ses performances généralement élevées, mais il lui arrive à plusieurs reprises de chuter sous la GeForce GTX Titan X.

Les GeForce GTX 980 et Radeon R9 290X permettent toutes deux de jouer dans des conditions relativement correctes, mais la GeForce GTX Titan et la 780 Ti affichent des framerates minimaux parfois assez limites.

Thief

L’AMD Radeon R9 295X2 continue à souffrir de performances inconstantes dans Thief. L’évolution de son framerate dans le temps ressemble assez fortement à celle que nous avions notée dans notre test initial de la carte. Plusieurs cartes mono-GPU se payent même le luxe de commencer le benchmark avec des framerates plus élevés. Les moyennes étant ce qu’elles sont, l’AMD termine néanmoins en première place, suivi de la GeForce GTX Titan X et de la GeForce GTX 980.

Pour la cinquième fois de suite, la Nvidia GeForce GTX Titan X démontre qu’elle peut afficher un framerate moyen suffisamment élevé pour permettre de jouer correctement en Ultra HD. L’avance de 30 % qu’elle obtient par rapport à la GeForce GTX 980 fait toute la différence et autorise le maintien des détails sur le réglage Very High. Même l’évolution du framerate dans le temps est exemplaire et fait montre d’un usage bien pensé de la technologie G-Sync (voir plus loin).

Sans surprise, l’AMD Radeon R9 295X2 continue à afficher des performances plus élevées. Cette fois-ci, les pics et les creux sont même moins prononcés et la victoire semble plus indiscutable.

Tomb Raider

Les framerates minimaux dans Tomb Raider nous semblent particulièrement faible, surtout pour un benchmark réalisé en 2560 x 1440, mais la séquence que nous avons choisie est spécifiquement conçue pour mettre les cartes graphiques à genoux. Il n’y a qu’un seul passage où les effets de cheveux TressFX sont vraiment mis en avant, et c’est là que leurs performances tombent en chute libre. Pour le reste du test, le framerate se maintient au-dessus des 50 images/s, un résultat fluide que viennent confirmer les moyennes finales.

Tomb Raider est encore un de ces titres surprenants qui fait mentir les résultats des benchmarks. Un framerate moyen de l’ordre de 30 images/s semble bien maigre, et pourtant, la plupart des cartes testées permettent de jouer de manière fluide. Mieux encore, il suffit pour gonfler le framerate de choisir le réglage Ultra au lieu d’Ultimate, ce qui désactive l’effet TressFX (particulièrement gourmand en puissance de calcul) et lisse les performances.

Consommation

Nous mesurons la consommation électrique des cartes suivant le protocole décrit dans notre article The Math Behind GPU Power Consumption And PSUs. C’est la seule manière pour nous d’obtenir des chiffres autorisant des conclusions pertinentes en matière d’efficacité énergétique.

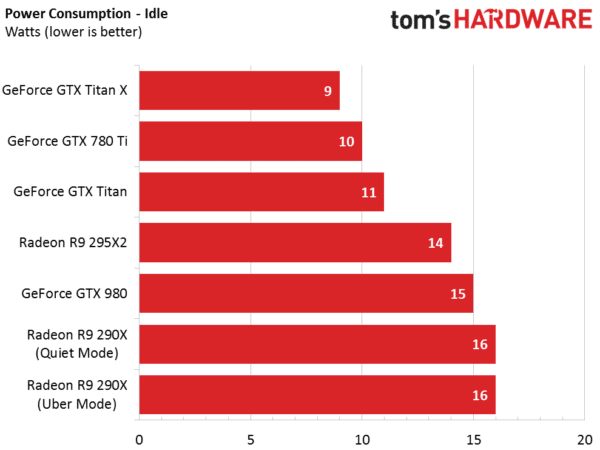

Consommation au repos et bureau 2D

Une consommation au repos de 8 watts, c’est purement et simplement fantastique, mais nous sommes perplexes quant à la manière dont la GeForce GTX Titan X parvient à se montrer moins gourmande que la GTX 980 alors qu’elle comporte trois fois plus de mémoire et un GPU considérablement plus complexe.

En examinant de plus près les différents rails, on constate que la consommation fluctue périodiquement ; le résultat final représente une moyenne qui masque de nombreux creux et pics.

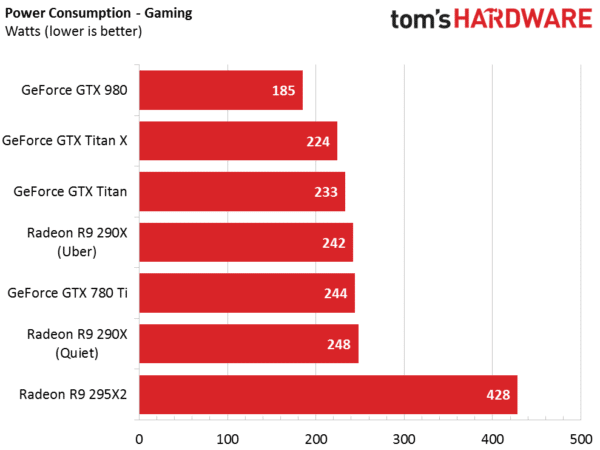

Jeu

À l’exception des applications professionnelles et du test de torture, le jeu constitue le scénario le plus énergivore pour une carte graphique. Les 224 watts de moyenne mesurés sont légèrement supérieurs à ce que nous avons testé sur la Quadro que lancera prochainement Nvidia. Cela n’a rien de bien surprenant, cette carte ayant une fréquence GPU Boost inférieure d’environ 10 MHz à celle de la GeForce GTX Titan X une fois la température cible atteinte.

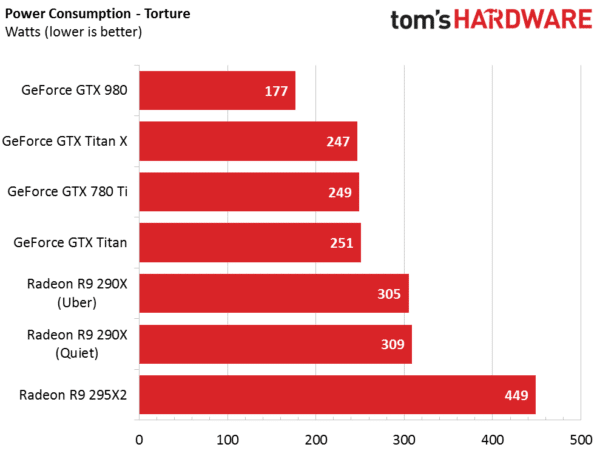

Torture (pleine charge)

Nvidia annonce une TDP de 250 watts pour la GeForce Titan X, mais la carte ne l’atteint jamais en temps normal : aucun de nos tests de résistance habituels ne parvient à lui faire dépasser les 247 watts. Dans les faits, cela laisse environ 25 watts aux overclockeurs, ce qui peut sembler limité mais relève tout de même assez franchement du scénario hypothétique.

Le TDP de 250 watts mentionné dans la documentation technique de Nvidia est difficile à atteindre, même en tentant délibérément de faire gonfler la consommation de la Titan X. En temps normal, cette carte consomme bien moins que son plafond théorique : ses deux connecteurs 8 et 6 broches nous paraissent bien superflus, et ce, alors que nous ne savons encore rien des systèmes de refroidissement qu’adopteront les concepteurs de cartes.

Enfin, il convient de féliciter Nvidia pour avoir limité à 75 watts la consommation de la GeForce GTX Titan X au connecteur PCI Express : nous n’avons noté strictement aucun dépassement de charge sur celui-ci (alors que le problème est récurrent sur les cartes moins haut de gamme). Le système de distribution dynamique de la charge sur les différents rails fonctionne à merveille.

Consommation : classement

Annoncée à 9 watts, la consommation électrique au repos de la GeForce GTX Titan X est des plus étonnantes quand on sait qu’elle comporte 12 Go de GDDR5 et que la GeForce GTX 980 est plus de 50 % plus gourmande.

Son efficacité énergétique dans les jeux est également impressionnante.

Température, GPU Boost et bruit

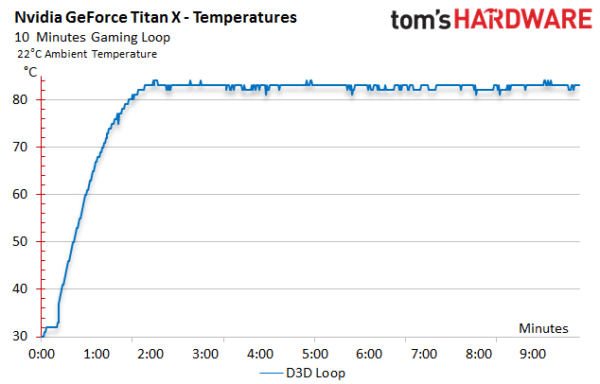

Températures

Nous avons mesuré l’évolution de la température de la GeForce GTX Titan X dans un boîtier fermé au fur et à mesure d’un benchmark de jeu. Elle atteint rapidement sa température cible, à savoir 83 °C, mais ne la dépasse jamais.

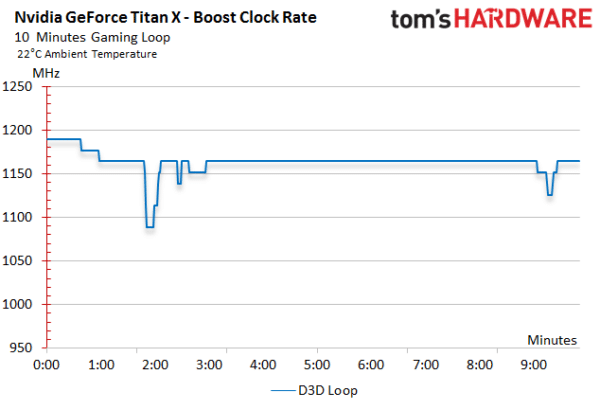

Fréquence GPU Boost

En comparant la progression parallèle des températures et des fréquences dans le temps, on constate que la fréquence GPU Boost de la carte, annoncée à 1190 MHz, chute fortement dans les instants qui suivent l’arrivée au plafond thermique, mais remonte ensuite pour se stabiliser à 1164 MHz. On note de temps à autre un creux moins prononcé lorsque la charge devient trop importante et menace de faire grimper la température.

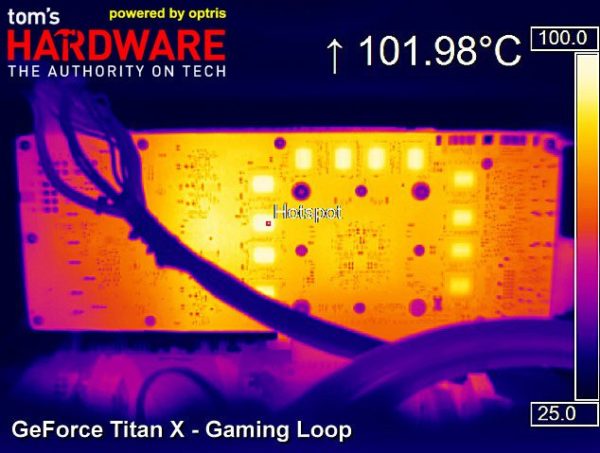

Températures après fonctionnement prolongé

L’absence de plaque arrière n’est pas gênante : à vrai dire, la plupart d’entre elles n’ont plus aujourd’hui qu’une fonction esthétique, à moins d’être conçues dans un but spécifique (par exemple renforcer la carte ou servir de caloducs pour certains composants). Dans l’espoir d’améliorer la circulation de l’air en configuration multi-cartes, Nvidia a tout simplement omis d’en placer une sur la GeForce GTX Titan X. On peut toutefois se demander ce qu’il advient des puces mémoire logées sur la face arrière, qui ne sont donc plus refroidies.

Il ne fait aucun doute qu’à long terme, des températures de l’ordre de 102 °C risquent fort de leur causer préjudice. Bien que nous comprenions la logique de Nvidia, il nous semble que, dans ce cas précis, il aurait été judicieux d’opter pour une plaque arrière.

Très sagement, la firme a opté pour un système de refroidissement où l’air chaud est éjecté du boîtier via le panneau de connecteurs, et celui-ci est bien conçu : nous mesurons entre 78 et 80 °C à la sortie. Ces chiffres ont toutefois tendance à fluctuer légèrement.

Sur sa face avant, la Titan X ne rencontre aucun problème d’ordre thermique : son point le plus chaud est l’endroit où le PCB est nu, c’est-à-dire uniquement aux alentours du connecteur PCI Express.

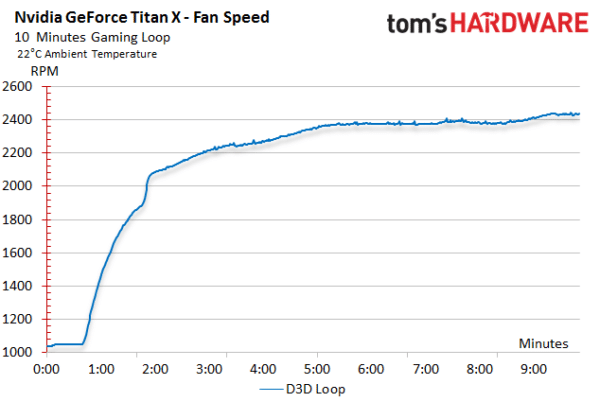

Vitesse du ventilateur

Le ventilateur atteint sa vitesse de rotation maximale après seulement 9 minutes de charge dans notre boîtier be quiet! Silent Base 800. Il ne ralentit que lorsque la charge diminue. Le système de refroidissement adopté par Nvidia a pour mission de maintenir le GM200 à 83 °C maximum, ce qui peut pousser le ventilateur à une vitesse de 2460 tr/min dans les jeux, la consommation moyenne atteignant alors 224 watts.

Nuisances sonores

Comme à notre habitude, nous mesurons les nuisances sonores à l’aide d’un microphone haut de gamme placé à la perpendiculaire du centre de la carte graphique, à une distance de 50 cm. Nous analysons les résultats à l’aide de Smaart 7. Nous avons noté et pris en compte le bruit ambiant lors de chaque prise de mesures. Il n’a jamais dépassé les 26 dB(A).

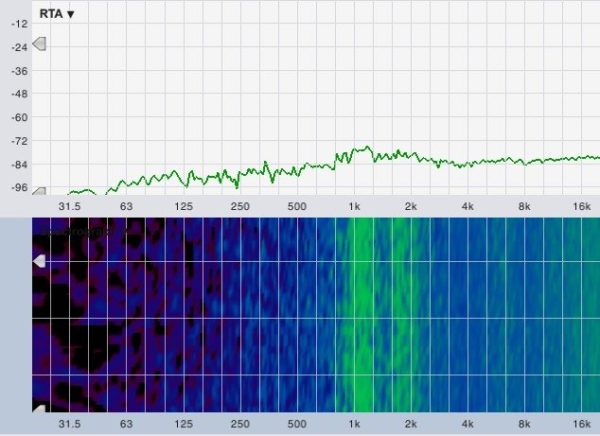

Commençons par examiner la plage de fréquences émises par la carte tandis que son ventilateur fait tout pour maintenir le GM200 à 83 °C lors de notre benchmark de jeu :

Nous n’observons aucun de ces bruits de moteur (fréquences graves) que provoquent parfois les ventilateurs choisis par les partenaires de Nvidia ; au lieu de cela, nous avons là un bruissement plaisant qui s’étend sur une plage relativement étendue du spectre sonore et se manifeste surtout aux alentours de 1,2 et 1,9 kHz. Le sifflement électrique des bobines, que l’on entend généralement entre 6 et 7 kHz, est ici complètement absent. Le reste, à partir de 10 kHz, n’est que du bruit d’air en mouvement.

Le tableau ci-dessous résume la situation de manière légèrement différente. Il faut savoir que nous avons tout d’abord mesuré la vitesse du ventilateur en boîtier fermé avant de refaire le test dans un boîtier ouvert, mais en forçant cette même vitesse de ventilateur. Cela nous permet de contourner l’impossibilité technique de mesurer les émissions sonores de la seule carte graphique dans un boîtier fermé.

| Boîtier ouvert (banc d’essai) | Boîtier ouvert (vitesse du ventilateur fixe, boîtier simulé) | Boîtier fermé (ordinateur complet) | |

|---|---|---|---|

| Au repos | 31,2 dB(A) | N/A | N/A |

| Jeu | 44,2 db(A) | 44,5 dB(A) | 39,7 dB(A) |

Mis à part le fait que la GeForce GTX Titan X ne parvient pas à maintenir sa fréquence GPU Boost maximale bien longtemps, le ventirad adopté par Nvidia demeure une véritable référence à l’aune duquel il conviendra de mesurer tous les autres systèmes de refroidissement à expulsion thermique directe.

G-Sync en 4K

Nous avons déjà abordé la technologie G-Sync dans notre article G-SYNC : LA solution que les joueurs attendaient ?. Nous y détaillions les problèmes que rencontrent généralement les joueurs avec la synchronisation verticale (v-sync) conventionnelle, présentions la nouvelle approche adoptée par Nvidia, à savoir un taux de rafraîchissement variable, et vous faisions part de nos expériences avec le premier écran compatible G-Sync. Au moment de poser notre déluge de questions à Nvidia, nous avions également débattu de l’intérêt de la technologie sur les moniteurs 120 et 144 Hz. Au final, nous avions conclu que le G-Sync se montrait le plus utile entre 30 et 60 images/s de framerate, une plage au sein de laquelle il est préférable d’activer la v-sync pour limiter le tearing mais où, malheureusement, celle-ci provoque des saccades car le rafraîchissement oscille périodiquement entre 60 et 30 Hz.

Le hasard faisant bien les choses, la plage de 30 à 60 images/s est justement celle où se situent les résultats obtenus par la GeForce GTX Titan X dans nos benchmarks en 3840 x 2160 avec les détails au maximum. Le G-Sync pourrait-il être LA technologie dont rêvaient les joueurs, le Saint Graal qui n’attendait plus que cette carte à cette résolution ?

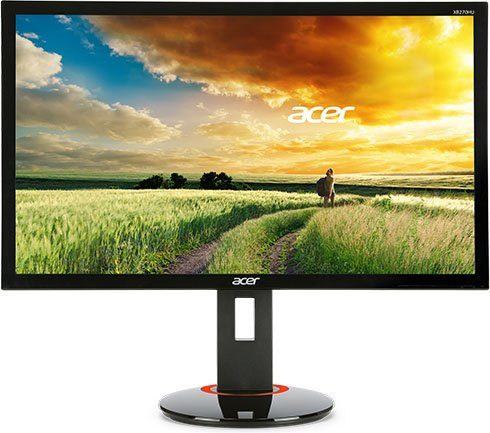

Nvidia nous a fait parvenir un Acer XB280HK bprz, qui est pour l’heure le seul écran 4K compatible G-Sync disponible sur le marché. Ce moniteur de 28″ coûte un peu plus de 600 € sur le net, ce qui en fait un partenaire raisonnablement abordable pour un produit de niche tel que la GeForce GTX Titan X. Le XB280HK fera prochainement l’objet d’un article plus détaillé dans nos colonnes, mais nous tenons à mentionner le fait que l’exemplaire que nous avons reçu souffrait d’un pixel mort dès son arrivée dans nos locaux. Ceci étant dit, c’était également le cas de l’Asus PQ321, qui coûtait quatre fois plus cher.

G-Sync et 4K en pratique

Pour rappel, G-Sync est une fonctionnalité qui influe, non sur les performances, mais sur la qualité, et plus spécifiquement sur le framerate perçu. Tous les benchmarks des pages précédentes ont été réalisés avec la synchronisation verticale remplacée par le G-Sync.

Le premier titre que nous avons voulu examiner est Far Cry 4, dont les décors luxuriants rendent le tearing particulièrement évident lorsque la synchronisation verticale est désactivée (les arbres sont les éléments les plus affectés par le problème). Nos tests indiquent que son framerate varie entre 33 et 51 images/s, avec une moyenne tout juste inférieure à 40 images/s. Avec la v-sync activée, on obtiendrait donc 30 images/s et une certaine latence. Lorsqu’elle est désactivée, le tearing est manifeste. G-Sync réduit le tearing sans limiter les performances à 30 images/s. Génial. La technologie n’est toutefois pas la panacée : il arrive encore que le framerate chute à 33 images/s, car G-Sync n’ajoute pas d’images interpolées mais améliore simplement la fluidité perçue. De par son gameplay, Far Cry 4 donnerait de meilleurs résultats avec un niveau de détail plus faible ou une puissance de calcul plus élevée.

Quid de Battlefield 4 ? Nous annoncions des framerates compris entre 27 et 48 images/s, avec une moyenne générale de 39 images/s sur la GeForce GTX Titan X en 3840 x 2160. Bien que ce titre suive lui aussi un rythme assez rapide, il s’avère bien plus fluide que ne le suggèrent les seuls chiffres lorsqu’on active le G-Sync.

Ce constat vaut également pour Metro: Last Light, où la technologie de Nvidia réduit considérablement le tearing qui mine normalement le moindre déplacement dans les étroits couloirs du métro de Moscou, et ce, en dépit d’un framerate moyen de l’ordre de 39 images/s à peine. Middle-Earth, Thief, Tomb Raider, Crysis 3 : dans tous ces jeux, le G-Sync permet de bénéficier d’un framerate plus élevé que si l’on activait la synchronisation verticale tout en éliminant un tearing qui sans elle serait réellement dérangeant.

L’appréciation du résultat final, cependant, est plus une question de préférence personnelle qu’autre chose. Notre avis est le suivant : la GeForce GTX Titan X est la première carte graphique mono-GPU capable de permettre de jouer dans de bonnes conditions en 3840 x 2160 et avec les détails à fond dans la plupart des jeux. L’ajout du G-Sync, quant à lui, neutralise les artéfacts visuels qui s’accumulent lorsqu’on choisit d’activer ou de désactiver la v-sync. Il s’agit là d’une technologie qui, selon nous, n’aurait pas pu faire son apparition à un meilleur moment.

Conclusion

À bien des égards, la conclusion de cet article s’écrit toute seule. Tarifée à 1000 $, la nouvelle carte graphique mono-GPU de Nvidia occupe la position précédemment détenue par la première GeForce GTX Titan : celle du tout haut de gamme. Bâtie autour du processeur GM200, la Titan X est plus rapide (beaucoup plus rapide), possède plus de fonctionnalités et est équipée de deux fois plus de mémoire GDDR5 alors que son prix et son format sont identiques et sa consommation similaire. Il s’agit également de la seule carte graphique au monde à tenir dans un boîtier mini-ITX tout en permettant de jouer dans de bonnes conditions en 3840 x 2160.

Qu’en est-il de la concurrence ?

L’AMD Radeon R9 290X a été lancée il y a près de 17 mois et coûte maintenant entre 310 et 340 €. Elle est formidable pour jouer en 2560 x 1440 et il suffit d’en monter deux en CrossFire pour obtenir des performances correctes en 4K. Mais il s’agit alors d’une configuration considérablement plus chaude et plus bruyante qui nécessite quatre emplacements PCI Express et souffre des limitations relatives au CrossFire. Il suffit pour se convaincre de l’étendue du problème de penser à tous les possesseurs de 290X qui ont acheté Far Cry 4 à sa sortie et qui n’obtiennent un profil multi-GPU qu’aujourd’hui, c’est-à-dire quatre mois plus tard. Les solutions mono-GPU ont pour elle leur élégance et leur simplicité, deux éléments que l’on a bien du mal à apprécier tant que l’on n’a pas été confronté aux saccades, aux nuisances sonores et aux mises à jour tardives.

La Radeon R9 295X2 est une meilleure manière de bénéficier du CrossFire avec deux GPU Hawaii ; cette carte nous avait vraiment impressionnés à sa sortie l’an dernier (tout particulièrement après que Nvidia a annoncé la Titan Z, une carte à… 3000 $). On trouve aujourd’hui des 295X2 à moins de 670 €, ce qui en fait une solution à la fois plus rapide et moins onéreuse que la GeForce GTX Titan X. Mais il faut bien avouer que la brute watercoolée d’AMD ne joue pas vraiment dans la même cour que sa rivale : encombrante et bruyante, elle consomme environ 500 watts de moyenne en charge. Si vous parvenez à fermer les yeux sur son relatif manque de grâce, la Radeon R9 295X2 constitue néanmoins une solution plus raisonnablement envisageable que la GeForce GTX Titan X pour jouer en 4K dans un boîtier ATX. Son tarif constamment revu à la baisse en fait un produit de choix dans le segment haut de gamme.

N’oublions pas non plus qu’AMD ne devrait pas tarder à annoncer ses nouvelles cartes, bien que les informations continuent à se faire attendre en ce qui concerne les successeurs des processeurs Hawaii.

Côté Nvidia, la technologie SLI n’est pas non plus exempte de défauts (elle pose par exemple son lot de problèmes dans Far Cry 4), mais si l’idée d’avoir deux GPU dans votre boîtier ne vous rebute pas, il peut être intéressant d’étudier la possibilité de monter une configuration basée sur une paire de GeForce GTX 980 : pour à peine plus cher qu’une Titan X, vous obtiendrez des performances considérablement supérieures.

Par contre, si, comme nous, vous possédez un boîtier mini-ITX actuellement confiné au 2560 x 1440, la GeForce GTX Titan X est actuellement votre seule possibilité de passer à l’Ultra HD, quitte à revoir (légèrement) à la baisse vos ambitions en matière de niveau de détails dans certains titres. Ce caractère unique mérite à lui seul que nous recommandions la nouvelle carte de Nvidia. Bien entendu, il doit exister quelque part un gagnant au Loto qui a assez de place dans son boîtier pour trois ou quatre Titan X ; lui n’a pas à hésiter : il n’existe tout bonnement aucune carte graphique au monde capable de battre les Titan en SLI.

Il ne fait aucun doute que la GeForce GTX Titan X est un produit de niche réservé à une catégorie très restreinte de joueurs. Mais si vous faites partie de cette catégorie, cette carte est sans égale. En dépit de cet attrait extrêmement limité (nous dirons « ciblé »), sa qualité intrinsèque lui vaut notre Recommended Award.