Introduction

Le concept du jeu sur multi-écrans est très simple : trois moniteurs sont reliés côté à côté pour être reconnus comme un seul écran géant afin de bénéficier d’un champ de vision plus important et d’accentuer l’immersion.

Par rapport à un unique moniteur 4K, un trio d’écrans 1080p propose plusieurs avantages : une image qui gagne considérablement en largeur, ce qui correspond au champ visuel humain. D’autre part, trois moniteurs en 1920×1080 reviennent à 6 220 800 pixels soit 25 % de moins qu’un écran 4K (8 294 400 pixels), ce qui se traduit par une charge moins importante sur la carte graphique et donc un meilleur débit d’images. Enfin, on peut s’offrir trois moniteurs 1080p 60 Hz de 20 à 23 pouces pour moins de 400 €. En comparaison, le ticket d’entrée pour une définition 4K se situe aux alentours de 430 euros : on trouve par exemple le Dell P2815Q à ce prix, modèle limité à 30 Hz en définition native que nous avons testé récemment. Accessoirement, une configuration multi-écrans s’avère très pratique en bureautique.

Du côté des inconvénients, il faut prendre en compte le fait que la consommation est triplée ainsi que les contraintes physiques : il faut un bureau capable d’accueillir trois moniteurs et de les positionner correctement. Par ailleurs, tous les jeux ne sont pas nécessairement compatibles avec ce type de configuration. Enfin, certains jugent que le fait d’avoir une telle surface d’affichage tend à détourner l’attention, ce avec quoi nous ne sommes pas d’accord. En bref, les avantages nous semblent prendre le pas sur les inconvénients.

Des cartes graphiques modestes pour jouer en multi-écrans ?

Sachant qu’un trio de moniteurs 1080p revient généralement moins cher qu’un seul écran 4K, nous poursuivons notre approche économique du jeu en multi-écrans avec des cartes graphiques très accessibles.

Gigabyte nous a envoyés deux cartes pour cet article, une Radeon R7 260X et une GeForce GTX 750 Ti. Bien qu’étant toutes deux assez proches sur le plan visuel, on remarque que la Radeon propose un connecteur CrossFire là où la GeForce est dépourvue de connecteur SLI. Par ailleurs, la Radeon est équipée d’une sortie HDMI et d’un connecteur DisplayPort, tandis que la GTX 750 Ti offre deux ports HDMI (en plus des connecteurs DVI présents sur les deux cartes). Pour le reste, les cartes sont de taille similaire, s’appuient toutes deux sur un PCB bleu caractéristique de la marque tout comme leur dissipateur Windforce.

Proposée à 128 euros, la GeForce GTX 750 Ti embarque 640 CUDA cores et 2 Go de GDDR5 sur un bus mémoire 128 bits. Premier modèle à bénéficier de l’architecture Maxwell, cette carte s’illustre en premier lieu par son excellent rendement, au point que le modèle de référence ne propose pas de connecteur d’alimentation. Le modèle de Gigabyte est cependant équipé d’un connecteur 6 broches qui pourrait s’avérer utile dans une perspective overclocking.

Pour un prix quasiment identique (132 euros), la Radeon R7 260X compte 896 Stream processors et 2 Go de GDDR5 sur un bus également 128 bits.

La technologie multi-écrans s’appelle Surround chez NVIDIA et Eyefinity chez AMD. Toutes deux sont devenues tout à fait fonctionnelles après plusieurs années de maturation, bien que l’Eyefinity soit peut-être un peu plus délicat à configurer (mais aussi plus souple dès lors qu’il s’agit de gérer des moniteurs dont la définition n’est pas identique).

Paramétrer son trio de moniteurs

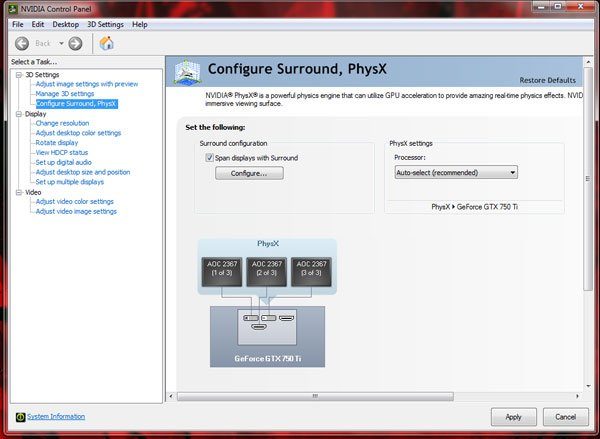

NVIDIA Surround

Le paramétrage du Surround est assez simple : après avoir ouvert le panneau de configuration NVIDIA, choisir « configurer Surround et PhysX » puis cocher la case « étendre affichages avec Surround ».

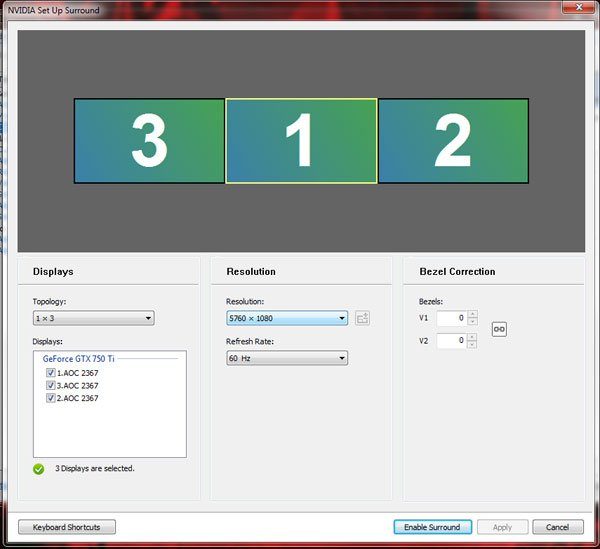

Cliquer ensuite sur « Configurer » pour déterminer la position de chaque écran grâce aux numéros affichés. Enfin, il est possible d’utiliser une option pour compenser l’espace entre les dalles des moniteurs : il faut alors cliquer sur les valeurs sous la rubrique « Bezel Correction », ce qui ouvre une boite de dialogue permettant d’ajuster la correction. Après cela, il ne reste plus qu’à cliquer sur « Activer Surround ».

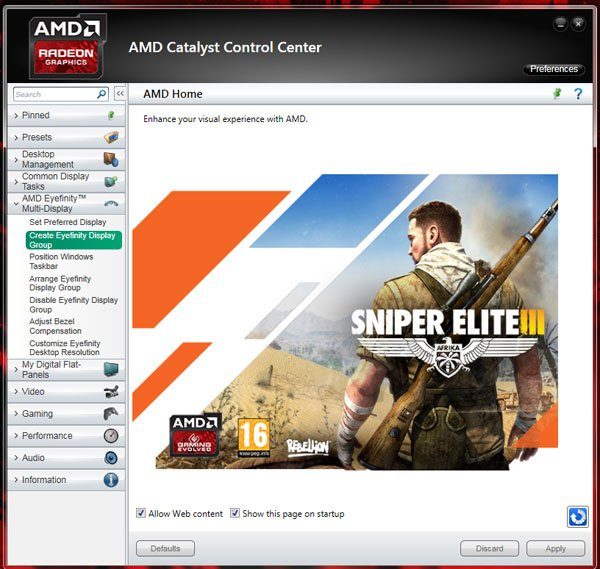

AMD Eyefinity

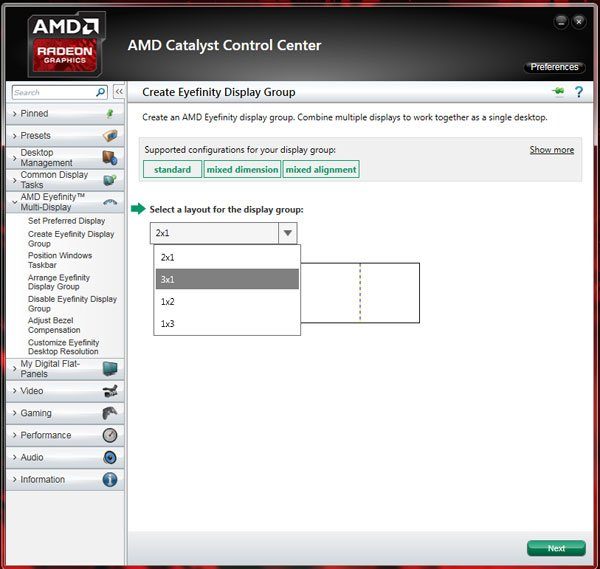

Le paramétrage d’Eyefinity est également assez facile, bien que nous ayons dû nous y prendre à deux reprises à cause d’une erreur à la première tentative. En premier lieu, aller dans « Multi-affichages AMD Eyefinity » pour choisir « Créer un groupe d’affichages Eyefinity » puis la configuration des écrans (dans notre cas, 3×1 correspondant à trois écrans en longueur et un en hauteur) avant de cliquer sur « Continuer ».

Set the position of each display by selecting the corresponding blue-colored box to match the monitor with a blue overlay. After selecting two of these, the arrangement is complete. This is where I made my initial error, since the process wasn’t completely intuitive.

La position de chaque moniteur se détermine ensuite en faisant glisser les cases bleues qui leur correspondent. Il suffit d’en choisir deux pour terminer le paramétrage. C’est à ce stade que nous avons fait une erreur, le procédé n’étant pas complètement intuitif.

Comme évoqué plus tôt, AMD nous laisse la possibilité d’utiliser des moniteurs proposant des définitions et dimensions différentes, ce qui est toujours bon à prendre. Bien entendu, il est possible de compenser l’espacement des dalles avec Eyefinity : pour cela, on clique sur « Régler la compensation de cadre » avant d’utiliser les flèches à l’écran.

Configuration du test

Comme signalé plus tôt, les configurations multi-écrans ne réussissent pas à tous les jeux : ceux qui s’en tirent le mieux son généralement les FPS et les jeux de course automobile. Sachant cela, nous avons retenu quatre FPS et deux jeux de conduite pour voir si nos cartes graphiques entrée de gamme permettent de jouer en multi-écrans. Trois titres sont récents (Battlefield 4, Titanfall, Grid 2) tandis que les deux autres ont déjà deux ans au compteur (Call of Duty: Black Ops II et Dirt Showdown). Les benchmarks ont été conduits avec Fraps pour la mesure du débit d’images, GPU-Z pour la lecture des sondes, MSI Afterburner pour l’overclocking de la GeForce et l’utilitaire Overdrive au sein des Catalyst pour l’overclocking de la Radeon. Etant donné que certains jeux ne fonctionnent pas en multi-écrans en natif, nous avons utilisé Widescreen Fixer pour rectifier le tir. Ce logiciel gratuit est tout simplement une bénédiction pour le multi-écrans : on ne compte plus le nombre de titres auxquels il nous a permis de jouer.

La composante multijoueur étant très difficile à évaluer sur le plan des performances, nous avons testé différents niveaux à plusieurs reprises pour avoir un aperçu aussi complet que possible. Par ailleurs, nous avons conservé les mêmes réglages graphiques sur les deux cartes afin de faciliter les comparaisons.

La machine de test constitue un compromis dans la mesure où il n’était pas question d’utiliser un Haswell-E pour parler du jeu en multi-écrans à budget serré, mais il ne fallait pas non plus engendrer un goulet d’étranglement au niveau du processeur (quitte à viser plus haut que ce que les deux cartes graphiques nécessitent). Nous avons donc choisi un Intel Core i5-3570K overclocké à 4,2 GHz, 16 Go de DDR3 Corsair LP paramétrés à 2133 MT/s et une carte mère ASRock Z77 Extreme4-M.

| Composants | |||||

|---|---|---|---|---|---|

| Processeur | Intel Core i5-3570K (Ivy Bridge), O/C @ 4,3GHz, quatre cores, LGA 1155, 6 Mo de cache L3 partagés | ||||

| Carte mère | ASRock Z77 Extreme4-M (LGA 115) chipset Intel Z77 | ||||

| Moniteurs | Trois 23” AOC 12367F IPS 1080p | ||||

| DRAM | Corsair Vengeance LP PC3-16000, 4 x 4 Go | ||||

| Cartes graphiques | Gigabyte Radeon R7 260X GPU @ 1000MHz, 2 Go de GDDR5 @ 1250MHz (5000 MT/s) Gigabyte GeForce GTX 750 Ti GPU @ 1165/1365MHz, 2 Go de GDDR5 @ 1753MHz (7012 MT/s) | ||||

| Stockage | Samsung 840 Pro, SSD 256 Go, SATA 6Gb/s | ||||

| Alimentation | Seasonic 660W Platinum, ATX12V, EPS12V | ||||

| Logiciels et pilotes | |||||

| OS | Microsoft Windows 8 Pro 64 bits | ||||

| DirectX | DirectX 11 | ||||

| Pilotes graphiques | Radeon: AMD Catalyst 14.9 GeForce: NVIDIA 344.48 | ||||

Battlefield 4

Pour avoir plus joué à Battlefield 4 que les autres titres du jour, nous avons une bonne idée de ses performances suivant divers réglages. Sachant que le FPS de DICE s’appuie sur un moteur 3D puissant (Frostbite 3) qui permet un bon échelonnement des performances sur un large éventail de composants, nous étions curieux de voir comment s’en sortiraient nos cartes graphiques entrée de gamme dans ces circonstances exigeantes.

GeForce GTX 750 Ti – Surround

Comme on peut le voir sur les graphiques ci-dessous, notre configuration permet de jouer avec un niveau de détails bas, sans v-sync. Visuellement parlant, le jeu n’impressionne pas quand ont fait de tels sacrifices et l’on constate du tearing. C’est là le prix à payer pour jouer sur trois écrans avec une carte graphique modeste.

Nous avons ensuite essayé d’overclocker le GPU tout en abaissant la définition en 4800×900 (au lieu de 5760×1080) pour passer à un niveau de détails moyen, ce qui est déjà plus agréable sur le plan visuel et reste jouable. Grâce à l’utilitaire MSI Afterburner, nous avons ainsi augmenté la fréquence GPU Boost à 1213 MHz (contre 1111 MHz d’origine) et la mémoire à 1407 MHz (au lieu de 1250 MHz), ce qui a sensiblement amélioré les performances.

Radeon R7 260X – Eyefinity

Les tests ont été entamés sous Eyefinity avec un profil medium en 4800×900, étant donné que ces réglages ont permis d’atteindre les meilleurs résultats avec la GeForce. Cependant, nous avons utilisé Mantle en plus de DirectX 11 avec la R7 260X. A l’arrivée, les résultats sont très proches d’une carte à l’autre. Mantle nous a permis de grappiller quelques ips en performances moyennes et maximales, sans pour autant augmenter les performances minimum.

Notons que toute tentative d’overclocking de la Radeon avec MSI Afterburner avait pour effet de figer le PC. Fort heureusement, l’utilitaire Overdrive au sein du Catalyst Control Center s’est montré parfaitement fonctionnel : nous avons pu atteindre un maximum stable de 1244 MHz pour le GPU (au lieu de 1188 MHz) et 1650 MHz au niveau de la mémoire (contre 1625 MHz). Dans ces conditions, les résultats se sont améliorés pour atteindre 47 ips, une performance plutôt appréciable !

Titanfall & Call Of Duty: Black Ops II

Titanfall est un jeu qui propose de nombreux paramètres ; nous avons donc pu trouver un équilibre entre réglages bas et medium pour arriver à des performances acceptables.

GeForce GTX 750 Ti – Surround

Dans un premier temps, nous avons essayé de jouer en définition native avec des réglages bas, mais le résultat ne nous a pas convaincus : si le débit d’image moyen se maintient entre 30 et 35 ips, ce que l’on considère comme étant jouable, le jeu n’est pas agréable à voir avec ces réglages. Nous avons donc abaissé la définition en 4800×900, overclocké le GPU et poussé certains réglages en medium tout en laissant les autres sur bas. Il en résulte un jeu beaucoup plus plaisant sur le plan visuel ainsi qu’une performance moyenne respectable.

Radeon R7 260X – Eyefinity

Le constat est identique du côté AMD : en 5760×1080 avec un profil bas, le débit d’image est correct mais les graphismes laissent franchement à désirer. Nous avons donc repris les réglages personnalisés utilisés sur la GTX 750 Ti pour améliorer l’expérience de jeu à tous points de vue.

Call Of Duty: Black Ops II

Les CoD ont le mérite d’être des fps bien rythmés que l’on aborde facilement, et Black Ops II s’inscrit lui aussi dans cette tendance. Bien qu’étant sorti en novembre 2012, ce titre a pu conserver une communauté de joueurs conséquente, ce qui est appréciable. Le moteur du fps d’Activision n’est pas particulièrement gourmand, ce qui veut dire que l’on devrait voir de très bonnes performances en multi-écrans. Précisons que Black Ops II n’est pas optimisé pour le jeu sur plusieurs écrans à la base, mais Widescreen Fixer permet d’ajouter facilement cette fonctionnalité.

GeForce GTX 750 Ti – Surround

Nous avons démarré ce jeu en 5760×1080 avec des réglages moyens, avec occlusion ambiante et sans AA/FXAA pour arriver à des résultats tout à fait corrects. Cependant, le tearing manifeste nous a poussés à descendre en 4800×900 tout en overclockant le GPU avec à la clé des performances maximum/moyennes de 95/58 ips. Avec la v-sync, le débit d’image tend à tomber trop souvent aux alentours de 30 ips à notre goût.

Radeon R7 260X – Eyefinity

Comme constaté avec la GTX 750 Ti, Black Ops II est fluide sur la R7 260X en définition native tout en souffrant d’un tearing prononcé. Là encore, le fait d’abaisser la définition en 4800×900 a permis de corriger le problème et de rendre le jeu nettement plus agréable.

Grid 2 & DiRT Showdown

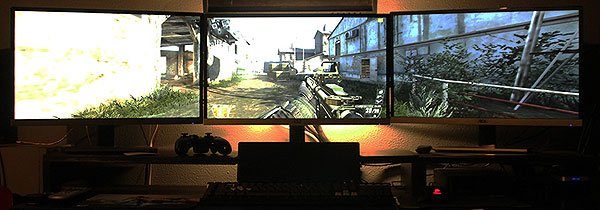

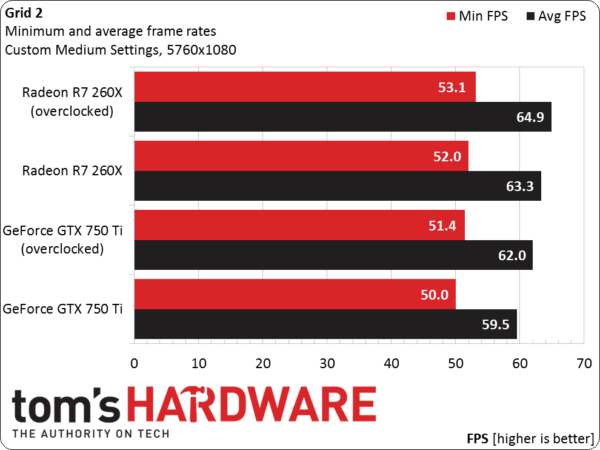

Jouer à Grid 2 en multi-écrans est une expérience marquante. Nous avons utilisé le benchmark intégré et fait plusieurs courses pour vérifier les résultats obtenus.

GeForce GTX 750 Ti – Surround

Avec des réglages personnalisés et sans v-sync, le jeu est fluide en 5760×1080. L’overclocking permet de gagner quelques images par seconde, mais contrairement aux précédents titres, on ne peut pas qualifier cette étape de nécessité.

Voici nos réglages en détail : profil medium, brouillard avancé désactivé, tissu élevé, occlusion ambiante élevée, occlusion ambiante douce désactivée, terrain élevé, traces de dérapage activées, éclairage avancé et illumination d’ensemble désactivés.

Radeon R7 260X – Eyefinity

Grid 2 faisant partie du programme AMD Evolved, nous nous attendions à ce que les performances sur la Radeon soit au moins aussi bonnes que sur la GTX 750 Ti, ce qui s’est vérifié par la suite. Là encore, l’overclocking ne permet pas de faire progresser significativement les performances.

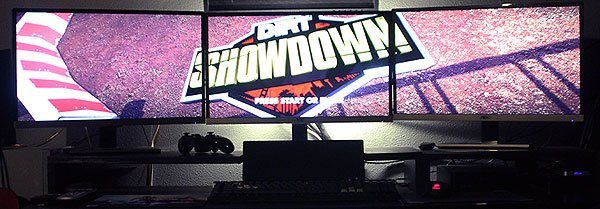

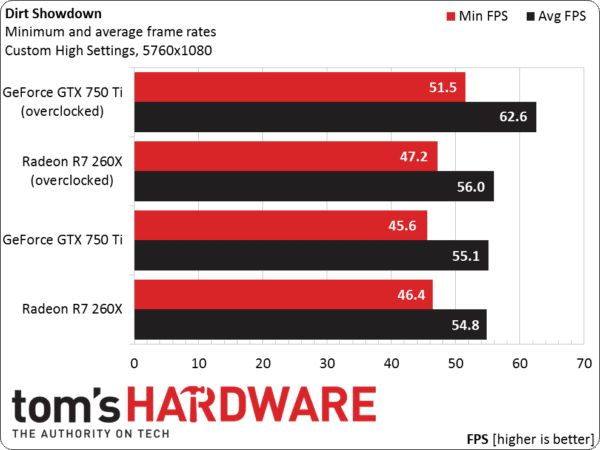

DiRT Showdown

Le titre de Codemasters ayant plus de deux ans et demi, il semblait logique de constater de très bonnes performances. Nous avons utilisé à nouveau des réglages personnalisés : pas de multi-sampling, mode plein écran, 60 Hz, niveau de détails élevé (mis à part l’éclairage avancé et l’illumination globale, tous deux désactivés).

GeForce GTX 750 Ti – Surround

Pas de mauvaises surprises : la petite GeForce n’a aucun mal à faire tourner DiRT Showdonwn dans de bonnes conditions avec nos réglages.

Radeon R7 260X – Eyefinity

DiRT Showdown a un point commun avec Grid 2 : tous deux font partie du programme Gaming Evolved d’AMD, laissant ainsi présager de bonnes performances sur la Radeon. A l’arrivée, la R7 260X affiche des performances quasi égales à celles de la GTX 750 Ti, cette dernière étant cependant plus réceptive que sa concurrente à l’overclocking ici.

Conclusion

Bon nombre d’entre nous s’imaginent que les cartes graphiques à petit prix comme la GeForce GTX 750 Ti et la Radeon R7 260X ne permettent absolument pas de jouer sur trois écrans dans des conditions acceptables. A l’appui de nos benchmarks, on peut faire un constat bien différent.

A la base, notre but n’était pas d’opposer une GeForce à une Radeon, mais plutôt de montrer que les deux cartes sont des options à considérer pour le multi-écrans : toutes deux peuvent gérer trois écrans et ce pour un prix d’environ 130 euros. En parallèle, souvenons-nous qu’il y a une dizaine d’années environ, un moniteur LCD 19 pouces coûtait plus cher que trois moniteurs 1080p entrée de gamme aujourd’hui. Voilà donc un exemple caractéristique de technologie qui s’améliore et devient de plus en plus accessible au fil du temps.

Un trio de moniteurs peut non seulement améliorer l’expérience de jeu, mais aussi le confort d’utilisation en général. La retouche d’image est par exemple plus facile, de même que l’on peut répartir navigateur, logiciel de traitement de texte et lecteur de musique/photos chacun sur un écran. Plus besoin d’agrandir/réduire les fenêtres : tout reste ouvert en simultané.

Cette expérimentation nous semble être une franche réussite. Bien entendu, ce n’est pas avec une GTX 750 Ti ou une R7 260X que l’on peut jouer aux titres les plus exigeants avec les réglages graphiques au maximum en 5760×1080, mais il est tout de même possible d’ajouter une considérable sensation d’immersion aux jeux PC pour peu que l’on soit prêt à quelques concessions.

La 4K se démocratise et nous ne manquons pas de tester de plus en plus souvent les moniteurs proposant cette définition, mais à nos yeux, cette débauche de pixels n’apporte pas autant que l’immersion procurée par trois moniteurs. Signalons par ailleurs que bon nombre de jeux (surtout ceux qui ont déjà quelques années au compteur) ne proposent pas de mise à l’échelle de l’interface utilisateur à l’écran, ce qui les rend injouables puisque des informations importantes sont affichées de manière microscopique. A l’opposé, une configuration en 5760×1080 permet d’utiliser une interface utilisateur de taille normale et s’avère moins lourde à gérer pour une carte graphique (25 % de pixels en moins qu’un moniteur 4K), ce qui permet d’atteindre des performances correctes plus facilement.

Bref, le retour en arrière est difficile une fois que l’on a goûté aux joies du multi-écrans. Au-delà de notre avis, nous espérons que cet article aura permis de relativiser les idées reçues à propos de ces configurations.