Deux fois plus de VRAM que l’actuel Ampere A100, qui embarque 40 Go de mémoire HMB2.

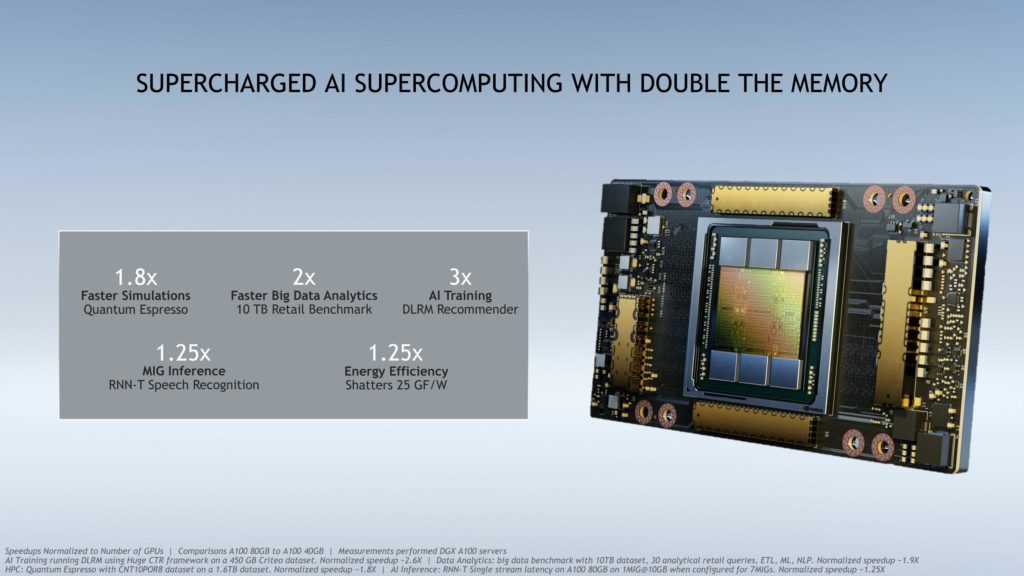

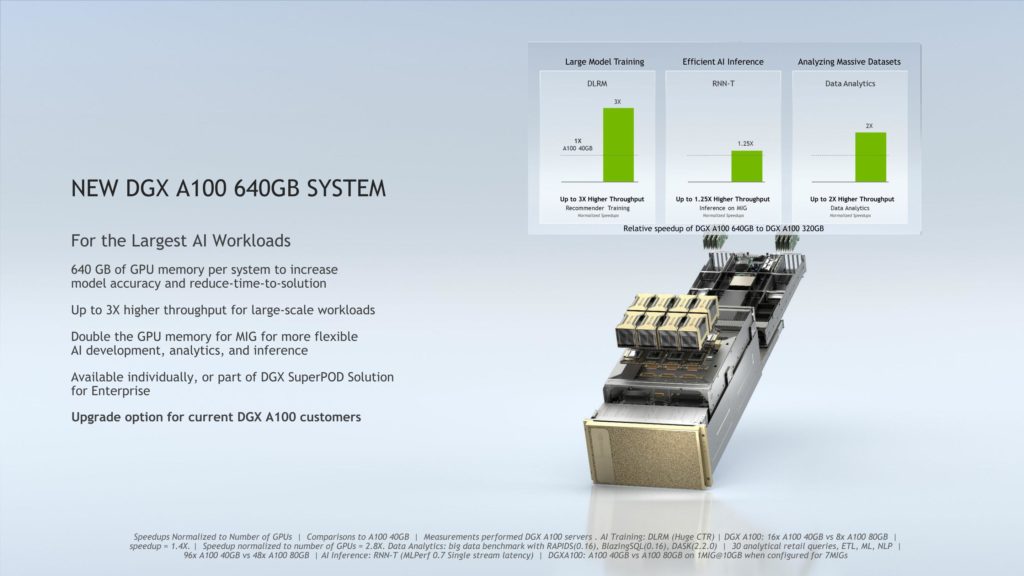

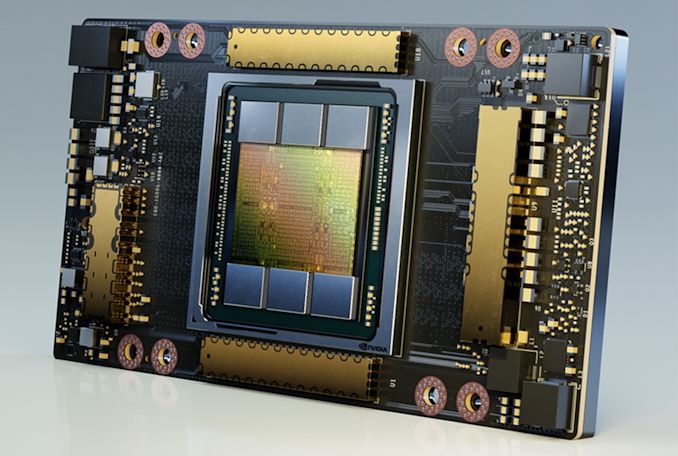

En mai dernier, NVIDIA avait officialisé son Ampere A100, un GPU comprenant 54 milliards de transistors muni de 40 Go de mémoire HBM2. À l’occasion du SC20, NVIDIA a présenté une nouvelle variante de ce GPU : elle est armée de deux fois plus de mémoire, 80 Go de mémoire, qui plus est de type HBM2E. La vitesse passe ainsi de 2,4 Gbit/s à 3,2 Gbit/s, ce qui augmente la bande passante mémoire à 2 To/s contre 1,6 To/s pour la première itération.

Toujours destinée aux plateformes de calcul intensif IA, cette A100 mieux achalandée en VRAM devrait pouvoir traiter une quantité de données encore plus conséquente. Pour le reste, les spécifications sont identiques à l’actuel A100. On retrouve donc les 6 912 cœurs CUDA FP32, une fréquence GPU de 1,41 GHz pour une puissance de calcul simple précision de 19,5 TFLOPS. Notez que les deux solutions cohabiteront dans les prochains mois : l’A100 donc il est question ici ne remplace pas l’ancien.

La carte Ampere A100 de NVIDIA s’impose sur MLPerf

Des GPU gravés en 7 nm par TSMC

Le site AnandTech a élaboré le tableau ci-dessous pour faciliter la comparaison entre les deux versions. Si pour se fournir en mémoire HBM2E, NVIDIA s’approvisionne apparemment auprès de Samsung (celle de SK Hynix offre une vitesse mémoire de 3,6 Gbit/s), qui se charge également de graver les RTX 3000 Ampere pour les particuliers en 8 nm, la production de ces GPU A100 revient à TSMC, et en 7 nm.

| GPU | A100 (80 Go) | A100 (40 Go) | V100 |

| Cœurs CUDA FP32 | 6912 | 6912 | 5120 |

| Fréquence Boost | 1,41 GHz | 1,41 GHz | 1,53 GHz |

| Vitesse mémoire | 3,2 Gbit/s HBM2e | 2,4 Gbit/s HBM2 | 1,75 Gbit/s HBM2 |

| Taille bus mémoire | 5120-bit | 5120-bit | 4096-bit |

| Bande passsante mémoire | 2,0 To/sec | 1,6 To/sec | 900 Go/sec |

| VRAM | 80 Go | 40 Go | 16 Go/32 Go |

| Simple précision | 19,5 TFLOPs | 19,5 TFLOPs | 15,7 TFLOPs |

| Double précision | 9,7 TFLOPs | 9,7 TFLOPs | 7,8 TFLOPs |

| INT8 Tensor | 624 TOPs | 624 TOPs | N/A |

| FP16 Tensor | 312 TFLOPs | 312 TFLOPs | 125 TFLOPs |

| TF32 Tensor | 156 TFLOPs | 156 TFLOPs | N/A |

| Interconnexion | NVLink 3 – 12 Liens (600 Go/sec) | NVLink 3 – 12 Liens (600 Go/sec) | NVLink 2 – 6 Liens (300 Go/sec) |

| GPU | GA100 (826 mm2) | GA100 (826 mm2) | GV100 (815 mm2) |

| Nombre de transistors | 54,2 milliards | 54,2 milliards | 21,1 milliards |

| TDP | 400 W | 400 W | 300 W/350 W |

| Process | TSMC 7N | TSMC 7N | TSMC 12 nm FFN |

| Interface | SXM4 | SXM4 | SXM2/SXM3 |

| Architecture | Ampere | Ampere | Volta |

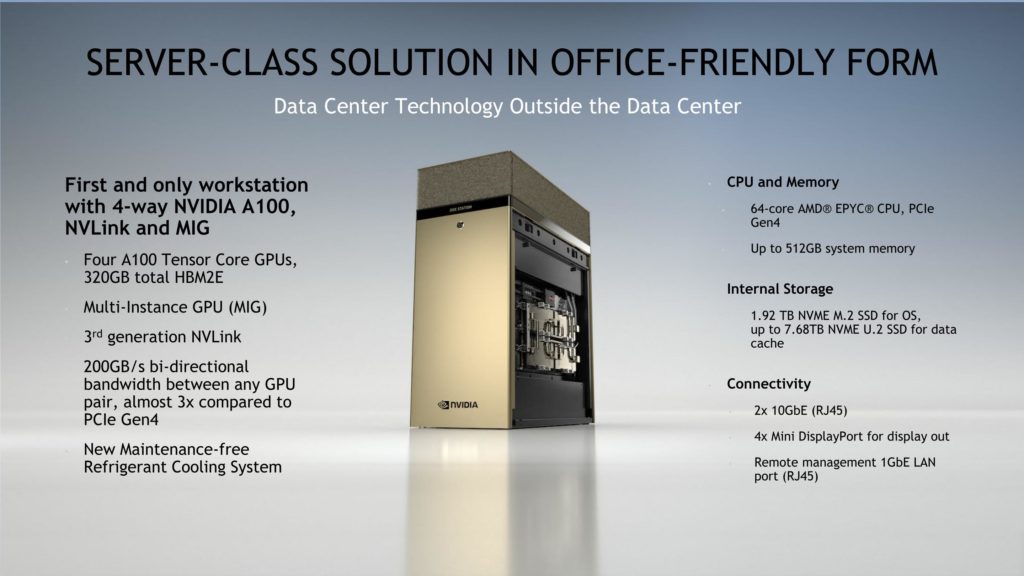

En outre, NVIDIA prévoit une DGX Station A100, la remplaçante de la Station DGX Volta, dotée de 4 GPU A100. Dans la station de travail, ces derniers collaborent avec un CPU AMD EPYC de 64 cœurs.

Source : NVIDIA

bjr

mieux achalandée ? J’ai un doute sur l’utilisation de ce mot dans ce contexte.