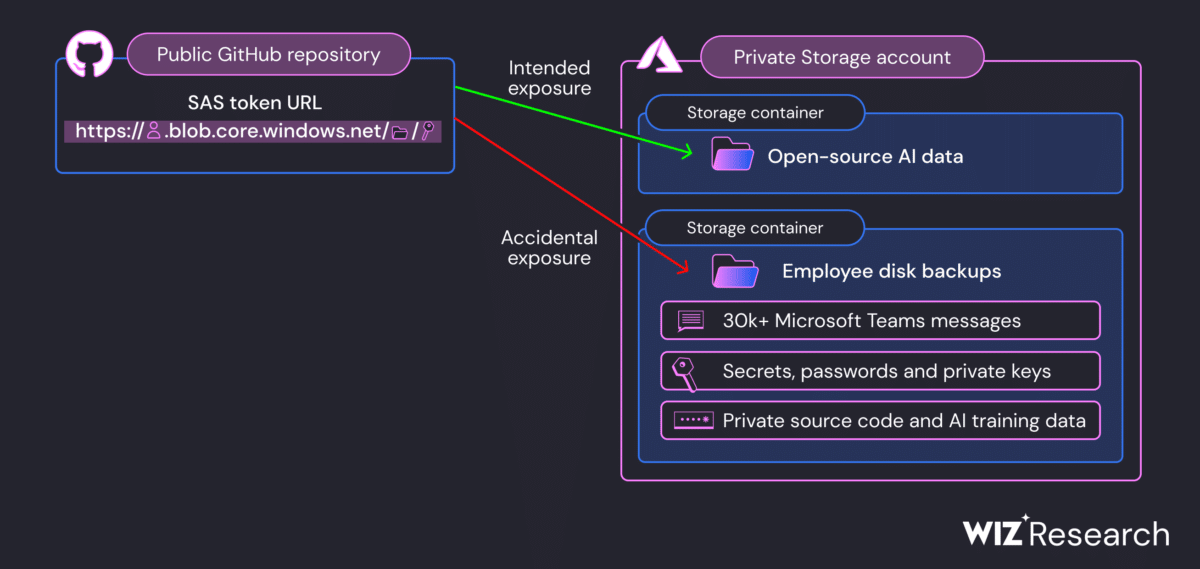

Un employé de Microsoft a accidentellement exposé 38 téraoctets de données privées en publiant un ensemble de données d’entraînement à l’IA open source sur GitHub. Les chercheurs en sécurité de Wiz ont découvert cette fuite et l’ont signalée à Microsoft.

Dans un contexte où les entreprises comme Microsoft récupèrent toujours plus de datas, la sécurité des données devient un problème majeur. Ces géants de la tech sont parfois prêts à tout pour entrainer leur IA et les affaires de failles sécuritaires sont malheureusement fréquentes. L’incident provient de la divulgation de 38 To de données sensibles par l’équipe de recherche en IA de Microsoft. L’affaire n’est pas récente, les données ont fuité en 2020 et Wiz reporta l’information à Microsoft en juin 2022.

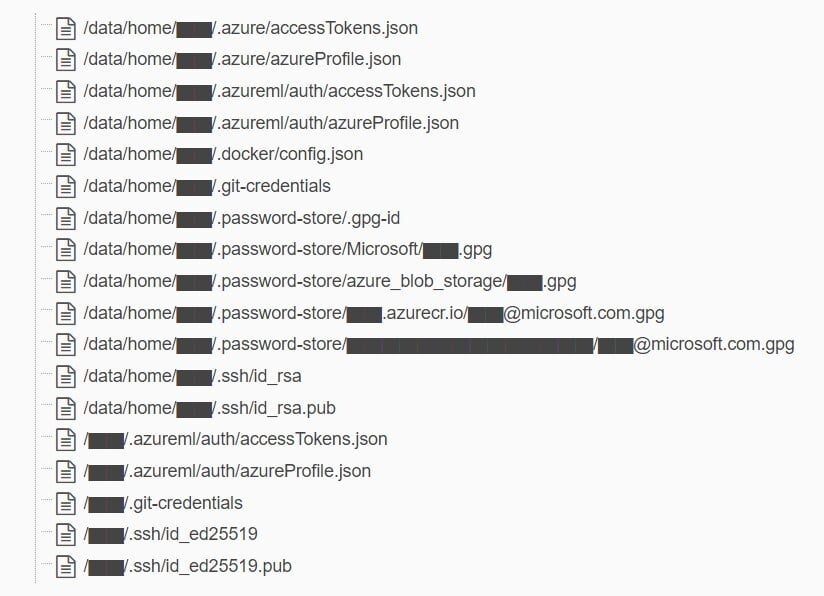

Dans un communiqué publié lundi, Microsoft minimise le problème en le qualifiant de simple « partage d’enseignements » afin que les clients ne fassent pas les mêmes erreurs. Malgré les affirmations de Wiz selon lesquelles les données fuitées contenaient des clés privées, des mots de passe, plus de 30 000 messages internes de Microsoft Teams et des données de sauvegarde, le Centre de réponse de sécurité de Microsoft affirme :

« Aucune donnée client n’a été exposée et aucun autre service interne n’a été mis en danger à cause de ce problème (…) Aucune action de la part des clients n’est requise en réponse à ce problème. »

Fuite de données chez Microsoft, un problème de configuration d’accès

Il est important de préciser que le compte de stockage en question est privé et administré par Azure Storage, service de Microsoft pour le stockage des données dans le GitHub. Sa protection, quant à elle, est assurée par un mécanisme appelé « token SAS » (Shared Access Signature), qui permet la création d’un lien partageable autorisant l’accès au compte de stockage.

Les chercheurs de Wiz ont expliqué que cette fuite était due à une mauvaise configuration du jeton SAS. Ce dernier permettait un accès trop permissif aux ressources Azure Storage de Microsoft, avec notamment des autorisations de contrôle total. Cela signifie que non seulement Wiz, mais aussi d’autres acteurs malveillants potentiels, pouvaient voir, supprimer ou modifier les fichiers dans le compte de stockage. Après avoir été informé du problème, Microsoft a révoqué le jeton SAS pour empêcher l’accès externe au compte de stockage et a mis fin à la fuite. Une enquête a conclu qu’il n’y avait aucun risque pour les clients.

En raison de l’absence de sécurité et de gouvernance des jetons SAS de compte, ceux-ci doivent être considérés comme aussi sensibles que la clé de compte elle-même. Par conséquent, il est fortement recommandé d’éviter d’utiliser les comptes SAS pour le partage externe.

En attendant, Microsoft a listé ses recommandations pour minimiser le risque des token trop permissifs, telles que limiter la portée des URL et définir un délai d’expiration plus court. Microsoft a également promis d’améliorer ses outils de détection et d’analyse pour identifier de manière proactive de tels cas à l’avenir.

Source: Wiz.io