Introduction

Nvidia aime les analogies. Au lancement de sa génération précédente de cartes graphiques, la société a comparé chacun de ses modules à une unité sur le champ de bataille. La GeForce GTX 480 était un char d’assaut : performances élevées, mais également prix élevé, consommation élevée et dissipation thermique élevée (cf. notre test). La GeForce GTX 460 était un chasseur, offrant un meilleur équilibre entre vitesse, rapport performances/watts et prix ; dans l’ensemble, il s’agissait d’une carte plus adaptée pour les joueurs. Enfin, la GeForce GTS 450 était le sniper, une carte censée offrir des framerates jouables en 1680 x 1050, selon Nvidia.

Ce trio de catégories a beau nous avoir semblé un peu loufoque à l’époque, il nous permet aujourd’hui d’appréhender plus aisément ce qui fait la spécificité de la GeForce GTX 680. Bien que son nom et son prix nous donnent l’impression d’avoir sous les yeux le successeur de l’actuel fleuron mono-GPU de la gamme Nvidia, il s’agit plutôt d’un « chasseur », c’est-à-dire d’une carte orientée gamers qui essaye presque totalement de faire oublier un aspect que la firme n’avait jusqu’ici cessé de marteler, à savoir les performances en GPGPU. Changement de cap donc, mais les joueurs devraient en avoir pour leur argent, comme avec la GeForce GTX 460 à son époque.

Pas toujours facile de trouver sa place

N’oublions toutefois pas que, quel que soit le rôle que Nvidia voudrait imposer à son nouveau modèle, c’est avant tout la concurrence qui décide du positionnement d’un nouveau produit. AMD a peut-être sur sa feuille de route des cartes haut de gamme dont personne n’a encore entendu parler ; mais pour l’heure, Nvidia sait cependant exactement ce que valent les six Radeon HD 7000 qui sont déjà sorties.

Si la Radeon HD 7970 était 30 ou 40 % plus rapide que ce que nos tests ont démontré, il y a de fortes chances pour que la carte que nous testons aujourd’hui ne se soit pas appelée « GeForce GTX 680 », mais bien GTX 660 ou 670. Mais le fer de lance de la gamme AMD étant ce qu’il est, Nvidia trouve qu’il est parfaitement justifié de faire succéder son nouveau « chasseur » à son ancien « char d’assaut » tout en nous faisant clairement comprendre que l’artillerie lourde ne va pas tarder à débarquer.

Ce que nous avons donc dans les mains est une carte à 500 $ basée sur la puce Nvidia GK104 et conçue spécifiquement pour les joueurs (si le GPGPU vous intéresse, vous allez encore devoir patienter un petit peu). La GeForce GTX 680 efface certains des défauts les plus criants de la génération précédente et y ajoute une poignée de fonctionnalités intéressantes.

La carte

Avec ses 25,5 cm, la GeForce GTX 680 est un bon centimètre plus longue que les cartes AMD Radeon HD 7800 et un bon centimètre plus courte que les Radeon HD 7900.

Équipée d’un ventilateur radial, elle évacue la majeure partie de l’air chaud par sa grille arrière, qui ne fait qu’environ un demi-emplacement de large ; fort heureusement, comme nous le verrons à la page consacrée aux performances thermiques et acoustiques, la GTX 680 ne connaît pas les problèmes de surchauffe.

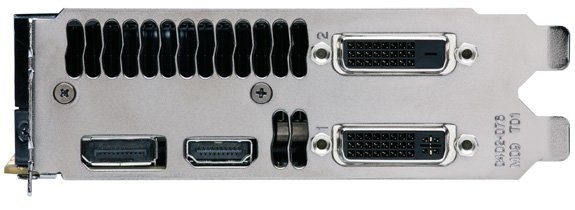

Le reste de la face arrière (qui prend deux emplacements) héberge quatre sorties vidéo : deux DVI dual-link, une HDMI pleine taille et une DisplayPort. Grande nouvelle : toutes ces sorties sont utilisables simultanément, ce qui répond agréablement à l’une des plus vives critiques jusqu’ici adressées à Nvidia concernant ses cartes Fermi. Nous allons enfin pouvoir procéder à des tests en configuration multi-moniteurs dans les jeux plutôt qu’en 2560 x 1600 ! Comme AMD, Nvidia annonce la prise en charge du HDMI 1.4a, des résolutions grimpant jusqu’à 4000 pixels horizontalement et de l’audio multi-flux.

Sur la tranche, la GeForce GTX 680 est dotée de deux connecteurs SLI, ce qui signifie que les configurations SLI à deux, trois et quatre voies sont de la partie (heureusement, car les AMD Radeon HD 7970 et 7950 permettent de monter des configurations CrossFire de même taille).

Nous avons également le premier élément physique semblant indiquer que la puce Nvidia GK104 est prévue pour fonctionner dans les environnements plus mainstream : la carte n’a besoin que de deux connecteurs d’alimentation auxiliaires à six broches. Avec l’emplacement PCI Express, ces deux connecteurs peuvent apporter jusqu’à 225 watts de puissance. Nvidia annonce toutefois un TDP de 195 watts, tout en précisant que la consommation devrait plus fréquemment tourner autour des 170 watts. Gardez ces chiffres en tête, car la marge disponible entre ces 170 watts et les 225 watts que peuvent fournir le port et les connecteurs ne va pas tarder à entrer en jeu.

Système de refroidissement

Nvidia affirme avoir consacré énormément d’efforts à trois aspects de son ventirad (qui occupe, comme la carte, deux emplacements) afin de réduire l’empreinte acoustique de la GeForce GTX 680, même en charge. Nous avons enlevé la jupe de la demoiselle afin d’y jeter un coup d’œil plus approfondi…

Premièrement, la firme a intégré au radiateur du GPU trois caloducs en forme de fer à cheval qui captent la chaleur du GK104 et la transfèrent dans un radiateur en aluminium occupant, une fois encore, une largeur de deux emplacements.

Deuxièmement, Nvidia a amélioré le radiateur proprement dit. Ses ailettes, par exemple, sont inclinées à l’endroit où sort l’air afin de mieux espacer le ventirad et la grille d’évacuation. Apparemment, sur les cartes précédentes, la chaleur restait coincée entre les ailettes et la grille, ce qui perturbait le refroidissement ; cette nouvelle approche est censée mieux réduire la température.

Troisièmement et dernièrement, la société affirme avoir ajouté un matériau servant de tampon acoustique au moteur du ventilateur ; notons que cette approche n’est pas exactement neuve, car c’était déjà le cas de la GeForce GTX 580, dont les nuisances sonores était effectivement déjà nettement moindres que celles de la GTX 480, tristement célèbre en la matière.

GK104 : la puce, l’architecture

Caractéristiques techniques

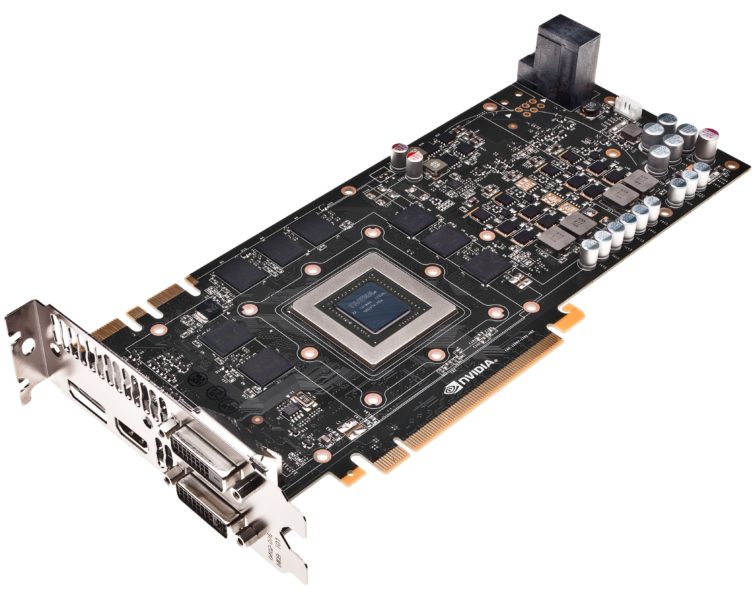

Le démontage du ventirad nous laisse avec une carte nue.

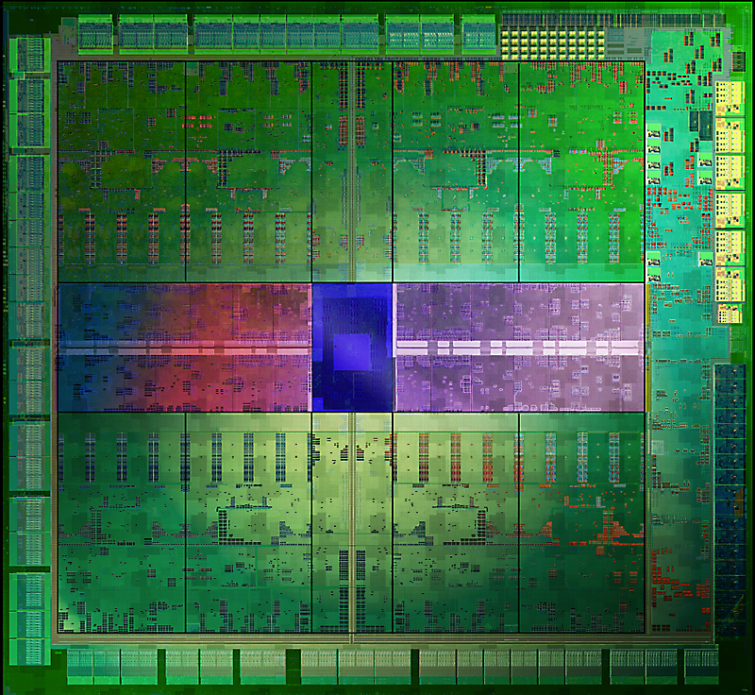

Au milieu de celle-ci trône le GPU GK104, dont le die de 294 mm² contient 3,54 milliards de transistors. Une fois de plus Nvidia se situe sur ce plan entre deux des modèles AMD actuels : le GPU Tahiti contient 4,31 milliards de transistors sur un die de 365 mm² tandis que le Pitcairn en contient 2,8 milliards sur un die de 212 mm².

Sachant que le GK104 est gravé en 28 nm par TSMC, il y a fort à parier pour que les cartes ne soient disponibles qu’en nombre restreint dans un premier temps : le fondeur doit en effet partager sa production, assez limitée, entre plusieurs clients. Ceci étant dit, Nvidia affirme que l’on trouvera bien quelques exemplaires en magasin dès aujourd’hui; la commercialisation de lots supplémentaires est prévue pour début avril.

Passons maintenant en revue les spécifications techniques du nouveau GPU par rapport à celles de la GeForce GTX 580 et de l’AMD Radeon HD 7970.

| GeForce GTX 680 | Radeon HD 7950 | Radeon HD 7970 | GeForce GTX 580 | |

|---|---|---|---|---|

| Shaders | 1536 | 1792 | 2048 | 512 |

| Unités de textures | 128 | 112 | 128 | 64 |

| ROP Full Color | 32 | 32 | 32 | 48 |

| Fréquence GPU | 1006 MHz | 800 MHz | 925 MHz | 772 MHz |

| Fillrate textures | 128,8 Gtex/s | 89,6 Gtex/s | 118,4 Gtex/s | 49,4 Gtex/s |

| Fréquence mémoire | 1502 MHz | 1250 MHz | 1375 MHz | 1002 MHz |

| Bus mémoire | 256 bits | 384 bits | 384 bits | 384 bits |

| Bande passante mémoire | 192,3 Go/s | 240 Go/s | 264 Go/s | 192,4 Go/s |

| RAM graphique | 2 Go de GDDR5 | 3 Go de GDDR5 | 3 Go de GDDR5 | 1,5 Go de GDDR5 |

| Taille du die | 294 mm2 | 365 mm2 | 365 mm2 | 520 mm2 |

| Transistors (milliards) | 3,54 | 4,31 | 4,31 | 3 |

| Finesse de gravure | 28 nm | 28 nm | 28 nm | 40 nm |

| Connecteurs d’alimentation | 2 x 6 broches | 2 x 6 broches | 1 x 8 broches + 1 x 6 broches | 1 x 8 broches + 1 x 6 broches |

| Consommation max. | 195 W | 200 W | 250 W | 244 W |

| Prix | 500 € (selon Nvidia) | 450 € | 500 € | env. 400 € |

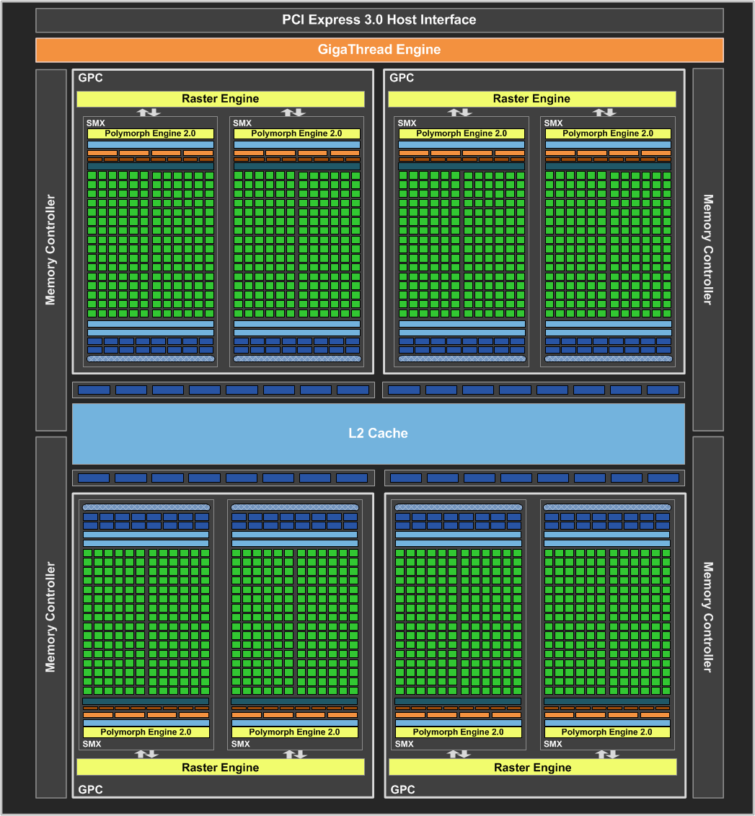

Le GK104 se compose de quatre Graphics Processing Clusters (GPC), contenant chacun deux Streaming Multiprocessors (anciennement appelé SM et maintenant dénommés SMX).

Nous pourrions sans doute consacrer des pages entières à l’évolution des GPU Nvidia, depuis le GF100 original jusqu’au GK104 lancé aujourd’hui, mais la manière la plus simple de décrire la nouvelle puce est probablement de la comparer au GF104 qui se trouvait au cœur de la GeForce GTX 460.

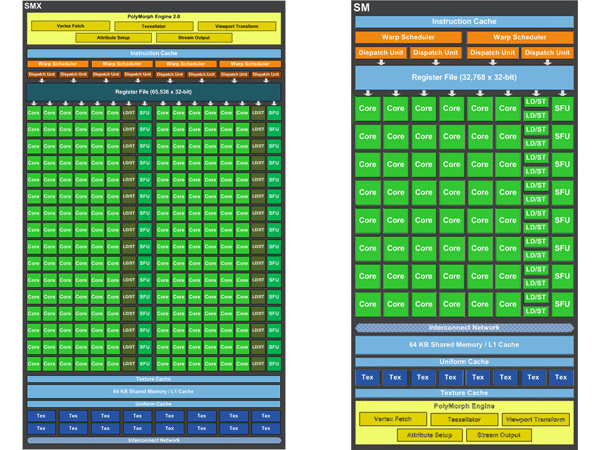

Par rapport aux SM du GF104, les SMX du GK104 contiennent deux fois plus de warp schedulers (4 contre 2), d’unité de distpatch (8 contre 4) et d’unité de textures (16 contre 8) ; de même, le registre est deux fois plus grand. Le nombre de cores CUDA est quant à lui multiplié par quatre : alors que le GF104 contenait 48 shaders par SM, le GK104 en contient 192 par SMX.

Pourquoi quadrupler le nombre de cores CUDA et doubler les autres ressources ? Les shaders de la puce Kepler fonctionnent à la fréquence du processeur (1:1), contrairement à ceux des architectures précédentes (depuis le G80 !), dont la fréquence était deux fois plus élevée que celle du core (2:1). Pour doubler le débit des shaders à une fréquence donnée, il faut donc quatre fois plus de cores.

Une architecture repensée pour l’efficacité

On se demande dans ce cas pourquoi Nvidia a réduit à ce point la fréquence de ses shaders. C’est bien simple : tout est question d’équilibre entre les performances, la consommation et l’espace occupé sur le die. L’architecture Fermi permettait aux ingénieurs de la firme d’optimiser ce dernier point ; moins de cores, moins de surface. Par contre, pour les faire tourner plus vite, il faut obligatoirement augmenter leur fréquence. L’architecture Kepler, à l’inverse, est optimisée pour l’efficacité : fréquence réduite, consommation réduite. Par contre, il faut augmenter le nombre de shaders pour obtenir les mêmes performances (ce qui augmente bien entendu la consommation, mais pas autant que la montée en fréquence). Par conséquent, les puces Kepler sacrifient l’espace sur le die au profit de la consommation.

Nvidia récupère une partie de cet espace en éliminant certaines des structures matérielles de contrôle, en particulier les warp schedulers, et en confiant leur travail aux logiciels. En minimisant l’énergie et la surface consommées par les circuits de contrôle, la firme dégage plus de marge pour le travail « utile ».

La firme au caméléon affirme que les changements qu’elle a apportés à l’architecture de ses SMX doivent théoriquement doubler les performances par watt des puces Kepler par rapport aux Fermi ; l’objectif est ambitieux, et nous verrons plus loin s’il est effectivement atteint.

En résumé, nous avons donc 8 SMX contenant chacun 192 cores CUDA, ce qui porte le total de ces derniers à 1536. Parallèlement, nous avons 16 unités de textures par SMX, soit 128 au total pour une puce GK104 non bridée. Et enfin, nous avons un moteur de géométrie PolyMorph par SMX, ce qui donne un total de 8. Ce dernier point peut surprendre : en effet, le GF104 contenait lui aussi huit moteurs PolyMorph ; Nvidia aurait donc négligé de faire évoluer ses performances en géométrie ? Pas tout à fait.

Géométrie

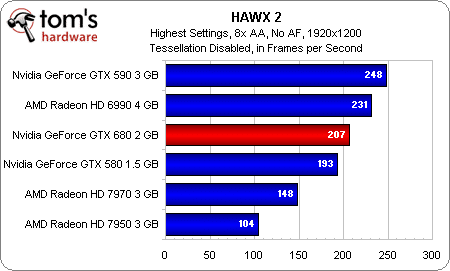

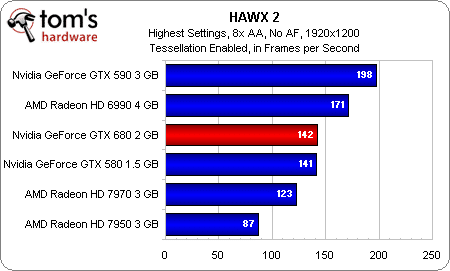

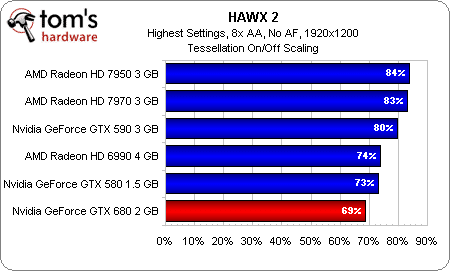

Pour commencer, Nvidia affirme que les moteurs PolyMorph des puces Kepler ont été redessinés afin de doubler leurs performances par MHz par rapport à ceux des puces Fermi. À l’heure actuelle, cette amélioration se remarque principalement dans les benchmarks synthétiques, mais de nombreux développeurs affirment que la géométrie devrait représenter l’essentiel de leurs efforts à l’avenir, le but étant d’augmenter le réalisme dans les jeux. La grande question est toutefois de savoir ce que l’on peut attendre de l’architecture Kepler dans les titres actuels, par exemple HAWX 2.

Dans l’absolu, la GeForce GTX 680 dépasse aisément les Radeon HD 7970 et 7950, que la tessellation soit activée ou non. Par contre, nous sommes quelque peu inquiets de constater que la nouvelle carte de Nvidia voit ses performances chuter de 31 % lorsqu’on l’active, alors que celles des Radeon à base de puce Tahiti ne diminuent que de 16 % environ. Bien entendu, la tessellation n’est pas le seul élément des jeux à affecter les performances globales, mais il reste intéressant de constater que, dans les titres actuels, les affirmations de Nvidia ne se vérifient pas nécessairement.

Afin de ne pas brider le débit théoriquement plus élevé de son moteur de géométrie, Nvidia a également doublé le nombre de moteurs de rastérisation (ROP) par rapport au GF104 ; le ratio avec les partitions ROP est maintenant de 1 pour 1. Comme sur le GF104, chacun des ROP du GK104 est capable de générer huit pixels en nombres entiers de 32 bits par cycle (soit 32 pixels au total).

Mémoire

Les deux GPU ont aussi en commun un bus mémoire de 256 bits ; la différence se situe au niveau de la bande passante maximale. Peut-être en raison de son positionnement en milieu de gamme, la GeForce GTX 460 était équipée de 1 Go de GDDR5 cadencée à 900 MHz, ce qui lui conférait une bande passante de 115,2 Go/s. La GTX 680 doit toutefois remplacer la GTX 580, qui était dotée de GDDR5 cadencée à 1002 MHz sur un bus de 384 bits lui permettant de faire grimper le débit à 192,4 Go/s. La nouvelle venue est donc armée de 2 Go de GDDR5 fonctionnant à 1502 MHz, ce qui lui donne une bande passante très similaire : 192,26 Go/s.

GPU Boost

GPU Boost : quand 1 GHz ne suffit pas

Outre sa mémoire GDDR5 très rapide, la GeForce GTX 680 bénéficie d’un avantage assez significatif sur les précédentes générations de cartes Nvidia : son GPU est cadencé par défaut à 1006 MHz. La société affirme toutefois qu’il peut monter plus haut, et ce, sans dépasser son enveloppe thermique de 192 watts.

Le problème de cette fréquence par défaut plus élevée, c’est que la charge de travail diffère fondamentalement d’une application à l’autre. Nvidia garantit que la GeForce GTX 680 n’atteint jamais son plafond thermique à 1006 MHz, même dans les jeux les plus exigeants. Mais quid des titres moins gourmands en énergie ? Ne risquent-ils pas de ne pas profiter pleinement des performances de la carte ? C’est là qu’entre en scène le GPU Boost.

Lorsqu’il subsiste une marge dans l’enveloppe thermique de la carte, la fonction GPU Boost augmente automatiquement la fréquence et la tension de la carte afin de booster les performances. Le mécanisme est en fait assez similaire à celui utilisé par la technologie Turbo Boost d’Intel : le système, tant du côté matériel que logiciel, surveille une série de variables (consommation, température, taux d’utilisation des ressources, etc. ; Nvidia refuse de divulguer l’intégralité de la liste) et les transmet à un algorithme qui altère ensuite la fréquence du GPU. Le délai de réaction est d’environ 100 ms.

Comme vous pouvez l’imaginer, pour chaque variable mesurée, un certain nombre de facteurs entrent en jeu. Utilisez-vous votre carte en Antarctique ou au Saharah ? Votre GK104 a-t-il été découpé dans le centre du wafer ou sur son bord ? Jamais deux GeForce GTX 680 ne se comporteront exactement de la même manière. Il faut savoir que le GPU Boost n’est pas désactivable ; il est donc impossible d’isoler ses effets. Autre conséquence de taille : les fabricants de cartes vont devoir citer deux fréquences sur leurs emballages. La première sera la fréquence de base et la seconde sera la fréquence boostée (en réalité une moyenne obtenue en charge dans les titres qui n’atteignent pas le TDP de la carte). Pour la GeForce GTX 680, ce deuxième chiffre serait de 1058 MHz. Mais un petit graphique vaut mieux qu’un long discours :

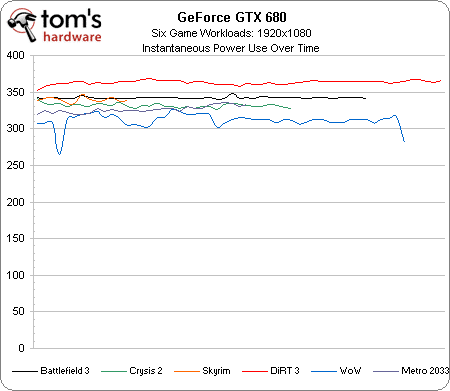

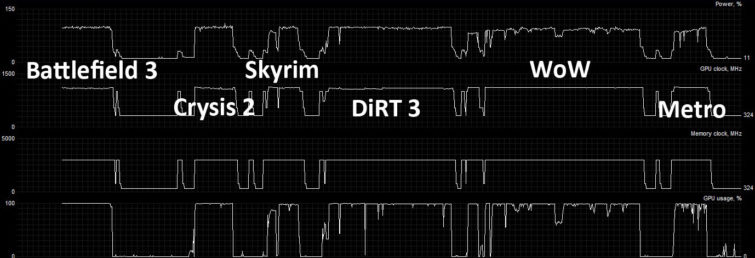

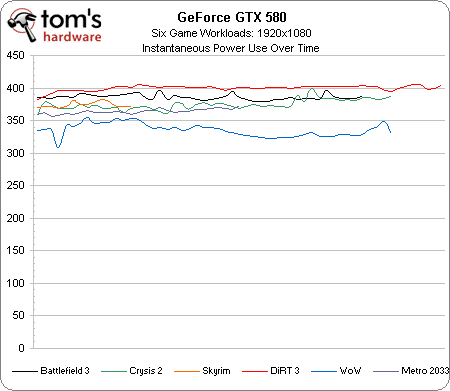

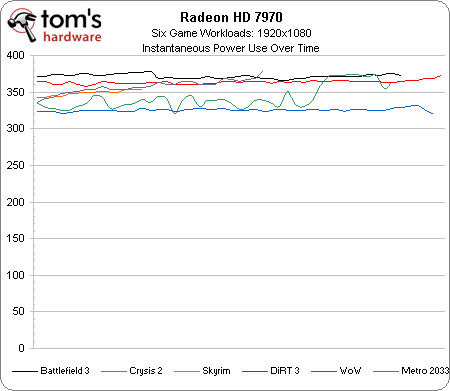

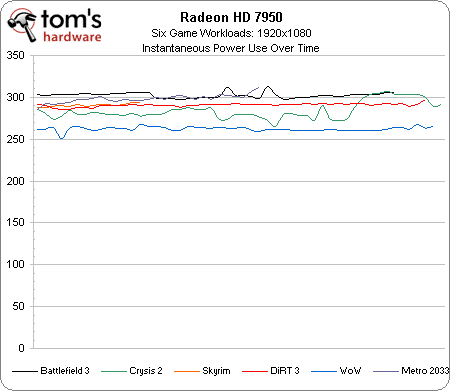

Ce graphique est le même que celui de la page consacrée aux performances par watt ; il représente la consommation instantanée de la carte dans six jeux s’exécutant en 1920 x 1080. Comme vous pouvez le voir, la consommation à la prise varie de 260 à 370 watts environ. En moyenne, la différence sera de l’ordre de 50 watts entre un titre limité par le processeur (Word of Warcraft, par exemple) et un autre plus gourmand en shaders (DiRT 3).

Au vu de ces chiffres de consommation, on pourrait s’attendre à ce que les jeux les plus gloutons en énergie atteignent le plafond de la GTX 680 tandis que les autres bénéficient d’une belle hausse de fréquence.

En réalité cependant, même les jeux les plus exigeants tels que DiRT 3 profitent d’une certain accélération. Sur le graphique ci-dessus, la première ligne indique la consommation de la carte (en pourcentage du maximum) ; il apparaît clairement que Word of Warcraft engendre pas mal de variations ; disposant d’une marge thermique importante, il se voit accorder la fréquence maximale autorisée par le TDP dans ces circonstances, à savoir 1110 MHz. Aussi surprenant que cela puisse paraître, Metro 2033 est également peu gourmand en énergie ; il bénéficie donc de la même fréquence. Crysis 2, DiRT 3 et même Battlefield 3 reçoivent eux aussi des hausses de fréquence, mais celles-ci sont un peu moins élevées et surtout moins stables.

En quoi le GPU Boost diffère-t-il du PowerTune d’AMD, que nous avions présenté dans notre présentation des Radeon HD 6970 et 6950 ? En résumé, le PowerTune ajoute des paliers entre le p-state le plus élevé du GPU et celui auquel la puce redescendrait en cas de dépassement du TDP. Un extrait de l’article en question :

« …grâce à PowerTune, au lieu de concevoir les Radeon HD 6xxx pour un scénario catastrophe hypothétique, AMD peut maintenant régler en usine une fréquence plus élevée qu’auparavant (880 MHz dans le cas de la HD 6970) et laisser à PowerTune le soin de diminuer les performances dans les applications qui l’auraient par le passé forcée à régler cette fréquence d’usine sur quelque chose comme, par exemple, 750 MHz. »

En d’autres termes, une carte graphique dotée de la fonction PowerTune peut être réglée en usine à une fréquence plus élevée qu’une carte conçue pour un scénario thermique moins favorable. C’est une très bonne chose, mais cela ne permet pas au GPU d’accélérer lorsqu’une marge thermique s’avère disponible.

AMD considère cela comme un point positif, car cela donne des performances stables. Évidemment, chacun aura un avis différent sur la question. En tant que testeurs, nous ne sommes effectivement pas très emballés par l’effet des incessantes variations de fréquence sur nos résultats de benchmarks ; cela ne nous empêche pas d’apprécier l’ingéniosité d’une technologie qui vise à maximiser de manière dynamique les performances au sein d’une enveloppe thermique donnée, mais qui permet également de ralentir la carte lorsqu’il n’y a rien (ou moins) à faire. Dans ce cas précis, il est évident que nos petits soucis doivent passer au second plan par rapport aux avantages potentiels que le GPU Boost peut apporter aux joueurs. Nous n’aurions toutefois pas craché sur la possibilité de désactiver cette fonction, ne serait-ce que pour mesurer les performances de base de la carte.

Overclocking

La mise en œuvre du GPU Boost ne signifie pas la fin de l’overclocking. Mais la fonction n’étant pas désactivable, l’opération est désormais quelque peu différente de ce à quoi vous êtes sans doute habitués.

Pour commencer, l’overclocking ne se fait désormais plus en valeur absolue, mais via une valeur (positive ou négative, dans le cas d’un underclocking) relative à la fréquence de base. Il est par exemple aisé d’augmenter la fréquence 3D de référence de 100, 150 voire 200 MHz ; cependant, si un jeu atteint déjà le plafond constitué par le TDP à la fréquence par défaut, il n’ira pas plus vite. À l’inverse, dans les applications qui n’atteignent normalement pas la limite thermique de la GTX 680, l’overclocking pousse la courbe des performances plus près du plafond en question.

Cependant, le GPU Boost ayant été conçu pour modifier les fréquences et les tensions en fonction de la marge thermique disponible, la manière la plus efficace de procéder à un overclocking est tout simplement de rehausser… le TDP ! L’utilitaire de paramétrage EVGA Precision X comprend une série de barres de réglage permettant d’ajuster le plafond de consommation et la valeur d’overclocking/underclocking de la fréquence du GPU.

D’après Nvidia, bien que le TDP de la GeForce GTX 680 soit de 195 watts, sa consommation typique est plutôt de l’ordre de 170 watts. La barre de réglage de Precision X permet en pratique de pousser la limite de consommation supérieure jusqu’aux 225 watts qu’autorisent l’emplacement PCI Express et les deux connecteurs d’alimentation auxiliaires à six broches.

En pratique

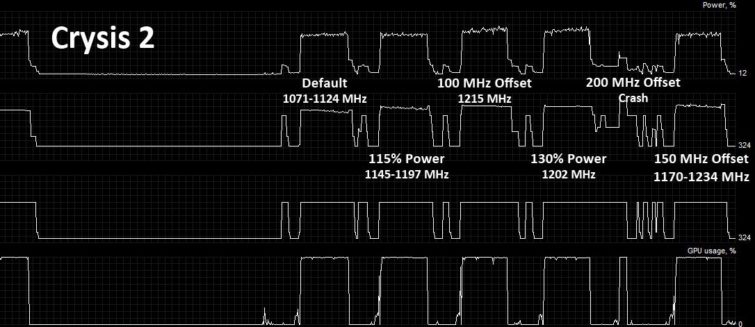

Pour mettre la théorie en pratique, nous avons eu recours à Crysis 2, le titre le plus stable de notre batterie de test.

Nous avons commencé par un benchmark du niveau Central Park en 1920 x 1080, en mode DirectX 11 et sans anti-aliasing. Le résultat est un framerate de 72,3 images/s et des fréquences boostées oscillant entre 1071 et 1124 MHz durant le test (rappelons que la fréquence de base est de 1006 MHz).

La ligne supérieure du graphique ci-dessus montre que nous atteignons régulièrement le plafond thermique du GK104. Nous avons donc ensuite rehaussé ce plafond de 15 %, ce qui nous a donné une légère augmentation du framerate (74,2 images/s) et des fréquences ballotant de 1145 à 1197 MHz.

Nous nous sommes alors dits que cette augmentation du TDP avait probablement dégagé une certaine marge thermique ; nous avons donc augmenté la fréquence de base de 100 MHz, ce qui a poussé le framerate à 76,1 images/s. Curieusement, la fréquence est restée bloquée à 1215 MHz. D’après Nvidia, il s’agit essentiellement de la fréquence maximale que la carte peut supporter dans ces circonstances (charge de travail et limite thermique).

Les limites de la technologie

Dans ce cas, pourquoi ne pas augmenter une fois de plus le TDP ? Curieusement, à 130 % dans Precision X (en gros, à 225 watts), les performances redescendent à 75,6 images/s et la fréquence reste coincée à 1202 MHz. Comment cela se fait-il ? C’est ici que le GPU Boost montre ses limites. Le résultat final dépend d’une série de facteurs qui sont surveillés en permanence, ce qui signifie que les performances évoluent avec le temps : en effet, le GPU chauffant de plus en plus, les fuites de courant augmentent et, en réaction, le système réduit automatiquement les fréquences et les tensions afin d’éviter d’entrer dans un cercle vicieux qui pourrait entraîner la mort de la carte.

C’est un peu comme avec une voiture : la puissance diminue si l’on n’attend pas assez longtemps entre les essais. À l’inverse, il est possible d’obtenir des performances élevées si l’on procède à des essais de quelques minutes bien espacés. Un GPU se comporte exactement de la même manière : si vous jouez pendant des heures, le GPU Boost est forcément moins efficace (mais c’est pour le bien de votre carte).

Notre tentative d’augmenter la fréquence de référence de 200 MHz montre bien que, même si cette technologie met tout en œuvre pour faire fonctionner le GPU à la fréquence la plus élevée possible dans les limites du TPD précisé, il reste encore possible de dépasser les capacités physiques de la carte et, par conséquent, de la pousser à se rétracter.

Nous sommes redescendus à +150 MHz et avons obtenus des performances stables, mais pas plus élevées qu’à +100 MHz. Il faudra donc encore chipoter un peu pour trouver le paramètre d’overclocking idéal, tout en gardant à l’esprit que le GPU Boost est toujours présent et activé.

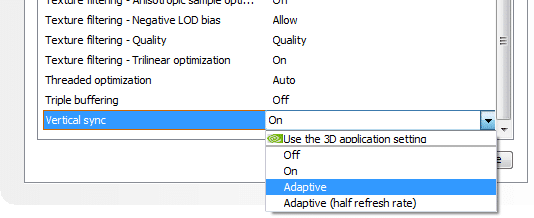

PCI Express 3.0 et synchronisation verticale adaptative

PCI Express 3.0 : un avantage supplémentaire

Comme l’immense majorité des cartes que nous avons testées ces sept ou huit dernières années, la GeForce GTX 680 est dotée d’une interface PCI Express à 16 lignes. Elle est néanmoins l’une des premières à faire appel à la troisième génération du bus en question (les six membres de la famille AMD Radeon HD 7000 l’ont prise de vitesse sur ce plan). Mais comme nous le savons déjà, il ne sert pas à grand-chose de doubler le débit d’une interface que les jeux actuels ne parviennent pas encore à saturer.

La prise en charge du PCI Express 3.0 crée toutefois une mini-polémique car le pilote que Nvidia a transmis à la presse le désactive sur les cartes-mères à base de chipset Intel X79. La position officielle de la firme est que la carte est effectivement compatible PCIe 3.0, mais que le X79 n’est validé que pour les débits PCIe 2.0. Par contre, mettez la carte dans une carte-mère avec processeur Ivy Bridge et vous bénéficierez immédiatement d’un taux de transfert de 8 GT/s.

Pour nous prouver que la GeForce GTX 680 fonctionne effectivement comme prévu, Nvidia nous a fait parvenir un pilote mis à jour, et de fait, le débit du cache est immédiatement passé à près de 12 Go/s. Si Nvidia valide un jour le X79, il suffira donc d’un nouveau pilote pour régler le problème. Curieusement, la bande passante PCIe des AMD Radeon HD 7900 semble avoir diminué par rapport à nos tests précédents ; ni AMD ni Gigabyte n’ont été en mesure de nous expliquer ce qui se passe.

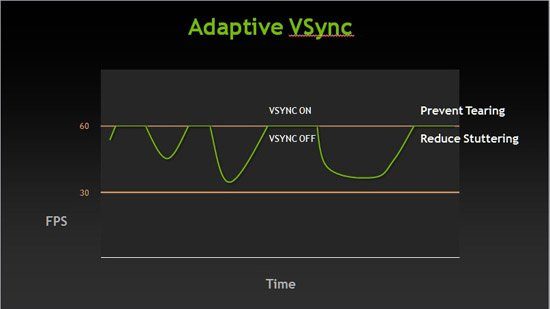

Adaptive V-Sync : la fluidité en toutes circonstances

Lorsque nous benchmarkons les jeux, nous cherchons toujours à désactiver la synchronisation verticale (v-sync), qui crée une synchronisation entre le taux de rafraîchissement de votre moniteur et le framerate de votre carte graphique. Si nous verrouillions le framerate à 60 images/s sur notre écran à 60 Hz, par exemple, nous ne pourrions faire état des performances réelles d’une carte graphique capable d’atteindre 90 ou 100 images/s. Dans la plupart des jeux, désactiver la synchronisation verticale est un jeu d’enfant, mais dans d’autres, nous devons ruser pour procéder à nos tests dans de bonnes conditions.

En situation réelle, par contre, il est conseillé d’activer la v-sync pour éviter le « tearing », cette distorsion visuelle qui se manifeste lorsque le framerate de la carte est supérieur au taux de rafraîchissement de l’écran et que, par conséquent, celui-ci affiche plus d’une image à la fois. Le tearing ennuie plus certains joueurs que d’autres, mais si vous possédez une carte graphique capable de vous maintenir au-dessus des 60 images/s (ou 65, 70 ou 75, selon le taux de rafraîchissement de votre écran), il n’y a pas vraiment de raison de ne pas activer la synchronisation verticale.

Les problèmes surviennent lorsque vous tombez sous les 60 images/s. Étant donné que la technologie synchronise le signal de sortie de la carte graphique (variable) avec le taux de rafraîchissement (fixe), tout framerate inférieur à 60 doit être ramené à un sous-multiple de 60 ; par exemple, si vous avez 47 images/s, le v-sync ramène ce chiffre à 30 images/s. La transition entre 60 et 30 se manifeste à l’écran par une légère perte de fluidité. Une fois encore, cela ennuie plus certaines personnes que d’autres, mais si vous savez où chercher, cela se remarque assez facilement.

Alors, cette v-sync, vaut-il mieux l’activer ou la désactiver ? La solution que Nvidia apporte à notre dilemme s’appelle Adaptive V-Sync. En pratique, tant que la carte génère plus de 60 images/s (sur un écran à 60 Hz, pour reprendre notre exemple), la synchronisation verticale reste activée. Lorsque le framerate tombe en-dessous de ce seuil, elle est automatiquement désactivée afin d’éviter les saccades. Dans le pilote 300.99 que la firme a fourni à la presse, l’Adaptive V-Sync se règle via un menu déroulant qui contient également les paramètres de synchronisation verticale traditionnelle.

D’après nos tests, ce qui nous a le plus gêné est le tearing constaté lorsque la v-sync est désactivée. Son activation nous a moins ennuyés. Pour être parfaitement honnêtement, cependant, nous devons bien reconnaître qu’il faut un titre aussi exigeant que Crysis 2 avec les détails à fond pour forcer la GeForce GTX 680 à passer ne serait-ce que semi-régulièrement sous le seuil des 60 images/s.

Dans l’ensemble, l’Adaptive V-Sync est une très bonne idée ; cette fonction sera sans doute plus utile sur les modèles moins haut de gamme, qui seront plus susceptibles de passer sous la limite correspondant au taux de rafraîchissement de l’écran.

Configuration de test et benchmarks

| Configuration de test | |

|---|---|

| Processeur | Intel Core i7-3960X (Sandy Bridge-E) 3,3 GHz overclocké à 4,2 GHz (42 x 100 MHz), LGA 2011, 15 Mo de cache L3 partagé, Hyper-Threading activé, fonctions d’économie d’énergie activées |

| Carte-mère | Gigabyte X79-UD5 (LGA 2011), chipset X79 Express, BIOS F9 |

| Mémoire | 16 Go (4 x 4 Go) de DDR3-1600 G.Skill, F3-12800CL9Q2-32GBZL @ 9-9-9-24 et 1,5 V |

| Stockage | Intel SSDSC2MH250A2 250 Go SATA 6 Gbit/s |

| Cartes graphiques | Nvidia GeForce GTX 680 2 Go |

| AMD Radeon HD 7970 3 Go | |

| AMD Radeon HD 7950 3 Go | |

| AMD Radeon HD 6990 4 Go | |

| Nvidia GeForce GTX 590 3 Go | |

| Nvidia GeForce GTX 580 1,5 Go | |

| Alimentation | Cooler Master UCP-1000 watts |

| OS et pilotes | |

| OS | Windows 7 Édition Intégrale 64 bits |

| DirectX | DirectX 11 |

| Pilotes graphiques | Nvidia GeForce 300.99 (pour la GTX 680) |

| Nvidia GeForce 296.10 (pour les GTX 580 et 590) | |

| AMD Catalyst 12.2 | |

| Jeux | |

|---|---|

| Battlefield 3 | Paramètres de qualité Ultra, AA désactivé / AF 16x ou MSAA 4x / AF 16x, vsync désactivé, 1680 x 1050 / 1920 x 1080 / 2560 x 1600, DirectX 11, Going Hunting, 90 secondes sous Fraps |

| Crysis 2 | DirectX 9 / DirectX 11, paramètres de qualité Ultra, v-sync désactivé, 1680 x 1050 / 1920 x 1080 / 2560 x 1600, AA désactivé / AF désactivé, Central Park, textures haute résolution : activées |

| Metro 2033 | Paramètres de qualité élevés, AAA / AF 4x ou MSAA 4x / AF 16x, 1680 x 1050 / 1920 x 1080 / 2560 x 1600, benchmark intégré, filtre Profondeur de champ désactivé, version Steam |

| DiRT 3 | Paramètres de qualité Ultra, AA désactivé / AF désactivé ou AA 8x / AF désactivé, 1680 x 1050 / 1920 x 1080 / 2560 x 1600, version Steam, benchmark intégré, DirectX 11 |

| The Elder Scrolls V: Skyrim | Paramètres de qualité Élevés (AA 8x / AF 8x) ou Ultra (AA 8x, AF 16x), FXAA activé, vsync désactivé, 1680 x 1050 / 1920 x 1080 / 2560 x 1600, 25 secondes sous Fraps |

| 3DMark 11 | Version 1.03, préréglage Extreme |

| HAWX 2 | Paramètres de qualité maximum, AA 8x, 1920 x 1200, version boîte, benchmark intégré, tessellation activée/désactivée |

| World of Warcraft: Cataclysm | Paramètres de qualité ultra élevés, AA désactivé / AF 16x ou AA 8x / AF 16x, From Crushblow to The Krazzworks, 1680 x 1050 / 1920 x 1080 / 2560 x 1600, FRAPS, rendu DirectX 11, client x64 |

| SiSoftware Sandra 2012 | Sandra Tech Support (Engineer) 2012.SP2, modules « GP Processing » et « GP Bandwidth » |

| CyberLink MediaEspresso 6.5 | Conversion d’un fichier vidéo MPEG-2 1080i de 449 Mo vers le profil Apple iPad 2 (1024 x 768) |

| LuxMark 2.0 | Exécutable 64 bits, version 1.0, scène « Classroom » |

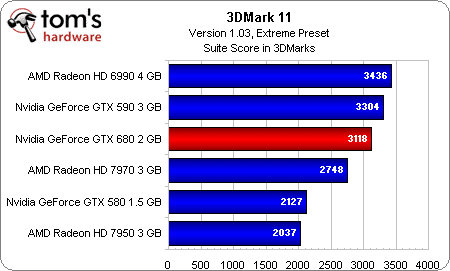

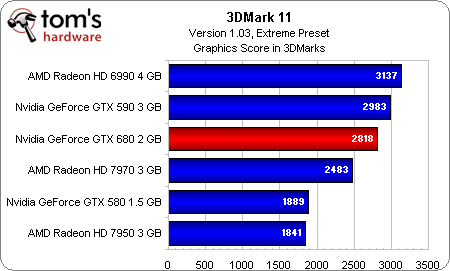

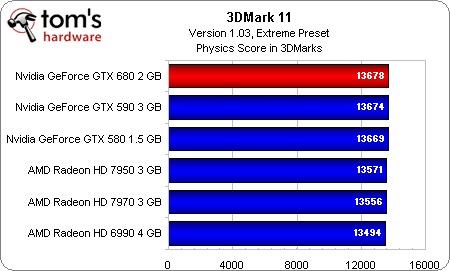

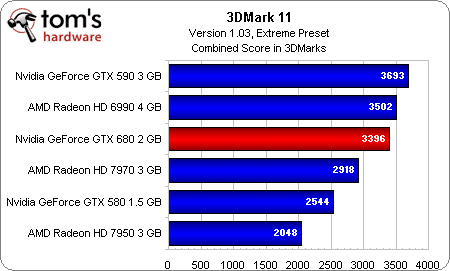

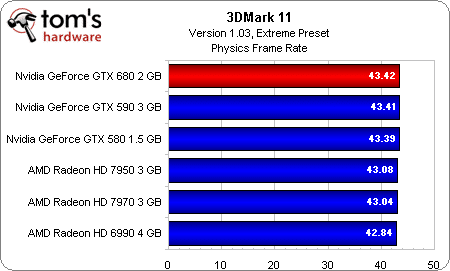

3DMark 11 (DX 11)

Score global

Bien que nous aimions commencer notre série de tests par le benchmark synthétique Futuremark 3DMark 11, nous savons pertinemment que celui-ci ne reflète pas toujours les performances des cartes évaluées en situation réelle, pour tout un tas de raisons différentes.

Il n’empêche que la GeForce GTX 680 n’est surpassée que par les deux cartes bi-GPU de notre classement, que nous ne continuons d’ailleurs à mentionner que pour le principe, car elles ne sont plus disponibles dans le commerce. La Radeon HD 7970 semble d’ores et déjà facilement battue.

Score graphique

Score physique

Score combiné

Framerate physique

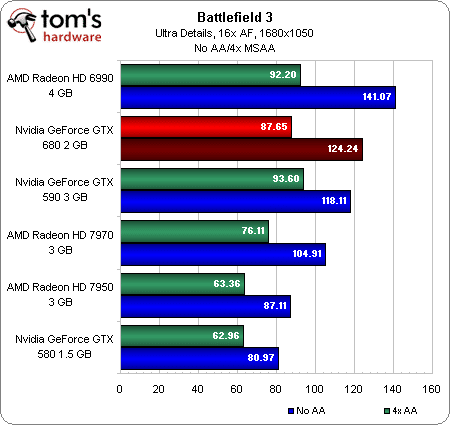

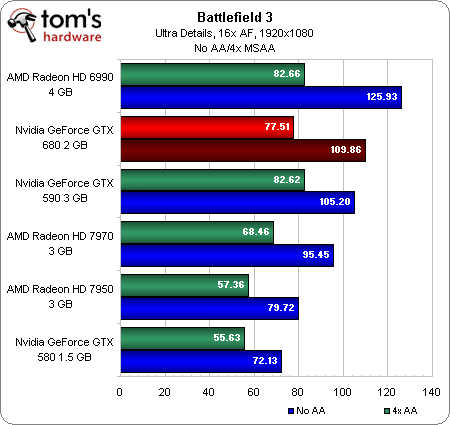

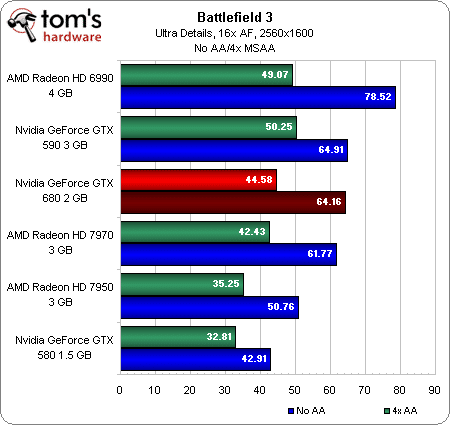

Battlefield 3 (DX 11)

1680 x 1050

1920 x 1080

2560 x 1600

Sous Battlefield 3 en 1680 x 1050 et 1920 x 1080, la Nvidia GeForce GTX 680 dépasse la GeForce GTX 590 lorsque l’anti-aliasing est désactivé ; l’AMD Radeon HD 6990 reste néanmoins la carte la plus rapide de toutes, avec ou sans le MSAA/FXAA 4x activé. La nouvelle carte Nvidia se démarque surtout de la Radeon HD 7970 à plus faible résolution ; en 2560 x 1600, l’écart est nettement plus minime.

Après notre article consacré au lancement des Radeon HD 7800, certains d’entre vous nous ont demandé de revenir aux paramètres de qualité Ultra, ce que nous avons fait cette fois-ci. Il est assez incroyable de constater que toutes les cartes présentées aujourd’hui parviennent à faire tourner ce jeu sans problème en 2560 x 1600 avec l’anti-aliasing désactivé (et probablement avec le FXAA activé) alors qu’il y a à peine un an, nous peinions à trouver un seul modèle capable de le faire fonctionner avec les détails au maximum (voir Battlefield 3 : quelles performances ?).

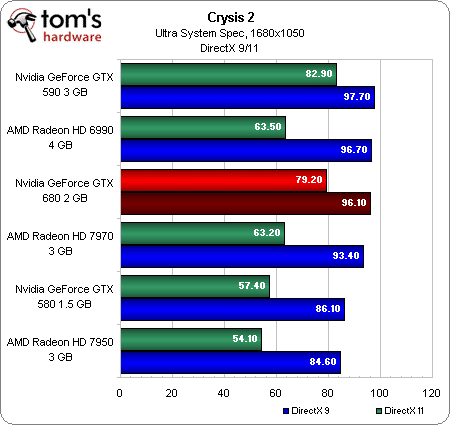

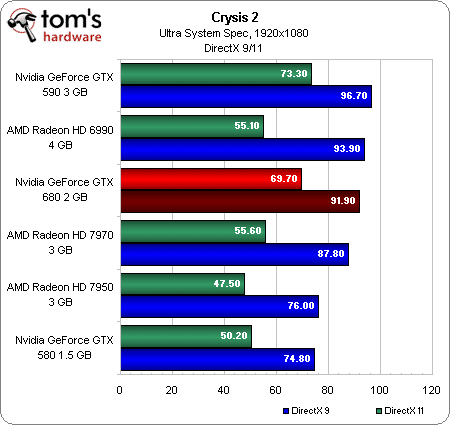

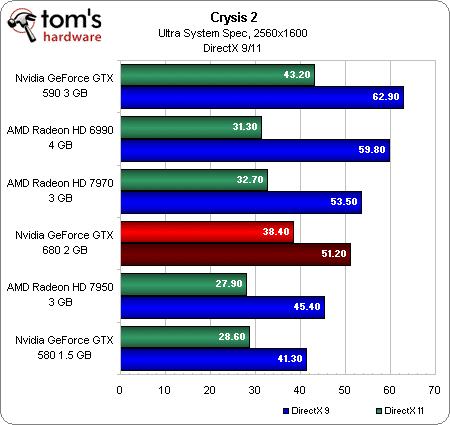

Crysis 2 (DX 9 / DX 11)

1680 x 1050

1920 x 1080

2560 x 1600

Sous Crysis 2 en mode DirectX 9, la GeForce GTX 680 fait mieux que la Radeon HD 7970 en 1680 x 1050 et 1920 x 1080, mais passe derrière celle-ci en 2560 x 1600. Si vous possédez une carte aussi haut de gamme, il est néanmoins plus probable que vous jouiez en mode DirectX 11, auquel cas la nouvelle carte de Nvidia occupe la deuxième place à tous les niveaux du classement, n’étant jamais dépassée que par la défunte GeForce GTX 590. Elle offre même un framerate jouable en 1920 x 1080.

Jusqu’il y a peu, les cartes AMD rencontraient de sérieux problèmes lors de nos tests sous Crysis 2 en mode DirectX 9. Fort heureusement, l’équipe chargée du développement des pilotes semble avoir mis les bouchées doubles pour régler les problèmes de jeunesse de la nouvelle architecture de la firme canadienne, GCN, au point que le mode DirectX 9 apparaît aujourd’hui comme l’une des forces d’AMD dans ce jeu ; à l’inverse, les performances en DirectX 11 semblent quelque peu en retrait par rapport à ce que nous avons constaté dans les autres benchmarks.

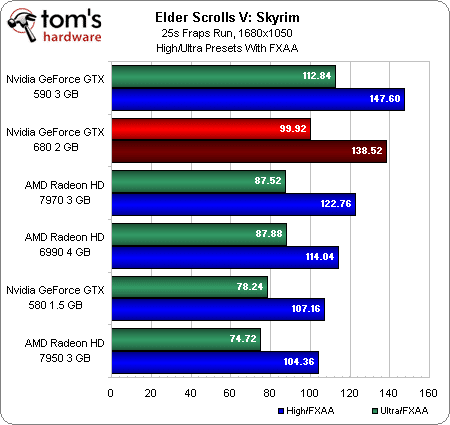

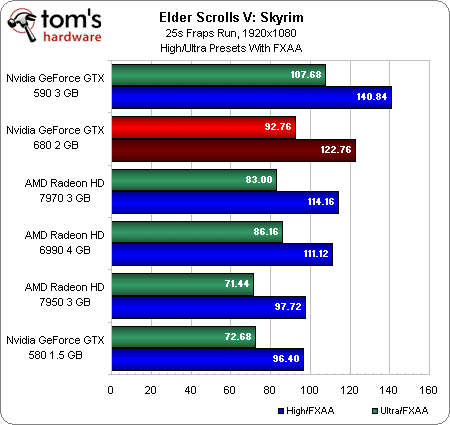

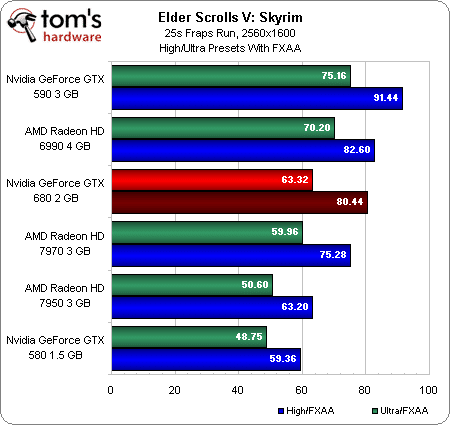

The Elder Scrolls V: Skyrim (DX 9)

1680 x 1050

1920 x 1080

2560 x 1600

La GeForce GTX 680 occupe la deuxième place du podium dans Skyrim en 1680 x 1050 et 1920 x 1080, mais toutes les cartes affichent des performances tellement satisfaisantes que cette victoire n’a pas grand sens.

Son framerate diminue un rien en 2560 x 1600, mais cela suffit pour que l’AMD Radeon HD 6990 la dépasse. N’oublions toutefois pas que la 6990 et la GTX 590 ne sont plus commercialisées, ce qui rend leurs performances purement symboliques.

Quoi qu’il en soit, la GeForce GTX 680 parvient à maintenir une certaine avance sur la Radeon HD 7970 dans les trois résolutions testées.

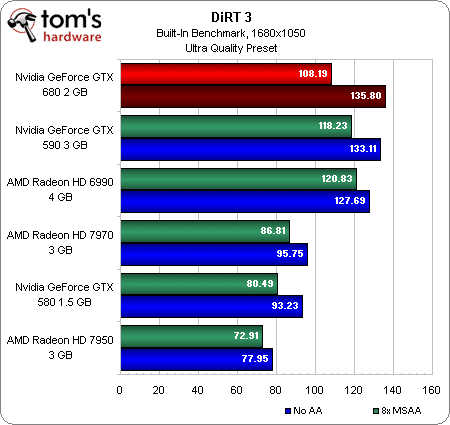

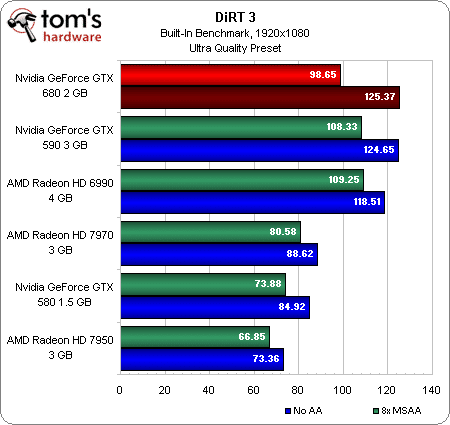

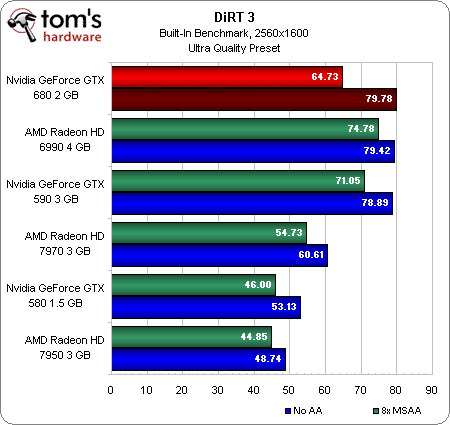

DiRT 3 (DX 11)

1680 x 1050

1920 x 1080

2560 x 1600

Lorsque le MSAA est désactivé, la GeForce GTX 680 parvient à battre les deux cartes bi-GPU dans toutes les résolutions testées sous DiRT 3. Activez le MSAA 8x et elle retombe toutefois derrière la Radeon HD 6990 et la GeForce GTX 590. Elle n’en reste pas moins la carte mono-GPU la plus rapide du marché actuel ; son framerate reste jouable jusqu’en 2560 x 1600.

Côté AMD, la Radeon HD 7970 n’a aucun problème à dépasser la GeForce GTX 580, ancienne championne de ce benchmark ; l’écart est particulièrement marqué en 2560 x 1600.

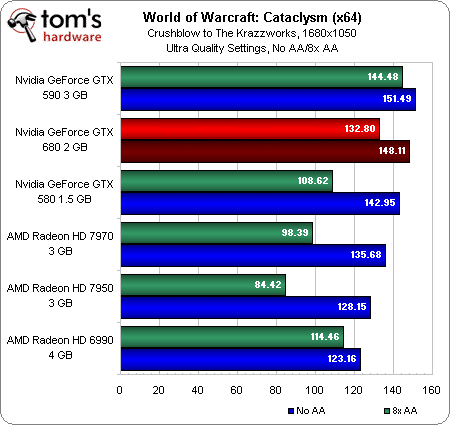

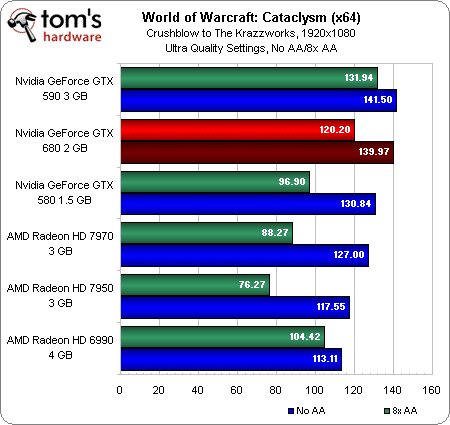

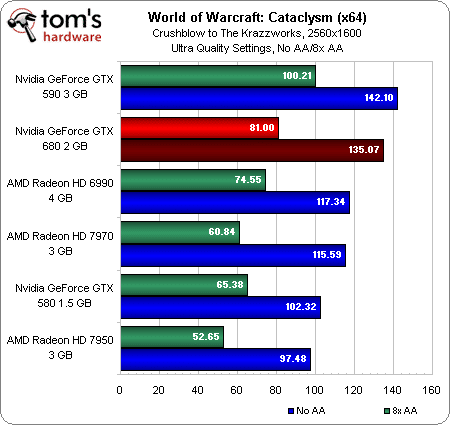

World Of Warcraft: Cataclysm (DX 11)

1680 x 1050

1920 x 1080

2560 x 1600

Certains d’entre vous nous ont demandé de benchmarker World of Warcraft avec le client 64 bits, qui est récemment passé en version 4.3.3. C’est donc ce que nous avons fait aujourd’hui.

Les cartes Nvidia ont tendance à se démarquer de leurs concurrentes dans WoW. Nous avions déjà remarqué cette tendance dans notre article World of Warcraft: Cataclysm, performances et qualité visuelle, et elle se perpétue encore aujourd’hui, plus d’un an plus tard, malgré un certain nombre de correctifs apportés au jeu et de révisions des pilotes. La GeForce GTX 590 occupe systématiquement la première place, suivie de près par la GeForce GTX 680 et la GTX 580.

Avez-vous remarqué la Radeon HD 6990 au bas du classement dans les deux résolutions les plus faibles ? Il convient de noter que, alors qu’elle termine bonne dernière lorsque l’anti-aliasing est désactivé, elle voit ses performances rester presque inchangées lorsqu’on active le MSAA 8x. En effet, WoW est essentiellement limité par les performances du processeur ; or le CrossFire d’AMD nécessite plus de puissance CPU que le SLI de Nvidia. C’est pour cette raison que la carte bi-GPU d’AMD est autant à la traîne mais ne souffre pratiquement pas de l’activation de l’anti-aliasing.

Bien entendu, lorsque nous passons en 2560 x 1600, la charge graphique devient telle que la 6990 fait un énorme bon et remonte à la troisième place, devant la GTX 680.

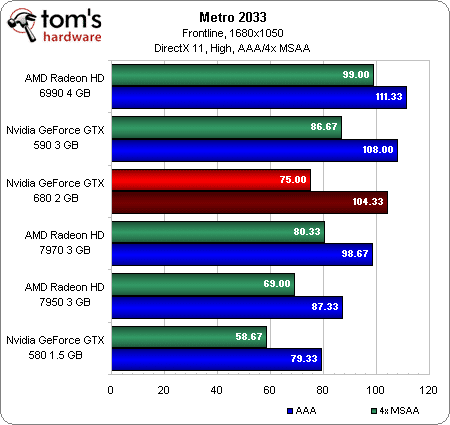

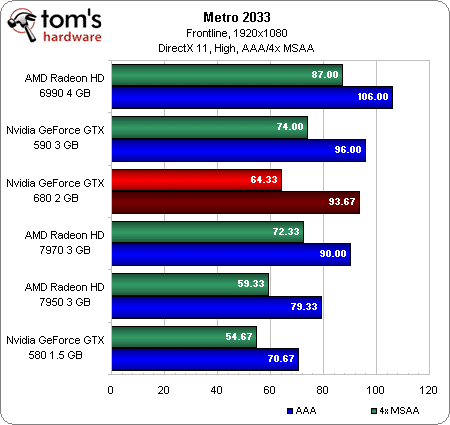

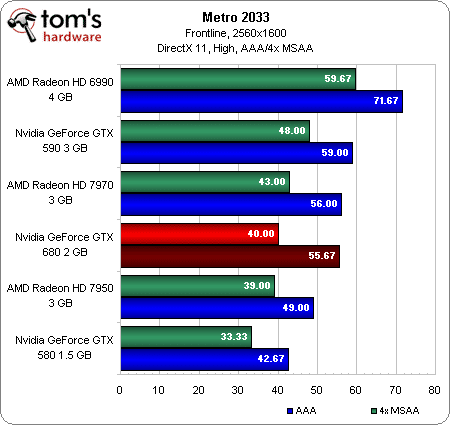

Metro 2033 (DX 11)

1680 x 1050

1920 x 1080

2560 x 1600

L’un des avantages lorsqu’on teste des cartes haut de gamme, c’est que cela nous permet de passer les détails sur Élevés dans Metro 2033. Notez qu’il reste, aujourd’hui encore, très difficile d’obtenir un framerate systématiquement jouable avec les détails réglés sur Très élevés ; quant au filtre de profondeur de champ basé sur DirectCompute, nous n’osons tout simplement pas l’activer, de peur de mettre nos machines à genoux…

Bref. À moindre résolution et avec l’Adaptive Anti-Aliasing activé, la GeForce GTX 680 démarre sur les chapeaux de roue, terminant juste derrière la Radeon HD 6990 et la GeForce GTX 590. Avec le MSAA 4x activé, par contre, elle se fait dépasser par l’AMD Radeon HD 7970.

Lorsque nous passons en 2560 x 1600, le fleuron mono-GPU d’AMD affiche des performances plus élevées quel que soit le type d’anti-aliasing utilisé, tandis que la Radeon HD 7950 parvient presque à faire jeu égal avec la nouvelle venue en MSAA 4x.

Pensiez-vous un jour voir la GeForce GTX 580 terminer bonne dernière d’un classement de six cartes haut de gamme ? Nous y sommes aujourd’hui.

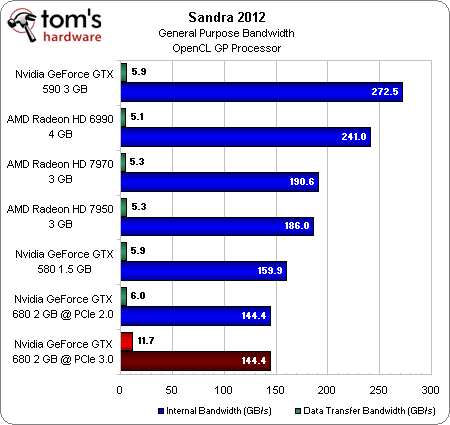

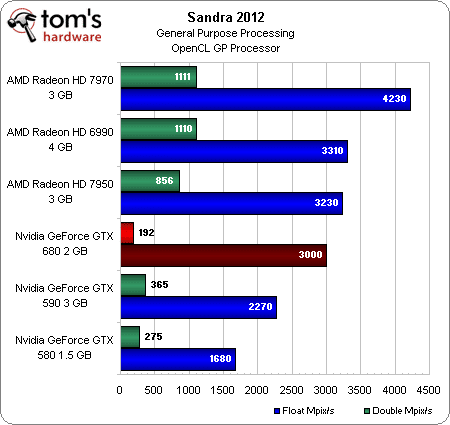

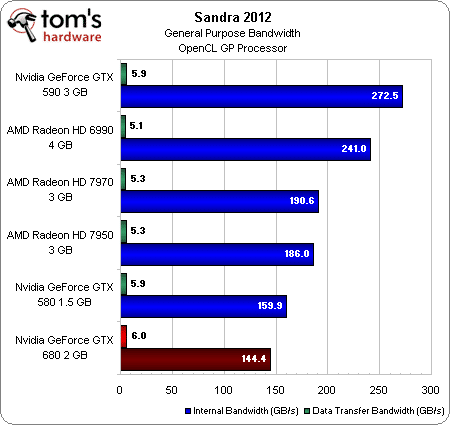

Sandra 2012

Performances GPGPU

Si vous cherchez la preuve que le GK104 a été conçu dès le départ pour remplir le rôle à l’époque confié à la GeForce GTX 460, à savoir celui du « chasseur », n’allez pas plus loin que le benchmark sous Sandra 2012.

Bien que le nombre de shaders accrus de la nouvelle puce ait une incidence positive sur les calculs en virgule flottante sur 32 bits et lui permette d’afficher en la matière des performances nettement supérieures à celles de la GeForce GTX 590, elle est loin de faire jeu égal avec les AMD Radeon HD 7950, 7970 et 6990.

Qui plus est, Nvidia limite les calculs en double précision sur 64 bits à 1/24e des calculs en simple précision afin d’éviter de cannibaliser ses cartes plus orientées GPGPU. Au final, cela signifie que la GeForce GTX 680 fait moins bien dans ce domaine que les GeForce GTX 590 et 580, et considérablement moins bien que les trois nouvelles cartes d’AMD.

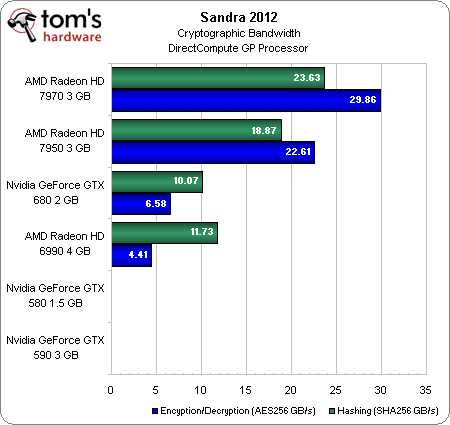

Cryptographie

L’architecture GCN d’AMD domine ce benchmark, au point de former une catégorie entièrement distincte de celle occupée par la GeForce GTX 680 et la Radeon HD 6990, qui se valent plus ou moins en comparaison.

Notons qu’avec les derniers pilotes Nvidia (296.10) comme avec plusieurs versions plus anciennes, les GeForce GTX 590 et 580 ne parviennent pas à mener à bien ce test, que ce soit en OpenCL ou en DirectCompute.

Bande passante GPGPU

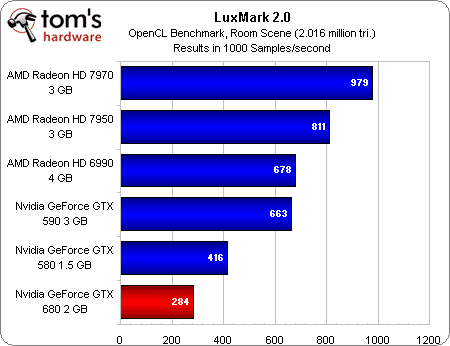

GPGPU : LuxMark 2.0

Pour sa génération de produits précédente, Nvidia accordait autant d’importance aux performances GPGPU qu’à celles dans les jeux ; à tout le moins en ce qui concerne son GPU haut de gamme, qui équipait à la fois les cartes Quadro et la GeForce GTX 480.

Cette fois-ci, lors de la conférence de presse annonçant le lancement de la GeForce GTX 680, la firme a tout bonnement refusé d’aborder la thématique du calcul GPGPU, arguant qu’elle avait été vivement critiquée pouvoir avoir « poussé » le sujet lors de la promotion de l’architecture Fermi et qu’elle n’avait plus l’intention de faire la même erreur.

En réalité, Nvidia n’a pas l’intention d’aborder le sujet… pour l’instant. Comme nous l’a montré le benchmark sous Sandra 2012, la GeForce GTX 680 est à la traîne des AMD Radeon HD 7900 en calcul 32 bits et se fait littéralement démolir en calcul en virgule flottante sur 64 bits ; la firme au caméléon a visiblement décidé de protéger sa gamme de cartes graphiques professionnelles en bridant les performances de ses cartes pour joueurs en la matière.

Performances OpenCL (LuxMark)

Il n’est donc pas surprenant de constater que la GeForce GTX 680 termine loin derrière la concurrence dans le benchmark LuxMark 2.0, basé sur OpenCL.

À titre de comparaison, la puce GF110 qui équipe les GeForce GTX 580 et 590 est plus adaptée aux calculs génériques ; Nvidia préfèrerait toutefois vendre à ses clients professionnels une carte Quadro ou Tesla. Nous pourrions contre-argumenter en disant qu’une AMD Radeon HD 7900 constitue, sur ce plan du moins, une alternative parfaitement viable (et nettement moins chère).

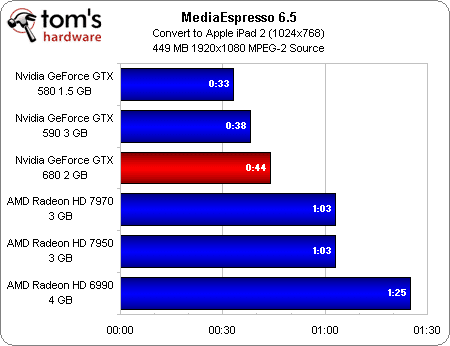

NVEnc et MediaEspresso 6.5

Le jour où Intel a présenté Quick Sync, « l’arme secrète » de ses processeurs Sandy Bridge, nous avons estimé qu’il faudrait à AMD et Nvidia environ un an pour passer de la conversion vidéo CUDA et APP à un pipeline plus ciblé, à fonction unique, capable d’afficher des performances dignes de ce nom conjuguées à une consommation moindre.

De fait, AMD a présenté sa solution, nommée Video Codec Engine, presque exactement un an après la sortie de notre article consacré au lancement des Sandy Bridge. Malheureusement, la partie logicielle de celle-ci (c’est-à-dire les pilotes) n’était pas prête pour le lancement de la Radeon HD 7970, ni d’ailleurs pour celui de la 7950. Quelque semaines plus tard, elle n’était toujours pas fonctionnelle pour la présentation des Radeon HD 7770 et 7750. Et il y a peu, à l’aube du lancement des Radeon HD 7870 et 7850, on nous a demandé de patienter encore un peu.

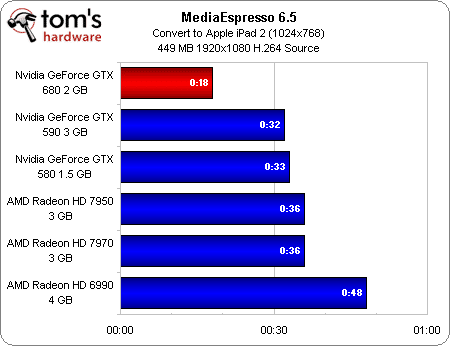

Aujourd’hui c’est au tour de Nvidia d’annoncer sa réponse au Quick Sync. La GeForce GTX 680 est dotée d’une fonctionnalité dénommée NVEnc, théoriquement capable de gérer une série de codecs en entrée et de décoder, prétraiter et réencoder du contenu de type H.264.

L’Intel Quick Sync gère le MPEG-2, le VC-1 et le H.264 en entrée et le MPEG-2 et le H.264 en sortie. Nvidia ne précise pas de format compatible en entrée, mais nous savons que le NVEnc est limité au H.264 en sortie. Par contre, alors que le moteur d’Intel plafonne à 1080p en entrée comme en sortie, celui de la firme au caméléon est censé gérer les résolutions grimpant jusqu’à 4096 x 4096.

Comme le Quick Sync, le NVEnc passe actuellement par une API propriétaire ; Nvidia prévoit toutefois d’y fournir l’accès via CUDA.

La firme nous a permis d’accéder à une version béta de CyberLink MediaEspresso 6.5 gérant sa fonctionnalité d’accélération matérielle de l’encodage/décodage vidéo.

MediaEspresso MPEG-2

Notre test standard pour MediaEspresso consiste à convertir un fichier MPEG-2 de près de 500 Mo en un film H.264 lisible sur iPad 2. Nous l’avons lancé à plusieurs reprises et avons, à notre surprise, constaté que la GeForce GTX 680 était moins performante que les GTX 580 et 590. C’est alors que la société nous a informés que ses pilotes souffraient d’un bug affectant les performances de la conversion du MPEG-2.

MediaEspresso H.264

Nous avons alors réessayé avec la bande-annonce de The Assault, encodée en H.264. Le moteur NVEnc a alors fait toute la différence et a divisé le temps de conversion par deux par rapport aux deux autres cartes Nvidia.

Il convient de mentionner que, alors nous avions précédemment eu de grosses difficultés à faire fonctionner l’accélération matérielle de la conversion sous MediaEspresso avec les cartes AMD, il semble que les derniers pilotes et les dernières versions du logiciel de CyberLink règlent le problème. Les performances, cependant, restent relativement modestes. Alors que les nouvelles Radeon HD 7900 parviennent presque à se hisser au niveau des cartes Nvidia de génération précédente dans les conversions H.264 vers H.264, les opérations MPEG-2 vers H.264 sont nettement moins impressionnantes. Et dans les deux cas, la Radeon HD 6990 s’enlise.

Il faut néanmoins concéder que, pour autant que nous sachions, le Video Codec Engine d’AMD n’est pas encore fonctionnel et qu’il y a de fortes chances pour que ce moteur, annoncé à la fin de l’année dernière, puisse remettre dans la course les nouvelles cartes de la firme canadienne. Malheureusement, le fait que nous soyons encore en train d’attendre des pilotes en état de marche près de quatre mois plus tard n’augure rien de bon.

Température et bruit

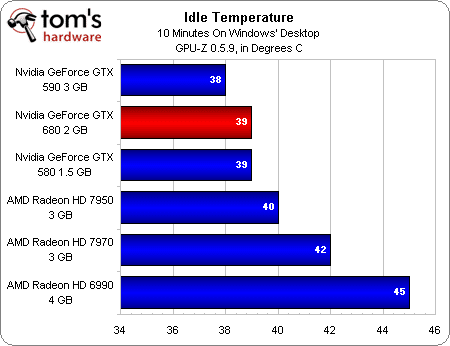

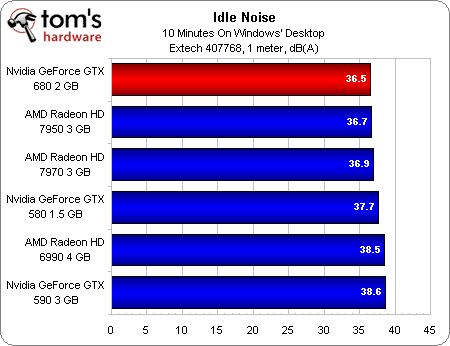

Température et bruit au repos

Il y a deux ans, lorsque Nvidia a lancé son architecture Fermi avec la GeFroce GTX 480, les critiques ont fusé concernant la consommation et la dissipation thermique catastrophiques des cartes. La société a alors tout mis en œuvre pour améliorer ses systèmes de refroidissement, une entreprise qui a culminé avec le lancement de la GeForce GTX 580, une carte mono-GPU haut de gamme qui savait se faire discrète, même en charge.

Quelques trucs d’ingénieurs et la gravure en 28 nm semblent aujourd’hui encore s’avérer payants : au repos, la GeForce GTX 680 est la plus silencieuse de toutes les cartes graphiques haut de gamme examinées aujourd’hui. Et elle ne semble même pas avoir besoin d’un flux d’air particulièrement important pour rester fraîche : seule la GeForce GTX 590 affiche une température moins élevée après 10 minutes à ne rien faire sur le bureau de Windows.

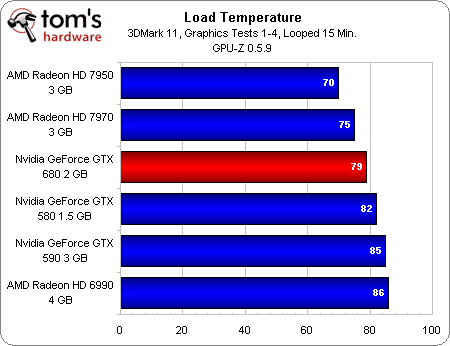

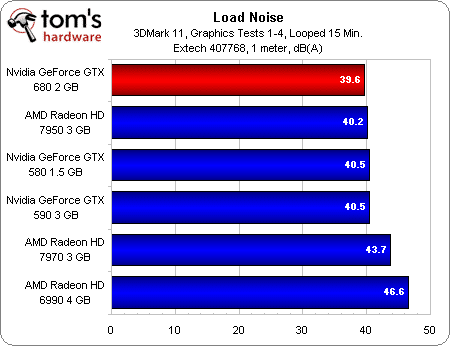

Température et bruit en charge

Le comportement des cartes en charge est toutefois plus révélateur que celui au repos. C’est ici que la GeForce GTX 680 nous impressionne réellement : elle obtient la meilleure note du lot en matière de nuisances sonores.

Mieux encore : bien qu’il soit silencieux, le ventirad de la carte garde le contrôle des températures. Certes, les AMD Radeon HD 7950 et 7970 font montre d’une dissipation thermique inférieure, mais la GTX 680 parvient à faire mieux que les deux autres cartes Nvidia testées aujourd’hui.

Consommation

Consommation au repos

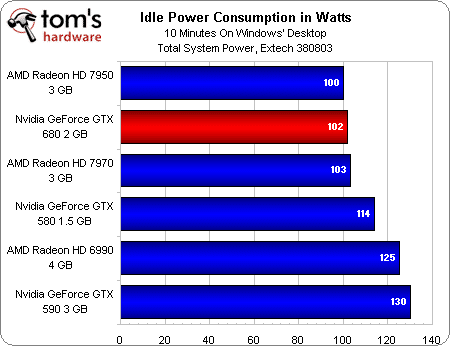

À mi-chemin entre la Radeon HD 7970 et la 7950, la consommation au repos de la GeForce GTX 680 est impressionnante.

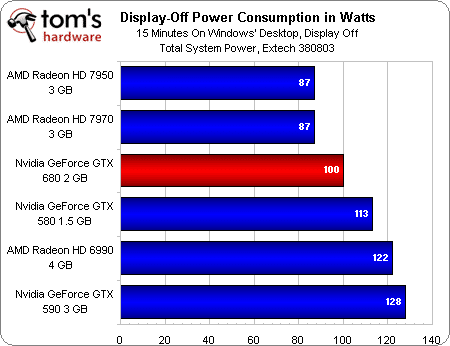

Consommation au repos, écran éteint

Malheureusement, Nvidia n’a pas mis en place d’équivalent à la technologie ZeroCore d’AMD, qui entre en jeu lorsque notre plate-forme de test éteint son écran. Alors que les deux Radeon HD 7900 voient encore leur consommation diminuer de 13 à 16 watts, celle de la GeForce GTX 680 ne descend que de deux. Il ne fait aucun doute qu’AMD détient ici l’avantage.

Consommation en charge

C’est ici que les choses deviennent réellement intéressantes.

Comme nous l’avons vu à plusieurs reprises dans les benchmarks, la GeForce GTX 680 affiche parfois des performances proches de celles de la GTX 590 et de la Radeon HD 6990 ; elle les dépasse même dans un titre comme DiRT 3. Mais la différence en termes de consommation est choquante.

La GeForce GTX 590, bien que chauffant relativement peu et étant assez silencieuse, est une horrible gloutonne. La Radeon HD 6990, bruyante et mal refroidie, s’en tire un peu mieux sur le plan de la consommation, mais reste tout de même loin d’être un exemple dans ce domaine.

Il faut passer en revue les cartes mono-GPU pour que la situation devienne acceptable. Au final, la GeForce GTX 680 se situe quelque part entre l’AMD Radeon HD 7970 et la 7950, deux cartes qui offrent des performances par watts nettement supérieures à celles de la précédente tenante du titre, la GeForce GTX 580.

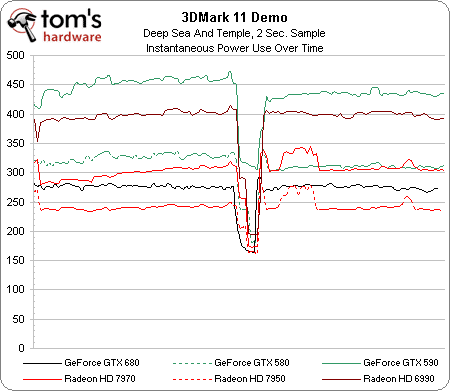

L’intérêt de la démo 3DMark est de faire passer nos cartes par deux charges de travail différentes. Contrairement aux autres cartes, la GTX 680 affiche une consommation instantanée relativement linéaire, ce qui semble démontrer que le GPU Boost ajuste continuellement les fréquences et les tensions afin de respecter, mais aussi d’utiliser au mieux, l’enveloppe thermique disponible.

Ces informations, certes intéressantes en théorie, ne nous disent toutefois pas grand-chose sur les performances par watt. Nous allons donc aborder le problème sous un angle différent…

Performances par watt

AMD et Nvidia affirment tous deux offrir des performances par watts sans précédent ; d’après nous, les deux sociétés disent la vérité.

Partant du principe qu’il n’existe pas deux charges de travail identiques, Nvidia va toutefois plus loin qu’AMD en permettant à sa carte d’ajuster ses fréquences et ses tensions en temps réel. Nous ne pouvons donc pas nous contenter de tester un jeu et de diviser son framerate moyen par sa consommation moyenne puis nous attendre à ce que vous croyiez que le résultat sera représentatif de tous les autres jeux. Malheureusement, nous n’avons pas non plus le temps de tester tous les jeux à toutes les résolutions (car oui, la consommation change en fonction de la résolution, du niveau de détails, etc.). Par conséquent, nous avons pris les jeux de notre panoplie de test, les avons tous réglés sur 1920 x 1080 et sur le niveau de détail le plus élevé possible, puis avons mesuré la consommation de chacune des six cartes.

Graphiques de consommation

Le résultat est un peu confus au début mais s’améliore par la suite. Dans un premier temps, nous avons quatre graphiques différents indiquant la consommation instantanée des cartes dans six jeux. Nous avons aussi les données concernant la GeForce GTX 590 et la Radeon HD 6990, mais les graphiques sont tellement… déformés que nous avons décidé de ne pas les publier.

Peu importe si certains tests se terminent avant les autres : ce qui compte, c’est que nous avons mesuré la consommation ainsi que les performances affichées durant chaque test. Les quatre graphiques ci-dessus montrent simplement les limites supérieures et inférieures de la consommation à la prise engendrée par chaque titre ; ils montrent également qu’aucun jeu n’est pareil aux autres.

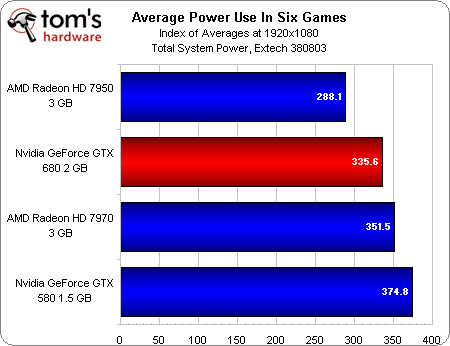

Consommation moyenne dans les six jeux

En faisant la moyenne de tous les jeux, on obtient les chiffres de consommation moyenne de chaque carte. La Radeon HD 7950 arrive en tête du classement, suivie de la GeForce GTX 680.

Nous savons déjà que la Radeon HD 7970 est une carte graphique plus rapide que la GeForce GTX 580 ; sachant qu’elle consomme également moins, nous pouvons donc conclure qu’elle est plus efficace sans même avoir besoin du graphique suivant.

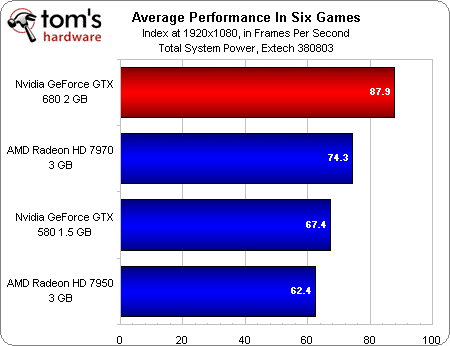

Performances moyennes dans les six jeux

En faisant la moyenne du framerate de chaque carte dans les six jeux en 1920 x 1080, nous obtenons un autre index, gradué en images par seconde. La GeForce GTX 680 termine aisément en première position, suivie de la Radeon HD 7970. La GeForce GTX 580 prend la troisième place, et la Radeon HD 7950 ferme la marche, un petit rien derrière.

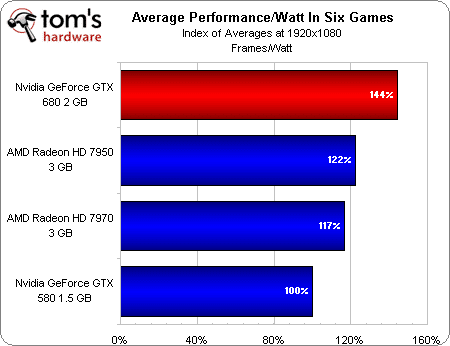

Rapport performances/watt dans les six jeux

MAJ 23/03 : Le graphe d’origine sur cette page plaçait la GeForce GTX 680 à 172 % des performances de la GTX 580. Il s’agissait d’une erreur de calcul, la bonne valeur étant de 144 %.

Notre référence est la GeForce GTX 580 et notre objectif est de déterminer comment s’en sortent les nouvelles architectures d’AMD et de Nvidia en comparaison. Par conséquent, nous avons pris la GTX 580 comme point de repère à 100 % ; les autres résultats parlent d’eux-mêmes.

Le constat est on ne peut plus clair : certes, les Radeon HD 7970 et 7950 offrent bien plus de performances par watt que la GeForce GTX 580, mais la GTX 680 écrase littéralement la concurrence.

En tant que joueur, quel intérêt accorder à un tel résultat ? Pas autant qu’aux performances absolues, nous n’en doutons pas. Mais à l’heure où AMD et Nvidia rivalisent d’ingéniosité pour accroître le rendement de leurs nouveaux produits, l’exercice reste parlant.

Conclusion

Il arrive parfois que, lorsqu’un fabricant lance une nouvelle carte, nous devions réellement nous concentrer pour décider si les gains en performances et les fonctionnalités justifient le prix. Il ne s’agit pas d’une science exacte et la réponse n’est pas toujours évidente.

Ce n’est pas du tout ce qui se passe aujourd’hui.

La GeForce GTX 680 est désormais la carte mono-GPU la plus rapide au monde, et l’écart qu’elle a creusé par rapport à la concurrence ne laisse aucune place à l’interprétation. Histoire de compliquer encore plus les choses pour AMD, Nvidia a décidé de commercialiser sa nouvelle carte à un prix très proche de celui de la Radeon HD 7970. Pour autant que les vendeurs respectent le prix public recommandé, le Canadien va donc devoir diminuer considérablement le prix de ses deux 7900 pour revenir dans la course. Selon nous, la 7970 devrait descendre de près d’une centaine d’euros et la 7950 d’une cinquantaine, ce qui laisserait encore une certaine marge par rapport à la 7870.

Tout indique que la GeForce GTX 680 va parfaitement remplir son rôle de « chasseur » dans la nouvelle gamme Nvidia. Misant tout sur le jeu, la carte a certes dû sacrifier les performances en calcul généraliste, comme la GTX 460 à son époque. Mais elle a tout pour plaire aux joueurs, tant elle s’avère concurrentielle face aux modèles haut de gamme d’AMD. Il est clair que le GK104 ne suivra pas le même chemin que le GF104.

Qu’on ne s’y trompe pas : l’AMD Radeon HD 7970 affiche des framerates supérieurs à ceux du précédent fleuron de la gamme Nvidia, la GeForce GTX 580, tout en consommant moins ; c’est la recette miracle pour obtenir un rapport performances/watts hors pair. Hors pair, jusqu’au moment où débarque la GTX 680, dont les performances font pâlir toutes les autres cartes mono-GPU du marché, mais qui se contente de deux connecteurs d’alimentation auxiliaires à six broches. Nous ne pouvons tout à fait corroborer les dires de Nvidia, qui affirme avoir doublé les performances par watts par rapport à l’architecture Fermi, mais les données que nous avons collectées semblent indiquer une augmentation de l’ordre de 44 %, ce qui reste énorme !

Au vu des performances qu’elle affiche dans nos benchmarks, de sa consommation, de ses fonctionnalités et de son prix concurrentiel, la GeForce GTX 680 est sans nul doute une meilleure carte graphique que la Radeon HD 7970. Et n’oublions pas que, pour la première fois dans l’histoire de Nvidia, elle gère plus de deux sorties écrans simultanées. Bref, c’est la carte idéale pour les joueurs.

Pour autant que l’on soit prêt à dépenser 500 € pour se l’offrir. Les joueurs dont le budget est plus limité feront en effet mieux de se tourner vers la Radeon HD 7870, qu’AMD a lancée en début de mois et que l’on commence à trouver en magasin. Vendue aux alentours de 350 €, elle constitue selon nous une solution plus équilibrée que les deux 7900, affiche des performances comparables à celles de la GeForce GTX 580 et est particulièrement peu gourmande en électricité. Bref, il ne faudrait pas que la GeForce GTX 680, malgré ses nombreuses qualités, vous fasse oublier qu’il existe aussi du matériel bien plus accessible. La carte Kepler est excellente, mais elle est également chère.

Pour terminer du côté des bonnes nouvelles, par contre, elle devrait être disponible le jour du lancement, et ce, à un prix proche de celui annoncé par Nvidia. Peu avant la levée du NDA, Newegg a en effet publié brièvement (« par erreur ») une page annonçant la GeForce GTX 680 pour environ 500 $. Reste à voir si (et quand) AMD baissera ses prix en réaction…