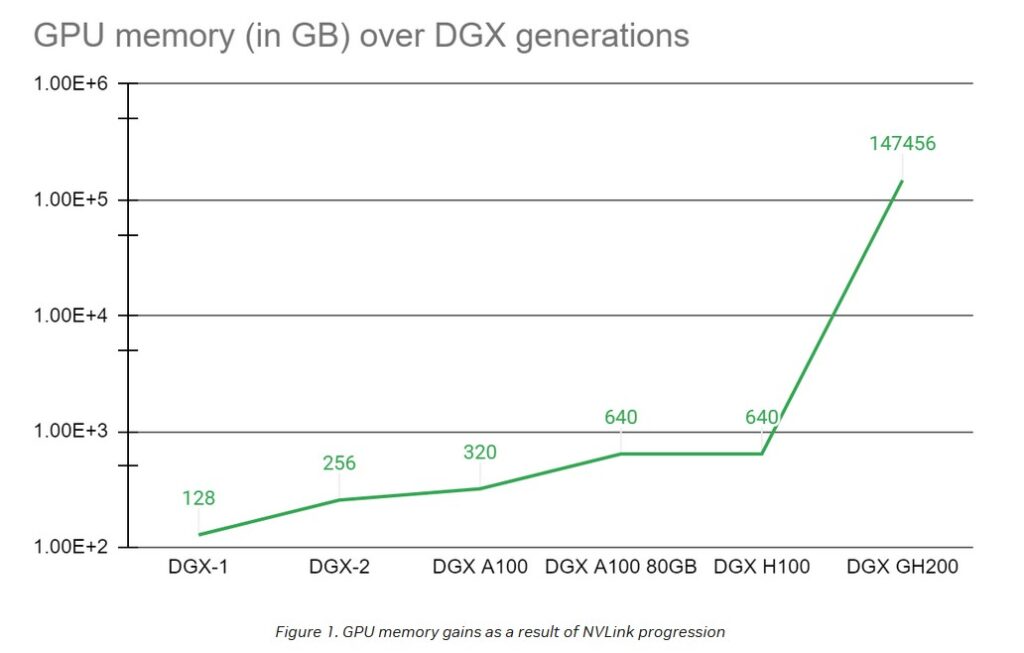

L’entreprise a présenté ses DGX H200 AI : près de 500 fois plus de mémoire que la génération précédente (NVIDIA DGX A100), et une architecture qui offre une bande passante NVLink 48 fois supérieure.

À l’occasion du Computex 2023, Jensen Huang, PDG de NVIDIA, a fait de nombreuses annonces lors d’une présentation de plus de deux heures (que vous pouvez voir ou revoir ci-dessous). Les principales sont le lancement de la nouvelle plateforme DGX GH200 AI, le début de la production de masse des Grace CPU Superchip et Grace Hopper Superchip, ainsi qu’un modèle AI baptisé ACE for Games.

Nous évoquerons les deux premiers sujets dans cet article ; l’ACE for Games sera traité dans une autre actualité.

À lire > Bientôt des CPU et GPU consommant 600 W et 700 W pour les centres de données

Production de masse des Grace Hopper Superchip et Grace CPU Superchip

Présentés en mars 2022, les Grace Hopper Superchip et Grace CPU Superchip entrent désormais en production de masse. Le processeur Grace est le CPU Arm de NVIDIA ; le Grace Hopper Superchip est une puce à 200 milliards de transistors combinant un processeur Grace à 72 cœurs, un GPU Hopper H100, 96 Go de HBM3 et 512 Go de LPPD5X.

Le GPU et le GPU communiquent grâce à la technologie d’interconnexion NVIDIA NVLink-C2C. La bande passante totale s’élève à 900 Go/s, soit une bande passante sept fois supérieure à celle de lignes PCIe Gen5 standards.

Ian Buck, vice président de l’informatique accélérée chez NVIDIA, a déclaré : « L’IA générative transforme rapidement les entreprises, débloque de nouvelles opportunités et accélère les découvertes dans les domaines de la santé, de la finance, des services aux entreprises et dans bien d’autres secteurs. Avec les superpuces Grace Hopper en pleine production, les fabricants du monde entier fourniront bientôt l’infrastructure accélérée dont les entreprises ont besoin pour construire et déployer des applications d’IA générative qui exploitent leurs données propriétaires uniques. »

A lire aussi, les actualités les plus récentes au sujet de NVIDIA et ses technologies :

DGX GH200 AI

La plateforme DGX GH200 AI succède à la plateforme DGX A100 lancée en 2020, laquelle succédait déjà à la DGX Volta.

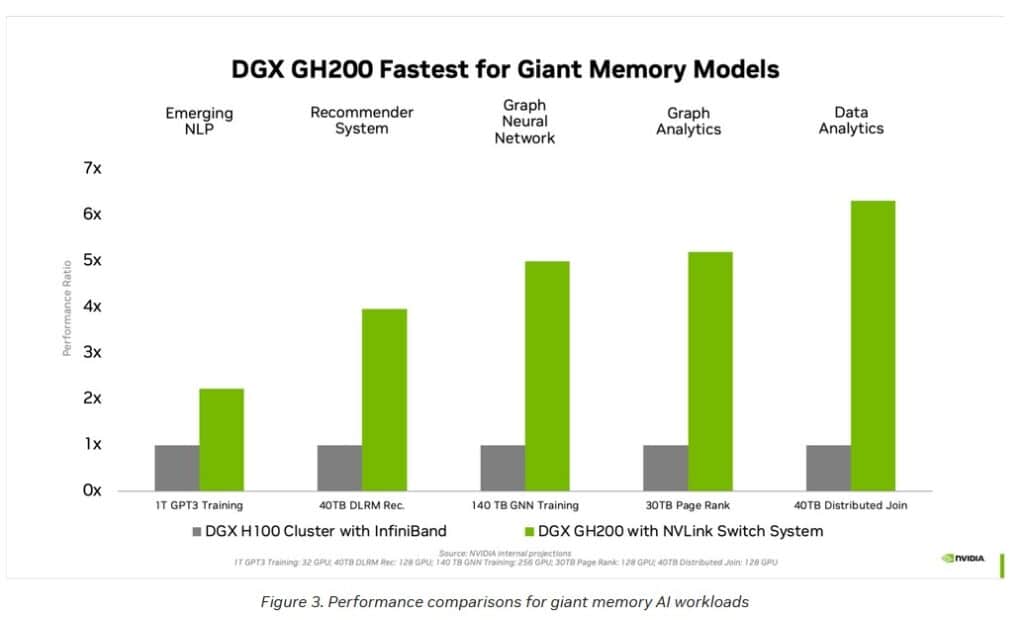

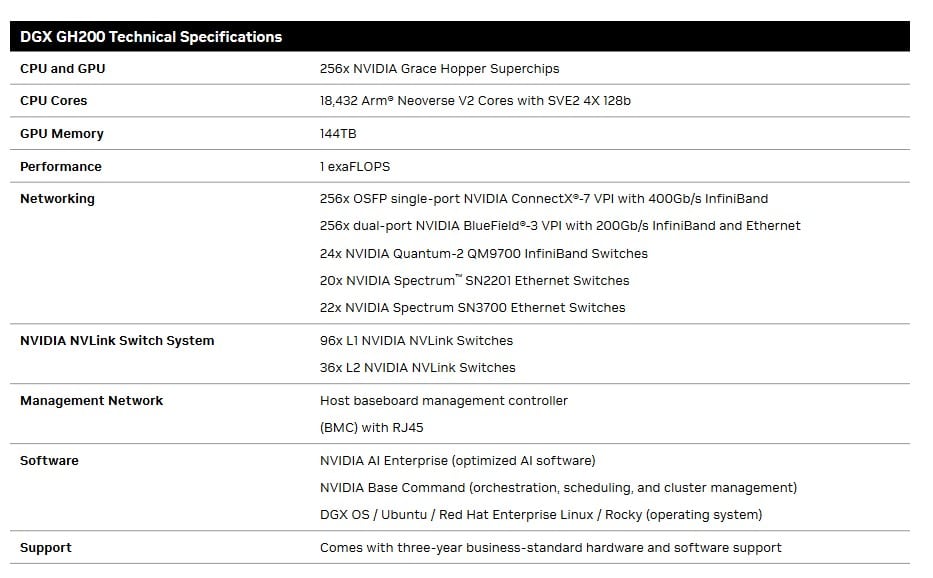

Cette plateforme DGX GH200 AI de l’entreprise, conçue, comme son nom l’indique, pour les charges de travail d’IA générative, associe jusqu’à 256 Grace Hopper Superchips (CPU + GPU) et 144 To de mémoire partagée.

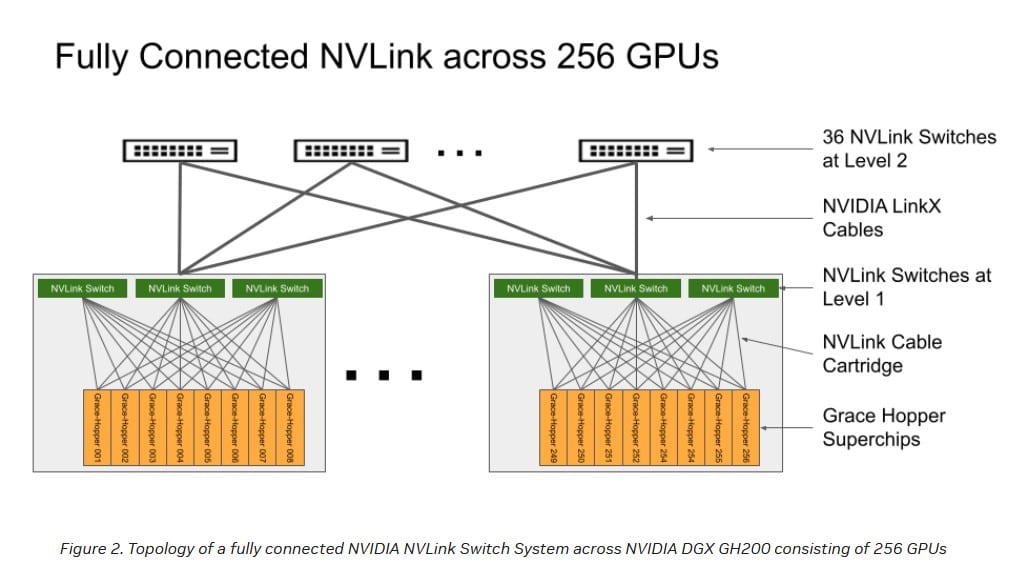

Pour la comparaison, les plateformes DGX A100 proposent jusqu’à huit GPU A100, et 320 Go de mémoire partagée. En outre, le système d’interconnexion de la génération précédente ne permettait qu’à huit GPU d’être combinés avec NVLink comme un seul GPU sans compromettre les performances. D’après l’entreprise, le nouveau NVIDIA NVLink Switch System multiplie par dix la bande passante GPU-to-GPU et par sept la bande passante CPU-to-GPU par rapport à son système de précédente génération. La société mentionne également une efficacité énergétique des interconnexions cinq fois supérieure.

« L’architecture DGX GH200 offre une bande passante NVLink 48 fois supérieure à celle de la génération précédente, ce qui permet d’obtenir la puissance d’un supercalculateur d’IA massif avec la simplicité de programmation d’un seul GPU », résume NVIDIA dans son communiqué.

Les NVIDIA DGX GH200 devraient être disponibles d’ici la fin de l’année. Parmi les clients cités : Google, Meta et Microsoft. Les caractéristiques principales des DGX H200 sont consignées dans le tableau ci-dessous.

Nouveaux systèmes MGX

Pour être complet, sachez que NVIDIA a également annoncé de nouveaux systèmes MGX en plus des systèmes DGX et HGX éprouvés.

MGX fonctionne avec différents facteurs de forme – 1U, 2U, 4U (refroidissement par air ou par liquide) – et est compatible avec les générations actuelles et futures du matériel NVIDIA (GPU, y compris les derniers H100, L40, L4 ; CPU Grace CPU Superchip, GH200 Grace Hopper Superchip, CPU x86 ; DPU NVIDIA BlueField-3, adaptateurs réseau ConnectX-7).

L’entreprise explique que « le MGX diffère du NVIDIA HGX en ce qu’il offre une compatibilité flexible et multigénérationnelle avec les produits NVIDIA afin que les constructeurs de systèmes puissent réutiliser les conceptions existantes et adopter facilement les produits de la prochaine génération sans avoir à procéder à des reconceptions coûteuses. HGX repose sur une carte de base multi-GPU connectée à NVLink et conçue pour évoluer afin de créer le nec plus ultra des systèmes d’IA et de HPC. »

À lire > 29 ans de supercalculateurs, une puissance multipliée par 18 millions !

Plateforme de mise en réseau NVIDIA Spectrum-X

Terminons par quelques mots au sujet de la plateforme de mise en réseau NVIDIA Spectrum-X, également présentée à l’occasion du Computex 2023. Elle combine un commutateur Ethernet NVIDIA Spectrum-4 et le DPU NVIDIA BlueField-3. Spectrum-X « offre les meilleures performances pour l’IA, l’apprentissage automatique et le traitement du langage naturel, ainsi que pour diverses applications industrielles » à en croire NVIDIA, qui présente d’ailleurs Spectrum-X comme la « première plateforme de mise en réseau Ethernet pour l’IA au monde ».

Sources : NVIDIA, NVIDIA DGX H200, NVIDIA MGX, NVIDIA Spectrum-X