Pas besoin d’investir des sommes mirobolantes dans des composants survitaminés si vous ne reliez votre ordinateur gaming qu’à un triste écran au rendu limité ! Figurant parmi les achats les plus importants (et les plus durables), le choix d’un écran gaming ne doit rien laisser au hasard. Découvrez notre sélection des meilleurs écrans gamer.

- Notre top 3 des meilleurs écrans gamers

- Samsung Odyssey G4, la qualité Samsung au meilleur prix

- Samsung Odyssey G5, équilibré, complet et abordable

- LG UltraGear 27GR75Q-B, l’alternative plus abordable

- Gigabyte M32U, la 4K sans concession sur la fluidité

- Samsung Odyssey OLED G8, la référence

- Asus ROG XG43UQ, l’écran grand format

- 📏 Quelle taille d’écran choisir ?

- 🤔 Quel type d’écran gaming choisir : incurvé ou plat ?

- ⚙️ FHD, QHD, 4K, quelle définition d’image choisir ?

- 👀 Quelle technologie de dalle choisir pour jouer sur son écran ?

- ⚡️ Écran gaming : la question du rafraîchissement

- ➖ Réduire le flou de mouvement sur un moniteur gaming

- 🔌 Quelle connectique pour son moniteur gaming ?

- 👉 Nos autres guides gaming :

Notre top 3 des meilleurs écrans gamers

Samsung Odyssey G4

- Taux de rafraîchissement de 240Hz

- Son temps de réponse de 1ms

- Son rapport qualité/prix

- Compatibilité G-Sync et FreeSync Premium

- Érgonomie complète sur l’orientation et la hauteur de l’écran

Samsung Odyssey G8

- Magnifique qualité d’affichage

- Dalle très lumineuse et contrastée

- Finitions soignées

- Idéal pour le gaming (FreeSync Premium Pro, G-Sync, 240 Hz et 1ms…)

- Fréquence de rafraîchissement de 144 Hz

Gigabyte M32U

- Une dalle IPS d’excellente facture, lumineuse, contrastée

- Ports HDMI 2.1

- Fréquence de 144 Hz

- Les réglages d’usine largement au-dessus de la moyenne

- Compatibilité Freesync Premium Pro

S’il est un périphérique obligatoirement associé à l’utilisation d’un ordinateur gaming, c’est bien l’écran. Dans le futur, on peut raisonnablement imaginer que les écrans seront totalement remplacés par d’autres types de périphériques. Tels que des casques ou des lunettes de réalité virtuelle et/ou augmentée. Mais cet avenir n’est pas pour tout de suite. Et les gamers seront encore coincés pendant quelques années avec cet imposant moniteur. Alors autant choisir le meilleur écran gamer !

Autrefois encombrants et cathodiques, les moniteurs se sont considérablement affinés grâce à la révolution LCD, gagnant en taille d’écran ce qu’ils ont perdu en profondeur. Les souvenirs des premiers écrans SVGA de 15 pouces, voire 17 ou 19 pouces pour les plus chanceux, sont désormais lointains, alors qu’aujourd’hui un écran de 22 pouces paraît insuffisant. La diversité des technologies LCD rend le choix complexe, surtout dans le marché du gaming, en pleine croissance. Pour simplifier votre décision, nous avons sélectionné des moniteurs gaming couvrant toutes les gammes de prix, et nous vous présenterons les critères essentiels à considérer avant achat.

À lire également : notre sélection des meilleurs PC gamers

Samsung Odyssey G4, la qualité Samsung au meilleur prix

Samsung Odyssey G4

La qualité Samsung au meilleur prix

-

€

Ecran PC Gamer – SAMSUNG – 27 – FHD -…139€

-

139€

-

149€

-

169.95€

-

171.33€

-

173.25€

-

173.67€

- Taux de rafraîchissement de 240Hz

- Son temps de réponse de 1ms

- Son rapport qualité/prix

- Compatibilité G-Sync et FreeSync Premium

- Érgonomie complète sur l’orientation et la hauteur de l’écran

- Seulement en 1080p

- Contrastes décevants

Le Samsung Odyssey G4 est l’écran parfait pour tout amateur de FPS grâce à son taux de rafraîchissement de 240Hz et son temps de réponse de 1ms. Pourtant, trouver un bon écran gamer pour moins de 200 euros, ce n’est pas une mince affaire. Et pour ce prix, il est aussi compatible G-Sync et FreeSync premium, les deux technologies NVIDIA et AMD. Notez que cela lui permet de performer avec n’importe quelle carte graphique. Décliné en 25 et de 27 pouces, il offre un excellent rapport qualité/prix.

C’est un écran qui peut proposer une résolution 21:9 en plus de sa résolution 16:9 d’origine, ce qui est un atout de taille pour les gamers souhaitant jouer à toutes sortes de jeux vidéo. Sa luminosité de 400 cd/㎡ et son contraste de 1000:1 vous permettent d’obtenir un bon rendu d’image, même s’il ne faudra pas vous attendre à des contrastes exeptionnels. Ajoutons à cela que le Samsung Odyssey G4 possède un pied réglable en hauteur, et qu’il est aussi inclinable jusqu’à 90°. En définitive, il s’agit de l’écran parfait pour les gamers en quêtent d’un produit abordable et de haute qualité.

Samsung Odyssey G5, équilibré, complet et abordable

Samsung Odyssey G5

Équilibré, complet et abordable

-

€

Ecran PC Gamer – SAMSUNG – 32 – WQHD…199.99€

-

199.99€

-

228.42€

-

229.99€

- HDR10 pour une colorimétrie très réaliste

- Taux de rafraîchissement de 165Hz

- Temps de réponse de 1ms

- Compatibilité G-Sync et FreeSync Premium

- Technologies anti-lumière bleue et Flicker Free

- Absence de haut-parleurs

- Une seule sortie HDMI

L’Odyssey G5 de Samsung est un moniteur gaming abordable avec une dalle VA de 32 pouces QHD, offrant une fréquence de 165 Hz et un temps de réponse de 1 ms. Certifié FreeSync Premium Pro et G-Sync, il assure une fluidité d’image optimale sans déchirures ni saccades. Son design incurvé à 1000R favorise l’immersion, bien que son ergonomie soit limitée avec un simple réglage d’inclinaison et une connectique de base comprenant une entrée DisplayPort 1.2, une entrée HDMI et une prise casque.

Malgré ses quelques concessions en termes de réglage et de connectique, l’Odyssey G5 se distingue par sa qualité d’image remarquable, ses couleurs fidèles et son bon contraste de 2860:1. C’est un choix solide pour les gamers recherchant une performance visuelle de haute qualité à un prix compétitif, parfait pour les jeux rapides et une utilisation multimédia.

LG UltraGear 27GR75Q-B, l’alternative plus abordable

LG UltraGear 27GR75Q-B

L'alternative au G5, moins chère

-

€

Écran PC – LG – 27GR75Q-B – 27…352.03€

-

352.03€

-

422.02€

- HDR10 pour une colorimétrie très réaliste

- Taux de rafraîchissement de 165Hz

- Temps de réponse de 1ms

- Compatibilité G-Sync et FreeSync Premium

- Absence de haut-parleurs

- Pas d’anti-lumière bleue

Le LG UltraGear est l’alternative directe de l’Odyssey G500. Ces deux écrans possèdent les mêmes qualités et les mêmes défauts. Il est donc compatible AMD FreeSync Premium et NVIDIA G-Sync. Son taux de rafraîchissement est de 165 Hz et sa résolution QHD.

On note tout de même que le LG UltraGear dispose d’une sortie HDMI supplémentaire, mais en contrepartie, il n’est pas doté de la technologie anti-lumière bleue ou des fonctionnalités Flicker Free qui permettent de limiter la perception de scintillements à hauts taux de rafraîchissement.

On peut noter également que le pied du LG UltraGear est plus imposant que celui du modèle Samsung. Si cela lui offre une bien meilleure stabilité, nous vous conseillons de le garder dans un coin de votre tête, surtout si vous n’avez pas un grand espace de jeu.

Gigabyte M32U, la 4K sans concession sur la fluidité

Gigabyte M32U

La 4K sans concession sur la fluidité

-

€

GIGABYTE M32U Moniteur de jeu 31,5 …615.99€

-

615.99€

- Une dalle IPS d’excellente facture, lumineuse, contrastée

- Ports HDMI 2.1

- Fréquence de 144 Hz

- Les réglages d’usine largement au-dessus de la moyenne

- Compatibilité Freesync Premium Pro

- Le prix encore un peu élevé

- Le mode sRGB bloque les réglages personnalisés

Il est difficile de trouver des modèles abordables en 4K, mais cet écran Gigabyte offre de solides arguments. Même s’il est logiquement encore difficile d’accès pour nombre de joueurs, il a le mérite d’offrir de la 4K pour moins de 1000€ et sans rogner sur les fonctionnalités ou les caractéristiques. Il offre un bilan intéressant. Trop souvent, sous prétexte de 4K, il faut se contenter d’un triste 60 Hz pour la fréquence de rafraîchissement. Inacceptable. Gigabyte ne se moque pas du monde avec ses 144 Hz et sa dalle IPS de 32″ d’excellente facture.

Ajoutons à cela que les noirs parviennent à garder un bon niveau de profondeur alors que l’uniformité des gris est excellente. On profite aussi de couleurs éclatantes quoique la HDR ait un petit problème de contraste. Mais à ce prix-là, il ne faut pas non plus trop en demander.

La présence de ports HDMI 2.1 pour les joueurs PlayStation 5 ou Xbox Series X|S achève en revanche d’en faire un excellent choix pour les amateurs de console. La présence d’un KVM intégré, d’un hub USB 3 ports, deux petits haut-parleurs 3 W et d’une sortie casque 3,5 mm viennent compléter le tableau.

Samsung Odyssey OLED G8, la référence

Samsung Odyssey G8

La référence

-

€

Ecran PC Gamer Incurvé – SAMSUNG -…1,060.48€

-

1,060.48€

-

1,309.60€

- Magnifique qualité d'affichage

- Dalle très lumineuse et contrastée

- Finitions soignées

- Idéal pour le gaming (FreeSync Premium Pro, G-Sync, 240 Hz et 1ms…)

- Fréquence de rafraîchissement de 144 Hz

- Attention, la courbure est prononcée

Le Samsung G8 est un écran PC gamer impressionnant. Il est doté de caractéristiques de pointe qui en font actuellement l’un des meilleurs moniteurs du marché. Avec sa résolution 4K, son taux de rafraîchissement de 240 Hz, sa technologie Neo-QLED, et sa diagonale de 32 pouces, il promet une expérience de jeu exceptionnelle. L’écran est ajustable en termes d’inclinaison, de pivotement et de hauteur, et ses finitions sont extrêmement soignées. La connectique est complète, avec deux ports HDMI 2.1, bien que certains puissent regretter l’absence d’USB-C ou de haut-parleurs.

En ce qui concerne la qualité d’image, le G8 offre de solides performances. Elles se traduisent par une luminosité élevée, des contrastes intenses et des couleurs précises. En ce qui concerne le jeu, l’écran 4K 240 Hz est une prouesse. Mais il nécessite une carte graphique très puissante pour en tirer pleinement parti. Il offre un temps de réponse de 1 ms. Et prend en charge les technologies FreeSync Premium Pro et G-Sync. Idéal pour des performances fluides et sans déchirures. En fin de compte, le Samsung Odyssey G8 est un bon choix pour les joueurs passionnés disposant du budget et du matériel appropriés.

Asus ROG XG43UQ, l’écran grand format

Asus ROG XG43UQ

L'écran grand format

-

€

XG43UQ899.99€

-

899.99€

-

1,371.09€

-

1,459.21€

-

1,482.69€

-

1,482.69€

- 4K et 144 Hz : si avez la machine, ça envoie du lourd

- Luminosité et contraste d’excellent niveau

- Largeur des angles de vision de la dalle VA

- Compatible Freesync Premium Pro

- Couleurs impeccables une fois la calibration effectuée

- Encombrant et pas évident à caser sur un bureau « de travail »

- Calibrage d’usine perfectible

- Une légère tendance au ghosting

La 4K sur un moniteur 27 pouces, c’est fin, c’est précis, mais ça impressionne quand même nettement moins que sur un 43 pouces. Alors pour clore notre sélection, nous avons décidé d’aller taquiner cette diagonale d’écran qui, du fait d’une hauteur plus importante que sur les modèles 32:9, autorise une dalle d’une bien plus grande superficie.

Commençons néanmoins par un petit reproche. De base, la calibration est imparfaite et il faudra régler quelques petites choses pour profiter pleinement des belles couleurs de cette dalle VA compatible HDR. Les angles de vision sont d’excellente facture. Et, ça n’a l’air de rien, mais sur une grande dalle, c’est appréciable.

Bien sûr, le 144 Hz assure un remarquable confort visuel. Pourvu que vous disposiez d’une configuration capable de maintenir les 144 ips sur du 4K ! Enfin, notons la présence de la compatibilité Freesync Premium Pro, d’un hub USB 3.0 2 ports, de haut-parleurs, d’une prise casque, d’un connecteur DisplayPort et de pas moins de 4 HDMI, dont deux en 2.1, rien que ça ! Terminons par une petite remarque pour remercier Asus qui, contrairement à la tendance, a décidé d’intégrer l’alimentation à son écran. Compte tenu de la taille du moniteur, c’est presque normal, mais malgré tout de plus en plus rare. Merci Asus.

À lire également : notre test de l’écran Corsair Xeneon 27QHD240

📏 Quelle taille d’écran choisir ?

Choisir un écran, c’est d’abord choisir la taille du produit que l’on souhaite voir trôner sur son bureau. Nous évoquons cette question même si, il faut bien le reconnaître, c’est sans doute celle pour laquelle vous aurez le moins besoin de conseils. En effet, chacun sait à peu près l’espace dont il dispose pour installer son nouvel écran et quelle taille de moniteur, il/elle apprécie pour jouer.

Précisons tout de même qu’à l’heure actuelle, deux tailles se partagent les faveurs des constructeurs et, en conséquence, autorise le plus de choix : les 24 et les 27 pouces avec, très proches, les modèles 28 pouces. Autrefois très populaires, les 21/22 pouces se sont raréfiés ces dernières années alors que les modèles 32 pouces tardent à s’imposer, restant cantonnés à un segment plus haut de gamme.

C’est donc sur ce créneau des 24 / 27 pouces que vous trouverez l’offre la plus large. C’est sur cette double gamme que vous pourrez mettre en application les conseils que nous vous donnons par la suite. Précisons enfin, que ces 24 / 27 impliquent un format 16/9, mais qu’il est tout à fait possible de viser quelque chose de différent. Nous le verrons au moment d’évoquer la définition d’image.

🤔 Quel type d’écran gaming choisir : incurvé ou plat ?

C’est question qui fait encore débat aujourd’hui : faut-il jouer sur un écran incurvé ou sur un écran plat ? Malheureusement, la bonne réponse n’existe pas. En fonction des genres de jeux auxquels on joue, les deux formes d’écrans ont des points positifs et négatifs.

Quels sont les avantages d’un écran incurvé ?

Ce format d’écran propose une immersion plus importante en imitant la structure de nos yeux et en offrant une dimension dans l’espace supplémentaire.

La distorsion de l’image sur les côtés de l’écran ne se fait pas ressentir sur un écran incurvé, là où sur un écran plat, notre œil n’est pas capable de rendre une image parfaite au niveau des angles de l’écran lorsque l’on regarde au centre de celui-ci. Ces avantages permettraient à nos yeux de moins fatiguer pendant de longues sessions, ce qui augmenterait le confort visuel.

Les désavantages pour le gaming

Pour les FPS, il y a presque une nécessité de devoir jouer en 16:9, or les écrans larges sont très souvent incurvés et beaucoup ont une résolution de 21:9 (écrans ultra-larges). Il faudra donc surveiller de près le type de résolution fourni par l’écran lors de l’achat si vous souhaitez jouer à ce type de jeu ou spécifiquement avec une résolution 16:9.

Les écrans ultralarges possèdent également plus de pixels ce qui affecte directement les performances de la carte graphique.

Le passage d’un écran plat à un écran incurvé nécessite un temps d’adaptation pour nos yeux, l’inverse est également vrai. C’est parfait si vous recherchez une nouvelle expérience visuelle, mais si vous souhaitez conserver vos habitudes de jeux, restez sur votre format actuel.

En résumé, il n’y a pas de bon choix prédisposé lorsque l’on hésite entre écran incurvé et écran plat, en revanche, il faut choisir le format en fonction de l’expérience de jeu que l’on souhaite se procurer.

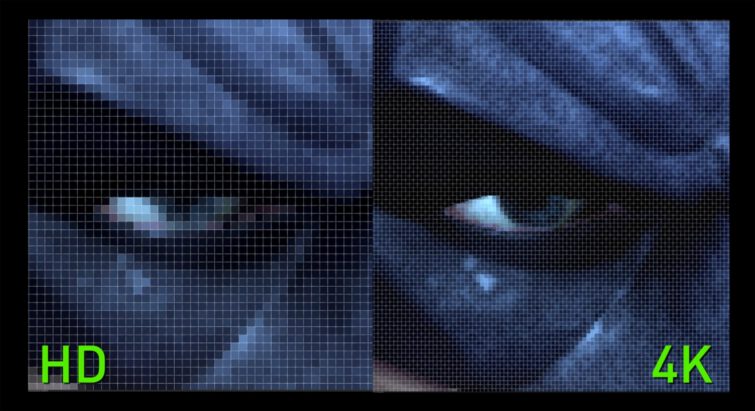

⚙️ FHD, QHD, 4K, quelle définition d’image choisir ?

Qu’il est loin le temps où les jeux vidéo se contentaient du 640×480, le fameux Super VGA. Aujourd’hui, la définition d’image – parfois le terme résolution est improprement employé – standard est un format emprunté au cinéma, le 1920 x 1080, également connu sous le nom de 1080p ou Full HD. Il s’agit d’un standard 16/9 qui s’adapte donc très bien à la diffusion de films et trouve un écho favorable dans le jeu vidéo.

C’est la définition la plus commune. Et celle qui devrait vous garantir une bonne fluidité d’animation, peu importe le niveau de détails retenu. Aujourd’hui, il s’agit toutefois d’une sorte de standard « par le bas » sur PC. De plus en plus de joueurs lorgnent le 1440p voire le 2160p. Ce second cas est l’adaptation informatique de la fameuse 4K. Il propose une image quatre fois plus grande que le 1080p avec 3840 points sur 2160. Le 1440p est un format intermédiaire (2560 x 1440) destiné à améliorer la finesse de l’image par rapport au 1080p. Mais il exige moins de ressources que le 2160p.

Le meilleur moyen de choisir est de vérifier votre carte graphique et les jeux qu’elle peut faire tourner. N’envisagez pas un écran 2160p pour jouer avec une GeForce GTX 1650 Ti. Elle aura du mal à débiter 30 images par seconde. Notez qu’il existe des formats plus exotiques, le 21/9 ou le 32/9. Il s’agit de proposer une image plus en longueur, plus en adéquation avec notre vision. Attention, on parle alors toujours de 1080p ou 1440p. Mais il y a davantage de pixels en largeur et la carte graphique est plus sollicitée à « hauteur » équivalente.

👀 Quelle technologie de dalle choisir pour jouer sur son écran ?

Trop souvent lorsque l’on ne connaissait pas bien le monde de l’écran gaming, on se contentait de regarder la taille et le format de l’écran. Pourtant, il existe une autre variable qui, paradoxalement, est aujourd’hui moins importante alors que l’on s’en soucie davantage. Par le passé, peu d’acheteurs comprenaient que la technologie dite TN (Twisted Nematic) impliquait de faire d’importantes concessions sur la qualité d’image, les angles de vision. Aujourd’hui alors justement que les TN ont fait d’importants progrès, les utilisateurs font davantage attention à ce point.

La technologie TN

Le TN a pour lui une réactivité remarquable qui autorise les jeux les plus rapides sans ressentir le moindre effet de rémanence ou d’image fantôme : l’impression que plusieurs images se superposent car l’ancienne n’a pas encore complètement disparu alors que la nouvelle arrive. Le TN doit également faire avec des angles de vision relativement faibles : ils ont nettement progressé en quelques années, mais dès lors que l’on n’est pas bien en face de l’écran, les choses deviennent vite plus sombres, les couleurs moins fidèles.

La technologie IPS

Pour évacuer ces défauts, les constructeurs ont imaginé la technologie dite IPS (In Plane Switching) et, dans une certaine mesure son concurrent, le VA (Vertical Alignment). Ces technologies disposent d’une qualité d’image bien supérieure : dans le cas du VA c’est surtout le contraste qui est meilleur alors que sur l’IPS on insiste sur le rendu des couleurs. Les angles de vision – meilleurs sur l’IPS – sont de toute façon un net cran au-dessus du TN, mais la réactivité des dalles est plus faible. Là encore, des progrès notables sont intervenus ces dernières années et IPS comme VA (surtout sa variante UV²A) sont parfaitement capables dès lors que l’on prend des produits affichant un temps de réponse inférieur à 5 ms.

La technologie OLED

Sur le papier, il est une technologie qui aurait dû mettre tout le monde d’accord, l’OLED. Sur le papier car dans les faits, les constructeurs ont toutes les peines du monde à proposer des produits de grande taille à des prix abordables. Ainsi, de par ses remarquables couleurs, son contraste impeccable, ses très bons angles de vision et sa réactivité irréprochable, l’OLED fait le bonheur des utilisateurs de smartphones, mais les moniteurs – plus encore ceux de gaming – sont rarissimes. Nous ne saurions donc vous conseiller de chercher un tel produit aujourd’hui pour du gaming, ce serait comme vous mettre en quête du mouton à cinq pattes.

À lire également : quelle est la meilleure technologie d’écran pour jouer ou travailler ?

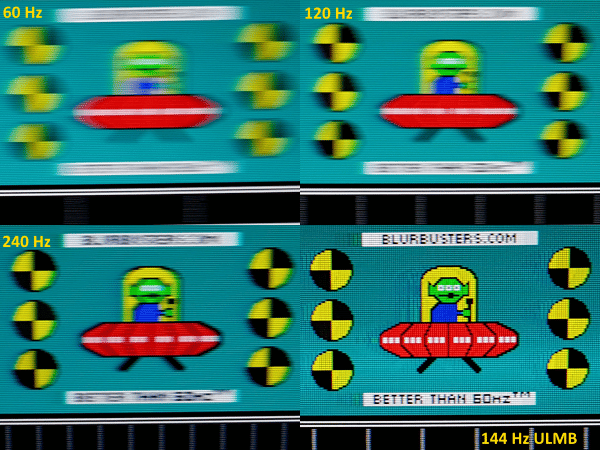

⚡️ Écran gaming : la question du rafraîchissement

Voilà encore une idée qui n’intéressait jadis que les plus experts. Les hardcore gamers comme on se plait à les appeler. La question du rafraîchissement de l’image a toutefois pris de l’importance à mesure que l’on s’est rendu compte que le 25 images par seconde, puis le 30 ips et même aujourd’hui le 60 ips ne sont pas la panacée. Alors que de nombreux joueurs se contentaient de 25 / 30 ips, les écrans étaient capables d’afficher sans peine ces « exigences », même chose pour le 60 ips. Les choses se sont compliquées quand des joueurs ont commencé à dire que plus de 60 images par seconde était non seulement perceptible, mais aussi nettement plus agréable.

Aujourd’hui, de nombreux joueurs ne jurent que par le 120 images par seconde. Et, en conséquence, dédaignent les moniteurs qui ne peuvent monter jusqu’à 120 Hz de fréquence de rafraîchissement. Il est effectivement parfaitement inutile de faire mouliner la carte graphique pour calculer 120 voire 144 ips, si votre moniteur n’est pas capable de rafraîchir l’image au même rythme. Pour une fois, les choses sont simples. Il faut « autant » de Hz que la fluidité d’animation visée. Et un moniteur estampillé 120 Hz sera donc à mettre « en face » d’une fluidité de 120 ips.

Bien sûr, plus la définition d’image est élevée, plus il est difficile de garantir un nombre d’images par seconde important. Les configurations « 4K » auront par exemple toutes les peines du monde à monter jusqu’à 100 ips et même garantir du 60 ips – « constant ». Insistons bien sur ce terme de « constant » – n’est pas à la portée de toutes les cartes graphiques.

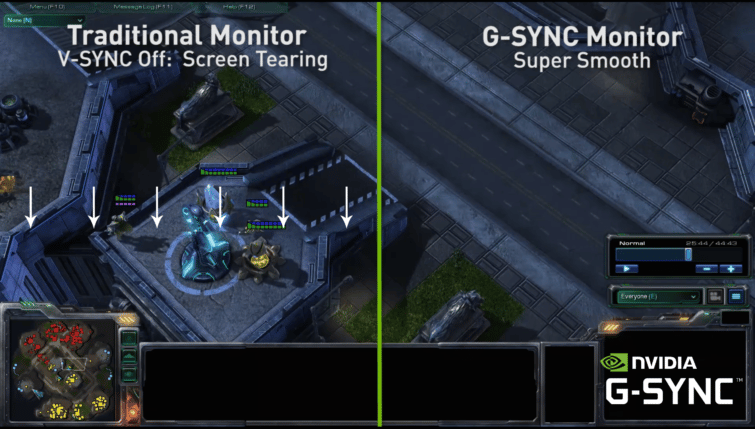

Enfin, impossible de ne pas parler de la fréquence de rafraîchissement sans évoquer le cas troublant des moniteurs G-Sync / Freesync. Imaginé par NVIDIA, le premier n’est autre qu’une technologie visant à systématiquement caler la fluidité de l’animation et la fréquence de rafraîchissement. Une telle synchronisation permet de ne pas avoir de « cassures » dans l’image. Ce que les anglophones nomment le tearing et qui s’avère particulièrement inesthétique. Si votre carte graphique est capable de délivrer une fluidité plus importante – en toute circonstance – que la fréquence de rafraîchissement du moniteur, vous n’en aurez pas besoin.

Sur l’immense majorité des configurations, ce ne sera cependant pas le cas. Le G-Sync a été conçu pour venir en aide aux joueurs. Freesync est arrivé très peu de temps après. Soutenu par le concurrent AMD, il se montre moins ambitieux technologiquement, mais tout aussi efficace et moins coûteux. Il est à noter que des écrans sont maintenant compatibles avec les deux normes afin de simplifier les décisions des acheteurs.

À lire également : notre dossier détaillant les technologies G-sync et Freesync

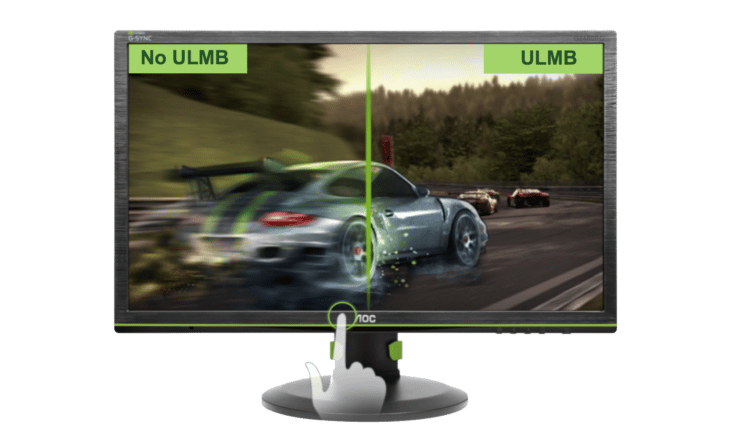

➖ Réduire le flou de mouvement sur un moniteur gaming

Si la hausse des fréquences des moniteurs a permis d’obtenir des animations plus fluides et un peu plus nettes, les effets de flou sur les objets qui se déplacent rapidement horizontalement restent assez présents. Les constructeurs ont alors mis au point des techniques dites de « réduction de flou ». Elles sont appelées ULMB chez Nvidia (et LightBoost pour la 3D). Turbo 240 chez Eizo. Ou encore plus sobrement Blur Reduction chez Benq. Une fois activées, ces technologies opèrent de la même façon . Insérer une image noire entre deux images envoyées par la carte graphique, en éteignant très rapidement le rétro éclairage (comme un stroboscope). Tous les joueurs sont unanimes : le résultat est spectaculaire ! Nombreux sont d’ailleurs ceux qui préfèrent l’ULMB au mode G-Sync (ceux qui ont une très bonne configuration sans doute !).

Cette technologie de réduction de flou a toutefois un défaut. Elle entraîne une baisse plus ou moins prononcée de la luminosité. Par exemple, si – dans les réglages de l’Asus Rog Swift PG278Q – on pousse cette fonction dans ses retranchements, la luminosité chute d’environ 50 % ! De plus, certains utilisateurs très sensibles pourront constater des scintillements, ce qui peut occasionner un mal aux yeux ou au crâne.

Enfin, il n’est actuellement pas possible d’activer les technologies G-sync/FreeSync et ULMB simultanément. Fluidité ou netteté, c’est donc à vous de voir ! L’idéal étant – si votre carte graphique peut constamment afficher 120 images par seconde dans votre jeu préféré – d’activer la V-sync (de préférence en mode Fast chez NVIDIA) et l’ULMB…

Asus a toutefois réussi ce tour de force en premier. Avec une techno ELMB (Extreme Low Motion Blur) faite maison qui permet de synchroniser Adaptive Sync (FreeSync et G-Sync Compatible) avec l’ULMB. Et ça marche plutôt bien, pour preuve : notre test exclusif du premier écran ELMB d’Asus.

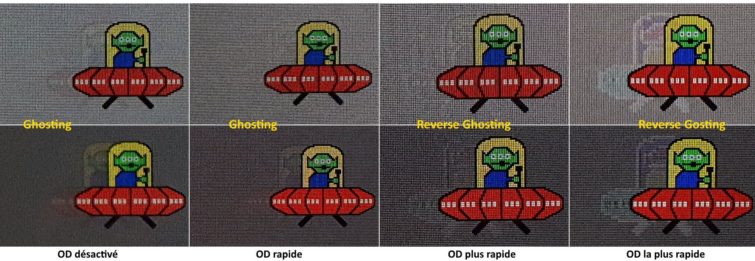

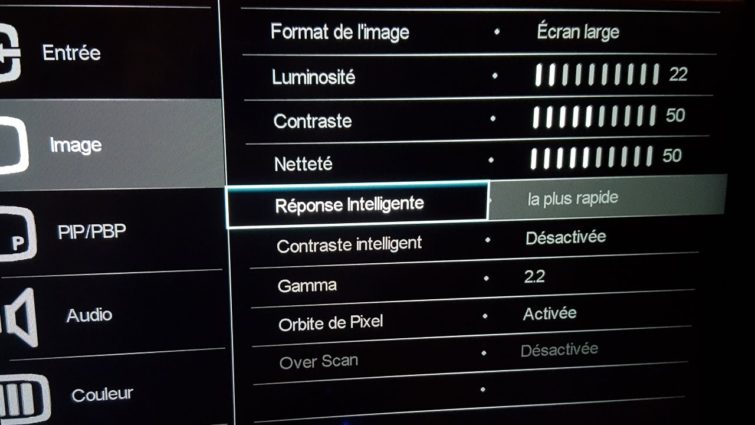

Comme le temps de réponse est quasiment toujours largement minimisé par les constructeurs, il convient de déterminer la valeur réelle par une autre série de tests. Rappelons qu’il s’agit pour schématiser de la vitesse des cristaux liquides. Si elle est trop lente, un effet appelé images fantômes, ou ghosting, apparaît sur les objets en mouvement. Il faut alors une valeur minimale. Pour accélérer artificiellement la vitesse de réaction des cristaux liquides, les constructeurs offrent parfois la possibilité dans les réglages du moniteur d’activer une fonction appelée overdrive. Attention toutefois, si celle-ci est mal gérée ou trop forte, un autre phénomène nuisible, le reverse ghosting, prend le relais. Le tout est de savoir si on peut trouver un réglage minimisant les deux phénomènes.

Enfin, les joueurs doivent tenir compte de l’input lag de leur prochain moniteur. Il s’agit du décalage entre le moment où le moniteur reçoit une image et celui où il l’affiche. S’il est mesuré à moins de 10-15 ms, c’est parfait pour les pros de la gâchette. Entre 15 et 30 ms, cela reste acceptable. Au-delà de 30 ms, l’écran s’adresse plutôt aux joueurs occasionnels. Ou à ceux qui préfèrent d’autres types de jeux qui n’exige pas de réactions rapides.

🔌 Quelle connectique pour son moniteur gaming ?

Beaucoup moins critique que par le passé, la question de la connectique profite à plein de la simplification des ports. Pour faire simple, autrefois il fallait choisir entre VGA, DVI et HDMI. Avec selon les cas, des différences et des particularités à ne pas négliger. Aujourd’hui, les choses se partagent essentiellement en deux. Le HDMI venu du monde de la vidéo et très lié aux consoles. Et le DisplayPort sorte de déclinaison informatique du HDMI, qui repose sur des standards assez similaires.

Entièrement numériques, HDMI et DisplayPort sont capables de faire passer de la vidéo haute définition avec des fréquences de rafraîchissement élevées. Attention cependant, même dans ce cas, il y a des évolutions. Ainsi, pour faire passer la 4K @ 60 Hz, il est nécessaire d’opter pour le HDMI 2.0 ou DisplayPort 1.2. Surveillez donc bien les versions de ces normes implémentées dans le moniteur de vos rêves.

Il est bon de souligner que certains moniteurs disposent de deux, voire trois ports HDMI en plus d’un DisplayPort. Plus ils sont nombreux et plus vous pourrez connecter de périphériques, consoles, box différents sans avoir à jouer du câble. Attention, les moniteurs G-Sync sont généralement moins bien dotés que les autres à ce niveau.

Terminons ces quelques recommandations et remarques générales par une sorte de fourre-tout des autres questions que l’on peut se poser. Ainsi, nous aimerions faire remarquer que de plus en plus de moniteurs intègrent des fonctionnalités « bonus ». Certains d’entre eux disposent d’un vrai hub USB 3.0 quand d’autres intègrent de petits haut-parleurs. Dans le premier cas, cela simplifie évidemment la connexion de clés USB, de claviers ou de souris. Dans le second, il s’agit de faire passer le son en HDMI. En branchant une console en plus du PC par exemple. Attention, le DisplayPort est généralement moins utilisé pour faire passer de l’audio.

La question des réglages n’est pas non plus à négliger même si les choses sont ici très difficiles à résumer. Si les interfaces se valent généralement, les moyens d’y accéder diffèrent sensiblement. Certains écrans passent par de classiques boutons en façade. D’autres utilisent une espèce de mini-joystick par exemple sur le cadre de l’écran. Enfin, certains préfèrent des zones tactiles en lieu et place des boutons. Ce sont les seuls que nous vous suggérons d’éviter. On s’y fait, mais c’est généralement moins pratique, moins réactif.

Directement lié à la question des réglages, les options d’interface peuvent changer votre utilisation du moniteur. Ainsi nous apprécions quand il est possible de partager l’image 4K d’un moniteur en 4 panneaux 1080p. Un pour chaque source. On peut alors contrôler ce qui se passe à l’écran des différents appareils connectés. Sur les écrans les plus larges (21/9 notamment), il est aussi possible de partager l’image en deux. Cela permet d’exploiter deux configurations en même temps sans associer deux moniteurs.

Enfin, nous aimerions souligner l’importance de choisir un écran doté d’un pied « de qualité ». Bien sûr, à ce niveau, cela dépend beaucoup de votre installation / de vos besoins. Mais sachez que certains moniteurs sont vendus avec des pieds « tout simples ». Quand d’autres autorisent une large amplitude de réglages, en hauteur par exemple. Mieux, certains modèles permettent une rotation de la surface d’affichage afin de passer en mode portrait par exemple. Une option inutile dans le cas d’une utilisation gaming, mais qui peut être intéressante sur d’autres usages.

“l’OLED fait le bonheur des utilisateurs de smartphones, mais les moniteurs – plus encore ceux de gaming – sont rarissimes. Nous ne saurions donc vous conseiller de chercher un tel produit aujourd’hui pour du gaming, ce serait comme vous mettre en quête du mouton à cinq pattes.”

Peut être mettre à jour votre guide, vu que vous en proposez un et qu’il existe maintenant plusieurs modèles. Et ça permettrai de donner les points fort et faible de cette technologie…